Flux RSS

Cloud computing

904 documents trouvés, affichage des résultats 781 à 790.

| < Les 10 documents précédents | Les 10 documents suivants > |

(31/03/2010 19:05:00)

Un cloud portatif pour équiper les forces nomades [1er avril ;-)]

Dernière tendance IT, transporter son cloud avec soi. Après le cloud privé, le cloud public ou encore le cloud fédéré, voici venir le cloud portatif. Développée par une alliance regroupant Digital, Compak, Blue Telecom et Big Green, cette plate-forme de services repose sur un ordinateur nomade animé par une distribution et des VM Linux. Une fois déployée, elle permet d'assurer des ressources fédérées à une dizaine d'utilisateurs dans un rayon de 15 mètres.

Certaines entreprises spécialisées dans les transports se sont déjà montrées très intéressées par ce programme. Une solution qui aurait également la faveur des forces armées pour monter rapidement une infrastructure IT sur un champ de bataille. L'armée afghane aurait l'intention d'en commander une centaine pour assurer la liaison avec les troupes enclavées dans des vallées ou sur des plateaux reculées.

(...)(30/03/2010 16:51:19)

Office mobile : Microsoft choisit la prudence

Office Web Apps, la suite bureautique pour Internet de Microsoft, intégrée à la dernière suite bureautique Office 2010 - annoncée pour le 12 mai en version entreprise et courant juin pour le grand public - comprend des versions web gratuites de Word, d'Excel et de PowerPoint. Telle est la parade de Microsoft à l'arrivée massive sur le marché d'outils de productivité signés Google et autres. « Nous devons être les leaders. Nous devons être ceux qui prennent les décisions difficiles, diriger le jeu et amener le marché vers nos produits,» a déclaré Stephen Elop, président de la division Business de Microsoft dans une interview. Car pour l'instant, en matière d'outils de productivité en ligne, Microsoft est plutôt suiveur que meneur.

Une étude datant de 2009, réalisée par le cabinet IDC, fait état d'une utilisation croissante de Google Docs. Elle précise aussi que 20 % des personnes interrogées affirment que la suite de Google est largement utilisée au sein de leur entreprise. Une étude similaire remontant à 2007, montre que Google Docs était à l'époque largement utilisée par 6% des entreprises. Mais Google, arrivé parmi les derniers sur le marché, de plus avec une suite de productivité en ligne maison, n'avait pas fait de tort à Microsoft. Deux ans plus tard, l'étude IDC 2009 montre que l'utilisation croissante de Google Docs dans les entreprises n'a pas eu d'effet négatif sur les parts de marché de Microsoft Office, suggérant que les applications de bureautique sur Internet sont des compléments plutôt que des substituts des suites de productivité classique, du moins pour l'instant.

[[page]]

Mais le rôle des applications de productivité en ligne pourrait changer à mesure que les entreprises se familiarisent avec leur usage et être utilisées en lieu et place des logiciels de bureau. Décrivant les effets du «cloud computing» - un terme fourre-tout employé pour désigner des services de calcul hébergés et offerts via Internet - sur le marché de l'informatique d'entreprise, Stephen Elop les qualifie de modèle de «rupture constructive. » Selon lui, Microsoft a une marge de manoeuvre étroite quand elle réfléchit à la manière dont les applications sont déployées et utilisées. «Quand je pense à ces transformations, je dois le faire d'une façon qui tienne compte et qui permette aux 500 millions de clients de Microsoft Office de nous suivre. Il faut s'interroger sur le nombre de personnes, leur lieu de travail, comment elles utilisent ce produit quotidiennement et avec quelle fréquence,» a expliqué Stephen Elop.

La large base d'utilisateurs d'Office représente incontestablement une source essentielle de revenus pour Microsoft. En 2009, les ventes d'Office ont dépassé 17 milliards de dollars, soit près de 30 pour cent des recettes globales de l'entreprise. Par conséquent, Microsoft veut être sûr que les nouvelles versions de Microsoft Office disponibles en ligne ou pouvant être utilisées depuis des téléphones portables ne remettent pas en cause ces bénéfices. «La nécessité d'une telle expérience, doit, sans aucun doute, être au moins, du même niveau que tout ce que les gens connaissent déjà, » a déclaré Stephen Elop. Dans la manière dont Microsoft voit évoluer les applications de productivité, les utilisateurs pourront modifier et déplacer des documents entre leurs ordinateurs personnels, Internet et des dispositifs mobiles, sans rien perdre de la mise en forme ou de la structure des documents.

[[page]]

« La meilleure combinaison possible sera celle qui permet une expérience transparente entre le PC, le téléphone portable, et le navigateur internet, » a déclaré Stephen Elop. « Les versions mobiles de Microsoft Office pour téléphones tournant sous Windows seront disponibles un peu plus tard cette année, ainsi que pour les smartphones Nokia tournant sous Symbian, » a t-il indiqué. Il a même prédit que, dans les années à venir, 200 à 300 millions de mobiles Nokia seront livrés avec une version d'Office mobile.

Pour l'instant, Microsoft n'a pas de plans pour proposer des versions mobiles de Microsoft Office pour les BlackBerry de Rim ou pour l'iPhone d'Apple. Microsoft n'a pas non plus l'intention de développer une version d'Office pour le système d'exploitation MeeGo, une combinaison des systèmes d'exploitation Maemo de Nokia et Moblin d'Intel. « Nous réfléchissons sérieusement à la stratégie à mener en fonction des appareils, et à quel moment la mettre en oeuvre, parce que nos options sont limitées, » a déclaré Stephen Elop. «A mesure que nous avançons, nous considérerons aussi d'autres environnements. Mais nous savons, sans ambiguïté, que nous devons examiner chaque plate-forme. Nos clients nous l'indiquent et l'attendent de nous, » a t-il conclu.

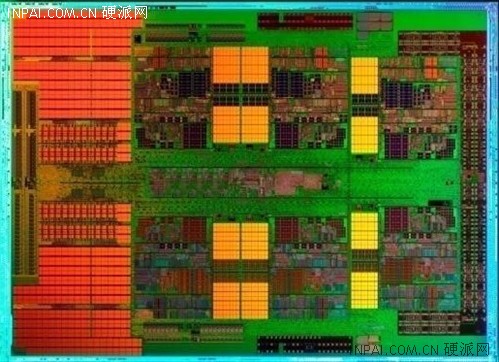

(...)(29/03/2010 15:16:49)Opteron 6100 : Un gros 12 coeurs AMD pour contrer les 6 coeurs d'Intel (MAJ)

Face à un concurrent toujours plus redoutable qui vient de dévoiler ses plates-formes bi et quadri sockets pour serveur (Intel Xeon Westmere 32 nm et Nehalem-EX 45 nm), AMD double le nombre de coeurs disponibles dans sa ligne de processeurs pour serveurs bi et quadri sockets avec la génération Magny-Cours. Le gain de performance attendu avec ces Opteron est environ le double des précédentes puces six coeurs selon AMD. Il faut bien évidemment comparer ces benchmarks avec ceux des Xeon Westmere 5600 et des Nehalem-EX 7500/6500, notamment sur les points des performances brutes et de la consommation électrique. Seul bémol sur ce dernier point, AMD communique ses chiffres en se basant sur la consommation moyenne (ACP) alors qu'Intel livre des données de type TDP (consommation maximale). Difficile de vraiment comparer l'enveloppe thermique des deux plates-formes dans ces conditions.

Dans son premier communiqué de presse sur la question, AMD ne compare toutefois les benchmarks de l'Opteron 6174 deux sockets que face au Xeon 2 voies X5680 (voir infographie ci-dessous). Le premier constat est qu'AMD a besoin de 12 coeurs pour faire le travail d'un six coeurs chez Intel mais avec une enveloppe thermique difficile à comparer (105 Watts en ACP contre 130 chez Intel en TDP). Un point pourtant particulièrement important quand on densifie ses salles informatiques pour réduire le nombre de serveurs. Les X6500 d'Intel (bi socket Nehalem-EX ) n'ayant pas encore été officiellement dévoilés, il est encore nécessaire d'attendre quelques heures pour confronter ces nouveaux bi sockets face à face...

Le fondeur entend bien tirer à profit les gains offerts par cette plate-forme pour convaincre les entreprises de remplacer leurs serveurs bi sockets par sa solution. Un des principaux avantages mis en avant par AMD est la réduction des coûts de licences logicielles. En 2004, avec l'arrivée des processeurs double coeur, Microsoft avait annoncé qu'il continuerait à licencier ses logiciels en prenant comme base les processeurs, et non pas le nombre de coeurs par puce. De nombreux fournisseurs ont une approche similaire mais cette pratique commerciale n'est pas universelle.

[[page]]

Pour Matt Lavallée, directeur technique de la société MLS Property Information Network (Shrewsbury, Massachusetts) qui fournit des données immobilières à des sites marchands, le passage 4 à 12 coeurs sur ses serveurs Opteron lui permettra de réduire le nombre de ses serveurs et de diminuer les coûts de ses licences logicielles. Matt Lavallée qui a déjà effectué des tests avec des préversions de Magny-Cours estime que l'utilisation de puces douze coeurs de base, qui coûtent un peu plus chers que les huit, est un bon moyen de réduire les coûts de ses serveurs SQL.

SIA exploite 60 serveurs, et son directeur technique pourrait théoriquement réduire de moitié son nombre de machines avec une évolution vers Magny-Cours. Prudemment, il envisage de diminuer d'un tiers seulement ses serveurs avec une mise à jour au niveau des puces. Matt Lavallée explique avoir commencé à utiliser des puces Opteron il y a environ deux ans et demi, et estime que le principale avantage de ces puces résident dans leur débit très important (jusqu'à 5,2 Gb/s, voir encadré).

Gordon Haff, analyste chez Illuminata, précise que c'est la performance, et non le nombre de coeurs, qui compte sur ces puces. Il s'attend à ce qu'Intel et AMD offrent au final des performances similaires mais en utilisant des approches différentes. AMD dispose de 10 options de tarification en fonction du nombre de coeurs, des cadences d'horloge et de la consommation électrique : compter environ 455 $ pour une puce huit coeurs à 1,8 GHz (65 Watts) et 1 386 $ pour un 12 coeurs à 2, 3 GHz (105 Watts).

(...)(29/03/2010 12:41:09)

Dépenses SOA : +24% entre 2008 et 2013, selon IDC

« Certains sur le marché prétendent que c'en est fini de la SOA. Rien n'est plus faux », a rectifié Ruediger Spies, vice-président d'IDC Central Europe pour les applications d'entreprise, lors de la conférence « SOA and Beyond » (SOA et au-delà) organisée la semaine dernière à Londres par le cabinet d'études. Pour le consultant, l'intérêt qui se manifeste en ce moment autour du cloud computing constitue notamment un catalyseur pour investir dans les architectures orientées services. Selon lui, entre 2008 et 2013, les dépenses SOA auront augmenté de 24% dans la zone EMEA (Europe, Moyen-Orient, Afrique), de 23,2% en Asie/Pacifique et de 24,7% sur le continent américain. C'est cette troisième région qui tirera la croissance, a précisé le consultant d'IDC, en expliquant que l'augmentation serait moindre en Europe où les entreprises disposent d'une meilleure architecture informatique qu'aux Etats-Unis, mieux intégrée.

Les projets SOA exigent de bien comprendre les besoins métiers

Ruediger Spies a rappelé que le succès des architectures orientées services impliquait pour l'entreprise de construire une vision à long terme. « Ce sont des projets dont la durée de vie dépasse celle des ERP, qui courent sur douze ou treize ans », rappelle l'analyste. Il recommande aussi que les architectes SOA définissent une valeur métier qui permette aux opérationnels de comprendre en quoi elles contribuent à améliorer les performances de l'entreprise. « Il s'agit avant tout d'intégration [entre applications]. Le responsable du projet doit comprendre les besoins des métiers. Il ne faut pas choisir un jeune diplômé qui vient juste de sortir de l'école, mais s'appuyer sur quelqu'un qui sera reconnu à la fois par les utilisateurs métiers et par les équipes informatiques », insiste Ruediger Spies.

L'analyste explique aussi qu'un projet SOA correctement défini fournira les bases pour les stratégies de BPM (gestion des processus métiers) qui, selon lui, sont très proches du cloud computing. Ce dernier, estime-t-il, ne constitue qu'une option supplémentaire lorsqu'une entreprise doit choisir une solution informatique ou remplacer ses systèmes en place. Et Ruediger Spies d'insister : si vous avez mis en place convenablement votre architecture orientée services, vous aurez votre feuille de route pour élaborer vos architectures de processus et d'information et la façon dont elles doivent se combiner. »

NTT Communication prend pied dans le cloud

Certains diront un de plus, mais les opérateurs télécoms à vocation internationale saisissent l'opportunité du cloud pour proposer des offres spécifiques sur le sujet. L'opérateur japonais NTT qui dispose d'une entité, baptisée NTT Communications, dont une unité d'affaires est dédiée aux services managés, NTT Europe Online, n'échappe pas à cette règle en proposant une solution baptisée Global Virtualization Services. Stéphane Estevez, responsable produit de NTT Europe Online explique que cette offre « s'adresse à l'activité infrastructure en mode IaaS (Infrastructure as a service) alliant puissance de calcul et machines virtuelles. Notre stratégie pour cette année est d'assister les entreprises dans leur migration vers ces nouveaux modèles, en gérant tous les types de cloud dans une vision globale ». L'avantage de la solution pour les entreprises disposant de plusieurs sites dans le monde est d'avoir un interlocuteur unique aussi bien sur le plan du support, que sur le portail d'administration, qui leur offre de nombreuses fonctionnalités de design d'architecture, d'installation et de gestion des opérations. (...)

(19/03/2010 09:50:21)Les défis sécuritaires du cloud

« Le défi va être permanent, mais sous tension, non seulement en terme d'innovations techniques, mais aussi en matière de communication», a déclaré le PDG de Microsoft Steve Ballmer lors d'une conférence à l'université de Washington qui s'est tenu ce mois-ci. «Certains pensent que le cloud est un coffre-fort bien sécurisé, mais d'autres estiment que ce n'est pas sûr et sécurisé, sans parler de ceux qui ne pensent pas grand-chose du tout. La question est de savoir si on peut donner aux gens des outils dont ils pourront avoir le contrôle, dont ils pourront se sentir responsable? Je crois que les utilisateurs seront en mesure d'apprécier la question de la sécurité cloud quand ils en verront les effets. Le problème actuel est que les utilisateurs ne savent pas vraiment ce qui se passe ... et il est primordial de réaliser des outils et des technologies qui en facilitent la gestion. » « L'idée de « partager » des informations transforme le problème de la sécurité cloud en défi » explique Eva Chen, PDG de Trend Micro, dans l'entretien qu'elle a accordé à Network World : «Traditionnellement, les entreprises étaient propriétaires de leurs infrastructures informatiques. Avec le cloud, elles partagent la puissance de calcul, le stockage. Elles veulent donc savoir avec qui elles partagent leurs données. Quand vous louez une chambre dans un hôtel, vous ne voulez pas que votre porte soit ouverte, vous voulez qu'elle soit fermée à clef. Pour le cloud, c'est pareil : une entreprise qui loue temporairement un espace a besoin de savoir qu'il y a des verrous. » Network World a également interrogé Art Coviello, président de la division RSA de EMC et vice-président exécutif chez EMC. " Sur la question de la sécurité du cloud, je pense honnêtement qu'elle réside au niveau du microprocesseur, car avoir confiance en ce socle matériel est essentiel. C'est même selon moi la condition sine qua non du processus, » a t-il déclaré. « L'autre grand enjeu, c'est la gestion. Afin de disposer de tous les contrôles, il faut unifier la politique de sécurité avec la politique commerciale de l'entreprise et coordonner les deux afin d'avoir un effet de levier. Les sociétés abonnées au service cloud doivent être en mesure de dicter et de déléguer cette politique aux prestataires, seuls à pouvoir appliquer les décisions. » [[page]] Education et interopérabilité Dave DeWalt, président et CEO de McAfee, a déclaré à Network World que l'éducation était pour lui le plus grand défi: «Beaucoup d'entreprises sont aujourd'hui inquiètes car depuis 20 ou 30 ans, elles avaient le contrôle totale sur leur activité. Mais dans l'approche cloud, elles doivent parfois faire appel à plusieurs fournisseurs pour gérer leurs applications et donnent à chaque prestataire un contrôle sur leurs données. En premier lieu, elles sont préoccupées par cette perte de contrôle sur leurs actifs sensibles. Et il n'existe aucun standard en matière de cloud aujourd'hui. Les applications à base de cloud en sont à leurs débuts. Des vulnérabilités existent et des erreurs sont commises. Le cloud a donc besoin d'évoluer. » Enrique Salem, Président et CEO de Symantec, a déclaré pour sa part que le cloud réclamait de nouvelles exigences en matière de sécurité. « Tout d'abord, du point de vue des infrastructures, la sécurité devra se rapprocher des applications et des données. Dans une architecture de services partagés, il ne suffit pas simplement de protéger le périmètre du cloud, le datacenter, les serveurs ou même les baies de stockage. Les sociétés doivent renforcer leur gouvernance des informations pour optimiser le contrôle de celles émanant de l'entreprise. Elles doivent définir des politiques et des procédures et se les appliquer. Il est clair que cela est plus facile à dire qu'à faire. Une autre condition essentielle est la nécessaire visibilité des outils de sécurité mis en oeuvre par les prestataires de cloud, pour être en adéquation avec le niveau formulé par les entreprises. Cette interopérabilité sera importante et permettra aux sociétés de tirer parti, ensemble, des différents modèles, et d'optimiser les avantages de chacun. » (...)

(18/03/2010 16:49:14)Un cloud public pour le développement chez IBM

Pour les départements informatiques, développer et tester sur une plate-forme « élastique » dans une infrastructure de cloud constitue une bonne manière d'optimiser leurs développements. En outre, l'utilisation d'une plate-forme cloud peut les aider à travailler plus rapidement, car les ressources peuvent être fournies à la demande, sans les blocages inhérents à la réservation préalable de temps et d'espace sur les systèmes internes, expliquent les promoteurs de cette solution. Big Blue a aussi publié une liste de partenaires pour son cloud : RightScale et Kaavo, qui proposent des programmes de supervision des clouds; Navajo Systems spécialisé dans la sécurité; AppFirst qui apporte des logiciels d'optimisation de la performance ; enfin Aviarc, Corent et Wavemaker qui fournissent des outils de développement. Le cloud public dédié au développement d'IBM exploitera également la technologie de virtualisation de Red Hat et supporte les systèmes Red Hat Enterprise Linux, Novell SUSE Linux et Java. Cette plate-forme sera disponible au deuxième trimestre de l'année aux États-Unis et au Canada, et dans le reste du monde par la suite. Parmi les concurrents de cette infrastructure, citons Amazon Web Services et Rackspace, qui ont, tous deux, établi des partenariats similaires. IBM pourrait toutefois avoir un avantage concurrentiel sur ces fournisseurs, étant donné sa longue expérience dans les entreprises et l'utilisation répandue de ses outils de développement Rational. IBM a d'ailleurs récemment annoncé la disponibilité de sa plateforme Rational Software Delivery Services v1.0 pour le cloud computing. (...)

(18/03/2010 09:39:25)John Chambers : Cisco n'a pas voulu concurrencer IBM et HP

Votre objectif de devenir la compagnie numéro un dans l'IT entraîne une présence sur des marchés très différents. Les gens vous connaissent comme société dans les réseaux, mais vous avez également une ambition qui va à l'encontre d'acteurs comme HP et IBM. Ce sont des choses très différentes non ? Nous sommes un des acteurs les plus importants aussi bien sur le plan de l'architecture réseau, que dans le domaine de la communication au sens large. Et sur ces points, nous travaillons concomitamment sur la technologie et le commercial. La position de leader a été acquise en enregistrant des très bons résultats sur des marchés en phase de croissance. Même les critiques les plus acerbes, peuvent le reconnaître. Il faut également constater que la première génération de nos concurrents comme SynOptics, Wellfleet, 3Com, Cabletron, n'existent plus et la même chose pourrait nous arriver si nous ne nous adaptons pas aux évolutions du marché. De plus, nous sommes des paranoïaques en imaginant que nous pourrions être à la traîne. Enfin, quand nous avons commencé dans le marché des fournisseurs de services, plusieurs personnes nous ont indiqué notre absence de compréhension des acteurs. La légitimité était du côté de nos concurrents, Nortel, Lucent, Alcatel, Siemens, Ericsson. Nous avons donc pensé comment devenir numéro un sur ce marché et maintenant, nous le sommes. Pour ce faire, la direction prise reposait sur l'architecture à la différence de nos concurrents. Lors du dernier Mobile World Congress à Barcelone, si vous posiez la question quel est votre partenaire le plus efficace en matière d'architecture et pour la distribution des services, nous sommes cités dans la majorité des cas. Une chose impensable il y a encore 5 ou 6 ans. Dans le domaine des datacenters, je n'ai pas voulu entrer en concurrence avec IBM et HP. J'aurais préféré établir un partenariat avec les deux. Mais nous avons décidé, il y a 5 ans maintenant, d'aller vers la virtualisation, et les partenariats envisagés, entraînaient un trop grand partage de notre technologie. Cela revêtait une importance stratégique pour nous, car la question n'est pas de transformer le marché. Je ne m'intéresse pas aux serveurs, je regarde la virtualisation, où vous devez savoir où sont les processeurs, où les informations sont stockées et où résident les applications. Le réseau devient une commodité. Nous avons donc suivi les attentes du marché en nous concentrant sur cette transition et non sur nos concurrents. [[page]] Quel est votre position sur le cloud et pourquoi certaines grandes compagnies n'y vont pas ? Il ne s'agit pas simplement de la question d'y aller. La problématique repose sur la virtualisation et sur le rôle que va jouer le réseau dans tout cela. Nous pensons que le réseau est une pièce centrale et non le datacenter ou le terminal de l'utilisateur final. Il existe plusieurs dispositifs pour recevoir tout type de contenu aussi bien à travers des réseaux sans fils ou filaires à la maison, sur un smartphone Apple, Microsoft ou IBM. De plus, le marché ne se fait plus sur la voix, ni sur la donnée, mais sur la vidéo. Maintenant, nous pouvons dire que c'est une grande période. Mais souvenez-vous, nous avions expliqué il y a quelque temps que la vision devait être globale, voix, vidéo et données. Cette décision a été prise il y a 15 ans et nous avons commencé à construire nos architectures dans cette optique. Comment voyez-vous le déploiement des offres de clouds publics et privés au sein des entreprises ? Peut-on les fédérer ? La perspective sur les clouds privés et publics au sein de l'entreprise doit aboutir in fine à un système de confédération, complétement transparent pour les utilisateurs finaux, les responsables informatiques et autres. Le réseau est au coeur de tout cela. C'est notre démarche quand nous développons des partenariats avec VMware ou EMC et encore plus récemment avec NetApp, en réfléchissant sur des standards ouverts sur ce type de sujet. Nos meilleurs partenaires dans le cloud seront les fournisseurs de services, car ils devront faire vivre leurs tuyaux et éviter que leur réseau ne soit qu'une commodité. La valeur reviendrait alors aux sociétés périphériques ou aux créateurs de contenus. Il me semble que nous avons une opportunité commune. [[page]] Quel sera le plus grand marché au sein des clouds ? Dans un premier temps le marché le plus important sera représenté par le cloud public. Sur le long terme, le privé et la combinaison de ce que l'on appelle la fédération des clouds. Nonobstant, nous développons nos propres clouds et nous nous interfacerons avec d'autres. Vos concurrents mettent en avant que vos solutions sont propriétaires, que répondez-vous ? Les premiers contrats contenaient beaucoup de technologies propriétaires. Nous sommes maintenant devenus une société avec des standards ouverts. Internet est ouvert à tous les terminaux et contenus. Quand nous avons intégré le marché de la téléprésence, nous disposions d'une forte part de marché sur le haut de gamme (64%). Nous avons proposé une norme ouverte et disponible pour l'ensemble des concurrents. A ce que je sache, nous n'avons pas de système d'exploitation propriétaire qui fonctionne sur nos produits. Internet doit être l'interface unique sur des différents terminaux. Cela nous permet d'aller plus vite sur le marché et de protèger nos clients qui ne seront pas bloqués par un OS, un terminal ou un datacenter. Quelle est votre réaction à la critique de l'existence d'une Cisco Tax ? Ce n'est pas très honnête de dire cela. Les clients n'ont pas de problème avec notre politique premium, car si vous ne faites pas ce type de produit, vous ne développez pas de nouveaux produits et ne protégez donc pas les investissements. Est-ce que je crois à la mise en place d'une consolidation industrielle rapide ? Absolument. Est-ce que je crois qu'une part de vos prises de décisions décisives est basée sur notre capacité à innover, à nous adapter au sein d'un marché en pleine évolution à travers des produits qui travaillent ensemble, dans une architecture ouverte ? Oui. Est-ce que les clients doivent payer un tarif premium pour cela ? Oui. Même si je soutiens qu'il ne s'agit pas d'une tarification premium. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |