Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 1171 à 1180.

| < Les 10 documents précédents | Les 10 documents suivants > |

(01/04/2010 17:08:43)

Free Cloud Alliance : union pour un cloud libre

Sur un marché promis à une forte croissance, les différents acteurs s'associent pour développer en commun leur technologie et leur savoir-faire. IELO, Mandriva, Nexedi et TioLive, éditeurs de logiciels libres viennent de créer la Free Cloud Alliance, initiative qui propose une offre globale réunissant Iaas, Paas et Saas.

Ces offres reposent sur différentes briques technologiques, NiftyName Virtual Datacenter de IELO qui est une solution Iaas conçue pour les hautes performances et la haute disponibilité. XS2 de Mandriva permet d'effectuer un stockage réparti des fichiers sur différents serveurs distants. NS2 (Neo Storage Server) de Nexidi apporte la possibilité de stocker des fichiers en mode objet, méthode particulièrement adaptée à l'archivage de grandes bases de données type gouvernementales ou pour l'enregistrement des transactions bancaires. Du même éditeur, Slap Cloud coordonne les ressources sur le cloud en détectant par exemple les machines inactives et fournir plus de puissances à celles qui en ont besoin. Enfin, pour chapeauter tous ces éléments, la plate-forme TioLive optimise les différentes briques pour composer une solution Paas Open Source.

Au-delà l'aspect marketing et de communication de l'annonce de l'initiative, elle a le mérite de remettre la problématique Open Source dans les débats des standards sur le cloud, qu'il soit public ou privé. La réunion des éditeurs démontrent aussi qu'une solution Open Source de bout en bout pour les clouds privés existe et qu'elle répond parfaitement à la volonté de toutes les entreprises, la réduction des coûts.

(...)(01/04/2010 12:31:18)Un datacenter mobile dans les nuages [1er avril ;-)]

La start-up californienne Datacloud vient de lancer son premier centre de calcul mobile destiné à couvrir des besoins ponctuels et localisés en puissance informatique. Le premier exemplaire a été lancé et présenté à la presse à San Francisco, au dessus de la célèbre baie, ce matin. En effet, Datacloud a placé son centre de calcul dans un dirigeable capable de se placer au dessus d'un salon, d'un événement ou de n'importe quelle installation temporaire requérant une forte puissance de calcul. Les équipes au sol sont reliées au centre de calcul par une liaison Wi-Fi classique cryptée, la distance à couvrir étant de fait très faible, permettant ainsi un réel très haut débit.

La conception de datacenters en conteneurs n'est pas neuve et l'offre de Datacloud n'est pas très innovante de ce point de vue. Deux difficultés restaient en fait à gérer : l'alimentation électrique et le refroidissement. L'intelligence de l'offre réside dans la manière de contourner ces difficultés. Le refroidissement repose sur le free-cooling : la température chute en effet considérablement au fur et à mesure de l'élévation en altitude. Si le datacenter chauffe, il suffit donc au dirigeable de monter de quelques centaines de mètres pour bénéficier d'un refroidissement plus important. De ce fait, la climatisation, grosse consommatrice d'énergie, n'est plus nécessaire.

Il reste cependant à alimenter les serveurs eux-mêmes, bien qu'optimisés sur le plan de la consommation énergétique. Le produit de Datacloud utilise pour cela des éoliennes positionnées sur de vastes ailes, des plaques solaires en silicone cristallisé et, enfin, des piles à combustibles à base alcoolique qui se rechargent par les autres alimentations et assurent en fait surtout l'uniformisation de la production électrique.

Encore expérimental, le dirigeable de Datacloud n'a pas de prix publié à ce jour.

Photo D.R. (...)

Plus de datacenters en France pour compenser les emplois délocalisés en Chine ?

A l'heure où la France recherche des prestations à forte valeur ajoutée, afin de contre balancer la fuite des activités à faible valeur ajoutée vers la Chine, ces entreprises proposent de couvrir l'hexagone par des DataCenters. Le Club appelle le gouvernement et les pouvoirs publics à le soutenir et à créer les conditions favorables au développement de ces « usines numériques. » Et il s'appuie également sur le développement du Cloud Computing.

Reste que dans ce domaine, ce n'est pas tant la localisation géographique des murs du DataCenter qui importe pour un centre informatique que la valeur ajoutée apportée dans le management logiciel des ressources informatiques, en offrant de la souplesse et de la réactivité. Et l'on peut disposer par exemple d'un centre informatique en Pologne, mais piloté par des équipes françaises depuis l'hexagone. C'est le savoir faire de ces équipes qui est alors important.

Le Club tient néanmoins à souligner les raisons pour lesquelles il estime que la France est bien positionnée pour héberger des DataCenters :

- une position géostratégique en Europe,

- un prix du m² foncier peu élevé,

- une infrastructure électrique de qualité, au coût peu élevé et faiblement émettrice de CO² (sous entendu : grâce au nucléaire),

- une infrastructure télécom fiable, ouverte à la compétition et bien connectée aux pays principaux acteurs de l'économie numérique,

- une population d'ingénieurs et de techniciens parmi les meilleurs ;

On peut également remarquer, que d'un point de vue réglementaire, l'hébergement de données personnelles est entouré d'un certain nombre de garde-fous stratégiques en France qui devraient rassurer les entreprises les plus paranoïaques (banques, établissements de santé,...). Le Club a édité un document, en anglais, afin d'aider à convaincre les investisseurs internationaux en donnant un détail exhaustif de l'attractivité de la France comme terre d'accueil des datacenters.

Le document peut être téléchargé sur : www.francefordatacenters.fr

Illustration datacenter HP, D.R.

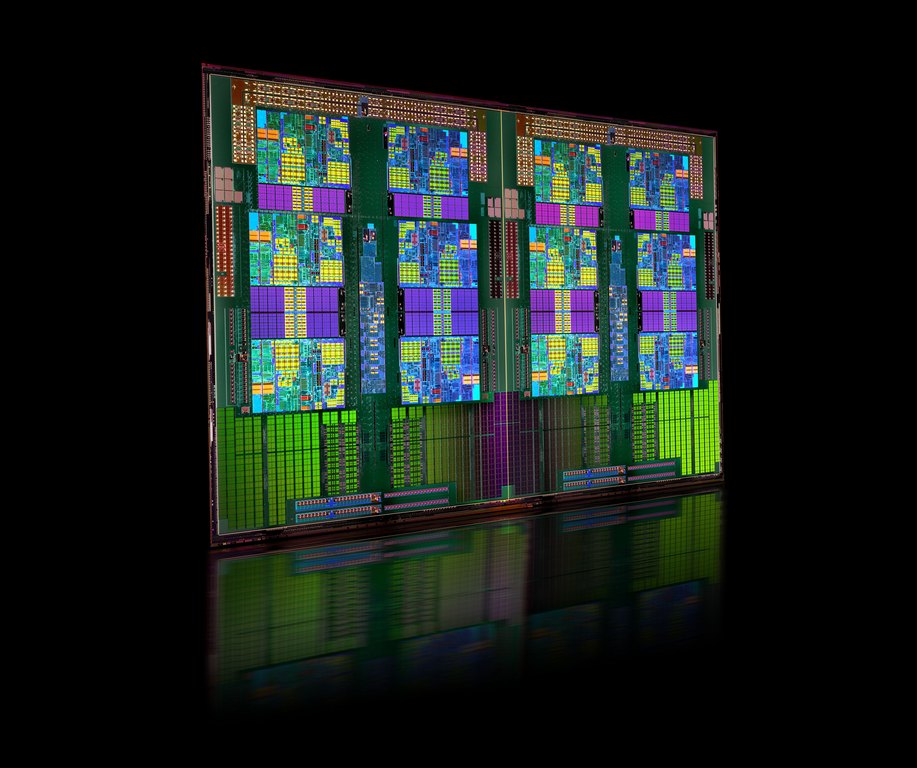

Acer dévoile ses serveurs Opteron 12 coeurs via Gateway

Pour arriver à ses fins, Acer, via sa marque Gateway, a choisi un double challenge. Primo en relancer une marque américaine très grand public qui avait quitté l'hexagone en catimini en 2001, secundo en misant sur la gamme de processeurs AMD Opteron 6100 également connue sous le nom de code Magny-Cours. Le lancement quasi-simultanée des deux produits, processeurs Opteron 6100 et serveurs Gateway, montrent combien les deux compagnies partagent une même vision du marché : « Nos deux entreprises ont un partenariat fort depuis deux ans, et nous voulons continuer à faire beaucoup de choses ensemble » explique Pat Patla, vice-président et manager général d'AMD.

Des solutions pour les PME et les grands comptes

Pour répondre aux besoins des petites entreprises, comme à celles des grandes compagnies, Gateway propose une gamme diversifiée et facilement adaptable en fonction de leurs usages. Il y a 4 familles de produits : les tours (GT) équipés de processeurs AMD Opteron 4000 pour les PME et PMI souhaitant gérer des serveurs de sites Internet, de messagerie e-mail etc. Les racks (GR) 2U avec les processeurs AMD opteron 6100, 12 ou 8 coeurs cadencés respectivement à 2,3 ou 2,4 GHz, et avec un maximum de 512 ou de 128 Go de mémoire. Suivent les racks Gemini (GW) qui sont similaires aux autres modèles GR mais proposent un meilleur rapport densité/consommation par Watt, grâce à une gestion parallèle permettant de cumuler 96 coeurs et 512 Go de Ram dans un seul Rack 2U. Gateway préconise ces derniers pour l'imagerie médicale et la gestion des simulations informatiques.

[[page]]

Enfin la filiale propose des châssis de serveurs blade 'GB7000' ou 'GB7000 F1' pouvant contenir jusqu'à 20 lames serveur bi sockets ou 10 avec quatre voies, et pouvant ainsi atteindre 480 coeurs au total, (avec les opterons 6000). Gateway propose deux types de lame différentes : la GB2x285 F1 intégrant deux sockets dual-node, et la GB685 F1 contenant 4 processeurs. Cette configuration est destinée aux grandes entreprises ayant besoins de centres de calcul, comme pour la gestion de sites d'e-commerce, gestion de business etc. Aujourd'hui, Gateway inclut la gamme de processeurs 6100 avec la plateforme Direct Connect Architecture 2.0 du fondeur, une combinaison qui permet de cumuler jusqu'à 48 coeurs (soit 4 Opteron) et augmente la rapidité des puces entre elles de 33%, grâce aux 4 canaux de mémoire les reliant à 12 barrettes DIMMS et un unique pont entre chaque processeurs.

Avec leur lancement prévu pour le second semestre 2010, Acer entend atteindre 10% de parts de marché des serveurs d'ici fin 2011 avec Gateway, et prévoit de commencer à s'imposer comme une référence en matière de service d'ici 2 à 3 ans, que ce soit du support vente à l'assistance technique, en passant par l'évaluation des besoins d'une entreprise. La marque s'appuiera sur une distribution renforcée « Nous souhaitons atteindre 1 000 revendeurs par pays » explique l'ambitieux e vice-président de Gateway Antonio Antonion Papale. Sur un marché où Dell, HP et IBM se partagent 85% du marché , il sera toutefois difficile pour Acer de bénéficier d'un accélérateur comme le trou d'air provoqué chez les revendeurs par le rachat de Compaq par HP il y a 9 ans. À l'époque, Acer avait habilement manoeuvré pour remplacer Compaq comme troisième fournisseur de PC chez les grossistes tout en misant sur l'essor du marché des notebooks.

Conquérir le coeur des systèmes informatiques des entreprises est une tâche beaucoup plus hardie même avec un allié de poids comme AMD. La bataille se joue en partie sur les prix mais également sur les services d'intégration qui sont devenus le point fort d'IBM avec IGS, de HP avec ES (ex EDS) et depuis peu de Dell avec le rachat récent de Perrot Systems (encore peu présent en France, il est vrai). Acer avance sur ce marché avec son cheval de Troie Gateway mais la seule association avec AMD ne sera pas suffisante pour impacter le marché. Une offre serveurs Gateway sur base Intel apparait inévitable si le taiwanais veux vraiment assoir cette marque dans le monde pro. Une possibilité que les dirigeants de Gateway n'exclue pas si le marché ne fait pas un bon accueil à cette première série de serveurs.

(...)(31/03/2010 18:37:51)

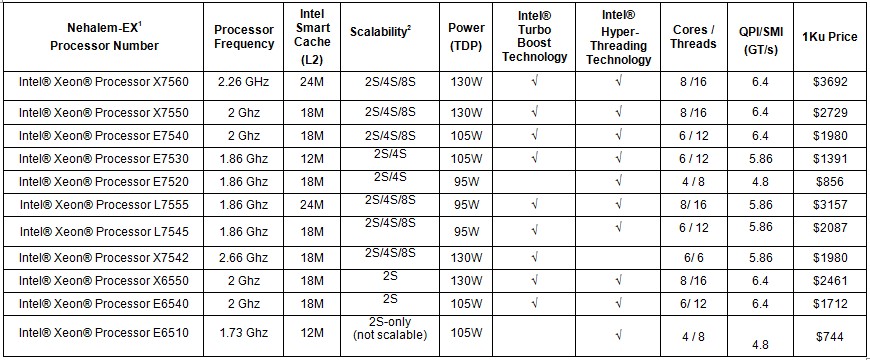

Intel Nehalem-EX : Cap sur la performance et la haute disponibilité

Attendues depuis plusieurs semaines, les puces Intel Xeon Nehalem-EX - avec quatre, six ou huit coeurs - vont permettre aux infrastructures informatiques de passer un cap en matière de performances. Lors d'un entretien, Pascal Lassaigne, directeur du marché entreprises chez Intel France, nous a ainsi expliqué que « jamais le gap d'amélioration n'avait été aussi fort entre deux générations de processeurs. Entre le Xeon 7400, classe Dunnington, et le 7500, sur base Nehalem-EX, les performances sont multipliées en moyenne par 3. Ainsi 100 serveurs monocoeur pourraient être remplacés par 5 machines animées par des Xeon 7500 huit coeurs et dans le cas où ces solutions monocore seraient remplacées par 100 unités Nehalem-EX, les performances seraient multipliées par 20. » Un benchmark réalisé par nos confrères d'InfoWorld a ainsi mis en test un Dell R810 équipé de deux puces Intel X7560 cadencées à 2,26 GHz avec 12 Mo de mémoire cache niveau 3 face à un HP équipé de quatre processeurs X7350 à 2,93 GHz avec 4 Mo de cache. Précisons encore que les Nehalem-EX supportent l'HyperThreading et que les tests ont été réalisés plusieurs fois avec et sans cette fonction. Sans surprise, le serveur Dell a surclassé la précédente génération de puces Intel et même une machine équipée de 4 Opteron 8435 (Istanbul), soit un total de 24 coeurs à 2,6 GHz. Une confrontation avec le dernier née d'AMD, l'Opteron 6100 Magny-Cours est également prévue.

Illustration Dell R810

[[page]]

Pour le lancement de cette plate-forme, Intel insiste particulièrement sur deux points : consolidation des datacenter et réduction de la consommation électrique. Destinés aux serveurs haut de gamme qui nécessitent une grande disponibilité et la capacité d'exécuter des applications critiques comme les bases de données ou des outils d'analyse décisionnelle en temps réel, les serveurs Nehalem-EX arrivent également sur le marché du calcul de haute performance avec des systèmes combinant jusqu'à 256 noeuds. Bull et SGI devraient bientôt présentés des machines de ce type.

« Les processeurs Nehalem-EX devraient aussi inclure un certain nombre de sécurité, de fonctions dédiés à la fiabilité et des améliorations dans la gestion de la mémoire par rapport à la génération précédente » poursuit Pascal Lassaigne d'Intel. Le fondeur de Santa Clara fournit sa plate-forme avec quatre canaux de mémoire pour alimenter les huit coeurs ce qui le met enfin à égalité avec l'Opteron 6100 12 coeurs d'AMD.

One Group Trading, une entreprise de négociation d'options à San Francisco, qui va bientôt recevoir des serveurs Nehalem-EX pour tests, attend un certain nombre de bénéfices avec cette plate-forme. Terence Judkins, DSI de l'entreprise a ainsi témoigné qu'il croyait ce que sera une très bonne mise à jour pour son infrastructure serveurs qui supporte une base de données, des outils d'analyse décisionnelle et des VM. « Les nouveaux serveurs nous permettront de consolider notre groupe de machines et par la même d'économiser l'énergie et les frais de maintenance. Si nous pouvons exécuter avec succès deux tâches sur un seul serveur là où auparavant nous avions besoin de deux machines alors c'est un home run », souligne Terence Judkins.

Cliquez pour agrandir le tableau

[[page]]

« Les fonctionnalités améliorées de Nehalem-EX pourrait également favoriser la montée de l'architecture x86 sur un marché dominé par les puces Intel Itanium et les processeurs à jeu d'instruction RISC (IBM PowerPC et Oracle / Sun Sparc) » estime Jim McGregor, responsable de l'analyse technologique chez In-Stat. Pour sa plate-forme Nehalem-EX, Intel a adapté certaines technologies issues de l'architecture IA-64 Itanium, comme le RAS (fiabilité, disponibilité et facilité de maintenance) afin de réduire la corruption des données et d'améliorer la performance générales des systèmes. D'autres technologies comme le MCA sera capable de détecter les erreurs dans le traitement des données en provenance de la CPU ou de mémoire système et de les corriger en travaillant de concert avec le système d'exploitation. « En apportant les caractéristiques RAS sur l'architecture x86, Intel a jeté de nouvelles bases pour les clients désirant quitter les plates-formes Risc » ajoute Jim McGregor. « Les entreprises ont toujours accepté de payer beaucoup plus chers pour bénéficier des avantages des systèmes basés sur l'architecture Risc, mais l'arrivée des Nehalem-EX qui offrent ces fonctionnalités à un prix nettement inférieur va peut-être changer la donne ». Toutefois, certaines entreprises vont continuer à travailler avec leurs plates-formes Risc ou Itanium pour des raisons de rendement, de solutions logicielles et de familiarité, ajoute-il. HP, par exemple, qui propose à la fois des machines x86 Nehalem-EX et des serveurs Integrity NonStop IA-64, continuera à proposer des puces Itanium pour ceux qui veulent des solutions éprouvées. « Toutefois, l'arrivée de la plate-forme Nehalem-EX offre un véritable avantage concurrentiel en terme de prix qui pourrait accélérer la progression de l'architecture x86 dans les systèmes haut de gamme. C'est un point que nul ne contestera» poursuit Jim McGregor.

L'Intel Nehalem-EX entre également en compétition avec le 12 coeurs Opteron 6100 d'AMD, qui contient le plus grand nombre de coeurs de processeur dans un serveur x86, explique Jim McGregor. Cependant, les puces d'AMD ne sont pas encore capables d'offrir les caractéristiques du Nehalem-EX sur le plan de la tolérance de panne. Mais pour les clients qui recherchent avant tout un bon rapport prix-performance, les Magny-Cours sont une très bonne base pour animer des serveurs classiques dans des environnements non critiques, ajoute-il.

Pour conclure signalons que les constructeurs tels que Dell, NEC, Cray, Cisco et IBM vont proposer des serveurs Nehalem-EX. Dell a déjà annoncé le PowerEdge M910, R910 et R810 serveurs, qui sont animé par des processeurs Nehalem EX. Le serveur R810 est offert à partir de 4999 $, le R910 à partir de 7799 $ et le M910 à partir de 4999 $. NEC, de son coté, commence à prendre les commandes pour l'Express5800/A1080a équipé de huit sockets. Le serveur est annoncé à un prix de 53 000 $ avec une carte mère quatre sockets et 128 Go de mémoire.

(...)(31/03/2010 17:27:52)

Le cloud source de pollution majeure selon Greenpeace

« Le cloud progresse dans une période où le climat change et la réduction des émissions de gaz sont des préoccupations essentielles » souligne le rapport « Make IT Green : Cloud Computing and its Contribution to Climate Change » de Greenpeace. Il explique que « l'accroissement de la demande en cloud provoquera aussi un grand besoin en ressources énergétiques ». A la question sur la quantification de ce besoin, Greenpeace avoue qu'il est difficile à évaluer, mais l'association estime que l'électricité consommée par les datacenters et les réseaux de télécommunications, qui sont les bases du cloud, devrait tripler entre 2007 et 2020.

l'iPad, concentré de cloud

Les grandes sociétés de l'Internet tentent d'améliorer leur efficience énergétique, leur permettant de réduire leur coût opérationnel. Mais Greenpeace souligne qu'elles privilégient le développement de datacenter, là où cela fait du sens, sans se préoccuper des questions énergétiques. Le rapport prend comme point de départ une mise à jour d'un travail sur l'iPad d'Apple, car l'association estime que ce terminal constitue un concentré des usages futurs (téléchargement de vidéos, livres, musiques) basés sur les services de type cloud.

[[page]]

Plusieurs sociétés concentrent l'ire de Greenpeace. Récemment, une campagne a été menée contre Facebook, sur sa décision de construire un datacenter à Prineville dans l'Oregon, tirant son énergie d'une centrale électrique au charbon. Le réseau social considère que le climat de l'Oregon est suffisant pour permettre une climatisation naturelle de ses équipements et n'a jamais favorisé l'utilisation du charbon. Bon point par contre pour Yahoo, qui utilise l'énergie hydroélectrique pour son datacenter dans la banlieue de Buffalo dans l'état de New York. Google et Microsoft travaillent eux sur des datacenters plus respectueux de l'environnement et investissent aussi dans l'éducation des gens en la matière. En 2009, Google, qui produit et commercialise de l'électricité, a proposé 3,7 milliards de dollars sur un plan de 20 ans pour réduire la dépendance énergétique américaine.

Vers des clouds plus vert..ueux

Néanmoins, Greenpeace souhaite que les entreprises Internet évoluent vers l'utilisation d'énergies renouvelables. « Si les fournisseurs de cloud veulent véritablement fournir un service vert, ils doivent orienter leurs investissements vers ces sources d'énergies alternatives, mais aussi s'impliquer davantage dans le débat politique sur ces sujets pour permettre le déploiement rapide de production électrique plus économique et d'accorder une place plus grande dans la R&D sur les systèmes de stockage qui délivrent de l'électricité en continu » (...)

Pour acquérir Bell Microproducts, Avnet met 600 M$ sur la table

Si le monde des éditeurs de logiciels et des constructeurs informatiques a connu durant les derniers mois son lot de fusion et acquisitions, cela n'a pas été le cas depuis longtemps dans celui des grossistes IT. Le distributeur américain Avnet devrait mettre fin à cette période de calme. Il a annoncé lundi sa volonté de racheter son compatriote et homologue Bell Micro pour un montant de 252 M$. La somme représente un bonus de 30% par rapport au cours atteint par l'action Bell Micro le vendredi précédent à Wall Street. Toutefois, l'investissement total consenti par Avnet devrait atteindre 594 M$ pour éponger la dette de sa futur acquisition. Les conseils d'administrations de deux entreprises étant déjà tombés d'accord sur les termes du rachat, il ne reste plus qu'à obtenir le feu vert des actionnaires de Bell Micro et l'autorisation des autorités de régulation américaine. L'opération devrait être finalisée d'ici deux à quatre mois.

Un revenu cumulé de 10 Md$ dans la distribution IT

Grossiste à valeur ajoutée d'envergure international (3 Md$ de CA en 2009), le groupe Avnet distribue des composants électroniques, des produits de stockage et des sous-systèmes. Présente dans une trentaine de pays, dont la France, sa division Avnet Technology Solutions a réalisé lors de son exercice 2009 un chiffre d'affaires de 7 Md$ auprès d'une clientèle de VARs, d'ISV, d'OEM et d'intégrateurs de systèmes.

Distributeur international lui aussi, avec une présence dans 55 pays, dont la France également, Bell Micro se focalise dans le stockage et les serveurs, ainsi que les composants, les périphériques et les logiciels. En Amérique du Nord, deux de ses filiales mènent une activité de revendeur et de prestataire de services. Avnet, qui souhaite rester concentré sur son métier de grossiste, semble peu enclin à les conserver au sein du groupe et indique être à la recherche d'une alternative pour ces entreprises.

Crédits photo Sun Microsystems

[[page]]

« Aux vues de nos présences géographiques et de nos lignes de produits respectives, il peut sembler qu'il y ait un certaines zones de recouvrement entre nos activités, indique Roy Vallee, le président et CEO d'Avnet. Mais quand on y regarde de plus près, elles sont finalement peu nombreuses ».

Par exemple, Bell Micro est fortement implanté dans des pays Européens tels que la Belgique, les Pays-Bas et le Luxembourg. Le grossiste est également implanté en Amérique Latine, un territoire dont Avnet s'est fait une priorité stratégique. Dans le domaine du stockage, Bell Micro devrait également étendre l'activité serveurs et stockage d'Avnet. Ce dernier est, certes, déjà bien implanté sur le marché des disques durs embarqués par les OEM et autres fabricants. Mais Bell Micro bénéficie quant à lui d'une bonne couverture du marché des disques durs vendus nus aux entreprises. Toujours dans le domaine du stockage, Bell Micro dispose d'une forte compétence dans le domaine des data centers, notamment dans l'intégration de systèmes de stockage et de serveurs.

Un groupe d'actionnaire consulte déjà des avocats

Certains revendeurs voient dans l'opération un moyen pour Avnet de réagir à l'acquisition de Sun Microsystems par Oracle. L'activité importante que mène Avnet autour des produits Sun serait en effet menacée par la décision d'Oracle de mettre d'avantage l'accent sur la vente directe. Il semble qu'Oracle n'ait en effet pas l'intention de laisser beaucoup de place à la distribution à valeur ajoutée autour des matériels Sun. Roy Vallee a toutefois contredit cette analyse qui sous-entend qu'Avnet chercherait à diversifier son portefeuille de produits sur la base des décisions prises par Oracle pour les produits Sun. Le patron d'Avnet reconnaît qu'« Oracle va assurer en direct les commandes de matériels Sun à ses plus grands clients et que cela aura forcement un impact négatif. Mais, pour « compenser » cela, Oracle ne souhaite plus traiter en direct avec n'importe quel revendeur. Les Vars de Sun devraient donc revenir à la distribution. En outre, Oracle devrait consolider le nombre des grossistes avec qui il veut traiter au niveau global, et cela devrait jouer en notre faveur. »

Reste maintenant à savoir quelle sera la décision des actionnaires de Bell Micro suite à l'annonce du rachat. Certains d'entre eux ont en tous cas demandé une enquête à un cabinet d'avocats afin de savoir si la vente est le fruit d'un processus équitable et si le prix proposé pour Bell Micro n'est pas sous-évalué.

(...)

Un cloud portatif pour équiper les forces nomades [1er avril ;-)]

Dernière tendance IT, transporter son cloud avec soi. Après le cloud privé, le cloud public ou encore le cloud fédéré, voici venir le cloud portatif. Développée par une alliance regroupant Digital, Compak, Blue Telecom et Big Green, cette plate-forme de services repose sur un ordinateur nomade animé par une distribution et des VM Linux. Une fois déployée, elle permet d'assurer des ressources fédérées à une dizaine d'utilisateurs dans un rayon de 15 mètres.

Certaines entreprises spécialisées dans les transports se sont déjà montrées très intéressées par ce programme. Une solution qui aurait également la faveur des forces armées pour monter rapidement une infrastructure IT sur un champ de bataille. L'armée afghane aurait l'intention d'en commander une centaine pour assurer la liaison avec les troupes enclavées dans des vallées ou sur des plateaux reculées.

(...)(30/03/2010 16:51:19)

Office mobile : Microsoft choisit la prudence

Office Web Apps, la suite bureautique pour Internet de Microsoft, intégrée à la dernière suite bureautique Office 2010 - annoncée pour le 12 mai en version entreprise et courant juin pour le grand public - comprend des versions web gratuites de Word, d'Excel et de PowerPoint. Telle est la parade de Microsoft à l'arrivée massive sur le marché d'outils de productivité signés Google et autres. « Nous devons être les leaders. Nous devons être ceux qui prennent les décisions difficiles, diriger le jeu et amener le marché vers nos produits,» a déclaré Stephen Elop, président de la division Business de Microsoft dans une interview. Car pour l'instant, en matière d'outils de productivité en ligne, Microsoft est plutôt suiveur que meneur.

Une étude datant de 2009, réalisée par le cabinet IDC, fait état d'une utilisation croissante de Google Docs. Elle précise aussi que 20 % des personnes interrogées affirment que la suite de Google est largement utilisée au sein de leur entreprise. Une étude similaire remontant à 2007, montre que Google Docs était à l'époque largement utilisée par 6% des entreprises. Mais Google, arrivé parmi les derniers sur le marché, de plus avec une suite de productivité en ligne maison, n'avait pas fait de tort à Microsoft. Deux ans plus tard, l'étude IDC 2009 montre que l'utilisation croissante de Google Docs dans les entreprises n'a pas eu d'effet négatif sur les parts de marché de Microsoft Office, suggérant que les applications de bureautique sur Internet sont des compléments plutôt que des substituts des suites de productivité classique, du moins pour l'instant.

[[page]]

Mais le rôle des applications de productivité en ligne pourrait changer à mesure que les entreprises se familiarisent avec leur usage et être utilisées en lieu et place des logiciels de bureau. Décrivant les effets du «cloud computing» - un terme fourre-tout employé pour désigner des services de calcul hébergés et offerts via Internet - sur le marché de l'informatique d'entreprise, Stephen Elop les qualifie de modèle de «rupture constructive. » Selon lui, Microsoft a une marge de manoeuvre étroite quand elle réfléchit à la manière dont les applications sont déployées et utilisées. «Quand je pense à ces transformations, je dois le faire d'une façon qui tienne compte et qui permette aux 500 millions de clients de Microsoft Office de nous suivre. Il faut s'interroger sur le nombre de personnes, leur lieu de travail, comment elles utilisent ce produit quotidiennement et avec quelle fréquence,» a expliqué Stephen Elop.

La large base d'utilisateurs d'Office représente incontestablement une source essentielle de revenus pour Microsoft. En 2009, les ventes d'Office ont dépassé 17 milliards de dollars, soit près de 30 pour cent des recettes globales de l'entreprise. Par conséquent, Microsoft veut être sûr que les nouvelles versions de Microsoft Office disponibles en ligne ou pouvant être utilisées depuis des téléphones portables ne remettent pas en cause ces bénéfices. «La nécessité d'une telle expérience, doit, sans aucun doute, être au moins, du même niveau que tout ce que les gens connaissent déjà, » a déclaré Stephen Elop. Dans la manière dont Microsoft voit évoluer les applications de productivité, les utilisateurs pourront modifier et déplacer des documents entre leurs ordinateurs personnels, Internet et des dispositifs mobiles, sans rien perdre de la mise en forme ou de la structure des documents.

[[page]]

« La meilleure combinaison possible sera celle qui permet une expérience transparente entre le PC, le téléphone portable, et le navigateur internet, » a déclaré Stephen Elop. « Les versions mobiles de Microsoft Office pour téléphones tournant sous Windows seront disponibles un peu plus tard cette année, ainsi que pour les smartphones Nokia tournant sous Symbian, » a t-il indiqué. Il a même prédit que, dans les années à venir, 200 à 300 millions de mobiles Nokia seront livrés avec une version d'Office mobile.

Pour l'instant, Microsoft n'a pas de plans pour proposer des versions mobiles de Microsoft Office pour les BlackBerry de Rim ou pour l'iPhone d'Apple. Microsoft n'a pas non plus l'intention de développer une version d'Office pour le système d'exploitation MeeGo, une combinaison des systèmes d'exploitation Maemo de Nokia et Moblin d'Intel. « Nous réfléchissons sérieusement à la stratégie à mener en fonction des appareils, et à quel moment la mettre en oeuvre, parce que nos options sont limitées, » a déclaré Stephen Elop. «A mesure que nous avançons, nous considérerons aussi d'autres environnements. Mais nous savons, sans ambiguïté, que nous devons examiner chaque plate-forme. Nos clients nous l'indiquent et l'attendent de nous, » a t-il conclu.

(...)(30/03/2010 16:36:11)Red Hat fait évoluer la virtualisation du poste de travail

La version beta 2.2 de RHEV intègre plusieurs évolutions qui permettront aux clients d'activer des architectures VDI (Virtualization Dekstop Infrastructure). « Elles faciliteront le déploiement d'un OS, Red Hat Linux, Windows XP ou 7 sur une plateforme sécurisée d'un hyperviseur haute performance » explique Andrew Cathrow, responsable senior du marketing produit chez Red Hat et d'ajouter « en utilisant un VDI, vous déplacez le système d'exploitation du terminal de l'utilisateur final au sein du datacenter, ce qui en facilite la gestion ». Les applications proposées par l'éditeur tournent avec une console de gestion de la virtualisation, un hyperviseur Bare Metal, basé sur KVM (Kernell-based Virtual Machine). Si ce dernier comprend l'OS Red Hat Entreprise Linux, RHEV peut également fonctionner avec d'autres OS hébergés Windows ou Linux.

Les évolutions intègrent SPICE (Simple Protocol for Independent Computing Environnements) pour le contrôle des postes de travail distants. L'éditeur a acquis cette compétence en rachetant en 2008 la société Qumranet. Le package inclut également un gestionnaire de connexions, un portail web, etc. L'objectif de la version 2.2 pour Andrew Cathrow est que « les clients disposent d'une plateforme commune et non plus d'un outil pour le poste de travail et d'un autre pour les serveurs ».

[[page]]

De la conversion KVM à l'extension mémoire

Parmi les autres fonctionnalités, on retrouve la possibilité d'importer des machines virtuelles depuis la plateforme, comme celles proposées par VMware, Citrix et Microsoft. Pour ce faire, RHEV utilise OVF (Open Virtualization Format), un standard ouvert pour les images de VM. Il s'agit de la première intégration du logiciel de conversion, V2V, qui permet de transformer des machines sous VMware ou Xen, créées sous Red Hat Entreprise Linux en machine KVM. L'environnement Windows devrait aussi prochainement être concerné par cet outil de conversion. Les évolutions comprennent également une fonction d'entreposage des données pour surveiller les performances et les usages des machines virtuelles. Sur le plan des performances, Red Hat a fait évoluer la mémoire maximale supportée des machines virtuelles de 64 Go à 256 Go et de 8 à 16 processeurs virtuels. Il pourra donc prendre en compte les derniers processeurs Xeon Nehalem-EX d'Intel et Opteron d'AMD. Ces extensions doivent faciliter le déploiement d'un nombre plus large d'applications au sein des entreprises, comme les progiciels SAP, sur une seule machine.

Si le responsable n'a pas donné les prix de la version 2.2, la précédente était à 499 dollars par socket pour l'édition Standard et 799 dollars par socket pour l'édition Premium. Les clients ayant déjà souscrits à la version 2.1 migreront vers la nouvelle version sans coût supplémentaire.

(...)| < Les 10 documents précédents | Les 10 documents suivants > |