Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 801 à 810.

| < Les 10 documents précédents | Les 10 documents suivants > |

(27/10/2010 16:40:46)

Hyper-V de Microsoft accompagne le développement d'OpenStack

« Cette association répond à la fois à la transformation de la plate-forme Hyper-V vers la prise en charge des environnements Open Source, mais aussi aux évolutions des clouds » souligne Alfonso Castro, directeur de la nouvelle stratégie Interopérabilité de Microsoft France. Concrètement, l'éditeur fournira des conseils techniques et d'architecture à Cloud.com. De son côté, Cloud.com développera le code supportant OpenStack sur Windows Server 2008 R2 Hyper-V. Le code du projet sera finalement enregistré dans l'annuaire de code public http://openstack.org. Pour autant précise Alfonso Castro, « il s'agit d'un transfert de technologie, nous mettons à disposition des ressources humaines et techniques, mais en aucun cas nous ne délivrons le code source de notre produit ».

Sur le plan des hyperviseurs, OpenStack est déjà compatible avec Xen, KVM et QEMU.

OpenStack a annoncé la semaine dernière les premiers éléments de ses travaux qui prendront leur essor en 2011. Ce projet est soutenu par de nombreux industriels, dont la NASA qui apporte son savoir-faire sur plusieurs briques technologiques. Cette dernière a rappelé d'ailleurs récemment que son objectif était d'améliorer la conquête spatiale et non devenir un fournisseur de cloud.

Apple termine un datacenter de 46 000 m² en Caroline du Nord

Le site Data Center Knowledge a publié des photos aériennes du nouveau centre de calcul d'Apple à Maiden en Caroline du Nord. C'est un agent immobilier de la ville de Charlotte, Jason Wagenseller, qui a le premier pris des clichés et une vidéo de ce idatacenter depuis un hélico. D'une surface totale de 46 452 m²(500 000 square feet) contre 9 300 m² environ (109 000 foot feet) pour celui de Newark en Californie, ce centre de calcul héberge, selon les informations fournies par Apple, des systèmes MacOS X, IBM/AIX, Linux et Sun/Solaris. Pour garantir une haute disponibilité, cette installation intègre des solutions Veritas Cluster Server, Oracle DataGuard et Real Application Clusters. Les infrastructures réseau sont quant à elles fournies par Brocade et Qlogic. Détail intéressant, les personnes postulant à un emploi dans ce idatacenter doivent être familières avec les solutions de stockage proposées par IBM, NetApp et Data Domain, et les solutions d'analyse de données de Teradata.

Signalons enfin que sur le cliché pris par Jason Wagenseller on voit nettement des travaux de terrassement qui laisse supposer des aménagements pour un deuxième datacenter sur le site.

(...)(26/10/2010 16:50:47)

IBM veut apporter plus de sécurité dans le cloud

Si la sécurité est aujourd'hui une des principales préoccupations des directeurs informatiques, qui sont ou qui vont passer au cloud (voir étude PAC), la gestion de ces plates-formes complexes demande une certaine expertise. Pour accompagner les entreprises dans leur réflexion cloud ou renforcer la sécurité des plates-formes déjà déployées, IBM propose deux services baptisés Cloud Security Roadmap et Cloud Security Assessment. Proposées par la division GTS d'IBM, ces solutions bénéficient de toute l'expérience de Big Blue. Selon Loic Guezo, directeur technique sécurité chez IBM ISS France, « ces offres se veulent innovantes et sont déconnectées de nos propositions matérielles et logicielles. Nous avons mis en oeuvre de bonnes pratiques développées par l'activité infogérance que nous proposons aujourd'hui aux entreprises ». L'offre Cloud Security Roadmap par exemple repose sur des experts en sécurité pour contrôler la conformité, la réponse aux menaces ou la gestion du stockage de données en externe. Pour mener à bien ces missions, IBM a investi 300 millions d'euros dans la rénovation de ses datacenters français, dont le plus gros est à Montpellier.

Les chercheurs des laboratoires de Watson et de Zurich travaillent sur une grande variété de projets pour explorer les différentes façons de renforcer la sécurité des clouds en améliorant notamment l'intégrité et la restauration des données ainsi que le cloisonnement des clients dans un cloud public. Les chercheurs d'IBM ont par exemple développé un outil baptisé Virtual Data Center, qui donne aux clients la possibilité d'isoler hermétiquement les données de deux entreprises qui partagent les mêmes systèmes dans un environnement virtualisé.

Un portier pour machines virtuelles

En complément, IBM dévoile également Virtual Doorman une solution de sécurité développée pour l'hyperviseur ESX de VMware. Proposé par la division Internet Security Services (ISS), ce système s'intègre parfaitement avec les API du superviseur pour contrôler les flux et l'intégrité des machines virtuelles lorsqu'elles sont montées ou lors d'une VMotion, nous explique Loic Guézo. La détection de rootkits est également au programme pour contrer les attaques malveillantes sur les datacenters virtualisés. Appelé Virtual Protection System, le logiciel fonctionne en dehors de la

machine virtuelle et peut identifier les logiciels malveillants lorsqu'il est installé dans l'une des machines virtuelles sur le serveur. Parce que le système fonctionne en dehors des VM de la machine, il peut détecter des problèmes difficiles à identifier tels que les rootkits. Il permet également aux administrateurs d'utiliser un seul produit pour surveiller plusieurs machines virtuelles. IBM compare son système à un portier virtuel pour le cloud, qui maintient les indésirables à bonne distance des VM. «La facturation est calculée en focntion du nombre de machines virtuelles » conclut Loic Guezo.

Illustration : Loic Guezo, directeur technique sécurité chez IBM ISS France

Mainframes : 57% des utilisateurs voient croître le nombre de Mips

Conduite auprès de 1 700 utilisateurs de mainframes, la dernière enquête réalisée par BMC Software montre d'abord que 84% des personnes interrogées s'attendent à voir progresser ou se maintenir le nombre de Mips (million d'instructions par seconde) sur ces plateformes. Ensuite, 57% estiment que ces environnements vont continuer à attirer de nouvelles charges de travail contre 4% seulement jugeant qu'ils ne sont pas viables et que leurs utilisateurs devraient songer à changer de stratégie dans les cinq ans. Un peu plus du tiers restant de l'échantillon (37%) considère qu'il s'agit d'une plateforme viable à long terme mais qu'elle se limitera aux applications existantes et n'en attirera pas de nouvelles.

Cliquer ici pour agrandir l'image

Ceux qui augmentent leur consommation de Mips invoquent d'abord la disponibilité de la plateforme (74%) comme principale raison à cela, puis sa robustesse sur le plan de la sécurité (70%) et l'environnement centralisé qu'elle procure (68%). Ils jugent aussi qu'elle est mieux adaptée aux exigences des débits transactionnels (65%). Lorsqu'on leur demande quelles sont leurs priorités sur l'année qui vient, ils sont 65% à citer la réduction des coûts informatiques. Ils énumèrent ensuite la reprise après sinistre (34%), la modernisation des applications (30%) et l'alignement entre les activités métiers avec la IT (29%).

Des outils d'administration pour les plateformes mixtes

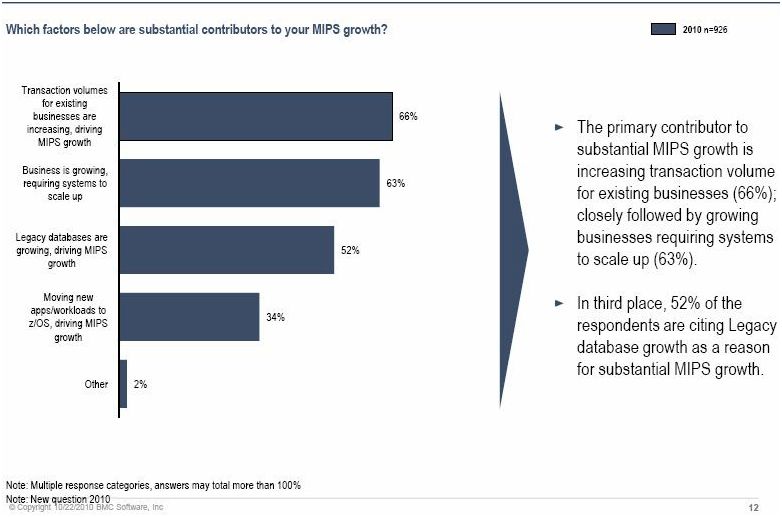

L'augmentation de la consommation de Mips est principalement causée par celles des volumes transactionnels sur les activités existantes (à 66%), par le développement de l'activité (63%) et, enfin, par l'augmentation des bases de données existantes (52%). Le transfert de nouveaux traitements vers les environnements zOS est également cité par 34% des personnes sondées.

Cliquer ici pour agrandir l'image

Prêchant pour sa paroisse, BMC Software fait également apparaître la demande des utilisateurs pour des outils d'administration capables de prendre en charge des environnements mixtes faisant tourner à la fois z/OS et z/Linux, et éventuellement d'autres OS à venir. A ce sujet, son enquête détaille le recours aux processeurs spécialisés : zIIP (System z Integrated Information Processor) originellement utilisé pour les tâches liés à DB2 et qui s'est depuis étendu à d'autres domaines, IFL (Integrated Facility for Linux) pour les traitements sous Linux, et zAAP (System z Application Assist Processor) pour les flux Java et XML. Les utilisateurs de mainframes interrogés sont 32% à utiliser un ou deux processeurs zIIP, 20% à recourir à un ou deux processeurs zAAP et 29%, un ou deux processeurs IFL. De 7 à 9% exploitent 3 à 4 de ces processeurs, 5% de 5 à 8, 3% de 9 à 16 et environ 3% plus de 17. Ces moteurs ne sont pas tellement utilisés pour les nouvelles applications, rappelle BMC.

70% des personnes interrogées dans le cadre de cette enquête appartiennent à des entreprises situées sur le continent américain, 21% sont installées sur la zone EMEA et 9 en Asie Pacifique. Un tiers ne sont pas des clients de BMC Software. (...)

La Cnav choisit une démarche projet basée sur la virtualisation d'applications

Pour centraliser son informatique et mutualiser l'ensemble des fonctions pour la totalité de ses postes de travail (sièges régionaux, agences locales points d'accueil) la Caisse Nationale d'Assurance Vieillesse (Cnav) a mis en place la solution de virtualisation d'applications Citrix XenApp. « L'environnement technique de la Cnav fonctionnait auparavant d'une manière extrêmement décentralisée, à travers 20 centres de productions régionaux », expose Serge Lamproux, architecte national de la Cnav et responsable du département informatique Carsat (Caisse d'assurance retraite et de la santé au travail)

des pays de la Loire. Le système d'information reposait, à la fin des années 1990, sur une architecture client serveur (sous Powerbuilder avec des bases de données Oracle). Des serveurs, des applications et des données embarquées étaient alors déployés dans toutes les régions Au final, l'architecture et le déploiement étaient devenus complexes et les temps de réponse, très élevés. Il s'agissait donc, pour la DSI de répondre à plusieurs problématiques : « Nous souhaitions être équipés de versions de produits pouvant être déployées plus rapidement et ayant des performances acceptables sans contraintes fortes au niveau du poste de travail », souligne Serge Lamproux et d'ajouter : « il s'agissait également de réduire les coûts d'administration, de faire en sorte que les différentes technologies cohabitent, tout en améliorant la qualité des services.»

Des temps de réponse diminués

Plusieurs solutions technologiques ont été étudiées, notamment l'ajout dans toutes les agences locales de serveurs AIX et de bases de données Oracle. Mais cette alternative fut abandonnée en raison de son coût, et trop consommatrice en ressources informatiques, sans amélioration significative des performances. Le passage à la solution XenApp de Citrix a permis d'établir un système d'accès au SI pour tous, avec toutes les applications de la branche retraite fonctionnant sur une même plate-forme. Les temps de réponse ont globalement été divisés par deux ou trois, sans accroître les débits du réseau.

7 M€ d'investissements sur trois ans

La suppression des serveurs locaux a représenté une économie importante. Parallèlement, le cycle de vie des postes de travail s'est allongé de 66%. Ils sont aujourd'hui remplacés en moyenne tous les cinq ans alors qu'ils étaient considérés comme obsolètes tous les trois ans sous l'ancienne architecture. L'investissement global autour de Citrix s'est porté à 7 millions d'euros sur trois ans, contre 8,7 millions pour une architecture classique. Du côté des gains, la non migration massive de l'OS des postes de travail et des mises à niveau associées a permis à l'organisme d'économiser 2,5 millions d'euros. Le fait de ne pas avoir à doubler les liaisons réseau entre le siège de la caisse et les agences a également contribuer à économiser un million d'euros. L'informatique régionale a été conservée dans les 20 sites de la Cnav, passant d'un schéma de 8 centres de production, à un total de deux centres au final.

Illustration : Serge Lamproux, architecte national de la Cnav a piloté le projet de serveurs d'applications reposant sur la plate-forme XenApp. Crédit photo : D.R

(...)

BT dévoile son offre cloud Virtual DataCenter

Les annonces des opérateurs télécoms se suivent, mais ne se ressemblent pas toutes. BT vient en effet d'annoncer son offre de cloud computing, nommée Virtual DataCenter (VDC). Bruno Fleisch, responsable du pôle IT et Services de BT France revient sur l'historique de ce produit « VDC est une offre globale qui existe depuis des années pour une utilisation interne à BT. Le 1er avril 2010, BT a décidé de commercialiser ce service, puis le 1er juillet dernier, il a été lancé en France, mais reposait sur une datacenter en Angleterre ». La nouveauté de la récente annonce est que VDC est maintenant disponible sur une plate-forme en France. BT dispose de 4 datacenters dont 2 en propre et 2 en location chez Interxion, VDC repose sur une de ces derniers. Ce choix d'un emplacement local répond à deux problématiques souligne Bruno Fleisch « des questions techniques, car la proximité apporte des améliorations en termes de bande passante et des impératifs législatifs pour la localisation des données ».

Une puissance de calcul dédiée

La plate-forme VDC repose techniquement sur les solutions VMware, Cisco et NetApp pour la partie stockage. Elle est complétée par HP pour la partie calcul. Bruno Fleisch a souhaité que l'offre soit lisible et s'établisse en fonction de la demande. Les prix débutent à partir de 180 euros par mois et par machine virtuelle, sur des contrats de 3 mois, 1 an ou 3 ans. Pour se différencier des autres opérateurs qui se lancent dans l'aventure cloud, le responsable précise que « BT propose de la puissance CPU dédiée pour chaque client et non du calcul mutualisé, afin de se prémunir contre certaines perturbations et de paramétrer le niveau de contention ». Le modèle de distribution de l'offre VDC qui sera disponible à la fin du mois de novembre se fera via un portail web, mais également dans un package comprenant un service d'infogérance. Traditionnellement orienté vers les sociétés du CAC40, BT entend bien également toucher le mid market et va travailler avec des éditeurs de logiciels pour proposer sa solution en mode SaaS. Bruno Fleisch ne rend pas public les objectifs souhaités sur VDC, mais pense moins gagner des clients qu'accompagner ses clients existants vers la transformation de leurs usages informatiques.

Amazon propose un accès gratuit à son cloud EC2

A dater du 1er novembre, Amazon Web Services lance une offre gratuite que l'on pourrait qualifier de « découverte ». Celle-ci s'adresse en effet à de nouveaux clients qui voudraient faire leurs premières armes dans le cloud pour exploiter des applications, en développer, en tester ou pour des actions de formation.

Amazon leur propose d'accéder, pendant un an, à une « micro instance » sur sa plateforme de cloud EC2, ainsi qu'à d'autres services. Cela inclut 750 heures d'utilisation par mois d'une instance sous Linux (32 ou 64 bit) comportant 613 Mo mémoire, complétée de 750 heures d'utilisation mensuelle de l'outil d'équilibrage de charge Elastic Load Balancer, avec un flux de données traitées de 15 Go. S'y ajoutent plusieurs espaces de stockage dont 10 Go sur Amazon Elastic Block Storage (avec un million de requêtes entrées/sorties) et 5 Go sur Amazon S3 (Simple Storage Solution). (...)

VMware présente Spring comme le principal framework Java

Oracle peut bien détenir la marque Java, cela n'empêche nullement VMware de présenter son propre framework Spring comme le meilleur modèle de programmation pour les développeurs Java dans les entreprises. « Sur le plan de l'innovation, je pense que Spring joue un rôle de premier plan », considère Rod Johnson, qui fut à l'origine de la première version du framework et qui est maintenant vice président senior et directeur général de la division des produits SpringSource chez VMware.

Il y a au moins une autre société qui partage l'enthousiasme de VMware, c'est Google. Le groupe de Sergey Brin et Larry Page a choisi Spring comme modèle de programmation pour Google App Engine, sa plateforme de conception et de déploiement d'applications hébergée sur ses serveurs. Sur la conférence développeurs SpringOne G2X, qui s'est tenue cette semaine à Chicago, les deux fournisseurs ont annoncé qu'ils avaient procédé à différentes intégrations entre Spring, Google App Engine et les outils GWT (Google Web Toolkit). Ces derniers permettent de développer sous Java des applications Ajax. A cette occasion, Rod Johnson s'est fait un malin plaisir de rappeler que Google s'était retiré de la conférence JavaOne en septembre dernier, alors qu'il était, cette fois, l'un des sponsors principaux de SpringOne.

Brad Abrams, responsable produit de la division des outils de développement chez Google, explique que son groupe a voulu identifier les tendances auprès des clients. « Nous leur avons parlé afin de savoir avec quels outils s'écrivaient les nouvelles applications, parce que c'est là que se trouvent les gisements de croissance pour App Engine. Et nous avons ressenti que Spring était vraiment une bonne plateforme. »

Bientôt un plug-in pour déployer sur App Engine

Tout le monde n'est pas aussi convaincu que Spring représente le futur du développement Java pour l'entreprise. Red Hat, par exemple, s'interroge carrément sur l'intérêt de ce framework. « La dernière itération de Java offre une architecture standard simple qui peut réduire les temps de développement en proposant une plateforme ouverte, ce qui rend inutile le recours à des frameworks comme Spring », écrit ainsi Ashesh Badani, directeur senior de l'offre JBoss Entreprise Middleware chez Red Hat, dans un récent billet de blog.

Né sous la forme d'un projet Open Source, le framework Spring a été conçu pour aider les développeurs à structurer rapidement des applications Java, en particulier pour le web, d'une façon qui soit cohérente du point de vue de l'architecture. Depuis son lancement, en 2002, il a pris de l'ampleur jusqu'à devenir l'un des frameworks Java les plus largement utilisés. Et en 2009, VMware rachetait la société de Rod Johnson.

Sur SpringOne, VMware et Google ont présenté les premiers fruits de leur travail conjoint (les deux sociétés ont commencé à travailler ensemble au printemps dernier). D'ici deux semaines, un plug-in pour la SpringSource Tool Suite permettra aux développeurs de déployer leurs applications sur App Engine. La plateforme de Google n'utilise qu'un sous-ensemble des interfaces de programmation (API) Java existantes. Google travaille donc pour faire en sorte que toutes les API utilisées par Spring soient disponibles dans App Engine, a notamment expliqué Brad Abrams.

Le GWT intégré avec Spring Roo

Par ailleurs, le GWT a été intégré à Spring Roo, un outil qui produit du code Spring en conformité avec les pré-requis de sécurité et avec d'autres points. « Désormais, Roo peut générer une application cliente Internet riche en utilisant le GWT », a confirmé le responsable des outils de développement de Google. Enfin, les outils d'analyse de performance de chacun des éditeurs sont maintenant associés. Ainsi, Speed Tracer, que l'on trouve dans le navigateur Chrome, a été adjoint à l'outil Spring Insight, inclus dans la SpringSource Tool Suite.

Alors que VMware présente Spring avant tout comme une solution de développement pour des applications exploitées dans le cloud, Rod Johnson rappelle que le framework a acquis sa notoriété en tant qu'alternative aux Enterprise Java Beans de Java EE utilisés pour le développement d'applications d'entreprise. Deux millions et demi de développeurs utiliseraient actuellement le framework Spring, selon son éditeur. « De façon générale, la communauté Open Source a repris la main sur les équipes techniques d'Oracle, considère Rod Johnson. Spring a pris le dessus sur les EJB il y a plusieurs années déjà et continue à prendre de l'ascendant ».

Spring, alternative légère à JEE ?

[[page]]

Spring, alternative légère à JEE ?

Les ingénieurs de Red Hat, pourtant, estiment que la dernière version de Java Enterprise Edition, JEE 6, permet de se passer de frameworks tels que Spring. En particulier, elle inclut la spécification JSR (Java Specification Requests) 299 qui couvre le découplage de composants logiciels (dependency injection). La prise en compte du contexte et le « dependency injection » figurent de fait parmi les principales fonctionnalités de Spring.

Pour appuyer cet argument, Ashesh Badani, de Red Hat, renvoie vers une note de Lincoln Baxter, de l'équipe de développement JBoss, portant sur la migration d'une application de Spring vers Java EE 6 (). « Le framework Spring apparait comme une alternative légère à Java EE qui s'était alourdi et était devenu complexe, peut-on y lire. En fait, utiliser Java EE peut s'avérer plus simple que recourir à Spring et prendre moins de temps. Il faut juste trouver la bonne documentation. »

Le patron de SpringSource a reconnu que Java EE 6 avait emprunté quelques idées à Spring et que sa dernière version était plus simple à utiliser que la précédente (dont la complexité avait attiré des développeurs vers Spring). Malgré tout, Java EE 6 ne dispose pas encore de toutes les fonctionnalités de son challenger, tel qu'un framework web à part entière, ou encore un outil d'amélioration de la productivité tels que Roo. Par ailleurs, Rod Johnson rappelle que Java EE 6 n'est pas encore mis en oeuvre sur l'ensemble des serveurs d'application. Certes, JBoss le supporte, mais pas encore WebSphere, d'IBM. Quant au serveur d'application Open Source Tomcat, il ne prend en compte qu'une partie des fonctionnalités de cette v.6.

« Je ne crois pas qu'il faille comparer point à point les modèles de programmation de Java EE et de Spring », a toutefois conclu Rod Johnson en ajoutant que pour une large majorité des mises en production actuelles, on ne pouvait pas non plus considérer Java EE comme une alternative à Spring.

Illustration : Rod Johnson, vice président senior et directeur général de la division des produits SpringSource chez VMware (crédit photo : D.R.) (...)

OpenStack, le projet de cloud Open Source, progresse

La mise à jour du code du projet surnommé « Austin » est disponible, soit trois mois après le lancement de l'aventure. OpenStack comprend le code qui alimente Cloud Files de Rackspace et la technologie Cloud Servers, ainsi que les logiciels développés par la NASA pour sa plate-forme cloud, Nebula. Une composante initiale basée sur Cloud Files, OpenStack Object Storage, avait été publiée en juillet. La mise à jour « Austin » améliore le déploiement, corrige des bugs et ajoute certaines fonctionnalités, comme un analyseur de statistiques et un meilleur contrôle d'accès. Un autre élément, appelé OpenStack Compute, moteur de provisioning construit avec le code de Cloud Servers et Nebula est maintenant disponible pour les essais et prototypes au sein d'Austin.

Ce projet Open Source, qui est disponible sous la licence Apache 2.0, est considéré par certains comme une alternative aux plates-formes de cloud propriétaires comme EC2 d'Amazon (Elastic Compute Cloud), ainsi qu'à la profusion d'offres des fournisseurs pour la création de clouds privés.

Rackspace souligne qu'il n'a aucun intérêt à intégrer le secteur des logiciels, préférant gagner des clients sur la qualité de son service d'hébergement. Par conséquent, la société estime que se tourner vers la technologie Open Source a du sens, car l'entreprise bénéficiera des développements menés par une communauté.

Des soutiens de poids

Rackspace et la NASA ne font pas cavalier seul. Le projet bénéficie du soutien d'AMD, Intel, Dell, Citrix et de dizaines de petites entreprises qui développent des services de gestion de surveillance de cloud et d'autres outils. Pour les fondeurs, ce projet les intéresse car ils sont à la recherche d'acteurs dans le domaine des plates-formes logicielles en complément de leurs puces qui équipent les datacenters.

SAP, pour sa part, annoncé une série d'initiatives pour fabriquer des clouds privés, à la fois grâce à des outils en propre, mais également via des partenariats avec IBM, Hewlett-Packard, Cisco Systems, EMC et VMware. Les fournisseurs tels que SAP sont plus enclins à collaborer avec d'autres acteurs établis, mais cela pourrait changer si de grands groupes poussent OpenStack comme outil de création de clouds privés, souligne Michael Coté, analyste chez Redmonk

Pendant ce temps, les contributeurs à OpenStack sont déjà tournés vers la prochaine itération prévue pour janvier 2011, dont le nom de code est « Bexar ». Ce sera un sujet de discussion lors d'un « Design Summit » prévu lui en novembre prochain.

| < Les 10 documents précédents | Les 10 documents suivants > |