Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 971 à 980.

| < Les 10 documents précédents | Les 10 documents suivants > |

(23/07/2010 15:35:45)

Microsoft renforce sa collaboration avec ARM

Dans le domaine de la mobilité ou des technologies embarquées, les processeurs ont une grande importance et ARM bénéficie d'une expertise dominante. Microsoft qui avait déjà des relations avec le constructeur vient d'annoncer la signature d'un accord de licence technologique sur l'architecture des puces.

Pour Ian Drew, vice-président marketing d'ARM « ce type de partenariat ouvre la voie à la création de votre propre micro architecture ». Seulement quelques sociétés ont signé des licences similaires, Qualcomm, Marvell Technology et Infineon.

Sur le plan stratégique, cet accord démontre la volonté de la firme de Redmond d'assurer une plus grande convergence entre logiciels et composants. Le choix d'ARM n'est pas non plus innocent, car le constructeur de microprocesseurs est très présent sur les smartphones ou les tablettes. Cette annonce intervient à un moment où Microsoft joue gros sur le développement de Windows Phone 7. La concurrence comme Apple utilise déjà les bénéfices de l'architecture ARM.

La virtualisation plus concrète et plus attractive que le cloud

La virtualisation facilite la consolidation et la maintenance d'un ensemble de serveurs. Elle justifie ainsi des coûts élevés par rapport à des évolutions matérielles conséquents. " L'un de nos clients a pu justifier un renouvellement de serveurs, car il n'avait pas besoin de payer des licences serveurs VMware supplémentaires " a déclaré Chris Wolf, analyste infrastructures au Gartner. " Ils se sont équipés de serveurs à 12 coeurs pour remplacer des serveurs 4 coeurs et peuvent désormais exécuter plus de machines virtuelles sur moins de serveurs, représentant ainsi des économies importantes."

Paul McWilliams, rédacteur en chef de NextInnings.com, un site financier axé sur les investissements technologiques souligne que " la plupart des technologies de rupture aboutissent à d'importantes économies uniquement lors de la première implémentation. Toutefois, l'amélioration de la puissance des serveurs x86, de meilleurs mécanismes d'accélération des serveurs virtuels à base de processeurs Intel et AMD, ajouté au nombre croissant de produits spécifiquement conçus pour les machines virtuelles, autorisent des réductions de coûts, même pour la seconde ou la troisième génération d'infrastructures virtuelles." Il ajoute que " si la première génération de solutions de virtualisation était concentrée sur les processeurs, aujourd'hui, elles s'étendent au niveau matériel, réseaux et stockage pour travailler plus efficacement."

Une sémantique difficile à appréhender

Un rapport d'IDC publié en juin estimait qu'en 2009 les services Cloud comptaient pour 16 milliards de dollars dans les 2,5 trilliards de dollars de dépenses mondiales consacrées à l'informatique, prévoyant que ce chiffre atteindrait les 55,5 milliards de dollars d'ici à 2014, soit 12% de toutes les dépenses en IT. Pour sa part, un rapport publié le 6 juillet par Forrester Research indique que "nombre de clients prêts à investir dans le Cloud Computing et les technologies afférentes, souffrent de la confusion qui règne autour du Cloud."

Crédit Photo: D.R

[[page]]

Selon ses conclusions, le trouble vient d'une part des fournisseurs qui appliquent le terme " cloud " à tous les produits de leur catalogue, d'autre part de l'incapacité des vendeurs à expliquer clairement les avantages de cette technologie. " De nombreuses entreprises hésitent à se lancer dans le cloud computing. Au contraire, ils connaissent les avantages concrets qu'ils peuvent tirer des technologies de virtualisation sur lequel les services cloud devraient être construits," explique Bernard Golden, PDG du cabinet de consultant Hyperstratus et blogueur de CIO.com. " Vous démarrez la virtualisation avec un niveau de base et vous ajoutez plusieurs couches pour obtenir plus de souplesse ou de la résilience, jusqu'à avoir éventuellement une automatisation complète, une gouvernance et d'autres éléments que vous associez au cloud computing," déclare t-il.

Un phénomène inéluctable

Chris Wolf indique qu' "il existe un écart sur l'adoption des services de base de la virtualisation " et d'ajouter " Les primo-adoptants affichent un taux de virtualisation situé entre 60 et 100 % ; les tardifs se situent généralement entre 20 et 40 %." La concurrence reste vive, explique-t-il, sur ces outils primaires de virtualisation. " Les clients qui planifient des projets Cloud sur le court terme ont tendance à exécuter VMware; ceux plus axés sur les coûts se tournent souvent vers Microsoft ou Citrix."

Même si les investisseurs optimistes placent la valeur marchande de VMware à 29 milliards de dollars avec un ratio coût/bénéfice "gonflé" à 140," déclare Paul McWilliams, " la virtualisation va continuer à stimuler les ventes des stocks et des produits IT. " J'aurais du mal à citer une entreprise de technologie qui dit avoir vu baisser la demande matériel. En général la plupart disent plutôt que la demande reste forte ou qu'elle est meilleure," dit encore Paul McWilliams. " La virtualisation est particulièrement attractive. Une fois que vous l'avez essayé, vous ne pouvez plus vous en passer."

Annuels Microsoft : Office 2010 fait grimper les résultats au 4e trimestre

Apple n'aura finalement pas surpassé Microsoft, qui aura su rester solide notamment grâce à la sortie d'Office 2010 et des bonnes ventes de Windows 7. Pour son quatrième trimestre, la firme de Redmond voit son chiffre d'affaires en hausse de 22% par rapport à la même période en 2009. Celui-ci passe donc de 13,1 à 16,04 milliards de dollars. Au niveau du bénéfice net, l'entreprise n'obtient pas les mêmes hausses qu' Apple, mais garde néanmoins l'avantage. Avec 48% supplémentaires par rapport à l'année dernière, le bénéfice net est de 4,52 milliards de dollars. Les estimations de Thomson Reuters sont donc dépassées de près d'un milliard de dollars pour le chiffre d'affaires, et de 500 millions de dollars pour le bénéfice net.

Seven, Azure et la Xbox

Peter Klein, directeur financier de Microsoft, a indiqué durant une conférence que la division Windows & Windows Live avait rapporté 4,5 milliards de dollars à elle seule ce trimestre, et l'activité Serveurs & Outils à hauteur de 4 milliards. 175 millions de copies de Windows 7 ont été vendues depuis son lancement, et les ventes trimestrielles ont généré un milliard de dollars de revenu. Il équipe 16% des ordinateurs mondiaux selon la firme. « Le cycle de renouvellement des ordinateurs d'entreprise s'est accéléré grâce à la sortie de crise, et nous avons enregistré une croissance à deux chiffres pour les ventes de licences pour le second trimestre d'affilée ». Néanmoins, le directeur financier précise qu'Azure, lancé plus tôt dans l'année, ne devrait pas représenter une part importante du chiffre pour l'année fiscale à venir, l'objectif actuel étant « d'établir une position de leader sur le marché du cloud computing ». Quant à la division Entertainment, responsable des projets Xbox notamment, elle enregistre 1,6 milliards de chiffre d'affaires, alors que dans les faits, elle est encore une fois dans le rouge, ayant fait perdre 172 millions à Microsoft. Steve Ballmer a repris les rênes de cette branche, mais il faudra attendre les prochains trimestres pour voir les premiers effets de ce changement.

Ce dernier trimestre de l'année fiscale est aussi l'occasion pour Microsoft de faire part de ses résultats annuels, eux aussi positifs. Le chiffre d'affaires progresse de 7%, à 62,48 milliards de dollars, et le bénéfice net de 29% à 18,76 milliards de dollars.

Orange Business Services se cherche un avenir

(Source EuroTMT) Lors de la présentation à la presse du plan Conquête 2015, Stéphane Richard, directeur général de France Télécom, n'a presque pas évoqué les activités d'Orange Business Services, la filiale dédiée aux services aux entreprises.

Hormis quelques allusions au Cloud Computing et au développement des réseaux, OBS apparait comme le parent pauvre de ce programme de reconquête. Il est vrai que son portefeuille est moins glamour et donc moins vendeur auprès des investisseurs et des journalistes que celui de la téléphonie mobile, avec l'iPhone et autre 4G, ou même de la fibre optique pour les particuliers qui promet de la VOD (Vidéo à la demande) et du streaming tous azimuts. Cette discrétion des nouveaux dirigeants de France Télécom est peut être donc liée à leur méconnaissance des activités d'OBS. A moins qu'ils ne se demandent ce qu'ils doivent faire de cette entité. Car depuis quelques mois, certaines voix s'interrogent sur l'avenir d'OBS au sein du groupe.

Né en 2006 d'un assemblage d'entités internes et d'acquisitions, à savoir Equant (opérateur télécoms international), Transpac (fleuron X25 du groupe qui a pris beaucoup de temps à migrer vers IP), Groupe Diwan et Silicomp (intégrateur), Orange Business Services est pourtant une entité conséquente. Il emploie plus de 20 000 personnes à travers le monde et a réalisé en 2009, un chiffre d'affaires de 7,6 milliards d'euros ce qui a représenté plus de 16 % du chiffre d'affaires du groupe France Télécom. Ses marchés sont très vastes et du fait de son histoire sont assez hétérogènes. Si l'on y retrouve tout naturellement, les activités liées directement aux télécommunications, OBS opère aussi sur le marché de la télé-santé, de la domotique, des services informatiques et donc maintenant du Cloud Computing.

Une concurrence plus rude

Par ailleurs, tant que la croissance était au rendez-vous, cette diversité était plutôt bien vue. N'y a-t-il pas eu des rumeurs sur un possible rachat de Cap Gemini par France Telecom ? Mais aujourd'hui, les services aux entreprises vont mal.

Au premier trimestre 2010, le chiffre d'affaires a chuté de 7 % par rapport à la même période de 2009. Malgré certains éléments conjoncturels tel que le report de projets, on peut douter d'une vraie reprise en 2010. Car la richesse du portefeuille est difficile à gérer et oblige OBS à multiplier ses ressources afin de faire face à la concurrence.

[[page]]

Pour s'en rendre compte, il suffit d'aller piocher dans le document de référence annuel 2009, de plus de 500 pages, dans lequel France Télécom recense ses différents adversaires sur le marché des entreprises. Parmi eux figurent SFR Business Team, les opérateurs alternatifs de la boucle locale à l'exemple de Numéricâble-Completel, de Colt, les opérateurs de services globaux tels que BT, AT&T, Verizon, les opérateurs des pays émergents dont Reliance ou encore Tata Communication, les opérateurs nationaux, les intégrateurs de réseaux avec Nextira One ou Spie Communication ou de systèmes comme IBM Global Services, HP, Atos Origin et enfin « les acteurs issus du monde de l'Internet qui se positionnent auprès des entreprises en leur proposant des services de VoIP ou des solutions en mode Cloud Computing, comme Amazon ou Salesforce » ! On comprend que pour l'opérateur français, la tâche est rude alors que les entreprises ont réduit leurs investissements, que certains concurrents n'hésitent pas à faire du dumping et qu'il faut revoir les marges à la baisse pour rester compétitif.

L'affaiblissement de France Télécom sur le marché de l'entreprise se fait surtout sentir au niveau des PME. Certes l'opérateur historique détient une énorme part de marché en France sur ce secteur. Mais peu à peu ses positions se voient combattues au profit de ses concurrents comme SFR qui a restructuré l'offre de Neuf Cegetel ou Bouygues Télécom qui se positionne avec succès sur certaines niches. Sans compter les opérateurs locaux qui connaissent bien les entreprises régionales ou même un acteur comme Hub Télécom qui aujourd'hui cherche des relais de croissance hors des plateformes aéroportuaires.

Une reprise en main nécessaire

De nombreuses PME à la recherche de solutions de données telles que les communications unifiées, la mise en place d'IPBX, s'étonnent que France Télécom ne réponde pas à leur appel d'offre ou ne cherche pas à être concurrentielle. « On a l'impression que la société a vraiment été atteinte dans son fonctionnement en 2009 et que les commerciaux peinent à reprendre le rythme » explique le dirigeant d'une société de transport.

Les analystes reconnaissent que les turbulences qui ont touché la société l'année dernière et le départ de la figure emblématique d'OBS, à savoir Barbara Dalibard, ont eu un impact sur l'activité de la branche entreprise. Mais aujourd'hui, ils sont plus optimistes à l'image d'Henri Tcheng de BearingPoint, qui considère que sous la houlette de son nouveau patron, Vivek Badrinath, OBS est maintenant en ordre de marche pour redevenir profitable.

Avant cela, il faudra sans doute que l'activité économique mondiale, et notamment celle de la vieille Europe, redémarre, mais aussi peut être que France Télécom allège son portefeuille professionnel pour, non pas se positionner partout, mais cibler les vrais marchés en croissance.

Avec le zEnterprise 196, IBM réinvente le mainframe

Avec le zEnterprise 196, IBM remet en selle sa plate-forme mainframe pour les années à venir. Big Blue entend bien placer au centre du datacenter et du cloud sa plate-forme centralisant les technologies maison. « Après le support de Linux en 2000 (...) et l'arrivée de processeurs plus performants en 2008, nous continuons d'innover sur cette plate-forme » souligne Rod Adkins, vice-président en charge de l'activité Systems et Technology chez IBM. « Aujourd'hui, nous proposons une solution permettant de regarder son système informatique comme une seule entité. » La firme d'Armonk a en effet donné à son mainframe zEnterprise la capacité de manager des systèmes Power7 et des blades x équipées d'Intel Xeon sur une console d'administration unique. Le z196 peut accueillir jusqu'à 96 processeurs et 114 lames avec huit coeurs chacune. Pour reprendre les propos de Steve Mills, vice-président en charge de l'activité Software, « cette annonce est un des changements les plus significatifs pour la plate-forme depuis ces 20 dernières années et intègre un grand nombre d'innovations. »

Des puces quatre coeurs à 5,2 GHz

Au chapitre matériel, le zEnterprise 196 repose sur des processeurs quatre coeurs à 5,2 GHz associés à 3 To de mémoire, soit deux fois plus que la précédente plate-forme, le z10, équipé de puces quatre coeurs à 4,4 GHz. Le nouveau processeur Z intègre deux fois plus de mémoire cache et une centaine d'instructions supplémentaires. Le système se présente sous la forme de la traditionnelle grande armoire auxquelles on peut ajouter des éléments complémentaires de type Power7 et BladeCenter x86 qui fonctionneront avec AIX et Linux.

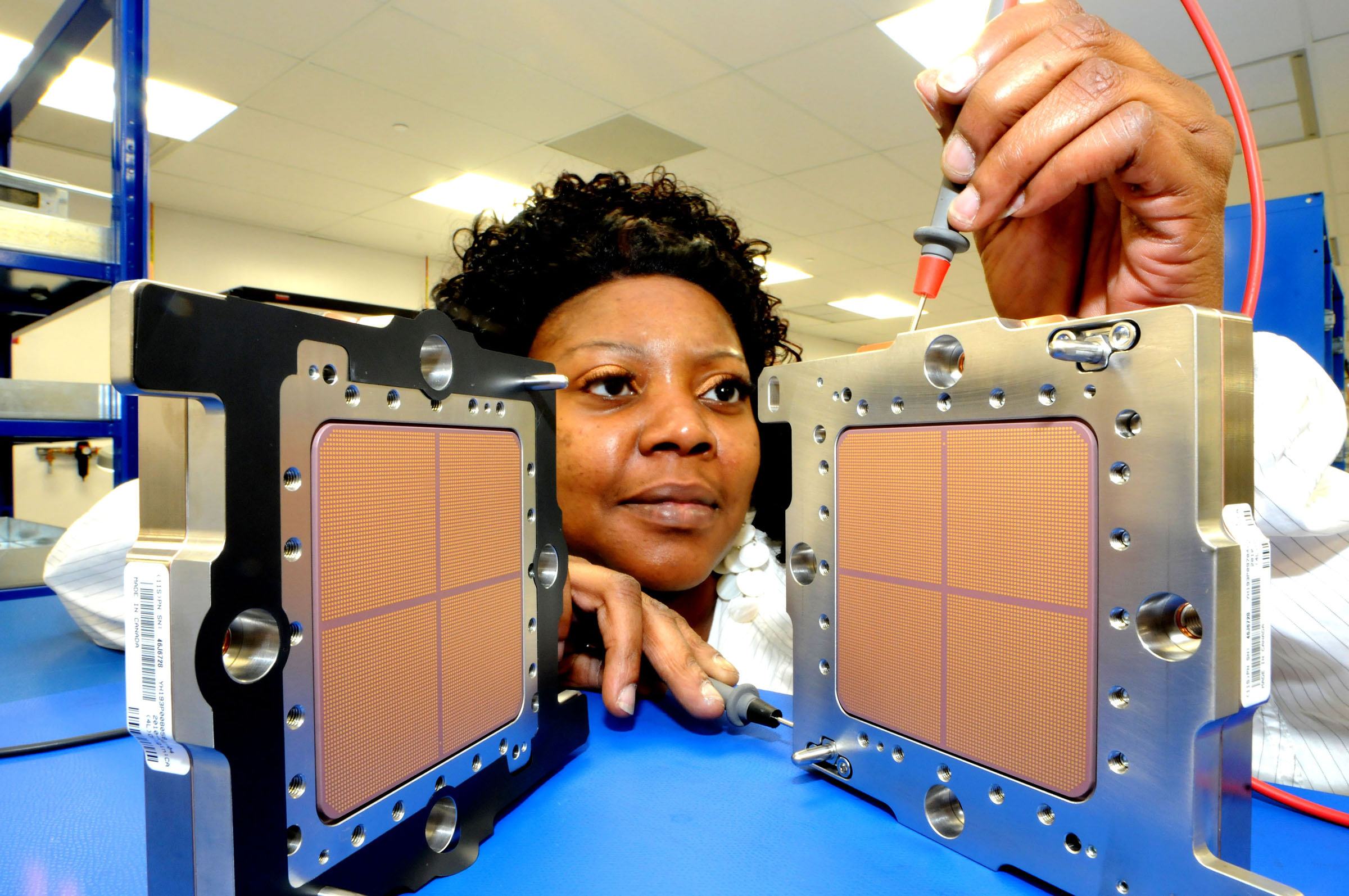

À la question de savoir quand Windows sera supporté, Ambuj Goyal (en illustration ci dessus), directeur Developpement & Manufacturing de la branche Systems & Technology, répond simplement que « c'est à l'étude suite à la demande de certains clients. Windows va venir». Mais aucun planning n'a été indiqué. « Les solutions x86 sont parfaitement supportées avec les principales distributions Linux et les machines virtuelles KVM et VMware. Nous proposons les mêmes capacités qu'un serveur Intel traditionnel, mais avec la sécurité d'un mainframe. Aujourd'hui 30% des serveurs X86 sont animés par Linux contre seulement 1% il y 10 ans, nous répondons donc à une grande partie du marché. » Impossible de savoir comment sont reliés les différents systèmes dans un z196, Amjub Goyal se contente de sourire en assurant que l'administration est parfaitement intégrée pour l'utilisateur qui peut gérer son système informatique avec beaucoup moins de complexité. Une partie des câbles et des équipements réseau deviennent par exemple inutiles puisque toutes les connexions se font au niveau du mainframe. À la question de savoir si des technologies héritées du rachat de PSI par IBM il y a deux ans déjà, sont réutilisées, Steve Mills et Amjub Goyal nous ont catégoriquement répondu que non. Toutes les technologies utilisées dans ce z196 sont issues de développements internes. Mais impossible de savoir pour l'instant quel type de switchs sont intégrés pour relier les différents équipements. Les extensions Power7 et BladeCenter sont gérés par l'Unified Resource Manager qui distribue la mémoire et les espaces disques. « Nous avons enfin réalisé une architecture de convergence entre différentes architectures », précise simplement Amjub Goyal.

Etendre la technologie System z

Avec son zEnterprise, IBM entend bien conquérir de nouveaux marchés et étendre la technologie des Z Séries en jouant notamment sur le TCO. Si le TCA reste toujours plus important que sur les systèmes Power ou X86, IBM indique après de savants calculs et une bonne dizaine de slides que son architecture hybride est censée couter un tiers de moins sur trois ans. La démonstration de Steve Mills met en scène 1603 serveurs X86 prenant en charge 10 000 workloads d'un côté et une architecte zEnterprise hybride avec 5 z196 (334 IFLS), 195 blades X86 et 250 lames Power7. Au final, le coût total d'acquisition et de fonctionnement serait inférieur d'un tiers, mais ce type de calcul est est toujours très compliqué et ne répond pas toujours à des décisions rationnelles. Il faut bien évidemment prendre en compte l'existant et les capacités techniques du personnel.Big Blue met toutefois en avant des arguments très convaincants comme un gain de performance de 60% pour une même consommation électrique ou l'automatisation d'un grand nombre de tâches au sein de ce « datacenter in the box ». Brad Day, analyste au Forrester Research, qualifie ce nouveau système de « très différent de ce qui a été fait avant » et parle même de « réelle rupture ». Brad Day croit comprendre que l'approche d'IBM est de focaliser sur la consolidation et la virtualisation, spécialement quant il voit que beaucoup de ressources Mips sont utilisées avec Linux sur les mainframes ?

Une arrivée attendue

L'arrivé de ce System z explique en partie la baisse de 24% du chiffre d'affaires d'IBM sur la partie mainframe au dernier trimestre. C'est typiquement le cas quand on nouveau système arrive. Reste à savoir comment les clients vont accueillir cette annonce. Steve Mills se montre très confiant, aussi bien avec les anciens clients qui pourront, comme à l'accoutumée, migrer leurs z10 vers cette architecture hybride mais également avec la conquête de nouveaux utilisateurs. Et de citer en exemple une jeune compagnie pétrolière américaine spécialisée dans la prospection.

Au chapitre disponibilité, le zEnterprise 196 et son extension Power7 sont livrables partir du mois de septembre. Pour le module BladeCenter, il faudra patienter jusqu'à l'année prochaine.

Crédits photos : IBM

(...)(22/07/2010 17:05:57)Des malwares sur certaines cartes mères de serveurs Dell

Le problème concerne un nombre restreint de cartes PowerEdge " Le billet indique que "ce malware a été détecté dans le firmware de gestion de serveurs embarqués." Forrest Norrod, vice-président et directeur général des plates-formes serveurs chez Dell, écrit dans un mail que " le problème affecte les cartes mères de remplacement de quatre types de serveurs, les PowerEdge R310, R410, R510 ainsi que les modèles T410." Il ajoute que " le code malveilant ne peut se manifester que dans des configurations spécifiques ou si l'antivirus du client est inactif ou obsolète."

Il précise que "ce virus n'affecte pas les systèmes produits dans nos usines et qu'il est uniquement limité aux pièces de rechange. Dell a retiré de sa chaîne d'approvisionnement toutes les cartes mères touchées et les nouveaux stocks de remplacement ne sont pas infectés par ces logiciels malveillants".

Découvert par hasard et communication superficielle

Le responsable n'a par contre fourni aucun détail sur la nature des malware identifiés, ni sur la manière dont ils affectent les serveurs ou les solutions possibles pour y remédier. Forrest Norrod a néanmoins déclaré que " Dell, conscient du problème, a établi la liste des clients concernés et est en contact avec eux," ajoutant qu'il publierait prochainement plus d'informations à ce sujet sur le site web du constructeur.

La réaction de Dell est intervenue après qu'un client a révélé publiquement avoir été contacté par un technicien qui souhaitait prendre rendez-vous pour nettoyer son serveur de ses logiciels malveillants. Dell a indiqué qu'il ne pensait pas que le problème aurait un impact sur ses clients. "A ce jour nous n'avons reçu aucuns rapports relatifs à la sécurité des données,» peut-on encore lire dans le message publié par Forrest Norrod.

Dell précise également que les systèmes d'exploitation autres que Windows ne sont pas touchés par le virus, et que les nouvelles cartes mères livrées avec les systèmes PowerEdge ne sont pas infectées.

Trois outils d'automatisation du cloud en test

Le travail réalisé lors de ces tests était de convertir un travail de type « batch » (traitement par lots) en application portée dans le Cloud. Nos confrères américains ont codé une application qui traite les fichiers vidéo par lot, les encode dans un format spécifique (grâce à ffmpeg, qui est une collection de logiciels libres dédiés au traitement de flux audio ou vidéo pour l'enregistrement, la lecture ou la conversion d'un format à un autre) et les diffuse sur différentes instances. Par ailleurs, la rédaction a testé la montée en puissance des requêtes en faisant fonctionner ffmpeg sur chaque instance. Les trois outils testés ont été capables de réaliser ces tâches, mais chacun d'une façon différente.

Ces trois outils exigent des connaissances en codage et en programmation (Appistry nettement plus que les autres). Savoir comment fonctionne chaque plateforme prend en effet un certain temps. Le plus simple à comprendre est Control Editor, de l'éditeur Tap In, parce que son interface graphique est accessible et ergonomique.

I. Les points forts des trois outils

1. La vue disponible dans Tap In

La vue d'ensemble des processus automatisés est excellente sur l'outil Control Editor de Tap In.

2. Les modèles de Rightscale

Rightscale fournit des modèles de systèmes en grille très puissants, diversifiés et les plus utiles des outils testés.

[[page]]

3. L'évolutivité de Rightscale

En termes de performances, lors des montées en charge, RightScale arrive en tête. Il est suivi de près par Tap In.

4. L'interface web d'Appistry

Appistry propose une interface utilisateur belle et sophistiquée pour un usage en mode web.

[[page]]

5. L'interopérabilité des outils

Appistry et Tap In assurent une très bonne interopérabilité avec les plateformes de clouds publics.

II. Les points faibles des outils

1. Trop de code à programmer

Appistry nécessite un travail de codage trop important.

[[page]]

2. Une compétence forte en codage et scripting

Tous les produits testés nécessitent des bases de codage en Ruby ou dans d'autres langages.

3. Des configurations complexes

L'outil Rightgrid de RIghtScale demande un travail de configuration complexe.

[[page]]

4. L'adaptabilité

RightScale supporte tous les clouds, à condition que ce soit des clouds EC2 d'Amazon ...

5. Une tarification en mode puzzle

La grille des prix d'Appistry ressemble est un peu nébuleux

Rackspace et la NASA s'associent dans le cloud Open Source

A force d'observer les nuages de l'espace, l'agence spatiale américaine a décidé de s'investir dans le cloud computing en mode Open Source. Cela passe par la création d'une plateforme commune baptisée Openstack, avec la société Rackspace. Pour l'instant peu formalisé, l'accord entre les deux sociétés porte sur une étroite collaboration pour initier d'autres initiatives dans le cloud computing. Dans leurs efforts, d'autres entreprises comme AMD, Citrix, Dell, Iomart, Spiceworks participeront à l'aventure.

Rackspace et la NASA ont chacun publié des éléments du code de la plateforme. Ainsi, l'hébergeur apporte le code de ses solutions Cloud Files et Cloud Server. De son côté, l'agence américaine met à disposition le code de sa plateforme cloud Nebula. « Le calcul scientifique moderne nécessite toujours plus d'augmentation de stockage et de puissance de traitement délivrée à la demande » explique Chris Kemp, CTO de la NASA et de compléter « pour répondre à cette demande, nous avons construit Nebula, une plateforme d'infrastructure cloud capable d'adresser les besoins de nos scientifiques et la communauté d'ingénieurs.

Les premiers travaux portent sur deux éléments ; Openstack compute, qui permet le déploiement et la gestion de capacité de calcul à grande échelle. Ce logiciel repose sur le langage Python, des frameworks Tornado et Twisted. La deuxième solution est baptisée OpenStack Object Storage et s'adresse au stockage des données.

En quête de standardisation

Fabio Torlini, à la tête des services cloud de Rackspace, explique que cette solution pourrait accélérer le développement de tels services en apportant un bon niveau d'interopérabilité. « Nous estimons que notre plateforme deviendra de facto un standard à terme » souligne le responsable et d'ajouter « le décollage des services sera alors massif ». Si Fabio Torlini reconnaît que le bénéfice immédiat de l'adoption d'une telle plateforme est limitée, sur le long terme, elle devrait dynamiser le nombre d'applications disponibles.

Le même dirigeant reconnaît que les utilisateurs restent frileux sur le cloud pour des questions de sécurité. La publication du code du projet doit répondre à ces inquiétudes et donner la possibilité aux entreprises d'adapter leur propre règle de sécurité.

Crédit Photo: NASA

(...)(19/07/2010 16:37:53)9 entreprises qui se frottent au cloud public

Les offres de Cloud Computing mises enoeuvre vont alors des plus connues comme celles d'Amazon, Microsoft, Google ou Salesforce, à celles de challengers comme Orange, Ecritel ou T-Systems. Pour autant, il faut reconnaître que des freins demeurent: immaturité de l'offre, contractualisation insuffisante du service, crainte en matière de protection et de confidentialité des données, incertitudes sur la conformité réglementaire liée à la localisation géographique des sites d'hébergement, poids de l'existant. Une source d'inquiétude en (...)

Retrouvez la suite avec les témoignages de Marc Vallée (Pages Jaunes Marketing Services), Serge Esposito (Voyages-SNCF), Pol Evlard (Malakoff Médéric), Christophe Vanbelle (Sarenza), Christophe Jeusse (Univar Europe), Viviane Madinier (La Poste), Joannès Vermorel (Lokad), Edouard Munck (Micro Application), Christian Taltas (Ibiza Software)... dans CIO.PDF 17

| < Les 10 documents précédents | Les 10 documents suivants > |