Flux RSS

108538 documents trouvés, affichage des résultats 8241 à 8250.

| < Les 10 documents précédents | Les 10 documents suivants > |

(22/04/2010 18:22:55)

Apple s'offrirait ARM ? (MAJ)

Dans les milieux financiers anglais, on prête à la firme de Cupertino de vouloir lancer une offre d'achat d'ARM. L'opération pour acquérir le fondeur est estimée entre 7 et 8 milliards de dollars. Quel est l'intérêt d'un tel projet ? Il est double. En premier lieu, Apple a pris le pari d'équiper les iPad de processeurs fabriqués en interne, le A4, que certains soupçonnent d'être une déclinaison d'une puce ARM. En s'offrant le fabricant de puces, la société dirigée par Steve Jobs acquiert une expertise et une compétence dans des composants clés pour l'avenir des futurs terminaux. Traitement graphique, puissance de calcul, les prochaines évolutions des tablettes par exemple, vont nécessiter des puces plus élaborées.

Dans un deuxième temps, ce rachat serait une réponse à la récente acquisition par Google de Agnilux, spécialiste dans les processeurs à basse consommation. Pour l'anecdote, cette société a été créée par des anciens de PA Semi, racheté par Apple et qui ont développé le processeur A4. En sachant, qu'ARM équipe une grande partie des téléphones mobiles concurrents de l'iPhone, comme ceux fonctionnant sous Android l'OS de Google. Cela ne sera pas sans poser quelques problèmes de concurrence soumis à la sagacité des autorités de régulation.

Richard Holway, analyste de Techmarketview, ne se prononce pas sur la validité d'une telle rumeur, mais il estime que "cette opération aurait du sens, car Apple qui a élaboré sa propre puce, n'a pas envie de voir sa technologie utilisée par des concurrents"

Rappelons néanmoins qu'il s'agit pour l'instant d'une rumeur, mais avec l'épisode de l'iPhone V4 en début de semaine, il arrive parfois que le virtuel rencontre la réalité. A suivre...

(MAJ)

La rumeur aura eu une faible durée de vie, hier la City, bruissait d'une potentielle OPA d'Apple sur le fabricant de processeurs ARM. Et bien, Warren East, dirigeant du fondeur a été catégorique dans un entretien accordé au Guardian « personne n'achètera la société » et d'ajouter « même si cela est flatteur de voir le cours de bourse grimper sur des rumeurs, l'objectif de notre entreprise est de travailler sur des produits standards pour tous les acteurs ».

(...)(22/04/2010 17:36:18)Microsoft se penche sur l'administration du cloud

Organisé à Las Vegas et un peu perturbé par le nuage de cendres (la majorité des participants européens n'a pu s'y rendre), l'évènement MMS a résolument consacré la stratégie du géant de Redmond dans le cloud. A travers des démonstrations, des annonces, Microsoft estime que l'administration est la pierre angulaire du développement des différentes offres de services informatiques hébergées en interne ou en externe. Pour Geneviève Koehler, chef de produit System Center chez Microsoft « nos clients sont de plus en plus intéressés par l'agilité du cloud, mais ils ont besoin d'outils d'administration pour se préparer à cette migration et être accompagnés étape par étape ».

Pour cela, l'éditeur a présenté Dynamic Infrastructure Toolkit pour System Center, qui sera disponible dans sa deuxième version bêta à la fin juin 2010. Il s'agit d'un guide de bonnes pratiques pour réaliser son cloud privé. Pour assurer l'étape ultérieure qui est de porter les applications vers les clouds publics, Microsoft travaille sur un Pack Management pour son logiciel Azure, qui intégrera une console d'administration commune sur le datacenter et auprès de l'hébergeur. Pour cette offre, qui est élaborée dans les laboratoires de l'éditeur, il faudra attendre fin 2011 pour son lancement.

Une offre dédiée PME-PMI

La vedette de cette conférence s'appelle Windows Intune et se définit comme un service en ligne pour l'administration et la sécurisation de parcs d'ordinateurs. Ce service s'adresse aux entreprises de taille moyenne disposant de 25 à 500 PC. Il comprend un service d'administration en ligne (System Center online), une protection anti-malware (Microsoft Malware Protection Engine) ainsi que la Software Assurance Windows 7 et la suite MDOP (Microsoft Desktop Optimization Pack). Cette dernière comprend plusieurs briques de fonctionnalités y compris de virtualisation. Fonctionnant sur les versions XP SP2, SP3, Vista de Windows, cette offre sera facturée par un abonnement unique, mais aucun tarif n'a été communiqué. Elle est disponible en version bêta aux Etats-Unis et la version commerciale n'est pas attendue avant un an.

Red Hat écarte Xen de RHEL 6 version beta

« Red Hat a choisi de concentrer ses efforts de virtualisation autour de la machine virtuelle sur Kernel KVM, » a déclaré Tim Burke, vice président de l'ingénierie pour la plate-forme Red Hat.Dans cette version, «la virtualisation a été l'objectif essentiel et nous avons considéré l'infrastructure qui pouvait être intégrée à nos services cloud» souligne Tim Burke. Pour être efficient dans les environnements cloud, l'OS RHEL 6 alloue dynamiquement les données au sein du noyau. Une fois les machines virtuelles chargées dans le système d'exploitation, l'administrateur peut spécifier la quantité de mémoire, le nombre de cycles de traitement et la quantité de bande passante qu'il souhaite attribuer à chaque machine.

L'autre fonctionnalité s'appelle le Completely Fair Scheduler (SCF), auquel revient la responsabilité de « répartir de manière plus dynamique les charges de travail entre les tâches » en redistribuant plus uniformément les ressources processeurs entre toutes les applications. Le système emprunte les techniques logiciels de Red Hat pour exploiter les services sans tolérance de latence, comme il accomplit aussi un travail plus sophistiqué de planification des priorités, en hiérarchisant les tâches, de la plus haute à la plus faible priorité » affirme Tim Burke. Des fonctions d'économies d'énergie ont également été ajoutées. Ainsi, l'infrastructure d'horloge a été réorganisée et force l'activité « ticketless » du noyau. Auparavant, ce dernier devait dialoguer avec le processeur 1 000 fois par seconde pour l'empêcher de passer en mode veille et ainsi économiser l'énergie. La fonctionnalité « tickless » repose un système de minuteries accordées au hardware, autorisant le processeur à se mettre en veille pendant des périodes où il n'y a pas d'autres tâches à effectuer.

L'espace occupé par les fichiers système a été amélioré pour être plus adapté aux ensembles de données importants. C'est notamment la première version de RHEL à utiliser ext4 comme fichier système par défaut, en place du ext3 auparavant. Le système d'exploitation peut maintenant exécuter des fichiers système d'une taille allant jusqu'à 16 téraoctets.

[[page]]

Il sait également effectuer une vérification système plus rapidement, impliquant une amélioration des temps de récupération lors d'arrêts inopinés. Pour les données de très grande taille, la solution de Red Hat propose une option pour mettre à niveau le fichier système du format XFS au format SGI qui peut prendre en charge des capacités allant jusqu' à 128 To.

Une décision cohérente

Au regard de l'implication de Red Hat dans le cloud computing, sa décision de laisser de côté Xen peut paraître surprenant. Mais ces dernières années, l'entreprise a apporté de plus en plus de soutien à KVM. Pour rappel, en 2008, Red Hat avait acquis l'éditeur de logiciel de virtualisation Qumranet, dont les développeurs sont en grande partie à l'origine de KVM. « L'une des raisons pour lesquelles Xen a été abandonné » expose le responsable, « est que la société ne peut dédoubler tous ses efforts pour maintenir deux hyperviseurs, une tâche exigeante qui réclame beaucoup d'implications. C'est le cas par exemple avec les serveurs équipés du processeur Nehalem d'Intel livré récemment qui apporte certaines fonctionnalités de virtualisation et implique la modification des deux logiciels. »

Simon Crosby, co-fondateur de XenSource et actuellement directeur de la technologie de la plateforme logicielle chez Citrix, a déclaré qu'il n'était pas surpris par la décision de Red Hat d'abandonner Xen. « Il est logique de ne soutenir qu'un seul code source, et Red Hat n'a pas contribué à enrichir le code Xen depuis plusieurs années ». Il fait remarquer que « avec Xen, Red Hat n'a pas eu beaucoup de chance sur le marché de la virtualisation. Ils ont même été vraiment mauvais sur le marché entreprise. Maintenant, ils ont cinq ans de retard par rapport au reste de la communauté ». Ce dernier a également noté que l'adoption de KVM par Red Hat va dans le sens opposé des autres acteurs du marché de la virtualisation serveur, et notamment Citrix et VMware. Ces derniers se tournent aujourd'hui vers des solutions d'infrastructure virtuelle allégées, pour lesquelles toutes les fonctions serveurs sont virtualisées. En revanche, KVM s'appuie sur le noyau de l'OS, et fonctionne uniquement sous machines virtuelles tournant sous Linux. «C'est une option Linux-first » souligne Simon Crosby.

Dans tous les cas, le passage à KVM nécessitera un certain travail de la part des utilisateurs actuels de Red Hat Entreprise Linus qui devront faire migrer leurs machines virtuelles Xen vers KVM (ou les obliger à installer Xen séparément). « Pour donner accès à des invités Xen RHEL 5 sur RHEL 6, il faut lancer un outil de conversion et de migration» a précisé Tim Burke.

Trimestriels Citrix : Des résultats conformes et en hausse

Le fournisseur de solutions de virtualisation met en avant un chiffre d'affaires en hausse de 12% au premier trimestre 2010 pour atteindre 414 millions de dollars contre 369 millions de dollars l'année précédente. Le bénéfice net non ajusté s'élève quant à lui à 47 millions de dollars contre 7 millions de dollars au premier trimestre 2009.

Mark Templeton, PDG de Citrix, s'est déclaré satisfait de ces résultats et constate « une forte demande sur les marchés stratégiques : la virtualisation, l'infrastructure réseau et la collaboration ». Le premier trimestre 2010 a été l'occasion pour Citrix de lancer la version Pack 1 de XenDekstop 4, pour la virtualisation du poste de travail. Sur ce sujet, l'éditeur s'est associé à Microsoft pour accélérer l'adoption et le déploiement de telles solutions.

Fort de ces bons résultats, Citrix prévoit un chiffre d'affaires pour 2010 compris entre 1,765 et 1,78 milliard de dollars.

Steria ouvre une plateforme d'infrastructure informatique en ligne

François Enaud, PDG de la SSII française Steria, a présenté ce matin avec Cisco une offre de plateforme informatique à la demande (« as a service »), assortie d'un paiement à l'usage. Celle-ci repose sur l'infrastructure de serveurs pour datacenter Unified Computing System (UCS), mise au point par le constructeur américain. L'annonce réalisée par webconférence s'est donc faite conjointement avec Laurent Blanchard, vice-président Europe de Cisco.

A partir de juin prochain, les entreprises pourront, en passant par un portail Internet sécurisé, accéder à cette plateforme baptisée par Steria "Infrastructure On Command" pour en exploiter les ressources informatiques (puissance de calcul, capacité de stockage...), en fonction de leurs besoins, en ne payant que pour les services consommés.

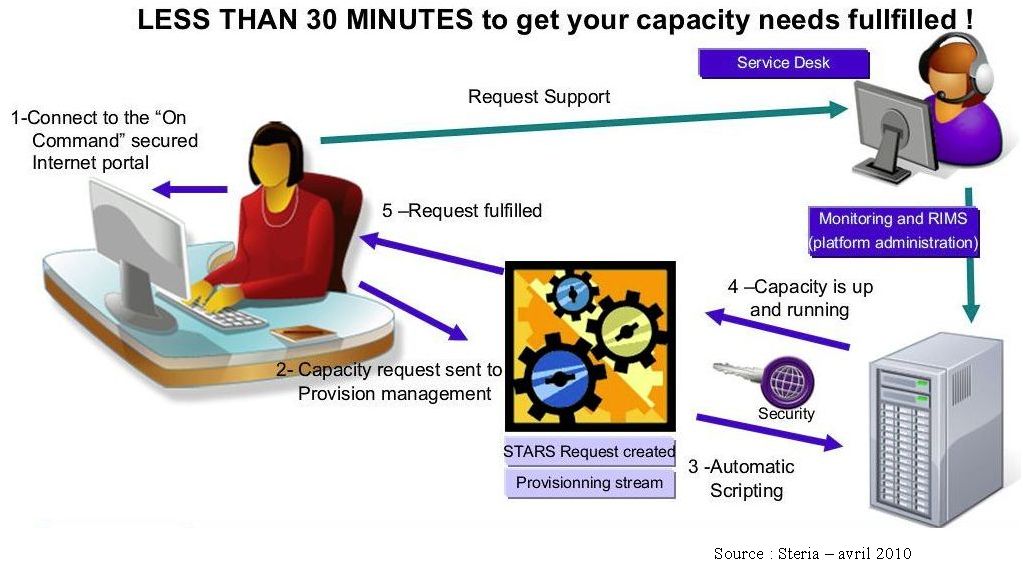

Un processus entièrement automatisé

Karine Brunet, directrice des services industriels de Steria, a expliqué la mise en oeuvre de la plateforme de cloud computing. Le client se connecte au catalogue de services et formule sa demande de ressources à partir de laquelle va s'enclencher, par le biais d'un processus automatisé, le provisionning des ressources auxquelles l'utilisateur aura accès trente minutes plus tard.

Cliquer sur l'image pour l'ouvrir

« Aucune intervention humaine n'est requise, souligne-t-on chez Steria. On peut ainsi augmenter sa puissance informatique en fonction de besoins qui peuvent être ponctuels, par exemple, pour disposer d'un environnement de test ou d'un environnement de production plus puissant pour une période donnée ». Ainsi, François Enaud pressent que le secteur de la distribution, avec ses contraintes de saisonnalités, ou encore les opérateurs télécoms, qui ont besoin d'augmenter rapidement leurs capacités de réponse, figureront parmi les premiers clients de l'offre. Au-delà de ces cas précis, ce service concerne potentiellement tous les secteurs d'activité.

Steria accompagnera cette mise à disposition d'une offre de services associés. Les niveaux de contrats de services dépendront de l'usage.

Plusieurs acteurs proposent déjà des offres de PaaS, Amazon faisant figure de pionnier dans ce domaine avec EC2 (Elastic Compute Cloud). Parmi les annonces des derniers mois, en France, figurent notamment celles d'Orange, de Microsoft et d'Atos Origin. De son côté, SGI propose d'accéder en ligne à un environnement HPC pour le calcul scientifique et Bull prévoit de le faire sous peu.

Illustration : François Enaud, PDG de Steria

| < Les 10 documents précédents | Les 10 documents suivants > |