Flux RSS

108538 documents trouvés, affichage des résultats 4291 à 4300.

| < Les 10 documents précédents | Les 10 documents suivants > |

(08/04/2011 17:20:06)

Recap IT : Cloud, Failles, Tablettes et Windows 8

Paris est devenu en l'espace d'une semaine le lieu de convergence du cloud. SalesForce.com a ouvert le bal avec un Marc Benioff au meilleur de sa forme, qui a mis en garde contre les risques de développement de faux clouds. De son côté, Oracle a rappelé lors d'une conférence à Paris sa présence sur l'ensemble des types de clouds, privés et publics. Enfin IBM a annoncé aussi son saut dans l'informatique dans les nuages en misant sur la qualité de service et la sécurité. De son côté, Facebook donne des indications stratégiques sur son projet de datacenter, Open Compute. Les annonces de la semaine ont concerné aussi le matériel et plus exactement les composants. Intel a lancé sa gamme de processeurs Xeon E7 à destination des serveurs haut de gamme.

Entre vulnérabilité et conservation des données

Sur ce dernier point, il en a été question au sujet d'IE9. En effet une société française a découvert une faille dans le navigateur pouvant pirater Windows 7, y compris dans sa dernière version SP1. Symantec a dévoilé en début de semaine son rapport sur la sécurité et souligne la montée en puissance des attaques depuis les réseaux sociaux et contre les smartphones. En ce qui concerne les données personnelles, certains éditeurs réunis autour de l'association ASIC ont saisi le Conseil d'Etat pour demander l'annulation d'un décret qui oblige les sites à sauvegarder pendant 1 an les données de leurs clients.

Les tablettes et Windows 8

La semaine a été plus discrète dans le monde des tablettes, même si on annonce la sortie de la Xoom de Motorola, qui semble ne pas séduire grand monde. Intel a promis des ardoises numériques équipées des puces Oak Trail pour le mois de mai prochain. L'actualité micro est plutôt à chercher vers les OS et notamment la prochaine version de Windows. En effet, encore secrète, quelques révélations ont été faites sur la possible adoption du ruban Office ou du web immersif et un lecteur PDF. Des interrogations se sont faites jour sur l'ouverture d'Android, avec des risques de fragmentation certains.

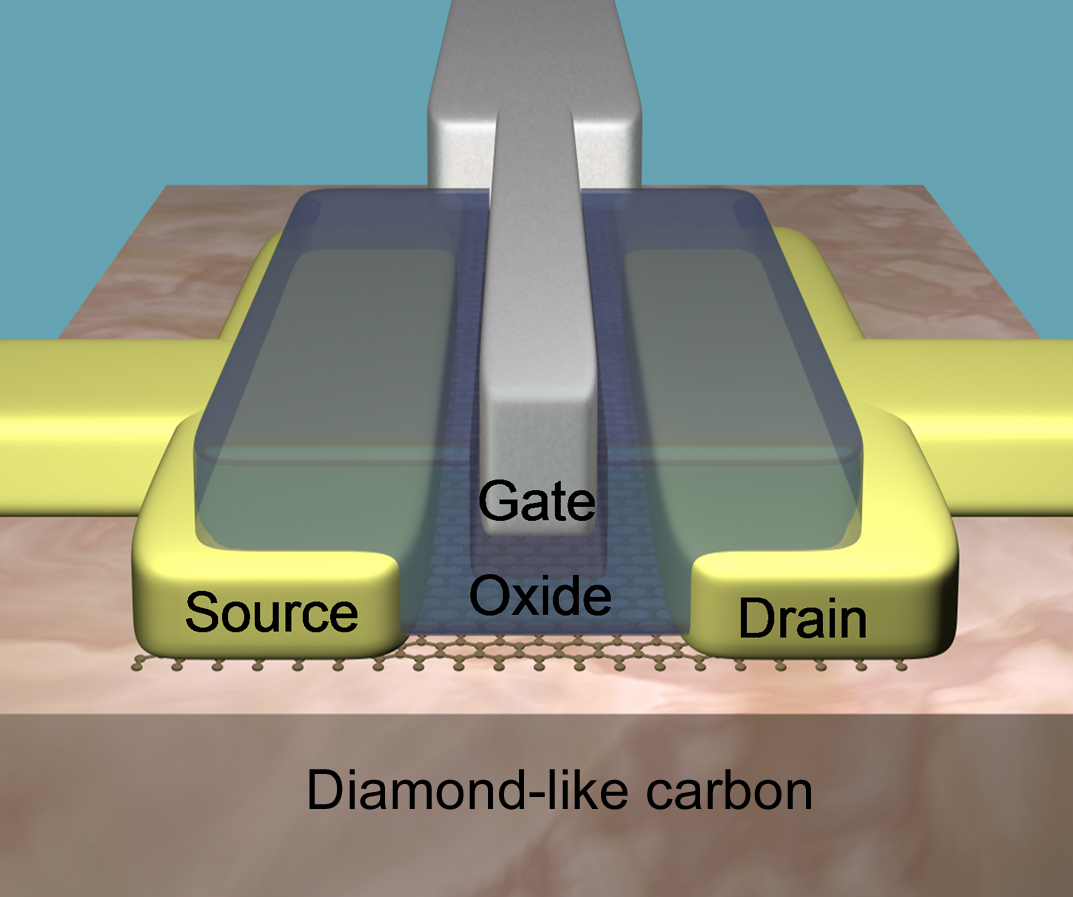

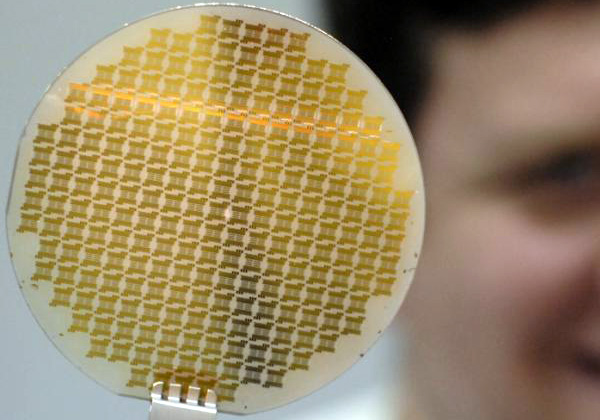

Un transistor IBM au graphène plus petit et cadencé à 155 GHz

Avec une fréquence de 155 GHz, le transistor haute performance au graphène (un cristal de carbone dont l'empilement constitue le graphite) dévoilé par les labs d'IBM est le plus rapide du moment : « il surpasse le modèle 100 GHz montré en février de l'année dernière par le fabricant, » a indiqué Yu-Ming Lin (voir illustration principale), un chercheur de Big Blue. « Cette recherche prouve également qu'il est possible de produire à faible coût des transistors haute performance, à base de graphène, en utilisant des procédés de fabrication identiques à ceux des semi-conducteurs classiques, » a ajouté le chercheur.

Cela pourrait ouvrir la voie à la production industrielle de processeurs au graphène. Mais Yu-Ming Lin ne s'est pas avancé sur une date de mise en fabrication de telles puces. « Des transistors au graphène permettraient d'améliorer les performances d'applications utilisées dans la communication sans fil, les réseaux, l'imagerie et les radars, » a indiqué Phédon Avouris, un chercheur-enseignant d'IBM.

Des recherches entamées pour la défense américaine

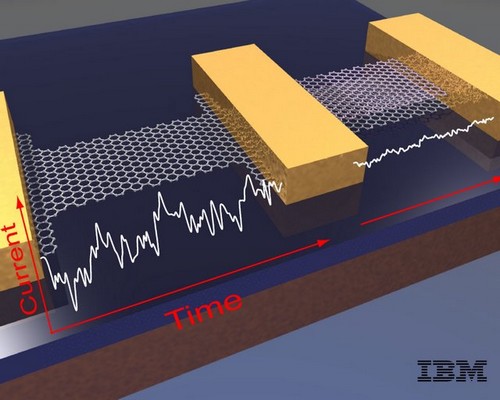

Le graphène se présente comme une couche d'atomes de carbone d'une seule d'épaisseur avec une structure hexagonale en nid d'abeille. Les recherches sur le transistor ont été entreprises par IBM dans le cadre du programme DARPA (Defense Advanced Research Projects Agency) à la demande de département américain de la Défense en vue de développer des transistors RF (fréquence radio) de haute performance. Selon Phédon Avouris, l'armée est très intéressée par les transistors au graphène. « Le flux d'électrons de ces transistors est plus rapide que celui des transistors classiques, ce qui permet des transferts de données plus rapides entre les puces, » a expliqué Yu-Ming Lin.

C'est la raison pour laquelle cette technologie est très prometteuse en matière d'applications réseau, laquelles nécessitent des communications à vitesses rapides et à fréquences élevées. « Les transistors au graphène sont capables d'effectuer des calculs plus rapidement que les transistors classiques, mais ils ne sont pas encore adaptés aux ordinateurs PC, » a-t-il ajouté. En effet, le graphène naturel ne présente pas d'écart énergétique, et les transistors au graphène ne permettent pas d'avoir le ratio de cycle requis pour les opérations de commutation numérique, ce qui est par contre le cas des processeurs conventionnels.

« En revanche, le flux continu d'énergie que procure le graphène permet un meilleur traitement des signaux analogiques, » explique encore le chercheur. « La vitesse élevée des électrons du graphène permet un traitement plus rapide des applications en électronique analogique, pour lesquelles un ratio élevé de compensation n'est pas nécessaire. »

Le plus petit transistor crée par IBM

Le transistor au graphène a bénéficié de l'utilisation d'un nouveau substrat appelé « carbone de type diamant» mis au point par IBM, grâce auquel le composant a fait preuve d'une excellente stabilité en température, entre la température ambiante et jusqu'à moins 268 degrés Celsius, la « température de l'hélium, » comme la définit IBM. « Les performances de ces dispositifs au graphène ont montré une excellente stabilité en température. Ce comportement est en grande partie du a l'utilisation d'un nouveau substrat de carbone de type diamant, » a déclaré IBM.

[[page]]

« Le transistor au graphène est également le plus petit transistor qu'IBM a mis au point à ce jour, » selon les chercheurs. La longueur de grille de la radio-fréquence du transistor au graphène est passée de 550 nanomètres à 40 nanomètres. La longueur de grille du transistor au graphène montré l'an dernier, lequel utilisait un substrat de carbure de silicium, était de 240 nanomètres.

« Mais plus important encore, la performance a été réalisée en utilisant des technologies de fabrication compatibles avec celles utilisées pour les supports à base de silicium, » a déclaré Yu-Ming Lin. « Si bien que la production industrielle de puces au graphène devient encore plus probable, » a-t-il ajouté.

Une découverte réalisée en 2004

Les possibilités du graphène sont devenues attrayantes pour les scientifiques. C'est en 2004 que André Geim et Konstantin Novoselov de l'Université de Manchester au Royaume-Uni ont isolé le graphène, jetant les bases de nouvelles recherches pour lesquelles ils ont reçu le prix Nobel de physique en 2010. « Le graphène offre un grand potentiel en matière de semi-conducteurs, mais l'industrie cherche encore à comprendre quels seraient ses avantages, » a déclaré Jim McGregor, spécialiste des stratégies en matière de technologie chez In-Stat.

Le graphène ne peut pas encore fonctionner comme un transistor numérique pour remplacer les puces en silicium actuelles. Cependant, il pourrait servir de technologie de complément à d'autres appareils utilisant le carbone pour effectuer des tâches de traitement de signal par exemple. « Comme toute nouvelle technologie, il faut des milliards de dollars d'investissement pour qu'elle devienne une alternative viable à une technologie existante.

Ensuite, cette alternative peut devenir une nécessité si la technologie actuelle se heurte à une limite physique indépassable, » a ajouté Jim McGregor. « Le graphène doit d'abord pouvoir répondre à trois exigences en matière de fabrication de semi-conducteurs : le matériau, le design et la gravure, » a-t-il encore déclaré. « Si le graphène peut être traité par les procédés de gravures actuels et futurs et répondre aux contraintes de design, alors il pourra devenir une technologie viable, mais seulement si ces deux conditions sont remplies, » a-t-il déclaré.

Enquête BMO 2011 : 28 850 projets de recrutements dans l'IT

L'enquête Besoins en main d'oeuvre (BMO) 2011, publiée par Pôle emploi et le Credoc, dénombre pas moins de 28 850 projets de recrutement IT cette année dans l'Hexagone, sur un total de 1,5 million de projets toutes fonctions confondues. Plus de 44% des prévisions d'embauche sont toujours difficiles à réaliser selon les déclarations des employeurs. Les tensions concernent les cadres et les ingénieurs d'études et développement, les spécialistes de la R&D et les responsables informatiques. Sont également concernés les postes de maintenance informatique (35,4%) et d'ingénieurs télécoms (23,9%). Sur l'ensemble de ces spécialités, près de 13 000 projets de recrutement sont jugés complexes à réaliser par les employeurs. Les informaticiens figurent ainsi au top 10 des métiers où sont signalées les plus fortes tensions.

La formation, une solution qui s'impose

Pour les entreprises, les difficultés de recrutement actuelles sont avant tout liées à une pénurie de candidats (pour 81% des établissements interrogés) ou au profil inadéquat des candidats (dans 71% des cas). 35% des sondés citent également des réticences liées aux conditions de travail (distance, horaires, salaire). La formation s'impose donc comme la première solution aux difficultés d'embauche rencontrées. Celle des candidats venant de l'extérieur (61%) est clairement privilégiée à celle des salariés déjà présents dans l'entreprise (35%). Certains recruteurs potentiels s'estiment même sans recours pour atteindre leurs objectifs : plus d'un tiers d'entre eux déclarent n'avoir aucune solution et préfèrent différer l'embauche. Enfin, les anticipations des entreprises quant à l'évolution de leur activité sont plutôt favorables dans l'informatique : pour près d'un employeur sur deux, les nouvelles technologies constitueront, cette année, l'un des domaines de renforcement des besoins en compétences

Méthodologie: L'enquête BMO a été réalisée auprès d'établissements employeurs hors administrations de l'État et entreprises publiques, soit un total de 2 400 000 entreprises en France.

(...)

Projet Open Compute : Facebook partage les secrets de son datacenter

En partageant ces informations stratégiques, Facebook pense qu'elle peut contribuer à améliorer les datacenters partout dans le monde. « C'est une bonne chose pour Facebook, mais également pour les nouvelles entreprises qui doivent traiter un grand nombre de données, » a déclaré Mark Zuckerberg, le PDG de Facebook lors d'une conférence de presse (voir illustration principale). « Nous essayons de favoriser un écosystème dans lequel les développeurs peuvent mettre facilement sur pied des start-ups, et nous pensons que, en partageant ce savoir-faire, nous allons aider à rendre cet écosystème plus efficace et favoriser sa croissance, » a-t-il ajouté.

Illustration : Le datacenter de FaceBook à Prineville, Oregon

« Les besoins de Facebook en terme de centres de calcul vont aller croissant, à mesure que nous ajoutons davantage d'applications en temps réel, » a encore déclaré le fondateur. « Il faut donc être capable de concevoir des serveurs plus efficaces, tant en améliorant le rapport puissance/efficacité que le coût. Cela conditionne en grande partie notre manière de faire, » a-t-il poursuivi.

Voilà un an maintenant que Facebook travaille à mettre au point et à peaufiner son cahier des charges pour ses serveurs de données : réduction des systèmes d'alimentation, conception d'un bâtiment qui peut se passer de climatisation, concertation avec des fabricants de serveurs pour réaliser des systèmes plus légers, qui chauffent moins et sont faciles à réparer. « Nos serveurs sont 38 % plus efficaces que ceux que nous possédions auparavant, » a déclaré Jonathan Heiliger, vice-président des opérations techniques chez Facebook. « Ils sont également 24 % moins chers à fabriquer que les modèles standards de l'industrie, » a-t-il ajouté.

Partenariat direct avec plusieurs fournisseurs

Pour mener à bien son projet Open Compute, Facebook a conclu un partenariat avec Advanced Micro Devices, Intel et Quanta, et travaille également sur de nouveaux modèles avec Dell, Hewlett-Packard, Rackspace, Skype et Zynga. Du point de vue visuel, les bare-bones n'ont pas grand intérêt - Facebook qualifie leur design de « débarrassé de toute vanité » - mais ils font leur travail. Selon la norme Power Usage Effectiveness, qui mesure l'efficacité des centres de calcul, Facebook affirme que son centre de Prineville se situe à 1,07 PUE. C'est bien en deçà - et donc bien meilleur - que la norme industrielle dont la moyenne se situe à 1,5 PUE.

Cliquer sur l'image pour agrandir la photo de ce chassis AMD

Les serveurs de Facebook pèsent environ 6 kilos de moins, mais sont plus épais qu'un système classique 1U (1,75 pouce) monté sur rack. D'une épaisseur de 1,5 U (soit 2,6 pouces), ses serveurs peuvent intégrer des radiateurs plus grands et sont dotés de ventilateurs plus efficaces. Ce qui signifie aussi moins de ventilation externe pour refroidir les serveurs. Par ailleurs, ceux-ci peuvent être ouverts et réparés sans outils - des clips et des systèmes à ressort suffisent à tenir tout en place. Seul luxe visible sur ces boîtes : une LED bleue inondant le centre de Prineville d'une lueur à la Facebook, et dont le prix par ampoule est supérieur de 5 cents par rapport à l'option la moins chère.

Annuels 2010 Proservia : une année de recentrage

La SSII Proservia publie ses comptes 2010. Avec 47,8 millions d'euros (ME) de chiffre d'affaires (CA), la société enregistre une progression organique de 7,6% et une croissance globale de 8,3%. Le résultat opérationnel passe de 0,6 ME à 2,5 entre 2009 et 2010. La marge opérationnelle bondit de 1,5% à 5,2% d'une année à l'autre.

En 2010, la société s'est recentrée sur son activité d'infrastructures, cédant WizTiVi et en rachetant NetLevel et Lynt. Pour 2011, la société indique simplement vouloir continuer sa croissance, renforcer sa politique de maîtrise des coûts et les synergies développées avec ses filiales NetLevel (infrastructures complexes) et Ovialis (MOA, architectures et décisionnel).

Baromètre HiTechPros/CIO : retour de la baisse du marché de la prestation informatique

Après un mois de février 2011 plutôt encourageant, le baromètre HiTechPros/CIO affiche une baisse des demandes clients en termes de compétences informatiques de 12 % pour le mois de mars 2011. C'est un résultat étonnant et les variations de l'évolution des demandes clients qui se succèdent à la hausse puis à la baisse depuis ce début d'année ne nous donnent pas une grande visibilité sur l'évolution de la demande à court terme.

Pour ce mois de mars on constate un ordre similaire par rapport à février 2011 pour les catégories techniques les plus demandées. En effet, les compétences les plus recherchées sont actuellement : « Nouvelles technologies » (36 % des demandes) qui garde sa place de première catégorie technique la plus prisée, « Systèmes, réseaux, sécurité » (21 % des demandes), et « Consulting Expertise » (11 % des demandes).

Les demandes ayant le plus augmenté ce mois-ci concernent les catégories techniques suivantes : Télécoms (+ 57 %) et recette, support utilisateurs (+ 30 %). A l'inverse, les catégories techniques particulièrement affectées par une baisse de la demande ce mois-ci sont : Nouvelles technologies (- 7 %), Mainframe (- 9 %) et Consulting expertise (- 13%).

Stibo Systems implante ses outils MDM en France

Editeur danois, créé en 1976, Stibo Systems ouvre un bureau en France. La société traite le référentiel produits des entreprises, essentiellement des grands comptes, avec une plateforme : Step master data. Stibo est spécialisée dans ce qu'on appelle le MDM (Master data mangement), le PIM (Product information management) et la publication multicanal (web, papier, ERP, échanges de données).

La société vend en direct, mais recourt à des intégrateurs pour l'implémentation de ses produits. Elle recherche actuellement des partenaires de ce type pour l'aider à se développer en France. Elle compte déjà des clients dans l'hexagone : Manutan, Jeulin, Seton.

Société indépendante, elle dépend d'une fondation, Stibo Systems affronte des concurrents comme IBM, Sap ou Oracle dans un marché mondial qui devrait tripler de taille entre 2008 et 2013, pour atteindre près de 3 milliards de dollars.

Un supercalculateur Bull de 1,92 Tflops à la Réunion

Le supercalculateur choisi est de la famille Bullx, de Bull. Il est composé de 20 noeuds R422-E2 et un noeud SMP BullX S6030 reliés par un réseau InfiniBand. Au total, 200 coeurs offriront une puissance de calcul de 1,92 Tflops. 36 To de données seront partagées. Le coût du projet n'a pas été communiqué.

Illustration principal : Chassis Bullx 7u, crédit D.R. (...)(08/04/2011 10:29:43)

Annuels 2010 Solutions 30 : franchir le cap des 50 millions d'euros de CA

« L'exercice 2010 représente une étape importante dans la croissance de notre groupe qui franchit pour la première fois la barre symbolique des 50 M€ », se félicite Gianbeppi Fortis, le président du directoire de Solutions30. Plus précisément, la société bien connue pour son activité dans le dépannage informatique à domicile a généré l'an dernier 54,7 M€ de facturations, soit une hausse de près de 22% comparé à 2009. Les revenus dégagés par le prestataire de services en Allemagne, Belgique, Espagne, Italie et Pays-Bas représentent 14,5% de son activité globale.

Parallèlement à la progression de l'activité de Solutions30, son résultat d'exploitation a également enregistré une hausse de près de 19% à 55,9 M€. Cela, malgré le travail mené par la société l'an dernier pour intégrer les trois sociétés qu'elle a racheté en 2009 : les activités d'intervention sur site d'Anovo en France, les activités « desktop » de SOGETI en Ile de France, la société Smartfix aux Pays-Bas.

Le résultat net grevé par des charges non courantes

En revanche, ces rachats ont contribué à faire baisser de 40,5% la rentabilité nette de Solutions30 par rapport à 2009. Elle reste tout de même dans le vert à 1,4 M€. Ce recul tient à l'inscription au bilan de charges non récurrentes et à la constitution de provisions pour charges exceptionnelles à hauteur de 1,9 M€. Cette somme a notamment financé une baisse des effectifs du groupe qui avaient progressé de 350 personnes suite à ses différentes acquisitions. 350 K€ ont également été provisionnés pour faire face à des litiges avec des fournisseurs des sociétés reprises. Enfin, Solutions30 a racheté à des associés minoritaires leurs parts dans une trentaine de ses agences. Sur les 70 implantations dont le groupe dispose aujourd'hui, seule l'agence de Reims conserve un actionnaire minoritaire aux côtés de Solutions30.

Annuels 2010 Micropole : une pression sur les prix persistante

Le PDG de Micropole en présentant les résultats annuels a utilisé des expressions qu'on ne lui soupçonnait pas : « après le passage devant la DSI, si cette dernière a signé pour un projet, nous ne sommes plus obligés d'endosser un ciré pour nous rendre dans les directions achats, et prendre une rafale ».

En clair, fin 2009, les prix ont baissé en moyenne de 2%, surtout en France. Une baisse confirmée au 1er semestre 2010, mais regagnée au second semestre par une hausse tarifaire. La pression sur les prix, qui, au-delà de la baisse ou du report des projets, a handicapé tout le secteur, semble s'être estompée. Micropole pense regagner encore quelques points, le taux d'occupation remonte également, il reste à moduler un troisième critère, celui des salaires internes dans le secteur. Réduite au pain sec depuis plusieurs années, la profession retrouvera un état normal après deux années et demi de crise.

Le paysage s'adoucit donc et Micropole affiche pour son exercice 2010 une croissance de 6,8% de son chiffre d'affaires, à périmètre et change constants, de 8,8% au total, avec un chiffre d'affaires de 102,5 millions d'euros. Dans un secteur à peine positif en 2010, Micropole reste au-dessus du lot. Et surtout, la société affiche des CA constamment positifs sur 5 ans : +13% en 2006, + 18% en 2007, +2% en 2008, + 9% en 2009 et donc + 8,8% en 2010.

Seul motif de désespoir, le cours de bourse

La rentabilité 2010 vient conforter cette trajectoire. Le résultat opérationnel courant se monte à 6,3 ME, contre 3,6 ME un an auparavant, soit 6,2% du CA, contre 3,8% en 2009. Le résultat opérationnel s'élève à 5,1 ME contre 3 ME. Enfin, le résultat net se monte à 4,2 ME, contre 2,5 ME, soit 4,1% du CA, contre 2,6%. Seul motif de désespoir, le cours de bourse, mais ceci est un autre sujet, commun à de nombreux acteurs des logiciels et services.

Sur sa lancée, Micropole se dote d'un plan de développement à trois ans. L'objectif est d'atteindre les 150 ME de CA, à la fois par croissance organique et par croissance externe. Sur le 1er volet, la société s'appuie sur ses trois activités : la BI (45%), le web IT (45%), l'ERP et la formation, sans exclure d'en développer de nouvelles. Elle tient à se distinguer en fuyant la stratégie « prix-volume » pour une approche métier plus différenciée avec des facturations plus élevées. Quant à la croissance externe, elle se fera en France ou à l'international (22% de l'activité actuelle). Visiblement l'Allemagne est en ligne de mire. A l'international, Micropole s'est renforcée en Belgique avec l'acquisition du spécialiste SAP Oasis (4ME de CA et 14% de résultat d'exploitation). Micropole est également présente en Suisse.

(...)

| < Les 10 documents précédents | Les 10 documents suivants > |