Flux RSS

Progiciels

2426 documents trouvés, affichage des résultats 301 à 310.

| < Les 10 documents précédents | Les 10 documents suivants > |

(26/05/2011 11:56:47)

Le marché des logiciels de CRM a crû de près de 8% en France, selon PAC

Les logiciels de gestion de la relation client constituent toujours un sujet d'actualité dans leurs quatre constituants : automatisation de la vente, marketing, assistance client, analyse des données. Loin de se fondre dans la masse du marché global, la croissance du secteur du CRM (pour customer relationship management) reste largement supérieure à celle du marché des applications de gestion, selon une étude du cabinet Pierre Audoin Consultant.

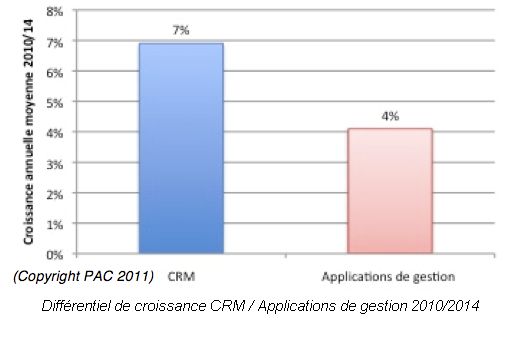

En France, la croissance des acteurs du CRM a ainsi été de 8% en 2010, selon PAC, et elle devrait se maintenir en moyenne aux environs de 7% par an jusqu'en 2014, contre seulement 4% pour les applications de gestion. Le créneau du SaaS (software as a service) croit encore plus vite, d'un facteur cinq.

Deux axes de travail : PME et grands comptes

Les soutiens de la croissance du CRM sont de deux ordres. D'une part, les PME sont en voie d'adoption de ces outils. D'autre part, les grandes entreprises font évoluer les applications existantes, notamment en migrant vers des solutions SaaS (15% du marché du CRM), et en augmentant le nombre de licences et d'accès aux outils. Cette augmentation du périmètre est notamment liée à la place croissante de « nouveaux » canaux, comme le e-commerce. Les quantités de données générées par les interactions réalisées avec les clients sont également en forte croissance et les traitements nécessaires ou souhaités nécessitent donc des améliorations applicatives.

Côté offre, la règle reste la dispersion. L'acteur dominant est Oracle (acquéreur en son temps de l'offre Siebel) avec seulement 15% du marché français, suivi de SAP avec 10%. Quant au pure-player SaaS (et créateur de ce modèle) Salesforce.com, il ne pèse encore que 4%, malgré sa notoriété. (...)

Avec AppUp, Intel veut proposer des services de cloud hybride aux PME

Intel vient d'annoncer une offre un peu différente de ce qu'il propose habituellement. Avec sa solution packagée AppUp Small Business Service, il espère faciliter l'accès à un nouveau type de service cloud. Celui-ci vise des PME souhaitant réduire leurs coûts informatiques en migrant vers le cloud, mais encore réticentes à le faire pour des problématiques de sécurité. AppUp leur permettra en effet d'exploiter des applications hébergées sur des serveurs installés en interne tout en étant facturées à l'usage et en restant déchargées de la gestion du matériel. Cette prestation va être commercialisée par des distributeurs ou des intégrateurs qui vendront aux entreprises l'accès à des logiciels sur la base d'un abonnement mensuel par utilisateur.

Le service AppUp repose sur l'environnement Hybrid Cloud d'Intel qui a été présenté l'an dernier comme une plateforme pouvant être utilisée par des intégrateurs pour distribuer des services hybrides. Il rassemble des serveurs, un éventail d'applications, ainsi que les logiciels d'Intel pour gérer et pouvoir suivre la « consommation » des logiciels afin de pouvoir la facturer.

Lancée en Amérique du Nord et en Inde

Pour l'instant, Intel limite cette offre aux fournisseurs de services évoluant sur deux zones géographiques : l'Amérique du Nord et l'Inde. Dans un premier temps, le package AppUp s'appuie sur le serveur ThinkServer TS200v. D'autres serveurs s'y ajouteront par la suite, fournis par Acer, NEC et d'autres. Par l'intermédiaire du founisseur de services, les enterprises pourront sélectionner des logiciels provenant des catalogues d'une dizaine d'éditeurs : Microsoft, Tally, Intuit, GFI Software, Astaro, gloStream, Level Platforms, SIOS et Vembu. Intel indique que d'autres éditeurs s'y joindront bientôt : Allscripts, Apani, Asigra, ClearCenter, Coversant, Critical Links, Elina Networks, Ensim, eTurns, Fonality, KineticD, Lumension, McAfee, Novell, Pragma Systems, StorageCraft, Symantec and WorkSpace Communications.

Les clients paieront donc pour une utilisation mensuelle du logiciel et le prix du serveur pourra, soit être inclus dans cet abonnement, soit être facturé séparément. Intel n'a fourni aucune indication de prix. Celui-ci différera probablement en fonction des applications utilisées et des services apportés par l'intégrateur.

Charles King, analyste du cabinet Pund-It, souligne qu'AppUp constitue un nouveau modèle économique pour Intel. Certes, il fabrique des processeurs pour serveurs, mais ici, il sert aussi d'intermédiaire entre les vendeurs de serveurs et les fournisseurs de services. « Cela ne me surprendrait pas de le voir prendre d'autres initiatives de cette nature à l'avenir », a-t-il confié à nos confrères d'IDG News Service.

Illustration : crédit Intel / LMI

Le MDM en mode projet et maturité, selon Business & Décisions

« Il y a deux ans, on y songeait ; l'année dernière, les pionniers commençaient à parler de retours concrets mais encore expérimentaux et limités ; cette année, on peut parler de projets de MDM [Master Data Management, gestion des données de référence, NDLR] très avancés et globaux dans les entreprises » s'est réjoui Jean-Michel Franco, directeur des solutions de Business & Décision. Il s'exprimait dans le cadre de la Matinale du MDM, organisée par la SSII le 24 mai 2011.

Pour Jean-Michel Franco, les données ont, pour les entreprises un double visage, à la manière du Dr Jekyll et de M. Hyde. Si elles permettent une meilleure connaissance du client ou une saine gestion optimisée, elles forment aussi un déluge ni toujours cohérent, ni toujours maîtrisé, ni même sécurisé, à la merci de fuites ou de piratages (comme dans les récentes affaires Sony ou Wikileaks).

Un pilotage métier indispensable

La gestion des données de référence, selon Business & Décision, implique une modélisation des données, une analyse en continu de celles-ci, la mise en oeuvre d'une gouvernance des données (qui fait quoi avec quelles données?), une intégration des données entre elles afin de les mettre en cohérence et enfin une véritable direction de projet. Jean-Michel Franco avertit : « il faut un pilotage métier à la création du modèle de données afin de répondre à un besoin du métier et pas à une problématique technique. Un pilotage par la DSI aboutit toujours à un échec. » Les producteurs de données ont en effet alors tendance à ne plus s'impliquer et à ne pas construire les données comme attendu.

Un projet de mise en oeuvre de MDM dans une banque internationale a ainsi été lié à une gestion du risque client dans le cadre d'une mise en conformité avec les accords Bâle II. La croissance de la qualité des données liée à leur saine gestion a ainsi permis de mieux mesurer le risque client et d'optimiser les réserves de capitaux. Trop souvent, la SSII Business & Décision aurait été appelée en pompier face à de sérieux problèmes de qualité des données avec des impacts sur les métiers. La durée moyenne d'un projet de MDM est de l'ordre de un an selon Business & Décision. Cette période se décompose en six mois de discussions pour calibrer le modèle de données, trois mois pour le mettre ne oeuvre techniquement et trois mois pour le tester et le facturer.

[[page]]

« Mais le MDM ne doit pas être vu comme comme un projet ponctuel ou comme la mise en place d'un produit : c'est une démarche qui doit être maintenue de manière constante pour tous les types de données (personnes, choses, lieux...) » milite Jean-Michel Franco.

La distribution en pionnier

Les mises en place de cette démarche ont été beaucoup constatées dans la distribution, comme avec Boulanger et Truffaut. Les premiers projets ont en effet beaucoup concerné l'unification des données au travers des différents canaux, à commencer par les produits, comme chez Boulanger, mais aussi, de plus en plus, en se penchant sur les données clients. La fameuse vision « à 360° » du client, totalement unifiée, est souvent galvaudée : il arrive que, soudain, on se rende compte que le service après-vente n'a pas été inclus dans cette vision soi-disant globale. Des projets globaux de gouvernance des données commencent aussi à apparaître dans ce secteur. « Un projet de MDM, c'est avant tout du décloisonnement » résume Jean-Michel Franco.

La distribution ne se limite pas à des magasins. RTE est ainsi une filiale d'EDF spécialisée dans le transport et de distribution d'énergie entre producteurs et consommateurs. Pour accomplir ses missions, RTE doit maîtriser les données de consommation et de production d'énergie. Au-delà de l'équilibrage instantané, il faut en effet disposer de données pour des analyses qui permettront de définir les tarifs. Ajoutons que les compteurs intelligents vont faire exploser les volumes et la richesse des données disponibles. RTE a donc construit un référentiel client unique qui alimente tous les logiciels en ayant besoin. Il n'y a ainsi plus de ressaisies et d'erreurs de réconciliations entre fichiers où les identifiants étaient différents. RTE a débuté son projet en janvier 2011 et sa phase de développement a duré quatre mois. La mise en production est prévue à la rentrée 2011.

Une offre pléthorique et diverse

Jean-Michel Franco indique que, pour répondre aux besoins des entreprises, il existe de nombreuses solutions. Mais, même s'il existe des pure players, la plupart des acteurs actuels ont en fait acquis des fournisseurs plus petits leur permettant de mettre pied dans le MDM mais sans pour autant perdre leur approche historique. Ainsi, certains acteurs partent de la gestion de processus (SAP, Oracle...). D'autres ont débuté dans le décisionnel (Informatica, SAS...). Middleware et synchronisation des données ont fourni une autre famille (avec Tibco, IBM...). Enfin, certains acteurs ont une approche de rupture, originale, comme Exalead qui provient du moteur de recherche.

PLM : PTC lance Windchill 10 en attendant d'intégrer MKS (MAJ)

Après la refonte de sa solution de CAO Pro/Engineeer devenue Creo, PTC dévoile Windchill 10, la dernière mouture de son logiciel de gestion du cycle de vie produit (PLM) Avec cette version repensée, l'éditeur bostonien renforce les fonctionnalités centrées sur la gestion de la qualité, l'analyse des variantes produits (conformité, coûts) et la gestion des nomenclatures multidisciplines. Sur l'ensemble du cycle de vie, l'outil établit des liens entre les différentes vues métiers de la structure d'un produit. Notamment dans l'automobile où la gestion globale d'un projet n'est pas encore totalement fiable.

« Les outils propriétaires développés par les constructeurs ne répondent pas à tous les besoins. Ces PLM travaillent principalement avec Catia de Dassault Systèmes, pour la gestion de la documentation par exemple, mais ils ne sont pas encore capables de gérer l'ensemble des composants d'une voiture. Avec Windchill, nous proposons par contre une brique de base sur laquelle se greffent les modules spécifiques pour arriver à la gestion de la configuration globale d'un véhicule. Quelques mois sont toutefois nécessaires pour arriver à maturité », nous a indiqué Marc Diouane, vice-président directeur de l'organisation Global Services de PTC.

Sur les 5 500 salariés que compte l'éditeur, 2 000 travaillent à la R&D et 1 200 aux services pour accompagner les clients dans la personnalisation de la solution afin de connecter la technique avec les objets produits par l'entreprise. Les constructeurs et les équipementiers se rendent compte que la traditionnelle gestion du cycle de vie dans un environnement hétérogène et fragmenté - même avec d'excellents outils - est incapable de fournir le niveau de visibilité nécessaire pour prendre rapidement les bonnes décisions. Voilà pourquoi les principaux constructeurs automobiles migrent vers un environnement de conception et de fabrication capable de soutenir une stratégie plate-forme mondiale. « Le PLM (Product LifeCycle Management) est une problématique importante dans l'industrie notamment dans l'automobile où nous équipons déjà Hyundai/Kia, Toyota, VW/Audi, Aston Martin Racing, et Volvo », nous a expliqué Marc Diouane.

D'autres solutions chez les concurrents

Dassault Systèmes propose déjà une solution baptisée PLM V6 intégrant ingénierie système et mécatronique (suite au rachat de Geensoft l'an dernier ). BMW, par exemple, utilise déjà PLM V6 pour gérer l'architecture, l'intégration et la conception des systèmes embarqués. PSA et Jaguar/Land Rover travaillent également avec Dassault Systèmes. Aston Martin (véhicules de route) de son coté travaille avec les outils de Siemens : NX Cad (CAO) pour le design et l'ingénierie, et Teamcenter (PLM) pour la standardisation des processus de développement de sa prochaine voiture de sport. Daimler AG utilise également Teamcenter comme épine dorsale de l'entreprise pour la gestion des données, et NX Cad comme logiciel standard en CAO. Enfin, Chrysler a également sélectionné Teamcenter comme logiciel PLM global à l'échelle de l'entreprise.

[[page]]

La complexité croissante et la sophistication du design de l'ingénierie automobile, couplée avec la contrainte d'une chaîne d'approvisionnement mondiale et multisource nécessitent des capacités nouvelles pour assurer la qualité tout en réduisant les coûts et les délais de mise sur le marché. « Aujourd'hui, on trouve 100 millions de lignes de code dans une voiture », complète Marc Diouane, « et les lignes de code dans l'industrie aéronautique ont augmenté de 500% en 10 ans. Avec Windchill et l'intégration prochaine de MKS, spécialiste de l'ALM, nous proposerons une boite noire pour superviser les logiciels embarqués ».

Déjà en production

Cette version 10 de Windchill est en production depuis le mois de mars 2011 chez certains clients. Hyundai Motor Society and Kia Motors Corporation (HKMC) a déjà commencé à utiliser Windchill comme système d'enregistrement complet dans les projets de nouvelles voitures : analyse des couts des matériaux et ingénierie. HKMC prévoit d'étendre Windchill dans tous ses centres de production et d'ingénierie dans le monde, et d'intégrer ses fournisseurs de niveau 1 qui seront appelés à utiliser ce PLM.

Pour revenir sur le produit, l'ergonomie de Windchill 10 a été revue en concertation avec les clients pour repenser l'interface utilisateur. Cet outil prend aussi en charge le calcul de l'empreinte globale des produits. Un tableau de bord lié à différents scénarios permet d'ailleurs une analyse multidimensionnelle avec filtrage par zone géographique : conception/performances, impact écologique, coûts... Différents modèles de calcul de coûts sont d'ailleurs proposés en relation avec une base de données alimentée par le constructeur et ses sous-traitants. Une interface avec les ERP des partenaires est même envisageable pour intégrer tous les coûts.

Rapprochement à venir avec l'ALM

L'amélioration des processus de développement permet de gérer des maquettes hétérogènes pour remonter une maquette numérique dans un environnement unique. Une obligation dans l'industrie automobile où la conception de la carrosserie fait souvent appel à Catia de Dassault Systèmes et à Creo de PTC pour le groupe motopropulseur. Les liens de plus en plus étroits entre mécanique, électronique et logiciels embarqués, imposent un même référentiel pour faciliter l'intégration des éléments et assurer la gestion des différentes configurations durant le cycle de vie du produit (SAV et documentation). La capture d'une configuration précise est également nécessaire pour remonter un problème précis.

Le support des logiciels embarqués ne sera toutefois pas effectif tant que les solutions de KMS ne seront pas digérés par PTC. La prochaine version de Windchill, connue sous le nom de code X-22, est attendue en mars 2012 et devrait intégrer des éléments issus du rachat de MKS pour initier un rapprochement vers l'ALM. Une fois intégrés, ces outils permettront à PTC de proposer une solution globale pour la mécatronique (mécanique, électronique et informatique temps réel).

Sapphire 2011 : SAP a certifié plusieurs de ses offres pour le cloud d'Amazon

Les utilisateurs des solutions décisionnelles BusinessObjects de SAP pourront maintenant, s'ils le souhaitent, exploiter leurs applications dans le cloud public d'Amazon. Lors de sa récente conférence utilisateurs SapphireNow (à Orlando, du 16 au 18 mai), l'éditeur allemand de solutions de gestion a annoncé qu'il avait entièrement testé et certifié les ressources d'infrastructure utilisées par Amazon Web Service (AWS). L'opérateur de cloud public figure désormais au nombre des partenaires technologiques mondiaux de SAP. Outre l'offre BO, les solutions de SAP bénéficiant de la méthodologie « Rapid Deployment » pourront aussi être mises en oeuvre sur AWS. Il en existe une douzaine : plusieurs offres de CRM (gestion de la relation client), cinq offres de gestion logistique et cinq autres concernant la production, la finance et la gestion de la IT.

D'autres logiciels d'entreprise sont déjà optimisés pour fonctionner sur AWS, parmi lesquels, notamment, plusieurs produits d'Oracle.

Première incursion de SAP dans le cloud public

L'éditeur allemand compte déjà des clients qui exploitent ses logiciels dans des infrastructures de cloud privé, hébergées par IBM, Verizon ou Dell. C'est en revanche sa première percée dans le cloud public, a souligné la semaine dernière Kevin Ichhpurani, senior vice-président de la société pour la division écosystème et réseaux de distribution. Le fournisseur a prévu de porter d'autres applications vers AWS, y compris son ERP phare. Adam Selipsky, vice-président d'Amazon Web Services, a insisté lors de SapphireNow, sur le fait que nulle part ailleurs, les entreprises pouvaient ainsi accéder à des ressources SAP à la demande avec une tarification à l'utilisation (« pay as you go »).

SAP a prévu de travailler avec des intégrateurs qui aideront les clients existants à migrer d'un scénario « on-premise » vers AWS. L'éditeur a travaillé étroitement avec Amazon pour optimiser les machines virtuelles sur les différentes couches (exécution, réseau, stockage) afin d'obtenir la meilleure performance, a indiqué Kevin Ichhpurani. Contractuellement, pour l'instant, les entreprises devront toujours traiter de façon séparée avec SAP et AWS (pour le service) et payer chacun d'eux de façon indépendante. Les deux fournisseurs ont mis au point des engagements de services (SLA) pour couvrir à la fois l'infrastructure AWS et le logiciel, a expliqué Adam Selipsky sans toutefois donner de détail sur les différents niveaux qui seront proposés.

Amazon et SAP devront sans doute faire quelques efforts pour promouvoir la fiabilité de ce genre d'offres compte tenu des récents problèmes rencontrés par le service EC2 d'Amazon. D'autres acteurs importants ont également subi des arrêts de fonctionnement ces derniers temps, en particulier Microsoft la semaine dernière, avec son service hébergé de messagerie. Ces incidents amènent les entreprises à se demander jusqu'à quel point leurs services IT peuvent s'appuyer sur les services cloud.

Illustration : AWS / LMI

TechEd 2011 : Microsoft étoffe sa suite Azure AppFabric

« La version CTP (Community Technology Preview) de Azure AppFabric à paraître en juin, offrira un ensemble de fonctionnalités pour construire et gérer des applications multi-tiers à partir d'une console unique, » a déclaré Seetharaman Harikrishnan, directeur général Application Server Group, chez Microsoft, au cours d'une présentation consacrée à ces technologies pendant la conférence TechEd à Atlanta (du 16 au 19 mai).

La plateforme middleware nouvelle génération de Microsoft doit permettre aux entreprises de gérer un ensemble d'applications qui peuvent être exécutées soit en interne, soit en externe dans une implémentation du service cloud Azure de Microsoft. Selon Seetharaman Harikrishnan, AppFabric permettra de simplifier la gestion des applications multi niveaux. « En particulier, les administrateurs ont eu du mal à gérer le niveau intermédiaire d'applications 3- tiers classiques, » a t-il déclaré. « De nombreuses entreprises ont standardisé le front-end de leur applications, le plus souvent en faisant appel à une interface de type navigateur basé sur un serveur Web, » a t-il expliqué. « Et ils ont normalisé les bases de données dans le back-end. Mais le niveau intermédiaire est resté un casse-tête en matière de gestion, » a-t-il ajouté.

C'est dans cette couche middleware, comme la nomme Microsoft, qu'est traité l'échange d'informations entre différentes applications, et où sont effectués, par exemple l'authentification des utilisateurs, le workflow et les services de messagerie. « Ce niveau intermédiaire n'a pas suscité beaucoup d'intérêt et laisse un peu à désirer, » a déclaré le directeur général. « C'est le problème des silos. » Chaque composant logiciel a un potentiel particulier, et est affecté à une fonction unique selon une structure qui résulte d'une architecture informatique dite en silos centrée autour de lignes de métiers, qui limite le partage des ressources.

Simplifier le middleware

« Azure AppFabric pourrait radicalement simplifier cette couche intermédiaire, » a t-il affirmé, notamment en offrant un ensemble de services préconfigurés pour fonctionner ensemble, ce qui permettrait aux développeurs de composer des applications en fonction du service. AppFabric Azure, qui fait partie de la plateforme Windows Azure, comporte déjà un certain nombre de produits différents, y compris un service de contrôle d'accès, un mécanisme de mise en cache et un service d'intégration qui s'appuie sur plusieurs fonctionnalités de BizTalk Server. Le nouvel ensemble permet de simplifier la procédure pour assembler ces autres services pour former des applications. « Cela devrait être facile pour vous de découvrir ces fonctionnalités et de les utiliser tout simplement, » a déclaré Seetharaman Harikrishnan.

AppFabric Developer Tools et AppFabric Application Manager font parti des nouveaux composants. Les outils de développement se présentent sous la forme d'un add-on pour Visual Studio. Celui-ci permet aux développeurs de composer des applications en rassemblant différents services sur une même palette. AppFabric Application Manager joue le rôle de runtime qui peut contrôler le fonctionnement et les performances de chaque application, ainsi que les services de base qu'elle utilise. Pour fonctionner, cette configuration nécessite aussi un nouvel ensemble d'extensions .NET Framework. Appelé Modèle de composition, il fournit les éléments pour décrire et assembler les composants dans une application.

Pendant le TechEd, Microsoft a également annoncé la sortie d'une nouvelle preview du Service Bus d'AppFabric. Cette version permettra la connectivité via REST (Representational State Transfer) ou HTTP API (interfaces de programmation d'application). Ainsi, Java et les applications basées sur PHP pourraient communiquer avec les applications AppFabric via ces API. Microsoft prévoit normalement de livrer AppFabric en 2012. Ces dernières années, l'éditeur a déjà livré plusieurs CTP aux professionnels des départements informatiques pour leur permettre de se familiariser avec cette technologie.

| < Les 10 documents précédents | Les 10 documents suivants > |