Flux RSS

R et D

956 documents trouvés, affichage des résultats 221 à 230.

| < Les 10 documents précédents | Les 10 documents suivants > |

(01/07/2010 10:16:58)

Des pistes pour rénover le réseau Internet

« L'architecture Internet n'a pas bougé depuis 35 ans... ». Cette phrase de Louis Pouzin, un des fondateurs des protocoles TCP/IP résume bien l'état d'esprit dans lequel s'est ouverte la conférence sur le futur d'Internet le 28 juin 2010 lors du forum Atena. Les pieds du réseau mondial sont fragiles et mal protégés comme le confirme Guy Pujolle, professeur à l'Institut de France : « l'Internet est une roue sur laquelle il n'y a quasiment que des rustines ».

L'enseignant émérite propose de revoir la sécurité du réseau en repartant de zéro ou en améliorant ce que l'on fait déjà. Il préconise en tout premier lieu de passer de la traditionnelle architecture en 7 couches du modèle OSI à une architecture en 7 plans (cloud, sécurité, connaissances, pilotage, management et contrôle, virtualisation et données), ce qui induit une plus grande interactivité entre ces éléments, ainsi qu'une plus grande modularité.

Il suggère par ailleurs une virtualisation intégrale, de disposer d'une intelligence plus collective dans les réseaux. C'est-à-dire de passer à un autopilotage des réseaux et d'axer le développement sur la mobilité.

[[page]]

Guy Pujolle propose également de durcir la sécurité d'entrée sur le web. Plus de login, plus de password mais une clé SSL unique comportant toutes les données de sécurité.

Imaginer l'après IP

La problématique d'une architecture post-IP a également été posée. En effet on considère souvent l'IP comme un système d'adressage efficace. Mais peut-on réellement parler d'adresse quand on parle d'IP ? Une adresse est censée nous renseigner sur où, qui et quoi. Or, l'adresse IP ne se contente que d'envoyer un signal à un serveur. Plusieurs solutions existent pour répondre à un remplacement de l'IP actuel et notamment la solution de migrer vers un réseau pair à pair (P2P). On peut citer aussi le projet ANA (Projet de création d'un réseau autonome), soutenu par plusieurs universités. Ce projet doit permette la formation complètement autonome de noeuds de réseau et de réseaux entiers de manière souple et dynamique.

Une autre réflexion a été émise durant l'événement, celle de la virtualisation totale des réseaux. L'objectif d'une telle évolution serait d'augmenter la modularité des réseaux et donc de rendre la demande de ressources des utilisateurs plus flexibles.

Silicon Valley 2010 : Réseaux pour datacenter et base de données en cluster (4e partie)

Présidée depuis octobre 2008 par Jayshree Ullal, ex-VP de Cisco en charge du pôle datacenter, Arista nous a reçu dans un élégant immeuble de Menlo Park. La start-up qui compte parmi ses actionnaires Andy Bechtolsheim, le cofondateur de Sun, s'est spécialisé dans les switchs 10 Gbit Ethernet haut de gamme (24 et 48 ports) pour les datacenters, les infrastructures HPC et bien sûr le cloud computing.

Principales caractéristiques techniques des solutions proposées par Arista : un système d'exploitation reposant sur un noyau Linux nommé Extensive OS (EOS) et une architecture structuré autour d'une base de données intégrée (SySDB). Doté d'un système de répartition de charge et d'une capacité de buffering pour réduire la congestion, EOS ambitionne de réduire la latence des commutateurs. De son coté, SySDB concentre toutes les informations nécessaires au bon fonctionnement des switchs. Complétée par des outils de supervisons pour réduire les erreurs humaines, cette base conserve les données concernant les commandes CLI et les protocoles réseau. Vice-président en charge de la technologie, Anshul Sadana explique qu'EOS était plus robuste que l'IOS de Cisco et que leur noyau était particulièrement protégé. Sur un marché du switch 10 Gbit évalué à 9 milliards de dollars en 2014, selon Jayshree Ullal, Arista pense avoir une carte à jouer. « Nous pouvons être une alternative dans les datacenters. Les grandes entreprises sont aujourd'hui obligées de prendre en compte les start-ups si elles veulent profiter de leurs capacités d'innovation » ajoute-t-elle. Aujourd'hui, Arista emploie une centaine de personnes, et revendique 340 clients dans le monde. Principalement des centres de recherche, des universités ou d'autres start-ups.

[[page]]

Switch haute densité

Poursuivons nos rencontres dans le monde du réseau avec Blade Networks Technology (BNT) à Santa Clara dans un immeuble qui domine la fab d'Intel . Pas vraiment une start-up, l'équipementier a été crée en 2006 suite à une spin off de l'activité commutateurs du Canadien Nortel. Financé par le fond d'investissement Garnett & Helfrich, BNT compte à ce jour 170 personnes. Si le produit phare de la marque reste le switch Ethernet mini-rack fourni en OEM à HP, IBM ou NEC, BNT commercialise depuis trois ans des systèmes top of the rack qui autorise la connexion maximale de 40 serveurs dans un module vertical en haut des armoires. Le best-seller de la marque, le RackSwitch G8124, est le premier modèle a être descendu sous la barre des 500 dollars par port 10 GigaEthernet, nous explique Vikram Mehta, le dynamique CEO de Blade Networks (voir photo ci-dessous). « Et en 2009, 500 000 serveurs ont été déployés dans le monde avec des équipements BNT, principalement dans des centres de calculs. Connecter un datacenter est une chose très différente de la connexion d'un PC portable. Il faut assurer la convergence entre des milliers de ports et des centaines de machines virtuelles. »

Avec ses 1000 ports switch virtuels, VMready de BNT permet d'adapter le réseau à la virtualisation. Cette solution s'interface avec les principaux éditeurs d'hyperviseur pour associer un virtual port à une VM. Aujourd'hui, l'intégration la plus avancée a été réalisée avec VMware. « Quand on fait une VMotion (déplacer une VM dans VCenter de VMware), le profil associé suit et reconfigure automatiquement le port », souligne Atul tambe, VP ingénierie matériel chez BNT. Et via les API, VMReady 2 va être capable de s'interfacer et de donner des ordres aux switchs. « Nous vivons aujourd'hui le même phénomène que le passage du mainframe au cluster Linux avec le développement du switch distribué en lieu et place du switch classique », ajoute Vikram Mehta.

[[page]]

Base de données MySQL en cluster

Pour notre dernier déplacement, nous quittons la Silicon Valley pour nous rendre dans le quartier d'affaires de San Francisco à la rencontre de Clustrix. Fondée en 2008 par des anciens d'Isilon Systems, Paul Mikesel et Aaron Passey, cette start-up est soutenue par les fonds d'investissement Sequoia - qui a encore des intérêts dans Isilon - VSVP et ATA Ventures. Basée sur une technologie très proche des baies de stockage distribuée d'Isilon Systems, cette start-up propose une solution pour répartir sans partitionnement une base de données de type MySQL sur plusieurs serveurs. Il s'agit de la technologie Isilon adaptée aux bases de données, ici baptisée Clustered Database Systems (CDS).

Découpée en tranches, la base de données est répartie sur tous les serveurs CLX 4100 en cluster. Ici aussi, le système est une solution complète comprenant logiciel et matériel. Si la configuration de base démarre à 80 000 dollars avec 3 appliances CLX 4100 en mode cluster - équipé de 32 Go de mémoire vive, de 2 x 4 coeurs Intel , de 7 x 160 Go SSD et de2 x 320 Go DD - , il suffit d'installer de nouvelles machines pour accroitre la capacité de traitement et l'espace de stockage. La compagnie n'a pas encore installé plus de vingt noeuds, mais rien n'empêcherait d'aller jusqu'à une centaine de serveurs. « Chaque noeud parle à l'autre en fois connecté en IP pour échanger des informations » explique Paul Mikesel, PDG et en charge de l'ingénierie chez Clustrix . Avec son système, la start-up réussit à combiner les fonctionnalités MySQL avec l'extensibilité et les performances des bases de données non-SQL.

Nous terminons ici notre tournée des start-ups, mais nous vous donnons rendez-vous pour une deuxième session en novembre prochain.

(...)(29/06/2010 14:56:10)Netra, une application mobile de prescription optique développée par le MIT

Destiné aux pays du tiers monde, le système Netra du MIT Media Lab requiert de l'utilisateur qu'il aligne deux lignes s'affichant sur l'écran de son terminal mobile tout en regardant dans un cube de plastique. « Vous tenez votre téléphone mobile devant votre oeil, vous cliquez sur quelques boutons, vous demandez le calcul et vous obtenez votre prescription de lunettes, » raconte Ramesh Raskar, professeur agrégé au MIT Media Lab. « Cette technologie fonctionne parce que la résolution des téléphones s'est améliorée de manière spectaculaire, » ajoute-t-il. « En superposant simplement un petit film optique, on peut sélectionner une onde lumineuse qui compense les aberrations de l'oeil et réaliser le calcul, » explique-t-il. L'application affiche deux lignes sur l'écran du téléphone que l'utilisateur doit aligner en utilisant les touches de son mobile tout en regardant dans le petit module en plastique qu'il tient au-dessus de l'écran. Le test est renouvelé huit fois, les lignes étant à chaque fois affichées de manière différente. À la suite de quoi l'application peut calculer la prescription de l'utilisateur. L'ensemble du processus prend environ deux minutes.

Crédit photo IDG NS

[[page]]

À l'heure actuelle, les éléments en plastique coûtent 1 à 2 dollars environ, mais les chercheurs estiment que, produits en masse, ils pourraient être vendus quelques cents chacun. L'OMS estime que 2 milliards de personnes présentent des défauts de réfraction optique non corrigés. Cette absence de correction est la seconde cause de cécité dans le monde. Les prescriptions oculaires sont généralement diagnostiquées grâce à un phoroptère ou un aberromètre. La première méthode utilise le système bien connu de lentilles amovibles : placées devant chaque oeil, elles servent à tester différentes combinaisons pour déterminer l'indice de correction. L'autre méthode utilise un rayon laser chargé de mesurer les caractéristiques de l'oeil sans interaction avec le patient. Pour Ramesh Raskar, la méthode du phoroptère, dite de réfraction subjective, « n'est pas fiable parce que fondée sur la vue du patient à un moment donné. » Par rapport aux méthodes traditionnelles, Netra est à la fois meilleur marché et portatif. L'équipe, qui compte commercialiser le système après l'avoir testé sur le terrain à Boston, prévoit de cibler en premier lieu certaines régions d'Afrique et d'Asie.

Outre Ramesh Raskar, Manuel Oliveira, professeur invité, Vitor Pampelune, étudiant du Media Lab et Ankit Mohan, post-doctorant de recherche associé, ont travaillé sur le projet dans le cadre du Camera Culture Group du MIT. Netra sera présenté fin juillet lors de la conférence annuelle du SIGGRAPH.

(...)(25/06/2010 15:12:16)Geforce 280 contre Core i7, une étude Intel confirme la supériorité de Nvidia

En moyenne, la Nvidia GeForce GTX 280 - commercialisée en juin 2008 - était 2,5 fois plus rapide que l'Intel Core i7 960 cadencé à 3,2 GHz processeur, et dans certaines circonstances jusqu'à plus de 14 fois plus véloces selon 12 chercheurs d'Intel. Ces derniers ont publié leurs observations dans un document baptisé Debunking the 100x GPU vs. CPU myth: An evaluation of throughput computing on CPU and GPU. À l'origine, cette étude devait définitivement discréditer les prétentions des puces 3D sur les processeurs Intel en comparant les performances d'un Core i7 et d'une carte exécutant une série de tests conçue pour exploiter les capacités de traitement en parallèle de ces circuits. Comme son nom l'indique, le traitement en parallèle consiste à effectuer de multiples calculs en simultané par opposition un travail en série qui réalise les tâches dans un ordre séquentiel.

Les puces graphiques intègrent aujourd'hui des centaines de noyaux (ou shader) qui sont utilisés pour calculer des polygones et plaquer des textures pour créer des images de plus en plus réalistes. La carte GTX280 de Nvidia intègre l'équivalent de 264 coeurs par socket, tandis que la société a récemment annoncé son GPU Tesla M20 avec 448 noyaux. Ces circuits sont donc bien adaptés au traitement en parallèle alors que les CPU du type Core i7 sont mieux adaptés au travail en série. Cela ne veut pas dire que les puces quatre coeurs d'Intel ne peuvent pas effectuer de calcul en parallèle, mais elles le font beaucoup moins bien que les GPU comme le GTX280. C'est en tout cas ce que confirme l'étude d'Intel.

« C'est un moment rare dans l'univers de la technologie quand une entreprise avec laquelle vous êtes en concurrence affirme à l'occasion d'une importante conférence que votre technologie est jusqu'à 14 fois plus rapide que la sienne » écrit sur son blog Andy Keane, responsable de l'activité calcul GPU chez Nvidia, qui a fourni un lien vers le document du fondeur de Santa Clara.

[[page]]

Andy Keane n'a pas été impressionné par le rendement communiqué par Intel, il affirme que 10 clients de Nvidia clients ont amélioré d'un facteur 100 les performances de leurs applications optimisées pour fonctionner sur des GPU. La comparaison de performances réalisée par la firme n'a probablement pas

utilisé les logiciels les plus optimisés qui auraient permis de meilleurs résultats souligne-t-il. Il note également qu'Intel n'a pas fourni de détails sur le code logiciel utilisé pour ces tests.

« Ce ne serait pas la première fois dans l'histoire de l'industrie qu'Intel se voit reprocher ce type de pratique lors de benchmarks », écrit-il, en fournissant un lien vers la Federal Trade Commission américaine (en charge du contrôle des pratiques commerciales anticoncurrentielles) lors d'une procédure antitrust entamée contre Intel en 2009.

Dans cette action, la FTC fait valoir que des précédents résultats de tests rapportés par Intel « ne sont pas des mesures précises, ni réalistes quant à l'utilisation ou la performance d'ordinateur ordinaire, parce qu'elles n'ont pas été réalisées dans un cadre proche des «conditions réelles».

Indépendamment des différences techniques entre processeurs et GPU, les puces graphiques sont aujourd'hui utilisées dans les systèmes informatiques haute performance, comme sur le super computer chinois Nebulae. Deuxième calculateur le plus puissant au monde combine en effet Intel Xeon et circuit 3D Nvidia. L'ajout de GPU à un système de ce type peut sensiblement augmenter les performances, tout en réduisant les coûts et la consommation d'énergie par rapport aux systèmes reposants sûrs de processeurs, a expliqué Iouri Drozdov, CEO du fabricant de supercomputer Novatte basé à Singapour.

L'année dernière, Novatte a construit un système pour une banque qui voulait baisser le prix de ses machines. Le supercomputer, dont le coût dépasse le million de dollars, repose sur 60 processeurs Intel Xeon et 120 GPU Nvidia. Un système aux performances similaires utilisant uniquement des Xeon coûterait 1,6 million de dollars et consommerait jusqu'à 28% de plus. Ce qui rendrait au final ce dernier plus coûteux à utiliser que le système construit avec les GPU, précise Iouri Drozdov.

Pour sa part, Intel reconnaît l'importance d'avoir une solution de traitement en parallèle afin de compléter sa gamme processeurs. Après avoir tenter de développer sa propre gamme GPU avec le projet Larrabee (vite abandonné), en mai dernier le fondeur de Santa Clara a annoncé le développement d'une puce 50 coeurs baptisée Knights Corner, avec laquelle la société espère concurrencer efficacement les fabricants de puces graphiques sur le segment du calcul haute performance. Intel n'a toutefois pas indiqué quand Knights Corner sera disponible.

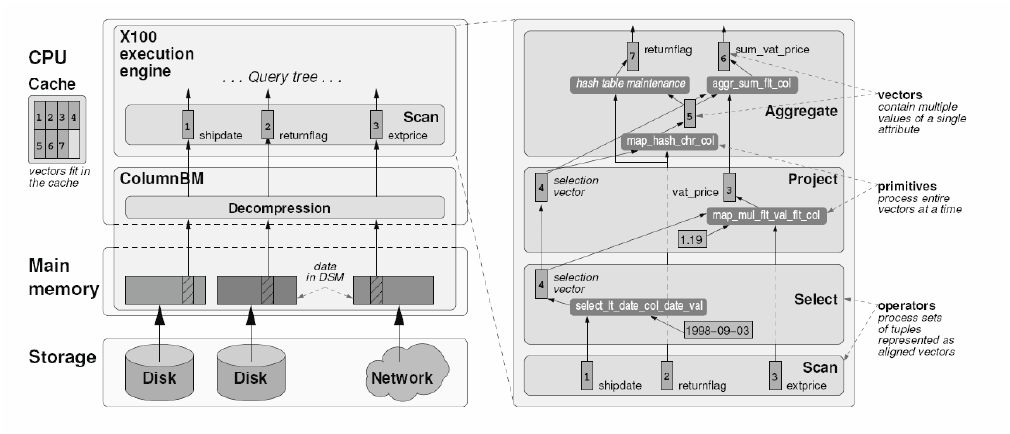

Avec VectorWise, Ingres affûte sa base pour les gros volumes

En s'appuyant sur un projet de recherche mené par l'Institut néerlandais CWI de recherche en informatique, l'éditeur de logiciels en Open Source Ingres vient de lancer une base de données spécifiquement conçue pour traiter les très gros volumes. C'est la préoccupation désormais commune de tous les spécialistes de la gestion de données, bloqués par les capacités des SGBD relationnels lorsqu'il s'agit d'analyser un nombre toujours croissant d'informations.

La technologie mise au point par VectorWise (émanation du CWI) est basée sur un moteur de requête qui tire parti des dernières générations de mémoires et de processeurs. Celui-ci est combiné à un stockage en colonnes, mode d'organisation désormais plébiscité pour optimiser les performances de traitement sur plusieurs téraoctets de données. Des performances atteintes sans qu'il soit nécessaire de mettre en place un système massivement parallèle à la configuration complexe, assure VectorWise. Les premiers benchmarks ont été fait sur une plateforme équipée de processeurs Xeon 5500 (Nehalem).

La base de données Ingres VectorWise peut être téléchargée gratuitement pour test.

Cliquer ici pour agrandir l'image

En savoir plus :

- Livre blanc sur Ingres/VectorWise

- Télécharger Ingres/vectorWise

Grenoble Ecole de Management crée un laboratoire d'innovation pédagogique

Les étudiants de Grenoble Ecole de Management, sélectionnés pour intégrer le Groupe Test Innovation, auront une surprise à la rentrée 2010. En effet, le campus grenoblois a choisi d'investir dans un parc de 50 iPads pour en expérimenter les futurs usages pédagogiques et quotidiens. Objectifs de la démarche : observer l'appropriation des méthodes et des outils par les étudiants et les professeurs, bénéficier de leurs retours d'expérience et de leurs idées, pour imaginer des applications pédagogiques transmissibles à tous au service de la vie de l'étudiant à l'Ecole. On peut aussi citer la consultation de livres numériques, l'accès aux supports de cours à distance, ou les publications des ouvrages des enseignants sur le e-book store. Toutefois, si la fourniture d'iPad constitue une nouveauté en soi, c'est dans le cadre d'une autre initiative qu'elle prend toute sa mesure : la création du Groupe Test Innovation, qui se positionne comme un laboratoire d'expérimentations et d'innovations pédagogiques.

Une présence moins intrusive qu'un PC portable

« La question que nous nous posons est de savoir si les tablettes actuelles ou futures vont remplacer les PC portables dans l'utilisation quotidienne », s'interroge Marc Humbert, responsable du Groupe Test Innovation. « On va peut-être s'apercevoir que la tablette est une présence moins intrusive en salle de classe qu'un PC portable ouvert parce qu'elle ne fait plus barrière entre les étudiants et le professeur. » Sélectionnés sur leur motivation et leur sensibilité aux problématiques de l'innovation, les 40 étudiants du futur laboratoire de recherche se verront proposer le même programme en termes d'acquisitions de connaissances et de compétences que les 500 élèves de 1ère année. Ils seront également soumis aux mêmes évaluations. En revanche, c'est sur la forme que le parcours différera, les élèves devant tester d'autres méthodes d'enseignements - tels que les serious games, ou le mind mapping.-, qui si elles sont concluantes, seront généralisées à l'ensemble des promotions.

Crédit photos : Grenoble Ecole de Management (...)

NKM : financer et non pas subventionner le numérique innovant

« Le Grand Emprunt ne servira pas à mettre en place un super-guichet à subventions : c'est avant tout de l'investissement par la prise de participations et des prêts » a martelé Nathalie Kosciusko-Morizet, secrétaire d'Etat au développement de l'économie numérique, lundi 7 juin lors du lancement de la consultation publique sur l'action de soutien aux usages et contenus numériques innovants. Elle s'est offusquée : « certaines interviews publiées dans la presse ont été hallucinantes, des acteurs étant persuadés de toucher des subventions issues du Grand Emprunt. »

Ces financements ne seront fixés en détail, sur leurs cibles exactes et leurs modalités précises, qu'après une consultation publique ouverte jusqu'au 5 juillet 2010 à 14 heures (selon le dossier distribué. Le site web du secrétariat d'Etat indique désormais le 7 juillet). Les montants en jeu ont de quoi exciter les convoitises puisque c'est au total 2,5 milliards d'euros qui seront débloqués pour soutenir les usages et contenus numériques innovants, sur un total de 4,5 milliards d'euros consacrés à la société de l'information dans le Grand Emprunt. La différence -2 milliards d'euros- est consacrée aux infrastructures (haut débit pour tous...). Le résultat de la consultation sur les infrastructures devrait d'ailleurs être publié sous peu, ce qui donnera le ton pour cette nouvelle consultation.

PME innovantes et logiciels libres en priorité

Pour la secrétaire d'Etat, « les géants d'aujourd'hui ont été les PME d'hier. Notre consultation vise à aller chercher les PME innovantes actuelles pour les aider à être les géants de demain. Nous cherchons à découvrir des projets ou des idées que nous ne connaissons pas actuellement. Nous lançons d'ailleurs un appel particulier aux éditeurs de logiciels libres et aux créateurs d'outils open-source. »

Neuf priorités d'investissements ont été définies : le développement de l'informatique en nuage (« cloud computing »), la numérisation des contenus culturels, éducatifs et scientifiques et leur indexation, le développement des technologies de base numérique (notamment les nanotechnologies, l'électronique et les logiciels embarqués), les réseaux électriques intelligents («smarts grids» pour mieux gérer l'énergie sur un plan écologique), la e-santé (ce qui va au delà de la seule télémédecine : toutes les applications numériques autour de la santé), la sécurité et résilience des réseaux (ce qui intègre la problématique de la signature électronique et de la confiance numérique), les systèmes de transports intelligents, la « ville numérique » (dont la question du télétravail) et enfin la e-éducation.

« Il ne s'agit en aucun cas de financer l'équipement des établissements, notamment scolaires ou hospitaliers avec la e-santé et la e-éducation, mais bien de faire émerger des offres et des technologies » a beaucoup insisté Nathalie Kosciusko-Morizet.

[[page]]

Autre point essentiel : très peu de subventions sont prévues. Un peu comme le fait Oseo-Anvar, l'intervention publique se fera sous forme de prises de participations, de prêts, d'avances remboursables et seulement très accessoirement de subventions. L'intervention de l'Etat, « investisseur avisé », se fera aux côtés d'investisseurs privés et sous la condition qu'elle soit nécessaire à structurer un segment de marché. Cependant, les financements liés au Grand Emprunt « n'ont ni les mêmes horizons ni les mêmes objectifs », selon la secrétaire d'Etat, que ceux délivrés par Oseo-Anvar et les circuits seront donc différents, via le FSN (Fonds pour la Société Numérique).

La consultation publique lancée vise à mieux définir les innovations où l'action de l'Etat est nécessaire. Pour chaque item d'innovation, plusieurs questions sont posées dans le document disponible. Les contributeurs doivent donc chercher à répondre à ces questions très ouvertes.

Des appels à projets pour la rentrée au plus tard

Les conclusions seront publiées (avec les contributions originales) courant juillet 2010. Lorsque le consensus sera large et sans surprise, les premiers appels à projets seront effectués dans la foulée. Les derniers devraient être publiés à la rentrée 2010.

Restera alors à définir comment l'Etat gèrera les actifs issus des financements comme les participations dans les entreprises innovantes. « La forme juridique du portage des actifs est encore en débat, l'ensemble du financement étant sous le contrôle des commissions des finances de l'Assemblée Nationale et du Sénat ainsi que sous celui de la Commission Rocard-Juppé » a indiqué Nathalie Kosciusko-Morizet. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |