Flux RSS

Virtualisation

557 documents trouvés, affichage des résultats 91 à 100.

| < Les 10 documents précédents | Les 10 documents suivants > |

(30/11/2010 15:36:05)

Une start-up recycle les ressources inutilisées dans les clouds

Si l'on s'intéresse aux technologies permettant d'améliorer l'utilisation des ressources informatiques au sein de l'entreprise, ce sont assurément VMware et son logiciel de virtualisation x86 qui viennent peut-être le plus facilement à l'esprit. Mais il en existe une nouvelle, plus récente, proposée par un petit vendeur qui a déjà attiré de nombreux clients classés au Fortune 500. Celui-ci propose des technologies de « grille » et de gestion cloud qui réutilisent les cycles de calcul perdus et automatisent le processus de construction de clusters HPC. Fondée il y a cinq ans, Cycle Computing avait pour principale activité d'aider ses clients à utiliser Condor, un système de gestion de charge pouvant exécuter des tâches de calcul intensif sur des PC mis en veille. Puis, l'entreprise a été amenée à gérer de nombreux systèmes de planification de tâches, imaginant pour ses clients des solutions permettant de réutiliser la capacité excédentaire des installations VMware, compatibles avec des services cloud comme l'EC2 d'Amazon.

Lors de la récente conférence SC10 sur les supercalculateurs qui s'est tenue à la Nouvelle Orléans, le fondateur et PDG de Cycle Computing, Jason Stowe, a pu faire état d'une impressionnante liste de clients, parmi lesquels JP Morgan Chase, Pacific Life, Lockheed Martin, Eli Lilly, Pfizer, Bank of America, Electronic Arts, Johnson & Johnson et ConocoPhillips. JP Morgan Chase, par exemple, s'appuie sur la technologie de Cycle Computing pour effectuer d'importants calculs en utilisant des capacités de travail qui, selon Jason Stowe, seraient perdues. Sa société de moins de 20 personnes, qui a démarré sans investisseurs extérieurs, affiche « quelques millions de dollars » de revenus pour moins d'une centaine de clients. « Cycle Computing a vu ses revenus croître de 50% par an au cours des quatre dernières années, » a déclaré son PDG.

Une technologie issue du monde mainframe

Tout comme VMware a emprunté sa technologie de virtualisation au mainframe d'IBM pour l'appliquer aux centres de calcul avec leurs serveurs x86, Computing Cycle s'est inspirée de stratégies fondées sur une recherche vieille de plusieurs décennies et l'a adapté à l'âge du cloud computing et de la virtualisation. L'idée d'exploiter les cycles inutilisés des ordinateurs de bureau pour réaliser des clusters de calcul existe « depuis 20 ans », explique Steve Conway, analyste chez IDC. Le système Condor est lui aussi connu depuis 25 ans environ. « Cycle Computing a réussi, parce qu'elle propose d'automatiser les tâches difficiles qui doivent être effectuées par les administrateurs, » fait remarquer l'analyste, ajoutant que «tout le monde cherche la facilité d'utilisation. » Mais pour Steve Conway, le plus intéressant au sujet de Computing Cycle, c'est son plan à long terme pour proposer une technologie de clusters viable et compatible avec des services cloud comme Amazon EC2. Même s'il pense que la technologie n'a pas encore atteint son maximum aujourd'hui, il estime « qu'au cours des prochaines années », il pourra être possible de la développer sur tous les clouds publics, un équivalent total de l'environnement informatique corporate sur site, avec toutes les politiques, toutes les directives, et tout le reste. « Ce modèle peut vraiment devenir une extension élastique de l'environnement d'entreprise, » a-t-il déclaré.

Le produit CycleCloud, construit sur Amazon Web Services, permet aux clients de créer des clusters de calcul haute performance qui ouvrent et ferment automatiquement les noeuds à mesure que les charges de travail démarrent et s'achèvent. « En quelques minutes - 10 à 15 min environ -le logiciel CycleCloud « met en route un environnement HPC complet à l'intérieur de l'infrastructure Amazon, » avec des systèmes de fichiers partagés, un térabit de stockage, une interconnexion de 10 Gigabits et des puces Nehalem d'Intel, » explique le PDG de Cycle Computing. Alors que CycleCloud gère les ressources externes, CycleServer, autre produit du vendeur, apporte au centre de calcul une interface web basée sur Condor, SGE, Torque et Hadoop pour la gestion des clusters HPC. La technologie de Cycle Computing fonctionne indifféremment sur des systèmes d'exploitation Linux et Windows.

En complément de VMware

L'une des utilisations les plus surprenantes de cette technologie concerne les datacenters faisant un usage intensif de l'hyperviseur VMware. Selon Jason Stowe, même si la technologie VMware optimise l'utilisation des cycles en permettant à de multiples images de système d'exploitation et à des applications de s'exécuter sur la même machine, ces serveurs sont encore sous-utilisés, en particulier la nuit. «VMware travaille sur la consolidation. Cela ne modifie pas la nature du pic comparé à l'utilisation moyenne,» indique le PDG de Cycle Computing. « Ces serveurs sont utilisés de manière incroyablement intense à certains moments, et pas du tout à d'autres. La virtualisation n'a aucun impact sur ça. » L'entreprise a une demande croissante pour améliorer l'utilisation des serveurs VMware et dispose « d'une assez belle notoriété autour de ça, » ajoute Jason Stowe. « Si vous tirez 20% à 40% de votre environnement VMware, c'est déjà assez impressionnant en terme de degré d'utilisation du processeur, » dit-il. « Mais vous laissez toujours une capacité de 60% de côté. Notre système permet d'arriver à plus de 90%. »

Même si les produits de Cycle sont plutôt ciblés sur des scénarios de calcul technique, en théorie, toute entreprise ayant une capacité de calcul inutilisée pourrait en bénéficier. « Parmi les concurrents de Cycle Computing, on peut citer SGI et Wipro, Amazon et Microsoft, » dit Steve Conway. Amazon, par exemple, offre désormais des instances de clusters basées sur des processeurs graphiques, et Windows HPC Server de Microsoft sait maintenant utiliser des PC en veille tournant sous Windows 7. Selon l'analyste, Cycle Computing a tendance à être plus cher que ses concurrents, car ses produits sont très spécialisés. Mais celui-ci a confiance dans l'avenir de la jeune entreprise. «Ce que j'aime à propos de Cycle en particulier, c'est la perspective que l'entreprise apporte, » dit Steve Conway. « Ils ont vraiment une vision très forte et très claire de la manière dont va évoluer le cloud computing dans les deux à cinq prochaines années. »

Cisco adapte ses solutions de vidéoconférence à la virtualisation

L'utilisation croissante de la vidéo et de la vidéoconférence dans les échanges professionnels a obligé les constructeurs comme Cisco à chercher des produits adaptés à la virtualisation qui permettent à leur tour de stocker les données et d'améliorer les applications quand elles sont placées sur des serveurs au sein des datacenters pour fonctionner en même temps sur des bureaux virtuels et des applications pour appareils mobiles. « En général, la voix et la vidéo ne passent pas très bien en mode virtualisé depuis un datacenter, » a déclaré Barry O'Sullivan, vice-président de Cisco pour les technologies Voice. « Mais avec la nouvelle architecture de virtualisation VXI - pour Virtualization Experience Infrastructure - nous pensons avoir résolu ce problème. » Selon lui, le VXI pourra améliorer de 60% la densité des bureaux virtuels sur les serveurs. Disponible de suite, on sait encore peu de chose sur le VXI.

Premier des deux dispositifs, le VXC 2200 se présente comme une tour autonome de moins de 12 cm de hauteur, dotée de quatre ports USB et de deux ports vidéo. « Celle-ci peut trouver sa place entre un téléphone de bureau et un système de téléprésence, » a déclaré Barry O'Sullivan. Le VXC 2100, plus petit, se fixe quand à lui sur le dos d'un téléphone IP Cisco, peut être connecté à deux écrans de bureau traditionnels, et dispose de quatre ports USB pour être notamment relié à un clavier. Tous deux sont alimentés via un port Power over Ethernet et chacun est doté d'un processeur intégré permettant le décodage des protocoles de virtualisation. « Cela signifie que les entreprises peuvent conserver leurs données sur les serveurs dans les datacenter, plutôt que sur l'ordinateur de bureau ou le dispositif mobile de leur salarié, » a déclaré le vice-président de Cisco. Le VXC 2200 et le VXC 2100 devraient être disponibles en mars 2011 pour un prix inférieur à 500 dollars, avec clavier USB, souris et licence client. Ils supporteront VMware View 4.5 et Citrix XenDesktop.

Teleprésence, webconference, iPad et Cius

Cisco a par ailleurs annoncé deux nouvelles solutions de videoconference : le système de TelePresence EX60 et le système 500-32 pouces. Disponible d'ici fin 2010 au prix de 6 900 dollars, le EX60 et son écran 21 pouces haute définition peut facilement servir de moniteur de bureau. Quant au CTS 500 32 pouces, également disponible d'ici à la fin de l'année au prix de 23 900 dollars, il est plutôt destiné aux dirigeants pour leurs besoins de vidéoconférence. Il peut être fixé au mur ou placé sur un pied. Ces dispositifs pourront être géré par le système unifié Cisco Unified Communications Manager. Ce qui signifie que ce système de contrôle d'appel unique pourra être utilisé à la fois pour la vidéoconférence et la voix.

Une autre innovation combine WebEx de Cisco avec la vidéo de haute définition. Dans la nouvelle interface, il est possible d'agrandir l'image de la personne qui parle à l'écran et apporte plus de souplesse dans la manière dont sont organisées les images des documents partagés par les participants. Cisco a également annoncé que le nouveau WebEx Meeting Center et sa vidéo haute définition seront compatibles avec l'iPad d'Apple dès le mois de décembre, puis avec la tablette Cius attendue en mars prochain. L'équipementier a profité de l'occasion pour signaler que sa tablette serait compatible avec VMware View, Citrix Receiver, et avec le logiciel de virtualisation Wyse Pocket Cloud et serait capable d'interagir avec tout ordinateur sous Windows utilisé dans un datacenter. Enfin, Cisco travaille aussi à rendre ses outils de vidéoconférence interopérables avec les terminaux standards de l'industrie, y compris ceux de concurrents comme Polycom et LifeSize.

Illustration: VXC 2200

Crédit Photo: Cisco

(...)(05/11/2010 14:14:57)Virtualiser avant de passer à Windows 7 ?

La virtualisation des bureaux, des applications et des fonctions utilisateurs peut potentiellement contribuer à pousser les utilisateurs vers une machine tournant sous Windows 7, et résoudre au passage les problèmes de compatibilité des applications. Toutefois, la mise en place des projets de virtualisation prend du temps et engendre un coût non négligeable - même si Microsoft a décidé de baisser le prix de la licence Windows pour les postes de travail virtuels -, si bien que les revendeurs informatiques auront à estimer au plus juste les avantages et les inconvénients d'une telle offre.

Sur son blog Windows, Microsoft ne dit cependant pas grand-chose, à part mettre en avant de manière très positive les avantages de la virtualisation du bureau pour l'entreprise. « À mesure que les clients migrent vers Windows 7, la plupart choisissent d'adopter les technologies de virtualisation, » écrit Rich Reynolds, le directeur général de Microsoft Windows. « Cela permet aux responsables informatiques de simplifier le déploiement, la migration et la gestion de leurs environnements de travail. Cela permet aussi d'offrir plus rapidement un service, de centraliser et de sécuriser les données. Cela rend enfin les applications et les fonctions utilisateurs disponibles indépendants de tout paramétrage local. » Celui-ci ajoute que « ces avantages peuvent aider les utilisateurs à se familiariser plus facilement et plus rapidement avec Windows 7, si bien que nous recommandons à tous nos clients passant sous Windows 7 de voir dans quelle mesure la virtualisation de bureau peut contribuer positivement à leur migration. »

Une offre vaste

Évidemment, Microsoft pousse ses propres produits de virtualisation pouvant aller de pair avec Windows 7. L'éditeur a notamment récemment mis à jour Microsoft Enterprise Desktop Virtualization qui améliore la compatibilité avec les applications existantes et offre plus d'options pour faire tourner des applications web nécessitant l'usage d'un Internet Explorer 6 dépassé. « La virtualisation de bureau rendra les tâches plus faciles à travers ses technologies. Par exemple, les outils de virtualisation de Microsoft permettent de séparer le bureau en plusieurs niveaux : la Session Utilisateur, les applications, et l'OS, » écrit encore le directeur général de l'éditeur. Par ailleurs, Win 7 intègre un mode XP et la technologie Virtual PC pour faire tourner des systèmes d'exploitation plus anciens.

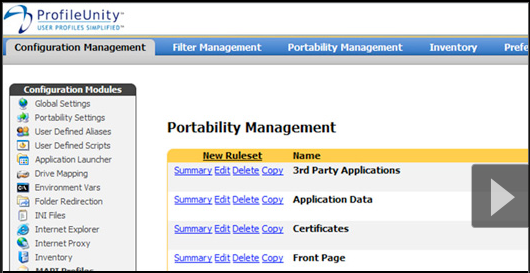

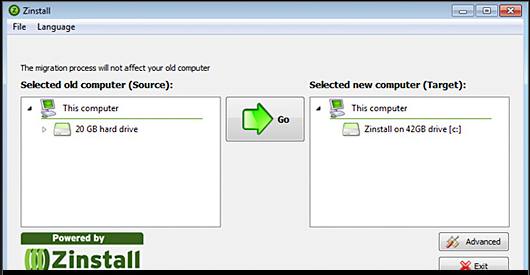

Cependant, dans le domaine de la virtualisation de bureau, Microsoft se trouve face à plusieurs concurrents de taille, et il est peu probable que l'éditeur parvienne à dominer ce marché, de la même manière qu'il domine celui des systèmes d'exploitation. Ses plus grands concurrents, Citrix et VMware, offrent tous deux, des logiciels aussi bien que des applications de virtualisation de bureau. Par ailleurs, constatant que de nombreux clients rencontraient des problèmes pour faire migrer leurs applications depuis d'anciennes versions Windows vers Seven, Vmware a déjà mis à jour cette année son logiciel de virtualisation d'applications ThinApp pour faciliter la transition. Mais Citrix XenDesktop et VMware ThinApp sont loin d'être les seules alternatives à Microsoft. Des fournisseurs comme Dell KACE K2000 Deployment Appliance, AppSense Environment Manager, Liquidware Labs ProfileUnity, Parallels Desktop Upgrade to Windows 7, Tranxition Migrate7, Viewfinity User Migration, Zinstall XP7, Ghost et Altiris de Symantec, proposent tous des solutions professionnelles ou grand public pour aider les utilisateurs à passer sur une plate-forme virtuelle pour accueillir Windows 7.

PDC 2010 : Windows Azure ressemble un peu plus à Amazon EC2

C'est une avancée notable que Microsoft propose sur sa plateforme de cloud Windows Azure en permettant d'y installer des machines virtuelles Windows Server. Cela rend théoriquement possible le portage vers cet environnement d'applications exploitées en interne et sur d'autres datacenters. Microsoft élargit donc sa palette de services dans le cloud face à un concurrent tel qu'Amazon qui propose depuis l'origine des services d'infrastructure avec sa plateforme EC2 (Elastic Compute Cloud).

Steve Ballmer (photo ci-dessus), PDG de l'éditeur, vient d'en faire l'annonce sur sa conférence développeurs PDC qui a démarré hier sur le campus de Redmond, où se trouve le siège social du groupe américain. Parmi les fonctions ainsi apportées figurent Azure Virtual Machine Role et Server Application Virtualization. Le premier outil permet de faire tourner une machine virtuelle de Windows Server 2008 R2 sur Azure et de faciliter ainsi aux développeurs les processus de migration vers le cloud. Une version bêta publique du produit sera disponible d'ici la fin de l'année. L'autre solution servira à transférer des images d'application vers Azure et à faciliter la migration sans exiger de réécriture ni les associer à une machine virtuelle. On peut créer une image virtuelle d'un serveur physique et la transférer sur Windows Azure, explique Bernard Ourghanlian, directeur technique de Microsoft France. Cette possibilité est pour l'instant limitée à Windows Server 2008 R2, mais il n'est pas exclu que d'autres versions de Windows soient ensuite supportées, en remontant jusqu'à Windows Server 2003. En revanche, il n'est pas envisagé de supporter d'autres systèmes d'exploitation tel qu'Amazon le fait sur EC2 avec Linux et Solaris.

A partir de 0,05 dollar de l'heure

Une fois que l'application est déployée sur Azure, les clients disposent automatiquement des capacités d'administration de la plateforme de cloud, ce qui inclut la configuration automatique et la gestion de l'OS utilisé. Server Application Virtualization pour Azure sera livré sous la forme d'une version CTP (community technology preview) avant fin 2010 et la version finale arrivera au deuxième semestre 2011.

Avec la prochaine version de System Center, qui devrait sortir avant fin 2011, on pourra administrer de façon centralisée les machines virtuelles sur des serveurs locaux et celles fonctionnant sur Azure.

Les développeurs peuvent désormais choisir entre cinq tailles d'instances de machine virtuelle pour faire tourner leur application en fonction des ressources requises. Microsoft vient en effet d'ajouter à sa tarification l'instance Extra Small, facturée à 5 cents de dollar l'heure. A ce prix, on dispose d'un processeur à 1 GHz, de768 Mo de mémoire et de 20 Go de capacités de stockage. Un tarif attractif pour ceux qui veulent pouvoir tester de petites applications dans le cloud. L'instance la plus robuste (Extra Large) permet de disposer de huit processeurs à 1,6 GHz, de 14 Go de mémoire, de 2 Go de stockage pour 0,96 dollar de l'heure. Les performances d'entrée/sortie diffèrent sensiblement : faible pour l'offre Extra Small, élevée pour l'Extra Large.

De son côté, Amazon va proposer un accès gratuit à EC2 à partir de la semaine prochaine.

Microsoft voit une convergence des offres cloud, Amazon non

En juin dernier, Microsoft avait promis qu'il offrirait la capacité d'exploiter des machines virtuelles, proposant ainsi des services se rapprochant de ceux d'Amazon, ce dernier permettant d'exploiter sur EC2 différentes machines virtuelles sous Windows et Linux.

Sur le marché du cloud computing, on distingue actuellement, d'une part, les fournisseurs de services d'infrastructure (IaaS) comme Amazon qui propose avec EC2 un accès « brut » aux instances de machines virtuelles. On trouve d'autre part des plateformes comme Azure qui offrent des outils aux développeurs mais donnent un accès moindre à l'infrastructure sous-jacente. Selon Microsoft, ces deux types d'environnement vont commencer à se ressembler et l'annonce de machines virtuelles Windows Server sur Azure est l'une des étapes qui y conduit. Pourtant, Amazon a prévenu qu'il ne prévoyait pas d'évoluer vers les environnements PaaS, en avançant comme raison le fait que ses clients lui ont clairement indiqué qu'ils voulaient continuer à bâtir leurs applications sans se voir imposer de modèle de programmation, de langage ou de systèmes d'exploitation, quels qu'ils soient.

Microsoft a également lancé AppFabric Composition Model pour Azure, un jeu d'extensions au framework .Net pour écrire des applications qui puissent être exploitées de façon cohérente entre l'environnement Azure et les plateformes Windows Server.

[[page]]

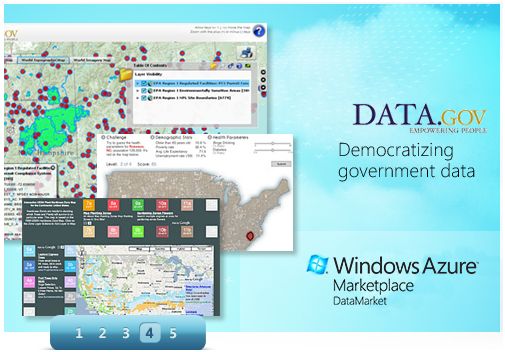

Sur sa conférence PDC, l'éditeur a par ailleurs annoncé l'ouverture de la place de marché Windows Azure DataMarket (ancien projet Dallas) qui propose, sous forme de services, l'accès à des contenus et à des données. Les développeurs pourront se servir des interfaces de programmation (API) OData exposées par DataMarket pour exploiter dans des applications les données mises à disposition sur la place de marché.

La place de marché DataMarket

Dans les entreprises, les utilisateurs intervenant sur des applications décisionnelles pourront combiner l'exploitation d'Excel et d'un outil comme PowerPivot avec l'accès à DataMarket et associer les données de l'entreprise avec des bases de données statistiques (professionnelles, industrielles, démographiques, etc.).

Illustration d'ouverture : Steve Ballmer, PDG de Microsoft, le 28 octobre à l'ouverture de la conférence développeurs PDC, sur le campus de Redmond (crédit photo : vidéo Microsoft)

La migration vers Windows 7 gourmande en ressources, mais nécessaire

Quelques 1 360 responsables informatiques ont été interrogés pour une étude, commandée par la firme de sécurité Symantec. Le rapport publié par l'éditeur montre que près d'un quart des entreprises (23%) dans le monde sont passés à Windows 7 depuis Windows Vista, trois ans seulement après le lancement de ce dernier. Symantec a constaté que la planification et le processus de migration implique activement la moitié de tous le personnel. Dans une autre étude, le Gartner a constaté que les entreprises consacrent de 12 à 18 mois sur le seul processus de planification. L'enquête de Symantec a également montré que la migration a pris plus longtemps que prévu, en raison d'une incompatibilité de certaines applications (citée par 52 %).

La même étude constate que les responsables informatiques sont contents de l'ensemble des avantages tirés de cette évolution. Interrogés sur les facteurs qui avaient été " quelque peu ou beaucoup améliorés " depuis la migration, la performance arrive en tête à 79%, suivi d'une expérience utilisateur final et de la sécurité (76% pour chaque). Les autres facteurs positifs sont la fiabilité (74%), la facilité d'utilisation (69%) et de la gestion (66%).

D'autres conclusions du rapport de migration vers Windows 7:

- La préparation : les sondés ont expliqué que leurs équipes informatiques ont dépensé en moyenne dix heures pour préparer la mise à jour - y compris la planification, la formation et des pilotes.

- Le processus de migration : la durée moyenne du temps consacrée à la migration de chaque machine existante disposant d'un ancien OS est de 5 h, mais elle est réduite à 4 h dans le cadre du déploiement d'un nouveau PC.

- L'automatisation : des commentaires des répondants ont indiqué que si une organisation avait au moins dix ordinateurs, cela valait la peine d'automatiser le processus de migration.

- Rajeunir à l'ensemble du parc : de nombreuses sociétés ont déclaré avoir utilisé leur mise à niveau vers Windows 7 comme une occasion pour mettre en oeuvre certains standards. Déployer une interface de bureau virtuelle et des mesures de sécurité supplémentaires. Afin de gérer les applications qui incompatibles avec Seven, 71% des répondants les ont tout simplement remplacé.

- Résultat : dans l'ensemble, 78% des équipes informatiques ont déclaré que le processus de migration s'était passé «en douceur», et 63% qu'il était plus facile que leur dernière mise à jour d'OS. Sur les 62% des sociétés qui s'étaient fixés des objectifs de ROI (retour sur investissement), 90% les ont atteint.

" Pour de nombreux responsables IT, la migration vers Windows 7 est le projet le plus important de l'année 2010 ", a déclaré Christine Ewing, directrice marketing produit chez Symantec. " Notre enquête démontre que, tandis que si certaines sociétés ont pris du retard en raison d'incompatibilité applicative et/ou des contraintes budgétaires, la plupart des compagnies interrogées ont atteint leurs objectifs lors de cette transition, à savoir une plus grande fiabilité, des performances améliorées et une meilleure expérience pour l'utilisateur final" conclut la responsable. (...)

Hyper-V de Microsoft accompagne le développement d'OpenStack

« Cette association répond à la fois à la transformation de la plate-forme Hyper-V vers la prise en charge des environnements Open Source, mais aussi aux évolutions des clouds » souligne Alfonso Castro, directeur de la nouvelle stratégie Interopérabilité de Microsoft France. Concrètement, l'éditeur fournira des conseils techniques et d'architecture à Cloud.com. De son côté, Cloud.com développera le code supportant OpenStack sur Windows Server 2008 R2 Hyper-V. Le code du projet sera finalement enregistré dans l'annuaire de code public http://openstack.org. Pour autant précise Alfonso Castro, « il s'agit d'un transfert de technologie, nous mettons à disposition des ressources humaines et techniques, mais en aucun cas nous ne délivrons le code source de notre produit ».

Sur le plan des hyperviseurs, OpenStack est déjà compatible avec Xen, KVM et QEMU.

OpenStack a annoncé la semaine dernière les premiers éléments de ses travaux qui prendront leur essor en 2011. Ce projet est soutenu par de nombreux industriels, dont la NASA qui apporte son savoir-faire sur plusieurs briques technologiques. Cette dernière a rappelé d'ailleurs récemment que son objectif était d'améliorer la conquête spatiale et non devenir un fournisseur de cloud.

| < Les 10 documents précédents | Les 10 documents suivants > |