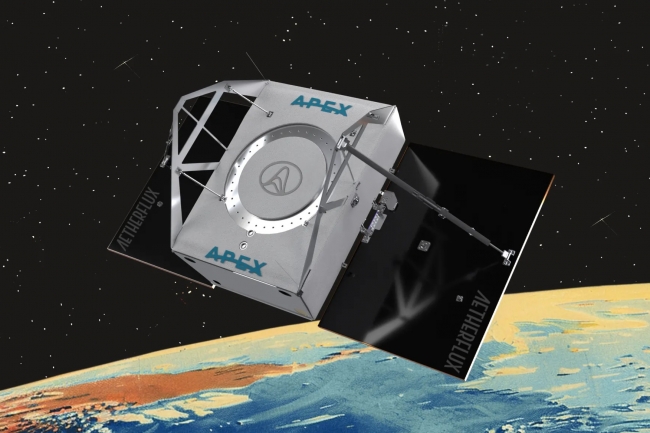

Aetherflux annonce le lancement de son premier satellite de centre de données orbital alimenté à l'énergie solaire au premier trimestre 2027. L’entreprise rejoint ainsi SpaceX, Amazon, Google et Starcloud dans la course aux infrastructures informatiques en orbite, alors que les besoins énergétiques de l'IA dépassent la capacité des centres de données terrestres. « Le premier nœud de centre de données d'Aetherflux destiné à un usage commercial est prévu pour le premier trimestre 2027, et les lancements de satellites suivants permettront de construire une constellation de nœuds afin d'augmenter la capacité », a déclaré Aetherflux dans l’annonce de son projet baptisé « Galactic Brain ». Cette initiative reflète la pression croissante exercée par l'IA sur l'infrastructure des centres de données. Selon les estimations du Forum économique mondial, la consommation énergétique des centres de données devrait doubler d'ici à 2030. Goldman Sachs pense que la demande en électricité sera encore plus élevée, avec une hausse de 160 % d'ici là. « Pourtant, moins d'un DSI sur dix a inclus l'informatique orbitale dans son plan d'action à trois ou cinq ans, même si plus de six sur dix citent l'énergie, l'espace et les autorisations comme les principales contraintes pesant sur l'infrastructure de l'IA », a fait remarquer Sanchit Vir Gogia, analyste en chef chez Greyhound Research, en citant les données de l'entreprise.

Feuille de route technique

D’après un porte-parole de l’entreprise, le premier nœud d'Aetherflux fournira une « bande passante de plusieurs gigabits », avec une disponibilité comparable à celle des serveurs terrestres grâce à l'utilisation de liaisons optiques intersatellitaires et de réseaux relais émergents. « Notre feuille de route commence par le déploiement de systèmes de classe téraflop en 2027 », a indiqué le porte-parole. « L'architecture a été conçue de manière à pouvoir passer rapidement à des constellations de classe pétaflop à mesure que nous augmentons le nombre de nœuds déployés. » Les entreprises se connecteront et géreront les charges de travail orbitales « de la même manière qu'elles gèrent aujourd'hui les charges de travail dans le cloud », à l'aide de liaisons optiques, a ajouté le porte-parole. L'entreprise prévoit de « lancer en permanence de nouveaux matériels et d’intégrer rapidement les dernières architectures », les anciens systèmes exécutant des tâches moins prioritaires afin d'exploiter pleinement la durée de vie utile de leurs GPU haut de gamme. L'entreprise a refusé de divulguer ses tarifs. Aetherflux prévoit de lancer environ 30 satellites à la fois à bord de fusées SpaceX Falcon 9. Avant le lancement du centre de données, l’entreprise lancera en 2026 un satellite de démonstration de transmission d'énergie afin de tester la transmission d'un kilowatt d'énergie depuis l'orbite vers des stations au sol, à l'aide de lasers infrarouges. La concurrence dans ce secteur s'est intensifiée ces derniers mois. En novembre, Starcloud a lancé son satellite Starcloud-1 équipé d'un processeur graphique Nvidia H100, 100 fois plus puissant que tous les processeurs graphiques précédemment utilisés dans l'espace selon l’entreprise, et il a démontré qu'il était capable d'exécuter le modèle d'IA Gemma de Google en orbite. En novembre également, Google a annoncé le projet Suncatcher, avec une mission de démonstration prévue pour 2027.

Des applications limitées à court terme, selon les analystes

« Malgré la concurrence, les datacenters orbitaux ne remplaceront pas les régions cloud terrestres pour l'hébergement général avant 2030 », a estimé Ashish Banerjee, analyste principal chez Gartner. « Ces centres conviennent plutôt à des charges de travail spécifiques, notamment pour répondre aux exigences de souveraineté des données dans des scénarios juridiquement complexes, offrir une reprise après sinistre à l'abri des risques terrestres et fournir un calcul asynchrone haute performance », a-t-il ajouté. « Les centres orbitaux sont idéaux pour les tâches par lot à forte intensité de calcul et à faible E/S », a expliqué M. Banerjee. « C’est le cas par exemple des simulations de repliement moléculaire pour l'industrie pharmaceutique, des simulations financières Monte Carlo à grande échelle ou de l'entraînement de poids de modèles d'IA spécifiques. Si la tâche prend 48 heures, la pénalité de latence de 500 ms d’un réseau de satellites en orbite terrestre basse (LEO) n'a aucune importance, » a-t-il ajouté. « Une application immédiate consiste à traiter les données générées par les satellites en orbite », a-t-il encore indiqué.

Les satellites d'observation de la Terre utilisant un radar à ouverture synthétique génèrent environ 10 gigaoctets par seconde, mais la bande passante limitée de la liaison descendante crée des goulots d'étranglement. « Le traitement des données en orbite et la transmission des seuls résultats pourraient réduire la latence et les coûts de communication », a-t-il poursuivi. Toujours selon M. Banerjee, les charges de travail adaptées à l'espace partagent trois caractéristiques : de faibles exigences en matière de transfert de données, une tolérance à la latence et une forte intensité énergétique. M. Gogia est d’accord sur la portée limitée de ces centres de données orbitaux. « Les services bancaires de base, le commerce électronique, les ERP, la collaboration et la plupart des analyses resteront résolument terrestres », a-t-il souligné. « Ces systèmes sont étroitement liés à l'interaction avec les utilisateurs, aux contrôles réglementaires et à la gravité des données existantes. »

Des obstacles importants liés aux coûts

L'idée selon laquelle le coût de l'énergie dans l'espace est presque nul « a du mérite, mais elle est économiquement dangereuse si elle est prise isolément », a pointé M. Banerjee. « Les centres de données terrestres ont des dépenses opérationnelles d'électricité et de refroidissement élevées, mais des dépenses d'investissement modérées. En orbite, les coûts opérationnels liés à l'énergie sont proches de zéro, mais les dépenses d'investissement sont astronomiques », a-t-il rappelé. « Il faut construire la centrale électrique (panneaux solaires) et la tour de refroidissement (radiateurs), puis lancer le tout à un coût de plusieurs milliers de dollars par kilogramme », a expliqué M. Banerjee. Les coûts de lancement constituent un obstacle majeur. Les recherches de Google ont montré que les coûts doivent passer sous la barre des 200 dollars par kilogramme d'ici le milieu des années 2030 pour que les centres de données orbitaux puissent rivaliser avec les installations terrestres en termes de coûts. Falcon 9 de SpaceX facture actuellement environ 2 500 dollars par kilogramme. Le renouvellement du matériel vient compliquer le défi. Sur Terre, les entreprises renouvellent leurs équipements tous les trois à cinq ans. « Dans l'espace, le matériel ne peut pas être mis à niveau une fois lancé », a déclaré M. Banerjee. « Si Aetherflux lance les GPU H100 en 2027, ils seront obsolètes d'ici 2030 », a-t-il ajouté. « Les fournisseurs orbitaux doivent traiter les satellites comme des objets jetables, en lançant de nouveaux clusters chaque année, ce qui augmente considérablement le coût total de possession. »

Le refroidissement ajoute un autre niveau de coût. « Dans le vide, le refroidissement ne se fait que par rayonnement, ce qui nécessite d'énormes panneaux radiateurs. Chaque kilogramme de radiateur augmente les coûts de lancement, réduisant ainsi les économies réalisées grâce à l'énergie solaire gratuite », a-t-il expliqué. « Compte tenu de ces défis, plus de 70 % des DSI estiment que l’avantage en termes de coût total doit être au moins de 30 à 40 % avant d'envisager des options orbitales », a constaté M. Gogia, citant les données de Greyhound Research. Mais, malgré ces obstacles, les prévisions du marché restent optimistes. BIS Research prévoit que le marché des centres de données en orbite atteindra 1,77 milliard de dollars en 2029 et 39,09 milliards de dollars d'ici 2035.

Des prévisions temporelles divergentes

« Les délais annoncés doivent être considérés comme des objectifs ambitieux et non comme des repères de planification pour les DSI », a estimé M. Gogia. « Les projets pilotes réalistes pour les charges de travail de niveau production sont plus susceptibles de voir le jour vers la fin de cette décennie. » Pour les architectes réseau qui planifient l'infrastructure, « l'informatique orbitale doit être considérée comme une région spécialisée ultra-éloignée, faiblement couplée aux systèmes existants », a-t-il ajouté, « car les temps de réponse restent de l'ordre de quelques dizaines de millisecondes, ce qui est acceptable pour la formation par lots en IA, mais ne convient pas aux systèmes transactionnels. »

M. Banerjee voit la proposition de valeur sous un angle différent. « Les responsables IT doivent considérer l'informatique orbitale non pas comme un moyen de réduire les coûts, mais comme un moyen d'assurer la durabilité et la disponibilité », a-t-il fait valoir. « On ne va pas dans l'espace pour économiser de l'argent sur sa facture cloud. On y va pour accéder à 500 mégawatts d'énergie verte que le réseau électrique de l’État ou de la région n’est tout simplement pas en mesure de fournir. » Pour l'instant, les deux analystes recommandent la prudence. « Au cours des trois à cinq prochaines années, les centres de données orbitaux devraient occuper une place importante dans la planification des scénarios, et non pas être considérés comme une dépendance dans les programmes de transformation fondamentaux », a convenu M. Gogia.

Commentaire