Akamai Technologies s'est associé à Neural Magic pour accélérer les charges de travail d'IA sur sa plateforme de livraison cloud, en optimisant les performances des modèles complexes sur des serveurs économiques basés sur un CPU plutôt que sur des accélérateurs couteux GPU (40K$ HT pour un circuit Nvidia H100 par exemple). Dans le cadre de cet accord, Neural Magic rejoindra le programme de partenariat d'Akamai, qui rend les services interopérables facilement accessibles sur sa plateforme CDN. Concernant Neural Magic, son logiciel est capable d'exécuter efficacement des modèles d'inférence de l'IA sur du matériel intégrant des CPU courants. Comme l’a expliqué Akamai, le logiciel de Neural Magic accélère l'inférence de l'IA à l'aide de technologies de sparsification de modèle automatisées, disponibles en tant que moteur d'inférence CPU.

Le spécialiste du CDN proposera désormais le logiciel de Neural Magic avec sa plate-forme de livraison de contenu distribué. « La solution de NeuralMagic, qui améliore l’exécution des charges de travail d'IA, sera mise à disposition des clients sur l'infrastructure de traitement distribuée d'Akamai », a déclaré Ramanath Iyer, responsable de la stratégie chez Akamai. « Les clients disposant de grands modèles d'apprentissage profond pourront dorénavant tirer parti d'une plateforme rentable basée sur un processeur en périphérie pour déployer des applications d'IA intensives en données et à grande échelle avec des performances améliorées et une latence réduite », a-t-il ajouté. « Cela signifie que les clients d'Akamai pourront capitaliser sur les avantages de l’edge computing, y compris une latence plus faible et la résidence des données, sans avoir besoin de compter sur des ressources GPU rares et coûteuses », a-t-il précisé. « En outre, à mesure de l'expansion de la plate-forme, la solution Neural Magic sera disponible dans les sites de périphérie éloignés à travers le réseau edge hyper distribué d'Akamai, autorisant un nombre toujours plus grand d'entreprises à mettre à l'échelle les charges de travail basées sur l'IA à travers le monde », a indiqué M. Iyer.

Du deep learning à la périphérie ?

La combinaison de ces technologies pourrait résoudre un dilemme posé par l'IA : celui de traitements IA exigeants à la périphérie (dans ce cas, le propre réseau de périphériques d'Akamai). En général, les experts en réseaux estiment qu'il n'est pas judicieux d'investir dans une infrastructure substantielle en périphérie si elle est utilisée ponctuellement. Fournir des modèles d'IA de manière efficace à la périphérie est aussi « un défi plus important qu’on ne le pense généralement », a rappelé John O'Hara, vice-président senior de l'ingénierie et directeur de l'exploitation de Neural Magic, dans un communiqué. « Le matériel spécialisé ou coûteux, ainsi que les exigences en matière d'alimentation et de livraison qui y sont associées, ne sont pas toujours disponibles ou réalisables, si bien que les entreprises ne profitent pas des avantages de l'inférence IA à la périphérie. L'utilisation d'un processeur moins coûteux pour effectuer ce type de travail d'IA, lorsqu'il est nécessaire, peut s’avérer plus facile à justifier pour une entreprise ».

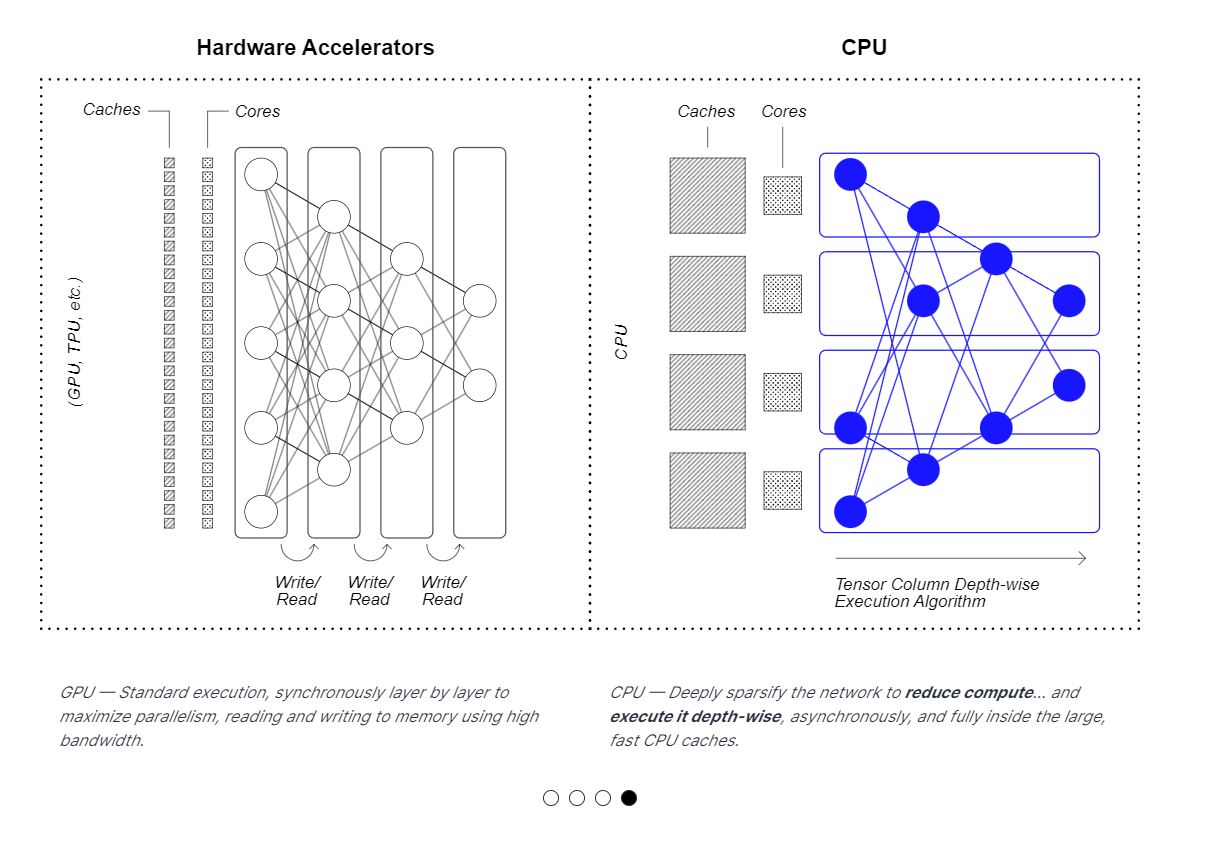

La solution logicielle de Neural Magic vient exploiter au mieux les ressources CPU pour l'inférence IA. (Crédit Neural Magic)

L'IA facilitée ?

Selon M. Iyer, ce partenariat pourrait favoriser l'innovation dans le domaine de l'inférence IA dans une multitude d'industries. « Fondamentalement, notre partenariat avec Neural Magic se concentre uniquement sur l'amélioration de l'efficacité de l'inférence », a-t-il expliqué. « Il y aura toujours des cas où les entreprises auront besoin d'un GPU si elles entraînent des modèles d'IA ou si leur charge de travail d'IA nécessite une plus grande quantité de calcul/mémoire. Cependant, les CPU ont aussi un rôle à jouer. L'exécution de charges de travail d'inférence IA sur une plateforme basée sur le CPU peut tout à fait aider les entreprises à utiliser leurs ressources limitées de manière beaucoup plus efficace, en réduisant les coûts et en améliorant la fiabilité », a-t-il poursuivi.

Une meilleure IA à la périphérie pourrait aussi présenter des avantages en termes de cybersécurité, car « elle permettrait une inspection plus sophistiquée du trafic à la périphérie du réseau », a souligné Fernando Montenegro, analyste principal chez Omdia. « Comme on peut le constater, les attaques ne se limitent plus à exploiter des vulnérabilités très spécifiques, mais elles incluent de plus en plus d'abus plus nuancés au niveau des applications, d’où l’intérêt de disposer de capacités de détection des anomalies assistées par l'IA », a-t-il fait valoir. « Si des partenariats comme celui-ci ouvrent la voie à une utilisation accrue de l'apprentissage profond et de l'IA générative par un plus grand nombre de développeurs, il faut considérer cela comme un point positif ».

Commentaire