Cap sur Ferret pour Apple. Alors que la liste des fournisseurs travaillant d'arrache-pied sur leur grand modèle de langage ne cesse de s'allonger (Claude d'Anthropic, Llama de Meta, GPT d'OpenAI, PaLM de Google, Mistral AI de Mistral...), un acteur clé de l'industrie s'était jusqu'à présent fait plutôt discret sur la question, Apple. Si la firme indiquait s'intéresser au sujet, elle n'avait jusqu'à présent pas présenté grand chose de concret mais c'est désormais chose faite. En octobre dernier, la firme à la pomme a ainsi discrètement publié sur GitHub ses travaux concernant son LLM, baptisé Ferret, qu'il élabore aux côtés de l'université de Cornell (New-York).

« Les données et le code sont destinés à un usage de recherche uniquement et font l'objet d'une licence. Ils sont également limités à des utilisations conformes à l'accord de licence de LLaMA, Vicuna et GPT-4 », peut-on lire dans les notes de recherche. « Le jeu de données est CC BY NC 4.0 (autorisant uniquement une utilisation non commerciale) et les modèles formés à l'aide du jeu de données ne doivent pas être utilisés en dehors du cadre de la recherche ». Deux modèles sont entrainés, à savoir à 7 et 13 milliards d'hyper-paramètres. « Ferret a été entraîné sur 8 GPU A100 avec 80 Go de mémoire. Pour entraîner moins de GPU, vous pouvez réduire la taille du lot d'entraînement par appareil et augmenter le nombre de pas d'accumulation du gradient en conséquence. La taille du lot global doit toujours rester la même : per_device_train_batch_size x gradient_accumulation_steps x num_gpus », explique le descriptif du projet.

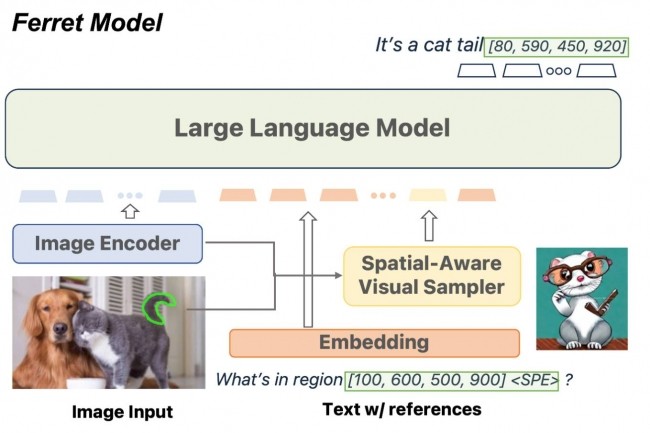

De l'analyse contextuelle d'images à grande échelle

« Ferret permet de référencer une région d'image de n'importe quelle forme », a expliqué Zhe Gan, chercheur au sein de l'équipe IA d'Apple. « Il montre souvent une meilleure compréhension précise des petites régions de l'image que GPT-4V ». Ce LLM examine une région spécifique d'une image, détermine les éléments qui pourraient être utiles en réponse à une requête, identifie ces éléments et dessine une cadre autour d'eux. Il peut ensuite utiliser les éléments identifiés suite à une requête d'un utilisateur, par exemple si ce dernier met en évidence l'image d'un animal dans une image plus grande, puis demande au LLM quel est l'animal, il répondra à cette requête en identifiant l'espère en question. Il pourra ensuite utiliser le contexte d'autres éléments détectés dans l'image pour fournir d'autres réponses pour dire par exemple ce que fait un animal.

Commentaire