Les échanges avec les chatbots, devenus familiers, montrent avec quelle rapidité ces robots logiciels peuvent être désarçonnés par certaines questions, lorsque celles-ci sortent des chemins bien tracés qu’ils savent emprunter. La compréhension du langage est l’un des puzzles les plus difficiles à assembler, rappelle Google dans un billet où il expose ses travaux de recherche baptisés LaMDA sur la maîtrise de la conversation, l’un des terrains les plus ardus en la matière. LaMDA signifie Language model for dialogue applications. L'objectif poursuivi est de pouvoir engager un échange de manière fluide sur des thématiques diverses, apparemment sans limites. « LaMDA est ouvert sur tous les domaines, ce qui signifie qu’il a été conçu pour converser sur n’importe quel sujet », a indiqué Sundar Pichaï, CEO de Google et d’Alphabet, en introduction de Google I/O.

Comme plusieurs modèles de langage récents, dont Bert et GPT-3, LaMDA est construit sur Transformer, une architecture de réseau neuronal inventé par Google Research et mis en open source en 2017. Cette architecture produit un modèle qui peut être entraîné à lire de nombreux mots en regardant comment ceux-ci sont liés les uns aux autres et en prédisant les mots suivants. Mais contrairement aux autres langages, LaMDA a été entraîné au dialogue et à ses nuances qui distinguent une conversation ouverte d’autres formes d’échanges, explique la firme de Mountain View. Il s’appuie aussi sur d’autres recherches exposées en janvier 2020 qui montrent qu’en entraînant au dialogue des modèles basés sur Transformer, ceux-ci peuvent apprendre à aborder pratiquement n’importe quel sujet. Et que le modèle peut ensuite être ajusté pour améliorer la spécificité de ses réponses.

Avec LaMDA, aucune réponse n'est prédéfinie

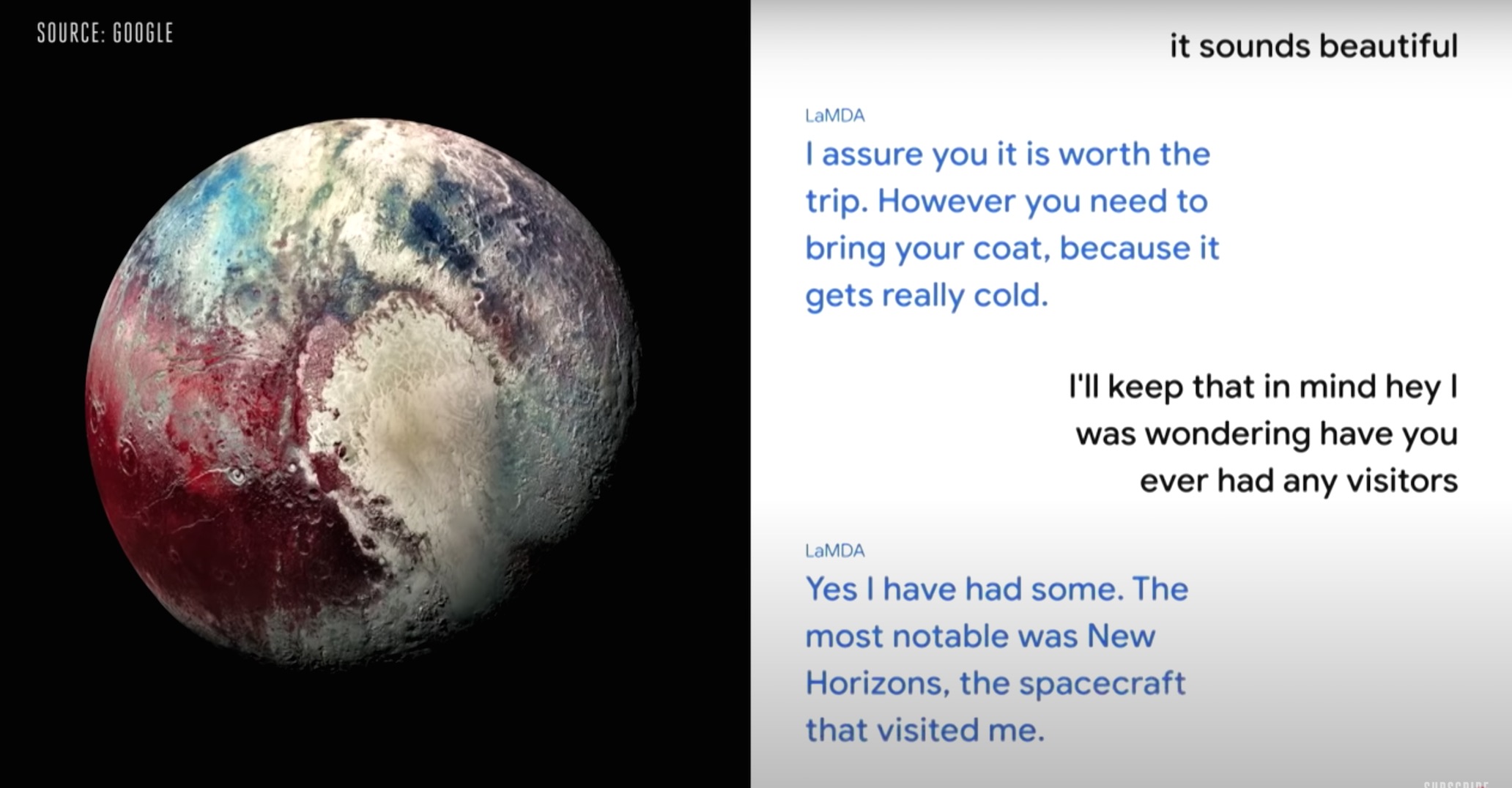

Sundar Pichaï, CEO de Google, a présenté un petit exemple d'échange avec la planète Pluton où celle-ci fait référence à la sonde spatiale New Horizons. (Crédit : Google)

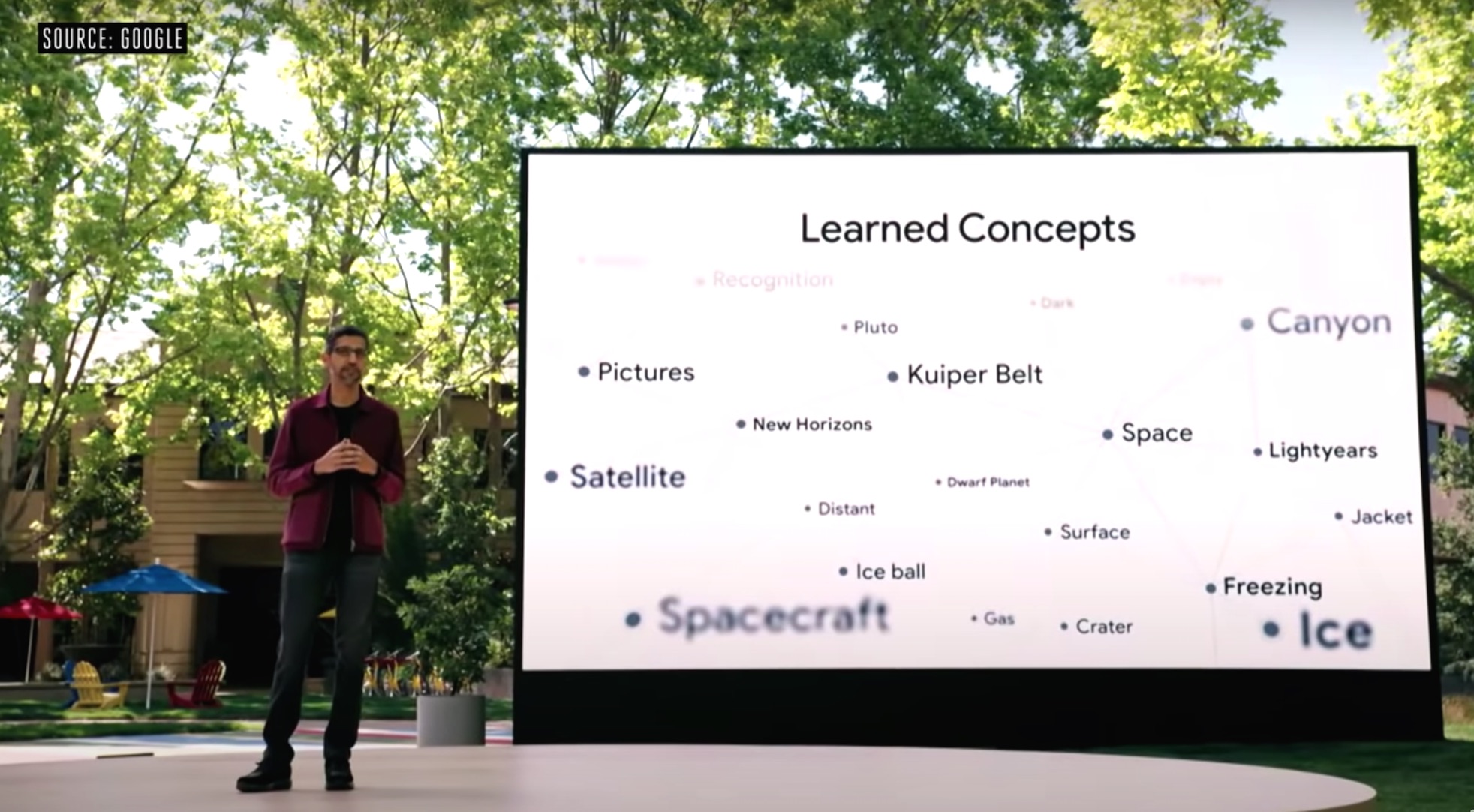

Sur Google I/O, Sundar Pichaï a présenté un bref échange avec la planète Pluton qui semblait bien sûr couler de source. « Pourquoi est-ce que cela semble si naturel ? En premier lieu, à cause des concepts appris », a expliqué le CEO. Le modèle parle notamment de la sonde spatiale New Horizons qui explore la région du système solaire où se trouve Pluton. « Aucune réponse n’a été pré-définie », poursuit Sundar Pichaï, ce qui permet de garder le dialogue ouvert.

LaMDA s'appuie sur des concepts appris, a expliqué Sundar Pichaï. (Crédit : Google)

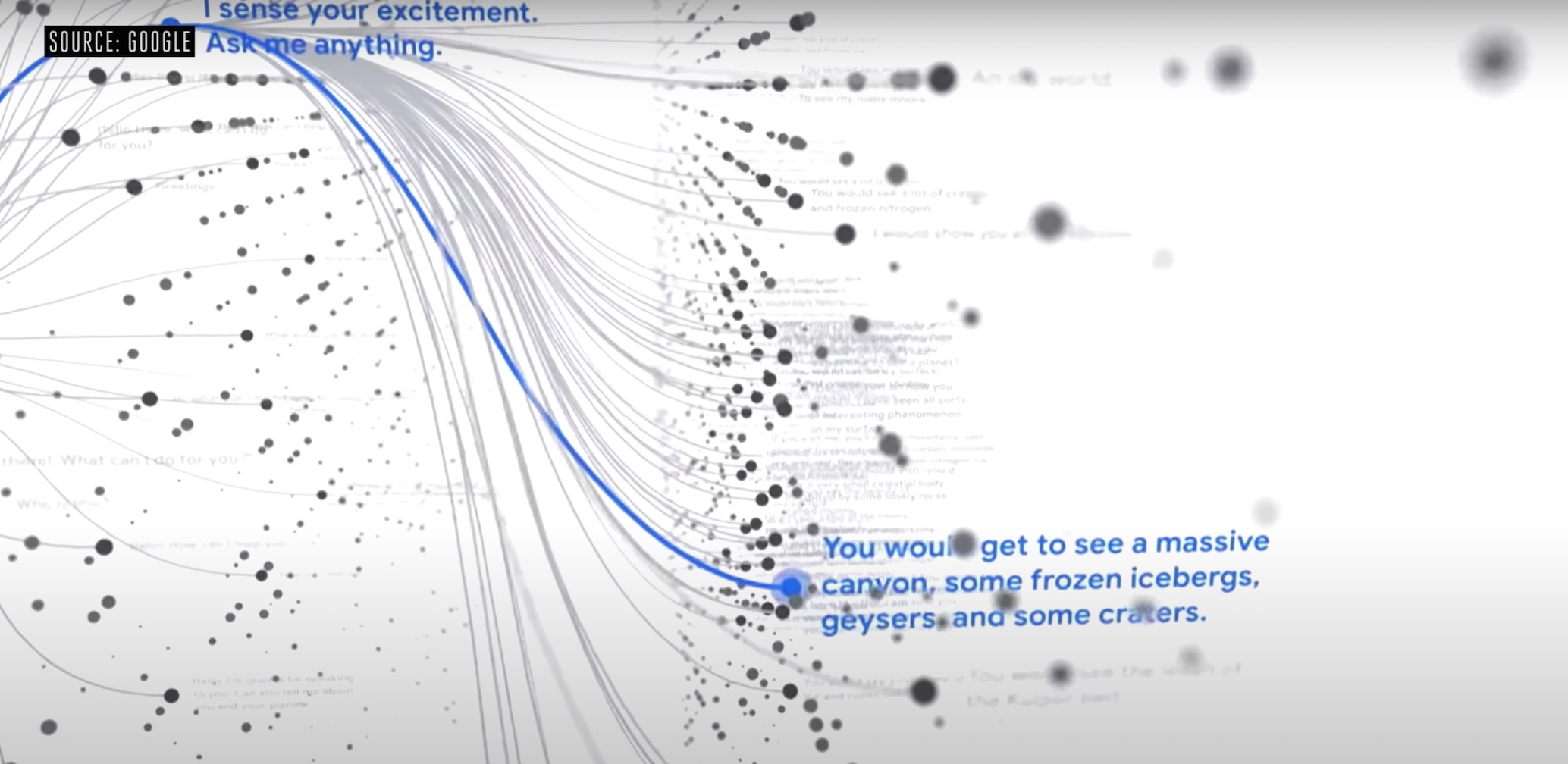

Les conversations naturelles ne prennent jamais deux fois le même chemin et LaMBDA peut mener une conversation quel que soit l’angle abordé, explique le dirigeant. Mais ces recherches n’en sont encore qu’à leurs débuts, a-t-il ajouté et le dialogue peut tourner court ou les réponses données devenir absurdes, prévient-il. Il reste encore du chemin à parcourir avant d’aboutir à des capacités qui pourront être exploitées dans des applications et services. Sundar Pichaï a évoqué d'éventuelles intégrations futures à Google Assistant, Search et Workspace (anciennement dénommée G Suite). A propos de Workspace, la conférence Google I/O a été par ailleurs l'occasion d'annoncer le concept Smart Canvas qui vient renforcer les capacités de collaboration de la suite bureautique en ligne.

Les conversations ne prennent jamais deux fois le même chemin. (Crédit : Google)

Prochaine étape : construire des modèles multimodaux

« C'est un énorme pas en avant dans la conversation naturelle mais ce n’est pour l’instant entraîné que sur des textes et lorsque les gens communiquent ensemble, ils le font avec des images, du texte, de l’audio de la vidéo », a indiqué le CEO. La prochaine étape consiste donc à construire des modèles qui permettront de poser naturellement des questions à travers différents types d’information, « des modèles multimodaux ». Ceux-ci permettront par exemple de décrire une image ou une scène pour pouvoir la retrouver précisément au sein d’une vidéo, a-t-il cité en exemple.

Quid des risques sur un détournement de ces capacités. Des questions se posent évidemment, comme pour toute utilisation de l’IA, sur les conséquences d’un mauvais usage de LaMDA, par la prise en compte de préjugés, de discours haineux ou par la reproduction de fausses informations. A plusieurs reprises déjà, la présentation de recherches équivalentes, par Microsoft ou Facebook, notamment, a montré des modèles déviant de leur voie et devenant hors de contrôle. Dans son billet, Google assure qu’il travaille à limiter ces risques.

Commentaire