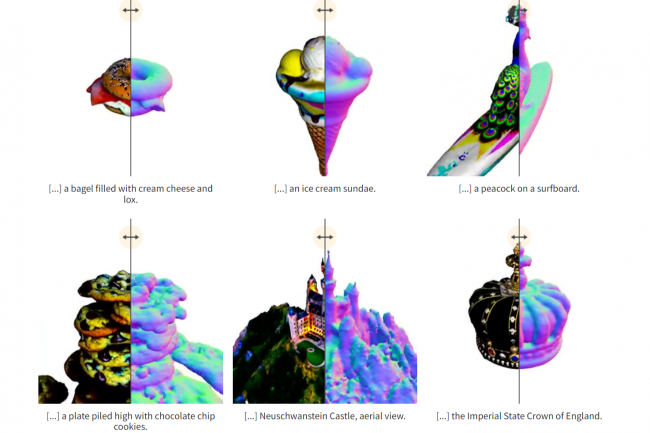

Dans le sillon de Meta, Google et Microsoft, la firme américaine Nvidia annonce la disponibilité de son propre outil de création de contenu text-to-3D baptisé Magic3D. Avec cet outil il est possible de « créer des modèles maillés 3D d'une qualité sans précédent » annonce Nvidia. Il se base sur les techniques de conditionnement de l'image et des invites de saisie de texte, offrant ainsi aux utilisateurs des moyens supplémentaires de contrôler la synthèse 3D. Nvidia précise utiliser « une stratégie super optimisée qui exploite les préférences de diffusion à la fois basse et haute résolution pour apprendre la représentation 3D du contenu cible ». Dans le contexte de la reconnaissance visuelle, il s’agit de passer de quelque chose de grossier à fin en se référant à l'application d'une méthode (ou d'un modèle appris par une machine) à une version à faible résolution de l'image, puis à l'augmentation progressive de la résolution pour obtenir une image plus « fine ». Elle ajoute que « Magic3D synthétise le contenu 3D avec une résolution 8 fois plus élevée que DreamFusion tout en étant 2 fois plus rapide ».

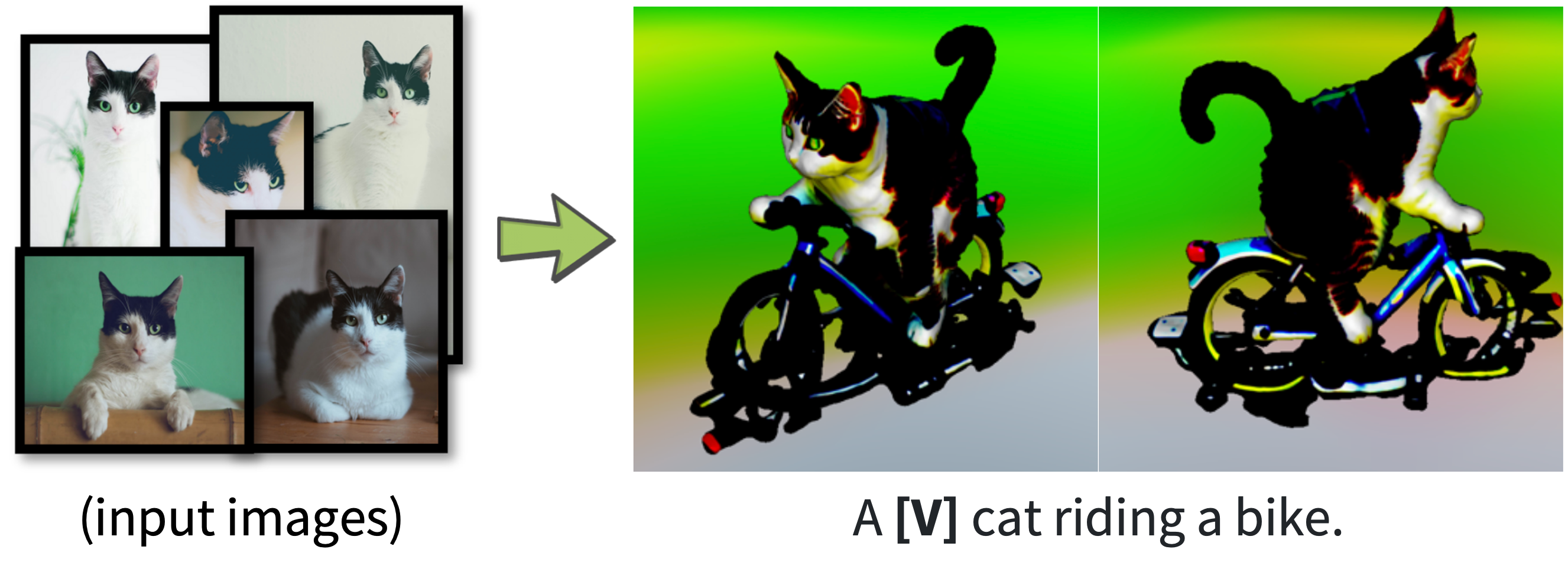

La firme fait référence au projet lancé par des chercheurs de chez Google et un en IA de l’Université de Californie à Berkeley (UC Berkeley). À partir d'une légende, DreamFusion génère des objets 3D avec une apparence et une profondeur de haute-fidélité. Les objets sont représentés sous la forme d'un champ de radiance neuronal et exploitent un antécédent de diffusion texte-image pré-entraîné tel que Imagen. De son côté, l’équipe de Magic3D annonce qu’il est possible de générer un modèle grossier dans un premier temps à partir d’une invite de texte de base, puis de l’affiner au fur et à mesure en modifiant des parties du texte dans l’invite. Le résultat est un maillage 3D haute résolution édité.

L’édition basée sur les invites permet d’affiner le modèle en temps réel. (Crédit : Nvidia)

Des capacités d’édition supplémentaires

Il est précisé que les modèles de diffusion peuvent être également affinés avec DreamBooth, optimisant ainsi les modèles 3D avec les invites données.

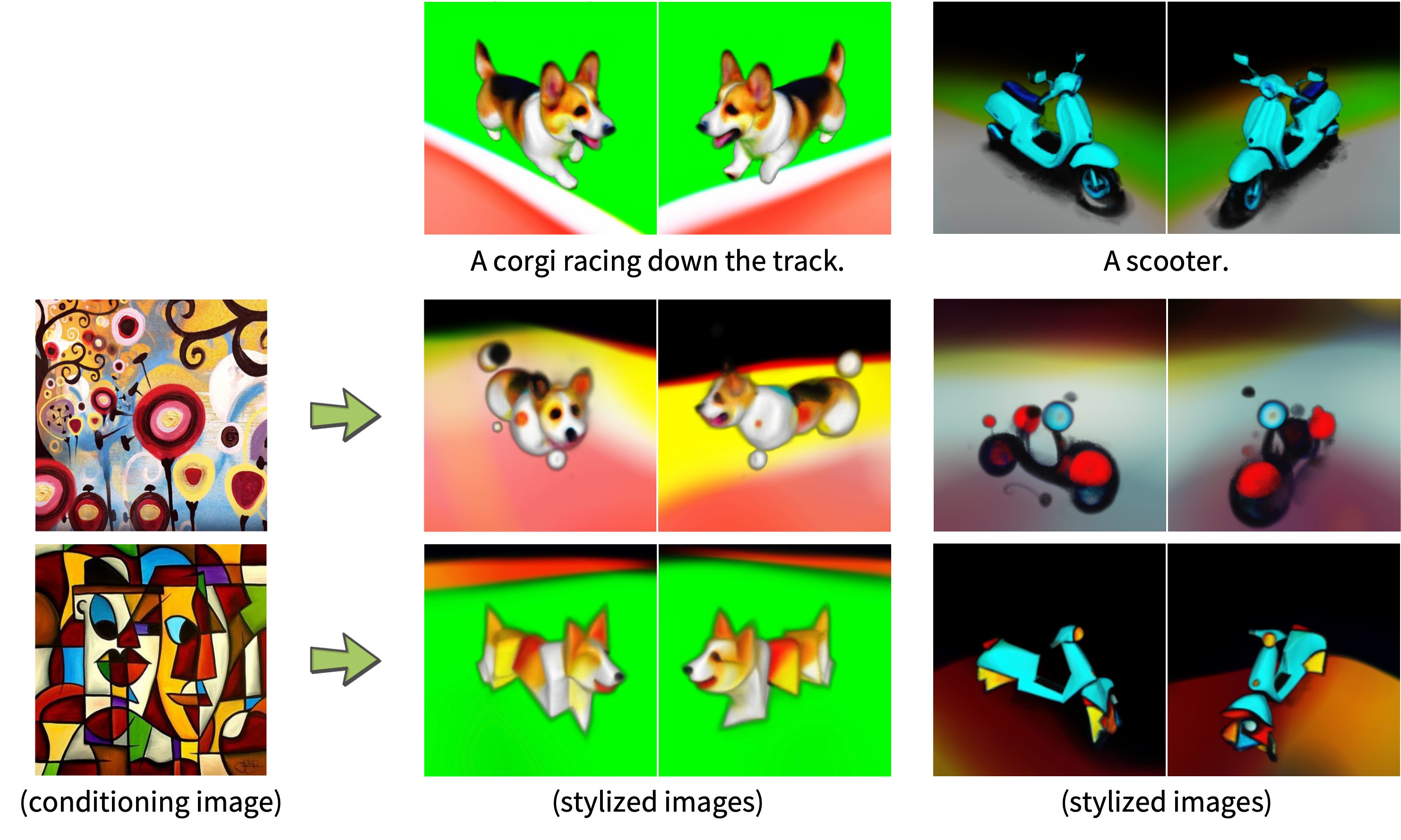

« Nous pouvons également conditionner le modèle de diffusion (eDiff-I) sur une image d'entrée pour transférer son style au modèle 3D de sortie » ajoute Nvidia.

Commentaire