En direct de Las Vegas. Profitant de sa conférence à Las Vegas, Snowflake a élargi la portée de Snowpark, son framework de développement, introduit en juin 2021 et disponible à tous depuis fin janvier 2022. Ce dernier aide les développeurs dans la construction de pipelines et d’applications évolutives ainsi que de flux d'apprentissage automatique directement dans la plateforme en utilisant leurs langages et bibliothèques préférés. A l’occasion de l'événement, la firme a annoncé Snowpark Container Services en étendant son framework via un runtime Kubernetes ou Docker pour différentes applications. Dans ce cadre, l’éditeur s’est associé à des dizaines de fournisseurs de logiciels et d’applications tiers, incluant Alteryx, Astronomer, Dataiku, Hex, Nvidia, SAS, pour ne citer qu’eux afin de proposer aux clients un accès sécurisé à une large gamme de produits et de solutions au sein de leur compte Snowflake.

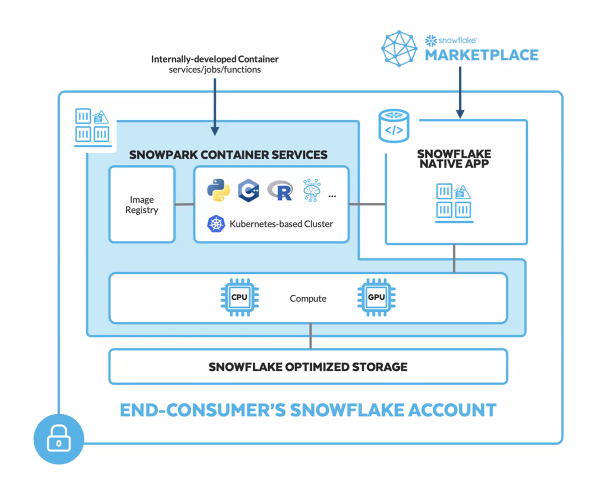

Snowpark Container Services offre ainsi accès à un large catalogue, notamment des grands modèles de langage (LLM), des Notebooks, des outils MLOps. Par exemple, sur le plan de l'accélération du calcul, les utilisateurs pourront compter sur les GPU Nvidia et les logiciels d'IA pour exécuter davantage de charges de travail au sein de la plateforme de Snowflake. Pour David Wallace, directeur de recherche sur les données et l'analyse client chez IDC, cet accès est primordial aujourd'hui : « Dans un contexte où la quantité de données clients dans les entrepôts de données n’a de cesse de croître, l'accès en libre-service aux informations est indispensable ». En outre, Snowpark Container Services peut être utilisé dans le cadre de l'offre Native App (preview publique sur AWS). Dans ce cas, les développeurs peuvent distribuer des applications qui s'exécutent entièrement dans le compte Snowflake de leur client final. « Les avancées de Snowflake en matière de produits révolutionnent la façon dont les clients construisent dans le Data Cloud, en permettant aux data scientists, aux ingénieurs de données et aux développeurs d'applications de bénéficier d'une programmabilité étendue et d'un large éventail de cas d'utilisation afin qu'ils puissent construire, tester et déployer tout ce dont ils peuvent rêver, sans compromis », commente Christian Kleinerman, vice-président senior responsable des produits Snowflake.

Snowpark Container Services consiste en une exécution supplémentaire de Snowpark qui aide les développeurs à enregistrer et à déployer des fichiers statiques non-modifiables ("container images") dans Snowflake. (Crédit : CS)

Faciliter le quotidien des développeurs, encore et toujours

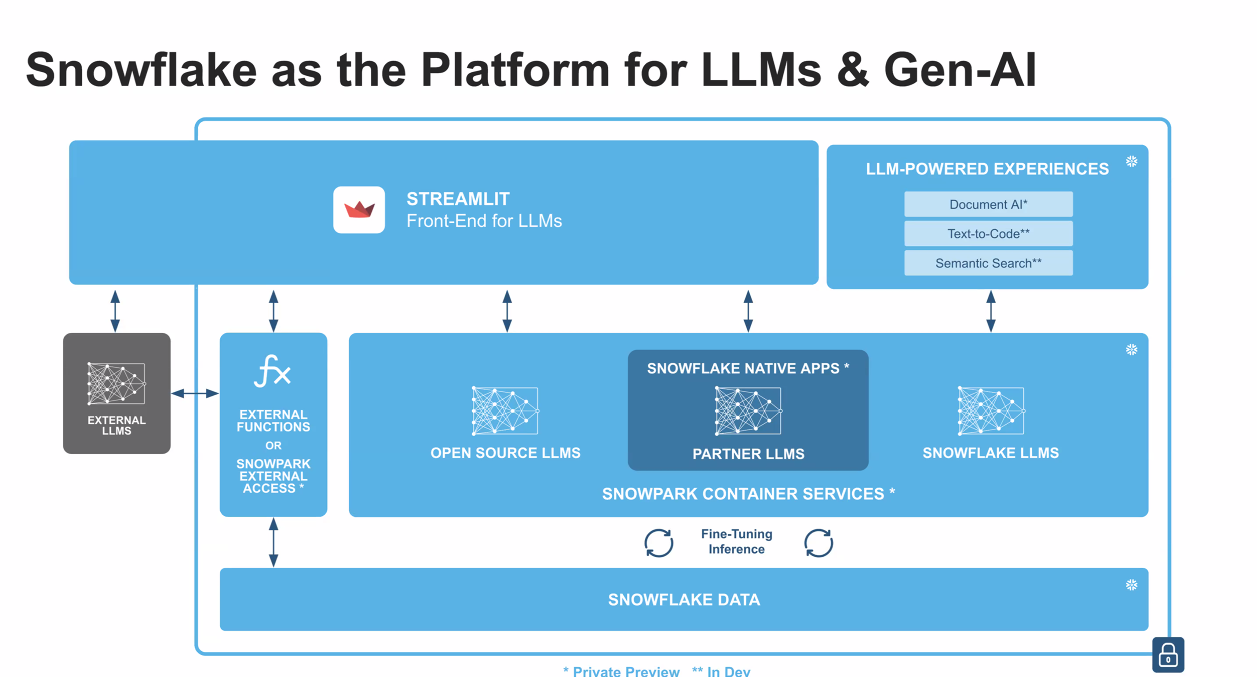

En étendant les capacités d’exécution d’une variété de charges de travail, y compris des applications complètes, l'hébergement de LLM ou encore l'entraînement de modèles, Snowflake ouvre clairement le champ des possibles. L’annonce faite d’un partenariat avec Nvidia en début de semaine en est la preuve. Via cette collaboration, les clients Snowflake auront accès à Nvidia AI Enterprise - le pilier logiciel de la plateforme Nvidia AI – à travers Snowpark Container Services. La plateforme comprend ainsi plus de 100 frameworks, des modèles pré-entraînés et des outils de développement tels que PyTorch pour l'entraînement, Rapids pour la science des données et Triton Inference Server pour les déploiements d'IA de production. Pour ce lancement produit, Snowflake a en effet créé un cercle restreint de partenariats pour tester sa technologie dans différents environnements avec des cas d'utilisation variés. Amplitude, spécialiste de l'analytique produit, a ainsi d'ores et déjà annoncé une application native dans Snowflake utilisant Snowpark Container Services. Avec cette app, les clients des deux entreprises accèdent donc plus facilement à des informations sur le comportement des utilisateurs en libre-service, directement depuis leur instance Snowflake. Cela passe notamment par « mieux comprendre chaque étape du parcours client, stimuler la croissance des utilisateurs actifs, augmenter la rétention ou encore améliorer la monétisation ». Il s'agit de l'un des premiers cas concrets dévoilés à la suite de l'annonce produit.

Snowflake intègre sa solution Container Services au sein des différentes sources de LLM ainsi que de son Data Cloud et de Streamlit notamment. (Crédit : CS)

En parallèle, Snowflake a annoncé d’autres outils dédiés au développement. Ces avancées comprennent un ensemble d’API ML Snowpark pour un développement de modèles plus efficace (disponible en avant-première publique), un registre de modèles Snowpark (Model Registry en aperçu privé) pour des MLOps évolutifs, l'intégration native de Git (aperçu privé) pour soutenir des flux de travail CI/CD, et l'interface native de ligne de commande (CLI) (aperçu privé) pour optimiser le développement et les tests. Dédiés aux data engineers, ces outils doivent aider ces derniers à travailler plus facilement et à moindre coût avec des données nécessitant une faible latence, sans avoir à assembler des solutions ou à construire des pipelines de données supplémentaires. Enfin, la firme a déclaré avancer sur le chemin de l’intégration de Streamlit, une start-up rachetée par Snowflake pour 800 millions de dollars. Cette dernière avait pour objectif de construire un projet open source pour faciliter la création d'applications personnalisées afin d’interagir avec les données. Dans le cadre de cette intégration, Snowflake indique que les data scientists et autres développeurs Python pourront « accroître l'impact de leur travail en créant des applications qui comblent le fossé entre les données et l'action de l'entreprise ».

Commentaire