Si le passage à l'Ethernet 400G a été jusqu'à présent une étape importante pour les opérateurs cloud et télécoms, l'ambition de ces utilisateurs, ainsi que des entreprises avec leurs datacenters, est d’adopter à terme du 800 Gb/s et peut-être même 1,6 Tb/s. Et si le 800 Gb/s semble être un objectif réaliste pour les équipementiers, les défis - tels que l'optique, la consommation électrique et l'architecture nécessaires pour atteindre le prochain saut de vitesse - semblent considérables. La nécessité d'augmenter la vitesse dans les centres de données et les nœuds de télécommunications est motivée par une myriade de besoins, notamment la croissance continue des topologies réseau XXL d'acteurs comme Google, Amazon et Facebook, mais aussi des charges de travail plus réparties dans le cloud, de l'intelligence artificielle, de la vidéo et des applications mobiles populaires que les réseaux actuels et futurs prendront en charge.

Un autre facteur à prendre en compte est la croissance du trafic IP mondial, qui devrait atteindre 396 exaoctets par mois d'ici 2022, contre 177 exaoctets en 2017, selon l'évaluation de la bande passante Ethernet de l'IEEE 802.3 Industry Connections publiée avril 2020. Les facteurs sous-jacents, tels que la hausse du nombre d'utilisateurs, l'augmentation des taux et des méthodes d'accès et le développement des services, indiquent tous une croissance continue de la demande de bande passante, selon le rapport.

Le 25 Gigabit Ethernet Consortium rebaptisé Ethernet Technology Consortium

Et l'industrie a fait preuve d'une grande activité pour développer des technologies Ethernet plus rapides. Par exemple, l'Institute of Electrical and Electronics Engineers (IEEE) et l'IEEE Standards Association ont formé, fin 2020, le groupe d'étude sur l'Ethernet IEEE 802.3 Beyond 400 Gbps. « Le chemin vers l'Ethernet à plus de 400G existe, mais il y a une foule d'options et de défis physiques qui devront être pris en compte pour assurer le prochain saut de vitesse pour l'Ethernet », a déclaré John d'Ambrosia, ingénieur chez Futurewei Technologies, dans une déclaration lors de la formation du groupe. À la fin de l'année dernière également, l'Optical Internetworking Forum (OIF) a mis en place de nouveaux projets autour de l'Ethernet plus véloce, dont le projet 800G Coherent. Cet effort vise à définir des spécifications de lignes 800G interopérables - qui définissent essentiellement la manière dont les équipements de commutation à plus haut débit communiquent sur de longues distances - pour l'interconnexion des campus et des centres de calcul, selon Tad Hofmeister, en charge des technologies de réseau optique chez Google et vice-président de l'OIF.

La semaine dernière, John d'Ambrosia et Tad Hofmeister ont participé, avec un groupe d'experts issus de l'industrie, notamment Cisco, Juniper, Google, Facebook et Microsoft, au Technology Exploration Forum (TEF) organisé par l’Ethernet Alliance afin d'examiner les questions et les exigences relatives à la fixation des standards Ethernet de prochaine génération. L'un des principaux défis à relever pour dépasser les 400 Gb/s est la puissance électrique nécessaire pour faire fonctionner ces systèmes. « La consommation d’énergie croît à un rythme insoutenable. C’est le problème à résoudre, car il limite ce que nous pouvons construire et déployer ainsi que ce que notre planète peut supporter », a déclaré Rakesh Chopra, un chercheur affilié à Cisco, au TEF. « La consommation par bit a toujours été améliorée - nous pouvons augmenter la bande passante de 80 fois - mais la puissance électrique requise pour cela augmente avec un multiple de 22. Chaque watt que nous consommons dans le réseau, c'est moins de serveurs que nous pouvons déployer. La question n'est pas de savoir à quel point on peut réduire les équipements, mais plutôt à quel point on peut être efficace ».

Maitriser la consommation énergétique

La consommation électrique est l'une des contraintes majeures pour les vitesses supérieures à 400G, a déclaré Sameh Boujelbene, directeur principal du cabinet d’études Dell'Oro. « La consommation a déjà un impact sur la façon dont les opérateurs cloud envisagent les vitesses plus élevées, car ils doivent attendre que les différentes technologies respectent les limites de leur enveloppe énergétique existante, et ce problème ne fait que s'aggraver avec des vitesses plus élevées ». La grande question est de savoir si nous devons d'abord nous attaquer au mur de la bande passante ou de la consommation, a déclaré Brad Booth, ingénieur principal au sein du groupe Azure Hardware Systems de Microsoft. « Si nous continuons à utiliser les mêmes technologies que celles que nous utilisons aujourd'hui, nous resterons sur la même bande passante. Nous avons besoin de plus en plus de performances, mais nous avons une limitation pour la consommation électrique. Nous devons nous fier à ce qui est produit et à ce qui est disponible pour les infrastructures que nous administrons ».

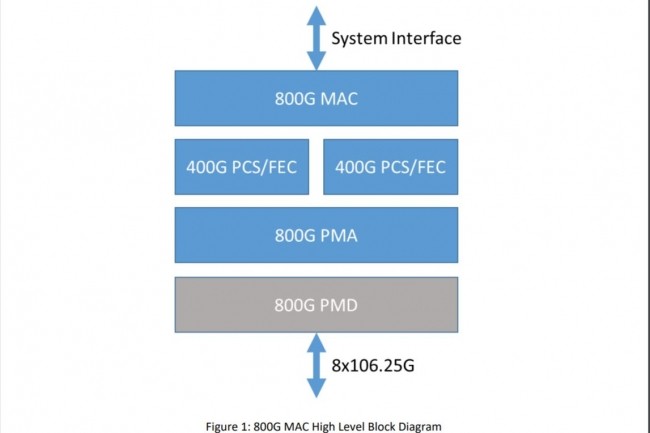

De nombreux organismes de recherches public et privé, comme la Darpa et d'autres, étudient la façon d’assurer une plus grande capacité en bande passante avec une consommation électrique maitrisée, a noté M. Booth. Et cela nécessitera des réponses créatives. « Les futurs réseaux de centres de calcul pourraient nécessiter la combinaison d'innovations photoniques et d'architectures réseau optimisées », a souligné M. Boujelbene. L'une de ces innovations baptisées optique co-packagée (CPO pour Co-Packaged Optics) est en cours de développement chez Broadcom, Cisco, Intel et d'autres, mais c'est encore un domaine naissant. Un commutateur de type Co-Packaged optics, comme le projet Humboldt de Broadcom, combine des interconnexions optiques avec une puce Tomahawh 4 (gravée en 7 nm) de 25,6 Tb/s dans le but de considérablement réduire la consommation d'énergie. « CPO constitue la prochaine grande étape dans la maitrise de la consommation d'énergie avec une augmentation de la densité et de la performance pour soutenir la mise à l'échelle des systèmes de prochaine génération », a déclaré Rob Stone, responsable de l'approvisionnement technique chez Facebook. M. Stone est également le président du groupe de travail technique du Consortium technologique Ethernet qui a annoncé l'achèvement d'une spécification pour le 800 GbE. « Ce qu'il faut, c'est un écosystème CPO soutenu par des normes pour une adoption à grande échelle ».

Une standardisation nécessaire

Facebook et Microsoft co-développent une spécification CPO« pour relever le défi de la croissance du trafic des centres de données en réduisant la consommation électrique de l'interface électrique du commutateur optique", ont déclaré les entreprises sur leur site CPO. « Une spécification de système commune est nécessaire pour aider les fournisseurs de produits optiques et de commutateurs à développer rapidement des solutions Co-Packaged Optics et permettre la création d'un écosystème diversifié de fournisseurs ». L'OIF travaille également sur un cadre Co-Packaged Optics, une spécification qui intégrera les espaces d'application et les considérations technologiques pertinentes pour le co-packaging des interfaces de communication avec une ou plusieurs ASIC. L'un des principaux objectifs de la spécification est d'identifier de nouvelles opportunités pour les normes d'interopérabilité en vue d'éventuels travaux futurs au sein de l'OIF ou d'autres organismes de normalisation, a déclaré M. Hofmeister.

L'OIF a cependant un long chemin à parcourir, selon les experts. « L'architecture, la conception, le déploiement et l'opérationnalisation de systèmes avec CPO sont une tâche incroyablement difficile, et il est donc essentiel pour l'industrie de commencer avant qu'il ne soit trop tard », a écrit M. Chopra de Cisco dans un récent blog sur CPO. « Aujourd'hui, chez les fournisseurs de services, la plupart des liens à l'extérieur du rack sont optiques, tandis que le câblage à l'intérieur du rack est en cuivre. Avec l'augmentation des vitesses, les liens en cuivre les plus longs doivent passer à l'optique. À terme, tous les liens sortant d'un boîtier en silicium seront optiques plutôt qu'électriques ».

Adoption du 800 GbE en 2025

« Bien qu'il soit de plus en plus difficile d'aller plus vite, la question est de savoir si nous pouvons construire des systèmes supportant le prochain débit et des densités plus élevées comme nous en avons l'habitude », a expliqué David Ofelt, ingénieur chez Juniper Networks. « Même si nous le pouvons, il n'est pas certain que le résultat sera acceptable pour l'utilisateur final ». Il faudra de nombreuses années avant que la technologie permettant de supporter des débits Ethernet plus rapides soit disponible en volume avec un conditionnement et un support système appropriés, a poursuivi M. Ofelt. « Ce n'est pas une question de normes lentes, c'est une question de construction réelle d'un écosystème à l'échelle », a-t-il déclaré.

Une partie du défi que représente le passage à des vitesses plus élevées en masse réside peut-être dans le fait que les taux d'adoption sont largement échelonnés. Par exemple, la majorité des entreprises passeront du 10G au 25G dans les deux à cinq prochaines années, et le 50G au 100G sera la prochaine vitesse pour beaucoup d'entre elles. Les attentes concernant le sans-fil à la périphérie du réseau pourraient changer, a souligné Vlad Kozlov, fondateur et dirigeant du cabinet d’études LightCounting. « Les entreprises qui dépendent fortement des services numériques ou qui les fournissent passeront du 100G au 400G dans les deux à cinq prochaines années. 800G ou 1,6T seront les prochaines étapes pour elles. Cependant, les services d'IA gourmands en bande passante pourraient changer cette situation à l'avenir : la majorité des entreprises auront besoin d'une connectivité plus rapide pour transmettre des vidéos de surveillance de leurs activités ».

En fin de compte, ce dont nous avons vraiment besoin, c'est d'une architecture sous-jacente flexible pour supporter la demande future de bande passante au-delà de 400 Gb/s, a déclaré M. d'Ambrosia au TEF. « Il y a beaucoup de travail à faire, et nous venons tout juste de commencer ».

Commentaire