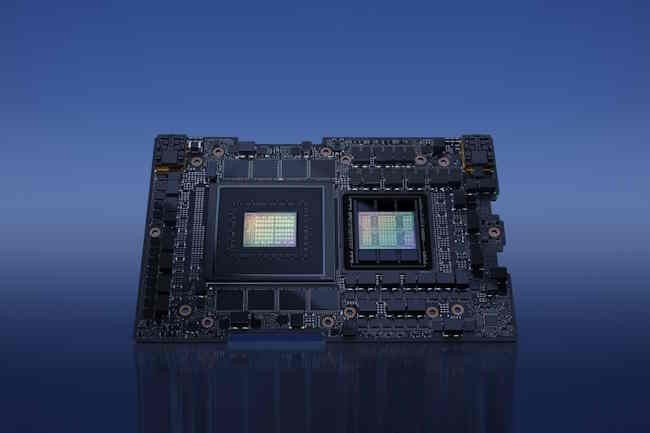

Nvidia ne perd pas de temps. Deux mois après avoir présenté DGX Cloud et ses systèmes DGX H100 à base d'accélérateur H100, le fournisseur américain profite de la conférence Computex 2023 à Taïwan pour donner des nouvelles de sa dernière puce GH200 orientée HPC et traitement IA à grande échelle. Désormais entrée en production et attendue d'ici la fin de l'année, elle associe un CPU Grace et un GPU Hopper H100 (Grace Hopper étant un clin d'oeil à une des informaticiennes les plus renommées).

Côté CPU, le choix a été fait sur une architecture Arm Neoverse V2 comportant 72 cœurs et il est livré avec une mémoire LPDDR5X pouvant aller jusqu'à 480 Go. Avec l'accélérateur H100, le système dispose d'une interconnexion beaucoup plus rapide qu'une configuration CPU + GPU traditionnelle basée sur le PCIe. Le lien NVLink-C2C promet une bande passante de 900 Go/seconde entre les deux puces (450 Go/sec dans chaque direction). Nvidia souligne que ce débit est 7 fois supérieur à celle de PCIe Gen5 pour une consommation 5 fois moindre. Au total, le système DGX GH200 comprendra jusqu'à 256 GH200, 144 To de mémoire et une capacité de traitement théorique d'1 exaflops.

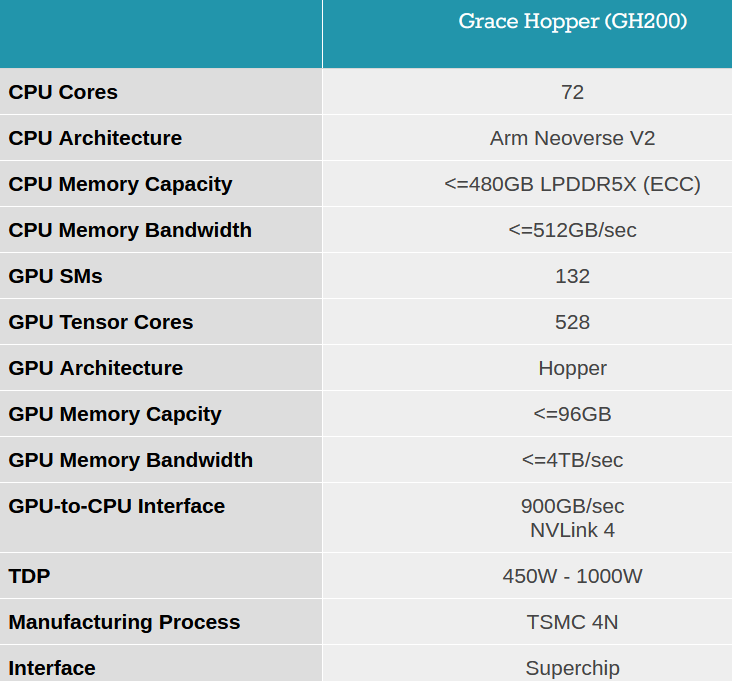

Les caractéristiques de la puce GH200 de Nvidia. (Crédit Photo: Nvidia)

Des designs de référence DGX GH200 pour les GAFAM

Nvidia annonce que son système GH200 sera intégré dans son supercalculateur Helios qui doit combiner 4 DGX GH200 interconnectés à l'aide de la technologie réseau Quantum-2 Infiniband de Nvidia, embarquant pas moins de 1 024 puces GH200 lorsqu'elle sera mise en service à la fin de l'année. Les partenaires de Nvidia prévoient aussi de créer leurs propres systèmes sur la base des GH 200, à commencer par Quanta Computer avec son S74G-2U lancé courant 2023. Mais il n'est pas seul puisque Asus, Cisco, Dell Technologies, Gigabyte Technology, HPE, Inventec ou encore Pegatron Corp font partie des fournisseurs associés.

Un cluster DGX GH200 peut délivrer jusqu'à 1 exaflops de traitement pour entraîner les grands modèles de données de l'IA générative. (Crédit Photo : Nvidia)

« L'IA générative transforme rapidement les entreprises, ouvre de nouvelles opportunités et accélère les découvertes dans les domaines de la santé, de la finance, des services aux entreprises et dans bien d'autres secteurs », a expliqué Ian Buck, vice président de la division Accelerated Computing de Nvidia. « Avec les puces Grace Hopper en pleine production, les fabricants du monde entier fourniront bientôt l'infrastructure accélérée dont les entreprises ont besoin pour construire et déployer des applications d'IA générative qui exploitent leurs données propriétaires ». Les premiers clients finaux de Nvidia sont - sans surprise - des gros consommateurs d'IA générative. Ainsi, parmi les premières entreprises intéressées, on trouve Google Cloud, Meta ou encore Microsoft. Nvidia prévoit par ailleurs de fournir son DGX GH200 en tant que modèle de référence pour les fournisseurs de services cloud qui souhaitent l'adapter à leur propre infrastructure. « L'entraînement de grands modèles d'IA est traditionnellement une tâche gourmande en ressources et en temps », a indiqué Girish Bablani, vice-président de l'activité Azure Infrastructure de Microsoft. « La possibilité pour DGX GH200 de travailler avec des ensembles de données de l'ordre du téraoctet permettrait aux développeurs de mener des recherches avancées à plus grande échelle et à des vitesses accélérées ».

Des logiciels de gestion IA spécifiques adossés aux systèmes DGX GH200

« Les supercalculateurs DGX GH200 AI intègrent les technologies de calcul accéléré et de réseau les plus avancées de Nvidia pour repousser les frontières de l'IA », a indiqué Jen-Hsun Huang, CEO de Nvidia. Les supercalculateurs DGX GH200 AI seront par ailleurs dotés d'un logiciel pour exécuter des charges de travail d'IA et d'analyse de données, incluant Base Command qui fournit la gestion des workloads, des clusters, et des bibliothèques IA. Une couche logicielle de plus de 100 frameworks d'IA, des modèles pré-entraînés et des outils de développement pour rationaliser la production d'IA générative, de vision par ordinateur, d'IA vocale et d'autres types de modèles sont également au programme.

Commentaire