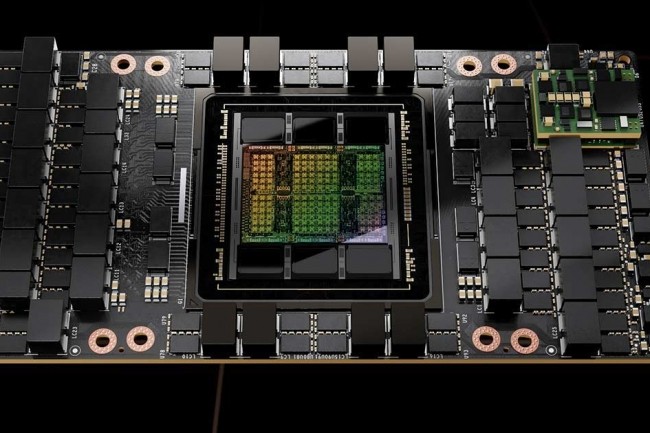

Alors que les systèmes d'IA et d'apprentissage machine travaillent avec des ensembles de données de plusieurs milliards d'entrées, les vitesses et les flux sont devenus plus importants que jamais. La publication par Nvidia de résultats de performances pour son accélérateur GPU Hopper H100 dans MLPerf 3.0, un benchmark de premier plan pour les charges de travail d'apprentissage profond. Comme on peut s’y attendre, Hopper a surpassé son prédécesseur A100 Ampere, dans les temps d'entraînement de l’IA, et ses performances se sont également améliorées grâce à des optimisations logicielles.

MLPerf exécute des milliers de modèles et de charges de travail pour simuler une utilisation réelle. Ces charges de travail incluent la classification d'images (ResNet 50 v1.5), le traitement du langage naturel (BERT Large), la reconnaissance vocale (RNN-T), l'imagerie médicale (3D U-Net), la détection d'objets (RetinaNet) et la recommandation (Deep Learning Recommendation Model, DLRM). Nvidia a publié pour la première fois les résultats des tests du H100 en utilisant le benchmark d’inférence MLPerf 2.1 en septembre 2022. Ces résultats ont montré que la puce H100 était 4,5 fois plus rapide que l'A100 pour exécuter différentes charges de travail d'inférence. Par rapport à MLPerf 2.1, le GPU H100 de Nvidia affiche des améliorations allant de 7 % à 54 % avec la version MLPerf 3.0.

Le concepteur a également indiqué que le modèle d'imagerie médicale était 30 % plus rapide avec MLPerf 3.0. Il faut préciser que Nvidia a effectué ces tests, et non un tiers indépendant. Mais ce n'est pas le seul fournisseur à procéder ainsi. Des dizaines d'autres, dont Intel, ont effectué leurs propres tests et devraient aussi constater des gains de performance.

Commentaire