Maintenant que l'AI Act a été voté par le Parlement européen, franchissant une première étape clef avant son adoption par les 27, il est temps d'évaluer comment les modèles de fondation, comme les LLM représentés par le désormais incontournable GPT-4 d'OpenAI, se conforment à cette future réglementation. Quatre chercheurs de l'université californienne de Standford (Rishi Bommasani, Kevin Klyman, Daniel Zhang et Percy Liang) se sont penchés sur la question. Et le bilan, guère reluisant, en dit long sur les efforts que l'industrie devra fournir pour s'aligner sur la première législation encadrant l'IA dans le monde.

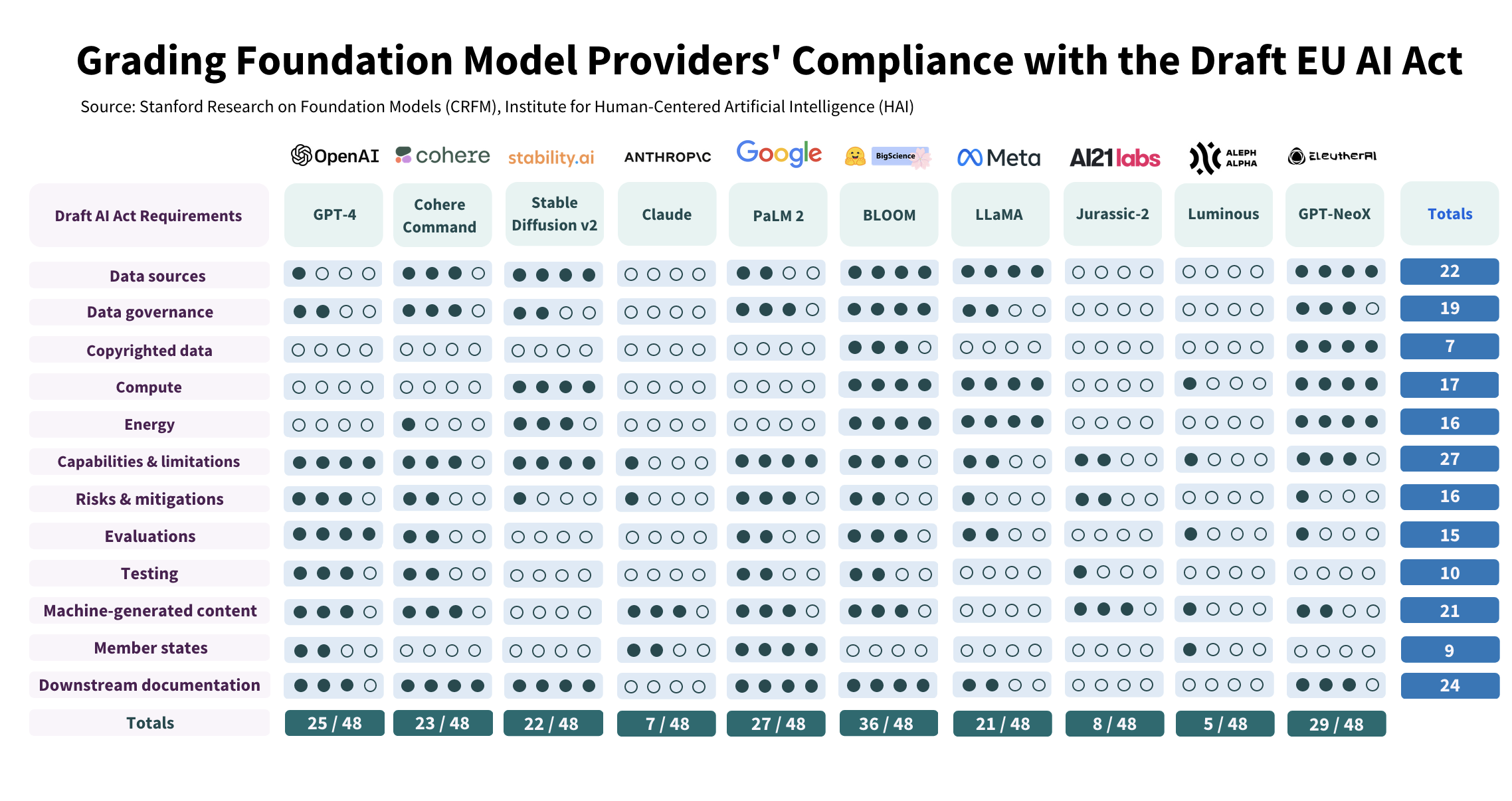

Scrutés sur 12 critères correspondant à autant d'exigences des législateurs de l'Union, 3 des 10 modèles étudiés obtiennent des notes déplorables. Les stars du domaine, dont GPT-4 (OpenAI), PaLM 2 (Google), Stable (Stability.ai) et LLaMA (Meta), font un peu mieux, avec des scores variant entre 21 et 27 sur 48. Le bon élève de la classe générative, le modèle Open Source Bloom, entraîné sur la calculateur français Jean Zay au CNRS et porté par HuggingFace, se détache nettement, avec un total de 36 points sur 48. « Même pour les prestataires les mieux notés, la marge d'amélioration reste importante », tempère toutefois Stanford, pour qui l'étude confirme l'ampleur des changements que l'industrie devra accepter pour se conformer à l'AI Act. Tout en ajoutant que ces changements restent « à la portée » des fournisseurs. Et les quatre auteurs de défendre, à rebours des doutes qui fleurissent en Europe, la pertinence de cette régulation : « L'adoption et l'application de la loi européenne sur l'IA entraîneront des changements positifs importants dans l'écosystème des modèles de fondation ».

Risques des modèles : le grand flou

Principale lacune de ces modèles au regard de l'AI Act, selon les chercheurs : le manque de transparence. « Les fournisseurs divulguent rarement les informations attendues concernant les données, le calcul et le déploiement de leurs modèles, ainsi que les principales caractéristiques des modèles eux-mêmes », écrivent les chercheurs qui estiment en particulier que les fournisseurs ne se conforment généralement pas aux exigences de la future législation en matière de documentation sur l'utilisation de données d'entraînement protégées par des droits d'auteur, sur le matériel utilisé et sur les émissions produites lors de la phase d'entraînement, sur la manière dont ils évaluent et testent les modèles ainsi que sur la façon dont ils limitent les risques inhérents aux modèles de fondation utilisés dans l'IA générative. « Si de nombreux fournisseurs de modèles de fondation énumèrent les risques, relativement peu d'entre eux divulguent les mesures d'atténuation qu'ils mettent en oeuvre et l'efficacité de ces mesures », écrivent les chercheurs. Par ailleurs, la future législation de l'Union demande aux prestataires de décrire « les risques non atténués en expliquant pourquoi ils ne peuvent pas l'être ». Ce qu'aucun des prestataires évalués ne fait actuellement, pointe l'étude de Standford.

Les chercheurs de Stanford ont évalué 10 modèles d'IA sur 12 critères correspondant à des exigences de l'AI Act. Bilan : aucun n'est conforme à la future réglementation européenne.

Et de recommander aux législateurs de donner la priorité à cette question de la transparence. « Notre évaluation démontre qu'il est actuellement possible pour les fournisseurs de modèles de fondation de se conformer à l'AI Act et que la divulgation d'informations relatives à l'élaboration, à l'utilisation et aux performances des modèles améliorerait la transparence dans l'ensemble de l'écosystème », écrivent les chercheurs, qui soulignent l'importance du texte européen, première législation sur l'IA à l'échelle mondiale appelée donc à créer un précédent. « Les décideurs politiques du monde entier s'inspirent déjà de cette législation, et les entreprises multinationales pourraient [du fait de l'AI Act] modifier leurs pratiques afin de maintenir un processus unique de développement de l'IA à l'échelle mondiale », veulent croire les auteurs de l'étude.

Commentaire