Qu'il semble loin le temps où Nvidia était principalement connu pour ses cartes graphiques pour joueurs de jeux-vidéo. Désormais, plus que jamais, le fabricant de puces et circuits graphiques américain vise le marché des entreprises, et plus spécifiquement celui des datacenters et du calcul haute performance. Manifestement en pleine forme et depuis sa cuisine, le toujours très sémillant CEO de Nvidia Jen-Hsun Huang a fait tomber une pluie d'annonces en la matière et a particulièrement mis le paquet sur ses fameuses puces DPU (data processing unit), positionnées pour répondre aux besoins de puces dédiées en environnement datacenters.

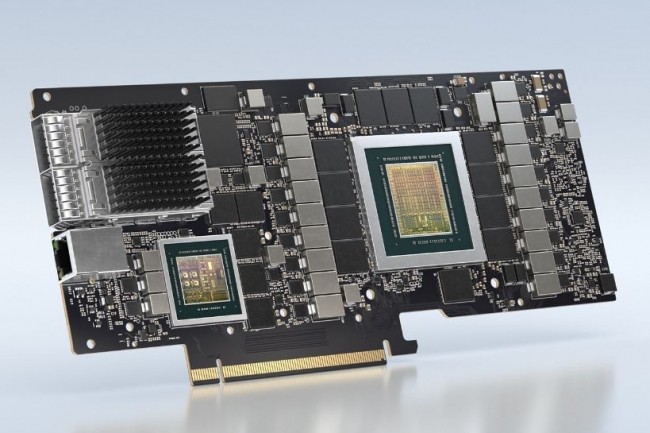

Après avoir conclu un partenariat clé avec VMware pour accroitre la performance de traitement en IA et apprentissage machine de sa Cloud Foundation, le fabricant a levé le voile sur les processeurs BlueField-2. Prévus pour équiper les serveurs des datacenters, ces DPU ont la particularité d'être mis en oeuvre sous la forme d'un contrôleur d'interface réseau - ou carte NIC - que les entreprises peuvent attacher à leurs serveurs via le standard d'interconnexion PCIe. Embarquant 8 coeurs physiques, les puces BlueField-2 reposent sur une architecture ARM Cortex-A72 et disposent des circuits d'accélération optimisés pour des tâches de sécurité.

Le CEO de Nvidia Jen-Hsun Huang a lancé le coup d'envoi de la conférence GTC 2020 depuis sa cuisine ce 5 octobre 2020. (crédit : Nvidia)

Jusqu'à 400 000 milliards d'ops de workloads IA en 2023

A noter l'annonce également d'une itération 2X de cette puce qui ajoute des capacités de traitement graphique reposant sur l'architecture maison Ampere déjà vue dans les derniers GPU haut de gamme du groupe. Pour répondre aux besoins, très en vogue, de baisse de consommation énergétique de datacenters toujours trop énergivores, Nvidia explique que son BlueField-2 dans sa version de base peut gérer autant de tâches à lui seul que 125 CPU classiques. Le constructeur ne compte pas s'arrêter en si bon chemin puisque des modèles de 3e et 4e génération de son BlueField sont dans les tuyaux et visent une capacité de traitement de 400 000 milliards d'opérations par seconde de workloads IA à horizon 2023.

A signaler que ces nouveaux DPU de Nvidia sont adossés à un kit de développement logiciel DOCA permettant de concevoir des applications tournant sur ces puces, incluant des interfaces de programmation, des exemples de code, de la documentation, des bibliothèques... « DOCA vous offre un ensemble unifié d’outils fiables pour développer les principaux services de datacenter fonctionnant sur le DPU, afin de gérer plusieurs types de traitement de données », a indiqué dans un billet de blog Ariel Kit, directeur du marketing produit pour l’unité réseau de Nvidia. « Il s'agit notamment de diriger le trafic réseau; accélérer, virtualiser et compresser le stockage; chiffre et déchiffrer les données; rechercher les menaces pour la sécurité; intégrer avec des outils de gestion à distance, et exécuter des applications de plan de contrôle vers les cœurs ARM ».

Pour sa dernière génération de Superpod, Nvidia s'appuie sur une batterie de partenaires dont Atos, HPE, Equinix, Interxion, Pure Storage et Fujitsu. (crédit : Nvidia)

140 appliances DGX A100 pour une puissance de 700 petaflops

Parmi les annonces, celle de permettre aux entreprises de concevoir un supercalculateur optimisé pour le deep learning en quelques semaines a pu surprendre. Avec la dernière version de son SuperPod, Nvidia espère réussir un double challenge, à savoir tirer ses ventes de puces tout en baissant le coût de la barrière à l'entrée en matière de construction de supercalculateur. Toutes les entreprises ont-elles pour autant des velléités à concevoir leur propre supercalculateur ? Rien n'est moins sûr, même si le coût bas promis par NVidia constitue un argument de poids.

SuperPod se présente comme un système multipetaflops pouvant être mis sur pied en quelques semaines, bâti sur des appliances Nvidia et des circuits réseaux Mellanox. Le supercalculateur SuperPod est articulé sur une appliance bien connue, DGX A100, intégrant huit puces A100 embarquant deux unités de calcul et 1To de mémoire. Nvidia annonce la possibilité de relier entre 20 et 140 appliances DGX A100 ensemble dans un réseau de switchs Mellanox HDR InfinityBand permettant de créer un supercalculateur doté d'une puissance de calcul pouvant aller de 100 à 700 petaflops. « Les supercalculateurs traditionnels peuvent prendre des années à être planifiés et déployés, mais la solution clé en main NVIDIA DGX SuperPOD pour les entreprises aide les clients à commencer leur transformation de l’IA dès aujourd'hui », a déclaré Charlie Boyle, vice président et directeur général des systèmes DGX de Nvidia.

Bientôt dans le Top30 des supercalculateurs les plus puissants ?

Nvidia a par ailleurs donné des détails sur deux projets basés sur ses SuperPod. Comme on n'est jamais mieux servi que par soi-même, le premier est interne au fabricant américain pour un système déployé sur son site de Cambridge en Grande-Bretagne pour un coût inférieur à 50 millions d'euros et qui devrait selon le groupe devenir le supercalculateur le plus puissant dans le pays dans les mois à venir. Avec une puissance de calcul IA de 400 petaflops, cela le classerait à la 29e place des supercalculateurs les plus puissants au Top500. Un autre projet est celui pour le compte du ministère de l'électronique et des technologies de l'information indien qui va utiliser 42 appliances DGX A100 pour un supercalculateur de calcul haute performance et IA.

Commentaire