La question est au centre des discussions entre décideurs IT, directions générales et métiers : qu'espérer des LLM en gain de productivité ? Et où les insérer dans les processus métiers pour en bénéficier ? C'est sur cette problématique que se penche une étude de la Harvard Business School, en collaboration avec le cabinet de conseil Boston Consulting Group (BCG) et des chercheurs issus d'autres écoles de management américaines. Et le moins que l'on puisse dire, c'est que la réponse aux questions posées est tout sauf simple. Certes, selon les auteurs, les résultats montrent que la génération de LLM actuellement disponibles est tout à fait capable d'entraîner des augmentations significatives de la qualité et de la productivité, voire d'automatiser complètement certaines tâches. Reste que l'identification des travaux automatisables reste complexe.

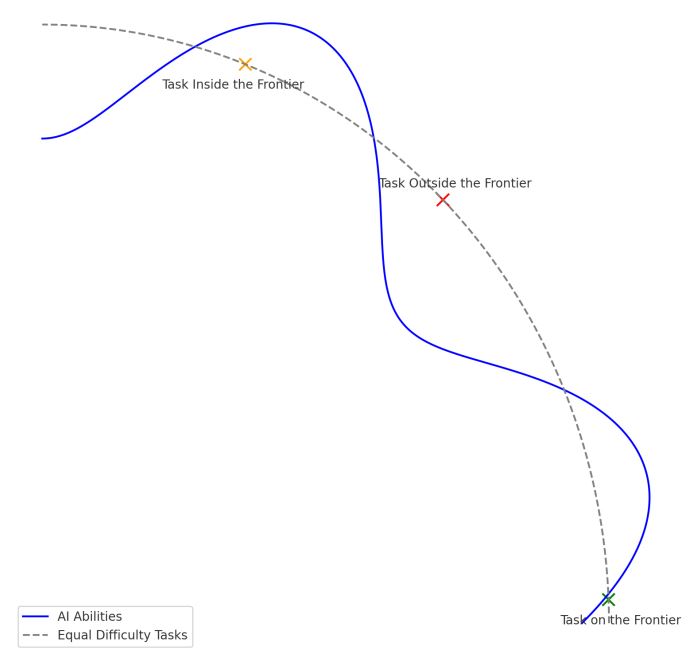

« Les tâches que l'IA peut réellement accomplir sont surprenantes et ne sont pas toutes immédiatement identifiables de façon évidente pour les utilisateurs, voire pour les producteurs de LLM eux-mêmes », écrivent les chercheurs. Et de parler d'une « frontière technologique en dents de scie », qu'il va falloir préciser métier par métier, tâche par tâche. « Certaines tâches inattendues - comme la génération d'idées - sont faciles à traiter pour les IA, tandis que d'autres, que l'on penserait faciles à gérer pour une machine - comme les mathématiques de base - sont de vrais défis pour certains LLM », précisent les auteurs de l'étude.

D'un côté et de l'autre de la frontière

Pour parvenir à cette conclusion, l'étude repose sur l'analyse d'expériences menées auprès de 758 consultants du BCG, répartis en trois catégories : un groupe n'ayant pas accès à l'IA, un autre bénéficiant de GPT-4, et un dernier de GPT-4 enrichi de mécanismes de prompt engineering. « Certaines tâches sont facilement accomplies par l'IA, tandis que d'autres, bien qu'apparemment d'un niveau de difficulté similaire, sont hors de portée de ses capacités actuelles », écrivent les auteurs de l'étude.

Pour les chercheurs de la Harvard Business School, bien utiliser les LLM revient à définir, métier par métier, la frontière où cette technologie permet d'améliorer le travail humain.

D'un côté, pour les 18 tâches situées à l'intérieur de cette 'frontière' virtuelle entre tâches faciles à exécuter par l'IA et tâches hors de sa portée, les consultants utilisant l'IA ont été nettement plus productifs (avec 12,2 % de tâches en plus en moyenne et 25,1 % de tâches en moins). Ils ont produit des résultats de qualité nettement supérieure (plus de 40 % de qualité en plus par rapport à un groupe de contrôle). De l'autre, pour une tâche sélectionnée comme étant en dehors de la 'frontière', les consultants utilisant l'IA produisent environ 20% de moins de réponses correctes par rapport à ceux qui n'utilisaient pas cette technologie. Intégrer les IA génératives dans les processus métiers revient donc largement à tracer cette frontière et à en surveiller les évolutions. Car, au-delà de celle-ci, la technologie a tendance à produire des résultats incorrects, mais plausibles (les hallucinations), et à commettre d'autres types d'erreurs, y compris en mathématiques et lors de la fourniture de citations.

Sans oublier un autre facteur de complexité : les bénéfices apportés par l'IA diffèrent grandement en fonction des compétences propres à chaque individu. Dans l'étude de la Harvard Business School, les consultants se situant en dessous du seuil de performances moyen bénéficiant d'un bond de 43% par rapport à leur propre score sans IA, tandis que chez les consultants les plus pointus, ces gains de productivité sont limités à 17%.

Un technologie naissante se vend parfois à un prix inférieur à la réalité. Et on le voit bien, les accès gratuits et les prix, ma foi, pas très élevés de ChatGPT ou Dall-E cachent bien le fait également connu que les data center qui les portent sont colossaux, et les couts d'apprentissage de ces bases de neurônes se comptent en millions.

Signaler un abusJe crois donc que calculer des prix de revient de l'IA générative, c'est marcher sur une dette cachée qui va forcément nous revenir dans la gueule un jour, soit sous forme d'augmentation de prix, soit sous force de taxes, soit d'interdictions, soit d'une dette écologique... une tension se libère forcément un jour, comme un tremblement de terre.