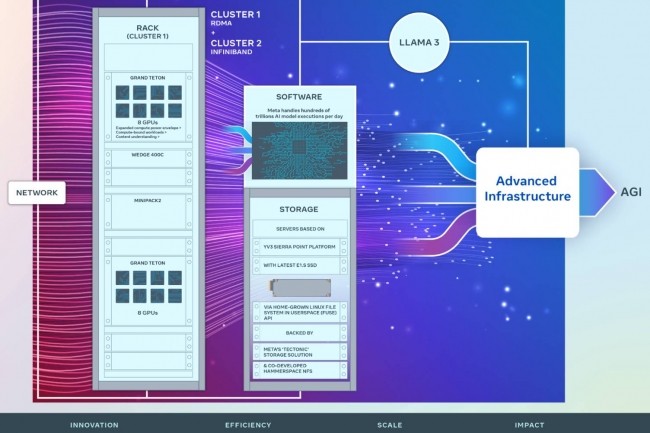

Dans la course aux traitements des LLM, Meta est bien décidé à ne pas se laisser distancer. Dans un billet de blog, Meta a montré ses derniers travaux en matière d'infrastructure soutenant les traitements IA et ses grands modèles de langage (LLM). Le moins que l'on puisse dire c'est que le fournisseur a mis le paquet avec deux clusters de 24 576 accélérateurs GPU Tensor Core H100 de Nvidia. « Nous partageons des détails sur le matériel, le réseau, le stockage, la conception, les performances et les logiciels qui nous permettent d'obtenir un débit et une fiabilité élevés pour diverses charges de travail d'IA. Nous utilisons cette conception de cluster pour l'entraînement du Llama 3 », explique Meta. Ces clusters s'appuient sur Grand Teton, OpenRack et PyTorch et s'inscrivent selon le groupe dans une logique d'open innovation. A terme, cette infrastructure est aussi conçue pour répondre aux besoins d'entrainements de futurs LLM. Meta indique avoir mis l'accent sur l'efficacité et la performance aussi bien en termes de réseaux, stockage que capacités de calcul pour répondre à des besoins et cas d'usage de plus en plus complexes de la GenAI.

Côté réseau, Meta a conçu un premier cluster RDMA (remote direct memory access) sur Ethernet convergé (RoCE) basée sur Arista 7800 avec des commutateurs rack OCP Wedge400 et Minipack2, le second est équipé d'une structure InfiniBand Nvidia Quantum2. Ces deux solutions interconnectent des points d'extrémité à 400 Gbps. « Grâce à ces deux solutions, nous sommes en mesure d'évaluer l'adéquation et l'évolutivité de ces différents types d'interconnexion pour la formation à grande échelle, ce qui nous permet de mieux comprendre la manière dont nous concevrons et construirons à l'avenir des grappes encore plus grandes et plus évoluées », indique Meta.

Une infrastructure de stockage à la pointe

Concernant le stockage, le fournisseur a mis au point une API Linux Filesystem in Userspace (FUSE) s'appuyant sur une version stockage distribué de Tectonic optimisée pour les systèmes à mémoire flash. « Cette solution permet à des milliers de GPU de sauvegarder et de charger des points de contrôle de manière synchronisée tout en fournissant un stockage flexible et à haut débit à l'échelle du gigaoctet requis pour le chargement des données », précise Meta. « Nous nous sommes également associés à Hammerspace (rencontre récemment) pour co-développer et mettre à disposition un système de fichiers réseau parallèle (NFS) afin de répondre aux exigences de l'expérience des développeurs pour ce cluster d'IA ». Avec à la clé des bénéfices en termes de débogage et de vélocité.

Cette infrastructure de stockage est basée sur un système serveur YV3 Sierra Point dotée d'une mise à niveau avec le dernier SSD E1.S de haute capacité. « Outre la capacité SSD plus élevée, le nombre de serveurs par rack a été personnalisé afin d'atteindre le bon équilibre entre la capacité de débit par serveur, la réduction du nombre de racks et l'efficacité énergétique associée. En utilisant les serveurs OCP (open compute project) comme des blocs de construction de type Lego, notre couche de stockage est capable de s'adapter de manière flexible aux exigences futures de ce cluster ainsi qu'aux futurs clusters d'IA plus importants, tout en étant tolérante aux pannes lors des opérations quotidiennes de maintenance de l'infrastructure », précise Meta.

350 000 GPU H100 dans le viseur de Meta d'ici fin 2024

La firme américaine a par ailleurs aussi indiqué qu'il allait acheter davantage d'accélérateurs GPU H100 de Nvidia avec l'intention d'en posséder plus de 350 000 d'ici la fin de l'année. Ceux-ci seront utilisés pour continuer à développer son infrastructure IA avec sans doute dans les mois qui viennent d'autres clusters encore plus puissants.

« En regardant vers l'avenir, nous reconnaissons que ce qui a fonctionné hier ou aujourd'hui peut ne pas être suffisant pour les besoins de demain. C'est pourquoi nous évaluons et améliorons constamment chaque aspect de notre infrastructure, des couches physiques et virtuelles à la couche logicielle et au-delà. Notre objectif est de créer des systèmes flexibles et fiables pour soutenir l'évolution rapide des nouveaux modèles et de la recherche », conclut le groupe.

Commentaire