Juste avant les salons Computex (du 24 au 27 mai, à Taipei, à Taïwan) et du ISC High Performance (du 29 mai au 2 juin à Hambourg, en Allemagne), Nvidia a dévoilé des conceptions de référence pour le calcul haute performance (HPC) et une technologie de refroidissement par eau (un fluide caloporteur en fait) pour ses GPU. Les architectures de référence exploitent le CPU Grace Superchip et le duo CPU/GPU Grace Hopper Superchip (tous les deux sur base ARM) pour datacenter, prévus pour l'année prochaine. Le processeur Grace Superchip combine deux matrices de processeur Grace sur un seul circuit, connectées avec la technologie NVLink-C2C de 900 Go/s du fournisseur de puces, qui fournit 144 cœurs et assure 1 To/s de bande passante mémoire dans une empreinte électrique de 500 watts. Grace Hopper Superchip remplace l'une des CPU par un GPU H100, également directement connecté au CPU par NVLink-C2C, avec une consommation de 1 000 watts.

Ces deux circuits vont intégrer les produits de la gamme HGX de Nvidia pour les grands déploiements HPC, où la densité de calcul est à l'ordre du jour. Ils sont disponibles en version 1U et 2U avec deux nœuds HGX Grace-Hopper ou quatre nœuds HGX Grace dans un seul châssis. Tous les quatre sont équipés de circuits réseau de type DPU BlueField-3.

Les quatre modèles commercialisés sont les suivants :

- Les systèmes HGX Grace Hopper pour l'apprentissage IA, l'inférence et le calcul intensif.

- Les HGX Grace pour le calcul intensif et les supercalculateurs avec une conception uniquement basée sur le CPU

- Les OVX pour alimenter la simulation des jumeaux numériques (copies virtuelles d'objets physiques) et les charges de travail collaboratives.

- Enfin, les CGX pour l’accélération graphique et les jeux en mode cloud (calcul déporté)

Les solutions de Nvidia se déclinent pour les principaux usages avec accélération GPU pour le calcul intensif. (Crédit S.L.)

« Ces nouveaux modèles de référence permettront à notre écosystème de produire rapidement des serveurs optimisés pour les piles logicielles d'informatique accélérée de Nvidia, et [ils] pourront être qualifiés comme faisant partie de notre gamme de systèmes certifiés par Nvidia », a expliqué Paresh Kharya, directeur de l’activité datacenter de Nvidia, lors d'un point presse. La firme de Santa Clara compte déjà six fournisseurs partenaires qui prévoient de lancer des systèmes au cours du premier semestre de l'année prochaine : Asus, Foxconn, Gigabyte, QCT, Supermicro et Wiwynn.

Refroidissement liquide pour les GPU

Sur le front du refroidissement par eau (fluide caloporteur), Nvidia reconnaît ce que les joueurs savent depuis un certain temps : Ses GPU sont très chauds et le refroidissement liquide est une alternative viable à celui par air. Le GPU actuel de la série 3000 de Nvidia, refroidi par air, fait jusqu'à trois pouces d'épaisseur. La carte sur laquelle se trouve le GPU ne fait que quelques millimètres d'épaisseur, le dissipateur thermique et le ventilateur comblant la différence, ce qui les rend extrêmement encombrants et difficiles à insérer dans un espace restreint. Nvidia s'inspire donc de pratiques anciennes déjà présentes dans les grands systèmes : il supprime le dissipateur thermique et le ventilateur et les remplace par un système de refroidissement liquide beaucoup plus fin, similaire à la technologie de refroidissement par eau utilisée sur les CPU. Le fluide caloporteur est acheminé par un tuyau pour refroidir la plaque au-dessus du processeur, avant d’être aspiré pour être refroidi.

Le résultat est une carte PCIe à refroidissement liquide pour le GPU phare de Nvidia, l'Ampere A100, qui sera disponible au troisième trimestre de cette année. Le fournisseur a un plan similaire pour le successeur de l'A100 récemment annoncé, le H100 exploitant l’architecture Hopper et attendu l'année prochaine. Le bloc avec le fluide caloporteur est beaucoup plus fin que le dissipateur thermique, ce qui est essentiel. Les dissipateurs thermiques sont si grands qu'ils bloquent l'emplacement PCI Express juste à côté. Avec le bloc d'eau, une deuxième carte peut être placée dans le châssis. « Le refroidissement liquide existe depuis l'époque des mainframes et il est largement utilisé aujourd'hui pour refroidir les superordinateurs les plus rapides du monde. Nous prenons généralement en charge ces déploiements avec nos plateformes HDX haute performance. Cependant, aujourd'hui, même les centres de données d'entreprise classiques étudient les possibilités de refroidissement liquide dans leurs infrastructures", a déclaré M. Kharya.

Ce dernier a ajouté que le refroidissement liquide permettra à ces serveurs HPC d'offrir le même niveau de performance que ceux avec refroidissement par air tout en consommant jusqu'à 30 % moins d'énergie, selon les résultats de tests récents que Nvidia a effectués avec Equinix. Plus d'une douzaine de fabricants de serveurs devraient prendre en charge la carte PCIe A100 à refroidissement liquide plus tard dans l'année, notamment ASUS, Gigabyte, Inspur et Supermicro.

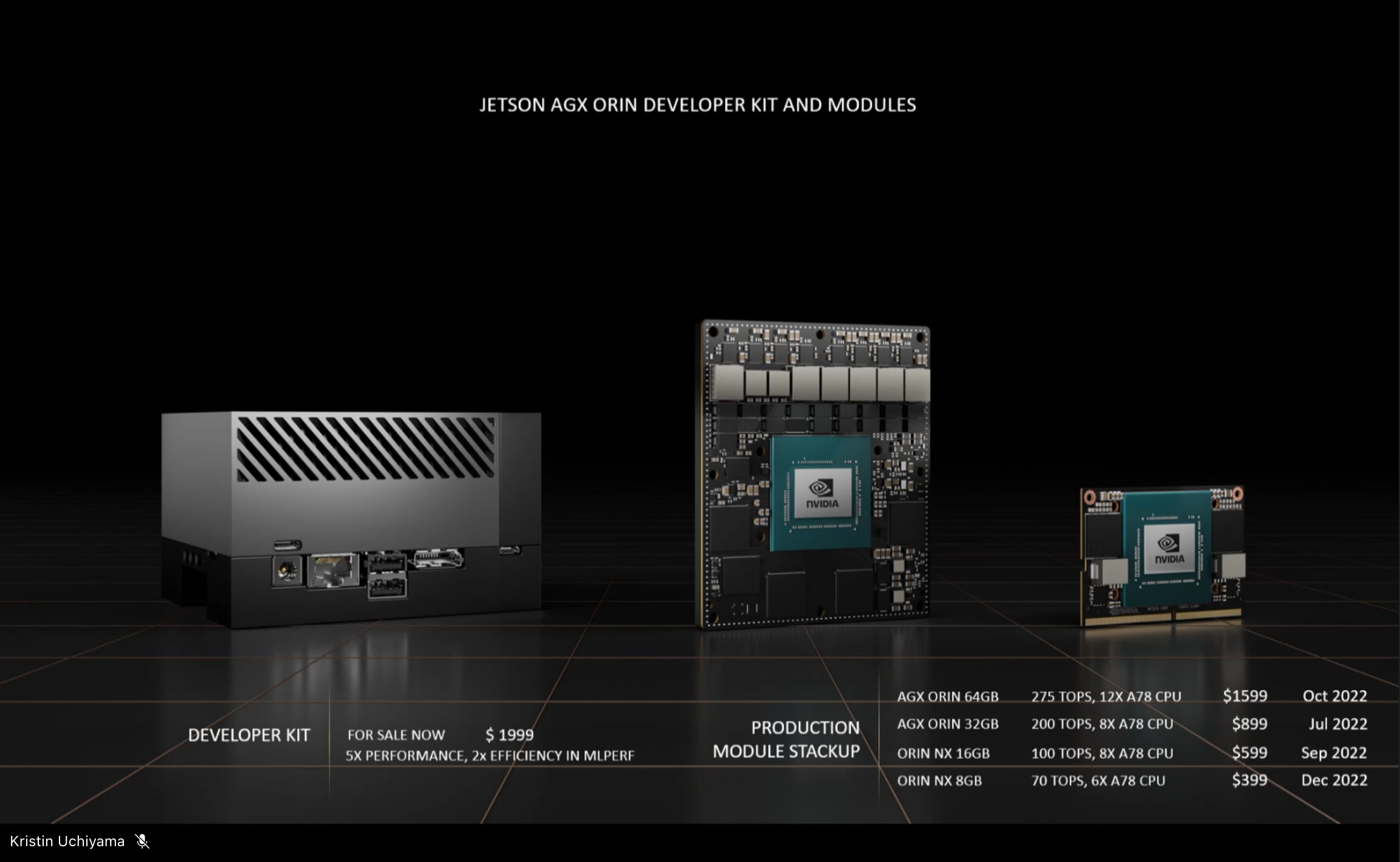

Jetson pour l'edge

La firme de Santa Clara a également annoncé un déploiement plus large de sa plateforme basse consommation Jetson AGX Orin sur des systèmes proposés par plus de deux douzaines de fournisseurs partenaires. Jetson AGX Orin a été annoncé plus tôt cette année lors de l’évènement GTC de Nvidia. Il s'agit d'un kit de développement avec un ordinateur monocarte basé sur un CPU ARM avec 12 cœurs Cortex-A78AE et un GPU Ampere A100.

Destiné aux usages périphériques et embarqués, Jetson repose sur une puce basse consommation épaulée un puissant GPU doté d’accélérateurs pour les traitements IA. (Crédit S.L.)

Nvidia affirme que 6 000 clients dans le monde construisent des solutions avec des circuits Jetson, et pour répondre à la demande croissante, le fournisseur a annoncé quatre modèles de référence avec différentes configurations mémoire, disponibles plus tard cette année.

Commentaire