Difficile de suivre la stratégie d'OpenAI dans la dénomination de ses modèles GPT. La société a récemment lancé GPT-4.5, mais vient de présenter la version 4.1 de son modèle. Décliné en plusieurs versions (standard, mini et nano), ils seront accessibles uniquement via l'API et se veulent plus rapides, économiques et performants. Selon l’entreprise, ces modèles « excellent dans les tâches de codage et le suivi des instructions » et dépassent GPT-4o et sa version mini « sur tous les plans ». Certaines de ces améliorations ont déjà été intégrées à la dernière version de GPT-4o, d’autres sont à venir.

En parallèle, OpenAI a annoncé la fin du modèle GPT-4.5 Preview, qui sera retiré de l’API le 14 juillet 2025. GPT-4.1 est désormais présenté comme son successeur naturel, offrant de meilleures performances à un coût réduit.

Une capacité de traitement renforcée

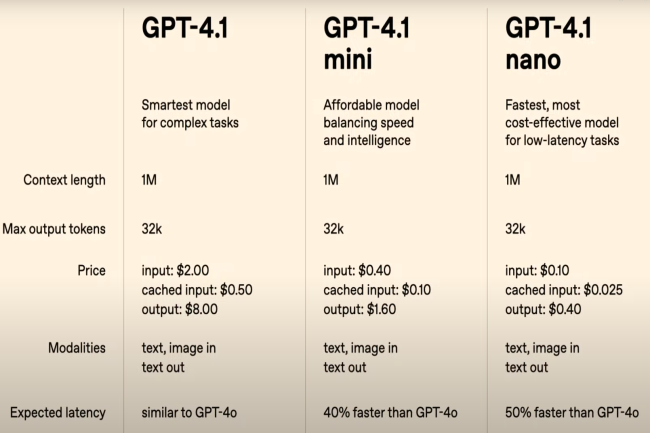

Les modèles bénéficient d’une fenêtre de contexte étendue à un million de tokens, contre 128 000 pour GPT-4o, et d’une meilleure compréhension des contextes longs. Ils se rapprochent ainsi de la proposition de Gemini de Google. La limite de sortie passe quant à elle de 16 385 à 32 767 tokens. OpenAI affirme avoir collaboré étroitement avec sa communauté de développeurs pour affiner ces modèles selon leurs besoins. À titre d’exemple, le score sur le benchmark SWE-bench verified a été amélioré de 21,4 % par rapport à GPT-4o.

Récapitulatif des avantages des trois versions de GPT-4.1

Les versions mini et nano se démarquent par leur efficacité et leur faible coût. Ainsi, le modèle mini offrirait une latence réduite de moitié par rapport à GPT‑4o et une baisse des coûts de 83 %, tout en maintenant des performances élevées. Quant au nano, le modèle le plus rapide et le plus économique, OpenAI précise qu’il est « idéal pour des tâches comme la classification ou l’autocomplétion ». Ces modèles s’intègrent également plus facilement à des outils comme l’API Responses, facilitant la création d'agents plus autonomes capables de traiter des documents complexes ou de répondre à des requêtes clients avec un minimum d’intervention humaine.

Des gains concrets sur les tâches complexes

Les gains de performance s’observent également sur des tâches techniques avancées. L'entreprise affirme que GPT-4.1 est plus efficace que GPT-4o pour résoudre du code de manière autonome, développer des interfaces front-end, effectuer des modifications ciblées, suivre des formats de diffusion ou utiliser des outils de manière cohérente.

Ces avancées s’accompagnent d’une baisse de coût : 26 % de réduction sur le coût médian par requête, 75 % de remise sur le cache de prompt (contre 50 % auparavant), pas de surcoût pour les longues requêtes, et 50 % de remise pour les utilisateurs de l’API Batch.

Des analystes s’interrogent

Malgré des annonces ambitieuses, certains experts appellent à la prudence. Justin St-Maurice, conseiller technique chez Info-Tech Research Group, exprime des doutes sur l'efficacité, la tarification et la capacité de mise à l’échelle des nouveaux modèles. « Cette annonce soulève assurément des questions », estime-t-il. Selon lui, « si la réduction de 83 % des coûts est réelle, ce serait un tournant, notamment pour les grandes entreprises et les fournisseurs de cloud qui examinent de près la valeur par watt ». Mais il nuance : « OpenAI ne précise pas clairement à quel modèle la comparaison se réfère. »

Malgré les réductions annoncées, Justin St-Maurice considère GPT-4.1 comme une solution haut de gamme, bien qu'elle soit en phase avec les tendances actuelles des serveurs MCP (Model Context Protocol) et des systèmes pour les agents. Il explique que « le traitement d’un million de tokens permet des workflows complexes et un raisonnement en temps réel, mais à 2 $ par million de tokens en entrée et 8 $ en sortie, cela reste coûteux, surtout face à des alternatives comme Llama. »

Commentaire