La fonctionnalité de la plateforme d'IA générative (genAI) dévoilée la semaine dernière par OpenAI sait utiliser un texte pour générer une vidéo, avec des acteurs et d'autres éléments mobiles réalistes. Appelé Sora, ce modèle de genAI dispose d'une fonction texte-vidéo capable de créer des scènes complexes et réalistes avec plusieurs personnages, des types de mouvements spécifiques et des détails précis sur le sujet et l'arrière-plan « tout en maintenant la qualité visuelle et le respect de l'invite de l'utilisateur ». Sora comprend non seulement ce que l'utilisateur demande dans l'invite, mais aussi comment ces choses existent dans le monde physique. « La technologie traduit les descriptions écrites en contenu vidéo, en s'appuyant sur des modèles d'IA qui comprennent les entrées textuelles et génèrent les éléments visuels et auditifs correspondants », a expliqué Bernard Marr, consultant en nouvelles technologies. « Ce processus s’appuie sur des algorithmes d'apprentissage profond qui ont la capacité d’interpréter le texte et de synthétiser des vidéos en fonction des scènes, des actions et des dialogues décrits dans le texte. Même si cette capacité est déjà proposée par les moteurs d'IA d'autres fournisseurs, comme Gemini de Google, l'impact de Sora devrait être profond », a-t-il estimé.

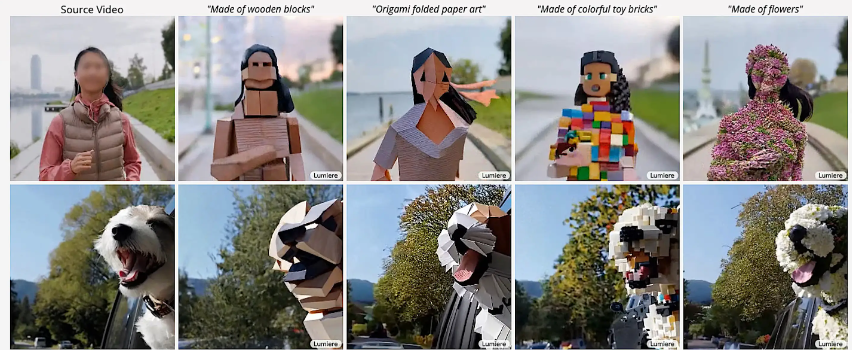

Les fonctions d'édition d'images basées sur le texte incluent dans Lumiere de Google peuvent être utilisées pour l'édition de vidéos. (Crédit : Google)

Comme toute technologie avancée de genAI, l'impact de Sora contribuera à remodeler la création de contenu, en améliorant la narration et en démocratisant la production vidéo. « Les capacités de conversion de texte en vidéo apportent un immense potentiel dans un tas de domaines comme l'éducation, pour créer par exemple des supports d'apprentissage immersifs, le marketing, pour générer des contenus attrayants, et le divertissement, pour le prototypage rapide et le storytelling », explique Bernard Marr. « Cependant, la capacité des modèles d'IA à traduire des descriptions textuelles en véritables vidéos souligne également la nécessité de considérations éthiques rigoureuses et de mesures de protection contre les utilisations abusives. L'émergence de la technologie de conversion de texte en vidéo soulève des questions complexes concernant la violation des droits d'auteur, d'autant plus qu'elle est capable de générer un contenu qui pourrait se rapprocher étroitement des œuvres protégées par ce droit d'auteur. Le paysage juridique dans ce domaine fait actuellement l'objet de plusieurs procès en cours, ce qui rend prématurée toute déclaration définitive sur la manière dont les problèmes de droits d'auteur seront résolus »..

Créer un monde pour satisfaire des besoins émotionnels

Selon le consultant, « un élément potentiellement plus inquiétant domine : la capacité de la technologie à produire des deep fakes très convaincants, ce qui soulève de sérieuses questions en matière d'éthique et de respect de la vie privée, et plaide en faveur d'une surveillance et d'une réglementation étroites ». Il y a cinq ans, aux Nations unies, Dan Faggella, fondateur et chercheur principal d'Emerj Artificial Intelligence, avait fait une présentation sur les deep fake. À l'époque, il avait souligné qu'en dépit des avertissements concernant ces faux numériques, à savoir que « les gens voudront croire ce qu'ils veulent croire ». Mais il y a plus important encore : bientôt, les gens pourront vivre dans des mondes d'IA où ils enfileront un casque et demanderont à un modèle d'IA de créer un monde unique pour satisfaire leurs besoins émotionnels, qu'il s'agisse de relaxation, d'humour ou d'action, le tout programmé spécifiquement pour l'utilisateur en question. « La machine sera capable de créer pour tout un chacun des expériences visuelles et sonores, et éventuellement haptiques, formées sur la base des expériences précédentes avec le casque », a avancé Dan Faggella. « Nous devons y réfléchir d'un point de vue politique, notamment sur la limite à accorder à cette modalité d’évasion ». Les modèles texte-vidéo peuvent aussi créer des applications qui font appel à l'IA pour aider les gens à être productifs, les éduquer et faire en sorte qu’ils restent focalisés sur leur travail. « Il peut s'agir de les former à devenir d'excellents vendeurs, de les aider à écrire du bon code et à coder beaucoup plus que ce qu'ils peuvent faire aujourd'hui », a-t-il ajouté.

Pour l'instant, Sora d'OpenAI et Gemini 1.5, le modèle d'IA multimodale de Google, sont à l’état de projets de recherche internes et ne sont proposés qu'à un groupe spécifique d'universitaires tiers et à d'autres personnes qui testent la technologie. Contrairement au populaire ChatGPT d'OpenAI, Google a déclaré que les utilisateurs pouvaient introduire dans son moteur de recherche une quantité beaucoup plus importante d'informations afin d'obtenir des réponses plus précises. Mais, même en tant que des projets de recherche internes, Sora et Gemini 1.5 présentent des exemples réels et des informations détaillées, notamment des vidéos, des photos, des gifs et des documents de recherche connexes. Outre le moteur d'IA multimodale Gemini de Google, Sora arrive après plusieurs modèles de conversion texte-vidéo, notamment Emu de Meta, Gen-2 de Runway et Stable Video Diffusion de Stability AI.

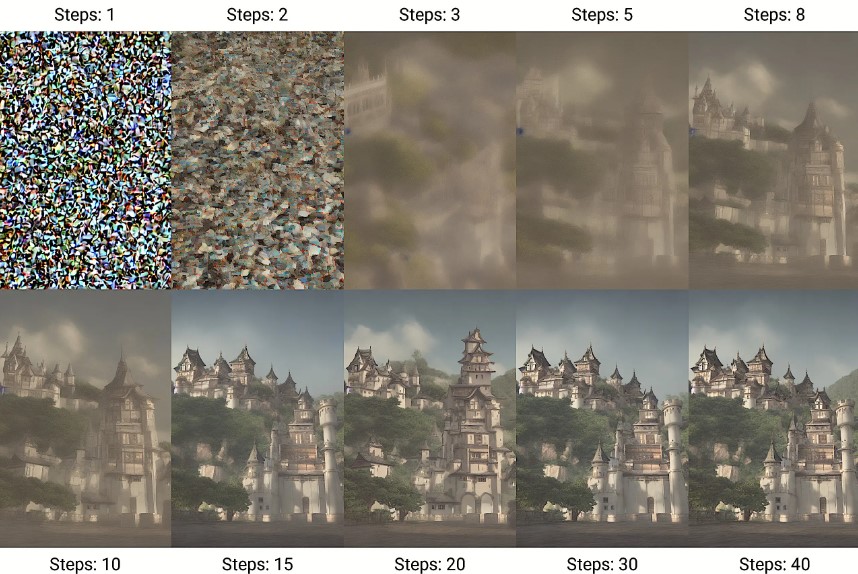

Dans le processus de débruitage utilisé par Stable Diffusion, le modèle génère des images en supprimant itérativement le bruit aléatoire jusqu'à ce qu'un nombre configuré d'étapes ait été atteint. Le processus est guidé par un encodeur de texte CLIP pré-entraîné sur les concepts avec le mécanisme d'attention, jusqu’à générer une image qui illustre une représentation du concept entraîné. (Crédit : Stable Diffusion/Wikipedia)

Sora plus fort que Google et les start-ups ?

Google mène deux projets de recherche simultanés qui font progresser ce qu'un porte-parole a appelé « l'état de l'art en matière de modèles de génération vidéo », à savoir Lumiere et VideoPoet. Lancé au début du mois, Lumiere est la technologie de génération vidéo la plus avancée de Google. Elle propose 80 images par seconde, contre 25 pour des concurrents comme Stable Video Diffusion. « Conçu pour traiter les informations et automatiser les tâches, Gemini offre une intégration transparente des modalités dès le départ, ce qui le rend potentiellement plus intuitif pour les utilisateurs qui recherchent une expérience directe et axée sur les tâches », a expliqué Bernard Marr, ajoutant néanmoins que « l'approche en couches de GPT-4 permettait une amélioration plus granulaire des capacités au fil du temps, et donc une flexibilité et une profondeur dans les capacités de conversation et de génération de contenu ».

Dans une comparaison directe, Sora semble plus puissant que les modèles de génération vidéo de Google. Alors que Lumiere de Google peut produire une vidéo d'une résolution de 512X512 pixels, Sora prétend atteindre des résolutions allant jusqu'à 1920X1080 pixels, soit une qualité HD. Les vidéos de Lumiere sont limitées à environ 5 secondes, alors que celles de Sora peuvent durer jusqu'à une minute. En outre, Lumiere ne peut pas réaliser de vidéos composées de plusieurs plans, alors que Sora le peut. Sora, comme d'autres modèles, serait également capable d'effectuer des tâches d'édition vidéo, créer par exemple des vidéos à partir d'images ou d'autres vidéos, combiner des éléments provenant de différentes vidéos et prolonger des vidéos dans le temps. « Dans la compétition entre Sora d’OpenAI et des start-ups comme Runway AI, la maturité peut offrir des avantages en termes de fiabilité et d'évolutivité », a encore déclaré Bernard Marr. « Alors que les start-ups apportent souvent des approches innovantes et de l'agilité, OpenAI, compte tenu du financement important qu’elle reçoit d'entreprises comme Microsoft, devrait pouvoir rattraper son retard et potentiellement le surmonter rapidement ».

Commentaire