En direct de Cupertino - Créée en 2011 seulement par des anciens salariés de Yahoo, la start-up HortonWorks a bien grandi. Elle possède désormais à sa tête un ancien d'IBM, Herb Cunitz, passé par les filtres SpringSource et VMware avant d'atterrir en octobre 2012 chez le spécialiste de la distribution Hadoop. Parmi les 300 clients de HortonWorks, le dirigeant a mis en avant Macy's, eBay, EDF, Expedia et Spotify qui possède le plus important cluster en Europe avec 1000 noeuds. Aux États-Unis, Yahoo reste le client le plus important avec 32 000 noeuds et en Asie c'est Samsung qui tient pour l'instant la corde avec 400 noeuds. Parmi les grands fournisseurs ayant déjà adopté sa distribution figurent déjà Microsoft, SAP, Teradata, HP et ce dernier s'appuyant par exemple sur HDP pour son service de traitement des big data HDInsight, disponible dans son cloud public Azure. Hortonworks compte aussi de nombreux partenaires technologiques qui intègrent sa plateforme Hadoop aux solutions qu'ils vendent.

Fidèle à son credo 100% Open Source, Horton Works entend toujours marquer sa différence avec ses principaux concurrents Cloudera et MapR en jouant une partition dépourvue de composants propriétaires. Si la distribution est disponible en ligne, le support est aujourd'hui la principale source de revenus de la start-up qui est passée d'une dizaine à 400 personnes aujourd'hui.

Deux moteurs dans HDP, Storm et Solr

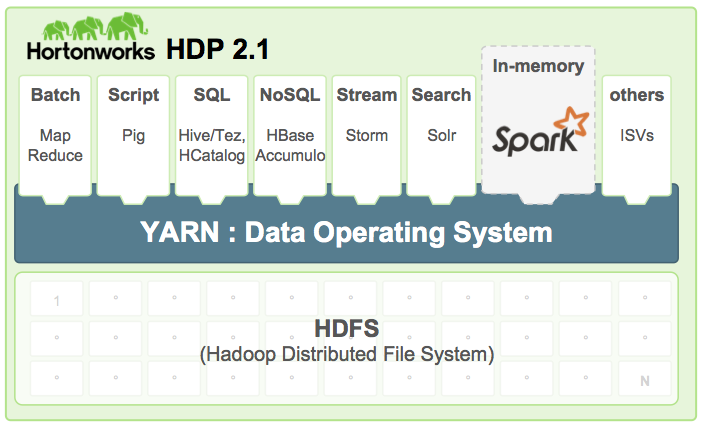

Avec HDP 2.1, une évolution majeure de sa distribution Hadoop, HortonWorks met en avant la mise en oeuvre de Stinger qui apporte l'interactivité aux requêtes de type SQL que permet Hive et élargit la sémantique SQL utilisée. Un autre apport notable porte sur la gouvernance de données, simplifiée avec l'arrivée d'Apache Falcon, framework conçu pour gérer le cycle de vie des données (acquisition, traitement, réplication, redirection vers des extensions non Hadoop). Falcon permet aussi de tracer le chemin des données (data lineage).

Avec cette version 2.1, Hortonworks a également ajouté deux moteurs dans HDP, Storm et Solr. Apache Storm permet le traitement de flux de données en temps réel et l'analyse d'événements provenant de capteurs ou pour la surveillance d'activités métiers. Il est intégré avec Ambari pour sa gestion. Enfin, sur les fonctionnalités de recherche, HPD 2.1 propose Apache Solr qui s'appuie sur le moteur Lucene.

Yarn comme fondement de HDP 2.1

Autre évolution majeure de cette distribution, l'intégration de Yarn (Yet another research negotiator), un successeur de MapReduce qui permet de faire tourner plusieurs applications dans Hadoop en partageant la gestion des ressources communes. A la question de savoir si Yarn était une évolution ou un remplaçant de MapReduce, Herb Cunitz nous a indiqué que l'intégration du moteur de stockage et du traitement batch permettait d'arriver à un traitement en temps réel demandé par de nombreux clients, sans toutefois renoncer à la réplication des données avec HDFS. « C'est toujours une demande des clients d'avoir une réplication des données sur un autre datacenter pour s'assurer qu'aucune donnée ne sera corrompue », a précisé le CEO.

Spark, un framework de la fondation Apache alternatif à MapReduce, s'interface avec HDFS dans HDP 2.1.

Yarn qui est vraiment la brique fondatrice de Hadoop 2.0, sorti octobre dernier, sert en fait de système d'exploitation à Hadoop pour transformer ce qui était une simple plate-forme de données à usage unique pour le traitement par lots en une plate-forme multi-usages qui permet de traiter des flux continus de données en temps réel. L'idée de vouloir appliquer l'analyse Hadoop à un flux de données n'est pas nouvelle. C'était une des principales préoccupations chez les différents acteurs de la plate-forme Hadoop. Et comme ses concurrents Cloudera et MapR, HortonWorks a également annoncé l'intégration de l'outil d'analyse in-memory Spark à sa distribution Hadoop. Spark offre une alternative à MapReduce car il exécute les jobs dans des micro-lots avec des intervalles de cinq secondes ou moins. Soit une sorte de fusion entre le batch et le temps réel ou presque. Il fournit aussi plus de stabilité que d'autres outils de traitement temps réel, comme Storm, également greffés sur Hadoop.

Silicon Valley 2014 : HortonWorks adopte à son tour le moteur in-memory Spark

0

Réaction

Après Cloudera et MapR, HortonWorks annonce à son tour l'arrivée du moteur de traitement in-memory Spark dans sa distribution HDP 2.1.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire