Flux RSS

Cloud computing

904 documents trouvés, affichage des résultats 21 à 30.

| < Les 10 documents précédents | Les 10 documents suivants > |

(07/03/2012 16:42:45)

Intel cible les datacenters avec ses puces Xeon E5

Reposant sur la micro-architecture Sandy Bridge, les puces pour serveurs Xeon E5-2600 (bi-socket) et E5-1600 (mono-socket), incluent jusqu'à 8 coeurs et sont jusqu'à 80% plus rapides que leurs prédécesseurs, a déclaré Bernadette Andrietti, directrice d'Intel EMEA, lors d'une conférence de presse à Paris. Ces processeurs consommeraient également moitié moins d'énergie que leurs prédécesseurs, selon Intel. Les puces Xeon E5 sont cadencées à 2,9 GHz max pour le E5-2680, avec 20 Mo de cache, et un mode Turbo 2.0 autorisant une surcadence ponctuelle de 900 MHz, et 3,6 GHz pour le E5-1600 . Quatre canaux mémoire sont désormais proposés au lieu de trois précédemment pour un maximum de 768 Go en DDR3/1600. Jean-Philippe Laurent, directeur technique Intel EMEA, nous a précisé que cette puce était composée de 2,3 milliards de transistors contre 1,570 pour la génération précédente (Xeon 5600).

La dernière mise à jour majeure d'Intel sur le segment des serveurs remonte à mars 2010, quand la firme avait annoncé ses puces Xeon 5600. Le portefeuille serveur actuel d'Intel comprend des processeurs d'entrée de gamme Xeon E3 (bi-socket), basés sur l'architecture Sandy Bridge, et haut de gamme Xeon E7, reposant sur l'architecture Westmere avec un maximum de 10 coeurs.

Un lancement avec les partenaires éditeurs et constructeurs

Pour le lancement de l'E5, Intel a travaillé avec les principaux fournisseurs de logiciels et les constructeurs de serveurs habituels pour valider des innovations techniques. Le fondeur recense déjà plus de 400 modèles de serveurs reposant sur sa nouvelle puce. Bull, IBM, Hewlett-Packard, SGI et Dell sont parmi les entreprises qui lancent de nouveaux serveurs. IBM indique que sa lame bi-socket BladeCenter HS23 est jusqu'à 62% plus rapide, supporte quatre fois plus de mémoire vive et accueille 20% de machines virtuelles supplémentaires que la BladeCenter HS22. SGI présentait aussi à Paris sa lame équipée de deux puces Xeon E5-2600. Intel a également déjà fourni des puces E5 pour un supercalculateur baptisé Stampede, qui sera déployé en 2013 au Texas Advanced Computing de l'Université du Texas. Le supercalculateur devrait offrir des performances en crête de 10 petaflops (soit 10 000 milliards d'opérations par seconde). Si les processeurs E5 assumeront 20% de la charge de travail, les 80% restant seront assurés par les puces spécialisées Mic .

La croissance globale du trafic Internet met à rude épreuve les centres de calcul, et ces nouveaux processeurs serveur aideront à répondre plus rapidement aux requêtes, a déclaré Mme Andrietti. « Pour 120 tablettes ou 600 smartphones mis en service, il faut un serveur supplémentaire. En 2015, selon une de nos études réalisées fin 2011, il y aura 3,1 milliards d'utilisateurs connectés, et aujourd'hui chaque utilisateur génère 4 Go de données par jour. » Les nouveaux processeurs devraient également aider à augmenter la virtualisation de serveurs et contribuer à réduire les coûts en alimentation électrique et en refroidissement. Mais Intel ne se focalise pas uniquement sur la performance. L'entreprise se penche également sur les autres défis liés aux datacenters, à savoir l'amélioration du stockage, de réseau et la sécurité, a expliqué Mme Andrietti.

[[page]]

Le Xeon E5 intègre par exemple un contrôleur PCIe 3.0 qui double la bande passante disponible en entrée/sortie et réduit la latence de 30%, ce qui pourrait aider au déploiement de machines virtuelles et de clouds à grande échelle. Les Xeon E5-2600 processeurs sont les premiers à intégrer le bus PCI-Express 3.0 sur le processeur. La technologie PCIe 3.0 déplace des données avec un débit de 8 Gbit/s , ce qui est une amélioration considérable par rapport à la précédente génération PCI-Express 2.0, qui plafonne à 5 Gbit/s.

Cette génération de puce est également la première à permettre un accès direct à la cache du processeur sans passer par la mémoire vive (fonction Data Direct I/O). La technologie réduit le besoin de rafraîchir la DRAM en limitant les aller/retour dans la mémoire système, afin de réduire la latence et d'économiser un peu d'énergie. Cette famille de puce supporte également les instructions AVX (Advanced Vector Extension) , qui permet d'améliorer les performances des applications gourmandes en calculs, telles que l'analyse financière, la création de contenus médias, ou la recherche médicale.

Intel a également lancé un contrôleur Ethernet 10 Gigabit pour cartes mères ce qui devrait faciliter le déploiement de cette technologie dans les serveurs. La généralisation de la technologie 10 Gigabit Ethernet devrait en effet accélérer le trafic réseau dans les datacenters.

La famille de processeurs Xeon E5-2600 est composée de 17 modèles, dont les prix vont de 198 $ à 2,050 $ (pour 1000 unités). En plus de cela, trois puces Xeon E5-1600 à mono-socket seront attendues pour les serveurs et les stations de travail, à des prix allant de 284 à 1080 $.

(...)(07/03/2012 12:12:53)

Amazon baisse, encore, les prix de ses services IaaS

Depuis 6 ans, c'est la 19e fois que AWS, le leader du marché, revoit à la baisse le tarif de ses services cloud. L'impact varie en fonction de la localisation géographique et le type de service utilisé, mais les plus grandes baissent profitent aux clients qui louent des instances de calcul et de stockage réservées, rattachées aux offres Elastic Compute Cloud (EC2) et Relational Database Service (RDS) du fournisseur.

L'instance réservée permet d'acheter de la puissance de calcul supplémentaire pour une période de temps définie. L'autre alternative est la solution à la demande, qui consiste à mettre en route ou à arrêter des serveurs à la demande du client qui paie alors sur une base ponctuelle. Le tarif des instances EC2 réservées subit une baisse pouvant atteindre 37% dans certaines zones géographiques, comme l'Est des États-Unis par exemple. L'offre à la demande baisse pour sa part de 10% dans cette même région. Selon le calculateur de prix de AWS, les instances à la demande Amazon EC2 High-Memory sont facturées 0,90 dollar de l'heure sous Linux/UNIX et 1,14 dollar l'heure sous Windows. Les tarifs de l'offre d'instances réservées RDS ont été également actualisés, affichant une baisse pouvant atteindre 42%, et jusqu'à 10% pour utilisation à la demande.

Le fournisseur semble aussi faire un appel du pied à ses clients d'entreprises qui utilisent beaucoup de produits AWS. Amazon a ainsi informé ses clients qu'ils pouvaient économiser de l'argent en élargissant leur utilisation EC2. Les clients qui ont des instances réservées à hauteur de 250 000 dollars bénéficient désormais de 10% de réduction sur tout achat d'instance réservée supplémentaire. Ceux qui dépassent les 2 millions de dollars d'instances réservées bénéficient d'une remise de 20% sur leurs futurs achats d'instances réservées.

(...)(07/03/2012 09:50:30)Pulse 2012 : Tivoli veut faciliter le voyage vers le cloud

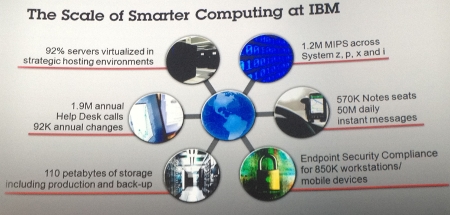

Lors de la deuxième journée de l'évènement Pulse 2012 d'IBM à Las Vegas, il a beaucoup été question de cloud. Steve Mills, senior vice-président en chrage des activités Software et Systems d'IBM était chargé de donner quelques chiffres sur la réalité du cloud chez Big Blue. 92% des serveurs ont été virtualisés, 110 Po de données ont été stockées (comprenant production et sauvegarde), gestion d'une flotte de 850 000 terminaux mobiles (PC et smartphone). Pour le dirigeant, la mise en place des outils Tivoli a eu des impacts significatifs. Ainsi sur le cloud « la gestion de la production/développement/test a réduit le temps d'allocation des ressources de 5 jours à 1 heure ». Après avoir listé les différents avantages de Tivoli, Steve Mills a expliqué qu'il était temps d'entrer dans une autre génération de systèmes, plus intégrés. « Nous avons de plus en plus de connaissances sur le cloud, il est nécessaire d'aboutir à une plus grande automatisation des processus pour garantir une meilleure visibilité et un plus grand contrôle » précise Steve Mills.

Impact des solutions Tivoli au sein d'IBM

Accélérer les déploiements

C'est dans ce cadre que Jamie Thomas, vice-présidente de la stratégie et du développement de Tivoli Software a présenté plusieurs annonces allant dans le sens d'une plus grande intégration au sein de la gamme Smartcloud foundation. Premier élément que nous avions dévoilé hier, Smartcloud desk control qui unifie plusieurs éléments de Tivoli, Service Request Manager, Change and Configuration Management Database, Asset Management for IT et Service Manager Quick Install. Autre annonce, Smartcloud provisonning qui s'inscrit dans la volonté d'automatisation le déploiement des clouds. Ce service optimise et accélère le déploiement de VM quelque soit l'hyperviseur (VMware, KVM et Microsoft). En complément, Smartcloud monitoring surveillera la disponibilité et l'utilisation des services clouds.

[[page]]

La délivrance plus rapide d'applications, de produit est aussi au centre des attentions de la firme d'Armonk avec la solution Continuous delivery, qui repose sur des bonnes pratiques en matière de gestion de cycle de développement des services clouds. Cette offre va intégrer l'expertise de Green Hat, société acquise en janvier 2012, qui donne aux développeurs les moyens de tester les applications sans avoir besoin de configurer physiquement des environnements de tests.

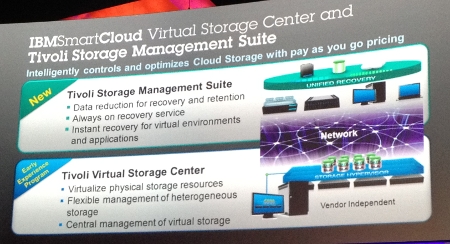

Une meilleure prise en charge du stockage et des terminaux mobiles

Le stockage n'est pas oublié avec deux solutions Tivoli Storage Management Suite qui s'adresse à la partie back-up et restauration des données. Tivoli Virtual Storage Center est un outil de virtualisation et d'administration des ressources de stockage. Ce service va entrer en concurrence avec des outils comme ceux de VMware (VSphere Storage), EMC, HDS ou Netapp. A noter que ce dernier service existe pour l'instant en version expérimentale et qu'IBM n'a pas donné de détail sur les technologies utilisées. Jamie Thomas a indiqué lors d'une table ronde, « nous nous intéressons de très prés aux évolutions du stockage, il est très important que nous soyons présents pour accompagner nos clients qui vont virtualiser leur brique de stockage ou les placer dans le cloud ».

Les offres Tivoli en matière de stockage

Cette tentation d'aller vers le cloud public à certains moments entraîne une prise en charge de la notion de cloud hybride. Les outils de management Tivoli vont prendre en compte cette dimension. Interrogé sur l'intégration de standards ouverts en matière de cloud, IBM a indiqué son implication dans le cloud standards customer council, qui regroupe 300 sociétés. Scott Hebner, vice-président marketing de l'activité Tivoli Software, a expliqué « le but de cette organisation est de donner la parole aux clients et non aux fournisseurs ou aux constructeurs ». Enfin, la mobilité a été abordée lors de la première journée et IBM a rappelé son offre de gestion des terminaux en incluant maintenant les mobiles (iPhone, iPad, Android, Windows Phone, etc.) ainsi que sa solution de déploiement d'applications mobiles via le service Worklight.

Au final, cette édition 2012 de Pulse confirme que l'infrastructure reste au coeur des grands changements de l'IT, mobilité, analytique, cloud. Son administration peut apporter des améliorations et des accompagnements sur ces différentes transformations.

Cebit 2012 : Le Brésil et la sécurité en vedette cette année

Le Cebit est inauguré cette année par la chancelière allemande Angela Merkel, la présidente brésilienne Dilma Rousseff et Eric Schmidt, le président exécutif du conseil d'administration de Google. Ce dernier viendra assurément défendre Google+, mis à mal dernièrement par une étude de comScore démontrant que les internautes ne passent en moyenne que trois minutes par mois sur ce réseau social.

De son côté, un autre acteur majeur de l'informatique viendra défendre son principal projet de l'année. Microsoft devrait en effet faire la démonstration de son système d'exploitation Windows 8, librement disponible au téléchargement en version bêta depuis le 29 février.

La sécurité informatique en vedette cette année

Cette édition sera également placée sous le signe de la sécurité, déclinée comme fil rouge à travers l'ensemble du Parc des expositions. De nombreux éditeurs viendront y présenter leurs dernières nouveautés en matière de solutions de sécurité, notamment pour les terminaux mobiles, de plus en plus vulnérables. L'un des autres thèmes abordés au Cebit sera le cloud computing.

De nombreux événements seront enfin organisés tout au long du salon sur le thème du Brésil et du développement des technologies de l'information et de la communication (TIC) en Amérique du Sud.

Le Cebit, rendez-vous incontournable des technologies de l'information, se tient depuis 1986 à Hanovre, en Allemagne. L'édition 2012 doit rassembler environ 4 200 exposants, venus de 70 pays. Selon ses organisateurs, le salon a rassemblé l'an passé 339 000 visiteurs.

Google Apps : le mécanisme de suppression de domaines toujours désactivé

Depuis le milieu du mois de janvier, les clients des Google Apps ont quelques difficultés à supprimer et à réactiver les domaines dans leurs comptes. Google a en effet désactivé depuis cette date, et de manière inattendue, le mécanisme automatisé pour réaliser ces tâches. Dès lors, les demandes de suppression et d'ajout de domaines se sont accumulées, mettant en difficulté les administrateurs des Apps qui ont du faire face à une série de problèmes divers, y compris l'impossibilité d'accéder aux comptes de messagerie de certains de leurs utilisateurs. Finalement, Google a dû mettre en place une procédure manuelle pour répondre à ces demandes, invitant les administrateurs concernés à déclarer leurs domaines dans un fil de discussion dédié sur le forum officiel Apps. Google les ajoute ensuite à une file d'attente pour les traiter manuellement.

Le 10 janvier, un officiel de Google identifié comme « Ricky » a posté un message sur le fil de discussion du forum, informant que « suite à une question connexe sur le sujet postée la semaine précédente, Google avait temporairement désactivé le mécanisme de suppression de domaines. » Celui-ci ajoutait qu'il faudrait attendre désormais deux semaines avant de pouvoir à nouveau supprimer les domaines et que Google ferait une mise à jour sur le fil dès que le mécanisme serait réactivé. Cependant, aucune mise à jour n'a encore été publiée, et le mécanisme automatisé n'est toujours pas fonctionnel.

Un mois et demi d'indisponibilité

Il y a plusieurs raisons pour lesquelles les administrateurs des Google Apps suppriment les domaines. Souvent, il s'agit pour eux de les réactiver immédiatement comme sous-domaine ou d'en faire l'alias d'un autre domaine de premier niveau. Si le processus est figé pendant des jours ou des semaines, cela peut perturber les échanges de courrier électronique et d'autres fonctions que certains employés utilisent fréquemment avec les Apps.

« Je constate que, dans un premier temps, il était question de mettre la fonction hors ligne pendant « deux semaines ». Or cela fait un mois et demi que la suppression a été désactivée. Est-ce que le problème a été résolu ? L'auto-suppression ne fonctionne toujours pas ? J'essaye de mettre place un compte Google Apps pour l'éducation et je dois vous dire que cette situation, aussi bien l'incapacité de réenregistrer un domaine précédemment supprimé, que l'impossibilité d'obtenir un quelconque soutien, ne me donne guère confiance dans le service des Google Apps, pour communiquer avec mon équipe et mes étudiants », a écrit un utilisateur identifié comme « CMcIlroy» le 27 février.

De multiples fils de discussions sur ce problème

Parallèlement à ce thread principal, de multiples fils de discussion toujours très actifs ont été ouverts dans lesquels les administrateurs des Apps évoquent le problème. Certains utilisateurs font remarquer que Google aurait pu informer les administrateurs des Apps sur la question. Ils sont notamment étonnés de voir que le problème n'a pas encore été ajouté à la liste des « Questions Connues ».

Une porte-parole de Google a déclaré que l'équipe des Apps était « tout à fait consciente des désagréments et qu'elle travaillait activement sur la question, » ajoutant « qu'elle espérait avoir résolu le problème dans quelques jours. »

(...)(23/02/2012 16:07:37)SWF : un service cloud pour automatiser les processus chez Amazon

Amazon Web Services (AWS) vient de lancer un service baptisé Simple Workflow Service (SWF) qui doit permettre aux entreprises d'automatiser leurs processus métiers, via des applications dans le cloud et sur site. « Avec SWF, les développeurs vont bénéficier d'un contrôle complet quant à la mise en oeuvre des étapes de traitement et la coordination des tâches pour les gérer, sans avoir à se soucier de la complexité sous-jacente, comme le suivi de leur déroulement et leur maintien jusqu'au dernier état, » a déclaré Amazon.

Ce service est toujours en version bêta, mais il a déjà été utilisé pour construire des applications pour le traitement d'image, l'encodage vidéo, l'infrastructure de provisionnement et la gestion des processus. Parmi les premiers utilisateurs du service, on trouve le Jet Propulsion Laboratory de la Nasa et Amazon lui-même.

Tous les flux de travail comprennent un certain nombre de tâches différentes qu'il faut coordonner. Par exemple, un système de traitement d'image comprend l'acceptation du fichier téléchargé, son stockage, son archivage, la validation du format et de la taille du fichier, et ainsi de suite, comme le détaille un article publié sur le blog d'Amazon. L'architecture sous-jacente est décomposée en collaborateurs et en décideurs. Chaque tâche est une action désignée comme collaborateur ou décideur dans SWF. Cette hiérarchie permet ensuite de coordonner les tâches. « SWF se charge de négocier les interactions entre les deux, » selon Amazon.

Un framework Java pour simplifier l'utilisation de SWF

Tout type de langage de programmation peut être utilisé pour écrire des collaborateurs et des décideurs, à condition que celui-ci soit capable de communiquer avec l'API utilisée par Amazon SWF pour son service Web. Il peut tourner dans le cloud, sur site ou dans un environnement mixte combinant les deux. Pour simplifier l'utilisation de SWF, Amazon a également créé l'AWS Flow Framework, qui fait partie du SDK AWS pour Java. De la même manière, la console AWS Management inclut le support complet pour le service SWF.

Les entreprises peuvent commencer à tester le service SWF gratuitement, et lancer jusqu'à 1 000 flux de travail et 10 000 tâches par mois et les laisser tourner l'équivalent de 30 000 workflows/jour. Amazon SWF est actuellement disponible uniquement dans l'Est des États-Unis, mais selon une FAQ sur SWF, Amazon prévoie assez rapidement de rendre son service disponible dans d'autres régions.

(...)(22/02/2012 14:08:54)Sogeti accompagne ses clients dans le cloud Windows Azure

Le cloud présente un énorme potentiel de développement pour les SSII. Sur ce terrain, « la plateforme d'évidence pour Sogeti, c'est le PaaS », expose François Merand, chargé de développer l'offre applicative Microsoft pour Sogeti France. « Et Azure est l'un de nos axes privilégiés ». La SSII a noué un partenariat très fort avec l'éditeur. Elle conçoit, développe et met en oeuvre des applications à exploiter dans le cloud. En complément, elle a bâti avec Microsoft l'offre Azure Privilege Club (APC) pour aider les clients à déterminer quels projets ils pourraient porter dans cet environnement.

Les entreprises connaissent plutôt bien le cloud dans ses versions IaaS(*), matérialisées par les datacenters de leurs partenaires, et SaaS, popularisées par des acteurs comme Salesforce.com ou Google. En revanche, le PaaS doit encore convaincre. « D'où la nécessité d'un accompagnement », explique Jason De Olivera, manager et architecte solutions senior chez Sogeti France. C'est lui qui est chargé de développer le programme APC dont l'objectif est d'accélérer la prise de décision autour du PaaS.

Il reste des freins à l'adoption du PaaS

Parmi les freins à une adoption rapide, le fait que les données soient gérées dans une infrastructure cloud située hors de France reste un problème soulevé par les RSSI (pour l'Europe, les datacenters Azure de Microsoft se trouvent en Irlande et aux Pays-Bas ; si les clients ne le spécifient pas, leurs données peuvent être gérées dans d'autres datacenters, situés aux Etats-Unis ou ailleurs). Autre remarque souvent formulée par les DSI : que faire de mes ressources techniques si l'informatique se déplace dans le cloud. Des solutions hybrides peuvent être trouvées à partir de l'existant, rappelle Jason De Olivera.

L'Azure Privilege Club propose avant tout un accompagnement et du conseil. La partie technique ne représente qu'un tiers de l'intervention qui dure environ six mois. Une phase d'évaluation (assessment) permettra d'identifier les opportunités : « Quelles données va-t-on mettre dans le cloud, comment trouver le projet éligible, quels sont ceux qui ne le sont pas tout de suite, ceux qui ne le sont pas... Et comment transformer l'entreprise pour que cela soit un succès », énumère le responsable du programme APC. Cette première phase dresse une liste des applications éligibles au cloud. Un examen plus détaillé débouche sur deux ou trois candidates au Proof of Concept. Ce peut être une refonte d'un existant ou une création de projet. Le client doit disposer en interne des ressources pour développer ces prototypes. C'est la seule vraie façon d'avoir entre les mains les éléments humains et financiers pour savoir quels projets mener et créer un guide de bonnes pratiques, souligne-t-on chez Sogeti.

Objectif : 50 clients pour APC 2012

L'initiative APC vient de démarrer sa deuxième édition. En 2011, un premier club avait regroupé une dizaine de grands clients de Sogeti dans le monde évoluant dans différents secteurs d'activité (industrie, grande distribution, éditeurs de logiciels, société de presse...). Deux entreprises françaises y figuraient, implantées dans l'énergie et la pharmacie/santé.

En 2012, la SSII aimerait rassembler une cinquantaine de clients au niveau international dont une dizaine en France. « Les Proof of Concept que l'on va faire, ce sont des projets que l'on démarre », explique François Merand en rappelant que le Time-to-market rapide est l'un des avantages du cloud. Parmi les enjeux : l'adhésion des équipes et quelquefois aussi, la transformation des modèles métiers (par exemple pour les éditeurs de logiciels qui modifie leur mode de facturation).

Un sponsor exécutif, à la direction de la DSI

Le format du club permet aux entreprises d'échanger leurs expériences autour de ces projets. Il y a par exemple dans Azure différents services prédéveloppés tels que la base de données, le service bus (fonctionnalités de connectivité sécurisées pour créer des applications distribuées et hybrides sur site et dans le cloud), ou encore le service de mise en cache pour un accès très rapide. « Cela ne fait pas sens d'utiliser tous les composants dans une application », expliquent les responsables de Sogeti. Les participants au programme Azure Privilege Club se rencontrent d'abord à Dublin, dans le datacenter de Microsoft, pour une réunion de lancement de deux jours au cours de laquelle sont évoquées les objectifs respectifs. Un nouvel échange s'opère à l'issue du projet.

« Nous travaillons au niveau de la direction de la DSI, avec un sponsor exécutif », insiste François Merand. Il faut une équipe suffisamment étoffée pour mener l'opération comme un vrai projet : un architecte et des intervenants métiers « car Azure impacte fortement le métier de l'entreprise ». Microsoft fait intervenir pour sa part ses ressources techniques, le client se voyant proposer une seule offre packagée.

(*) IaaS, infrastructure as a Service, PaaS, Platform as a Service, SaaS, Software as a Service.

Boursorama gère désormais ses services IT en SaaS

Boursorama est doté d'une DSI d'une centaine de collaborateurs pour traiter les 25 000 demandes d'interventions par an des utilisateurs. Les outils utilisés étaient insatisfaisants et la DSI a décider de faire appel au marché pour gérer les services IT de l'établissement financier en ligne.

La filiale de la Société Générale a fait un appel au marché puis a pré-sélectionné plusieurs éditeurs auxquels elle a demandé des maquettes. Sur cette base, Boursorama a choisi le SaaS proposé par EasyVista sur des critères de fonctionnalités, de simplicité d'utilisation et d'ergonomie.

L'entreprise a opté alors pour un processus itératif de mise en place de sa nouvelle gestion des services IT. Celle-ci a concerné autant la gestion des incidents que les demandes de services. Deux catalogues de services ont été créés, l'un pour le support bureautique, l'autre pour les le support fonctionnel. L'ensemble a été déployé en trois mois. Le coût du projet n'a pas été communiqué. (...)

NEC ITPS s'invite dans le cloud et les datacenters

NEC IT Platform Solutions (ITPS) est l'une des trois divisions de NEC, elle est chargée de la partie stockage, serveurs, logiciels. Les deux autres s'occupent des infrastructures télécoms (division carrier solutions) et des écrans LCD et des projecteurs (division display solutions). NEC ITPS est 100% en indirect, elle passe par trois grossistes : Avnet, Config, ETC, deux spécialistes, un pour la partie cloud stockage, l'autre pour la partie sécurité, et un généraliste.

La société dispose en France d'un nombre de revendeurs limité avec une trentaine de gold, « nous pouvons entretenir des relations humaines avec notre réseau et nous lui apportons de véritables joyaux » souligne Pascal Drouet, directeur commercial channel France de NEC ITPS. En clair, le réseau n'est peut-être pas encore très dense, mais il bénéficie d'une offre que les concurrents n'ont pas.

Parmi cette offre, une solution logicielle de virtualisation de réseau : programmable flow. La virtualisation du poste de travail existe déjà, le constructeur propose la version 4.0 de VPCC (une solution complète logicielle NEC + hyperviseur + serveur et stockage NEC). Des solutions de virtualisation basée sur OpenFlow. NEC ITPS a par ailleurs mis au point une solution de déduplication de données, elle sera lancée en milieu d'année, et cible les questions d'archivage légal avec Bâle 2.

Une solution complète en préparation pour les hôpitaux

NEC ITPS propose également des offres métiers. Pour l'éducation, il s'agit de deux suites logicielles, Eole et Edutice, liées à deux serveurs certifiés pour l'Education nationale. En matière de santé, NEC ITPS s'est focalisé sur les questions de PRA et de PCA avec une autre solution logicielle, express cluster. Lors du salon HIT au mois de mai prochain, la société présentera une solution de bout en bout pour les hôpitaux. Enfin, concernant les PME, NEC ITPS propose Flexpower, un serveur qui est aussi un mini SAN (Il a la capacité de supporter jusqu'à six modules serveur et 14 disques durs SAS 2,5'', ainsi que 2 modules Switch Ethernet). Il est déployé avec Intel.

Dernier volet et non des moindres des offres NEC ITPS destinées aux partenaires, celle concernant les datacenters. Le constructeur propose que les PME et PMI puissent héberger leurs données dans des datacenters de proximité. Le constructeur va homologuer ces centres, leur capacité d'hébergement étant revendue, en marque blanche ou en revente classique, par ses partenaires.

Microsoft réduit jusqu'à 75% le coût de SQL Azure

Les tarifs d'utilisation du service de base de données SQL Azure viennent d'être revus à la baisse par Microsoft. L'éditeur a également lancé une option pour ouvrir ce service aux clients souhaitant accéder à moins de 100 Mo. Steven Martin, directeur général, responsable de la planification pour Windows Azure, a communiqué la semaine dernière les prix révisés. Dans un billet, il indique que les utilisateurs vont bénéficier d'une économie de 48% à 75% pour les bases de données de plus de 1 Go (48% pour les bases de 5 Go tarifées 25,99 $ par mois contre 49,95 $ précédemment, 75% pour celles 25 Go, par exemple, désormais à 75,99 $ contre 299,97 $, ce qui, dans ce cas, met le Go à 3,04 $). Quant à l'option 100 Mo, elle permettra de commencer à utiliser SQL Azure pour la moitié du précédent coût, en fournissant malgré tout la totalité des fonctionnalités. Cela inclut la haute disponibilité, la tolérance aux pannes, le provisionning, l'évolutivité de la base, la connexion aux bases installées sur site et le SLA complet.

Ces deux modifications dans l'offre SQL Azure de Microsoft résultent des remarques communiquées par les utilisateurs et de l'évolution des modèles d'usages, explique Steven Martin. Au cours des dix-huit mois écoulés, deux usages se sont dégagés. En premier lieu, de nombreux projets démarrent modestement mais ils ont besoin de grossir rapidement. D'où la possibilité offerte d'accéder à des déploiements plus larges à moindre coût. « A mesure que votre base de données grossira, le prix par Go baissera de façon significative », assure le responsable de Microsoft. Deuxièmement, de nombre clients du cloud ayant des traitements plus légers veulent disposer d'une option peu coûteuse pour des usages modestes. « De la même façon que nous proposons une option de 150 Go pour les clients ayant des pré-requis élevés, nous étendons la palette de choix à l'autre bout du spectre avec une option de départ à 100 Mo », ajoute Steven Martin.

A partir de 3,54 euros par mois pour 100 Mo

La facturation de SQL Azure est calculée sur la base d'un tarif progressif, en fonction de la taille de la base de données. Cette dernière existe en deux éditions. L'édition Web prend en charge une base de données relationnelle T-SQL (Transact-SQL) de 5 Go maximum. L'édition Business va jusqu'à 150 Go. Le site Windowsazure.com/fr donne le détail de la tarification pour un paiement à l'utilisation. Une calculatrice en ligne permet de se faire immédiatement une idée du coût en fonction du nombre de Go consommé. Il existe aussi un tarif d'abonnement de six mois(*).

En déplaçant le curseur de la calculatrice, on connaît le prix du service au Go consommé, ci-dessus 120,45 euros pour 94 Go par mois.

A l'utilisation, le prix de SQL Azure, par base de données et par mois, démarre à 3,5425 euros par mois jusqu'à 100 Mo. Il s'élève à 7,085 euros entre 100 Mo et 1 Go. Entre 1 Go et 10 Go, l'utilisation de SQL Azure est facturée 7,085 euros pour le premier Go et 2,834 euros pour chaque Go supplémentaire(**). Ainsi, pour une base de données de 4,4 Go utilisée une journée, il en coûtera 0,5944 euros au client.

(*) L'abonnement de six mois à SQL Azure coûte 56,729 euros pour une unité de base, ce qui correspond en fait à une valeur de 70,92 euros sur la base de données Business Edition lorsque celle-ci est facturée à l'utilisation. Ce service s'adresse à des utilisateurs qui démarrent ou qui ont des besoins réduits en taille de base. Pour les entreprises plus consommatrices, Microsoft propose un autre abonnement, annuel cette fois, à partir de 10 000 euros, explique Julien Lesaicherre, de Microsoft France. Cela correspond à une utilisation pré-payée que l'entreprise consommera comme elle l'entend, au rythme choisi.

(**) Entre 10 Go et 50 Go, il en coûte 32,5906 euros pour les 10 premiers Go, puis 1,417 euros pour chaque Go. Enfin, au-delà, les 50 premiers Go reviennent à 89, 2699 euros, puis à 0,7085 euros pour chaque Go supplémentaire. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |