Flux RSS

Cloud computing

904 documents trouvés, affichage des résultats 541 à 550.

| < Les 10 documents précédents | Les 10 documents suivants > |

(04/11/2010 11:03:46)

Inquiétudes des entreprises sur la sécurité du cloud et du web 2.0

« Moins d'un tiers des entreprises dans le monde disposent d'un plan de gestion des risques informatiques à même de les prémunir contre les dangers liés à l'utilisation des nouvelles technologies » constate le cabinet Ernst & Young dans sa treizième étude mondiale sur la sécurité informatique, « Global Information Security Survey ». Les principaux problèmes sont liés à la croissance de l'externalisation, notamment via l'informatique en nuage (cloud computing) comme le très courant SaaS, mais aussi par les pratiques collaboratives comme les réseaux sociaux et le web 2.0. Michel Richard, associé chez Ernst & Young responsable du département sécurité des SI, attire également l'attention sur la mobilité croissante des équipes et l'insécurité inhérente aux outils et méthodes de cette mobilité (smartphone, ordinateurs portables, tablettes, connexion au SI par le web, etc.). Pour lui, il ne s'agit pas de remettre en cause l'évolution des pratiques métiers mais plutôt d'être conscient des risques et de prendre les mesures nécessaires pour s'en prémunir.

Précisons que le cabinet ne s'intéresse pas principalement à la sécurité informatique au sens technique du mot mais plus à la sécurité des données transitant dans un SI.

La sécurité parent pauvre des budgets

Les dépenses en sécurité n'augmentent en proportion du budget IT que dans la moitié des cas. Dans 6% des cas, la proportion des budgets informatiques consacrée à la sécurité est même en baisse, le solde étant constitué par des organisations aux dépenses plus ou moins stables en sécurité.

Les priorités des entreprises concernent avant tout la continuité d'activité (28% des répondants la placent en première priorité) et la « compliance » (16%), c'est à dire la conformité avec les règles tant légales que professionnelles (Bâle II, etc.). Viennent ensuite la prévention des pertes de données, la gestion des risques sur la sécurité des données, les problématiques d'identification et de sécurité d'accès...

Les efforts particuliers de cette année ne recoupent pas nécessairement les besoins immédiats. En effet, une priorité peut être déjà largement traitée et ne pas nécessiter de nouveaux investissements. Malgré tout, on constate que dans ces efforts financiers la continuité d'activité mais au même niveau que la prévention des fuites d'informations (50% des répondants vont dépenser davantage que l'année passée). Les problématiques d'identification et de sécurité d'accès sont juste derrière (48%) et suivies de la sécurisation des clouds.

[[page]]

La perte directe d'efficacité de l'organisation liée à un problème de sécurité est loin d'être la préoccupation majeure des répondants (38% sont principalement préoccupés par la perte de chiffre d'affaires directement induite). Dans 67% des réponses, c'est en effet la perte de crédibilité de l'entreprise et de ses marques qui est jugée comme la conséquence la plus dramatique d'un incident de sécurité, suivi par la perte de confiance des actionnaires (42%) et des clients (41%).

Les fuites de données dans les nuages sont redoutées

Les risques évoluent. Pour 52% des répondants, le danger qui s'accroit le plus concerne les pertes de données, loin devant la perte de visibilité sur la confidentialité et la sécurité des données (39%) et les accès non-autorisés à celles-ci (34%). Seulement 30% des organisations disposent d'un plan de sécurité informatique qui tient effectivement compte de l'évolution des risques.

Or la nature même des SI évolue. Si 55% des répondants n'envisagent pas de recourir au cloud dans les 12 prochains mois, 23% y recourent déjà et 22% travaillent sur le sujet (soit déjà planifié, soit en cours d'évaluation). Les craintes de sécurité expliquent sans doute que le cloud privé reste privilégié (54% des répondants) contre 29% pour le « vrai » cloud public et 45% qui entendent mixer les deux ou recourir à des solutions hybrides. Le SaaS reste le mode d'exploitation le plus populaire (77% des répondants), devant l'IaaS (45%) et le PaaS (34%).

Une vision moyen-terme plutôt myope

Au-delà du SI au sens strict, les nouveaux usages sont des sources d'inquiétudes mal maîtrisées, qu'il s'agisse du cloud, des réseaux sociaux ou de l'introduction des outils personnels comme les smartphones. Seules 28% des entreprises estiment disposer d'une politique de sécurité adaptée et 34% savoir ce qu'il faudrait faire, 35% n'en n'ayant pas vraiment une vision et désirant y réfléchir.

Les répondants sont curieusement fidèles aux référentiels de bonnes pratiques : 52% déclarent pratiquer ITIL, 47% ISO/IEC 27001:2005, 43% Cobit, 35% ISO/IEC 27002:2005... Malgré tout, seules 60% des organisations disposent d'un plan stratégique formel sur l'évolution de leur politique de sécurité du SI et des données dans les trois ans à venir.

ZendCon 2010 : Les développeurs PHP critiquent la surmédiatisation du cloud

Les développeurs ont pu entendre Andi Gutmans, CEO de Zend Technologies, exposer les projets de son entreprise en matière de cloud, lesquels impliquent le développement d’une plateforme PHP Zend Cloud. Au cours de sa présentation, celui-ci s’est interrogé pour se demander si le cloud amorçait un vrai changement ou si cette technologie était tout simplement une mode. Les développeurs ont donné par la suite des avis mitigés sur la question. « Je pense que dans les 10 ou 15 ans à venir, nous utiliserons tous le cloud, mais au jour d’aujourd’hui, les vendeurs font le forcing sur ce modèle, » a déclaré Phillip Winn, développeur back-end pour l’éditeur de jeux Tapulous. « Je ne vois pas de valeur dans cette technologie, » a t-il ajouté. « Et même si je n’ai pas d’opinion tranchée sur le sujet, le cloud a peu d’intérêt pour moi, et cela ne m’affecte pas. » Philipp Winn s’est souvenu de l’un de ses anciens employeurs qui pensait que cette solution pouvait servir à réduire les coûts et les effectifs. « Au final, économiquement, il s’est avéré que ce modèle n’avait aucun sens pour son entreprise, » a t-il déclaré.

Pour Chuck Hudson, également présent au ZendCon 2010 et fondateur du cabinet conseil Aduci, le cloud est devenu à la mode et bénéficie d’une promotion hors norme. « Mais il y a sûrement des choses à prendre ici, où l’on trouve des développeurs capables de développer des systèmes rapidement et des entreprises qui souhaitent réduire leurs coûts en infrastructure et en maintenance, et profiter des avantages que peut apporter le cloud, » explique-t-il. Plutôt que de considérer ce modèle comme un destructeur potentiel d'emploi, Chuck Hudson pense que, pour les informaticiens, celui-ci représente une chance d’élargir leurs horizons. « Pour les personnes en place, le Cloud doit être une opportunité d'apprendre une autre technologie et de l'appliquer en s’apparentant plutôt dans ce cas à une mise à jour des outils. » Pour Joseph Munowenyu, programmeur informatique à la Valley City State University (Dakota du Nord), le cloud est « l’espace d’où tout est dirigé. » Quant au cabinet conseil Atos Origin où travaille le développeur Chris Campbell, celui-ci n'utilise pas encore le cloud. « Nous en avons examiné la possibilité. Mais,il nous a semblé que la technologie était mise en avant par un battage médiatique visant à faire adopter le concept, » a t-il déclaré.

Critique, mais pragmatique

Après sa présentation, Andi Gutmans a reconnu que l’on pouvait être « un peu fatigué d'entendre à ce point » parler de cloud computing. « Cependant, les clients n'en sont pas moins intéressés de tirer parti de ses avantages, » a t-il ajouté. Sa plateforme Zend Cloud offrira aussi bien des services cloud portables et natifs, le contrôle des applications, la gestion du cluster, le déploiement d'applications, la gestion de la configuration et l'intégration IDE.

Attenant à la Zend Conference, les participants à la Cloud Computing & Expo Conference semblaient, comme on peut s’y attendre, plus positifs quant aux avantages du cloud. «Nous sommes vraiment intéressés par cette technologie et à l'heure actuelle, je réfléchis à la mise en place d’un projet qui utiliserait les Amazon Web Services. Celui-ci nous premettrait de mener l’ensemble de notre travail de recherche», a déclaré Jim Cannaliato, vice-président de la technologie au SAIC. Un autre participant a témoigné du fait que son entreprise investissait de manière croissante mais mesurée dans le cloud. « Nous sommes partiellement équipés, de sorte que nous ne sommes pas pleinement Cloud, mais c'est la direction que nous avons choisi, » a déclaré Sadri Behbahany, senior director des TI chez Wacom.

CA renforce son portefeuille d'outils d'automatisation

Si quatre de ces outils sont des mises à jour des solutions Automation déclinées en Workload, Virtual, Server et Client de CA, deux autres - Process et Configuration Automation - sont nouveaux. Les produits sont accessibles séparément, de manière à laisser aux entreprises la possibilité de réaliser des déploiements à la carte et à leur rythme, quitte à ajouter d'autres fonctionnalités par la suite. CA propose aussi trois formules sous forme de kits d'outils préintégrés.

A mesure que les entreprises augmentent leurs déploiements en matière de virtualisation et ajoutent des solutions cloud à leurs configurations, les équipes de management doivent affronter de nouveaux défis et les équipes informatiques sont sous pression en vue de l'automatisation des processus. « Les activités traditionnelles comme l'allocation serveur, la gestion et le suivi des performances, deviennent plus complexes dans des environnements virtualisés et de cloud, » explique Mary Johnston Turner, directrice de recherche pour les logiciels de gestion système chez IDC. « Les solutions d'allocation automatisée sont nécessaires pour aider les équipes IT à relever ces enjeux,» souligne encore Mary Turner. « La suite CA Automation vise à répondre à plusieurs de ces exigences, tout en offrant aux clients des options pour une mise en oeuvre modulaire. »

Le service Process Automation permet de rationnaliser certains processus à travers des plates-formes, des applications et des groupes. Le logiciel comprend plus de 50 types de procédures prédéfinies, dont certaines développées par CA et d'autres par des vendeurs tiers comme IBM, BMC, Microsoft et VMware. Quant à Configuration Automation, qui effectue l'inventaire de l'environnement informatique, il comprend 1 000 modèles. « L'automatisation de la configuration des systèmes informatiques peut conduire à une plus grande standardisation des services, ce qui peut en retour aider les entreprises à réduire les temps d'interruption et à mieux respecter les politiques réglementaires et de sécurité, » explique CA.

A l'unité ou en package

Le module Workload, qui contrôle la répartition des charges de travail, peut être hébergé et géré à partir de plates-formes mainframe et distribuées. Elément nouveau, il permet désormais de planifier la charge de travail dans les clouds publics de type Amazon EC2, et de gérer les flux mixtes pour les ressources virtualisées. Sur le plan des infrastructures, Virtual Automation offre la capacité, grâce à un système intégré de réservation, « d'effectuer l'attribution de serveur virtuel en libre-service et de manière automatisé, » explique l'éditeur. Les fonctionnalités incluent le support de l'hyperviseur Hyper-V de Microsoft et de VPC d'Amazon. Server Automation gère le provisionnement, l'application de correctifs et le déploiement des applications et des services à travers les systèmes physiques et virtuels, en utilisant des modèles standards. Enfin, Client Automation (anciennement connu sous le nom de IT Client Manager) automatise les tâches de gestion client, notamment les hyperviseurs de type Bare Metal, la gestion des correctifs, les migrations de Windows 7. « Les nouvelles fonctionnalités incluent la gestion VMware VDI (Virtual Desktop Infrastructure) et des options de reporting avancées, » indique CA.

Pour les plus pressés, l'éditeur propose aussi des packages de services. Par exemple, Automation Suite for Hybrid Clouds comprend les outils à destination des environnements cloud privé et public. Il se compose de trois modules - Process, Server et Virtual Automation, ainsi que du logiciel Service Catalog.

Automation Suite for Data Centers, quant à lui, est destiné aux sociétés qui doivent gérer une infrastructure physique et virtuelle intégrée et démarrent dans le cloud computing. Le bundle, connu sous le nom de CA Spectrum Automation Manager, comprend pour sa part quatre modules: Configuration, Process, Server et Virtual Automation.

Le dernier bundle d'outils pré-intégrés, CA Automation Suite for Cisco UCS, offre les mêmes modules que ceux présents sont dans le pack Data Centers mais avec en plus des outils pour la fourniture et la migration des serveurs vers la plate-forme de l'équipementier américain.

Trimestriels Microsoft : Des ventes solides sur les fondamentaux

Les ventes robustes de Windows 7, Office 2010 et des consoles Xbox 360 ont propulsé le bénéfice net de Microsoft à 5,41 milliards de dollars pour son premier trimestre fiscal de 2011, soit une augmentation de 51% par rapport à la même période un an auparavant. La société a également signalé une progression de 25% du chiffre d'affaires pour ce trimestre, à 16,20 milliards de dollars. Ce chiffre dépasse ce que de nombreux analystes avaient prévu: en s'attendant à des revenus de 15,80 milliards de dollars.

Globalement, les ventes de la suite Office ont augmenté de 15% , grâce à la version 2010 dévoilée en juin dernier. La console Xbox 360 voit ses ventes progresser de 38% et la société note également que le cycle de mise à jour des PC vers Windows 7 continue à soutenir la commercialisation de ce dernier. « Nous constatons une amélioration de la demande des entreprises reflétant leur intérêt sur Windows 7, Office 2010, et nos produits serveur et base de données", a déclaré Kevin Turner, du DG de Microsoft, dans un communiqué.

Cloud et tablette

La bonne performance de ce trimestre est en contraste avec la méfiance accrue des investisseurs qui critique la stratégie de Microsoft de ne pas s'impliquer dans les technologies en dehors des ordinateurs personnels, comme les smartphones et les tablettes. Lors de la conférence Professional Developers cette semaine à Seattle, Steve Ballmer a exprimé son enthousiasme pour le les efforts menés autour des smartphones. Peter Klein, le directeur financier de la firme de Redmond, croit beaucoup dans les services de cloud computing comme une source importante de croissance, citant un récent contrat gagné avec l'Etat de New York. « Ces victoires dans le cloud nous ouvrent de grands potentiels économiques. Dans de nombreux cas, il s'agit de nouveaux clients », a déclaré Peter Klein. Il a également noté que les réservations pour Azure ont augmenté de 40 % rapport au trimestre précédent.

L'intégration de windows pour les tablettes peut se révéler un autre domaine de croissance pour l'entreprise. «Nous sommes convaincus que ces terminaux élargiront le marché des PC et nous sommes enthousiastes quant à notre possibilité de mettre notre OS sur des facteurs de formes supplémentaire » précise le responsable financier. Par contre, il ne pense pas que les ventes de tablettes cannibaliseront celles de PC. Il prévoit aussi que le marché entreprise continuera à être un moteur pour le reste de l'exercice fiscal. « Nous nous attendons à ce que les achats de PC et de serveurs de rester une grande priorité pour la plupart des entreprises » conclut-il.

PDC 2010 : Windows Azure ressemble un peu plus à Amazon EC2

C'est une avancée notable que Microsoft propose sur sa plateforme de cloud Windows Azure en permettant d'y installer des machines virtuelles Windows Server. Cela rend théoriquement possible le portage vers cet environnement d'applications exploitées en interne et sur d'autres datacenters. Microsoft élargit donc sa palette de services dans le cloud face à un concurrent tel qu'Amazon qui propose depuis l'origine des services d'infrastructure avec sa plateforme EC2 (Elastic Compute Cloud).

Steve Ballmer (photo ci-dessus), PDG de l'éditeur, vient d'en faire l'annonce sur sa conférence développeurs PDC qui a démarré hier sur le campus de Redmond, où se trouve le siège social du groupe américain. Parmi les fonctions ainsi apportées figurent Azure Virtual Machine Role et Server Application Virtualization. Le premier outil permet de faire tourner une machine virtuelle de Windows Server 2008 R2 sur Azure et de faciliter ainsi aux développeurs les processus de migration vers le cloud. Une version bêta publique du produit sera disponible d'ici la fin de l'année. L'autre solution servira à transférer des images d'application vers Azure et à faciliter la migration sans exiger de réécriture ni les associer à une machine virtuelle. On peut créer une image virtuelle d'un serveur physique et la transférer sur Windows Azure, explique Bernard Ourghanlian, directeur technique de Microsoft France. Cette possibilité est pour l'instant limitée à Windows Server 2008 R2, mais il n'est pas exclu que d'autres versions de Windows soient ensuite supportées, en remontant jusqu'à Windows Server 2003. En revanche, il n'est pas envisagé de supporter d'autres systèmes d'exploitation tel qu'Amazon le fait sur EC2 avec Linux et Solaris.

A partir de 0,05 dollar de l'heure

Une fois que l'application est déployée sur Azure, les clients disposent automatiquement des capacités d'administration de la plateforme de cloud, ce qui inclut la configuration automatique et la gestion de l'OS utilisé. Server Application Virtualization pour Azure sera livré sous la forme d'une version CTP (community technology preview) avant fin 2010 et la version finale arrivera au deuxième semestre 2011.

Avec la prochaine version de System Center, qui devrait sortir avant fin 2011, on pourra administrer de façon centralisée les machines virtuelles sur des serveurs locaux et celles fonctionnant sur Azure.

Les développeurs peuvent désormais choisir entre cinq tailles d'instances de machine virtuelle pour faire tourner leur application en fonction des ressources requises. Microsoft vient en effet d'ajouter à sa tarification l'instance Extra Small, facturée à 5 cents de dollar l'heure. A ce prix, on dispose d'un processeur à 1 GHz, de768 Mo de mémoire et de 20 Go de capacités de stockage. Un tarif attractif pour ceux qui veulent pouvoir tester de petites applications dans le cloud. L'instance la plus robuste (Extra Large) permet de disposer de huit processeurs à 1,6 GHz, de 14 Go de mémoire, de 2 Go de stockage pour 0,96 dollar de l'heure. Les performances d'entrée/sortie diffèrent sensiblement : faible pour l'offre Extra Small, élevée pour l'Extra Large.

De son côté, Amazon va proposer un accès gratuit à EC2 à partir de la semaine prochaine.

Microsoft voit une convergence des offres cloud, Amazon non

En juin dernier, Microsoft avait promis qu'il offrirait la capacité d'exploiter des machines virtuelles, proposant ainsi des services se rapprochant de ceux d'Amazon, ce dernier permettant d'exploiter sur EC2 différentes machines virtuelles sous Windows et Linux.

Sur le marché du cloud computing, on distingue actuellement, d'une part, les fournisseurs de services d'infrastructure (IaaS) comme Amazon qui propose avec EC2 un accès « brut » aux instances de machines virtuelles. On trouve d'autre part des plateformes comme Azure qui offrent des outils aux développeurs mais donnent un accès moindre à l'infrastructure sous-jacente. Selon Microsoft, ces deux types d'environnement vont commencer à se ressembler et l'annonce de machines virtuelles Windows Server sur Azure est l'une des étapes qui y conduit. Pourtant, Amazon a prévenu qu'il ne prévoyait pas d'évoluer vers les environnements PaaS, en avançant comme raison le fait que ses clients lui ont clairement indiqué qu'ils voulaient continuer à bâtir leurs applications sans se voir imposer de modèle de programmation, de langage ou de systèmes d'exploitation, quels qu'ils soient.

Microsoft a également lancé AppFabric Composition Model pour Azure, un jeu d'extensions au framework .Net pour écrire des applications qui puissent être exploitées de façon cohérente entre l'environnement Azure et les plateformes Windows Server.

[[page]]

Sur sa conférence PDC, l'éditeur a par ailleurs annoncé l'ouverture de la place de marché Windows Azure DataMarket (ancien projet Dallas) qui propose, sous forme de services, l'accès à des contenus et à des données. Les développeurs pourront se servir des interfaces de programmation (API) OData exposées par DataMarket pour exploiter dans des applications les données mises à disposition sur la place de marché.

La place de marché DataMarket

Dans les entreprises, les utilisateurs intervenant sur des applications décisionnelles pourront combiner l'exploitation d'Excel et d'un outil comme PowerPivot avec l'accès à DataMarket et associer les données de l'entreprise avec des bases de données statistiques (professionnelles, industrielles, démographiques, etc.).

Illustration d'ouverture : Steve Ballmer, PDG de Microsoft, le 28 octobre à l'ouverture de la conférence développeurs PDC, sur le campus de Redmond (crédit photo : vidéo Microsoft)

Conférence LMI/CIO : Innovations et défis 2011 de la DSI

Des compagnies d'assurances mobilisent la géo-localisation et le dialogue de machine à machine (M2M) pour créer des formules inédites d'assurance automobile. Les distributeurs d'eau ou d'électricité s'appuient sur les smart grid et les compteurs intelligents afin d'instaurer des usages et des modèles de tarification qui rentabiliseront mieux leurs réseaux.

Pour se renouveler, l'entreprise doit non seulement identifier ces nouvelles approches, mais aussi améliorer sa capacité à les mettre en oeuvre rapidement et efficacement. En première ligne, la DSI constitue le levier d'action de la direction générale et des métiers. Pour assumer ses responsabilités, elle sera amenée à opter pour de nouveaux modes de fonctionnement et à repenser ses relations avec les métiers.

La DSI doit délivrer rapidement les ressources et les applicatifs demandés avec la qualité de service attendue. Elle peut s'appuyer sur des offres packagées récentes telles que le SaaS ou le cloud computing accompagnées de nouvelles approches comme les méthodes agiles ou l'optimisation par le Lean. Sans oublier de tirer le meilleur parti de la convergence entre les réseaux informatiques, le stockage et la téléphonie - fixe et mobile -, la vidéoconférence en mode téléprésence tout en s'arcboutant sur des serveurs surpuissants au nombre de coeurs démultiplié qui devront être exploités au mieux par les applications critiques.

Venez discuter avec vos pairs le 23 novembre prochain

Pour discuter de ces thèmes, nous vous invitons à une matinée sur l'innovation et les défis de la DSI le mardi 23 novembre au pavillon Dauphine à Paris dans le 16e arrondissement.

Vous pourrez ainsi réfléchir aux avantages de la « Blue Ocean Strategy », aux moyens de transformer l'innovation IT en atout concurrentiel et de cultivez l'innovation IT avec des experts comme Jean-François Caenen, directeur de l'innovation chez Capgemini, des témoignages de DSI et des tables rondes avec notamment : Christophe Bardet, directeur central marketing & développement de MMA, Patrick Hereng, DSI du groupe Total, Eric Legal, directeur d'Issy Media, Jean-Claude Saussaye, DSI de MMA, et Frédéric Tapissier, responsable études et développements à la direction des réseaux, de l'innovation et des nouvelles technologies de TF1.

Pour découvrir le programme détaillé et vous inscrire à cette conférence organisée par Le Monde Informatique et CIO cliquer sur ce lien.

(...)(28/10/2010 17:37:47)Trimestriels SAP : Licences et maintenance progressent de 9% en France

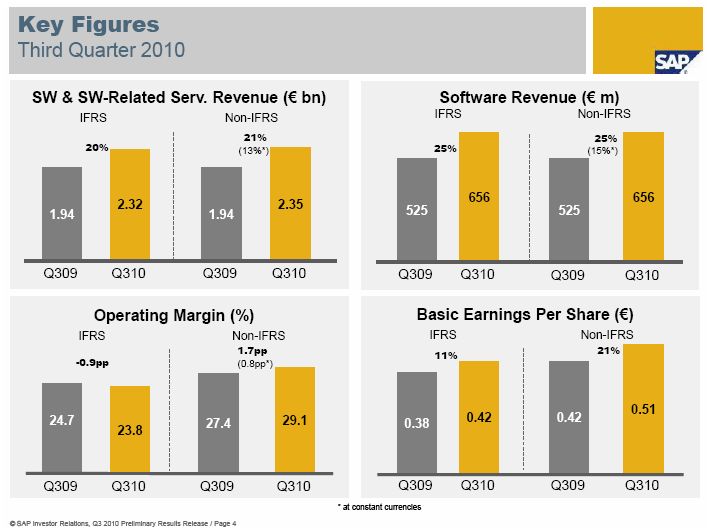

Si SAP peut se targuer d'une progression de presque 20% sur le chiffre d'affaires de son troisième trimestre fiscal, à 3 milliards d'euros, il le doit en partie à l'intégration de Sybase. Si l'on retranche les ventes de l'éditeur américain (définitivement acquis le 26 juillet dernier), le groupe allemand, fournisseur de solutions de gestion et de BI, se contente d'une croissance de 15%, à taux de change constant par rapport à l'an dernier. A taux de change courant, l'augmentation se limite à 7%. Sur les neuf premiers mois de l'année, le chiffre d'affaires licences et maintenance a progressé de 16% à 6,52 milliards de dollars, et les ventes de licences seules ont augmenté de 18% à 1,76 Md$. Sur l'année, SAP maintient ses prévisions de croissance globale : entre +6 et +8% par rapport à 2009, hors Sybase.

Cliquer ici pour agrandir l'image

Entre juillet et septembre 2010, les ventes de licences de SAP se sont élevées à 656 millions d'euros, soit une hausse de 25% par rapport au troisième trimestre 2009, mais là aussi, en incluant les ventes de Sybase. En ajoutant à ces revenus ceux de la maintenance, SAP atteint 2,31 milliards d'euros (+20%, à taux de change constant). Les meilleurs résultats ont été obtenus sur les pays qui connaissent un développement rapide, sur lesquels le chiffre d'affaires a grimpé de 41% sur les revenus issus des licences et de la maintenance. Les produits traditionnels (installés sur site) y sont prisés, les offres décisionnelles aussi. Aux Etats-Unis, les résultats sont également satisfaisants : +27%. En Europe, la progression se borne à 13%.

SAP France poursuit le recrutement de partenaires

Sur l'Hexagone, la croissance a atteint 9% sur les revenus de licences et de maintenance, avec des résultats disparates en fonction des segments de marché propres à SAP. Sur ses grands comptes IBS (Industry Business Solutions), la filiale française affiche +33% sur les ventes de licences trimestrielles, sur tous les secteurs d'activité. Sur ses quatorze plus gros clients en revanche (Primary Channel Network), calme plat. « Le secteur public est celui qui a le mieux fonctionné », a précisé ce matin à Paris Nicolas Sekkaki, directeur de la filiale française, lors d'un point presse. Il a évoqué le projet Chorus qui, en dépit des problèmes rencontrés, va passer de 14 000 utilisateurs à 25 000 d'ici janvier.

Illustration : Nicolas Sekkaki, PDG de SAP France (crédit photo : D.R.)

[[page]]

Sur les PME (moins de 500 M€ de CA), la filiale française enregistre une légère décroissance sur le trimestre avec, là aussi, des disparités. Les ventes du progiciel BusinessOne, qui vise les plus petites entreprises, ont déjà bouclé leur plan de croissance annuel. Elles ont crû de 40% sur le trimestre. En revanche, sur les structures de 300 à 500 M€, SAP subit toujours un déficit d'image. Pour faire croître son marché PME, où le succès tarde toujours contrairement aux autres pays, la filiale française poursuit activement son recrutement de partenaires. Elle veut étoffer son réseau, à la fois par segments industriels et par zones géographiques. D'ici à 2012, SAP France aimerait réaliser 75% de ventes en indirect vers les PME. Depuis janvier, elle a déjà progressé de 12% pour atteindre 50%. « Nous devons avoir un écosystème de partenaires plus dense. Déjà, nous disposons d'un meilleur maillage », estime Nicolas Sekkaki.

SAP vise 1 milliard d'utilisateurs d'ici 2015

Si l'éditeur allemand a globalement vu ses ventes progresser sur son troisième trimestre, en revanche, sa marge opérationnelle IFRS s'est rétractée (le cours de son action a baissé à l'annonce de ses résultats). Sur la période, la marge a représenté 23,8% du chiffre d'affaires contre 24,7% l'an dernier à même époque. Les perspectives semblent meilleures pour le quatrième trimestre puisque SAP prévoit une marge opérationnelle située entre 30 et 31% (à taux de change constant) sur l'ensemble de l'exercice.

Et d'ici à 2015, l'éditeur ne craint pas d'afficher d'ambitieux objectifs : 35% de marge opérationnelle, un chiffre d'affaires de 20 milliards d'euros (contre quelque 11 Md€ actuellement) et un milliard d'utilisateurs (excusez du peu), contre 35 millions aujourd'hui. Des chiffres relayés par le directeur général de SAP France. « Derrière cette ambition, il y a une philosophie, a-t-il expliqué. Il s'agit d'abord d'apporter de l'innovation et de la valeur ajoutée plus vite et sans rupture pour l'entreprise. SAP dépense 14,5% de son chiffre d'affaires en R&D et pourtant, nous ne figurons pas dans le palmarès des entreprises les plus innovantes », déplore le dirigeant français. Il faut être capable de déployer un projet de CRM en trois mois, sans devoir tout modifier, donne-t-il en exemple. Sur ce terrain, SAP va notamment proposer ses applications « On-Demand », la première ayant été livrée cet été. D'ici cinq ans, 10% du chiffre d'affaires de l'éditeur devrait se faire sur les applications en ligne (l'offre Business ByDesign* et les solutions On-Demand).

Des AppStores pour accéder à l'innovation simplement

« Nous voulons également transformer l'interface utilisateur en expérience client », a ajouté le dirigeant français en explicitant : « il faut que les utilisateurs reconnaissent l'univers SAP et qu'ils aient envie d'y revenir. Nous devons donc définir ce qu'ils attendent et le développer. » Sur ce sujet, SAP aurait beaucoup appris de Sybase. Nicolas Sekkaki rappelle aussi le passage aux méthodes de développement agile (Scrum en particulier), qui se généralise depuis l'intégration des équipes de Business Objects qui les exploitent de longue date. « Nous voulons que les nouvelles applications puissent s'intégrer facilement dans l'univers du client », poursuit le dirigeant en faisant référence à la version 7.3 de la plateforme d'intégration Netweaver, actuellement en bêta.

Pas plus qu'à Ray Ozzie, ex-Microsoft, il n'a échappé à SAP que le marché des utilisateurs était désormais en avance sur celui des entreprises. « Nous avons appris que la consommation des applications et des données était plus importante [que les applications elles-mêmes], a admis ce matin Nicolas Sekkaki en évoquant la mise en place d'« AppStores » pour accéder à l'innovation très simplement. « Il faut penser d'abord à l'usage ». Mais le dire ne suffit pas. Encore faut-il aussi s'employer à changer l'image de SAP dans l'esprit des utilisateurs potentiels. Le groupe travaille sur le positionnement de sa marque. Dans la campagne de publicité qui va démarrer sur quatre pays (Chine, Allemagne, Etats-Unis, Brésil), il a mis ses clients à contribution pour convaincre le marché de la facilité d'accès à ses logiciels.

(*) En France, pour l'instant, la filiale compte 21 clients sur le progiciel de gestion dans le cloud, Business ByDesign. Aucun n'est encore passé en version 2.5. (...)

Intel présente sa vision du Cloud pour 2015

Intel a exposé la manière dont elle envisageait faire évoluer le cloud computing à l'horizon 2015, notamment comment améliorer son interopérabilité, le rendre plus sûr et plus simple, en mettant aussi à contribution de grandes entreprises et des fournisseurs de logiciels et de matériels. Pour l'occasion, le géant du processeur a également annoncé le lancement de l'Open Data Center Alliance (ODCA), une coalition de grandes entreprises, qui doit jeter les bases matérielles et dessiner les futurs besoins en logiciels à même de répondre aux exigences d'ouverture et d'interopérabilité souhaitées pour les centres de calcul de demain. Intel a également dévoilé son propre programme Cloud Builders, qu'elle compte engager avec une vingtaine de développeurs de matériel et de logiciels de premier plan au niveau mondial, lequel concentrera les ressources nécessaires pour stimuler l'innovation et faire en sorte que les clouds soient plus faciles à déployer, à utiliser et à partager.

L'ODCA se compose de 70 entreprises de premier plan qui, ensemble, dépensent plus de 50 milliards de dollars en IT chaque année et ont déjà des projets de cloud en cours. Parmi les membres, on trouve BMW, China Life, la Deutsche Bank, JP Morgan Chase, Lockheed Martin, Marriott International, Shell, Terremark, USB et la National Australia Bank. Selon Mario Mueller, vice-président de BMW pour l'infrastructure informatique, l'ODCA représente «le premier consortium mondial réunissant des responsables informatiques avec pour objectif de définir ensemble des normes pour les datacenters d'aujourd'hui et de demain. » Cinq groupes de travail ont été désignés pour réaliser un rapport sur les infrastructures, la gestion, la sécurité, les services, la gouvernance et l'écosystème, qu'ils présenteront devant un comité technique. Intel, à l'origine du projet, agira à titre de conseiller technique au sein du comité directeur de l'ODCA.

Un rôle de conseiller pour Intel

L'Alliance a publié la version 0.5 de sa feuille de route aujourd'hui, diffusée sur une série de webcasts, publics ou réservés à ses membres, pour suivre son avancée jusqu'à la feuille de route 1.0 qui sera dévoilée au cours du premier trimestre 2011. « Compte tenu de son histoire, Intel est parfaitement à sa place dans ce rôle, » a déclaré Mario Mueller. Quand à Boyd Davis, vice-président d'Intel Architecture Group, celui-ci a déclaré qu'Intel serait guidée et stimulée par les programmes de l'Alliance. «C'est à nous de répondre aux exigences de la feuille de route de l'ODCA, » a-t-il déclaré lors d'une conférence de presse donnée à Genève. « Ce sont les entreprises impliquées qui ont demandé à Intel d'apporter son expertise et sa vision. Nous avons contribué à faire naître ce projet, mais notre rôle principal sera de rendre son organisation efficace. Nous ne disposons pas de droit de vote et nous n'avons aucun contrôle sur ce que produira le groupe. Au contraire, la feuille de route pourrait nous mettre face à des défis considérables, et leur ordre du jour pourrait orienter vers des produits qui ne trouveront pas forcément leur place dans le portefeuille d'Intel. Nous sommes fiers de ce rôle, à l'image de notre histoire, mais l'ODCA est un groupe très ouvert d'esprit et notre rôle ne nous donne aucun avantage particulier. Nous examinerons les exigences de l'ODCA et travaillerons à pousser l'Intel Cloud Builders vers ces objectifs. »

Travailler sur la meilleure plate-forme cloud

Boyds Davis a annoncé un élargissement important du programme Cloud Builders, avec la livraison d'une vingtaine d'architectures de référence, les premières, par des fournisseurs de technologie comme Cisco, Citrix, Dell, EMC, HP, IBM, Microsoft, NetApp et VMware. « Notre objectif est d'unifier l'ensemble des attributions du cloud computing. C'est le bon moment pour l'Alliance de montrer le chemin afin de donner une orientation claire au cloud. Le programme Cloud Builders souhaite inciter les clients qui utilisent la technologie d'Intel d'agir à un niveau supérieur. Pendant des années, nous nous sommes employés à définir quel était le meilleur PC, quels étaient les meilleurs serveurs, pour profiter de nos solutions. Le programme Cloud Builders élargit un peu plus notre champ : nous sommes maintenant un élément parmi ceux impliqués dans les solutions tournant dans les datacenters. Les clients peuvent désormais déployer en toute confiance ces architectures en ayant le choix parmi les solutions proposées par plusieurs vendeurs différents».

(...)(27/10/2010 16:40:46)Hyper-V de Microsoft accompagne le développement d'OpenStack

« Cette association répond à la fois à la transformation de la plate-forme Hyper-V vers la prise en charge des environnements Open Source, mais aussi aux évolutions des clouds » souligne Alfonso Castro, directeur de la nouvelle stratégie Interopérabilité de Microsoft France. Concrètement, l'éditeur fournira des conseils techniques et d'architecture à Cloud.com. De son côté, Cloud.com développera le code supportant OpenStack sur Windows Server 2008 R2 Hyper-V. Le code du projet sera finalement enregistré dans l'annuaire de code public http://openstack.org. Pour autant précise Alfonso Castro, « il s'agit d'un transfert de technologie, nous mettons à disposition des ressources humaines et techniques, mais en aucun cas nous ne délivrons le code source de notre produit ».

Sur le plan des hyperviseurs, OpenStack est déjà compatible avec Xen, KVM et QEMU.

OpenStack a annoncé la semaine dernière les premiers éléments de ses travaux qui prendront leur essor en 2011. Ce projet est soutenu par de nombreux industriels, dont la NASA qui apporte son savoir-faire sur plusieurs briques technologiques. Cette dernière a rappelé d'ailleurs récemment que son objectif était d'améliorer la conquête spatiale et non devenir un fournisseur de cloud.

| < Les 10 documents précédents | Les 10 documents suivants > |