Flux RSS

HPC

138 documents trouvés, affichage des résultats 31 à 40.

| < Les 10 documents précédents | Les 10 documents suivants > |

(07/10/2011 10:18:01)

OpenWorld 2011 : Oracle affiche ses ambitions face à IBM, VMware et EMC

Les premiers jours de la conférence d'Oracle sont tout en contraste. D'un côté un enthousiasme débordant au sujet de ses machines surpuissantes Exadata, Exalogic, Exalytics. De l'autre, une extrême discrétion au sujet de ses solutions logicielles, les très attendues applications Fusion ayant été programmées pour la fin de la semaine.

S'agissant donc de hardware, John Fowler, ancien de Sun et aujourd'hui responsable de l'activité "systems" chez Oracle, est revenu mardi sur les performances du SPARC T4 supercluster présenté il y a quelques jours. A l'opposé des systèmes spécialisés (Exadata, Exalogic, Exalytics), le cluster est une solution "généraliste" destinée à faire tourner tout type d'application. Oracle cherche explicitement à le positionner comme un concurrent des systèmes Power 7 d'IBM. Fowler les comparant à plusieurs reprises pour souligner la supériorité du système d'Oracle au niveau de la performance et du prix.

Les prétentions d'Oracle ne se limitent cependant pas aux systèmes ultrapuissants, la société ayant l'ambition d'offrir les meilleures performances à chaque échelon du stack, avec un concurrent désigné à chaque étage. Au niveau de la couche de virtualisation, John Fowler a ainsi affirmé que la solution Oracle VM est plus extensible et plus économique que celle de VMware. Côté stockage, c'est EMC qui a fait les frais de la comparaison, le système Pillar Axiom 600 étant quatre fois plus extensible et deux fois plus efficace que l'équivalent d'EMC, selon les dires du cadre d'Oracle. Une comparaison pour le moins étonnante un jour après l'intervention en "guest star" du CEO d'EMC Joe Tucci sur la scène d'Oracle Open World.

Crédit photo : Rodolphe Keller

Entretien Yukihiro Matsumoto : « nous travaillons pour adapter Ruby aux terminaux mobiles »

Le langage Open Source Ruby a été créé par le développeur Yukihiro « Matz » Matsumoto en 1995. Aujourd'hui devenu un classique parmi les langages de programmation, il est utilisé par des sociétés comme SalesForce.com, Twitter et sert de base pour le framework d'applications Web, Ruby on Rail. Pour élaborer Ruby, Yukihiro Matsuomoto a combiné plusieurs langages tels que Perl, Smalltalk, Eiffel, Ada et Lisp.

Dans une interview à nos confrères de InfoWorld.com, le fondateur explique son intention d'augmenter la présence de Ruby sur les plate-formes mobiles et donne des détails sur l'histoire du langage.

Pourquoi avez-vous inventé Ruby?

J'ai commencé à développer à l'âge de 15 ans et j'ai toujours été intéressé par les langages de programmation en général. Je me suis spécialisé en informatique pour les étudier. Après cela, je voulais créer mon propre langage de programmation. Au début, c'était surtout conçu comme un langage de script. En 1995, beaucoup de personnes estimaient que la programmation orientée objet était trop compliquée pour faire du script. Mais je voulais vraiment que mon langage soit orienté objet.

Pour lire la suite, cliquer ici

IBM brille sur le marché des serveurs au second trimestre

Alors que le marché mondial du PC n'a affiché qu'une croissance molle (+2,3%) au second trimestre 2011, celui des serveurs a fait montre d'une santé insolente. Entre avril et juin derniers, sa hausse en valeur s'est élevée à 17,9%, à période comparée de 2010, pour un chiffre d'affaires 13,2 Md$. Le nombre d'unités livrées dans le monde est monté à 2,1 millions, soit 8,5% de mieux qu'en 2010. Pour mettre en exergue cette performance, IDC, qui publie ces statistiques, indique qu'il s'agit des plus importants volumes trimestriels jamais dégagés par le marché des serveurs toutes années confondues. Les revenus qui en découlent sont quant à eux les plus hauts depuis trois ans.

Tous les segments de produits progressent

Ce tableau idyllique est renforcé par le fait que tous les segments de produits ont contribué, pour le troisième trimestre consécutif, à la croissance globale du marché des serveurs au second trimestre. Les ventes de plates-formes d'entrée de gamme se sont ainsi appréciées de 16,6% en valeur, celles de systèmes de milieu de gamme de 16,7% et celles des serveurs haut de gamme de 22,8%.

Analysée par type de processeurs, la croissance est là aussi à tous les rendez-vous. De fait, les systèmes à base de processeurs X86 ont vu leur ventes atteindre 8,4 Md$ (+15,1) pour 1,9 millions serveurs livrés (+5,4%). En parallèle, le marché des serveurs non-X86 (processeurs RISC, EPIC, CISC) a cru de 23,3% à 4,8 Md$.

En revanche, on constate une plus forte disparité de la hausse des ventes en fonction des systèmes d'exploitation embarqués, même si, là encore, la croissance est partout : +1,5% à 2,9 Md$ pour les serveurs Unix, +12,4% à 5,9 Md$ pour les serveurs Windows, +47,5% à 2,7 Md$ pour les serveurs Linux.

Le dernier angle de vue qui peut-être encore choisi pour analyser le marché des serveurs est celui des facteurs de forme et plus particulièrement celui des serveurs lames. Ce format représente désormais 15,2% (soit 2 Md$, en hausse de 26,9%) des revenus totaux issus des ventes de serveurs au deuxième trimestre et 21,2% du chiffre d'affaires des ventes de plates-formes X86.

IBM détrône HP

Premier fabricant de serveurs lames dans le monde, HP a en revanche perdu sa place de numéro un toutes catégories confondues au second trimestre. La croissance de ses ventes de serveurs n'ayant atteint que 9,3%, sa part de marché a reculé à 29,8%. De quoi permettre à IBM de se hisser sur la première marche du podium avec des ventes en hausse de 24,5%, aboutissant à une part de marché de 30,5%. Un chiffre atteint grâce à une augmentation des ventes de mainframes. "Ces chiffres étaient en fait légèrement mieux que ce qu'on attend ", a déclaré Jed Scaramella, analyste chez IDC. Toujours en troisième et quatrième position, Dell et Oracle n'ont toutefois par réussi à maintenir leurs parts de marché respectives qui reculent légèrement faute d'une croissance forte de leur vente. Cinquième du classement, Fujitsu enregistre de son côté des ventes en valeur en hausse de 133,6% pour une part de marché multipliée par deux à 6,5%.

Supercalculateur pétaflopique Blue Waters : IBM et le NCSA arrêtent le projet

Du fait de problèmes complexes imprévus et d'un coût trop élevé, IBM et le National Center for Supercomputing Applications (NCSA) de l'Université de l'Illinois ont décidé, d'un commun accord, d'abandonner leur projet de construire un supercalculateur pétaflopique pour les États-Unis.

C'est en 2008 qu'IBM avait démarré un contrat nommé « Blue Waters » pour développer un supercalculateur sur quatre ans. Ce projet de 208 millions de dollars est arrivé à son terme le 6 août dernier. IBM devait livrer la première version du système autour de l'année prochaine. Mais la technologie innovante finalement développée par le constructeur était beaucoup plus complexe que prévue et nécessitait un soutien financier et technique très conséquent, au-delà de ce que Big Blue avait initialement prévu, ont expliqué les deux partenaires dans une déclaration commune. « Le NCSA et IBM ont cherché ensemble plusieurs solutions pour maintenir la participation d'IBM dans le projet, mais n'ont pas réussi à trouver un terrain d'entente, satisfaisant pour chacun, sur la voie à suivre. »

IBM rend les sommes reçues et NCSA le matériel

La firme dirigée par Sam Palmisano va restituer l'argent reçu à ce jour pour le projet et le NCSA va rendre le matériel à IBM. Mais les deux parties ont promis de travailler ensemble sur de futurs projets pétaflopiques. « C'est rare d'entendre dire que les montants allouée pour un projet sont restitués, surtout dans le cas de contrats gouvernementaux », a déclaré Rick Doherty, directeur de Envisioneering Group, une société de recherche en marketing et d'évaluation dans le domaine des technologies.

Financé par la National Science Foundation et l'Université de l'Illinois, le projet Blue Waters avait pour but de construire super-ordinateur sur la base d'un processeur Power7 capable de réaliser 10 puissance 15 (un million de milliards) d'opérations à virgule flottante par seconde, soit un petaflop. S'il avait été achevé, il se serait placé dans les premiers au classement semestriel Top 500 des supercalculateurs les plus puissants au monde. Le NCSA pensait offrir aux chercheurs la possibilité d'utiliser son supercalculateur pour effectuer des simulations complexes, des modélisations ou encore pour mener des travaux très gourmands en calcul pour la physique, les sciences des matériaux, la météorologie, la biologie et d'autres domaines encore.

Un abandon qui n'est pas si surprenant

Pour certains, l'abandon du contrat n'est pas tout à fait surprenant. « IBM a engagé beaucoup de ressources dans le projet », a affirmé Rick Doherty. Big Blue, qui a fourni des logiciels, du matériel et du personnel pour mener à bien le projet, escomptait récupérer une partie de son investissement en vendant des technologies qu'elle développait pour le programme. Finalement, sa stratégie s'est avérée trop onéreuse. « Ce n'était pas un choix rentable pour IBM », a estimé le directeur d'Envisioneering Group.

L'autre défi auquel IBM et le NCSA ont peut-être également été confronté, c'est de devoir faire face à un paysage technologique en permanente évolution. « Le domaine pétaflopique et les 'big data' aujourd'hui, c'est un peu l'équivalent de la recherche sur les voyages spatiaux il y a 40 ans, inconnu et sauvage », a expliqué Rick Doherty. Au cours des quatre dernières années, « les performances techniques ont explosé », jusqu'à parvenir à faire passer la puissance de calcul à l'échelle du pétaoctet, « avec l'utilisation de GPU (processeurs graphiques) à faible énergie », a ajouté Rick Doherty. « Le programme Blue Waters nécessitait sans doute d'être redéfini pour mettre à profit ces nouvelles évolutions ». Mais ces adaptations ont fait « grimper le coût de réalisation au-delà de ce que IBM pouvait supporter », estime-t-il. IBM n'a pas souhaité s'exprimer à ce sujet en dehors du cadre de la déclaration faite conjointement avec le NCSA.

Illustration : projet Blue Waters (crédit : NCSA)

Teratec 2011 : Le HPC bientôt partagé entre CPU, GPU et MIC

Dans une ambiance surchauffée - la grande salle non climatisée était un vrai four - éditeurs, constructeurs, fondeurs, centres de recherche et intégrateurs ont pu présenter et discuter de leurs solutions dédiées au HPC lors du forum Teratec 2011. Et même si le représentant du gouvernement à une nouvelle fois fait faux bond - attendu le 28 juin à 17h, Éric Besson, ministre de l'Industrie a simplement envoyé une vidéo tout comme Christine Lagarde en 2010. Dans ce message enregistré, le ministre a souligné les atouts de la France dans le calcul intensif et rappelé la nécessité d'encourager les coopérations entre la recherche et l'industrie dans ce domaine. Ce discours convenu et l'absence même du ministre ne sont pas vraiment une surprise sur le forum, de nombreux participants ne croyaient pas vraiment à sa venue.

Intel met en avant son MIC tueur de GPU

Pour revenir au HPC, de nombreux exposants présentaient leurs solutions logicielles et matérielles pour accompagner la croissance du marché. Chez Dell, par exemple, Marc Mendez Bermond, expert consultant en HPC, suit avec attention l'évolution du marché du calcul. « Avec une base installée confortable - 38 Téraflops viennent d'être livrés à l'université de Bordeaux - 120 à 150 Téraflops livrés chaque trimestre, Dell se distingue de ses concurrents. Nous ne sommes pas présents sur le supercomputer, mais plutôt proche des laboratoires de recherche. Notre base nous différencie de nos concurrents qui viennent du haut de gamme qui essaient de descendre ». Aujourd'hui, les clients cherchent tous la même chose, à savoir passer de 1 à 10 Pétaflops en 2012.

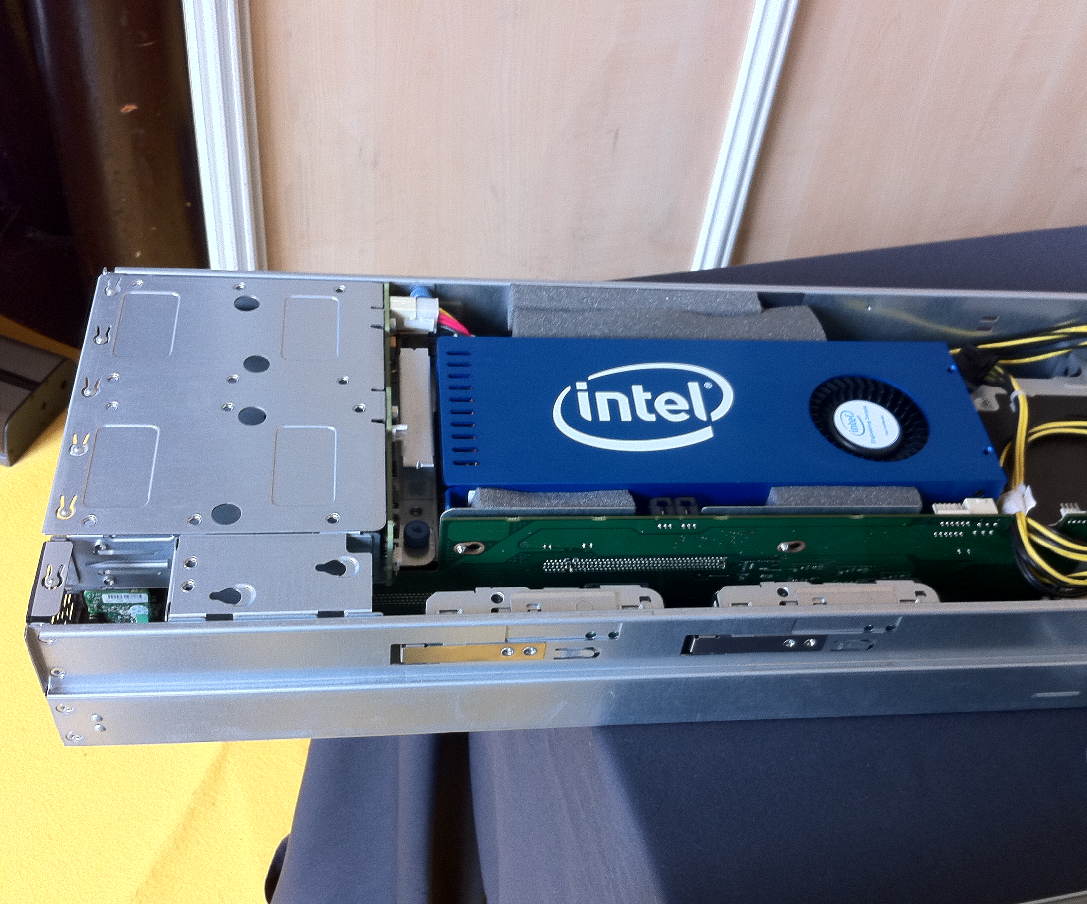

Carte Intel MIC Knight Ferry

« Tout le monde demande une solution pour aller plus vite que le CPU », nous explique Patrice Gommy, directeur marketing de SGI France. Et les solutions se partagent aujourd'hui entre CPU, GPU et MIC (Many Integrated Core), le petit dernier d'Intel présenté au dernier salon Supercomputing à Hamburg. Sur le stand du fondeur à Teratec, la carte MIC Knight Ferry qui intègre 32 puces Pentium-M à 1,2 GHz, capable de traiter 4 threads par cycle d'horloge, était mise en avant pour justement contrer les plates-formes GPU. Exploitable avec les mêmes outils de développement (C, C++ et Fortran) que ceux destinés aux puces x86, l'architecture MIC, qui reprend certains éléments du projet Larrabee, se distingue nettement des Cuba, DirectCompute et OpenCL utilisés sur GPU. C'est en tout cas le but d'Intel : proposer une plate-forme aussi performante que le GPU mais beaucoup plus facile à programmer.

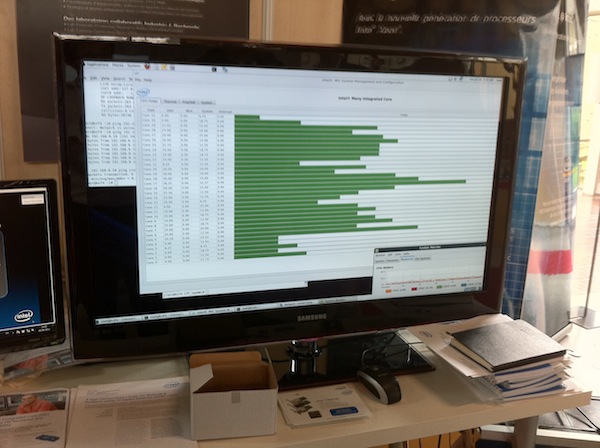

Tableau de bord pour suivre l'activité des 32 puces du MIC d'Intel

À Hamburg, Intel avait dévoilé un châssis bi socket Xeon équipé de huit cartes MIC délivrant une puissance de calcul de 7,3 Gigaflops. Attendus dans 12 à 18 mois chez Bull, HP, SGI et SuperMicro, les cartes MIC commercialisées, reposeront sur la deuxième génération de produit baptisé Knight Corner et gravé en 22 nm 3D TRI-gate pour atteindre la frontière de l'exaflops (un trillion d'opérations par seconde). Et avec les directives OpenMP (Open Multi-Processing), il sera possible de forcer la main au système pour décharger les processeurs du serveur et exploiter directement les cartes MIC.

Le GPU pousse ses pions

En attendant la disponibilité de cette plate-forme, les clients ne négligent pas les solutions GPU. Le stand de Nvidia était très fréquenté le 28 juin dans l'après-midi. « Le GPU offre une puissance de calcul à un prix très avantageux, indique Marc Mendez Bermond de Dell, et ce, même si l'efficience est toujours meilleure sur le CPU : 90% contre 60% environ pour le GPU ». De nombreux partenaires comme l'INRIA ou ClusterVision et surtout les fondeurs travaillent à l'amélioration des algorithmes pour augmenter le rendement. « Aujourd'hui, le marché de la production se partage entre CPU, 90%, et GPU, 10 %, et celui de la recherche est quant à lui dominé à 70% par le GPU » nous assure Marc Mendez Bermond. Et ce principalement sous Linux. « On a une paire de projets par an sous Windows en HPC », poursuit le consultant. Et dans le cadre de son projet datacenters d'un milliard de dollars, Dell proposera lui aussi du HPC dans le cloud comme chez Amazon, SGI, IBM et Microsoft.

Enfin signalons pour conclure que le prix Bull-Joseph Fourier 2011, décerné conjointement par Bull et GENCI, a été décerné à Julien Bohbot chef de projet et ingénieur de recherche à l'IFP Energies Nouvelles. Monsieur Julien Bohbot est récompensé pour ses travaux de parallélisation des applications utilisées pour la simulation de la combustion des moteurs automobiles. Ses travaux laissent envisager d'importants progrès dans l'amélioration des codes visant à réduire les émissions de polluants.

(...)(28/06/2011 10:49:39)Les supercalculateurs de Bull ont leur club

Lors du salon iSC11 (International Supercomputing Conference) à Hambourg, un groupe international d'utilisateurs de solutions de calcul parallèle scientifique et technique fournies par Bull a créé un club, le BuX. Les sept fondateurs sont : Atomic Weapons Establishment (Royaume Uni), Barcelona Supercomputing Center (Espagne), CEA (Commissariat à l'Energie Atomique et aux Energies Alternatives, France), le Jülich Research Center (Forschungszentrum Jülich, Allemagne), le GENCI (Grand Equipement National de Calcul Intensif, France), le centre régional de recherche de l'Université de Cologne (Regionales Rechenzentrum der Universität zu Köln, Allemagne) et l'Université RWTH d'Aix la Chapelle (Rheinisch-Westfälische Technische Hochschule Aachen, Allemagne).

A l'image de tous les autres clubs d'utilisateurs, le BuX visera à partager des expériences et des pratiques, à remonter à Bull les attentes de ses clients, à faciliter les relations entre des experts Bull et les utilisateurs lors d'événements dédiés et enfin à assurer une veille technologique visant à guider la roadmap des produits.

Bien que le BuX soit une structure indépendante du constructeur, celui-ci met à disposition sur son site un formulaire de contact pour les utilisateurs intéressés.

Supercalculateurs : le Japon reprend la tête du Top500

L'ordinateur japonais K, le plus ambitieux projet de calculateur au monde entrepris par Fujitsu, a pris la première place du Top500 des supercalculateurs, mettant ainsi fin au règne du Tianhe-1A chinois, tenant du titre depuis six mois seulement. Avec 8.16 petaflops (un petaflop = un million de milliards d'opérations en virgule flottante par seconde), le K japonais est plus puissant que l'ensemble des cinq systèmes suivant du palmarès. Toujours en cours de construction, le supercalculateur K évalué comporte pour l'instant 68.544 processeurs SPARC64 VIIIfx, nom de code Venus, intégrant chacun huit coeurs, pour un total de 548 352 noyaux, soit presque deux fois plus que n'importe quel autre système figurant dans le Top500. Quand il entrera en service en novembre 2012, le K comportera plus de 80 000 processeurs SPARC64 VIIIfx, selon son constructeur, Fujitsu.

62 supercalculateurs chinois dans le Top500

L'arrivée du Japon au sommet signifie aussi que le supercalculateur chinois Tianhe-1A, qui avait pris la place de numéro 1 en novembre de l'année dernière, se retrouve maintenant en deuxième position avec ses 2,57 petaflops. Mais le nombre de systèmes classés appartenant à la Chine ne cesse d'augmenter, passant de 42 à 62. La modification du classement au sommet signifie également que Jaguar, le supercalculateur construit pour le Département Américain de l'Énergie (DOE), descend en troisième position. Ce classement semestriel a été révélé aujourd'hui au cours de l'International Supercomputing Conference 2011 (ISC) qui se tient actuellement à Hambourg (Allemagne). Contrairement à d'autres superordinateurs récents, le supercalculateur K n'utilise pas de processeurs graphiques ou autres accélérateurs. Et s'il utilise beaucoup de puissance, il est aussi l'un des systèmes les plus économes en énergie, selon le site Top500.org.

Le supercalculateur est installé à l'Institut avancé de sciences informatiques (AICS) de Riken à Kobe (Japon). Quant il sera achevé, il pourra tourner à plus de 10 petaflops. C'est la première fois que le Japon dispose du supercalculateur le plus puissant du monde depuis que son Simulateur Terrestre (Earth Simulator) a été dépassé par le supercalculateur IBM BlueGene/L construit par le DOE et par le Columbia de la NASA en novembre 2004. Pour la première fois, les dix premiers systèmes du classement affichent une performance de plus de 1 pétaflop, même si ce sont les seuls systèmes de la liste à atteindre ce niveau. Les Etats-Unis en ont cinq dans le top 10, le Japon et la Chine en ont deux chacun, et la France en a un. Le Roadrunner du DOE, premier système à avoir franchi la limite du pétaflop en juin 2008, se retrouve désormais à la dixième place.

48% du classement a été modifié en six mois

Les performances des ordinateurs sont mesurées selon les indicateurs établis par Linpack, consistant en un ensemble de routines qui permettent de résoudre des équations linéaires. Dans le nouveau classement, le 500ème système de la liste était classé en 262ème position il y a six mois seulement. Ce qui signifie que près de 48 % de la liste a changé au cours de cette période. Selon le site Top500.org, le taux de renouvellement des systèmes a régulièrement augmenté dans les derniers classements. Alors que les performances des systèmes apparaissant dans le haut de la liste progressent à pas de géants, les avancées de ceux situés en bas de la liste sont plus modestes. Ainsi, en six mois, le premier du top 100 est passé de 75,76 à 88,92 téraflops (un téraflop = mille milliards d'opérations en virgule flottante par seconde). Enfin, avec 213 systèmes présents dans le Top 500, IBM domine, devant Hewlett-Packard qui compte 153 systèmes. Intel continue à fournir la majorité des processeurs des supercalculateurs de la liste, suivi par AMD et IBM. Les processeurs Westmere d'Intel sont maintenant utilisés par 178 systèmes, contre 56 systèmes, il y a 6 mois.

Le Top 500 est réalisé par Hans Meuer de l'Université de Mannheim (Allemagne), Erich Strohmaier et Horst Simon du NERSC/Lawrence Berkeley National Laboratory, et par Jack Dongarra de l'Université du Tennessee, Knoxville.

Illustration : le K2 de Fujitsu (crédit : DR)

(Cliquer ici pour agrandir l'image)

| < Les 10 documents précédents | Les 10 documents suivants > |