Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 1131 à 1140.

| < Les 10 documents précédents | Les 10 documents suivants > |

(22/04/2010 15:31:41)

Steria ouvre une plateforme d'infrastructure informatique en ligne

François Enaud, PDG de la SSII française Steria, a présenté ce matin avec Cisco une offre de plateforme informatique à la demande (« as a service »), assortie d'un paiement à l'usage. Celle-ci repose sur l'infrastructure de serveurs pour datacenter Unified Computing System (UCS), mise au point par le constructeur américain. L'annonce réalisée par webconférence s'est donc faite conjointement avec Laurent Blanchard, vice-président Europe de Cisco.

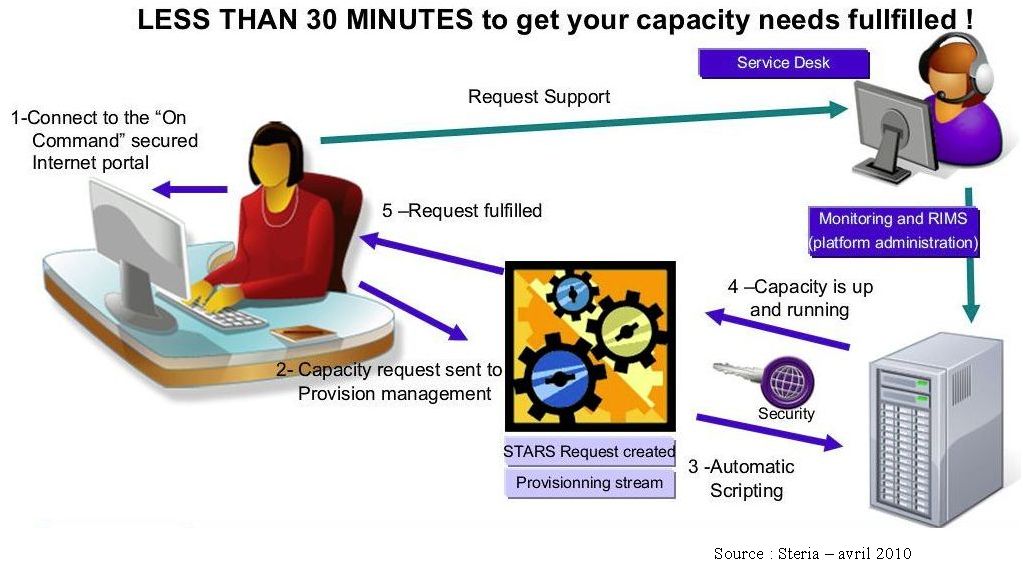

A partir de juin prochain, les entreprises pourront, en passant par un portail Internet sécurisé, accéder à cette plateforme baptisée par Steria "Infrastructure On Command" pour en exploiter les ressources informatiques (puissance de calcul, capacité de stockage...), en fonction de leurs besoins, en ne payant que pour les services consommés.

Un processus entièrement automatisé

Karine Brunet, directrice des services industriels de Steria, a expliqué la mise en oeuvre de la plateforme de cloud computing. Le client se connecte au catalogue de services et formule sa demande de ressources à partir de laquelle va s'enclencher, par le biais d'un processus automatisé, le provisionning des ressources auxquelles l'utilisateur aura accès trente minutes plus tard.

Cliquer sur l'image pour l'ouvrir

« Aucune intervention humaine n'est requise, souligne-t-on chez Steria. On peut ainsi augmenter sa puissance informatique en fonction de besoins qui peuvent être ponctuels, par exemple, pour disposer d'un environnement de test ou d'un environnement de production plus puissant pour une période donnée ». Ainsi, François Enaud pressent que le secteur de la distribution, avec ses contraintes de saisonnalités, ou encore les opérateurs télécoms, qui ont besoin d'augmenter rapidement leurs capacités de réponse, figureront parmi les premiers clients de l'offre. Au-delà de ces cas précis, ce service concerne potentiellement tous les secteurs d'activité.

Steria accompagnera cette mise à disposition d'une offre de services associés. Les niveaux de contrats de services dépendront de l'usage.

Plusieurs acteurs proposent déjà des offres de PaaS, Amazon faisant figure de pionnier dans ce domaine avec EC2 (Elastic Compute Cloud). Parmi les annonces des derniers mois, en France, figurent notamment celles d'Orange, de Microsoft et d'Atos Origin. De son côté, SGI propose d'accéder en ligne à un environnement HPC pour le calcul scientifique et Bull prévoit de le faire sous peu.

Illustration : François Enaud, PDG de Steria

Quid des protections des données dans le cloud ?

Le CIL (Correspondant Informatique et Libertés) devient une fonction clé de l'entreprise lorsque celle-ci décide de passer au cloud. C'est un des enseignements majeurs d'une conférence organisée par EuroCloud, le mardi 20 avril à la CCI de Paris. Elle aura vu l'intervention de Bruno Rasle, directeur général de l'AFCDP (Association Française des Correspondants aux Données Personnelles), et de Sylvain Lebarbier, CIL à la mutuelle AG2R. L'évènement aura également été l'occasion de rappeler les missions du ce métier particulier dans l'entreprise, un poste qui n'est manifestement pas de tout repos.

Le développement du cloud externe implique effectivement que les entreprises ne stockent plus l'ensemble de leurs données sur leurs propres serveurs mais s'en remettent à un prestataire. Les données peuvent être délocalisées dans un autre pays hors UE. Les utilisateurs sont réticents lorsqu'il s'agit de transférer leurs données à un prestataire, mais la CNIL (Commission Nationale de l'Informatique et des Libertés) dispose de sérieux garde-fous juridiques sur ce sujet.

Afin que le cloud ne soit pas synonyme de mauvaise utilisation des données, le CIL a pour mission de vérifier la conformité réglementaire des usages et d'en limiter le risque juridique. Ce responsable doit s'assurer du respect de la réglementation établie par la loi informatique et libertés réformée en 2004, dont la CNIL vérifie l'application. Car en cas de violation, l'entreprise est passible de sanctions financières ou peut voir son système de traitement de données suspendu. Comme le précise Bruno Rasle « la CNIL a gagné en pouvoir de contrôle et l'on ne peut s'y opposer ».

[[page]]

Selon l'autorité administrative indépendante, il revient au CIL de déployer des mesures de protection appropriées, même si le risque pénal est porté par le responsable de traitement (PDG ou, par délégation, DSI, DAF...). Elle ajoute qu' « il doit se concentrer sur deux dimensions différentes de la protection des données, à savoir la sécurité des données personnelles et les flux de données transfrontaliers ». Ainsi, lors de la nomination d'un CIL, tous les projets informatiques, qu'ils soient anciens ou en cours de déploiement sont soumis au contrôle de conformité. Sylvain Lebarbier, CIL d'AG2R insiste pour sa part : « aucun projet n'est mis en oeuvre sans notre accord ».

Des compétences bien précises

Au quotidien, le responsable analyse quatre problématiques majeures : les formalités et les déclarations à remplir auprès de la CNIL, le consentement des différents métiers pour l'utilisation des données, la sécurité notamment concernant les données transmises à un tiers avant la signature d'un contrat, ainsi que la finalité d'un projet. Il relève malgré tout quelques problèmes relatifs à l'exercice des fonctions de CIL. Il déplore que l'on dise que le CIL « fait perdre du temps ». Cette profession est encore trop méconnue, est souvent mal comprise. « Généralement les entreprises pensent qu'elles ont un CIL or souvent elles n'ont qu'un juriste » complète-t-il. Il ajoute que pour veiller au mieux au respect des règles de conformité, il doit s'en remettre régulièrement aux différents métiers et plus particulièrement aux services informatiques pour leur poser des questions précises.

Malheureusement, dans la plupart des cas, la réponse est « je ne sais pas ». A ces problèmes, se mêle en plus une dimension managériale. En effet, lorsque le projet ne semble pas satisfaire à la réglementation, le CIL peut en bloquer la mise en place. Sylvain Lebarbier insiste, « le CIL est l'allié de l'entreprise mais il n'hésitera pas à remettre un projet en question s'il y a un problème de conformité ». Il justifie cette démarche par le fait que « pour être un facteur de confiance, le CIL doit faire figure d'autorité ». Aujourd'hui, la France compte 1 800 correspondants informatique et libertés. Et même si ce nombre tend à s'accroître, la profession peine à recruter car elle nécessite d'avoir des connaissances à la fois juridiques, techniques et sectorielles, et de comprendre le fonctionnement ainsi que les enjeux des différents métiers qui composent l'entreprise. Pour y remédier, des formations spécialisées commencent à se déployer en France et à l'étranger. (...)

L'hyperviseur KVM progresse dans le cloud

The Planet gère en co-location sept centres de données dans le monde, comptabilisant 20.000 clients qui font tourner 15 millions de sites Web. Et plus de 80% utilisent déjà linux. Mais The Planet est un nouveau venu dans l'espace du cloud. Son service est en version bêta publique et comprend plus de 500 serveurs virtuels tournant sur des machines Dell à base de processeurs Intel Nehalem dual-core.

Pour les développeurs sous Linux, KVM est plus facile à utiliser que Xen, car il « n'a jamais été vraiment intégré à Linux » explique Carl Meadows, responsable senior du marketing produit pour The Planet. KVM, de son côté, « a été construit directement dans Linux et l'utilise comme hôte. Il est beaucoup plus simple et plus élégant que Xen » commente-t-il. « Cette intégration facilite également la distribution de correctifs aux clients, alors que le même déploiement à partir d'un autre logiciel de virtualisation nécessite plus de travail » ajoute le responsable. « En outre, KVM permet à The Planet de laisser à ses clients toute liberté pour personnaliser le noyau tournant sur leurs serveurs virtuels, de même que la portabilité du logiciel permet aux machines virtuelles de migrer facilement vers des serveurs physiques et vice versa. Depuis que KVM fonctionne en mode natif, il est beaucoup plus facile pour nous de créer un environnement hybride dynamique que Xen ne le permet » dit encore Carl Meadows.

Amazon EC2, un des géants du marché du cloud public, utilise Xen pour la virtualisation. Mais Carl Meadows pense que KVM peut devenir l'hyperviseur open source de référence sur le long terme, et certains déploiements choisis récemment par IBM viennent renforcer ses arguments. Même si The Planet fait tourner KVM sur Ubuntu, alors qu'IBM a préféré la version Red Hat.

[[page]]

Ce dernier et KVM semblent également avoir gagné l'intérêt de Novell, puisque ce dernier l'utilisera dans la version 11 de son serveur SUSE Linux Enterprise. Evidemment, Novell continue de supporter Xen.

Des avantages reconnus par les concurrents

Quant à Simon Crosby, CTO de Citrix, il écrit sur son blog « il faut s'attendre à ce que Novell supporte KVM ». Le bloggeur reconnaît aussi que cette solution présente certains avantages : « Il est important de réaliser que pour un fournisseur de solutions Linux, KVM simplifie considérablement l'ingénierie, les essais et le conditionnement pour les déploiements. Il se comporte comme un driver intégré au noyau, alors que Xen exige que le fournisseur choisisse une version particulière de la solution de virtualisation de Citrix ». Mais au final, il conclut que « les préférences utilisateurs sont plus importantes que le reste et là, c'est Xen qui l'emporte, en partie parce qu'il offre une compatibilité avec des systèmes d'exploitation et des hyperviseurs multiples ».

« Si le contexte implique que le client achète, installe et fasse fonctionner Linux pour mettre en place sa virtualisation, alors KVM pourra probablement convenir » prédit le dirigeant de Citrix. « Par contre, si l'utilisateur souhaite déployer une plateforme de virtualisation agnostique par rapport à l'OS du serveur hôte, pour réaliser une infrastructure virtuelle complète, c'est vers un hyperviseur de type 1, vers lequel il se tournera. » Bien que Citrix dispose d'un solide partenariat avec Microsoft, le responsable technique souligne que « s'appuyer sur un éditeur de système d'exploitation est problématique, car aucun n'a encore travaillé à une virtualisation des produits concurrents, et qu'il n'y aucun intérêt stratégique à le faire ».

Dans le cas de The Planet, le débat est moins Xen contre KVM que Xen contre VMware. L'opérateur propose en effet un service d'hébergement managé qui utilise VMware en complément de KVM sur son offre cloud. Le choix de cette solution est dicté par la popularité des solutions VMware et la demande des clients qui souhaitent débuter la virtualisation par un cloud privé. « KVM ne disposent pas de certaines fonctionnalités incluses dans VMware, comme la migration en temps réel et la déduplication de RAM, » explique Carl Meadows. Le développement de KVM peut également s'appuyer sur la communauté Open Source, mais en termes d'outils de gestion, il est encore loin derrière VMware. C'est d'ailleurs cette différence qui justifie son prix.

Le cloud computing, un enjeu national pour l'Afdel

Les applications du cloud computing se concrétisant de plus en plus nettement, différents acteurs français de la IT expriment tour à tour l'urgence d'en maîtriser les enjeux. L'Afdel, association française des éditeurs de logiciels, vient en particulier de publier un livre blanc intitulé « Cloud computing - Une feuille de route pour la France ». Cette brochure illustrée de 80 pages doit être adressée aux pouvoirs publics et aux principales organisations professionnelles, dont le Medef et le Cigref.

L'Afdel souhaite une consultation publique sur ce sujet, afin de définir les orientations des appels à projets dans le cadre du Grand Emprunt. Rappelons que ce dernier doit consacrer 2,5 milliards d'euros aux contenus et aux usages innovants du numérique, tandis que 2 milliards contribueront à déployer des infrastructures Internet à très haut débit.

Le début d'une autre ère de l'informatique

La semaine dernière, l'association a réuni ses adhérents à Paris pour leur présenter les conclusions de son groupe de travail sur le cloud computing. En substance, l'association prend acte que celui-ci annonce « la fin d'une ère de l'informatique, celle des systèmes d'information juxtaposés, de façon parfois chaotique (...) et le début d'une autre » qui se présente sous la forme de services numériques « disponibles en tout lieu, à la demande et pour toute organisation, quelle que soit leur taille ».

[[page]]

Le SaaS (software as a service) est pour l'instant le principal moteur du cloud, souligne Patrick Bertrand, président de l'Afdel, en préface du livre blanc. Il rappelle que cette évolution est évidemment poussée par le développement des usages grand public (webmail, messagerie instantanée, réseaux sociaux) : « L'informatique de demain sera donc 'user friendly' ou ne sera pas... », d'où l'importance du logiciel, notamment, qui reste la dernière interface avec l'utilisateur.

Mais, au-delà, « si l'informatique de demain devient une industrie lourde, celle de datacenters géants, nous devons en relever le défi, insiste Patrick Bertrand. La France a besoin d'une politique industrielle [...] créatrice d'emplois ». Le président de l'Afdel pointe le risque de voir les services suivre la délocalisation des emplois industriels.

EuroCloud France évoque le mode SaaS en version indirecte

L'ancien ASP Forum, devenu EuroCloud France prend de nouvelles orientations. D'abord, et comme son nom l'indique, il devient le représentant en France d'une organisation pan-européenne, forte aujourd'hui de 18 membres. Elle devrait atteindre le cap des 25 d'ici la fin de l'année, avec une belle percée à l'Est, après l'Ukraine et la Turquie, la Russie et la Pologne devraient adhérer.

Un congrès européen va se tenir au Luxembourg le 21 juin prochain a annoncé Pierre-José Billotte, le président France. EuroCloud Europe prépare pour cette occasion la publication d'un Livre blanc qui comprendra à la fois une synthèse européenne et un focus sur chaque pays. Il sera présenté à Nelly Kroes, la Commissaire européenne en charge des TIC.

Les Etats Généraux de ce mardi 20 avril ont également mis l'accent sur la distribution en Saas (software as a service). Un aspect aujourd'hui essentiel pour le développement du cloud. D'ailleurs, EuroCloud était présent début février lors du salon IT Partners, et à l'inverse, ce dernier l'était lors des Etats Généraux d'EuroCloud. Un mouvement d'échange et un travail de fond pour engager le secteur dans la voie de la distribution indirecte. « Le channel est un sujet majeur pour le développement du cloud et nous prendrons plusieurs initiatives cette année en ce sens », nous explique Pierre-José Billotte, président d'EuroCloud France.

Le contrat et la rémunération : 2 sujets épineux

Le sujet est rien moins qu'épineux. Déjà en terme contractuels. Plusieurs éditeurs présents lors de l'atelier spécialisé mené dans le cadre des Etats Généraux affirment reproduire simplement les contrats rédigés pour des formes de distribution traditionnelles. Mais apparemment, la notion de responsabilité n'est plus la même. Le distributeur porterait moins de responsabilité (au sens juridique) dans la distribution en Saas que dans les autres formes de ventes en indirect. Cette responsabilité repose davantage sur l'éditeur-hébergeur.

Photo : Pierre-José Billotte, président France d'EuroCloud Europe (Crédit : DR)

[[page]]

Deuxième point douloureux, celui de la rémunération. Dans les formules en Saas, la rémunération est souvent mensuelle ou trimestrielle, et non plus forfaitaire comme dans le schéma traditionnel. Les intégrateurs apportent également des compléments ultérieurs sous forme de services. Cette modalité de rémunération régulière rassure le partenaire en indirect, mais le laisse au départ exsangue. Il aura du mal à se lancer en Saas et à financer des investissements.

Certains éditeurs préparent donc des forfaits attribués dès le départ de la prestation, de manière à couvrir l'investissement de leur partenaire et à lever un frein possible dans l'engagement de la distribution. C'est un changement d'autant plus notable que les éditeurs ne sont pas tous engagés en indirect dans les mêmes proportions. Ils doivent donc renforcer cet engagement et l'envisager de manière innovante.

Trimestriels IBM : les services reprennent doucement

IBM a enregistré une hausse de 13% de son bénéfice net sur son premier trimestre fiscal, clos le 31 mars dernier. Son chiffre d'affaires a progressé de 5,3%, à 22,86 Md$, par rapport au premier trimestre 2009. Big Blue le doit principalement à sa division Global Technology Services (GTS qui regroupe les services IT, la maintenance, le conseil en infrastructure et l'outsourcing), dont le chiffre d'affaires a augmenté de 6,3%, à 9,3 Md$, ainsi qu'à sa division Logiciels, en hausse de 10,6%, à 5 Md$. Cette dernière regroupe la partie Information Management (Cognos, DB2, l'ECM avec FileNet, Informix et Infosphere), mais aussi les offres Lotus, Rational, Tivoli, WebSphere, ainsi que les logiciels destinés à ses mainframes System z. La marge brute de sa division GTS s'établit à 34,4% et celle de sa division Logiciels est toujours aussi élevée : 84,6% (84,2% au premier trimestre 2009). A noter la hausse de 23% sur les ventes de logiciels d'administration Tivoli et de 13% sur les produits middleware WebSphere.

En revanche, le chiffre d'affaires de l'autre activité de services, Global Business Services (GBS, soit le conseil et l'intégration de systèmes et d'applications) reste pratiquement étal, à 4,41 Md$. Prise dans son ensemble, l'activité services d'IBM, qui rassemble GTS et GBS et pèse 60% du chiffre d'affaires global, n'aura donc progressé que de 4,2% sur ce premier trimestre, à 13,7 Md$. Big Blue souligne néanmoins qu'il a signé sur la période treize contrats de services dépassant les 100 M$, ce qui atteste tout de même d'une certaine reprise des investissements.

Hausse sur les projets décisionnels et Smart Planet

Sur ce trimestre, Sam Palmisano, le PDG d'IBM, attire l'attention sur les bons résultats obtenus par le groupe dans trois domaines : les activités liées aux applications analytiques (BI), les solutions Smarter Planet (projets de développement durable dans les villes autour d'une meilleure gestion de l'énergie, des transports et des questions de sécurité) et, enfin, les économies en croissance. Les revenus de la zone Asie/Pacifique ont augmenté de 10% à 5,3 Md$ (mais de 1% seulement à taux de change constant). La zone EMEA (Europe, Moyen-Orient, Afrique) a progressé de 5% à 7,6 Md$ (-2% à taux de change constant) et la zone Amériques de 2% à 9,5 Md$ (étal à taux de change constant).

Illustration : Sam Palmisano, PDG d'IBM (crédit photo : IBM)[[page]]

System x en hausse, System p et z en baisse

La division Systems & Technology qui couvre son activité matériel a de son côté augmenté de 4,9% par rapport à l'an dernier, à 3,385 Md$. Sur cette partie, les performances sont inégales. Ainsi, les ventes de System x (plateformes x86 sur processeurs Intel et AMD, systèmes de stockage) ont grimpé de 36%, mais celles réalisées sur les technologies 'maison', les System z (mainframes) et Power (pSeries et iSeries), ont chuté de 17%. IBM escompte toutefois une remontée sur ces matériels un peu plus tard cette année, avec la livraison des prochains System z.

Quant à l'activité Global Financing d'IBM, qui ne représente que 2,3% de son chiffre d'affaires global, elle recule de 7,1%, à 537 M$, mais avec une marge brute de 49,8%.

Pour Dov Levy, analyste financier chez CM-CIC Securities, ces résultats mitigés confirment que le groupe n'a pas encore profité de la reprise de la demande « qui s'annonce progressive ». Il estime cependant que celle-ci devrait s'accélérer à partir du deuxième semestre si l'on considère « la forte progression des prises de commandes dans le conseil qui montre que les grands groupes recommencent sérieusement à réfléchir » à réactiver « leurs projets de transformation ».

Aux Etats-Unis, le cloud progresse, mais les frustrations aussi

Aujourd'hui, le cloud se développe un peu de manière anarchique, mais cette croissance entraîne une certaine frustration, un mot que l'on entend de plus en plus dans les discussions sur les services hébergés. Par exemple, les clients du cloud et aussi certains fournisseurs, tempêtent contre le manque d'information sur les données et sur les standards de sécurité. Certains pointent du doigt l'absence de règles qui imposent aux fournisseurs de services hébergés d'indiquer la localisation des données des clients, surtout si elles sont hébergées hors des Etats-Unis et donc non soumis à la loi américaine sur la sécurité.

Lors de la SaasCon 2010, qui s'est tenu au début du mois, Ed Bellis, responsable de la sécurité du système d'information chez Orbitz, agence de voyage en ligne, a expliqué le choix de son entreprise d'utiliser le cloud pour améliorer la productivité et recentrer les managers sur leur coeur de métier. Néanmoins, le dirigeant interpelle les différents acteurs en demandant d'urgence des standards de sécurité pour le cloud. Orbitz, qui est à la fois utilisateur et fournisseur de services cloud, indique qu'il doit répondre à des exigences de sécurité à tous les niveaux, allant de l'enquête sur site à l'inspection des datacenters.

Des standards et du poids

Les normes élaborées par la Cloud Alliance Security, un groupe sans but lucratif financé par les utilisateurs et les fournisseurs de cloud pourrait constituer une solution. Les normes devraient afficher les données dans un format commun, permettant aux clients, selon Ed Bellis de savoir exactement « quelle est notre position sur la sécurité ». Le responsable indique que l'existence de telles normes réduirait d'un tiers son travail d'enquête.

[[page]]

De son côté, Keith Waldorf, vice-president des opérations de Doctor Dispense, spécialiste dans la e-prescription, a été très critique sur l'inflexibilité et les termes des contrats de certains fournisseurs. Il donne comme exemple, un accord passé dans le domaine matériel et logiciel qui était tellement verrouillé qu'il lui interdisait de profiter des améliorations ou des nouveautés du fournisseur. « Nous avons cassé ce contrat pour chercher un nouveau prestataire » souligne le dirigeant, et de préciser « aujourd'hui les accords sur le cloud sont tous sur le même modèle, à la discrétion des fournisseurs ».

Il est probable que les grandes entreprises infléchiront cette orientation lors de la négociation de leur contrat. Ainsi, dans le contrat pour l'utilisation des Google Apps, la ville de Los Angeles a demandé à Google d'accepter le paiement de dommages en cas de violation de l'accord de non divulgation. Mais la plupart des utilisateurs n'ont pas le même poids, explique Jim Reavis, fondateur de la Cloud Security Alliance.

HP trouve des performances de calcul pour les Memristors

Ces memristors (contraction de memory et resistors) comprennent une résistance avec de la mémoire et sont considérées comme le quatrième composant électrique passif (après condensateur, bobine et résistance). Elles ont été élaborées à l'origine pour étendre la capacité mémoire des terminaux. Les chercheurs des HP Labs, qui ont démontré leur existence en 2008, ont découvert qu'elles pouvaient être utilisées pour le calcul logique. Cette découverte signifie que dans les 6 à 8 prochaines années, la memristor sera à même de gérer en même temps la mémoire et le calcul sur une même puce.

« Cette technologie a le potentiel d'inverser les fondamentaux de l'informatique, souligne Dan Olds, un analyste de Gabriel Consulting Group, car elles disposent de la combinaison processeur et stockage, qui agissent comme des synapses du cerveau humain. Connectées entre elles, les memristors amélioreront sensiblement la « reconnaissance de formes » par rapport aux ordinateurs traditionnels ».

Un potentiel important

Toujours au stade de la recherche, ces composants apporteront aux transitors une sorte de turbo boost, déclare Stan Williams, chercheur au HP Labs. « Les memristors devraient être utilisées dans certains équipements d'ici 3 ans. Elles sont néanmoins en concurrence avec les mémoires flash, mais comprendront plus de mémoire, consommeront moins d'énergie et seront plus rapides » conclu le scientifique.

« C'est potentiellement une technologie de rupture » observe un analyste sur l'industrie Rob Enderle « si la technologie est commercialisée rapidement et que le prix est abordable, cela pourrait effectivement transformer le marché de l'électronique grand public ». Les résistances à mémoire pourront concrétiser l'avènement du Web en 3D, car selon Dan Olds, elles ont une incroyable capacité de travail par rapport à leur taille ».

Le marché des semi-conducteurs, un retour à la croissance

(Source EuroTMT) Depuis un creux de plus de 12 ans touché il y a un peu plus d'un an par les bourses mondiales, ces dernières ont rebondi de quelque 70 %, aidée par les perspectives d'une reprise économique.

Si l'on regarde les performances secteur par secteur, on se rend compte que ce sont les valeurs financières et technologiques qui ont tiré le marché vers le haut. Et si l'on affine encore davantage, on constate que l'action Advanced Micro Devices (AMD), le concurrent le plus proche d'Intel, a bondi de quelque 300 % sur les 12 derniers mois. Cette évolution boursière en dit long sur la dynamique retrouvée d'un secteur des semi-conducteurs qui vient de traverser l'une des pires crises de son histoire. Les cabinets d'études ont multiplié les prévisions étayant le scénario d'un retour durable de la croissance.

Après avoir reculé de près de 10 % en 2009 malgré un bon quatrième trimestre, le chiffre d'affaires mondial du secteur des semi-conducteurs devrait progresser de 19,5 % cette année pour atteindre 276 milliards de dollars (208 milliards d'euros). Les ventes devraient notamment être tirées par une demande extrêmement soutenue pour les PC et les mémoires DRAM utilisées notamment dans les appareils portables. Gartner ajoute que le chiffre d'affaires du secteur devrait continuer à augmenter jusqu'en 2014, la barre des 300 milliards de dollars devant être franchie dès 2012 avec 304 milliards.

[[page]]

De son côté, IDC anticipe une hausse de 15,1 % du volume total de ventes de microprocesseurs en 2010. Signe que la reprise économique est encore fragile, la SIA (Semiconductor Industry Association) a toutefois annoncé en début de semaine que les ventes mondiales de semi-conducteurs avaient reculé de 1,3 % en février par rapport au mois de janvier. Cela représente quand même un bond de 56% par rapport à février 2009.

Des perspectives optimistes

Mais la SIA estime possible de revoir à la hausse la prévision, faite au mois de novembre, d'une progression de 10,2% des ventes de semi-conducteurs en 2010 à 242 milliards de dollars. Le secteur va également bénéficier de l'émergence de nouveaux segments de marché, notamment celui des tablettes dont l'iPad d'Apple est le porte-drapeau. Le fabricant de puces graphiques Nvidia voit ainsi les ventes de tablettes commencer à être un vrai relais de croissance pour sa puce Tegra à partir du troisième trimestre de cette année. Pour l'instant, la reprise des ventes du secteur semble profiter à AMD qui, selon iSuppli, a pris des parts de marché à Intel dans le segment des microprocesseurs pour ordinateurs. Sur le quatrième trimestre 2009, AMD a ainsi vu sa part de marché augmenter de 1,6 point à 12,6 % alors qu'Intel a perdu un point. Le numéro un mondial conserve encore une avance confortable sur son concurrent le plus direct avec une part de marché de 80,6 %.

En outre, à plus long terme, avec les bonnes performances commerciales enregistrées par Intel à la fois dans le domaine des netbooks et dans celui des serveurs, certains spécialistes commencent à s'interroger sur la capacité d'AMD à continuer à progresser. En attendant, les analystes redoutent une chose pour la pérennité de la croissance du secteur dans son ensemble : que les entreprises, après avoir drastiquement réduit leurs capacités de production au plus fort de la crise, les augmentent trop vite et cassent ainsi la dynamique en provoquant une accumulation de stocks chez leurs clients.

| < Les 10 documents précédents | Les 10 documents suivants > |