Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 1321 à 1330.

| < Les 10 documents précédents | Les 10 documents suivants > |

(19/08/2009 15:14:25)

Nvidia entre plus encore dans le HPC avec le calcul algébrique

EM Photonics vient d'optimiser une bibliothèque de fonctions de calcul algébrique (Lapack) pour les cartes graphiques de Nvidia utilisant la technologie Cuda (Compute Unified Device Archictecture) de ce dernier. Ce système de parallélisation des traitements a permis au constructeur de transformer ses processeurs graphiques en outils de calcul scientifique. Il en a fait une gamme à part entière, appelée Tesla et réservée au HPC (calcul haute performance) le mettant ainsi à portée du plus grand nombre. La bibliothèque de fonctions portée par EM Photonics ajoute une pierre à cet édifice puisqu'elle est couramment utilisée dans la mécanique de structure, la physique du calcul ou l'electronic design automation (CAO électronique). Autant de disciplines utilisées davantage dans l'univers professionnel que le grand public auquel est habitué Nvidia. Selon le constructeur, Cula utilisé avec ses cartes Tesla devrait voir ses performances de calcul multipliées par 10 par rapport à une utilisation d'un seul quadricoeus classique, sans coprocesseur de calcul dédié. (...)

(17/08/2009 16:33:14)IBM travaille sur des puces à base d'ADN

Versés depuis plus de 20 ans dans les nanotechnologies, les chercheurs d'IBM viennent de combiner deux techniques destinées à concevoir des puces dont la finesse de gravure ne dépasserait pas 6 nm. Les processeurs actuels utilisent une technologie en 35 nm, et les prochaines passeront seulement en 22nm. Le différentiel pourrait donc être important et devrait, selon IBM, permettre d'obtenir « plus de puissance dans un espace très petit mais aussi de réduire la consommation électrique et le coût de fabrication ». L'autre avantage de la découverte des chercheurs réside dans la possibilité d'utiliser des nano-composants avec des processus de fabrication traditionnels. Enficher des nanocomposants dans des origamis d'ADN La technique employée par IBM s'appuie sur les travaux de Paul Rothmund, du CalTech (California Institute of Technology), sur le pliage d'ADN (ou origami d'ADN). Ils provoquent une réaction entre de longs brins d'ADN viral et des brins courts de molécules synthétiques. Les brins les plus courts se comportent comme des agrafes qui viennent relier des paires de bases complémentaires et de cette façon, plient l'ADN viral. Les chercheurs obtiennent alors des « origamis d'ADN » qui ont la forme de carrés, de triangles ou d'étoiles nanométriques. Ceux-ci servent ensuite de circuits imprimés miniatures. En modifiant les brins courts d'ADN synthétiques utilisés comme accroches, les chercheurs sont en effet arrivés à les utiliser comme points d'attache, non pas pour des éléments d'ADN, mais pour des nanotubes ou des nanocomposants. L'espacement entre ces derniers ne dépasse alors pas 6 nm. L'avantage essentiel de la solution imaginée par IBM autour de nano-origamis utilisés comme des circuits imprimés, c'est qu'elle devrait permettre aux fabricants de se servir de leur processus actuels de production. (...)

(13/08/2009 12:20:43)BMC et CA préparent le terrain pour l'administration de clouds hybrides

Quelques jours après BMC, CA a annoncé avoir modifié ses logiciels de supervision de façon à offrir aux entreprises une console unique pour administrer aussi bien les serveurs et applications en interne que les machines et services applicatifs fournis par Amazon sur EC2. Les deux éditeurs spécialistes de la supervision font le même constat. Comme les autres batailles avant celle-ci, la bataille cloud vs datacenter privé aboutira à un équilibre : beaucoup d'entreprises choisiront de conserver leur patrimoine en interne, éventuellement au sein de clouds privés (s'adaptant aux concepts d'Itil, les datacenters privés deviennent des fournisseurs de service internes aux entreprises), tout en confiant une partie de leurs applications à des clouds externes. C'est donc l'avènement de ces clouds hybrides que ces éditeurs préparent. Pour Régis Mauger, qui vient de prendre en main la partie consulting de BMC Software France, ce n'est que grâce à des outils d'administration comme ceux que son entreprise prépare que le cloud tiendra sa promesse d'élasticité. « Chacun va avoir son propre datacenter et une solution de 'capacity management' [allocation de ressources, NDLR], explique-t-il. Les entreprises pourront ainsi s'appuyer sur le cloud public pour se délester en cas de forte charge, par exemple, ce mode hybride permettra d'avoir en quelque sorte un 'buffer' externe, un tampon absorbant le pic de charge. » RightScale travaille déjà sur l'administration multi-cloud Pour l'heure, on en est juste au stade de la centralisation des informations. Mais de toute façon, reprend Régis Mauger, le marché ne demande pas davantage pour l'instant. Beaucoup d'entreprises n'ont toujours pas entamé de démarche de cartographie et d'inventaire, et encore moins se sont lancées dans des projets de virtualisation et de consolidation. Certains acteurs se positionnent toutefois déjà sur l'administration d'environnements multi-clouds. C'est le cas de RightScale, une start-up californienne, qui promet non seulement une administration centralisée, mais aussi une portabilité transparente d'un cloud à l'autre. L'offre d'administration de RightScale supporte déjà, outre les services d'Amazon, ceux de GoGrid, FlexiScale et Eucalyptus, et l'éditeur annonce le support prochain des offres de RackSpace et de Sun. (...)

(11/08/2009 16:40:29)VMware achète SpringSource avec le cloud en perspective

VMware s'offre pour 420 M$ (86% en liquidités, le reste en action) SpringSource, éditeur de Spring, framework de développement d'application Java très largement utilisé, et du serveur d'applications modulaire dm Server. Fondés il y a cinq ans, SpringSource et les communautés qui gravitent autour sont aussi des contributeurs importants aux projets Apache et Eclipse. Le savoir-faire de SpringSource vient renforcer VMware dans le domaine du Paas "Platform as a service", autrement dit, du cloud computing. Dans la logithèque de SpringSource, la Tool Suite Eclipse de SpringSource devrait s'intégrer à VMware Workstation. Cela devrait donner un bel outil de paramétrage multi-environnement pour les développeurs. Quant à l'intérêt des appliances logicielles (serveurs virtuels) dm Server et tc Server (serveur Apache Tomcat), il tombe sous le sens : une entreprise disposant de machines en interne ou en externe pourra disposer d'une plateforme logicielle standardisée, redimensionnable à volonté. Au cours des mois précédant son rachat par VMware, SpringSource avait procédé à d'intéressantes emplettes. En novembre dernier, l'éditeur avait mis la main sur G2one, qui développe le langage dynamique Groovy, et, en mai dernier, SpringSource avait acheté les actifs logiciels d'Hyperic, éditeur d'une offre de supervision sous Java des performances applicatives. Un peu plus tôt en 2008, SpringSource avait aussi acquis Covalent (support Apache). Tant chez VMware que chez SpringSource, on affirme que ce rachat d'une entreprise fondée sur l'Open source par une autre très attachée au secret de ses lignes de code ne pose aucun problème. A preuve, SpringSource sera intégré sans être démantelé dans VMware. Il faudra attendre quelque temps avant de voir si l'opération réussit mieux que dans d'autres cas tel que celui de MySQL avec Sun, qui affichait pourtant l'Open Source sur son plastron. La transaction sera close au troisième trimestre et les premiers produits communs sont attendus pour janvier 2009. (...)

(06/08/2009 17:40:36)Un nouveau patron des mainframes IBM pour redorer leur blason

Nommé en juillet à la tête de la division grands systèmes d'IBM, Tom Rosamilia va avoir la tâche difficile de relancer la demande pour ce type de machines dans le contexte de crise économique. Une mission d'autant plus difficile que les clients ont déjà, pour la plupart, mis à jour leur parc avec les modèles z10, annoncés en 2008. Alors qu'au deuxième trimestre de l'an dernier, les ventes de ces nouvelles machines avait fait bondir l'activité grands systèmes de 34%, au deuxième trimestre de cette année, IBM a enregistré une baisse de 39% du CA de cette division. En terme de Mips livrés, la baisse représente 20%. Pris dans la masse d'IBM, les ventes de grands systèmes représentent moins de 5% du total, mais le profit généré par l'ensemble de l'écosystème (logiciels, périphériques, maintenance) atteint encore près de la moitié des profits. D'ici la mi-août, Big Blue devrait procéder à un train d'annonces qui visera à proposer des configurations clés en main. Les domaines visés seraient la sécurité, les entrepôts de données et la reprise après désastre. IBM pourrait aussi souligner le rôle que ses grands systèmes peuvent jouer dans des environnements de cloud. (...)

(06/08/2009 11:11:55)Micron transcende les performances de la mémoire DDR3

Avec ses barrettes DDR3 LRDIMM, Micron Technology affirme réduire de 50 à 75% l'utilisation du bus mémoire des serveurs. Ce progrès laisse espérer un net gain de performances pour les serveurs équipés de processeurs Intel Xeon 5500 (Nehalem) qui font un usage exclusif de ce type de mémoire. Ils intégreront un plus grand nombre de barrettes plus denses que lorsqu'ils exploitaient la mémoire RDRIMM (Registred dual-inline memory module). Les barrettes LRDIMM (Load-reduced, dual-inline memory module) doivent cette réduction de la consommation de bande passante à la présence d'une puce iMB (Isolation memory buffer), conçue par Inphi. Ce composant remplace l'habituel buffer qui stocke adresses et commandes. De plus, Micron utilise des composants mémoire de 2 Gbits gravés en 50 nm qui ne consomment que 1,35 volt. Micron affirme qu'il sera possible d'attribuer jusqu'à 48 Go de mémoire par processeur. Il commence à tester des modules LDRIMM 8 Go et promet des 16 Go pour le début de l'an prochain. Il n'indique cependant aucun prix. Depuis le mois de mai, soit l'époque du lancement des Xeon 5500, le prix d'un composant DDR3 a augmenté de 30%. (...)

(05/08/2009 16:13:29)AMD fait migrer des machines virtuelles à chaud entre tous ses Opteron

AMD a fait la démonstration d'une migration à chaud de machines virtuelles entre des plateformes animées par des processeurs Opteron allant du bi-coeur Rev F (2006) au 12 coeurs Magny-Cours, attendu pour 2010, en passant par le quadricoeur Shanghai (2007) et l'hexacoeur Istanbul. AMD consacre d'importants efforts à promouvoir la possibilité de telles migrations entre des plateformes équipées de processeurs Opteron de générations différentes. Et ce, quel que soit l'hyperviseur utilisé. Son service marketing capitalise sur l'impossibilité théorique de déplacer une machine virtuelle entre des serveurs équipés de processeurs de différentes générations. Il omet de préciser que la fonction "Extended Migration" des processeurs Opteron repose sur le principe du plus petit dénominateur commun. Autrement dit, toutes les plateformes serveurs concernées doivent être paramétrées avec le jeu d'instructions du processeur le moins évolué afin que les machines virtuelles reposent toujours sur un socle perçu comme identique. (...)

(04/08/2009 09:53:45)STMicroelectronics premier client de GlobalFoundries

GlobalFoundries, l'outil de production qu'AMD a transféré dans une co-entreprise, vient de signer un contrat avec l'Européen STMicroelectronics, son premier client, exception faite de son actionnaire fondeur. Connu dans un premier temps sous le nom de The Foundry Company, GlobalFoundries est officiellement né en mars dernier, à la suite de l'accord signé entre Atic (Advanced technology investment company), soutenu par le fonds d'investissement des Emirats arabes unis, et AMD. Ce dernier détenant 34% du capital de la nouvelle société. GlobalFoundries commencera à livrer STMicroelectronics à compter de la mi-2010 avec des puces basse consommation gravées en 40 nm. Les analystes soulignent que GlobalFoundries décroche un premier client bien plus rapidement que prévu. Ils constatent aussi que ce contrat intervient au moment ou TMSC, sous-traitant de STMicro, connaît des difficultés pour mettre en place une chaîne de production en 40 nm. (...)

(31/07/2009 17:01:07)Les images 3D directement calculées sur un supercalculateur Blue Gene

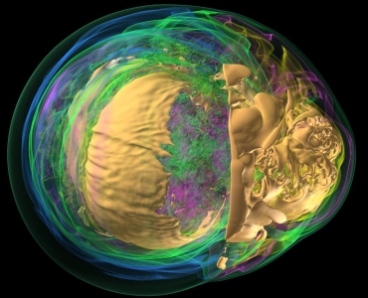

Et si on pouvait se passer des processeurs graphiques pour obtenir la visualisation en 3D de larges volumes de données ? Des chercheurs de l'Argonne National Laboratory, un centre de recherches du ministère américain de l'Energie, se sont posés cette question et ont réussi à trouver un moyen de le faire, grâce à une technique logicielle de parallélisation.

Le but, expliquent-ils, était de supprimer un goulet d'étranglement traditionnel : en règle générale, une fois que le supercalculateur a compilé les données, celles-ci sont transmises à une ferme de calculateurs graphiques, qui se chargent de l'aspect visualisation. Dans ce processus, disent-ils, du temps et de l'espace disque sont gâchés.

A la place, les scientifiques ont exploité en parallèle les 160 000 coeurs de leur Blue Gene/P, un supercalculateur IBM de 557 Tflops (557 000 milliards d'opérations par seconde). « Nous avons été capables d'aller jusqu'à des volumes de 80 milliards de voxels », explique un des chercheurs (un voxel est l'équivalent dans un espace à trois dimensions du pixel pour la 2D ; il s'agit d'un mot-valise, formé par la concaténation de l'apocope de 'volume' et de l'aphérèse de 'pixel').

Pour démontrer leur savoir faire, les chercheurs ont ainsi calculé le rendu graphique en 3D de l'effondrement d'une supernova, créant ce qu'ils appellent « l'image la plus cool jamais créée sur un supercalculateur à l'Argonne National Laboratory » (cf. photo). (...)

Et si on pouvait se passer des processeurs graphiques pour obtenir la visualisation en 3D de larges volumes de données ? Des chercheurs de l'Argonne National Laboratory, un centre de recherches du ministère américain de l'Energie, se sont posés cette question et ont réussi à trouver un moyen de le faire, grâce à une technique logicielle de parallélisation.

Le but, expliquent-ils, était de supprimer un goulet d'étranglement traditionnel : en règle générale, une fois que le supercalculateur a compilé les données, celles-ci sont transmises à une ferme de calculateurs graphiques, qui se chargent de l'aspect visualisation. Dans ce processus, disent-ils, du temps et de l'espace disque sont gâchés.

A la place, les scientifiques ont exploité en parallèle les 160 000 coeurs de leur Blue Gene/P, un supercalculateur IBM de 557 Tflops (557 000 milliards d'opérations par seconde). « Nous avons été capables d'aller jusqu'à des volumes de 80 milliards de voxels », explique un des chercheurs (un voxel est l'équivalent dans un espace à trois dimensions du pixel pour la 2D ; il s'agit d'un mot-valise, formé par la concaténation de l'apocope de 'volume' et de l'aphérèse de 'pixel').

Pour démontrer leur savoir faire, les chercheurs ont ainsi calculé le rendu graphique en 3D de l'effondrement d'une supernova, créant ce qu'ils appellent « l'image la plus cool jamais créée sur un supercalculateur à l'Argonne National Laboratory » (cf. photo). (...)

| < Les 10 documents précédents | Les 10 documents suivants > |