Flux RSS

108538 documents trouvés, affichage des résultats 1571 à 1580.

| < Les 10 documents précédents | Les 10 documents suivants > |

(24/11/2011 17:29:31)

La justice européenne condamne le filtrage généralisé des internautes

L'affaire remonte à quelques temps déjà. La SABAM, équivalent de la SACEM en Belgique, voulait imposer à l'opérateur Scarlet un système de filtrage des internautes pour prévenir les échanges des fichiers illégaux sur les réseaux P2P. La justice belge avait donné raison à la société des ayants droits et imposé au FAI la mise en place du filtrage à ses frais. L'opérateur a fait appel de cette décision et la cour d'Appel de Bruxelles a saisi la Cour de Justice de l'Union européenne pour savoir si cette décision était contraire ou non au droit communautaire.

La réponse était très attendue et la CJUE a rendu un arrêt qui confirme l'illégalité de cette décision. Pour motiver son jugement, la Cour s'appuie sur la directive e-commerce qui interdit « des mesures qui obligeraient un fournisseur d'accès à Internet à procéder à une surveillance générale des informations qu'il transmet sur son réseau ». Le filtrage, s'il est global, pourrait même devenir une atteinte aux droits fondamentaux des citoyens européens.

En conséquence, la juridiction communautaire estime que « le droit de l'Union s'oppose à une injonction faite à un fournisseur d'accès à Internet de mettre en place un système de filtrage de toutes les communications électroniques transitant par ses services, lequel s'applique indistinctement à l'égard de toute sa clientèle, à titre préventif, à ses frais exclusifs et sans limitation dans le temps. »

Si l'arrêt ne concerne que les partis en présence, il donne cependant des indications et des limites à ne pas dépasser dans le filtrage des internautes. Il fournit des arguments pour les associations anti-filtrage, notamment dans l'optique d'une extension des contrôles sur les sites de streaming.

Les gammes Sage 30 et 100 s'affichent sous iOS et Android

Sage veut gagner des utilisateurs au-delà de sa sphère habituelle. Dans les PME de 5 à 200 salariés, où ses gammes Sage 100 et Sage 30 ont pris leurs aises au fil des ans, l'éditeur compte en moyenne 12% d'utilisateurs, ratio classique pour une solution de gestion qui cible les fonctions comptables, commerciales et logistiques et les ressources humaines.

Avec la Génération i7 qu'il lance cette semaine, Sage vise plus large. Il propose de paramétrer des interfaces simplifiées pour des utilisateurs plus occasionnels qui accéderont uniquement aux outils et données qui leur sont utiles. Ce peut être l'annuaire des clients ou des fournisseurs, par exemple, pour retrouver une adresse, ou encore une interface de saisie de commande.

L'objectif est de rendre l'usage du logiciel aussi simple que celui d'un site de e-commerce. Cette amélioration, apportée par l'arrivée de la technologie SET sur Sage 30 et 100, permet à l'ensemble des utilisateurs d'accéder aux logiciels à partir d'une connexion web. Et de travailler ainsi à distance si nécessaire.

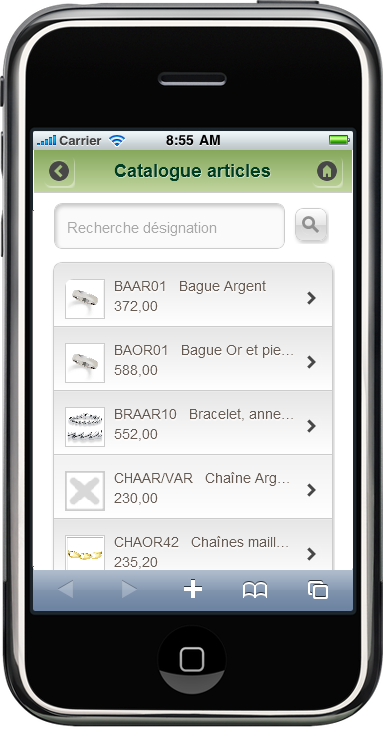

cliquer pour agrandir l'image

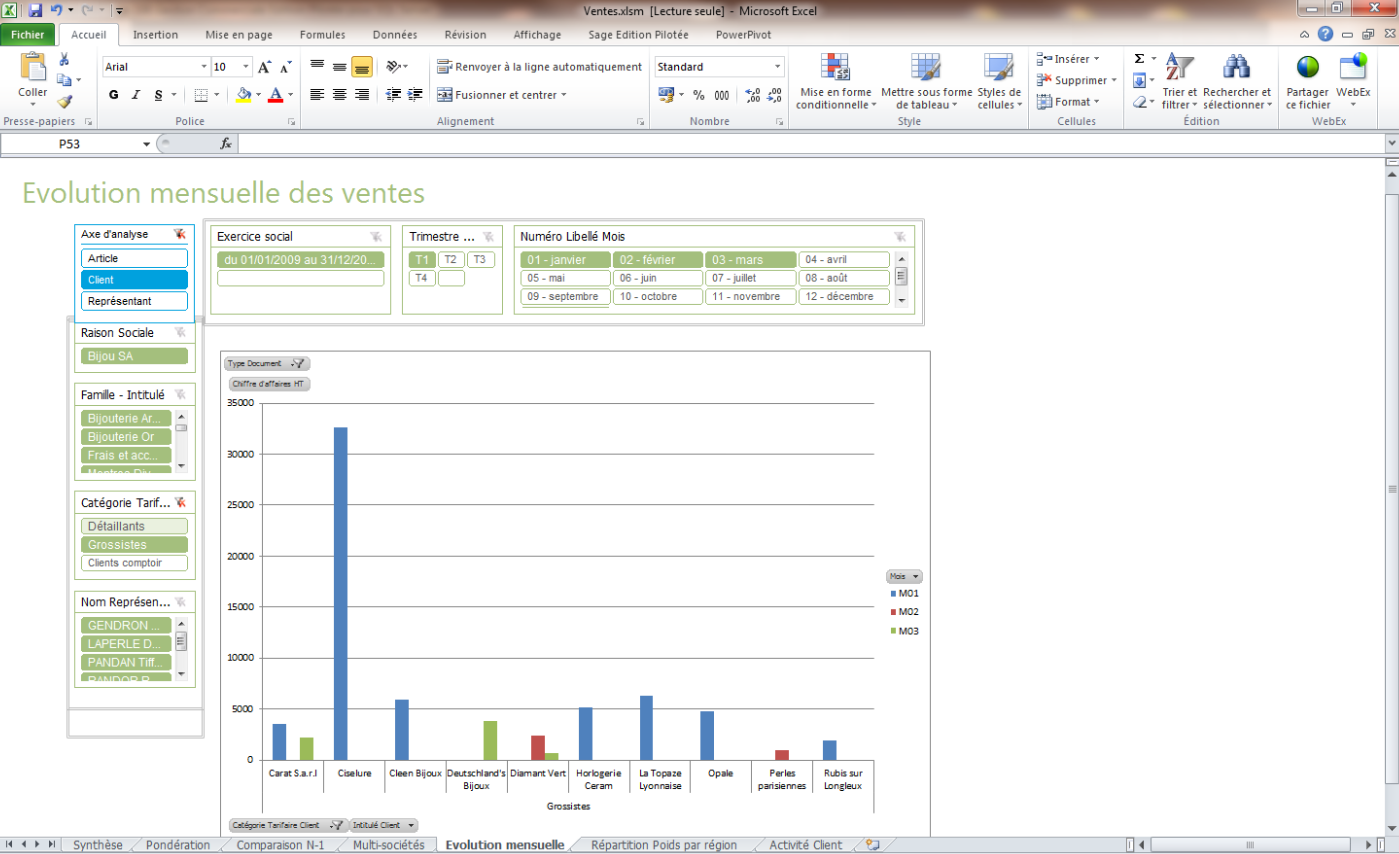

cliquer pour agrandir l'image

L'accès aux données (catalogue produits, commandes passées, etc.) peut aussi se faire depuis un terminal mobile fonctionnant sous iOS (iPhone, iPad) ou sous Android.

Objectif : 400 000 utilisateurs d'ici 12 à 18 mois

Actuellement, Sage dénombre environ 210 000 utilisateurs de ses gammes 30 et 100 (une même base de produit déclinée suivant la profondeur fonctionnelle requise par les clients et la taille de l'entreprise). En simplifiant l'accès à cette offre, il espère passer à 400 000 utilisateurs d'ici 12 à 18 mois. A terme, il a l'ambition d'en atteindre 600 000, « compte tenu des observations faites sur d'autres marchés », souligne Hémeric de Saint-Chamas, directeur général de la division PME de Sage.

Ces deux gammes fonctionnent sur base de données propriétaire Sage, sur SQL Server ou sur SQL Express. L'utilisation d'une base Microsoft permet de disposer des « états pilotés » qui fournissent à l'entreprise les indicateurs clés de son activité, à des fins décisionnelles. Avec la Génération i7, ces états peuvent être récupérés à partir du tableur Excel, ce qui autorise les utilisateurs à les modifier (cf écran ci-dessous).

Production et Gestion des affaires

Pour les utilisateurs métiers, les versions i7 s'enrichissent de deux offres complètes. D'une part, la gestion de production acquise par Sage avec le rachat d'Alcior, désormais intégrée à la gamme avec les technologies .Net. D'autre part, un module de gestion des affaires adapté aux besoins des sociétés de services. L'éditeur propose par ailleurs en standard quatre profils métiers présentant des interfaces utilisateurs type pour les fonctions de la vente, des achats, de la logistique et de la comptabilité.

Les clients existants pourront accéder aux versions i7 à partir de 500 euros HT. En complément, il existe un service de migration effectué à distance par Sage ou l'un de ses partenaires, pour environ 800 euros HT. Pour les nouveaux clients, le prix d'une licence Sage 100 Comptabilité est fixé à 1 400 euros HT et celui de la licence Sage 100 Gestion Commerciale à 2 400 euros HT.

Un éditeur dresse un palmarès des attaques DDOS dans le monde

Une attaque en déni de service distribué (DDoS) lancée à l'encontre d'une société asiatique de commerce électronique, pendant une semaine début novembre, a constitué jusqu'à présent l'incident le plus important de l'année dans ce domaine, selon Prolexic, une société qui protège les sites web contre de telles attaques. Quatre vagues successives ont été lancées à partir de botnets multiples entre le 5 novembre et le 12 novembre 2011, a précisé le spécialiste de la sécurité.

Ce dernier estime que jusqu'à 250 000 ordinateurs infectés avec le malware ont participé à l'attaque, nombre d'entre eux se trouvant en Chine. Au plus fort de l'assaut ces ordinateurs ont réalisé 15 000 connexions par seconde sur leur cible (la plateforme de la société de e-commerce), la noyant sous un trafic allant jusqu'à 45 Gbt/s, soit 69 millions de paquets par seconde indique Prolexic. Ce dernier n'a pas souhaité donner le nom de la société, qui est l'un de ses clients, en raison d'accords de confidentialité.

Des attaques pouvant être soutenues par l'Etat

La raison de l'attaque est inconnue, mais un utilisateur mécontent ou un concurrent effectuant un sabotage industriel sont deux des possibilités, a estimé Paul Sop, directeur technique chez Prolexic. « Parfois, nous voyons aussi une attaque soutenue par un Etat ou par des factotums, car une large quantité de paiements sur Internet sont effectués hors du pays dans le cadre des transactions de e-commerce », a-t-il ajouté. « L'Etat ne collecte pas d'impôts sur ces dernières, et dans certains pays, les transactions de e-commerce sont prises pour cibles ». Arbor Networks, un autre société qui lutte contre les attaques par déni de service, n'a pas eu d'informations sur cette attaque, mais a déclaré que la description réalisée par Prolexic était conforme aux données recueillies récemment.

L'ampleur du phénomène décrit par Prolexic est plausible, et se situe juste au-dessus de ce que nous avons pu voir au cours troisième trimestre, a pour sa part déclaré Jose Nazario, chercheur en sécurité chez Arbor Networks. Pour lui, et bien que ce type d'attaque soit jusqu' a présent la plus importante cette année, elle est loin d'être la plus massive de tous les temps. Le chercheur a rappelé que la plus grande attaque observée par Arbor en 2010 avait culminé à plus de 100 Gbt/s.

Des attaques moins puissantes mais plus nombreuses

Prolexic a également indiqué avoir observé des incidents de plus de 100 Gbt/s dans le passé. La firme considère que les attaques sont généralement moins puissantes aujourd'hui, mais que leur fréquence a augmenté. « Il ya encore des milliers de botnets capables de prendre 99% des sites web sur Internet » a exposé Paul Sop. « Actuellement, les pirates préfèrent utiliser la puissance combinée de plus petits réseaux de botnets au lieu d'en construire de plus grands. « Si vous vous appuyez sur un botnet géant il est probable que cela attirera davantage l'oeil des professionnels de la sécurité. Les attaquants savent qu'ils peuvent rester sous le radar si leur botnets contrôlent moins de 50 000 postes ».

Cette année, la plupart du trafic DDoS est sorti de l'Asie, mais le problème reste mondial. Par exemple, la semaine dernière Prolexic a enregistré un certain nombre d'attaques provenant d'Europe de l'Est. Toutefois, si l'on compte le nombre d'ordinateurs infectés qui ont participé à des attaques DDoS, la Chine et les États-Unis occupent les premières places.

(...)(24/11/2011 15:55:50)

Microsoft scrute Yahoo en vue d'une possible prise de participation

Des fonds d'investissements en collaboration avec Google jusqu'au Chinois Alibaba, le sort de Yahoo intéresse beaucoup de monde. Mais pour avoir accès au dossier et aux informations financières, le portail Internet demande la signature d'un accord de confidentialité, NDA (Non Disclosure Agreement). Or on apprend par le New York Times que Microsoft a signé cet accord pour avoir accès aux documents financiers et à l'état des lieux des différentes activités de Yahoo. Cependant, selon le journal économique, pas question pour la firme de Redmond de racheter la totalité du portail, mais plutôt de passer par un consortium (avec des fonds d'investissements) pour prendre des participations dans Yahoo. Microsoft se rappelle de l'échec de la précédente OPA sur Yahoo en 2008, mais surtout la société doit protéger son partenariat sur la partie publicité et l'intégration du moteur de recherche Bing sur le portail web.

Un intérêt croissant

Le regain d'intérêt pour Yahoo s'explique aussi par le récent licenciement de son PDG Carole Bartz. Certains lui reprochait notamment les faibles résultats du partenariat noué avec Microsoft et de bloquer les éventuelles propositions de rachat ou d'alliance. Le président du conseil d'administration du portail, Tim Morse, avait alors créé un comité exécutif pour travailler sur un « examen stratégique global » visant à obtenir le retour de la firme vers une piste de croissance. Cette analyse arrive peut-être à son terme et chacun fournit ses armes pour séduire et conquérir Yahoo.

Google protège son trafic HTTPS des attaques à venir

Google prend les devants. Il a modifié la méthode de chiffrement utilisée par ses services https, parmi lesquels se trouvent la messagerie Gmail, le traitement de texte en ligne Docs et le réseau social Google+, lancé fin juin. Le but est d'empêcher que le trafic qui transite actuellement sur ces services puisse être déchiffrés ultérieurement lorsque des avancées technologiques rendront cette manipulation possible.

Aujourd'hui, la majorité des services mettant en oeuvre https se servent d'une clé privée, connue seulement du propriétaire du domaine, pour générer des clés de session qui sont ensuite utilisées pour chiffrer le trafic entre les serveurs et leurs clients. Cette approche expose potentiellement les connexions en cas d'attaques ultérieures. « Dans dix ans, quand les ordinateurs seront beaucoup plus rapides, un adversaire pourrait casser la clé privée du serveur et rétrospectivement déchiffrer le trafic e-mail envoyé aujourd'hui », explique Adam Langley, l'un des membres de l'équipe de sécurité de Google, sur un blog officiel.

forward secrecy à l'oeuvre

Pour prévenir ce risque, assez faible mais néanmoins réel, Google permet d'utiliser par défaut la propriété de codage forward secrecy (ou PFS, perfect forward secrecy), qui implique de recourir à différentes clés privés pour chiffrer des sessions et de les détruire après un certain temps. De cette façon, un attaquant qui a réussi à casser ou à voler une seule clé ne sera pas en mesure de récupérer suffisamment de trafic e-mail sur une période couvrant plusieurs mois d'activité, indique Adam Langley. Il fait remarquer que même l'administrateur serveur ne pourra pas déchiffrer le trafic HTTPS rétroactivement.

Puisque SSL n'était pas conçu pour supporter des mécanismes d'échange de clé capable de mettre en oeuvre par défaut la propriété forward secrecy, les ingénieurs de Google ont dû mettre au point une extension pour la boîte à outils OpenSSL. C'est intégré à la version 1.0.1 d'OpenSSL qui n'a pas encore été publiée dans une version stable.

Supporté seulement par Firefox et Chrome

La nouvelle mise en oeuvre de Google HTTPS utilise ECHDHE_RSA comme clé d'échange et l'algorithme RC4_128 pour le chiffrement. Malheureusement, cette combinaison n'est supportée que dans les navigateurs Firefox et Chrome pour le moment, ce qui signifie que les connexions HTTPS sur Internet Explorer ne profiteront pas de cette fonction complémentaire de sécurité.

Ce n'est pas nécessairement un problème avec IE qui supporte en revanche la combinaison clé d'échange EDH (Ephemeral Diffie--Hellman) et RC4. EDH apporte aussi la propriété forward secrecy, mais Google a préféré ECDHE (Elliptic curve Diffie-Hellman) pour des raisons de performances.

La société de Larry Page prévoit d'ajouter le support d'IE à l'avenir et espère que son exemple encouragera d'autres fournisseurs de services utilisant HTTPS à mettre en oeuvre forward secrecy afin que cette propriété puisse un jour devenir la norme pour le chiffrement du trafic en ligne. (...)

Une base de données as a service pour Heroku de Salesforce.com

Heroku, filiale de Salesforce.com, vient de lancer sa base de données à la demande qui s'appuie sur le projet Open Source PostgreSQL. « Heroku Postgres a traité avec succès et en toute sécurité 19 milliards de transactions, et 400 millions de transactions supplémentaires sont traitées chaque jour, » a déclaré Heroku dans un blog. « Les clients qui utilisent le service peuvent se concentrer sur leurs tâches de développement d'applications, plutôt qu'à l'administration des bases de données, » a ajouté Heroku. L'option vient enrichir le service Database.com annoncé précédemment par Salesforce.com, qui ouvre l'accès de sa plateforme de développement Force.com à une infrastructure de bases de données.

Acquis par Salesforce.com l'an dernier, Heroku a hérité d'une participation significative dans le web et le développement d'applications pour les consommateurs, avec des objectifs semblables à ceux visés par Force.com dans le domaine des logiciels d'entreprise. Ceux qui choisissent Heroku Postgres seront « protégés de façon permanente » d'une panne de leurs bases de données, précise le message du blog. Le système « crée plusieurs copies, distribuées géographiquement, et prend en compte tous les changements au fur et à mesure de l'écriture des données, » indique encore le blog. « Et si un météorite anéantissait la côte Est, vous ne perdriez pas vos données ! » Heroku Postgres utilise une version standard, non modifiée, de PostgreSQL. « Tout client libpq peut tourner sans problème sur notre service. Et si jamais vous décidiez de revenir à votre propre DBA, c'est possible. Aucun verrouillage ne vous l'empêchera. »

Renforcer l'intérêt et fédérer autour de PostgreSQL

L'annonce pourrait avoir des conséquences positives pour PostgreSQL en général, comme l'a fait remarquer un observateur. « PostgreSQL est une technologie honorable et populaire à juste titre, même si MySQL a réduit l'écart technique, » a déclaré l'analyste Curt Monash de Monash Research. « PostgreSQL a manqué du support d'une communauté, qui apporte cohésion et pragmatisme au projet, ou d'un coach corporate efficace. Peut-être que la mise en place d'un ou plusieurs services cloud pourront combler l'écart. » VMware a également lancé il y a peu de temps un forfait basé sur PostgreSQL pour les déploiements cloud. Et au mois d'août dernier EnterpriseDB avait annoncé une version cloud de sa base de données avec des couches de fonctionnalités supplémentaires écrites en code Open Source PostgreSQL.

La tarification de Heroku Postgres commence à 200 dollars par mois pour 1.7 Go de cache, pour atteindre 6 400 dollars par mois pour 68 Go de cache. Toutes les bases sont livrées avec une capacité de stockage de 2 To, un monitoring 24/24, des instantanés quotidiens et un accès depuis n'importe quel client PostgreSQL. Comparativement, Database.com est gratuit pour un petit nombre d'utilisateurs et de données. Une fois ces limites dépassées, le prix pour les utilisateurs, les données et le nombre de transactions sont établis sur une base évolutive. « Si vous voulez une base de données classique, l'offre de PostgreSQL est plus logique que Database.com, » a déclaré Curt Monash. « Mais si vous êtes intéressé par toute la pile Force.com, alors Database.com s'avère être une bonne option. »

Produits innovants : Bluenove s'associe au programme de l'ESSEC, Centrale Paris et Strate College

La société de conseil IT Bluenove et le programme Création d'un Produit Innovant (CPI), mené conjointement par Centrale Paris, l'ESSEC et Strate Collège, annoncent la signature d'un partenariat de 3 ans autour de l'innovation et plus particulièrement de l'Open Innovation. Ce rapprochement s'inspire d'un modèle développé sur les Campus américains, notamment à l'Université de Stanford dans la Silicon Valley, visant à multiplier les passerelles entre les grands corps de l'enseignement et les entreprises.

Outre ces axes de recherche, Bluenove apportera son expertise en innovation aux 250 participants annuels du programme CPI pour favoriser l'innovation collaborative autour de quatre dimensions clés. Premièrement, le Design Thinking. Cette approche de l'innovation par les usages, l'observation terrain et les recherches ethnologiques utilise la sensibilité du designer couplée à une méthodologie de résolution de problèmes. L'objectif est de satisfaire les besoins des usagers, d'une façon technologiquement réalisable et commercialement rentable.

Deuxième axe, l'Open Innovation, ou l'utilisation par les entreprises de ressources externes pour leur R&D. Celle-ci conduit à faire travailler ensemble des populations mixtes d'ingénieurs, de managers et de designers. Le troisième axe, qui concerne l'entreprenariat, passera par la réalisation de projets concrets pilotés par des unités opérationnelles de l'entreprise et destinés à être commercialisés. Enfin l'impact sociétal constitue le quatrième volet du programme. Il vise à former des acteurs économiques, mus par des notions d'éthique et de responsabilité. (...)

Intel propose des puces Pentium Sandy Bridge pour les micro-serveurs

Intel a présenté la puce Pentium 350 qui s'adresse aux serveurs d'entrée de gamme. Le processeur dual-core fonctionne à une vitesse d'horloge de 1,2 GHz secondé par 3 Mo de cache. Comme les autres puces serveurs, la Pentium 350 n'intègre pas de circuit dédié au traitement graphique, comme c'est le cas de la plupart des processeurs d'Intel destinés aux ordinateurs portables et aux machines de bureau. Il bénéficie par contre de la micro-architecture Sandy Bridge.

La ligne, historique, de processeurs Pentium, existe depuis plus d'une décennie. Aujourd'hui, ces processeurs équipent principalement des ordinateurs portables et des machines de bureau premier prix. La puce Pentium d'Intel a longtemps été le processeur phare du monde PC, une position désormais détenue par les processeurs Core. Pendant un temps, le fondeur a commercialisé des puces Pentium III et Pentium II Xeon pour serveurs. Un porte-parole d'Intel a indiqué que la récente puce présentée était essentiellement destinée à des micro-serveurs, compacts et de faible puissance, utilisés comme serveurs web et pour la distribution de contenu en ligne. Le fondeur propose déjà des puces Xeon E3 - en attendant les E5 - et devrait bientôt lancer des puces basse consommation Atom 64 bits pour micro-serveurs.

Un recyclage opportun

« La sortie de ce processeur montre que, pour Intel, le Pentium peut-être encore utile, » a déclaré Dean McCarron, analyste principal chez Mercury Research. En plus des microserveurs, « le Pentium 350 pourrait également être utilisé dans des serveurs bon marché pour effectuer des tâches spécifiques comme le stockage partagé, le partage d'impression ou de documents, » a ajouté l'analyste. « C'est une réorientation», a déclaré Dean McCarron. Le Pentium 350 offre une alternative aux autres puces PC d'Intel, lesquelles pourraient aussi être utilisées dans les serveurs. Mais, si elles offrent des fonctionnalités supplémentaires comme le traitement graphique, elles coûtent aussi plus chères.

« Le processeur consomme 15 watts, et il y a peut-être la possibilité de l'intégrer dans des serveurs lames, » a déclaré l'analyste. Mais ce processeur ne vient pas en remplacement des processeurs Atom basse-consommation actuels d'Intel. Ces derniers sont plutôt destinés aux netbooks et aux tablettes, mais ils sont également utilisés dans les serveurs à haute densité comme le SM10000-64HD de SeaMicro pour le traitement de transactions dans le cloud. « Le fait de destiner la puce Pentium à des serveurs pourrait aussi signifier que le fondeur veut remplacer le Celeron, le processeur le plus bas de gamme d'Intel, par du Pentium, » a estimé l'analyste. Les processeurs Celeron sont utilisés dans des machines de bureau et des portables à bas prix, et dans quelques serveurs bas de gamme. Pour l'instant, Intel a refusé de fournir le prix de son Pentium 350.

D-Link mise sur le stockage et sur la surveillance IP

D-Link va profiter de la prochaine édition du salon IT-Partners (31 janvier et 1er février 2012) pour annoncer l'entrée en vigueur de nouvelles évolutions apportées à son programme partenaire. Aujourd'hui baptisé Partner +, ce dernier sera alors renommé VIP + (VIP pour Value In Partnership) et proposera aux revendeurs de pouvoir se certifier aussi sur les gammes de produits de stockage et de vidéosurveillance IP du fabricant. Jusqu'ici, les revendeurs labellisés de D-Link ne pouvaient prétendre qu'à une certification dans le domaine des réseaux et du Wi-fi, les marchés historiques du fabricant.

Si l'ajout de ces nouvelles spécialités au programme partenaire de D-Link s'explique par une extension de l'offre du fabricant au-delà son coeur de métier traditionnel, cette diversification n'en est pas pour autant très récente. L'entreprise commercialise en effet des caméras IP depuis près de 8 ans. En, outre, elle s'est lancé dans le stockage il y a quatre ans avec une offre de type NAS qui a été enrichie depuis par des NAS professionnelles et des SAN. « Nous nous sommes positionnés sur ces marché avec des gammes restreintes et les avons ensuite étoffées. L'an dernier, nous avons ainsi renouveler notre offre de caméras IP et intégrer la HD dans certains modèles en septembre 2011 », explique Marilyne Michel, la responsable de D-Link France. Résultat, le fabricant dispose aujourd'hui d'une trentaine de références de caméras IP et de dix références en matière de solutions de stockage. Plutôt qu'une diversification, c'est donc la volonté de D-Link de passer la vitesse supérieure sur ces deux familles de produits qui explique l'évolution de son programme partenaire.

80% de croissance attendus dans la vidéosurveillance IP en 2012

A l'heure actuelle, leurs ventes ne représentent que 30% du chiffre d'affaires de l'entreprise contre 70% pour les produits de commutation et les produits sans fil. Il pourrait en être rapidement autrement si D-Link parvient, comme il le prévoir, de faire progresser de 80% ses ventes de caméras IP et de 60% celles de ses produits de stockage. Ces chiffres peuvent paraître optimistes mais le fabricant dispose après tout d'une marche de croissance importante puisqu'il ne joue pas encore dans la cours des grands sur ces deux marchés.

(...)

EBG se penche sur l'impact de la mobilité et des réseaux sociaux sur le marketing

L'Electronic Business Group (EBG) est une communauté professionnelle de 550 entreprises (dont tout le SBF 120) qui organise de nombreux événements. Les 22 et 23 novembre 2011, sa conférence Mobile & Social Media a réuni plusieurs centaines de responsables à l'Espace Grande Arche à La Défense. Il a permis aux responsables marketing de découvrir les opportunités liées aux outils mobiles et sociaux. Pas d'annonce fracassante ou de grande innovation durant ces deux jours mais bien un petit cours de rattrapage pour qui n'est pas familier du « 2.0 », au fil de nombreuses interventions, souvent prestigieuses. Pour accueillir des intervenants de toute l'Europe, la manifestation était entièrement en anglais, y compris pour les interventions d'acteurs français.

« Le marché mondial du marketing et de la communication se déplace : géographiquement, la Chine est désormais quatrième, juste devant la France et derrière l'Allemagne ; en termes de médias, cela change autant au profit des nouveaux médias » a martelé Sir Martin Sorrell CEO de WPP, le premier groupe d'agences de communication au monde (Grey Global Group, Ogilvy & Mather, Young & Rubicam, Hill & Knowlton, Burson-Marsteller, Cohn & Wolfe...). Pour celui-ci, le développement du « social » et du « mobile » passera nécessairement par une consolidation des multiples plates-formes incompatibles entre elles qui existent aujourd'hui. Une telle consolidation est en effet nécessaire pour éviter la multiplication des développements technologiques pour un même service. Sir Martin Sorrell a notamment applaudi à la pénétration fracassante d'Android sur le marché du mobile.

Un consensus pour une révolution en devenir

Hugues Pietrini, président d'Orangina Schweppes, a confirmé l'évidence : l'émergence du digital transforme les pratiques du marketing. Au delà, pour Patrick Hoffstetter, « chief digital officer » de Renault rattaché au directeur du marketing, la révolution bouleverse les méthodes même de travail de toute l'entreprise.Les pratiques restent cependant en général basiques : Coca Cola anime, grâce à des community managers, une écosystème autour de pages de fans (avec une rentabilité annoncée comme supérieure à celle de publicités audiovisuelles), le fabriquant de jouets Lego incite ses clients à échanger des photos de leurs plus belles réalisations avec les briques en plastique...µ

Une des leçons de ces pratiques est, pour une fois, très morale : si on peut tromper un client plusieurs fois, si on peut tromper de multiples clients une seule fois, on ne peut pas tromper de multiples clients reliés dans une communauté de nombreuses fois. La clé de départ d'un bon marketing en ligne est donc... un bon produit. Sinon, le retour de bâton est vite terrible.

[[page]]

La recommandation et la viralité

Le développement du chiffre d'affaires passe ainsi de plus en plus par la recommandation de son service ou de son produit par des consommateurs. Or les médias sociaux permettent justement d'industrialiser à très grande échelle la recommandation. Un usage publicitaire des réseaux sociaux doit s'appuyer sur la viralité, donc l'envie des internautes de partager votre contenu avec leurs amis, ce qui implique que celui-ci doit être drôle et leur offrir un avantage.

Enrico Castellani, directeur marketing de Kimberly Clark, a ainsi présenté en détail la campagne pour la marque de couches-culottes Huggies en Italie. Pour se distinguer de ses concurrents, cette marque a misé sur la « réalité ». Au premier trimestre 2010, elle a travaillé sur les concepts de la campagne avec une série de blogueuses. Puis une publicité de lancement a été diffusée au cinéma pour amener le public sur le réseau social utilisé. Durant les deuxièmes et troisièmes trimestres, les clientes ont été incités à expliquer la véritable vie avec un bébé (autrement dit : l'enfer), au contraire des grands sourires de la plupart des publicités. En votant pour les meilleures histoires, les internautes gagnaient des bons de réduction. Ce dernier avantage reste en effet indispensable comme toutes les études le montre.

Le pilotage des actions sur les médias sociaux et notamment la mesure d'efficacité reste un problème. L'utilisation de tels coupons de réduction repérés comme venant de tel site à telle date est un bon moyen de tracer l'efficacité d'une campagne. « Compter les fans est insuffisant, il faut d'autres mesures clés de performances » a jugé Marion Bauer, directrice marketing de Vueling.

Faire venir en magasin

Mais la transformation de la « sympathie » en ligne en acte d'achat reste un grand problème récurrent. Or seul cet acte d'achat importe au final pour l'entreprise. Le commerce en ligne ne représentant que 15 à 20% du total, l'un des moyens d'y parvenir est d'amener les prospects en magasins à proximité de leur localisation (notamment en utilisant la géolocalisation du consommateur disponible sur les smartphones). Njara Zafimehy, COO de Scroon, a ainsi loué le site français « LaFourchette.com » comme un outil particulièrement précieux pour les restaurants : il permet de recommander des établissements et aussi de réserver une bonne table ainsi repérée. Pour lui, la somme des chiffres d'affaires des petites enseignes de proximité est et va rester supérieur au cumul de chiffres d'affaires des grands groupes de distribution. Et ce sont ces petites enseignes qui vont le plus bénéficier de la recommandation comme moyen de se promouvoir auprès de clients potentiels.

Mais, pour la plupart des directeurs marketing, l'usage des réseaux sociaux se résument bien souvent à lancer une vidéo virale. Un vrai travail comme celui de Voyages-SNCF reste l'exception.

| < Les 10 documents précédents | Les 10 documents suivants > |