Flux RSS

108538 documents trouvés, affichage des résultats 4941 à 4950.

| < Les 10 documents précédents | Les 10 documents suivants > |

(16/02/2011 15:01:18)

Selon Forrester, les premiers clouds privés seraient voués à l'échec

Les analystes de Forrester n'ont pas de nouvelles très encourageantes pour les fournisseurs IT qui mettent en place leurs premiers cloud en interne. Selon eux, cette infrastructure est susceptible d'échouer. D'un autre côté, les mêmes analystes insistent sur le fait que « c'est une bonne chose, » parce que cet échec permettra de réussir par la suite. « La plupart de ces entreprises ne sont pas encore prêtes à utiliser un cloud interne. Néanmoins, nous pensons que, en 2011, les départements Infrastructure et Opérations (I&O) vont commencer à en déployer un certain nombre. Ces efforts sont très probablement voués à l'échec. Mais grâce à cette première étape et à l'expérience qu'elle apportera, il sera possible d'en tirer de précieux enseignements sur ce qui est vraiment nécessaire pour gérer un tel environnement, » ont écrit les deux analystes de Forrester, James Staten et Lauren Nelson (en illustration principale), dans leur rapport intitulé « 2011 Top 10 IaaS Cloud Predictions pour I&O Leaders » et destiné aux responsables des départements Infrastructure et Opérations.

Clouds privés : les entreprises ne sont pas encore assez matures

Selon Forrester, « il faut plus de maturité dans la virtualisation et des améliorations dans la normalisation, l'automatisation et l'infrastructure pour s'engager avec succès dans la mise en place d'un cloud interne capable de fournir des services équivalents à ceux offerts par des IaaS (Infrastructure-as-a-Service) comme l'Elastic Compute Cloud d'Amazon. » Toujours selon le rapport, « la plupart des entreprises n'ont pas la maturité nécessaire en terme de virtualisation et ne sont pas prêtes à mettre en oeuvre le niveau d'automatisation et de standardisation exigé par un environnement cloud. » Comme l'expliquent les deux experts, « la perspective architecturale change : le cloud met fin à l'architecture en silos, pour un pool unique de ressources permettant deux niveaux de priorité élémentaires - un concept révolutionnaire et un défi pour les gestionnaires I&O. La gestion des meilleures pratiques viendra avec l'expérience, et le plus tôt sera le mieux. En même temps, même si l'infrastructure n'est pas encore prête, mieux vaut ne pas éviter de considérer une telle mise en route. »

Des solutions clouds déjà pérennes

Cela ne veut pas dire pour autant que toutes les tentatives sont vouées à l'échec et qu'il n'y aura pas de success-story. Comme l'a récemment rapporté notre confrère Network World, de grandes entreprises comme Bechtel et First American Corp ont déjà fait le bilan des avantages acquis grâce à des clouds en interne. De nombreux éditeurs de logiciels comme VMware, Joyent, Red Hat, Platform Computing ou la start-up Nimbula fondée par l'équipe à l'origine d'Amazon EC2, proposent également des outils d'automatisation pour virtualiser l'infrastructure et offrir des fonctionnalités semblables à celle du cloud. Pour ceux qui ne veulent pas mettre en place une nouvelle infrastructure en interne, Amazon, Terremark, Savvis, Rackspace et d'autres proposent également des serveurs virtuels hébergés. Une étude réalisée au cours du troisième trimestre 2010 par Forrester auprès de 1252 décideurs IT en matière de serveurs et de stockage a révélé que 15% d'entre eux prévoient d'acheter des ressources IaaS à Amazon ou à d'autres vendeurs, et 6% ont déjà franchi cette étape. Parmi les entreprises de plus de 20 000 salariés, 20% d'entre elles prévoient d'adopter l'IaaS et 8% ont déjà adopté ce type de solution.

Parmi les points soulevés par le rapport de Forrester on note :

- Dans leurs entreprises, les responsables IT «aguerris» ne doivent pas s'opposer aux adopteurs précoces qui souhaitent acheter de nouveaux services de cloud computing.

- Les cloud privés hébergés par des fournisseurs, avec une offre de ressources dédiées, et non partagées, seront trois fois plus nombreux que les cloud déployés en interne.

- Les cloud publics, mis en place par des associations ou un groupe d'entreprises en vue de partager les coûts, vont se développer dans certains secteurs, notamment la biotechnologie, l'enseignement supérieur et les organismes gouvernementaux.

- Le cloud computing haute performance sera plus largement répandu grâce à de nouvelles applications qui permettent d'accéder à la puissance des technologies de grille sans les complications de leur mise en oeuvre.

- L'économie du cloud va grandement s'améliorer. Les développeurs vont pouvoir créer de petites applications qui pourront, si nécessaire, être élargies pour des usages à grande échelle en fonction des besoins. De nouveaux outils vont permettre de comparer plus facilement les coûts, quitte à avoir recours à plusieurs services cloud pour obtenir le meilleur prix.

- Les outils analytiques du cloud vont stimuler la business intelligence (BI) en proposant des services plus rapides et plus rentables.

- Les nouvelles fonctionnalités de Windows Azure et d'autres nuages vont aider les entreprises à profiter de l'analyse des données, ce qui pourrait potentiellement inciter les clients à devenir eux-mêmes des fournisseurs de BI par une valorisation de leurs données internes et la mise en place de nouveaux services susceptibles de générer des revenus.

- Les normes du cloud vont continuer à bouger en 2011. Cette tendance rend « le marché du cloud... trop immature pour une normalisation. » Cela ne doit pas empêcher les clients d'adopter des services cloud. Ils doivent s'orienter vers des fournisseurs qui ont du souffle et sont suffisamment répandus sur le marché pour ne pas prendre le risque de miser sur un perdant.

- La sécurité du cloud « aura fait ses preuves », mais les professionnels de l'IT doivent analyser attentivement la sécurité, la confidentialité, la conformité, le cadre juridique et contractuel de l'ensemble de leurs applications et ne qualifier que celles qui sont prêtes pour être proposées dans les services cloud. Les utilisateurs doivent aussi se diriger vers des produits « capables de sécuriser les données avant qu'elles ne soient rendues disponibles dans le cloud. »

Illustration principale : Lauren E Nelson, chercheur chez Forrester

Un utilisateur consulte les applis de son iPhone 84 minutes par jour

Les fonctions traditionnelles du téléphone (appel, emails, SMS) ne représentent que 40% du temps passés sur iPhone. Les 60% restants sont dédiés aux Web et aux applications.

Un possesseur d'iPhone dispose en moyenne de 108 applications installées dont 88 téléchargées depuis l'app store. Les applications gratuites sont plébiscitées avec une répartition de 58%, devant le payant (23%) et le standard (19%).

Appsfire a réalisé son enquête en étudiant mille iPhone synchronisés avec son service.

RSA 2011 : La virtualisation, clé de la sécurité dans le cloud

Dans une allocution prononcée lors de la RSA Security Conference qui se tient actuellement à San Francisco, Art Coviello, patron de RSA (la filiale sécurité d'EMC), a apporté un peu d'optimisme dans le domaine de la sécurité dans le cloud computing. S'il a reconnu la légitimité des préoccupations des entreprises en matière de déplacement de données et d'applications dans le cloud, celui-ci a affirmé que les méthodes pour traiter ces problèmes étaient plus proches de nous qu'on ne le pensait. « Dès aujourd'hui, nous pouvons faire en sorte que le cloud soit digne de confiance, » a-t-il déclaré. Pour lui, l'une des clefs consiste à cesser de dépendre des modèles de sécurité conçus pour les infrastructures physiques. Au lieu de cela, les entreprises doivent penser à tirer parti des technologies de virtualisation pour renforcer la sécurité, la visibilité et le contrôle dont ils veulent bénéficier dans les environnements cloud.

La sécurité doit évoluer avec le cloud

Une solution de sécurité reposant sur VMware

« Les économies et l'adaptabilité que permet le cloud, poussent un nombre croissant d'entreprises à l'adopter, indépendamment des questions de sécurité et du contrôle dont elles peuvent disposer, » a déclaré le patron de RAS. Aussi contre-intuitif que cela puisse paraître, «si l'effet de levier agit correctement, la virtualisation peut devenir une solution pour dépasser le niveau de contrôle et de visibilité qui existe aujourd'hui dans les environnements physiques, » a-t-il estimé. « Dans le cadre du travail propre à RSA pour aller vers ces modes de sécurisation, l'entreprise a lancé un service Cloud Trust Authority, » a indiqué Art Coviello. Celui-ci tire profit des outils de virtualisation de VMware (une autre filiale d'EMC) pour délivrer un ensemble de services pour gérer les identités et surveiller la conformité dans le cloud.

Illustration : Art Coviello, patron de RSA

Panel Apec entreprise 2011 : L'emploi informatique repart

Les entreprises IT interrogées par l'Apec, dans le cadre de son panel annuel, ont formulé des prévisions de recrutements plutôt optimistes. C'est en particulier le cas des informaticiens qui pourraient se voir proposer entre 29 000 et 32 000 postes de cadres, soit 9 à 21% de plus que l'an dernier. « Sur un marché de l'emploi globalement dégradé, un segment tire son épingle du jeu, celui des emplois qualifiés », a déclaré Jacky Chatelain, directeur général de l'Apec, à l'occasion d'un point presse. « Ainsi, tout nous laisse penser que la bonne orientation du marché de l'emploi des cadres, où l'informatique figure en bonne place, ne se démentira pas en 2011. » La fonction IT, locomotive de la filière cadres, représente à elle seule près de 17% des recrutements totaux, soit 6 embauches prévues sur 10. Dans un contexte économique moins tendu, les entreprises de la high-tech semblent avoir repris confiance, et la prudence voire le pessimisme affichés un an auparavant sont moins fréquemment de mise. Au niveau sectoriel, les services, secteur poids lourd du recrutement de cadres avec 7 embauches sur 10, pourrait connaître une croissance proche des 12% (3% pour le bas de la fourchette). Selon l'Apec, c'est notamment le dynamisme des activités informatiques qui explique cette bonne orientation du secteur.

Les débutants moins courtisés que leurs aînés

Contre toute attente, le bilan 2010 est globalement positif et l'on peut estimer que cette année fut celle du redressement du marché de l'emploi des cadres. Selon le décompte que vient de diffuser l'Apec, 26 500 recrutements d'informaticiens ont été effectués l'an dernier (sur un total de 164 600 recrutements de cadres), contre 21 700 en 2009, soit une hausse de 22%. Ainsi, l'informatique figurait en tête eu la filière cadres, juste derrière la fonction commerciale. Seul bémol toutefois : 2011 devrait être nettement plus favorable aux profils expérimentés et devrait laisser à la traîne les débutants qui peineront à décrocher un job. « Les profils qui possèdent entre 3 à 5 ans d'expérience semblent profiter du redressement économique », souligne Pierre Lamblin, directeur des études et recherche à l'Apec. Celui-ci pointe l' appétence des entreprises à l'égard de ces derniers, notamment dans l'informatique, «La population des jeunes diplômés dans les recrutements est anormalement basse », note le responsable des études et recherche. « L'accès au premier emploi des jeunes diplômés est devenu plus difficile car ils sont en concurrence directe avec les promotions précédentes. » L'enquête sur la situation des jeunes diplômés de la promotion 2009, conduite par l'Apec en 2010, montrait en effet, que dans l'informatique, les télécoms et les technologies multimédia, 70% des jeunes diplômés de 2009 étaient en poste, soit une baisse de 10 points par rapport à ceux de la promotion 2008 et de 21 points par rapport à ceux de 2007.

Note méthodologique : Le panel Apec entreprise 2011 a été réalisée auprès d'un échantillon de 11 000 entreprises du secteur privé, représentant 2 000 000 salariés dont 340 000 cadres. Les sociétés ont été contactées du 2 novembre au 20 décembre 2010.

Illustration : Jacky Chatelain, directeur général de l'Apec. Crédit photo :Christophe Lebedinsky

(...)

Des services santé sur mobiles

La première solution mobile, imaginée en collaboration avec MyGlucoHealth, permettra aux diabétiques de mesurer leur taux de glucose dans le sang par l'intermédiaire du Bluetooth. Disponible sur les mobiles simplifiés "Doro PhoneEasy", ce service vise notamment à faciliter la transmission des résultats des tests de glucose au portail sécurisé MyGlucoHealth ou au médecin traitant, mais également de renforcer la "surveillance à distance par les professionnels de santé".

Un second service, développé avec la société Medixine, rappellera les patients à l'ordre en cas de non prise de médicaments. Baptisée "Doro EasyMed Reminder", cette application disponible sur les mobiles "Doro PhoneEasy 338 gsm" donnera l'occasion aux patients d'envoyer un SMS confirmant la prise de médicaments grâce à une simple touche. En cas d'oubli, un rappel sera envoyé sous la forme d'alerte SMS.

"La fourniture en direct de solutions mobiles pour aider et améliorer la santé et les conditions de soins présente beaucoup d'avantages. Nos solutions permettent aujourd'hui de cibler des besoins simples au sein des familles avant de s'orienter vers les professionnels de santé et les budgets publics", explique Jérôme Arnaud, président de Doro.

Crédit photo : Myglucohealth (...)(16/02/2011 10:03:49)Le supercomputer Watson d'IBM défie les candidats du jeu Jeopardy (MAJ)

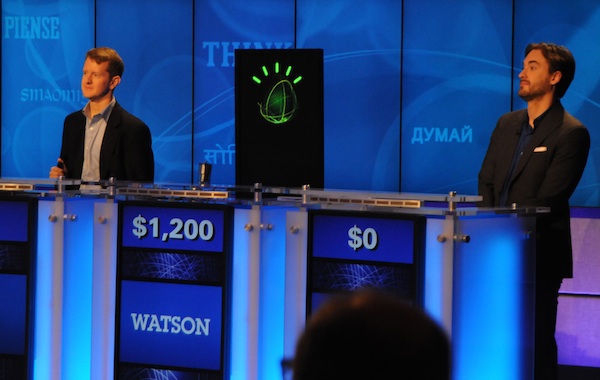

En 1997, IBM avait fait une percée avec Deep Blue, qui était parvenu à vaincre le champion mondial d'échecs Gary Gasparov. En 2011, la société revient à la charge avec un autre ordinateur, Watson, nommé en l'honneur du fondateur d'IBM, Thomas J. Watson.

Cette fois-ci, l'ordinateur se mesurera aux deux plus grands gagnants de l'histoire de Jeopardy, soit Ken Jennings et Brad Rutter. Ken Jennings détient le record du plus grand nombre de parties consécutives gagnées à Jeopardy, soit 74. Ses gains à vie se chiffrent à 2,5 millions de dollars. Brad Rutter détient quant à lui le record des gains à l'émission, soit 3,2 millions de dollars.

Ken Jennings et Brad Rutter, les deux lauréats du jeu Jeopardy

Autopsie d'un superordinateur

Le Watson est particulièrement impressionnant. Cet ordinateur est composé de 10 racks contenant chacun 9 serveurs Power 750 montés en réseau. Chaque serveur, dont la valeur se chiffre à environ 300 000 dollars, possède 32 coeurs qui peuvent gérer un total de 128 tâches en parallèle. L'ordinateur dans son ensemble compte 2 880 coeurs, peut effectuer 11 520 tâches en parallèle, possède une mémoire vive de 15 000 gigaoctets (Go) et une puissance totale de 80 téraflops. Selon les dirigeants d'IBM, ces performances placent Watson dans le Top 100 des ordinateurs les plus puissants au monde en ce moment.

À titre comparatif, Deep-Blue avait une puissance totale de 1 téraflop et celle de la salle des serveurs de l'usine d'IBM Canada à Bromont frôle les 4 téraflops. Pour chaque téraflop de puissance, un ordinateur peut effectuer mille milliards d'opérations à la seconde.

Une intelligence artificielle de plus en plus fine

Si le matériel qui compose Watson est imposant, le vrai défi pour l'équipe d'IBM fut tout autre qu'avec Deep Blue, selon Éric Paradis, spécialiste consultant en technologies de l'information chez IBM Canada à l'usine de Bromont. « En matière de logiciel, les échecs, c'est relativement simple. Avec Deep Blue, en 1997, il s'agissait surtout d'un exploit matériel. Il s'agit d'une planche de 64 cases avec des règles et des pièces qui ont toutes un rôle limité. L'algorithme était assez simple: à chaque coup, il fallait prévoir le prochain mouvement de l'adversaire et ensuite établir quel serait le meilleur mouvement à partir de toutes les combinaisons possibles », dit-il.

Dans le cas de Watson, le défi est de traiter le langage naturel. L'ordinateur est équipé d'une série d'algorithmes qui ont nécessité plusieurs années de recherche et même certains partenariats avec des universités. M. Paradis précise que contrairement à la croyance populaire, Watson n'entend pas et ne peut donc reconnaître la voix. Il reçoit les questions en texte, de même que les réponses de ses concurrents. À défaut d'entendre, il doit donc comprendre les questions : « Les questions de Jeopardy peuvent contenir des jeux de mots, des farces, des doubles sens... Par exemple, si vous cherchez Mercury dans un moteur de recherche Internet, vous pouvez obtenir des résultats sur un métal, sur une planète, sur une vieille marque de voitures et même sur le chanteur Freddy Mercury. Un seul mot peut donc avoir différents sens, ce qui rend le défi de la compréhension très complexe », dit-il.

Entretien réalisé par Denis Lalonde, rédacteur en chef du magazine Direction informatique.

[[page]]

A défaut d'Internet, une base de connaissance interne

De plus, Watson n'a pas accès à Internet. Il contient l'équivalent de 200 millions de pages de contenus, structurés (anatomie, atlas géographiques...) et non structurés (tels que journaux, documents historiques, scénarios de films...). Il est également doté de connaissances élémentaires logiques, par exemple que la pluie est mouillée, qu'un père est toujours plus vieux que son fils et que quelqu'un qui est décédé ne peut revenir à la vie. Les questions à Jeopardy peuvent toucher à une multitude de catégories, allant du sport à l'histoire et à la littérature, en passant par la géographie, ce qui nécessite des connaissances générales très poussées. « Un algorithme très important est aussi celui de l'acquisition et de l'indexation dynamique de connaissances. Cela signifie que Watson s'améliore avec l'usage », affirme M. Paradis, rencontré à Bromont quelques jours avant l'affrontement entre la machine et l'homme.

L'ordinateur possède également la capacité de s'adapter à une catégorie. Si, à un moment durant l'émission, on recherche uniquement des noms de joueurs de hockey et que Watson ne l'a pas réalisé au début, il peut faire l'ajustement pour répondre aux questions restantes dans cette catégorie précise. Comme les mauvaises réponses à Jeopardy font perdre des points, Watson doit également autoévaluer le degré de confiance en ses réponses.

Préparer l'après-Jeopardy

Évidemment, l'objectif ultime derrière la conception de Watson est de réaliser une percée au niveau de l'intelligence artificielle qui permettrait à IBM de vendre des clones de son superordinateur pour divers types d'applications commerciales, industrielles ou publiques.

Éric Paradis explique que Watson pourrait par exemple servir de référence au niveau médical. « L'ordinateur, avec ses algorithmes et son architecture, pourrait contenir l'ensemble de la littérature médicale et tirer des conclusions à partir de symptômes, de résultats et de tous les outils à la disposition des médecins. Ces derniers ont accès à des connaissances phénoménales, mais qui ne sont pas toujours organisées. Le système pourrait alors intervenir », dit-il. C'est pourquoi IBM tient à ce que Watson soit capable d'évaluer lui-même sa capacité à donner de bonnes réponses. Dans le cas d'un diagnostic médical, la marge d'erreur est nulle.

Un match en deux manches

Après la première manche, Watson et Brad Rutter ont terminé à égalité avec 5 000 dollars chacun, alors que Ken Jennings a remporté seulement 2 000 dollars. Et lors de la seconde et dernière manche, Watson a pris le pas sur ses deux adversaires : le supercomputer d'IBM a remporté des gains d'un montant de 35 734 dollars contre 10 400 pour Brad Rutter et 4 000 pour Ken Jennings. Big Blue a indiqué qu'il reverserait cette somme rondelette à des oeuvres.

(...)

Annuels Infodis : activité stable en 2010

Près de 83% des revenus du groupe et 90% de son résultat ont été générés par sa filiale Infodis IT (services informatiques) qui regroupe 200 de ses 250 collaborateurs. Visuladis (distributeur en vidéo numérique), sa seconde filiale, a vu son chiffre d'affaires s'apprécier de 20% à 3 M€ en 2010. Elle devrait enregistrer une croissance de son activité de l'ordre de 10% en 2011.

L'année en cours devrait être l'occasion pour le groupe Infodis de réaliser des opérations de croissance externe. En janvier, l'entreprise a en effet recruté Gérard Guerguerian au poste de directeur général (le groupe en compte trois), un ancien vice-président senior d'Atos Origin. Avocat spécialisé dans les fusions acquisistions, il a pour mission de faire doubler la SSII de taille très rapidement.

Trimestriels SII : des revenus en hausse de 21,6% au 3e trimestre

Suite à l'annonce de ces résultats, SII a relevé ses prévisions pour l'ensemble de son exercice 2010/11 qui devrait se terminer sur un chiffre d'affaires de 220 M€ (avec une croissance organique supérieure à 13%) contre 213 M€ annoncés précédemment. Si cet objectif était atteint, la société de services enregistrerait alors un revenu annuel en hausse de 15,7%.

Les dernières activités d'Arès finalement cédées à GFI

L'interminable feuilleton Arès a pris fin lundi soir à l'issue du jugement prononcé par le Tribunal de commerce d'Evry. Comme nous l'avancions, le 20 janvier dernier, c'est GFI qui reprend les dernières activités d'Arès : Arès : une reprise casse-tête

Exceptionnellement dans ce genre de dossier, GFI donne des chiffres. La SSII a payé 2,9 millions d'euros (ME) pour reprendre le fonds de commerce d'Ares en France (et au Luxembourg). Ce qui représente 433 salariés, dont 404 en France et 29 au Luxembourg (le personnel administratif n'est pas repris). Et un chiffre d'affaires de 28 ME sur dix mois en 2011. En année pleine, en 2012, ce CA serait de 32 ME prévoit GFI. Cette activité sera logée dans la division « application services et infrastructure services » de GFI. La direction de GFI souligne la complémentarité des offres rachetées par rapport à celles de GFI notamment dans le secteur public et celui de la retraite.

Arès, créée en 1985, fut placée en redressement judiciaire le 18 juillet 2008 et en liquidation judiciaire le 25 novembre 2010. Son histoire récente est celle d'un lent dépeçage.

Tribune de Patrick Benazet, Web 2.0 : vers des identités numériques truquées ?

Flash sur l'internet ! C'est désormais le réflexe qu'on peut avoir assez spontanément pour dresser l'inventaire des données personnelles d'un individu. Serons-nous bientôt tous des grands-hommes dans l'encyclopédie du Web, statut réservé jusqu'alors dans les manuels aux individus ayant marqué l'histoire? Le processus de signification assisté par le réseau nous conduit-il vers plus de facilité ou vers plus de difficulté dans la construction de la connaissance des personnes ? L'information literacy est-elle à la portée des internautes rendus à la facilité apparente procurée par les moteurs de recherche sociaux? Nous allons tenter de trouver des réponses à ces questionnements.

Le résultat produit par les outils de recherche documentaire désormais disponibles sur l'internet a des effets assez remarquables tant sur les contenus que sur les cheminements cognitifs, effets que nous analysons à travers les signes composites qu'ils génèrent à un moment où l'identité numérique devient une préoccupation forte des dirigeants de ce monde.

Dès le début des années 1990 et la conception du World Wild Web, la problématique de l'indexation des données était mise en avant. Structuré en pages, le Web faisait ressortir dès le départ le problème du repérage des informations et un « web sémantique » était mis en projet dans la perspective d'une montée en charge des contenus que l'avenir a largement confirmé puisqu'on exprime le nombre de pages en ligne en 2011 à la puissance douze, c'est à dire en trillon (1000 milliards) (1) dont environ 40 milliards seraient indexées par Google contre 26 millions en 2006. Ce projet de web sémantique visait à fournir les outils de structuration de l'information sur la base d'une catégorisation des données (2) associée à de puissants outils d'indexation. L'engouement des internautes depuis l'arrivée du Web 2.0 au milieu de la première décennie des années 2000 n'a pas laissé au web sémantique le temps de s'imposer et donne aujourd'hui lieu à une extraordinaire pagaille sémiotique. Le Web 2.0 a été l'avènement des « réseaux sociaux », sortes de lieux de rencontre dans la sphère virtuelle où chaque individu de notre planète disposant d'un accès à l'internet est libre de publier tout type d'information relative à tout type de sujet et en particulier relative à lui-même (3). Apportant naturellement une réponse à la question de la localisation des données sur les réseaux sociaux, les moteurs de recherche se sont penchés sur ce nouvel environnement donnant naissance aux « moteurs de recherche sociaux ». Même si les technologies mises en oeuvre pour localiser et restituer l'information ne sont pas exposées en toute transparence, la technique du « mashup » est largement usitée. Alors arrêtons-nous quelques instant sur ce mashup. La traduction directe de l'anglais nous donne le mot purée en français, le résultat produit par le mashup s'apparenterait-il à une purée informationnelle ?

1 Google n'indique désormais plus le nombre de pages indexées et le trillon est un ordre de grandeur car le concept de page ne correspond plus à ce qu'il était au départ du fait de l'arrivée des blogs des tchats et autres réseaux sociaux qui donnent aux internautes la possibilité de générer des milliers de pages en une seule seconde.

2 De nombreux dispositifs ont été proposés : des méta-descripteurs aux langages naturels.

3 Facebook est certainement l'exemple le plus représentatif de cette dynamique des réseaux sociaux.

Pour lire la suite de cette tribune rendez-vous dans notre Blog Experts

| < Les 10 documents précédents | Les 10 documents suivants > |