Attention, un twittos peut cacher un autre. Alors que la grande majorité des utilisateurs de Twitter font un usage « normal » de la plateforme en donnant leur avis, humeur et/ou diffusant des liens légitimes sur tout un tas de sujets, d'autres en revanche en travestissent l'usage. Identifiés en tant que « bots », Twitter estime ainsi à 8,5% la part de cette frange d'utilisateurs que l'on peut aisément faire rentrer dans la case des indésirables. Sont ainsi considérés comme des bots par Twitter, les mécanismes automatisés permettant de diffuser du spam (spambots), faire des copier-coller de tweets appartenant à des sources légitimes mais en n'hésitant pas au passage à insérer des micro-URL dans les liens pour récupérer une contrepartie pécunière de génération de trafic (paybots). Ou encore les influence bots qui tentent d'influencer et d'amener les conversations Twitter sur un terrain propice à la propagande pouvant aller jusqu'à constituer un vecteur de diffusion des idées et opinions radicalisées en tous genres, voire de désinformation.

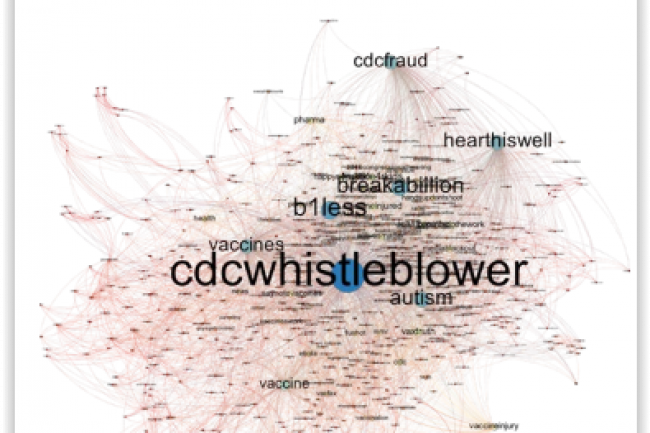

C'est dans ce contexte que le département recherche de la défense américaine (Darpa) a conduit le concours « Twitter Bot Detection Challenge » à cheval entre les mois de février et mars 2015, mais dont les résultats viennent juste d'être rendus publics. Cette compétition visait à identifier 39 bots d'influence pro vaccination créés de toute pièce dans un environnement créé sur la base de l'API Twitter contenant plus de 7 000 comptes et 4 millions de tweets. Ont participé, 6 équipes comprenant des chercheurs et des éditeurs, à savoir l'Université de Californie du Sud (USC), les Universités de l'Indiana et du Michigan (DESPIC), Georgia Tech, Sentimetrix, IBM et Boston Fusion.

Le machine learning nécessaire mais pas suffisant

Au terme du concours, c'est l'équipe de Sentimetrix qui a obtenu le plus haut score (sur la base de critères combinant notamment rapidité et précision de la recherche de bots), devant l'USC, DESPIC et IBM, pointant seulement à la 4e place. Avec un score final de 24, l'équipe Georgia Tech s'est toutefois faite largement distancée. « Les trois gagnants ont trouvé que les les techniques de machine learning utilisées seules étaient insuffisantes en raison d'un manque de données d'entraînement. Cependant, un processus semi-automatisé incluant le machine learning s'est avéré utile », peut-on lire dans le rapport. Parmi les variables qui ont été analysées afin de détecter les bots, on trouve notamment la syntaxe, la sémantique, les comportements utilisateurs, les profils utilisateurs ainsi que des fonctions réseaux.

Commentaire