Petit à petit Snowflake monte en puissance sur l’IA. Après avoir dévoilé en novembre dernier Cortex (service facilitant la création d’applications à base d’IA), investi dans Mistral AI, le spécialiste du datawarehouse cloud lance un LLM nommé Arctic. Le nom peut prêter à confusion, car l’éditeur américain dispose aussi d’une famille de modèles sous la même appellation. Selon Shridar Ramaswamy, fondateur de Neeva racheté par Snonwflake en mai 2023 et successeur de Frank Slootman en février dernier au poste de CEO, « Arctic est une étape importante pour la société et les équipes de recherche en IA avec une performance et une transparence accrues ».

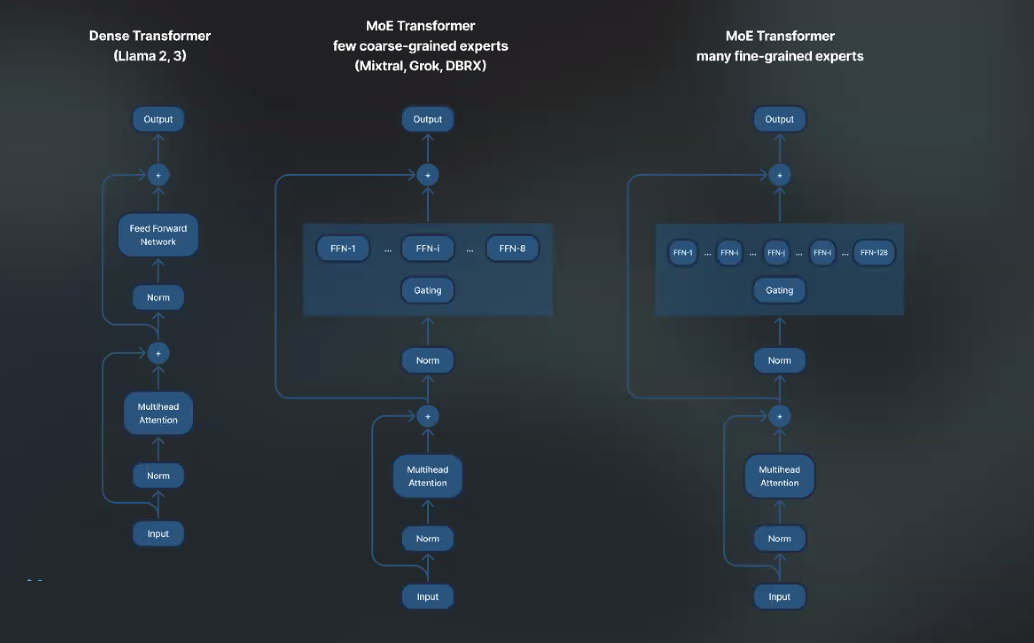

En termes de capacité, le LLM de Snowflake embarque 480 milliards de paramètres. Mais c’est sur l’architecture open source choisie que la société entend faire la différence en s’appuyant sur le MoE (mixture of experts). Yuxiong He, ingénieure émérite chez Snowflake et à l’origine de la bibliothèque d’optimisation de deep learning Deepspeed tente une métaphore hospitalière pour l'expliquer, « au début les patients sont reçus par un généraliste qui n’aura pas nécessairement le bon diagnostic et va les orienter vers un expert (cardiologue, psychiatre ou rhumatologue). Celui-ci pourra également demandé conseil auprès d’experts encore plus pointus (chirurgie cardiaque, allergologue,…) ». Dans le cas d’Arctic, les tâches IA sont divisées en plusieurs composants (experts). Chaque expert est conçu pour des travaux spécifiques et les résultats sont plus précis. Le modèle est capable de mobiliser 128 experts pouvant activer chacun 17 des 480 milliards de paramètres pendant l’inférence et l’entraînement.

Snowflake se sert de l'architecture MoE pour son LLM Arctic. (Crédit Photo : Snowflake)

Un entraînement optimisé et une transparence revendiquée

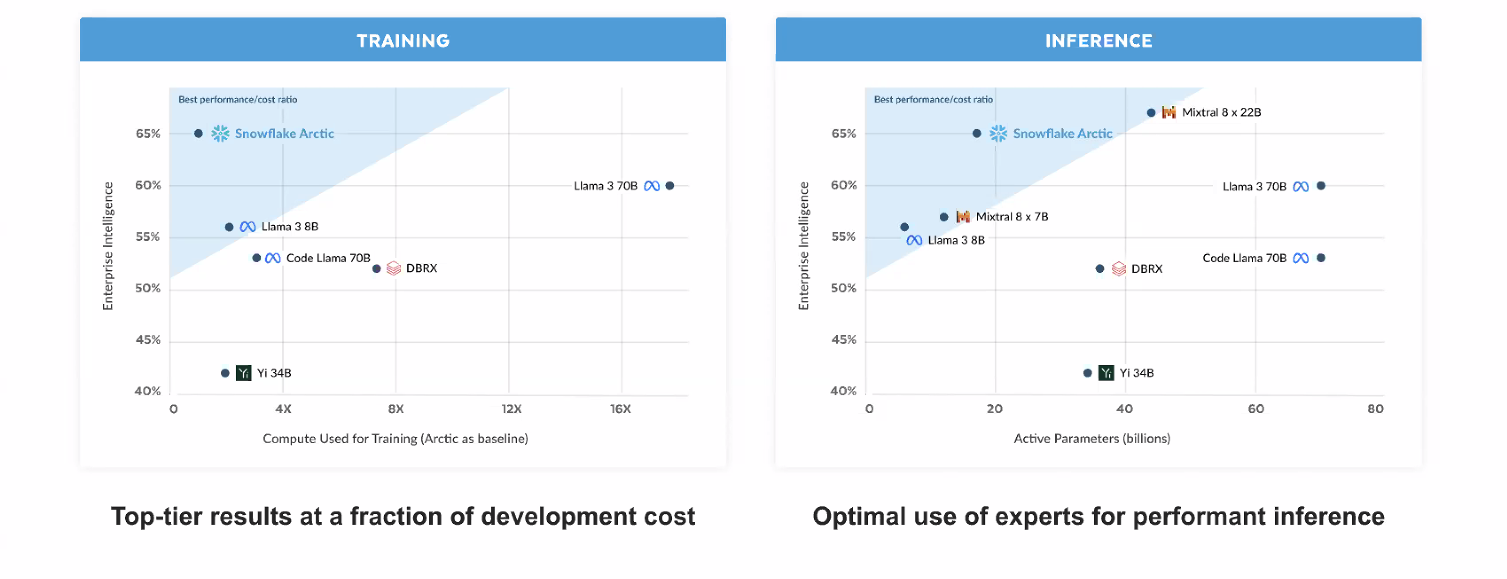

Ce choix d’architecture (adoptée par d’autres éditeurs de LLM comme Mixtral 8x7B ou Llama) apporte plusieurs bénéfices : des inférences plus efficaces et un entraînement moins cher. L’équipe de Yuxiong indique avoir développé Arctic en moins de 3 mois et dépensé un huitième du coût de formation de modèles comparables. Le LLM a été entraîné sur des instances P5 d’AWS. Snowflake oriente Arctic pour des usages entreprises comme la génération de requête SQL ou de code et obtient des performances accrues dans ces domaines. L’autre aspect sur lequel la firme américaine insiste, c’est le caractère « réellement » ouvert de son LLM. Elle publie le poids de son modèle, ainsi que les détails de la recherche qui a conduit à sa formation sous licence Apache 2.0. Elle prévoit de publier d’autres éléments prochainement.

Les coûts de développement et les performances d'Arctic mis en perspective face à la concurrence. (Crédit Photo : Snowflake)

Arctic est disponible au sein de Cortex cité précédemment et sera accessible sur d’autres plateformes : AWS , Hugging Face, Lamini, Azure de Microsoft, le catalogue d’API de Nvidia, Perplexity, Together AI. Avec Arctic, Snowflake se lance donc dans la guerre des LLM avec un peu de retard par rapport à des concurrents directs comme Databricks (avec DBRX) ou les différentes déclinaisons de Llama de Meta.

Commentaire