En direct de Munich. L’Hadoop Summit, renommé il y a quelques mois DataWorks Summit, a posé ses valises à Munich du 5 au 6 avril pour son édition 2017. C’est la 5ème année qu'Hortonworks et Yahoo organisent en Europe cette conférence consacrée aux technologies big data. En dehors de la sortie d'HPD 2.6, version majeure de la distribution Hadoop d'Hortonworks, qui vient booster les requêtes SQL, trois thématiques sont abordées cette année, nous a exposé Shaun Connolly, responsable de la stratégie de l'éditeur, lors d'un point presse. Premièrement, il sera fortement question de la valeur apportée par les données en mouvement (data in motion) combinées avec les données au repos (data at rest). Le deuxième focus portera sur la transition d'Hadoop vers le cloud et la troisième thématique abordera l'intelligence artificielle et l'apprentissage machine qui se nourrissent de la donnée.

Les informations extraites des données en transit - provenant de l'IoT, des réseaux sociaux, des parcours sur le web ou des logs aux serveurs - complètent les données « at rest » gérées dans les environnements Hadoop et les datawarehouses et permettent d'ouvrir de nouveaux champs d’application. Hortonworks répond à ces deux approches avec son offre DataFlow connectée à sa plateforme HDP. DataFlow est issue du rachat d’Onyara, le créateur du projet Apache Nifi conçu pour automatiser les flux de données entre des systèmes. A Munich, Rajnish Verma, recruté en janvier au poste de président et COO d’Hortonworks (précédemment COO de Tibco Software) a cité en exemple une compagnie d’assurance calculant des primes en temps réel, « ce qui était pratiquement impossible à faire il y a à peine 3 ans ». Dans le domaine médical, il a évoqué le cas d’UNOS (United Network for Organ Sharing), qui met à disposition en quasi temps réel une base de données détaillées sur les dons d’organe.

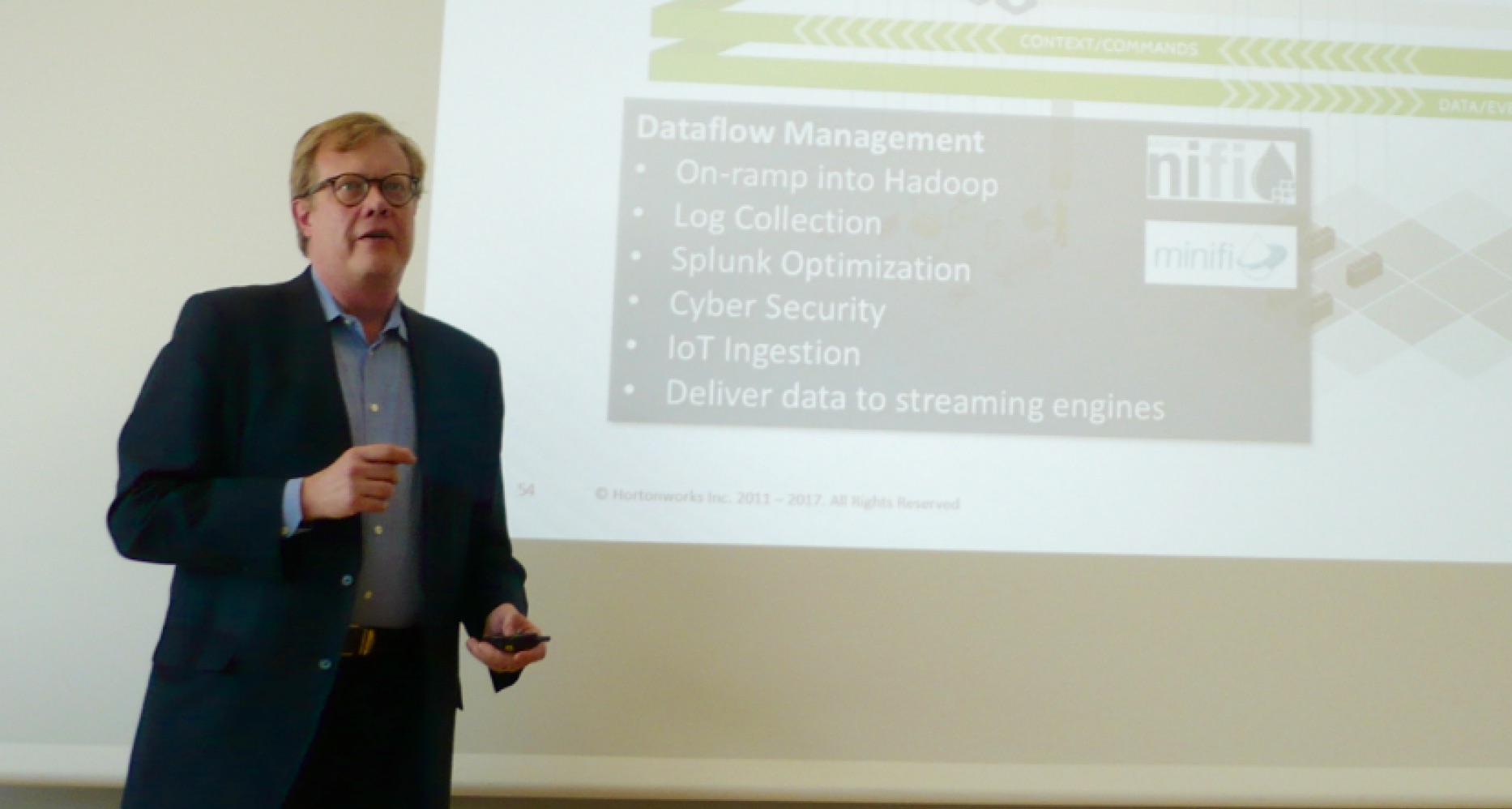

Shaun Connolly, chief strategy officer d'Hortonworks, lors de son intervention en amont de DataWorks 2017. (crédit : LMI/MG)

Data Cloud for AWS pour exploiter Spark et Hive avec S3 et RDS

Du côté de la transition des projets vers le cloud, Hortonworks Data Platform était déjà disponible sur la marketplace de Microsoft Azure. Depuis quelques mois, HDP l’est aussi sur celle d’Amazon Web Services. L’offre Data Cloud for AWS permet de faire tourner des charges de travail Apache Hadoop, Spark et Hive dans le cloud public, intégrées avec les services de stockage S3, la base de données RDS et EC2. « Nous avons une grande variété de clients qui se tournent vers le cloud », a indiqué Shaun Connolly. En dehors d’Azure (Microsoft est un partenaire privilégié d’Hortonworks) et d’AWS, certains clients exploitent également HDP sur Google, a indiqué le responsable de la stratégie.

Au passage, Shaun Connolly a insisté sur la prépondérance incontestable du rôle joué par les technologies open source dans le big data, en particulier la fondation Apache, pour porter vers les entreprises des projets tels que Hive, HBase, Spark, Kafka, Storm ou NiFi. A cet égard, il qualifie de « génération Github » les développeurs qui contribuent maintenant depuis toutes ces années à enrichir ce patrimoine commun.

HPD 2.6 : Hive 2.0 avec LLAP et propriétés ACID

A sa suite, Scott Gnau, le CTO d’Hortonworks, a présenté la version 2.6 de HDP, développée prioritairement pour le cloud. Elle sort bien sûr aussi on premise, sur serveurs x86 et, c'est tout nouveau, sur Power System d’IBM. L'un de ses apports principaux est l'accélération des requêtes SQL par le support de Hive 2.0 et de la fonctionnalité LLAP (Low Latency Analytical Processing). A travers une mise en cache avancée, « les requêtes interactives se font en quelques secondes », pointe Scott Gnau. Cela répond aux besoins des projets en temps réel qui ont fortement augmenté, selon l’éditeur, à côté des traitements effectués classiquement en mode différé (batch) sur les bases Hadoop. Cette version de HDP apporte aussi à Apache Hive les propriétés ACID (atomicité, cohérence, isolation, durabilité) utilisées en standard avec SQL, ce qui permet d’effectuer des mises à jour rapides et des requêtes sur le même moteur. « Toute application Hive peut en tirer parti, c’est probablement l’une des fonctionnalités les plus intéressantes jamais livrées », s’enthousiasme Scott Gnau. Toutes ces évolutions permettent aussi d'optimiser l'exploitation des datawarehouses dans lesquels les entreprises ont lourdement investi. Sur ce terrain, Hortonworks entretient depuis longtemps un partenariat étroit avec Teradata.

A Munich, Scott Gnau, CTO d'Hortonworks, a par ailleurs rappelé les apports de l'offre DataFlow dans l'IoT. (crédit : LMI/MG)

Parmi les autres avancées de HDP 2.6, les data scientists disposent d’une expérience utilisateur améliorée, d'une part avec Spark 2.1, d'autre part avec la dernière version de Zeppelin (interface web utilisée pour les analyses visuelles interactives avec SQL, Scala ou Python). On peut maintenant configurer Zeppelin pour authentifier les utilisateurs à travers les annuaires LDAP et via une connexion SSL chiffrée. Du côté des fonctions de sécurité centralisée, le temps de synchronisation est réduit sur Ranger et Atlas pour les entreprises gérant des bases utilisateurs importantes. Ranger permet d’assurer la sécurité de façon cohérente au sein d’un cluster Hadoop, tandis qu’Atlas fournit des outils de gouvernance pour gérer la conformité à travers les métadonnées dans et au-delà de la pile Hadoop. Les améliorations apportées ont par exemple étendu à HDFS, Kafka et HBase le support de la politique basée sur des tags dynamiques.

Commentaire