Flux RSS

108538 documents trouvés, affichage des résultats 9121 à 9130.

| < Les 10 documents précédents | Les 10 documents suivants > |

(08/02/2010 17:57:27)

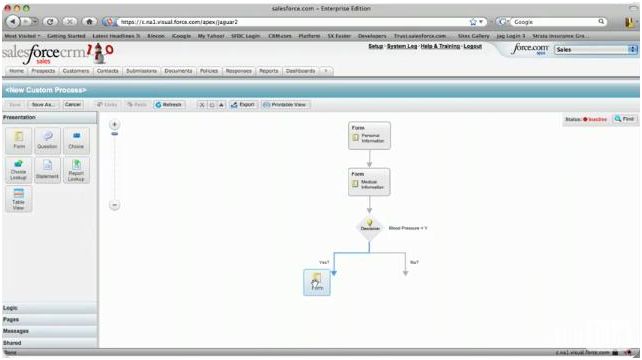

Un outil pour créer des processus métiers sur Force.com

Salesforce.com ajoute à sa plateforme de développement dans le cloud (Force.com) un outil graphique de conception et de déploiement de processus métiers. Issu du récent rachat de la société britannique Informavores, Visual Process Manager se compose de quatre éléments. L'interface Process Designer, du type de celle que l'on utilise pour construire des organigrammes par glisser-déposer d'objets, permettra d'élaborer différents types de processus métiers : script d'appel d'un client pour le télévendeur, suivi d'une réclamation client, procédure de recouvrement d'une facture, gestion des contrats, etc. Process Simulator sera utilisé pour simuler les processus avant leur déploiement, afin de repérer et rectifier les conflits entre les actions. Real-time Process Engine est le moteur d'exécution. Enfin, Process Wizard Builder servira à développer des systèmes d'assistance pour guider l'utilisateur lors de l'exécution des processus. Ces derniers peuvent aussi être déroulés sur un site Web ouvert au public.

L'outil est déjà disponible, au prix de 50 dollars par utilisateur et par mois pour les utilisateurs des éditions Enterprise et Unlimited de Salesforce.com.

Sur Force.com, les développeurs disposent déjà du langage Apex et de l'environnement de conception d'interface utilisateurs, Visualforce. Avec la mise à disposition de Visual Process Manager, Salesforce cherche à accroître le nombre de personnes susceptibles de développer sur sa plateforme, estime China Martens, analyste du cabinet 451 Group. Selon elle, en se focalisant sur le langage Apex et sur des modèles de développement plus sophistiqués, lors du lancement de Force.com, l'éditeur n'a pas attiré une audience aussi large que ce qu'il espérait. « Les utilisateurs plus enclins à utiliser des outils de type 'pointer-cliquer' ne les ont pas vraiment rejoints ». (...)

Sur Force.com, les développeurs disposent déjà du langage Apex et de l'environnement de conception d'interface utilisateurs, Visualforce. Avec la mise à disposition de Visual Process Manager, Salesforce cherche à accroître le nombre de personnes susceptibles de développer sur sa plateforme, estime China Martens, analyste du cabinet 451 Group. Selon elle, en se focalisant sur le langage Apex et sur des modèles de développement plus sophistiqués, lors du lancement de Force.com, l'éditeur n'a pas attiré une audience aussi large que ce qu'il espérait. « Les utilisateurs plus enclins à utiliser des outils de type 'pointer-cliquer' ne les ont pas vraiment rejoints ». (...)

Mardi 9 février, journée européenne de l'Internet

La Journée pour un Internet plus sûr (Safer Internet day), initiée en 2004 par la Commission européenne, a lieu mardi 9 février. A l'heure de l'explosion des réseaux sociaux en ligne, cette manifestation a pour but de sensibiliser les internautes les plus jeunes des dangers qui peuvent exister sur la Toile. Une campagne sera notamment lancée pour encourager les adolescents à "réfléchir avant de publier". Selon la Commission européenne, les sites de socialisation (Facebook, MySpace, etc.) comptent plus de 41,7 millions d'utilisateurs réguliers en Europe, dont une grande partie sont des enfants et des adolescents. A l'horizon 2012, ce chiffre devrait passer à 107 millions. Bruxelles estime que ces jeunes internautes "ne réalisent pas toujours que les informations personnelles qu'ils publient telles que des photos ou des vidéos restent en ligne et sont accessibles à tous, ce qui les expose à des risques tels que le harcèlement en ligne et les sollicitations d'adultes à des fins sexuelles en ligne". D'où le thème de 7ème édition de la Journée pour un Internet plus sûr : "Tu publies ? Réfléchis !". Une campagne, lancée à partir de mardi 9 février dans plus de 60 pays dans le monde, sensibilisera les jeunes internautes sur les possibilités qu'ils ont de contrôler leur identité en ligne en utilisant les options de paramétrage des sites de socialisation. La Commission européenne publiera également un rapport sur la façon dont une vingtaine d'entreprises signataires d'un accord en 2009 ont mis en oeuvre des mesures pour améliorer la sécurité des mineurs qui utilisent des sites de socialisation. Facebook, MySpace, Dailymotion ou encore Skyrock s'étaient notamment engagés par cet accord à mettre place des dispositifs de sécurité pour protéger leurs jeunes utilisateurs. Par ailleurs, un site Internet dédié met avant plusieurs reflexes à adopter par les jeunes utilisateurs de réseaux sociaux, comme ne pas répondre aux messages de harcèlement, dénoncer des contenus choquants aux autorités, ou parler avec une personne de confiance des problèmes rencontrés en ligne. En décembre 2008, l'Union européenne avait adopté un programme couvrant la période 2009-2013 qui consacre la somme de 55 millions d'euros pour le financement d'actions visant à rendre l'Internet plus sûr pour les enfants. Site : www.keepcontrol.eu (...)

(08/02/2010 17:32:34)Fast Search: Microsoft abandonne les version Linux et Unix

Lors du rachat de l'entreprise norvégienne spécialisée dans la recherche de données pour entreprises Fast Search en 2008, la firme de Redmond avait annoncé qu'elle continuerait à proposer et à améliorer ses plateformes de recherches fonctionnant sous Linux et Unix. « Depuis deux ans, nous n'avons fait que ça» affirme Bjorn Olstad, directeur technique de Fast Search et ingénieur chez Microsoft. Cependant, les versions proposées cette année seront les dernières à être compatibles avec les systèmes d'exploitation Linux et Unix. Bjorn Olstad affirme que c'est une décision logique de la part de Microsoft : « même si je comprends que le changement vers Windows sera compliqué pour beaucoup de nos utilisateurs, je suis convaincu que cela nous facilitera la tâche pour développer des innovations pour notre système. Microsoft fera en sorte de simplifier un maximum cette transition pour les utilisateurs concernés ». Le directeur technique a ensuite expliqué que les prochains outils de recherche et interfaces utilisateurs fonctionneront encore sur Windows, Linux et Unix. En effet, ils dépendront du core ESP 5.3, un noyau soi-disant prévu pour les 10 années à venir. Pour bénéficier des innovations Windows et des services Cloud, les utilisateurs restés sous Unix ou Linux devront cependant utiliser une plateforme d'architecture mixte. « Cette annonce n'implique pas d'action immédiate, j'espère que la plupart d'entre vous garderont leur installation actuelle en attendant » ajoute Bjorn Olstad. « Un nombre significatif de personnes utilisent Fast Search sous Linux ou Unix » affirme Jared Spataro, directeur de la section recherche chez Microsoft, sans donner de chiffres. « Nous faisons cette annonce aujourd'hui pour permettre à ces utilisateurs d'avoir assez de temps pour se préparer » ajoute-t-il Selon Whit Andrews, un analyste du cabinet d'études Gartner, ce changement est une grande surprise. « Je pensais honnêtement que, pour continuer à bien développer leur solution, garder la plateforme Linux était une chose primordiale. La promesse de Microsoft concernant la compatibilité de leur système offre un certain confort poursuit-il, les utilisateurs de Linux ne seront pas exclus puisqu'ils auront encore la possibilité d'utiliser Fast Search pendant au moins 10 ans ». Enfin, même s'il a affirmé qu'il n'y avait pas de version stand-alone de Fast Search prévue pour le moment, Jared Spataro a confié qu'une étude de marché de Microsoft avait révélé une forte demande et surtout un grand besoin pour un tel produit sur le marché. (...)

(08/02/2010 17:15:38)Moonlight 3.0, la technologie Silverlight sur Linux, arrive en version alpha

Selon une information publiée sur le site du projet Mono, la version 3.0 de Moonlight, le plugin pour navigateur Internet qui permet de développer des applications web riches dans un moteur de rendu vectoriel, est maintenant disponible en version alpha. Cette mouture permet de porter d'exécuter les applications web développées avec Microsoft Silverlight - un concurrent de Flash, de Flex, de JavaFX et de Quicktime - sur les plateformes Linux et Unix. Selon un communiqué publié par Novell, le sponsor du projet Mono, la version bêta annoncée pour cet été, sera suivie de la version finale à l'automne. « La nouvelle édition comporte des capacités d'infrastructure qui rapprochent Moonlight 3 de Silverlight 3, » a déclaré Novell. Précisons toutefois que Microsoft vient de dévoiler la béta publique de Silverlight 4. Moonlight 3.0 supporte aujourd'hui le démultiplexeur MP4, bien qu'il n'existe pas encore de codecs associés, à moins qu'un développeur ne se charge de les créer à partir du code source et rende le plugin capable d'interpréter les codecs de FFMpeg. Le communiqué signale aussi la présence d'un début de virtualisation de l'interface utilisateur et d'une couche noyau au sein de la plate-forme. « Le coeur de Moonlight est maintenant séparé du moteur qui gère le système de fenêtrage. Cela devrait permettre aux développeurs qui ne sont pas en X11/Gtk+-centric de faire le portage de Moonlight » a déclaré Miguel de Icaza. La version alpha 3.0 supporte également le Binding/BindingExpression (l'interfaçage) et la mise à jour des API. Un outil de développement SVN (Subversion) de Silverlight 3.0 apporte le support du pixel shader, un système qui travaille sur la luminosité individuelle des pixels développé par David Reveman. La page de téléchargement de Moonlight 3.0 insiste sur le fait que le projet n'en est qu'à un stade alpha et appelle les utilisateurs à la prudence. Elle indique notamment qu'il y a « plusieurs nouveaux sous-systèmes dans Silverlight 3 (comme la gestion des pixel shaders, la messagerie locale, la couche client HTTP) qui mettent en oeuvre des vecteurs d'actions qui n'ont pas encore été ni implémentées ni vérifiées et conseille de les faire tourner sur des ordinateurs qui ne sont pas utilisés en production. Selon le texte, cette situation va progressivement évoluer au cours des versions bêta. Les développeurs peuvent d'ailleurs consulter « l'état des dispositifs de sécurité de Moonlight sur la Moonlight Status Page». (...)

(08/02/2010 17:12:00)Le marché des logiciels et services ne repartira doucement que mi-2010, selon PAC

« Doucement » : c'est le mot choisi par Pierre Audoin Consultants (PAC) pour qualifier la reprise dans les logiciels et services en 2010. Un diagnostic bien étayé, puisque l'étude est mondiale, tous les bureaux de PAC dans le monde y sont associés. Le cabinet prévoit une croissance de 0,9% dans les logiciels et de 1% dans les services entre 2009 et 2010, à l'échelle mondiale. Les chiffres ont été respectivement de -3,8% et de -2,2% entre 2008 et 2009, et de +5,5% et de +4,9% entre 2007 et 2008. La profession s'habituait à ces 4 à 5% de croissance annuelle. « Mais 2009 fut une année de décroissance relativement importante » commente Frédéric Giron, directeur de la filière IT Services de PAC (*), « 2010 ne permettra pas de retrouver la croissance passée, le secteur reprendra des couleurs, mais son environnement économique restera toujours difficile. Nous sommes donc sur un scénario de reprise douce pour le second semestre 2010. En 2011, on devrait commencer à se rapprocher des 4 à 5% de croissance passés ». PAC anticipe +5% pour les logiciels et +4,4% pour les services entre 2010 et 2011. La pression restera forte sur les prix A quelques variantes près, ces tendances sont valables pour tous les pays développés. La France ne connaît pas de situation vraiment différente. Elle a été plutôt moins touchée que les pays comparables en 2009, mais pour autant ne reprendra pas plus rapidement. Les phénomènes qui expliquent la crise de 2009, dans les logiciels et services, et qui ont fait souffrir les SSII et les éditeurs, vont se prolonger. PAC parle délicatement d'une « optimisation » des budgets des entreprises clientes. En clair : « la préoccupation principale des clients reste la maîtrise de leurs coûts. Tous les moyens sont bons pour diminuer l'enveloppe budgétaire. L'idée c'est de continuer les projets avec des budgets plus serrés, de faire autant, avec moins ». Cette pression sur les prix sera donc toujours aussi forte pour les prestataires. Elle s'accompagne d'une diminution par les clients du nombre de leurs partenaires, d'interventions des directions achats, de nouvelles procédures dans l'élaboration des contrats, de pression sur les taux journaliers. Bref, à client inventif devrait répondre des prestataires également plus innovants. Ils doivent se montrer plus industriels dans leurs processus et trouver de nouvelles attitudes en clientèle, souligne PAC. Autre conséquence, la consolidation pourrait s'intensifier dans le secteur, surtout parmi les SSII de taille moyenne. (*) Il quitte cette direction pour rejoindre en Inde, Springboard Research un autre cabinet d'étude, partenaire de PAC, mais évoluant sur toute l'Asie. (...)

(08/02/2010 12:52:39)Efficience énergétique au menu du Green Grid

Lors de son troisième forum annuel, le Green Grid, consortium d'entreprises du secteur informatique, chargé d'améliorer le rendement énergétique des datacenters, a dévoilé deux nouveaux outils à destination d'une meilleure efficience énergétique. En premier lieu, l'évaluateur de rendement énergétique s'applique à plusieurs scénarios selon la topologie du réseau, l'architecture choisie, les équipements connectés, la charge de travail et les contraintes d'espaces. Les résultats statistiques, ainsi fournis, doivent guider les responsables des systèmes d'information dans leurs choix et l'optimisation du rendement des centres de données. Le deuxième outil, baptisé PUE (Power Usage Effectiveness) mesure à intervalles réguliers le niveau d'énergie utilisé par le site par rapport à celui du matériel informatique utilisé. Cette mesure est importante pour améliorer l'efficacité du rendement énergétique des datacenters. Elle vient compléter et améliorer l'outil de mesure sur les systèmes de refroidissements des salles. En effet, des données plus fines sur l'implication des matériels informatiques dans la consommation énergétique peuvent orienter les décideurs et les équipementiers vers des solutions de virtualisation ou des procédés de refroidissement plus adaptés. Les deux outils seront disponibles en ligne à la fin du premier trimestre 2010. Formation et alliance avec Data Center Pulse Par ailleurs, le Green Grid a annoncé le lancement d'un cours en ligne intitulé « Data Center 101 : Constrained Capacity » pour aider les exploitants et les responsables des datacenters à comprendre le vocabulaire technique, ainsi que les solutions à apporter pour améliorer l'efficience énergétique. Parallèlement, le consortium continue de travailler sur le livre blanc concernant l'impact de la virtualisation sur l'infrastructure physique des datacenters. Enfin, le Green Grid a noué une alliance avec Data Center Pulse, une communauté mondiale d'utilisateurs qui regroupe des propriétaires et des exploitants de datacenters. Cet accord a pour mission de répondre de façon homogène aux besoins énergétiques de la communauté informatique. (...)

(08/02/2010 16:00:47)Des datacenters labellisés Energy Star dès juin

L'Agence américaine pour la protection de l'environnement (Environmental Protection Agency, EPA) est en train de boucler les travaux du programme Energy Star pour les datacenters qui, pense t-elle, sera opérationnel en juin. « L'objectif est de sensibiliser les entreprises et de les inciter à améliorer l'efficacité énergétique de leurs centres de données, mais aussi de leur donner un moyen de suivre dans le temps l'efficacité des projets », a déclaré Alexandra Sullivan, membre de l'EPA, lors de la Green Grid Data Center Conference qui s'est tenue à San Jose, en Californie. Les centres de données souhaitant prendre part au programme disposeront d'un outil en ligne pour évaluer leur efficacité énergétique sur une échelle de 1 à 100. Les datas centers qui obtiendront un score supérieur ou égal à 75 pourront faire, auprès de l'EPA, une demande de certification afin d'obtenir le label Energy Star. L'EPA fortement impliquée dans les datas centers L'Agence américaine pour la protection de l'environnement est devenue de plus en plus active dans les datacenters. Elle a déjà mis en place un programme Energy Star pour les serveurs x86, et son programme pour les équipements de stockage est en cours. Elle a aussi commencé à travailler sur un programme Energy Star pour les systèmes UPS, les systèmes d'alimentation sans coupure. Tous ont été conçus pour aider les entreprises à choisir des produits éco-suffisants en énergie. Le programme élaboré pour les centres de données est un peu différent dans ce sens qu'il se veut plus incitatif. Du fait de la grande sensibilisation du public aux questions environnementales, l'EPA espère que les entreprises verront dans la norme Energy Star un moyen de mieux vendre leurs produits. L'EPA qualifie déjà l'efficacité énergétique d'une vingtaine de types de bâtiments différents, y compris les bureaux et les hôpitaux. Les critères essentiels sont la surface au sol et le temps d'occupation. Mais pour les centres de données, elle a du élaborer un système d'évaluation différent. Dans leur cas, l'évaluation se fera largement fonction du PUE (Power Unit Efficiency), qui mesure la puissance énergétique totale fournie à un datacenter, divisée par la quantité effectivement dépensée par les équipements informatiques, qui échappe à la dissipation par des systèmes de refroidissement ou des équipements électriques inefficaces. L'évaluation de l'EPA prendra également en compte la production d'énergie par les systèmes UPS. « Cela signifie que, même si les centres de données ayant de bons scores PUE seront les mieux classés, ce ne sera pas le seul facteur d'évaluation », a déclaré Alexandra Sullivan. Le PUE comme étalon, mais l'EPA reste ouverte Mais le programme risque de faire débat. Certains participants à l'événement Green Grid ayant été surpris que d'autres critères ne soient pas pris en considération. Par exemple, si un centre de données est situé dans un région froide ou chaude, ou le niveau de redondance que cela procure. Selon Don Klein, vice-président du marketing et du développement chez Modius, qui fabrique des appareils mesurant la consommation d'énergie des datas centers, « il faut prendre en compte la situation géographique, parce que c'est plus facile d'avoir un score PUE faible si le centre se trouve dans une région froide. » Mais ce n'est pas l'avis d'Alexandra Sullivan. Pour elle, les données analysées, provenant de 108 centres, ont montré que seuls les systèmes UPS devaient être pris en compte. «Nous avons été surpris de constater qu'il n'y avait pas beaucoup de variables opérationnelles à avoir un effet statistiquement significatif sur le PUE, a t-elle indiqué. « La différence vient plus des pratiques de gestion en matière énergétique que des caractéristiques. » [[page]] Toujours selon Alexandra Sullivan, « le niveau de redondance ne devrait pas jouer non plus parce que de nombreux centres de données fonctionnent sur plusieurs niveaux dans un espace unique, » a t-elle fait valoir. Par contre, les entreprises qui utilisent l'air frais ambiant pour suppléer aux conditionneurs d'air obtiendront toujours un meilleur classement, parce que ce type de refroidissement tend à abaisser les scores PUE. Cependant, l'EPA n'exclut pas d'améliorer ses méthodes de mesure. Ainsi, les centres de données auront la possibilité de fournir des informations sur leur niveau de redondance. « De cette manière nous pourrons l'analyser et voir si cette donnée est pertinente pour être prise en compte dans les futurs modèles d'évaluation, » a déclaré Alexandra Sullivan. Gary Murphy, principal chez idGROUP, une entreprise qui conçoit des datas centers, a qualifié le programme de «très utile». Selon lui, « il procurera aux gestionnaires de centres de données un bilan à montrer aux cadres de niveau C - très concernés par le coût en énergie des datas centers - pour prouver que leurs installations sont efficaces » D'un autre côté, Gary Murphy se demande si l'EPA a collecté suffisamment de données pour son analyse, car «108 centres de données, ce n'est pas beaucoup», dit-il. L'EPA devrait intégrer les données d'évaluation pour les data centers à son outil en ligne en juin, et permettre aux entreprises qui souhaitent y participer d'y entrer leurs données pour estimer leur score. En dehors de l'Europe, où le programme Energy Star est également reconnu, Andrew Fanara, directeur du programme, a fait savoir que la Chine et l'Inde avaient également accepté « le principe» de l'utilisation du système de l'EPA pour le classement de leurs produits. « Il est important d'éviter de créer une mosaïque de programmes régionaux, a t-il déclaré, surtout pour les entreprises multinationales. » (...)

(08/02/2010 11:06:21)Léo Apotheker quitte SAP, il est remplacé par deux co-PDG

Léo Apotheker quitte SAP. Il était passé seul aux commandes de l'éditeur allemand il y a moins d'un an, au printemps 2009, après avoir occupé le poste de co-PDG pendant treize mois aux côtés de Henning Kagermann, désormais à la retraite. Léo Apotheker a rejoint SAP en 1988 et dirigé de longues années la filiale française. Au fil des années, il a progressivement occupé des responsabilités de plus en plus importantes au sein des instances dirigeantes de l'éditeur. La nouvelle de sa démission est tombée brutalement, hier dimanche 7 février. Malgré tout, certains signes avant-coureurs avaient pu laisser entrevoir un prochain départ, d'autant que son mandat de dirigeant arrivait à échéance et devait être renouvelé. Il est remplacé par une direction de nouveau bicéphale, comme elle le fut longtemps, constituée cette fois de Bill McDermott (ci-dessous, à gauche), responsable des opérations, et Jim Hagemann Snabe (à droite), reponsable du développement produit.

Tous deux étaient déjà membres du conseil exécutif de SAP, auquel vient par ailleurs d'entrer le directeur technique (CTO), Vishal Sikka (ci-dessous).

Le communiqué officiel précise que le Conseil de surveillance de la société a trouvé un accord avec l'actuel PDG pour ne pas prolonger son contrat en tant que membre du conseil exécutif de SAP. Sa démission comme PDG et membre du conseil exécutif prend effet immédiatement. Léo Apotheker a dirigé seul SAP pendant l'un des exercices fiscaux les plus rudes de l'éditeur. Assez fortement touché par la crise économique, SAP a enregistré un recul de 27% sur ses ventes de logiciels en 2009. Le fournisseur a également connu une période de conflit avec ses clients à la suite de l'augmentation de ses tarifs de maintenance et de l'instauration d'un contrat de support unique. Tout récemment, il avait fait machine arrière en proposant de nouveau le choix entre un contrat de maintenance Standard à 18% annuel du coût d'achat des licences, et le contrat étendue Enterprise Support, à 22%. La semaine dernière, SAP France avait déjà annoncé le départ de son PDG, Pascal Rialland, nommé à la direction générale d'Omer Telecom, après quatre années à la tête de la filiale française. Il est remplacé à son poste par Nicolas Sekkaki, jusque-là directeur général d'IBM France en charge de l'activité services. (...)

Les Européens hyperconnectés deviennent un problème pour les opérateurs

« L'arrivée des smartphones a créé une certaine accoutumance au tout-connecté » explique Jacques Rame, le président de Motorola France. En effet, huit consommateurs européens sur dix (77 %) confirment que les technologies mobiles font partie intégrante de leur vie privée et professionnelle, et les deux tiers (66 %) pensent qu'elles contribuent à trouver un équilibre dans leur vie. 74% des Français affirment qu'être connecté en permanence à Internet est même devenu un besoin émotionnel. Pour preuve, 59 % confient se sentir en paix lorsqu'ils sont connectés alors que 31% d'entre eux se disent frustrés lorsqu'ils n'ont pas accès à un point de connexion. Jacques Rames explique aussi ce sentiment par l'essor des réseaux sociaux : « aujourd'hui, pouvoir être en relation permanente avec ses amis et sa famille est quelque chose d'extrêmement rassurant. ». Il ressort aussi des résultats de l'enquête qu'indépendamment des générations, les consommateurs utilisant les réseaux sociaux aimeraient avoir la possibilité d'utiliser leur poste de télévision pour recommander des programmes à des personnes de même sensibilité. Partager en temps réel ses émotions Cette demande croissante de connectivité a donc montré que même si elles vont de pair, la demande d'offres et de services l'emporte sur celle de l'avancée technique. «Il y a un autre besoin naissant qui se fait sentir, c'est celui de pouvoir partager les mêmes contenus sur différents écrans. » affirme Jacques Rames, « synchroniser les informations de la vie extérieure et celles de la vie à la maison est devenue un enjeu majeur ». Cette possibilité de gérer différents supports à partir de chez soi s'appelle le 'Home Networking' et c'est ce dans quoi Motorola prévoit d'axer ses futurs projets, en proposant des interfaces de TV et VoD (Video on Demand) simplifiés, notamment en collaboration avec la Livebox d'Orange. Un avenir incertain pour les opérateurs télécoms « Aujourd'hui tout ce qui n'est pas monétisable pour les opérateurs explose » annonce Roland Montagne le directeur business du cabinet d'étude Idate en parlant des offres Internet mobiles illimitées. « De plus, le marché des mobiles semble de plus en plus saturé ». En Europe, les ventes de terminaux ont effectivement baissé de 1,5% en 2009 bien qu'il ait connu une hausse d'1% en France avec 23,6 millions de téléphones. Ces problèmes obligent donc les opérateurs à proposer plus de services, mieux personnalisés. En première ligne pour que les opérateurs regagnent des bénéfices : les services de vidéo. Selon l'enquête de Motorola, les Européens sont de plus en plus nombreux à accéder à des contenus vidéo par d'autres moyens que leur TV : 32 % regardent de la vidéo en streaming sur Internet, 5 % utilisent la télévision à la demande et 13 % téléchargent des films sur le Net au moins une fois par semaine. Les consommateurs recherchent en fait la possibilité de consommer des vidéos comme bon leur semble. Les services de télévision mobile et de TV 3D seraient donc des solutions prioritairement étudiées par les opérateurs. Autre champs de bataille pour ces derniers, le développement de la fibre optique et le passage de la 3G à la quatrième génération de réseaux mobiles: la LTE. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |