Flux RSS

Administration de serveurs

213 documents trouvés, affichage des résultats 31 à 40.

| < Les 10 documents précédents | Les 10 documents suivants > |

(08/04/2011 10:52:27)

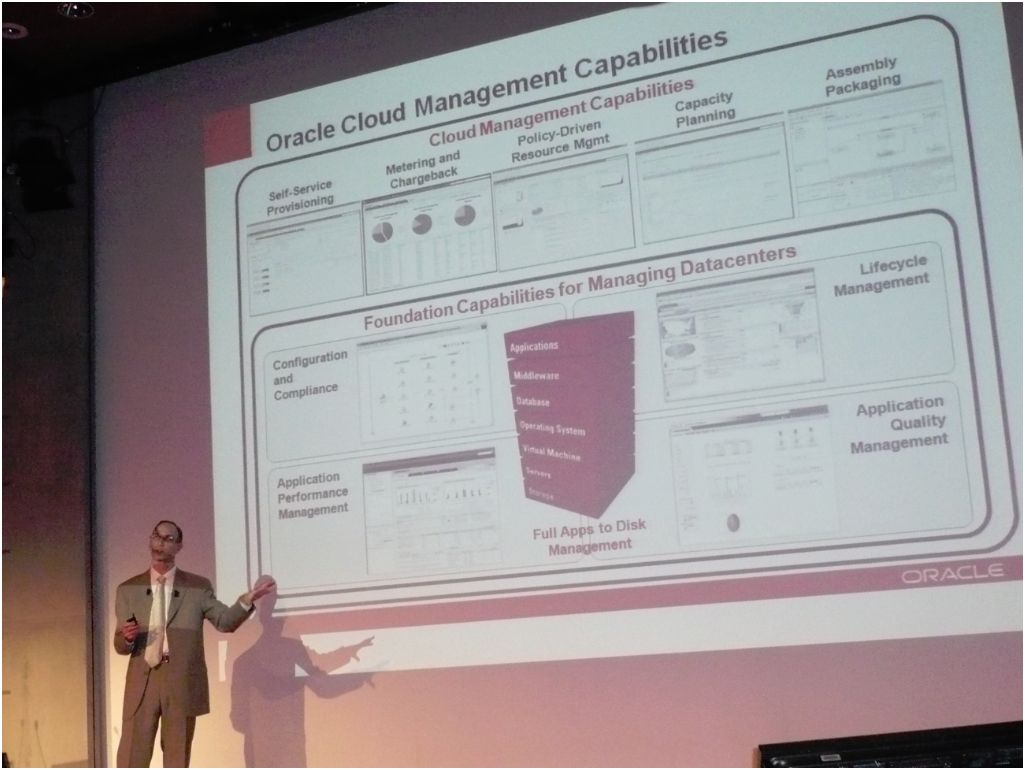

Que le cloud soit privé ou public, Oracle a réponse à tout

Si le PDG de Salesforce.com, présent mardi à Paris, a une idée très resserrée du cloud, public et multitenant, Oracle revendique de son côté une vision très large de la question. Hasard ou pas des calendriers, deux jours après son compatriote californien Marc Benioff, la société de Larry Ellison avait programmé son propre événement, à deux pas du Cnit de la Défense. Rick Schultz (en photo), vice président marketing technologie produit, y a donné la version du cloud selon Oracle. L'éditeur de Redwood reprend simplement la définition générique de l'agence américaine NIST (National Institute of Standards and Technology), soit « un modèle pour accéder à la demande à un pool de ressources informatiques configurables qui peut être rapidement mis à disposition, avec un minimum d'intervention de la part des fournisseurs qui le mettent en oeuvre ». Ce qui laisse à Oracle un terrain de jeu suffisamment étendu pour couvrir, avec ses matériels, middleware et applications, les trois modèles de services (SaaS, PaaS et IaaS) et les quatre modèles de déploiement (cloud public, privé, communautaire et hybride).

Les clouds privés prennent la corde

Rick Schultz a repris ce matin le b.a.-ba du glossaire cloud et des mérites respectifs des modèles privé et public. « Les entreprises vont adopter un mix de modèles, suivant ce qui s'adapte le mieux aux applications qu'elles utilisent déjà ». Fin 2010, une étude conduite par l'IOUG (Independent Oracle Users Group) auprès de 267 responsables IT a montré que 29% avaient déjà déployé un cloud interne (pour la plupart sur un périmètre limité) et que 37% donnaient déjà accès à certains processus à partir d'un cloud privé. Quant aux réticences autour du cloud public, elles portent avant tout sur la sécurité (à 43%), avant le coût (25%) et la qualité de service (25%). « Les clouds privés suscitent de plus en plus d'intérêt, pointe Rick Schultz. Le PaaS privé, notamment, maximise la flexibilité et le contrôle en réduisant les interventions manuelles. »

Si Oracle a une vision très large du cloud, sa stratégie est en revanche très ciblée, affirme-t-il. En version privée, il dispose de tous les ingrédients pour installer des applications sur une plateforme partagée, offrir base de données et middleware en PaaS et jusqu'au matériel et systèmes pour bâtir PaaS ou IaaS (cf ses offres Exadata et Exalogic*, cette dernière associant clustering et virtualisation), ainsi que les outils d'administration du cloud (solution Enteprise Manager). En version publique, il propose son offre applicative (les composants ERP de Fusion Applications par exemple peuvent être déployés sur un cloud public) ou l'accès à ses bases de données ou à son middleware sur un cloud tel que celui d'Amazon. Il y a deux mois, ce dernier a indiqué qu'il allait également supporter Oracle VM, la technologie de virtualisation de serveurs de l'éditeur qui repose sur Xen. « Nous poursuivons nos investissements dans nos différents produits de virtualisation », a précisé Rick Schultz par la suite, lors d'une session de questions/réponses, en insistant sur l'effort réalisé par le groupe en R&D (4 milliards de dollars prévus sur 2011 - contre 3,25 Md$ en 2010, soit 12% du chiffre d'affaires de l'exercice). « Nous continuons d'investir sur les technologies rachetées », rappelle le VP marketing technologie product.

250 applications sur une infrastructure partagée

Rick Schultz illustre son propos par quelques cas d'écoles. Le Crédit Suisse, notamment, a déployé trois clouds privés internes, PaaS et IaaS. Succédant au VP marketing d'Oracle, Massimo Pezzini, de Gartner, zoome sur le cas. La banque dispose notamment d'une plateforme pour des applications Java (rassemblant WebLogic Portal, WebLogic Server, JMS, Application Integration Components, RAC [Real Application Cluster], des outils de sécurité et de gestion de système et le framework applicatif). Le modèle de déploiement est double : partagé pour certaines applications ou consacré à une application. Bilan : le Crédit Suisse exploite 250 applications sur une infrastructure Solaris partagée (reposant sur 180 serveurs) et 20 applications déployées sur des serveurs strictement dédiés, pour la banque sur Internet et les systèmes de paiement.

(*) Pour Rick Schultz, les premiers clients d'Exalogic, offre toute récente lancée sur OpenWorld 2010, seront très probablement les utilisateurs des solutions middleware WebLogic.

Illustration : Rick Schultz, vice président marketing technologie produit (crédit : M.G.)

Rick Schultz, VP marketing technologie produit d'Oracle, expose les capacités d'administration du cloud proposées par l'éditeur (crédit : M.G.) (...)

Pour baisser ses coûts IT, Essilor fait appel à moins de prestataires

Jeudi 31 mars, Bénédicte Bonnet Roussey, Business Services Sourcing Manager chez Essilor a exposé les bonnes pratiques mises en place à la DSI du numéro un mondial du verre ophtalmique dans le cadre de la coopération avec la direction des achats IT afin de réduire les coûts des prestations informatiques. Elle s'exprimait à l'occasion d'une table ronde organisée par Luc Domissy dans les locaux de l'ESCP à Paris sur le thème de la Gouvernance IT, dans le cadre du groupement des grandes écoles G9+ et plus particulièrement du GP Informatique Arts & Métiers ParisTech.

La direction des achats IT d'Essilor s'est penchée en 2008 sur le coût des prestataires auxquels les différentes équipes informatiques font appel sur les 5 continents, et 100 pays. La facture à l'époque s'élevait à 28 millions d'euros. Les deux tiers de cette facture concernaient la traditionnelle assistance technique en mode régie, assez peu structurée. L'autre tiers se séparait pour moitié entre des prestations d'intégration réalisées au forfait et pour l'autre moitié en TMA, structurée.

Réduction du nombre de prestataires

On peut constater l'extrême émiettement des prestations puisque l'assistance technique était réalisée via 128 personnes travaillant pour 54 sociétés différentes. « Notre objectif, commun avec la DSI, était de rationaliser auprès de 15 fournisseurs uniquement, dont 3 fournisseurs principaux dits VIP auxquels nous proposerions en priorité et en exclusivité les projets et 12 challengers. Ceux-ci se verraient consultés si les trois fournisseurs principaux n'arrivaient pas à répondre » décrit Bénédicte Bonnet Roussey.

Un appel d'offres a été lancé début 2009 auprès du panel de 54 sociétés. Les critères de choix pour déterminer les prestataires conservés étaient multiples : compétences technologiques, possibilité d'accéder à des prestations offshore, ... « Nous avons défini une grille tarifaire à partir du référentiel de compétences du Cigref qui comprend 50 profils où nous en avons retenu 13 » ajoute la responsable des achats. Les 3 fournisseurs VIP n'étaient pas forcément les moins chers. « Leur capacité à aider à la réflexion stratégique sur l'IT a été prise en compte » déclare Bénédicte Bonnet Roussey.

Au terme de cette expérience, on peut en retenir quelques éléments de réflexion. Tout d'abord, tout le business qui était confié aux prestataires qui n'avaient pas été retenus, et qui donc ont été déréférencés, n'a pu être rebasculé vers les trois prestataires principaux. La raison en est très humaine : les relations personnelles qui ont ...

Photo D.R.

[[page]]

... pu être créées entre un patron de l'IT et son prestataire ne s'interrompent pas si facilement. « Il faut suivre cela de près pour faire respecter les règles du jeu définies avec la DSI » note la responsable des achats. Elle attire l'attention sur les risques que peut faire courir une relation trop intime sur le long terme entre une direction des systèmes d'information et son prestataire : le délit de marchandage.

Au bout d'un certain temps, on ne fait plus suffisamment attention à qui fait partie de l'entreprise ou pas. « Afin de ne pas tomber dans ce travers, il faut éviter tous les signes qui auraient tendance à montrer que le prestataire est traité comme un salarié de l'entreprise. Par exemple, il ne doit pas avoir d'email d'entreprise, ni de ligne directe, ni voir ses congés être validés par le manager de l'entreprise cliente. Pour notre part, nous avons mis en place des contrats de 3 mois qui doivent être renouvelés » dit-elle. L'économie réalisée par Essilor grâce à cette remise à plat des prestations IT a atteint 10% sur la masse d'achat.

« Pour le futur, il faut évidemment que nous allions vers la forfaitisation, et vers la massification, avant même de recourir à l'offshore » retient-elle. Le déréférencement s'avère difficile à réaliser jusqu'au bout, d'autant plus dans une période de crise et de resserrement des budgets IT. Un prestataire qui est présent dans une entreprise depuis des années, dix ou quinze ans, a tout intérêt d'y rester, d'autant plus qu'il a perdu de la valeur sur le marché pour son employeur en restant trop longtemps dans l'entreprise.

En conclusion, Bénédicte Bonnet Roussey attire l'attention sur un moyen qu'elle utilise afin d'avoir une vision plus juste du coût d'un prestataire : « Je demande à ce qu'il chiffre sur un projet non seulement sa propre prestation mais également la charge qu'il estime que cela représente côté Essilor, et on peut choisir selon la bottom-line parmi les prestataires. »

Microsoft dévoile son outil de virtualisation de serveur d'applications

La virtualisation des serveurs d'applications est une fonctionnalité désormais disponible en version bêta dans System Center Virtual Machine Manager, et devrait être livrée plus tard cette année en même temps que la version finale du System Center 2012. Microsoft n'est pas le premier vendeur à virtualiser les serveurs d'applications, mais, pour une fois, il le fait avant son rival VMware. Avec peut-être un avantage : les clients de VMware sont aussi des utilisateurs de Windows.

Tout comme la virtualisation serveur dissocie le système d'exploitation du serveur, la virtualisation d'applications ajoute une couche supplémentaire et dissocie le programme du système d'exploitation. Cela permet une plus grande souplesse dans la migration, la mise à jour et la restauration de certains éléments logiciels. Jusque-là, la virtualisation des applications concernait uniquement les logiciels de bureau. Comme on pouvait s'y attendre, la virtualisation de serveur d'applications, virtualise elle, le « software framework », dissociant l'application et sa configuration de l'OS sous-jacent. Autrement dit, au lieu de faire une copie virtuelle d'Outlook par exemple, on crée une copie virtuelle d'Exchange Server.

Simplifier les mises à jour

Pourquoi opérer de cette façon ? Selon David Greschler, directeur de la stratégie virtualisation chez Microsoft, « les applications actuelles côté serveur sont étroitement associées à des machines virtuelles, si bien qu'il est difficile de déplacer les applications d'une machine virtuelle à une autre, ou de mettre à jour l'OS sans affecter l'application, et vice versa. » Avec des serveurs d'applications virtualisées, il devient possible de mettre à jour le système d'exploitation sans avoir à se préoccuper d'une éventuelle réinstallation du logiciel.

Avec une application virtualisée, les administrateurs peuvent créer des « images systèmes types », ou des instances génériques d'un système d'exploitation qu'ils pourront appliquer à plusieurs types d'applications. « Au lieu d'avoir une machine virtuelle Exchange, on a une VM générique avec un système d'exploitation où l'on peut introduire une application en temps réel, » explique David Greschler. De nombreuses applications utilisent une image système identique. Elles peuvent donc être plus facilement déplacées du datacenter d'un client vers un service cloud Windows Azure.

Alléger la gestion des instances

Les responsables de Microsoft ont largement fait valoir que cette approche pouvait contribuer à alléger la gestion des instances : au lieu d'avoir à gérer des milliers d'instances système spécialisées, quelques instances génériques reproduites des milliers de fois suffisent. « Lors du Patch Tuesday par exemple, cette technologie permettra aux services informatiques de traiter le système d'exploitation et l'application séparément, ce qui rendra plus facile le déploiement des mises à jour de sécurité, » a indiqué Microsoft.

[[page]]

L'objectif de l'éditeur de Redmond est de mettre davantage l'accent sur l'application, plutôt que sur la machine virtuelle, ce que le directeur de la stratégie appelle la « nappe », alors que les applications représentent les plats que l'on dépose par dessus. Techniquement, la virtualisation de serveurs d'applications peut même être utilisée sur des serveurs physiques dépourvus d'hyperviseur, mais il est peu probable que beaucoup de clients soient tentés par cette solution.

Une technologie issue du rachat de Softricity

David Greschler est le cofondateur de Softricity, une entreprise acquise par Microsoft en 2006. Au moment du rachat, Sofricity était propriétaire d'une technologie de virtualisation d'applications de bureau, prête à l'usage, et avait déjà commencé à plancher sur la virtualisation d'application côté serveur. Selon David Greschler, « la priorité de Microsoft était alors de s'assurer que App-V pour le bureau puisse être exploitée. » L'outil serveur d'applications « était en test dans les laboratoires. C'était juste un projet. Aujourd'hui, c'est une réalité. »

Mais Microsoft n'est pas le premier à être parvenu à ce stade. La start-up AppZero se vante de disposer de sa propre technologie de virtualisation d'application côté serveur, qui permet de déplacer les applications entre serveurs physiques et virtuels et à travers des déploiements VMware, Xen et Hyper-V. Mais Microsoft avance plus vite que son principal rival : VMWare sait virtualiser les serveurs et les applications de bureau, mais pas encore les serveurs d'applications. « Actuellement, VMware ne supporte pas la virtualisation des serveurs d'applications, » a confirmé AppZero.

Pas de support de Linux bien sûr

Avec System Center 2012, Microsoft étend sa capacité à gérer plusieurs hyperviseurs. System Center prenait déjà en charge la technologie Hyper-V et VMware, et la nouvelle version sera en mesure de gérer XenServer de Citrix. Avec une limitation cependant : la technologie de Microsoft ne fonctionne qu'avec Windows Server et pas avec Linux. « C'est une architecture tout à fait différente, » explique le directeur de la stratégie, à propos de Linux. « La couche de virtualisation des applications est très liée à la structure de Windows, au registre, aux fichiers, et à tous les composants dont ce système d'exploitation a besoin pour faire tourner une application. » Pour l'heure, la prise en charge de Linux n'est « pas sur notre feuille de route, » a déclaré David Greschler.

Microsoft branche System Center sur le cloud

Selon Microsoft, les additions à la suite System Center 2012, qui devrait sortir plus tard dans l'année, sont nécessaires pour aider les services informatiques à suivre le rythme des demandes au niveau des différents départements de l'entreprise. « Si le service central ne réagit pas assez vite, ceux qui travaillent au niveau des départements ne vont pas les précéder et iront chercher de l'espace sur un site de type Windows Azure s'ils ont besoin d'effectuer un déploiement rapide, » a déclaré Amy Barzdukas, directrice générale de la division Serveur et Outils chez Microsoft, à l'occasion de la conférence Management Summit qui a débuté cette semaine à Las Vegas.

Au coeur de l'offre de cloud privé, System Center Virtual Machine Manager 2012 permettra aux administrateurs de déployer des machines virtuelles, soit sur des serveurs locaux, soit sur des plates-formes hébergées sur Windows Azure. L'administrateur pourra configurer différentes machines virtuelles afin de constituer des ensembles de serveurs dédiés à des tâches spécifiques ou à certains types d'activité. Le logiciel travaille avec des machines virtuelles reposant sur l'hyperviseur maison, Hyper-V, mais également avec ceux de VMware et de Citrix.

Une version bêta disponible pour test

« On peut créer un ensemble de machines virtuelles à partir de solutions standards qui fournissent l'application et les paramètres réseau, et les proposer aux utilisateurs », a déclaré la dirigeante. Microsoft a mis en ligne une version bêta de Virtual Machine Manager, qui peut être testée pendant quelques semaines. Le temps que la version finale arrive. Selon Chris Wolf, vice-président de Gartner Research, le « cloud management » ne consiste plus à simplement créer une machine virtuelle et à la déployer dans une infrastructure de type cloud computing. Les entreprises ont également besoin d'outils pour en automatiser la configuration et les opérations. » CA Technology et HP ne disent pas autre chose, et, ce, depuis plusieurs mois.

Sur les 7,5 millions de serveurs équipés de Windows Server que Microsoft compte livrer en 2012, environ 1,5 million sont destinés à des environnements « hautement virtualisés », indique Amy Barzdukas. L'autre nouveauté du System Center 2012, c'est le logiciel, nom de code Concero, qui doit contribuer à un meilleur contrôle de l'affectation des ressources au niveau d'un département. Celui-ci permettra au superviseur de choisir pour l'administrateur local un ensemble de serveurs ou d'autres ressources de façon à gérer plus finement la répartition des ressources. « Concero est une sorte de console d'administration, mise à la disposition de l'administrateur au niveau local. Elle lui offre la possibilité de gérer les ressources déléguées par l'administrateur central, » précise-t-elle. « Celle-ci se base sur l'expérience spécifique de l'administrateur local et sa bonne connaissance des besoins de son unité. En fait, elle leur permet de contrôler eux-mêmes l'ensemble de la gestion. »

D'autres améliorations à venir sur System Center

Lors de la conférence Management Summit, Microsoft a également donné des détails sur d'autres améliorations dont profitera la prochaine version de System Center. Notamment, Operations Manager 2012 inclura la technologie de mesure du rendement .Net acquise par Microsoft avec le rachat d'AVIcode. Opalis, une autre technologie, également tombée dans le panier de Microsoft et rebaptisée System Center Orchestrator 2012 après avoir été mise à jour, permet aux utilisateurs d'automatiser le flux entre différents systèmes.

La mise à jour de Service Manager 2012 permettra aux administrateurs des centres de calcul d'effectuer leurs propres requêtes au coup par coup, de façon à accélérer le processus d'approbation pour l'allocation des ressources Cloud. Une version bêta d'un nouveau service baptisé System Center Advisor (anciennement connu sous le nom de code « Atlanta »), et destiné à la régulation des déploiements de serveurs SQL dans le cloud, est également disponible.

Toujours lors de cette conférence, Microsoft a annoncé que la société de distribution Target a déployé Hyper-V et System Center pour mieux gérer ses serveurs dispersés sur tout le territoire. « En migrant vers cette plate-forme, Target peut désormais réduire de sept à deux le nombre de serveurs utilisés » [sur ses sites] a indiqué Microsoft. Cela a permis de supprimer 8 000 serveurs répartis dans les 1 755 enseignes de la chaine de supermarchés aux États-Unis. Amy Barzdukas a souligné que les serveurs de la société de distribution pouvaient exécuter, dans les machines virtuelles, une application Linux maison, que Target a développé pour gérer l'exploitation des espaces « pharmacie » de ses supermarchés.

(...)(02/03/2011 14:45:36)IBM affine ses outils pour automatiser et accélérer la virtualisation

Dennis Quan, directeur du laboratoire de développement Tivoli Chine d'IBM, est resté assez vague sur la manière dont le logiciel pouvait atteindre ces vitesses de déploiement de VM, indiquant simplement qu'il utilisait un certain nombre de techniques, dont le streaming de l'image. Selon lui, « le logiciel permettrait d'améliorer les performances dans des entreprises où les personnels des services informatiques doivent consacrer plusieurs minutes, voire même une heure, à installer une seule machine virtuelle. » Et ce se serait pas son seul avantage. Une des raisons pour laquelle les entreprises déplacent leurs activités vers le cloud, c'est pour n'utiliser que les ressources informatiques dont elles ont besoin. « Cette idée suppose également que, quand ces ressources ne leur sont plus nécessaires, elles peuvent les restituer au cloud et les rendre disponibles à d'autres utilisateurs, » ajoute Dennis Quan. Or, certains rechignent à se séparer de ces ressources, même si elles ne sont plus utiles. En particulier, à cause du temps qu'il leur faudra consacrer à nouveau pour les remettre en place. « Si vous offrez aux utilisateurs la possibilité de retrouver leurs ressources en quelques secondes, voire quelques minutes, ils ne vont plus se demander combien de temps il leur faudra pour les récupérer rapidement et ils accepteront de s'en défaire au moment voulu, » a déclaré le directeur du laboratoire de Big Blue. « Le logiciel permettra également aux entreprises d'agir plus rapidement, pour effectuer des modifications, par exemple, » a-t-il ajouté.

IBM a également annoncé que Tivoli Provisioning Manager prenait désormais en charge la fédération d'image et le déploiement sous infrastructure hétérogène. « Cet outil apporte un système de gestion unique pour différents hyperviseurs » a déclaré Dennis Quan. « Une entreprise peut utiliser VMware, PowerVM et des hyperviseurs Xen et les gérer depuis la même console, » explique-t-il. IBM annonce également le lancement « imminent » de la version bêta d'un nouveau logiciel qui étend les capacités de gestion aux clouds hybrides. « Les utilisateurs pourront surveiller et diriger des services hébergés en interne ou sur des clouds publics. Ces modalités sont très adaptées aux services financiers et aux organismes publics qui préfèrent conserver les données importantes dans leurs systèmes internes et acceptent de mettre des applications moins sensibles dans un cloud public, » déclare encore le responsable de Tivoli Chine. Ce dernier n'a pas communiqué la liste des clouds publics qui seraient supportés, mais a affirmé que le logiciel serait en mesure d'être relié à de nombreux services. Celui-ci compte affiner cette liste avec le déploiement de la version bêta. IBM annonce également que Tivoli Storage Manager, son logiciel de gestion des besoins de stockage, de récupération et de protection des données, prend désormais en charge la virtualisation. « Celui-ci offre un meilleur contrôle sur l'environnement et applique une politique plus uniforme, » explique encore Dennis Quan.

Ces nouvelles fonctionnalités et produits seront probablement bien accueillis par les directeurs financiers, mais pas forcément par les services informatiques. « L'automatisation de la gestion et la réduction du temps d'approvisionnement font que les services informatiques auront besoin de moins d'administrateurs, » estime le responsable d'IBM. « Dans un environnement informatique, c'est la ressource humaine qui coûte le plus cher, » ajoute-t-il. « Avec des milliers de machines virtuelles, chaque minute de l'activité humaine requise par chacune d'elle fait grimper la facture. Plus ce secteur sera automatisé, et plus une entreprise pourra réaliser avec le cloud des retours sur investissement. »

Illustration principale : Denis Quan, crédit photo H. Parkey-Coney/IBM

Selon Forrester, les premiers clouds privés seraient voués à l'échec

Les analystes de Forrester n'ont pas de nouvelles très encourageantes pour les fournisseurs IT qui mettent en place leurs premiers cloud en interne. Selon eux, cette infrastructure est susceptible d'échouer. D'un autre côté, les mêmes analystes insistent sur le fait que « c'est une bonne chose, » parce que cet échec permettra de réussir par la suite. « La plupart de ces entreprises ne sont pas encore prêtes à utiliser un cloud interne. Néanmoins, nous pensons que, en 2011, les départements Infrastructure et Opérations (I&O) vont commencer à en déployer un certain nombre. Ces efforts sont très probablement voués à l'échec. Mais grâce à cette première étape et à l'expérience qu'elle apportera, il sera possible d'en tirer de précieux enseignements sur ce qui est vraiment nécessaire pour gérer un tel environnement, » ont écrit les deux analystes de Forrester, James Staten et Lauren Nelson (en illustration principale), dans leur rapport intitulé « 2011 Top 10 IaaS Cloud Predictions pour I&O Leaders » et destiné aux responsables des départements Infrastructure et Opérations.

Clouds privés : les entreprises ne sont pas encore assez matures

Selon Forrester, « il faut plus de maturité dans la virtualisation et des améliorations dans la normalisation, l'automatisation et l'infrastructure pour s'engager avec succès dans la mise en place d'un cloud interne capable de fournir des services équivalents à ceux offerts par des IaaS (Infrastructure-as-a-Service) comme l'Elastic Compute Cloud d'Amazon. » Toujours selon le rapport, « la plupart des entreprises n'ont pas la maturité nécessaire en terme de virtualisation et ne sont pas prêtes à mettre en oeuvre le niveau d'automatisation et de standardisation exigé par un environnement cloud. » Comme l'expliquent les deux experts, « la perspective architecturale change : le cloud met fin à l'architecture en silos, pour un pool unique de ressources permettant deux niveaux de priorité élémentaires - un concept révolutionnaire et un défi pour les gestionnaires I&O. La gestion des meilleures pratiques viendra avec l'expérience, et le plus tôt sera le mieux. En même temps, même si l'infrastructure n'est pas encore prête, mieux vaut ne pas éviter de considérer une telle mise en route. »

Des solutions clouds déjà pérennes

Cela ne veut pas dire pour autant que toutes les tentatives sont vouées à l'échec et qu'il n'y aura pas de success-story. Comme l'a récemment rapporté notre confrère Network World, de grandes entreprises comme Bechtel et First American Corp ont déjà fait le bilan des avantages acquis grâce à des clouds en interne. De nombreux éditeurs de logiciels comme VMware, Joyent, Red Hat, Platform Computing ou la start-up Nimbula fondée par l'équipe à l'origine d'Amazon EC2, proposent également des outils d'automatisation pour virtualiser l'infrastructure et offrir des fonctionnalités semblables à celle du cloud. Pour ceux qui ne veulent pas mettre en place une nouvelle infrastructure en interne, Amazon, Terremark, Savvis, Rackspace et d'autres proposent également des serveurs virtuels hébergés. Une étude réalisée au cours du troisième trimestre 2010 par Forrester auprès de 1252 décideurs IT en matière de serveurs et de stockage a révélé que 15% d'entre eux prévoient d'acheter des ressources IaaS à Amazon ou à d'autres vendeurs, et 6% ont déjà franchi cette étape. Parmi les entreprises de plus de 20 000 salariés, 20% d'entre elles prévoient d'adopter l'IaaS et 8% ont déjà adopté ce type de solution.

Parmi les points soulevés par le rapport de Forrester on note :

- Dans leurs entreprises, les responsables IT «aguerris» ne doivent pas s'opposer aux adopteurs précoces qui souhaitent acheter de nouveaux services de cloud computing.

- Les cloud privés hébergés par des fournisseurs, avec une offre de ressources dédiées, et non partagées, seront trois fois plus nombreux que les cloud déployés en interne.

- Les cloud publics, mis en place par des associations ou un groupe d'entreprises en vue de partager les coûts, vont se développer dans certains secteurs, notamment la biotechnologie, l'enseignement supérieur et les organismes gouvernementaux.

- Le cloud computing haute performance sera plus largement répandu grâce à de nouvelles applications qui permettent d'accéder à la puissance des technologies de grille sans les complications de leur mise en oeuvre.

- L'économie du cloud va grandement s'améliorer. Les développeurs vont pouvoir créer de petites applications qui pourront, si nécessaire, être élargies pour des usages à grande échelle en fonction des besoins. De nouveaux outils vont permettre de comparer plus facilement les coûts, quitte à avoir recours à plusieurs services cloud pour obtenir le meilleur prix.

- Les outils analytiques du cloud vont stimuler la business intelligence (BI) en proposant des services plus rapides et plus rentables.

- Les nouvelles fonctionnalités de Windows Azure et d'autres nuages vont aider les entreprises à profiter de l'analyse des données, ce qui pourrait potentiellement inciter les clients à devenir eux-mêmes des fournisseurs de BI par une valorisation de leurs données internes et la mise en place de nouveaux services susceptibles de générer des revenus.

- Les normes du cloud vont continuer à bouger en 2011. Cette tendance rend « le marché du cloud... trop immature pour une normalisation. » Cela ne doit pas empêcher les clients d'adopter des services cloud. Ils doivent s'orienter vers des fournisseurs qui ont du souffle et sont suffisamment répandus sur le marché pour ne pas prendre le risque de miser sur un perdant.

- La sécurité du cloud « aura fait ses preuves », mais les professionnels de l'IT doivent analyser attentivement la sécurité, la confidentialité, la conformité, le cadre juridique et contractuel de l'ensemble de leurs applications et ne qualifier que celles qui sont prêtes pour être proposées dans les services cloud. Les utilisateurs doivent aussi se diriger vers des produits « capables de sécuriser les données avant qu'elles ne soient rendues disponibles dans le cloud. »

Illustration principale : Lauren E Nelson, chercheur chez Forrester

Le cloud au coeur de l'entreprise avec HP Hybrid Delivery

« Avec Hybrid Delivery, nous proposons une fondation permettant de s'appuyer sur l'existant pour aller vers le cloud, privé et public, tout en prenant soin de la gouvernance et des applications existantes », nous a expliqué Xavier Poisson Gouyou Beauchamps, directeur commercial cloud computing chez HP Europe lors d'une conférence de presse à l'Innovation Center de Genève. Il s'agit bien de combiner un système d'information traditionnel, reposant sur une infrastructure HP ou autre, et des services innovants exploitant une architecture cloud.

Après de deux années tendues, les entreprises, principalement les DAF (directeur administratif et financier), sont toujours à la recherche des leviers qui leur permettront de baisser les coûts de production et de mieux répondre aux demandes des utilisateurs. « A l'issue d'une période de crise, les entreprises veulent aller de l'avant, mais ne savent pas comment s'adapter rapidement aux évolutions du marché », souligne Ian Brooks, directeur marketing solutions et industries chez HP Europe. Les responsables chez HP ont bien compris que la révolution cloud n'est pas une remise en question radicale des ressources IT de l'entreprise, mais une évolution à long terme.

Adapter les usages au cloud

Pour accompagner progressivement la transformation des entreprises, HP mise sur sa solution Hybrid Delivery. Seul bémol, seules les solutions du constructeur de Palo Alto sont concernées. Pour opérer cette consolidation avec la création d'un cloud privé qui pilotera l'ensemble des ressources de l'entreprise, HP utilise ses stacks maison, à savoir Blade System Matrix, les logiciels Cloud Service Automation et Cloud Services, et enfin des API qui permettent de se connecter aux clouds public d'Amazon et d'Enterprise Service (sur le site de L'Isle-d'Abeau pour l'Europe) pour l'instant. Et pour gérer les environnements hétérogènes des clients, HP s'appuie sur des agents systèmes installés sur les machines et en cas de problèmes insolubles, des accords entre constructeurs permettent de régler les dysfonctionnements, nous a précisé Mark Wilkinson, responsable des pratiques cloud chez HP Software Services.

Avec sa solution Hybrid Delivery, le constructeur de Palo Alto ambitionne de créer de nouvelles sortes d'entreprise, mais le cloud n'est pas qu'une approche technologique. Il est également nécessaire de refondre les usages et les pratiques. « Les laboratoires de recherche de HP, le Cloud Computing Competence Center à Grenoble par exemple, peuvent accompagner les DSI dans la transformation de leur entreprise avec des ateliers et un support dédié », précise Ian Brooks. « Toutes les grandes entreprises étudient aujourd'hui les bénéfices qu'elles pourraient tirer d'un cloud. Une vision globale du cloud est nécessaire, car ce n'est pas un simple bloc de plus dans les ressources IT ». Avec son offre Hybrid Delivery, HP propose un cloud privé comme un service qui donne aux clients la possibilité de mixer des services internes, clouds privé et public.

Déployer un catalogue de services SAP

A titre d'exemple, HP a invité dans son centre de Genève Tobias Imhof, directeur des opérations et services SAP chez Resource AG, une filiale de Swisscom, qui a déployé la plate-forme Hybrid Delivery. Cette société qui a réalisé un chiffre d'affaires de 100 millions d'euros en 2010 propose des solutions SAP à destination des PME. Avec la solution Hybrid Delivery, Tobias Imhof a développé de nouveaux services reposant sur un catalogue à la demande disponible pour tous les clients. [[page]]L'objectif était d'éliminer les silos et de réduire les prix des contrats proposés. « Les clients ne paient que pour les ressources dont ils ont réellement besoin et le délai de déploiement des projets est passé de 6 semaines à 2/7 jours. L'adaptation des employés ne demande plus qu'une semaine au lieu de 6 à 12 semaines. »

Resource AG propose tous les modules SAP à ses clients sur les environnements Windows, Solaris et Aix. En terme d'infrastructures, la compagnie a pour l'instant installé un Blade System Matrix, bientôt épaulé par un second pour assurer une redondance complète. Neuf clients (de 50 à 1000 utilisateurs) exploitent déjà les ressources reposant sur la solution de HP chez Resource AG. Si la solution concerne avant tout les opérateurs et les 3 000 plus grandes entreprises dans le monde, elle répond par ricochet aux besoins d'un grand nombre de PME et d'éditeurs qui devront passer par un prestataire de type SSII.

Aujourd'hui, HP ne rencontre que peu de concurrents sur ce segment du marché, IBM et Cisco principalement, mais le passage au cloud est toujours freiné par les questions de sécurité, de disponibilité et de migration. Pour la sécurité, Xavier Poisson met en avant l'étanchéité des solutions proposées, tant au niveau applicatif que stockage avec la technologie 3Par. Pour la disponibilité, HP peut s'engager, après audit, sur des SLA très contraignants. Enfin la question de la migration ne se pose pas encore, mais il est vrai que tant que les machines virtuelles ne seront pas standardisées, il sera toujours difficile de passer de KVM à HyperV ou ESX.

Illustration principale : HP Blade System Matrix

Les appliances de datawarehouse de Microsoft-HP signent-elles la fin de Neoview ?

Lancée il y a plusieurs années, du temps où Mark Hurd était à la tête de HP, la plateforme Neoview destinée à la gestion des datawarehouses (entrepôts de données) n'a jamais réussi à gagner du terrain de manière marquante sur ce marché. Les appliances Microsoft-HP annoncées mercredi, viennent s'ajouter à la gamme de produits HP Enterprise Data Warehouse pour SQL Server commercialisés depuis novembre 2010. Les nouveaux matériels combinent les logiciels de Microsoft avec le hardware HP. Notamment un Data Warehouse Entreprise destiné aux petites et moyennes entreprises, un Business Decision Appliance for BI (business intelligence) et une plate-forme de messagerie pour Microsoft Exchange. Un autre matériel destiné à la consolidation des bases de données est également en cours de finalisation.

Même si HP n'a manifestement pas renoncé aux appliances dans sa stratégie produits, il semble que Neoview « appartienne déjà au passé, » selon James Kobielus, analyste chez Forrester Research. Il estime que cette solution a connu plusieurs difficultés. D'une part, les prix de HP sont restés « beaucoup trop élevés » ces dernières années, explique-t-il. De même, si Neoview n'est pas une plate-forme mal architecturée, « celle-ci n'a pas été vraiment conçue avec une technologie différente », estime le consultant. Des produits concurrents comme Oracle Exadata apportaient certaines innovations telles qu'un système de cache reposant sur de la mémoire flash. HP n'a pas non plus vraiment présenté Neoview comme ne solution sur laquelle ses partenaires pourraient développer des applications dédiées, complète le consultant.

Un produit voué à disparaître

Pour Curt Monash, analyste chez Monash Research, Neoview n'est rien d'autre qu'un lamentable échec. « Il est évident que le produit n'a jamais bien fonctionné », explique-t-il. « Une fois placé dans le monde entier au sein du premier cercle de clients fidèles à HP, qui ont accepté d'essayer le produit, il n'y a plus eu de signe visible dans l'évolution des ventes, et voilà un certain temps que d'autres vendeurs n'identifient plus Neoview parmi leurs concurrents. » Dans le secteur des bases de données analytiques, « les nouveaux produits ne se distinguent par rien d'autre que le prix et la performance, » ajoute Curt Monash. « Les vrais éléments de différenciation se bonifient avec la maturité du produit. Donc, lorsqu'un produit est lancé, s'il n'est pas au bon prix et pas assez performant, il n'apporte rien de plus. » « Je serais étonné de voir de nouvelles ventes ou des campagnes de marketing pour Neoview » soupçonne le consultant. Le porte-parole d'HP n'a pas souhaité commenter ces analyses. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |