Mise en route en 2011 sur le plateau de Paris-Saclay, la Maison de la simulation vient d'être officiellement inaugurée le 15 septembre 2014. Ce laboratoire, qui fournit des ressources de calcul intensif à la communauté scientifique, a été créé en commun par le CEA, le CNRS, l'Inria et les universités Paris-Sud et Versailles-St Quentin. Il constitue en quelque sorte le pendant, pour le monde académique, de l'environnement HPC que le campus Teratec apporte à l'industrie et aux entreprises, les deux démarches intervenant de façon complémentaires. « La simulation est devenue le 3ème pilier de la science, après la théorie et l'expérimentation », a rappelé Edouard Audit, directeur de la Maison de la simulation, lors d'une visite organisée pour la presse en amont de l'inauguration.

Parmi les défis à relever dans le monde du HPC, outre la montée en puissance du parallélisme dans les supercalculateurs et la maîtrise de leur consommation électrique, figurent la visualisation et l'exploitation de très gros volumes de données. Les équipes pluridisciplinaires (physiciens, mathématiciens, informaticiens...) accueillies par la Maison de la simulation peuvent accéder à deux équipements phares. D'une part, le cluster de calcul Poincaré - hébergé administrativement par le CNRS sur son centre Idris à Orsay - leur fournit une puissance CPU de 33,9 Tflops complétée de 9,4 Tflops sur processeurs graphiques (*). D'autre part, la Maison de la simulation dispose dans ses propres locaux - Kdans l'immeuble Digiteo Labs du CEA - d'un mur d'images stéréoscopique pour visualiser et exploiter de grands volumes de données. Cette solution interactive haute performance résulte du projet Digiscope qui regroupe 9 établissements du plateau de Saclay dont Telecom ParisTech et 11 laboratoires. Une infrastructure de téléprésence sera bientôt installée en complément pour développer des méthodes de visualisation collaborative, nous a expliqué Edouard Audit.

Adapter les logiciels pour l'exascale

Au niveau national, la Maison de la simulation s'inscrit dans un dispositif de calcul intensif mis en place par Genci et qui comprend aussi le Cines (à Montpellier) et le TGCC du CEA (à Bruyères-le-Châtel). Par ailleurs, le supercalculateur pétaflopique Curie, contribution de la France au projet européen Prace, se trouve au TGCC. Dans la perspective des technologies exascales qui vont arriver sur les ressources HPC et des changements de paradigmes que cela entraîne, l'une des missions de la Maison de la simulation consiste à adapter les logiciels pour ces futures machines et à préparer les utilisateurs. L'enseignement et la formation constitue l'une de ses autres missions, non moins importante. Par ailleurs, ses ingénieurs spécialisés dans le calcul intensif apportent une aide au développement et à l'optimisation de code de haut niveau. Leur expertise porte également sur l'algorithmique parallèle, la visualisation et le post-traitement des données.

Lors de la visite à Digiteo Labs, plusieurs projets de recherche ont été présentés, illustrant sous différents angles l'exploitation des ressources de simulation. Julien Bigot, chercheur en calcul HPC à la Maison, a montré comment on les utilisait pour comprendre à une échelle macroscopique les règles qui commandent le comportement du plasma de fusion par confinement magnétique. Le but est de mieux prévoir les instabilités, dans la perspective d'un projet comme celui du réacteur thermonucléaire Iter. « Nous simulons 1 ms de comportement du plasma », a indiqué le chercheur en expliquant qu'il s'agissait d'une simulation très exigeante en compétences (en physique, mathématiques et informatique), tant pour l'écrire que pour en comprendre les résultats. Cela représente 279 milliards de points à simuler en discrétisation 3D. « Il faut utiliser de nouvelles machines chaque année et nous devons donc adapter le code », a souligné J.Bigot. Pour le porter sur le supercalculateur Juqueen, par exemple, il a fallu faire énormément d'adaptations (sur le code pour chaque processeur, sur les écritures sur disques, etc.).

Une expertise sur les GPU et l'architecture CUDA

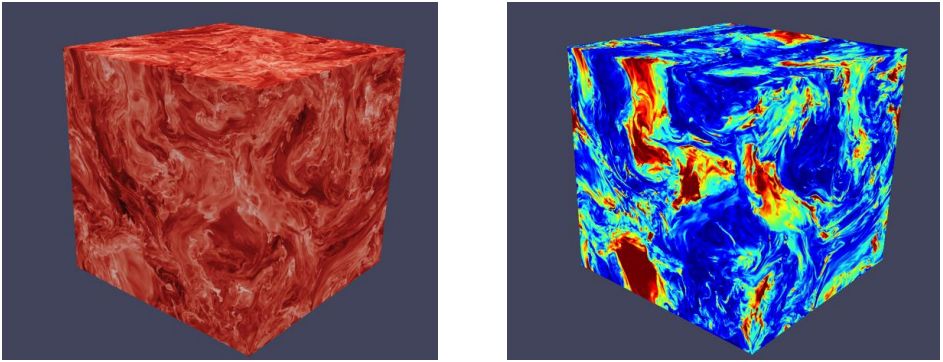

Une autre présentation, réalisée par Pierre Kestener, également chercheur à la Maison de la simulation, a illustré le recours aux processeurs graphiques (GPU) pour simuler des écoulements fluides en astrophysique. « Les GPU sont devenus des processeurs à part entière qui nécessitent de mettre en oeuvre des techniques de programmation spécialisées », a-t-il indiqué en rappelant que, de ce point de vue, l'architecture CUDA en 2007 avait constitué un point de rupture technologique et pédagogique. Depuis 2 ans, la Maison de la simulation est d'ailleurs Nvidia CUDA teaching center. Ainsi, ses ingénieurs ont entièrement réécrit le code Ramses-GPU destiné à la simulation de systèmes astrophysiques afin de l'adapter aux coeurs GPU. « 45 000 lignes de code en cours d'utilisation sur plusieurs applications », a souligné P. Kestener. Il est par exemple utilisé pour simuler les disques d'accrétion des systèmes proto-platénaires. « On remonte à la physique de formation des étoiles dans le milieu interstellaire ».

Fluctuations turbulentes d'un écoulement magnéto-hydrodynamique calculé avec le code RamsesGPU.

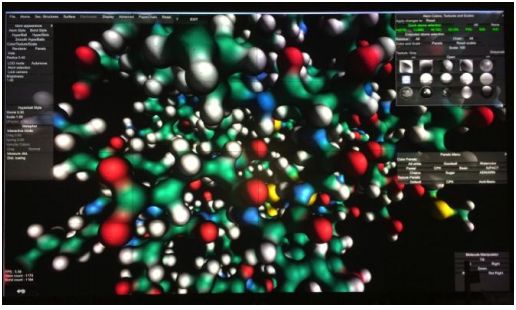

La troisième démonstration présentée lors de la visite a porté sur la visualisation des systèmes biologiques. Marc Baaden, chercheur au laboratoire de biochimie théorique du CNRS, s'intéresse au comportement des molécules qu'il essaie de simuler. « J'utilise une technique de dynamique moléculaire. Nous essayons de comprendre la saisonnalité de la grippe, un virus de la grippe représentant 5 millions de particules », explique-t-il. Le chercheur travaille aussi sur les canaux ioniques en cherchant à comprendre les mécanismes de communication entre les neurones du cerveau, notamment dans le domaine du tabagisme. Pour observer la « danse des molécules », son équipe a développé le logiciel UnityMol en C# à partir du moteur Unity3D utilisé pour créer des jeux vidéos. « On peut comprendre les molécules, les manipuler », explique M.Baaden. « Nous profitons des capacités que nous avons ici, à la Maison de la simulation pour étendre les capacités d'UnityMol. Sur les démonstrations en 3D, en termes de résolution, nous avons ici l'un des plus grands murs d'images en Europe ». Pour ces chercheurs qui doivent étudier un déluge de données, le défi, c'est de ne pas passer à côté de découvertes.

Le laboratoire de biochimie théorique du CNRS a développé le logiciel UnityMol à partir du moteur Unity3D.

(*) Installé en octobre 2012, le cluster de calcul Poincaré a été acquis auprès d'IBM dans le cadre du projet Equip@meso. Il fournit une puissance CPU de 33,9 Tflops (1 632 coeurs, puces Sandy Bridge E5-2670 à 2,6 GHz) complétée de 9,4 Tflops apportés par 19 978 coeurs GPU Nvidia Tesla K20M.

La Maison de la simulation prépare les évolutions du calcul intensif

0

Réaction

Ayant vocation à héberger des équipes pluridisciplinaires, composées de chercheurs et d'informaticiens spécialisés sur le calcul intensif, la Maison de la simulation relève le défi des architectures parallèles de demain.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire