Flux RSS

NAS

267 documents trouvés, affichage des résultats 71 à 80.

| < Les 10 documents précédents | Les 10 documents suivants > |

(17/11/2010 12:34:44)

Silicon Valley 2010 : Cartes Flash et sauvegarde cloud (2e partie)

Si vous nous avez suivis en juin dernier, vous vous souvenez peut-être que nous avions déjà rencontré les dirigeants de Fusion-IO dont le directeur scientifique n'est autre que le célèbre Woz, Steve Wozniak, le cofondateur d'Apple avec Steve Jobs. Malheureusement, une fois de plus Woz nous a fait faux bond pour cause de déplacement en Europe. Nous avons toutefois pu discuter avec les dirigeants de Fusion-IO qui nous ont dévoilé leurs produits à venir. Toujours basée à Sake Lake City mais avec des bureaux commerciaux à San José, la start-up reste spécialisée dans les cartes PCIe équipées de mémoire Flash SLC ou MLC (selon la capacité) pour accélérer les échanges sur les serveurs. Cette mémoire additionnelle, qui vient se placer entre la RAM et les disques SSD internes ou intégrés dans des baies SAN, dope les échanges entre les processeurs et les logiciels en réduisant le temps de latence lié à l'usage d'un réseau. HP, IBM et Dell revendent aujourd'hui ces produits en OEM pour améliorer les performances de leurs serveurs notamment en transactionnels.

Jim Dawson vice président en charge des ventes et Lance Smith COO chez Fusion-IO

Mais pour tenir ses concurrents à distance, LSI et Texas Memory Systems notamment, Fusion-IO préannonce une troisième famille de cartes, en complément des séries ioDrive et ioDrive Duo, les ioDrive Octal. Cette dernière offre une capacité de stockage maximale de 5,12 To, toujours avec des composants Flash Nand MLC sur un bus PCIe Gen2 16x. Ce qui permettrait un débit théorique de 6 Gbit/s en lecture et de 4,4 Gbit/s en écriture, jusqu'à jusqu'à 740 000 entrées / sorties par seconde (IOPS) en lecture et 1 112 000 IOPS en écriture et un temps de latence de 30 ms. Rappelons que les modèles ioDrive et ioDrive Duo plafonnent quant à elle à 640 Go et 1,28 To. Le prix des modèles ioDrive Octal n'est pas encore annoncé, mais il devrait être coquet (80 000 $ environ. Précisons qu'il faut compter 12 000 $ pour une carte ioDrive Duo de 320 Go et environ 20 000 $ pour la version 640 Go. « Nous avons créé quelque chose entre la DRAM et le stockage pour combler le fossé entre les deux technologies nous explique Jim Dawson vice président en charge des ventes chez Fusion-IO. Personne n'est encore arrivé sur le marché avec ce niveau de performances. Nous allons continuer à innover et nous n'avons pas peur de la concurrence. Nous ne saturons pas encore le bus PCIe, nous pouvons encore progresser. »

Carte ioDrive Octal offrant une capacité de stockage maximale de 5,12 To

Outil de monitoring à venir

En complément, la start-up annonce également un outil pour gérer ses produits. « Nos clients veulent précisément savoir ce qui se passe. Nous fournissons donc la plateforme IOSphere pour centraliser la supervision de nos produits ». Cet outil, disponible au 1er trimestre prochain, se compose en fait de deux éléments : ioManager pour gérer les cartes Fusion-IO dans un serveur et ioDirector pour un Datacenter. Enfin, pour réduire le temps de latence, ioMemory permettra placer en cache des données habituellement conservées dans une baie SAN ou NAS.

[[page]]

Sauvegarde en ligne avec i365

La même journée, nous avons été à la rencontre d'i365, une filiale de Seagate spécialisée dans la sauvegarde. Cette dernière annonce une solution de stockage en ligne qui concurrence celle de StorSimple que nous avons détaillé hier (voir lien). Mais là où StorSimple propose un appliance à installer dans l'entreprise pour ensuite dédupliquer et compresser les données qui seront sauvegardées dans un cloud, i365 préfère se reposer sur un VAR. C'est en effet ce dernier qui proposera aux PME-MPI une solution de sauvegarde mutualisée en ligne, un cloud de nos jours, grâce à un appliance i365 baptisé Evault CCSp (Cloud Connect Service Provider Programm). Terry Cunningham, président d'i365, nous a détaillé cette annonce qui compte déjà plusieurs partenaires en France : Akube, CFI, Diademys, Noeva, Act400 ou encore Champagne Informatique. « Nous proposons une solution de sauvegarde aux VARs qui souhaitent ajouter des offres de services cloud à leur catalogue pour ne perdre leurs clients. Les clients paient ici pour l'espace de stockage qu'il utilise dans une architecture multi couches » précise Terry Cunningham. Pour utiliser la solution Evault, les clients doivent installer un agent sur leurs serveurs pour assurer la déduplication et la compression des données qui seront stockées sur les Datacenter d'i365. La compagnie reste très discrète sur le nombre et les capacités de ses datacenters. En Europe un Datacenter à Amtserdam et un autre à Londres répondront aux besoins nous assure le dirigeant de la compagnie. « Le 1er back-up est complet et les suivants incrémentaux », nous précise George Hoening, responsable des produits et des services chez i365. « De base l'appliance est livré avec 10 To dont 3 To seulement sont activés. L'espace disponible est mis en service à la demande. Chaque appliance fonctionne avec une seule instance logicielle pour assurer la sauvegarde de plusieurs clients et éditer des factures détaillées ». Chaque sauvegarde est bien sûr séparée et cryptée dans cette architecture multitenant. Les données sont ensuite répliquées sur les datacenters d'i365 pour garantir une sécurité maximale.

Terry Cunningham, président d'i365

En cas de défaillance du revendeur, le client ne pourra pas s'adresser directement à i365. Il devra repasser par un autre VAR pour retrouver son service. « Il n'y a pas de contrat entre i365 et les entreprises, précise à ce sujet Terry Cunningham. Le business model passe uniquement par les partenaires qui possèdent l'appliance sur leur site. Précisons que cette dernière est vendue 17 800 € avec 3 To activés et la sauvegarde facturée 0,80 centime pour un Go par mois. « Nous avons trouvé un intérêt particulier en France pour notre solution » explique Valerie Fawzi, responsable marketing chez i365. « C'est une première étape pour que les VARs deviennent des partenaires de confiance pour la sauvegarde d'autres services à venir. Par exemple héberger temporairement des machines virtuelles en attendant qu'un client résolve un problème serveur », souligne Terry Cunningfham. On le voit à différence de StorSimple qui supprime les intermédiaires entre le client et son stockage cloud, i365 souhaite réinstaller les revendeurs spécialisés au coeur du business cloud.

Silicon Valley 2010 : Sécurité et stockage dans le cloud (1e partie)

Sécurité réseau dans le cloud

Fondée en 2006 par J. Chaudhry et K. Kailash, Zscaler propose aujourd'hui aux entreprises un service de sécurité en mode SaaS basé sur son cloud hébergé dans 44 datacenters (en colocation) à travers le monde. Cette solution repose sur une idée simple : au lieu de multiplier les appliances de sécurité dans les entreprises pourquoi ne pas transiter par un serveur proxy, celui du cloud de Zscaler en l'occurrence. Ce dernier propose en fait un service de filtrage capable de contrôler les accès web et la messagerie d'un poste de travail ou d'un terminal mobile de type smartphone ou tablette Internet. Le blocage des spams, le filtrage web et la gestion de la bande passante suivant les politiques réseau de l'entreprise permettent de réduire la charge des serveurs d'un tiers selon les dirigeants de Zscaler. La première question qui vient à l'esprit au mot proxy est bien sûr celle de l'impact sur les performances. « Nous avons déployé notre cloud dans une quarantaine de datacenters dans le monde, avec plusieurs instances dans les noeuds et un coeur centralisé pour suivre les utilisateurs lors de leur déplacement. Ainsi un utilisateur français à Sunnyvale (le siège de Zscaler en Californie, NDLR) sera automatiquement géré par le Datacenter Fremont pour réduire le temps de latence » précise Jay Chaudhry, CEO de Zscaler. « Nous conservons dans notre base de données tous les profils des utilisateurs qui pourront être appliqués n' importe où dans le monde. Il ne s'agit pas de synchronisation instantanée, mais de ce que nous appelons shadow policies. Nous avons passé 5 années à déployer nos appliances dans les datacenters et à peaufiner l'équilibrage de charge de notre proxy configuré par 10 Gigabit».

LVMH et la CINP, déjà clients en France

Plusieurs entreprises françaises utilisent déjà le service proposé par la société de Sunnyvale. « LVMH par exemple a renoncé à ses 600 appliances de sécurité déployés dans ses nombreuses filiales dans le monde pour sécuriser ses accès web avec notre solution » poursuit le CEO. Et depuis cet été, la CINP de Paris (Chambre Interdépartementale des Notaires de Paris) met progressivement en place le service de filtrage en ligne du web et des e-mails de Zscaler pour ses 10 000 utilisateurs. Le service est facturé de 1 à 5 $ par utilisateur et par mois en fonction des options. « Toutes les compagnies sur Internet sont potentiellement nos clients » explique Shrey Bhatia, vice-président en charge des ventes chez Zscaler. « La sécurité est un marché en pleine croissance (20 à 30% par an) et comme cette solution marche partout dans le monde, nous sommes confiants. 50% de nos revenus proviennent déjà du reste du monde (hors USA, NDLR). »

Jay Chaudhry, CEO de Zscaler et Upa Hazarika, responsable produit

Côté technique, la solution de Zscaler repose sur un noyau FreeBSD. «Ce dernier était trop lent pour le 10 Gigabit, nous lui avons donc apporté des améliorations pour développer notre service. Nous avons également développé notre propre système de fichiers pour offrir un service rapide ». Il est utile de préciser à ce stade que K. Kailash, le cofondateur de Zscaler est également à l'origine de Netscaler, rachetée en 2005 par Citrix, et qu'un grand nombre d'ingénieurs de cette start-up ont travaillé sur le projet Zscaler.

Julien Sobrier, développeur chez Zscaler

Notre passage chez Zscaler a également été l'occasion de rencontrer uen développeur français travaillant pour la compagnie, Julien Sobrier, à l'origine d'un plug-in pour FireFox, BlackSheet capable de détecter les intrusions de Firesheep. Cette extension repère si quelqu'un utilise Firesheep sur le réseau où il est connecté, laissant à l'utilisateur le soin d'apprécier la meilleure attitude à adopter en matière de sécurité quand il utilise un réseau WiFi ouvert par exemple. Arrivé en 2003 dans la Silicon Valley, Julien Sobrier a travaillé plusieurs années chez Juniper avant de rejoindre l'équipe de R&D de Zscaler, forte de huit personnes à ce jour. «Nous travaillons sur les évolution virales et collaborons avec d'autres éditeurs comme Google et Microsoft pour prévenir les menaces sur Internet».

Pour revenir sur la solution cloud proposé par Zscaler, Julien Sobrier point les avantages de la plate-forme : analyse en temps réel, mise à jour instantanée des signatures virales, inspection ne profondeur des fichiers et enfin outil d'analyse du trafic. Les amélioration à venir pour les clients sur lequel travaille Julien Sobrier sont chercher du coté du data mining et d'une analyse encore plus profonde, notamment au niveau des fichiers PDF.

[[page]]

Le stockage émarge dans le cloud

Avec StorSimple, une start-up fondée en mai 2009 et installée à Santa Clara, on passe à un service cloud reposant sur un appliance baptisé Armada pour stocker et sauvegarder ses données sur les plates-formes d'Amazon, de Microsoft ou d'Iron Mountain. Avec un appliance Armada, les clients ont la possibilité de stocker des données localement et de faire des sauvegardes instantanées dans le cloud, de mettre en cache les données, de les stocker ou cde les répliquer dans un cloud. Pour ce faire, l'Armada Storage Appliance dispose des fonctions de déduplication primaire, de compression et de hiérarchisation automatique des données. Les informations conservées dans les nuages apparaissent comme des données stockées localement et s'intègrent à l'environnement de stockage existant.

Ursheet Parikh, CEO et fondateur de StorSimple

L'Armada identifie et enregistre «à chaud» toutes les modifications de données et les stocke sur des disques SSD. Lorsque les données sont considérées comme moins fréquemment utilisés, elles sont automatiquement migrés vers des solutions de stockage moins onéreuses comme le Serial ATA. Toutes les data stockées dans le cloud sont cryptées. « A la différence de certains acteurs qui sont obligés de s'associer pour proposer un service de stockage cloud, nous proposons une solution clef en main » assure Ursheet Parikh, CEO et fondateur de StorSimple avec Guru Pangal, anciennement directeur général et vice-président chez Brocade. La société est financée à hauteur de 8 millions de dollars par Redpoint Ventures et Index Ventures. « Notre appliance est simplement vu comme un volume iSCSI et travaille en temps réel pour optimiser le travail des applications », explique encore Ursheet Parikh, auparavant responsable marketing produit chez Cisco.

3 appliances au catalogue

La start-up joue également la complémentarité avec les solutions de Microsoft. Son service de stockage en ligne est optimisé pour les applications SharePoint, Exchange, Windows et les machines virtuelles. Enfin quand une entreprise utilise l'option capture instantanée, le service CloudClone va transférer une image complète, passée à la moulinette compression et déduplication avant d'arriver sur le cloud. Par la suite, les changements supplémentaires seront de simples snapshoot. Trois appliances sont en fait proposés par StorSimple : l'Armada 1010 (à partir de 10 000 $) pour un volume de stockage de 10 To, l'Armada 5010 (30K$) pour 20 To et l'Armada 7010 (50K$) pour 40 To. On paie en fait pour ce qui est injecté dans le cloud et la prochaine release du logiciel maison supportera la migration automatique vers un nouvel appliance.

Christophe Morton, directeur marketing de StorSimple avec l'appliance Armada 1010

(...)

Stockage : EMC acquiert Isilon

La consolidation dans le secteur du stockage bat son plein. L'année 2010 a été riche en acquisition et la fin de l'année ne dément pas ce dynamisme. Au coeur des mouvements, EMC revendique depuis 1 semaine la palme de la gourmandise avec deux acquisitions. La plus récente concerne le rachat d'Isilon, spécialiste du stockage en cluster pour des clients à fort volume de données (notamment les chaînes de télévision, mais aussi les scientifiques à travers le décodage du génome par exemple). Le prix de l'acquisition est de 2,25 milliards de dollars. Pour mémoire, HP a racheté 3Par pour 2,4 milliards de dollars au mois de septembre dernier.

Sur les termes financiers, EMC va racheter des actions Isilon au prix de 33,85 dollars. Les discussions pour cet accord avaient été dévoilées par la presse économique américaine au mois d'octobre dernier. Dans le communiqué commun, EMC souhaite que l'opération se finalise avant la fin de cette année. Sur le plan technique, la société de Hopkinton devrait coupler Atmos et les solutions d'Isilon pour fournir une infrastructure de sauvegarde dédiée à la gestion des « Big Data ». Cette activité pourrait représenter jusqu'à 1 milliard de dollars au second semestre 2012. Pour Joe Tucci, PDG d'EMC, « les vagues inéluctables du cloud computing et des données massives, sont une réalité. Les clients recherchent donc de nouveaux moyens pour stocker, protéger, sécuriser et ajouter de l'intelligence à l'énorme quantité d'informations qu'ils accumuleront au cours de la prochaine décennie. EMC, en combinaison avec Isilon, se situe au carrefour de ces tendances avec des produits de premier plan. »

Bus Tech auparavant

Il y a moins d'une semaine, EMC avait annoncé l'acquisition de Bus-Tech. Cette dernière, basée à Bedford, dans le Massachusetts, fournit des VTL (Virtual Tape Library), un système de stockage comprenant un serveur, plusieurs disques et un logiciel émulant cet espace disque en bande magnétique. Bus-Tech propose des solutions à destination des mainframes, elle concurrençait directement IBM dans la sauvegarde des données sur les grands systèmes.

Le montant de cette transaction n'a pas été annoncé. Bus-Tech sera intégré à la division « Backup Recovery System » d'EMC.

Microsoft pousse Hyper-V pour combler son retard dans le cloud privé

Microsoft a conclu un partenariat avec six grands fournisseurs de solutions matérielles pour proposer des architectures de référence qui aideront les entreprises à construire des clouds privés de type IaaS (Infrastructure-as-a-Service). Dell, Fujitsu, Hitachi, Hewlett-Packard, IBM et NEC sont les principaux partenaires de ce programme baptisé Hyper-V Fast Track Cloud qui propose des plates-formes prédéfinies et certifiées pour assembler et configurer plus rapidement des clouds privés reposant sur les solutions de l'éditeur.

L'annonce fait partie d'un certain nombre de nouvelles initiatives de Microsoft pour offrir davantage de soutien aux entreprises intéressées par le déploiement de clouds reposant sur la technologie Hyper-V, et ce en interne ou via un prestataire de services informatiques. Rappelons que Hyper-V est l'hyperviseur de type 1 livré avec Windows Server 2008 R2, pour installer plusieurs machines virtuelles sur un serveur physique.

"Nous pensons que ce programme va accélérer le déploiement des projets clouds. Microsoft a une position unique sur le marché du cloud computing avec ses plates-formes, ses infrastructures et ses liens avec de nombreux partenaires », nous a précisé lors de cette annonce Jérôme Trédan, directeur de la division serveurs chez l'éditeur de Redmond. « Une des bases de ce programme a été le lancement de l'offre reposant sur la plate-forme HP BladeSystem Matrix (voir lien). Le programme d'engagement Hyper-V Fast Track Cloud étend aujourd'hui cette base à 80% des constructeurs présents en France. »

Des architectures de référence pour aller plus vite

Pour chacun des six partenaires, Microsoft propose une architecture de référence ainsi que la documentation technique pour installer les logiciels. Par exemple, le HP Cloud Fondation pour l'architecture Hyper-V montre comment intégrer les équipements et les logiciels BladeSystem Matrix (serveurs stockage et réseau), System Center et Windows Server 2008 R2 Hyper-V dans un cloud privé.

Les architectures de référence sont censées régler toute une série de problèmes de mise en oeuvre comme la façon dont les couches réseau et stockage vont travailler ensemble, combien de machines virtuelles peuvent être déployées sur un serveur physique et enfin comment opérer le basculement avec les systèmes existants. Les architectures de référence de Dell, HP et IBM ont été dévoilées lors de la conférence Microsoft TechEd à Berlin et celles des autres fournisseurs le seront dans les prochains mois.

En plus de Fast Track, la société a également commencé à sélectionner les prestataires qui seront capables de fournir des services cloud reposant sur la technologie Hyper-V dans le cadre du programme Hyper-V Cloud Service Provider. A ce jour, l'éditeur a accrédité plus de 70 fournisseurs, dont Agarik et Linkbynet en France. Mathieu Demmor, responsable marketing chez ce dernier prestataire, nous a expliqué vouloir adresser le marché des TPE-PME avec ses offres clouds privés Hyper-V. « Une offre infrastructure pour des budgets serrés qui démarre à 550 € HT par mois pour une instance virtuelle web et une disponibilité de 99,5% et passe à 1470 € HT par mois pour 4 machines virtuelles avec une dispo de 99,75%. »

Un effort indispensable pour suivre et rattraper Vmware

Microsoft propose des formations à ces prestataires et intégrateurs pour accompagner les projets de clouds privés chez les clients. Un ensemble de guides, Hyper-V Deployement Guides, sont également fournis pour mettre en place des clouds privés avec une grande variété d'équipements.

Pour les intégrateurs travaillant pour le compte d'entreprises, Microsoft propose un programme baptisé Hyper-V Cloud Accelerate, qui aidera les intégrateurs à mettre en place des systèmes de test et à déployer des systèmes de production. Les conseils et les partenaires de Microsoft accompagneront le mouvement. « "Les nouveaux programmes sont probablement nécessaires pour aider Microsoft à vendre Hyper-V et System Center comme des pièces de base pour les clouds internes », a souligné Derrick Harris, analyste chez GigaOm, sur son blog. « Le principal compétiteur sur le marché des hyperviseurs pour le cloud est Vware, qui a fait un excellent travail marketing pour pousser ses produits de virtualisation en tant que solution pour les clouds. Considérant le leadership significatif de VMware sur le marché et les esprits, Microsoft a besoin d'accompagner les utilisateurs vers sa technologie Hyper-V-est-connecté-au-cloud» si elle veut combler l'écart. "

L'éditeur de Redmond a annoncé ces services au cours de sa conférence TechEd Europe, qui se tient cette semaine à Berlin.

Crédit photo : D.R.

Mises à jour d'importance chez NetApp

Bien installé sur le marché du stockage en réseau, avec un chiffre d'affaires qui approchent les 4 milliards de dollars, NetApp bénéfice d'une demande qui croît de manière conséquence. « Le stockage est aujourd'hui l'investissement IT clef dans les entreprises » a souligné Andreas König, directeur général Europe de NetApp, lors d'une conférence de presse à Amsterdam. Avec 69 000 systèmes installés en Europe, la société de Sunnyvale se classe deuxième sur la zone EMEA, avec 16,4% du marché selon IDC au deuxième trimestre 2010, mais première en Allemagne grâce à sa collaboration étroite avec Fujitsu. L'ambition clairement affichée est de détrôner EMC en 2012. Pour ce faire l'accord passé avec Fujitsu en Europe prend toute son importance. « Nous développons notre relation avec Fujitsu au fur et à mesure, selon les opportunités qui se présentent » souligne Andreas König qui a beaucoup travaillé sur cet accord.

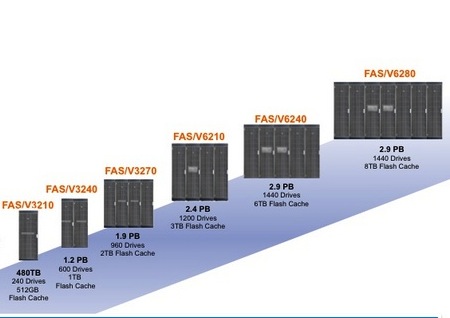

Pour accompagner le développement du marché, la société de Sunnyvale annonce donc une mise à jour importante de ses solutions de stockage en réseau avec l'arrivé de Ontap 8.0.1, l'OS maison disponible pour tous les anciens produits de la marque, de l' architecture One Unified Storage qui supporte sur une même carte réseau les protocoles FCoE, iSCSI, NTS et CiFS, de la solution virtualisée FlexPod qui regroupe les outils de Cisco, VMware et donc NetApp, de OnCommand, un outil d'administration, et enfin des baies FAS/V3200 (voir ci-dessous) et 6200.

Mise à niveau de l'OS maison

Au coeur des solutions NetApp, on trouve depuis 15 ans l'OS maison. ONTAP 8.0.1 apporte en complément de l'outil de déduplication un algorithme de compression développé en interne pour améliorer la gestion de l'espace de stockage. Le constructeur annonce également le support des SSD et l'arrivée de disques durs SAS de plus grande capacité (jusqu'à 600 Go à 10 ou 15 tr/m en 2,5 ou 3,5 pouces) en complément des cartes mémoire flash (FlashCash) et des SSD. Soit quatre niveaux de stockage pour répondre à tous les besoins des entreprises. NetApp introduit d'ailleurs la notion de FlexCache en complément de son offre FlashCache. Derrière cette appellation se dissimule une solution destinée aux petites filiales de grands groupes capables de stocker les données les plus demandées et d'éviter les transferts incessants sur le réseau interne à l'entreprise. « On envoie les données dont ont besoin les filiales pour travailler » précise à ce sujet Andreas König. Les informations peuvent être stockées sur un espace réservé sur des disques SAS, SATA ou même SSD pour offrir de meilleures performances nous a expliqué John Rolloson, directeur technique EMEA de NetApp. « Cette solution peut également répondre aux besoins des fermes de calcul de certaines sociétés ».

Réseau unifié pour simplifier l'infra

Pour réduire la complexité des infrastructures réseau partagées entre serveurs et stockage, NetApp avance sa solution One Unified Storage. Reposant sur un produit fourni par un partenaire (QLogic), cette carte assure la connexion avec les équipements FCoE, iSCSI, NFS (Unix) et CIFS (Windows) en mêlant plusieurs formats de données, mode blocs et fichiers. « Un seul câble Ethernet 10 Gigabits peut gérer toute son infrastructure de stockage » précise John Rolloson.

Pour concurrencer la plate-forme virtualisée pour datacenter VBlock proposée par EMC, Cisco et VMware, NetApp annonce l'offre FlexPod qui rassemble et certifie également les produits UCS et Nexus de Cisco et les outils VSphere et VCenter. A la question de savoir quels sont les bénéfices de FlexPod vis-à-vis de VBlock, Andreas König nous a simplement expliqué que la solution de NetApp proposait sans supplément la déduplication, le cloning et le multitenancy. « En fait nous proposons déjà depuis plusieurs mois cette solution à nos clients avec nos partenaires Cisco et VMware ». La principale nouveauté aujourd'hui c'est l'habillage marketing avec l'appellation FlexPod qui regroupe une solution préconfigurée et certifiée pour fournir un partage sécurisé et multitenant des infrastructures entre plusieurs clients. NetApp apporte par exemple sa technologie Multistore pour garantir la sécurité et l'étanchéité des données stockées dans un FlexPod. Pour l'administration de la plate-forme serveur, NetApp se repose sur Vcenter même si d'autres fournisseurs sont proposés (BMC, CA, Microsoft, HP, Citrix, IBM...). Pour superviser les systèmes de stockage, NetApp a d'ailleurs étoffé sa solution interne désormais baptisée OnCommand Management Software Suite. « Quand, je suis arrivé chez NetApp il y a 5 ans déjà, il était nécessaire se fournir à l'extérieur pour analyser et automatiser la gestion des données. Aujourd'hui nous franchissons étape majeure avec une solution de management ouverte », assure le directeur technique. Une API est en effet proposé pour faciliter l'intégration aux outils des principaux éditeurs du marché.

Compression et déduplication sur toutes les baies

Terminons avec les annonces de baies de stockage NAS/SAN dont les prix vont de 20 000 à 2 millions d'euros. En entrée de gamme, on trouve les FAS/V3210, 3240 et 3270 qui offrent de 1200 à 1920 To avec des disques SATA, SAS et SSD et de 1 à 2 To sur les cartes Flash. Les FAS/V6210, 6240 et 6280 offrent plus d'options en configuration et en extension avec une capacité maximale de 2880 To (SATA, SSD et SSD) et toujours 8 To en cache Flash. NetApp qui a déjà expédié plus de 150 000 baies de stockage change progressivement de stratégie. « Nous savons que les infrastructures doivent évoluer et ce que nous proposons, c'est de standardiser les infrastructures pour offrir la meilleure base pour le cloud », rapporte John Rolloson. Pour ce faire, la compagnie passe par plus de software. Après le raté Data Domain, NetApp a ainsi poursuivi le développement de sa propre solution de déduplication, aujourd'hui complété par un algorithme de compression également développé en interne. « A l'époque, la solution de dédup de DataDomain était meilleure que la notre, mais nous avons continué à la travailler faute de mieux » explique avec franchise John Rolloson. « Nous offrons aujourd'hui un taux de 5 pour 1 en compression et déduplication, soit un maximum de 75% en compression et 30 en déduplication. Et en back-up notre ratio est même meilleur ». Tous ces outils sont livrés avec la release 8.0.1 d'ONTAP ainsi qu'un utilitaire baptisé Space Saving pour estimer le gain possible grâce à la compression et la déduplication.

Illustration principale : Disques SSD 2,5 pouces dans une baie NetApp

Selon IDC, les technologies de stockage doivent améliorer leur bilan énergétique

La migration vers de plus petits disques durs et l'utilisation croissante de SSD font parties des technologies clés qui permettront de concevoir des datacenters « basse consommation » où les coûts en refroidissement seront revus à la baisse, explique dans une note IDC. Selon le cabinet d'études, le recours à des technologies de stockage plus efficace devrait permettre de stabiliser, voire même de réduire, la puissance et les dépenses en refroidissement des centres de calcul d'ici à 2014.

« Il ne fait aucun doute que les difficultés économiques des années 2008 et 2009 ont modifié les attitudes et les comportements des responsables informatiques et [des fabricants] de systèmes, beaucoup montrent de l'intérêt pour l'adoption rapide de systèmes de stockage plus rentables », a déclaré David Reinsel, vice-président du groupe Storage Systems chez IDC. L'analyste explique encore que la consommation et le refroidissement des disques durs à plateaux ne sont pas encore entrés dans une phase de décroissance et que l'augmentation incessante des capacités (3 To aujourd'hui en Serial ATA chez Seagate et Western Digital) se traduit par une «une croissance renouvelée coûts en énergie ». Mais pour l'instant, la migration vers des disques durs plus petits de 2,5 pouces (en remplacement des 3,5 dans les baies de stockage), la progression continue des SSD et de l'adoption de technologies qui rendent plus efficace l'utilisation des capacités existantes, telles que la déduplication des données, la compression, les classes de stockage et l'allocation dynamique, réduira les coûts globaux en énergie globale d'après le cabinet d'études américain.

+38% pour les ventes de baies de stockage de 2008 à 2009

Selon le rapport d'IDC, les systèmes de stockage restent toujours un des investissements majeurs dans les entreprises même avec un fort ralentissement économique, du fait de la hausse continue des données à conserver. Les livraisons en systèmes de stockage externes ont ainsi augmenté de 38% de 2008 à 2009. Dans le même temps, les expéditions de disques durs pour baies de stockage externes ont augmenté de seulement 10%. Les responsables informatiques ont donc acheté plus de stockage, mais comme l'efficacité des technologies a augmenté les budgets ont été remis à plat ou diminués, selon IDC. Bien que les technologies telles que la déduplication des données et le thin provisioning sont effectivement les plus efficaces une fois déployées, la migration vers des composants consommant moins d'énergie, et générant moins de chaleur, apportent des économies d'énergie plus importantes sur le long terme.

Parmi les technologies consommant moins de puissance citons les disques durs Serial ATA (SATA), qui tournent généralement à 5400 tr / min ou 7200 tr / min, mais offrent deux fois plus de stockage de données qualité de leurs homologues haute performance à 10 et 15 000 tr/m. Et certains modèles 2,5 pouces hybrides comme le Seagate Momentum XT 500 Go (voir illustration) compensent leur faible vitesse de rotation (7200 tr/m tout de même) avec une quantité généreuse de mémoire Flash (4 Go) pour stocker les fichiers ou les blocs les plus utilisés.

Le SATA de plus en plus présent

Les disques SATA sont de plus en plus popularité dans les systèmes de stockage multi-tiers comme les solutions de 3PAR aujourd'hui tombé dans le giron de HP. L'architecture des baies repose sur plusieurs classes de stockage ou les données les plus importantes et les plus demandées sont stockées sur des SSD, les moins critiques sur des disques FC ou SAS , et les autres semi-archivées (nearline) sur des SATA. "Ensemble, ces technologies joueront un rôle essentiel dans le ralentissement de la croissance de la la consommation des systèmes de stockage en entreprise, des coûts en refroidissement, et l'empreinte carbone associée, au cours des prochaines années », indique IDC.

Illustration principale : Disque dur 2,5 pouces hybride Seagate Momentus XT (500 Go à 7200 tr/m avec 4 Go de Flash en cache)

Solutions de stockage : Compubase livre son étude 2010

Premier constat, le nombre de revendeurs de produits de stockage avoisine les 7000, soit près 50% de l'ensemble des sociétés impliquées dans la fourniture de matériel et de services IT en France. Une très grande partie d'entre eux est impliqué dans la commercialisation de périphériques de sauvegarde ou de disques durs. Les revendeurs de solutions de stockage pour serveur sont moins nombreux mais représentent tout de même un part importante des professionnels présents sur le marché du stockage. En revanche, les revendeurs de solutions d'hébergement fournies par des tiers constituent encore une niche.

Des partenaires plutôt locaux ou régionaux

Dans le rangs des 7000 partenaires comptabilisés par Compubase, ceux dotées d'un effectif compris entre 2 et 9 personnes sont de loin les plus représentés. La proportion de ceux qui comptent de 50 à 249 salariés est inférieure à 10%. En terme de positionnement géographique, les partenaires IT présents sur le marché du stockage rayonnent la plupart du temps au niveau local ou régional.

D'un point de vue financier, les ventes de produits et de solutions de stockage réalisées par les partenaires représentent en moyenne 10% de leur chiffre d'affaires global. Résultat, les deux tiers des sociétés interrogées par Compubase réalisent 10 K€ de revenus par an en revente de produit et de solutions de stockage. Les partenaires qui réalisent plus de 100 K€ de chiffre d'affaires annuel sur ce périmètre sont une minorité. Une analyse plus fine par type d'acteurs distribuant des produits de stockage montre que (hormis les grossistes et la revente aux particulier), ce sont les revendeurs et les intégrateurs d'infrastructures qui captent la plus grande partie des revenus du marché. Chose étonnante, bien qu'elles constituent en taille le deuxième vivier de sociétés présentes sur le marché du stockage, les SSII et les sociétés de services ne génèrent qu'une faible part de ses revenus.

Venedim renforce ses compétences dans le stockage

Créée en 2005, Venedim est une SSII très particulière qui se développe en créant des filiales spécialisées. Le but est d'échapper au syndrôme de la SSII généraliste, celle qui couvre toutes les fonctions et emploie une grande masse de collaborateurs. Olivier Frerot, le PDG de Venedim, veille à spécialiser ses équipes en impliquant le mangement comme actionnaire des filiales. Après « infrastructures », « consulting », « télécom et réseaux », Venedim lance « Venedim Storage ». Une opération plus complexe que les autres.

Venedim opérait déjà dans le secteur du stockage et continuera à le faire avec sa filiale infrastructures. Cette dernière travaille sur le conseil en solutions de stockage. En plus, Venedim développe maintenant des relations capitalistiques et commerciales avec une société toulousaine, Solution Data. Venedim prend 35% de cette société, qui elle même prend 25% de Venedim Infrastructures. Solution Data s'occupera de la partie intégration des solutions de stockage.

Spécialisée dans les produits Netapp

Solution Data est spécialisée à 80% dans les produits NetApp. Elle travaille également sur EMC, Hitachi, Symantec et VMware. Focalisée initialement sur un contrat avec Airbus, ses dirigeants souhaitent se déployer nationalement, l'accord avec Venedim leur apporte la solution. « Nous créons une synergie entre leurs activités de déploiement de solutions de stockage et nos activités initiales de conseil sur cesecteur» souligne Olivier Frerot.

Venedim, qui compte réaliser 13 millions d'euros de chiffre d'affaires en 2010, devrait atteindre entre 16,5 et 18 ME en 2011. En plus de sa stratégie de filialisation, la société compte s'implanter en régions. Soit par filiales, soit par des directions régionales. Une filiale est en place sur l'Ile-de-France, deux autres devraient se créer début 2011 à Lyon et Toulouse, le grand ouest sera pourvu plus tard, sans doute par une direction régionale.

Crédit photo : NetApp

3 classes de stockage dans les outils Symantec Veritas

Veritas Operations Manager 3.1 et Storage Foundation High Availability 5.1 ont été enrichis de « storage templates », autrement dit de modèles qui permettent aux administrateurs d'automatiser leurs modalités de stockages selon des critères de performance et de protection des données.Chacun des trois modèles Or, Argent et Bronze, peut ainsi être utilisé pour déterminer le type de disque, le niveau de RAID et pour choisir une allocation des données soit par « thin provisioning » (approvisionnement dynamique) soit par une méthode plus classique de surallocation.

Par exemple, si un administrateur décide qu'aucun e-mail ne doit contenir d'informations financières sensibles sur l'entreprise avec un niveau « Bronze », le système propose de stocker les données sur des disques Serial ATA (SATA) au sein d'un NAS avec une protection de type RAID 6. L'administrateur peut également mettre en place un niveau « Or » pour toutes les bases de données SQL, de manière à stocker automatiquement tous les datas sur des systèmes haute performance, beaucoup plus chers, de type Solid State Drive (SSD), avec réplication et protection de niveau RAID 10.

Simplifier le travail des administrateurs

Selon Niraj Zaveri, senior product marketing manager chez Symantec, les administrateurs système doivent généralement prévoir des espaces de stockage pour héberger les applications serveur, puis qualifier ces machines en fonction des exigences des applications dans une base de données, et ensuite créer un volume de stockage ou un système de fichiers dédié dans zone de stockage réseau (SAN) ou un NAS. Ce processus exige, en particulier dans les environnements de serveurs virtualisés, l'écriture de nombreux scripts manuels. « Avec ces outils, il suffit simplement de définir l'ensemble des services de stockage disponibles pour les applications, » explique-t-il. « Le processus automatise l'identification des périphériques de stockage en fonction des services de stockage disponibles... et industrialise la gestion complexe du SAN sous-jacent. »

« Aujourd'hui, dans la plupart des centres de calcul, il n'existe pas de politiques visant à adapter les données en fonction du stockage, » ajoute Niraj Zaveri. « En général, chaque business unit correspond à un type particulier de stockage et de capacité. Les administrateurs en effectuent le remplissage, souvent par surallocation de stockage, d'où un certain gaspillage. » La dernière offre de Symantec permet aux administrateurs d'estimer l'importance de chaque application, de faire les choix de manière à adapter le besoin chaque fois que c'est nécessaire. «Il s'agit de s'appuyer, autant que possible, sur ces modèles, » explique-t-il. « Les nouvelles fonctionnalités de Veritas Operations Manager permettent d'établir des passerelles entre le serveur, la base de données et la gestion du stockage pour optimiser l'utilisation des capacités, les opérations d'allocation, maintenir la conformité, en assurer la disponibilité sous Unix, Linux, Windows et les environnements VMware. » Ils contribuent aussi à effacer la limite entre l'administration serveurs et l'administration de stockage. « Le métier de l'administrateur, très spécialisé, a évolué vers un rôle plus général dans lequel il peut être à la fois administrateur Unix et gérer les applications de stockage dans l'environnement Unix, » a-t-il dit.

Test de panne pour vérifier le système

Symantec a également ajouté à ses logiciels Operations Manager un outil de reporting capable de générer des rapports selon des critères prédéfinis, comme identifier automatiquement quelles sont les ressources de stockage sous-employées, suivre l'utilisation en analysant les fichiers des bases de données, effectuer des comparaisons par disques et par RAID. A noter que les capacités de stockage non utilisées peuvent être réaffectées par l'administrateur dans un autre espace. Parmi les nouveaux outils de surveillance en temps réel, la fonction Fire Drill permet aux administrateurs de simuler une panne système afin de tester les configurations de continuité de service et de reprise après un crash. Fire Drill prend une photographie instantanée du serveur de production, qu'il soit physique ou virtuel, et transfère les données vers un système de récupération après sinistre, qui remet les données en ligne pour tests.

Si Veritas Operations Manager 3.1 est d'ores et déjà disponible, Veritas Storage Foundation HA 5.1 ne sera livré qu'en novembre. Symantec informe par ailleurs que son logiciel Veritas Operations Manager est fourni sans frais supplémentaire aux clients qui achètent Storage Foundation HA.

Illustration : Approvionnement dynamique dans Veritas Operations Manager 3.1

| < Les 10 documents précédents | Les 10 documents suivants > |