Flux RSS

108538 documents trouvés, affichage des résultats 1341 à 1350.

| < Les 10 documents précédents | Les 10 documents suivants > |

(13/12/2011 10:18:05)

Les défis des DSI européens face à la crise selon Gartner

Avec l'extrême incertitude qui affecte toutes les entreprises opérant dans la zone euro, les DSI doivent agir immédiatement pour protéger leurs entreprises, selon le Gartner. « Ils sont les seuls cadres disposant d'une visibilité suffisante et de la capacité à répondre aux défis posés par la crise de la zone euro, note David Furlonger du Gartner. Pour lui, « les chefs d'entreprise réclament de la part des DSI une plus grande efficacité de leur informatique et la faculté d'ajouter de la valeur à l'entreprises. La crise est l'occasion pour l'informatique de démontrer sa valeur réelle, avec des étapes importantes et audacieuses à franchir. »

Pour le Gartner, la crise actuelle a tout pour saper totalement la zone euro, l'ensemble de l'Union européenne et au-delà ! Poussée par l'omniprésence de l'internet, la crise affecte négativement chaque entreprise ou individu faisant des affaires dans ou avec la région. Le métier du CIO est de garantir la continuité d'activité. Le Gartner leur conseille d'être vigilants sur quatre points :

1er défi : la volatilité du marché

Les conditions du marché nécessitent pour les DSI d'aider à développer un environnement de travail qui favorise la vitesse, l'agilité et l'adaptabilité, sans sacrifier la notion de responsabilité. Les capacités de gestion du changement sont essentielles. Les fondamentaux pour réaliser une gestion efficace du changement sont la demande d'information, d'analyse, de flexibilité des ressources humaines et une structure de gestion plus décentralisée pour le commandement et le contrôle.

2ème Défi : les coûts d'investissement

Les coûts d'accès au capital à travers l'Europe vont probablement continuer de se détériorer jusqu'à ce qu'intervienne une importante réparation des déséquilibres structurels entre pays et organisations. Le refus ou l'incapacité d'amortir la dette et de restructurer les bilans publics et ceux du secteur privé est un obstacle important à l'efficacité du marché. Les lignes de crédit seront probablement incertaines ou supprimées, obligeant les entreprises à réduire leurs stocks.

[[page]]

Dans cette situation, les DSI devront faire face à une croissance zéro de leur budget, et à des réductions substantielles dans les investissements et les budgets opérationnels disponibles.

3ème défi : la gestion du capital humain

Des millions de personnes sont sans emploi en Europe. De plus, la crise pèse sur les salaires, les avantages et les conditions de travail, le tout combiné à un coût de la vie élevé. Une situation aggravée par le manque de fonds de retraite, l'augmentation de l'âge des départs en retraite et les pertes de bénéfices.

Les DSI et les dirigeants d'entreprises sont confrontés à des problèmes importants en termes de RH pour récompenser et motiver du personnel, obtenir des fonds pour embaucher de nouveaux talents, et traiter les difficultés du personnel. Les DSI doivent également prévoir les problèmes de rétention des travailleurs étrangers pour passer à de meilleures opportunités ou le retrait de permis de travail à ceux nés hors UE en réponse à la montée rapide du chômage.

4ème défi : la gestion des risques

Les marchés de capitaux estiment que le risque de défaut de contrepartie du gouvernement est substantiel. La probabilité de hausses des fraudes internes et externes est forte. Du point de vue informatique, le risque opérationnel est accru par le biais des questions telles que les changements dans les obligations contractuelles et la continuité des activités. S'ajoute à cela l'augmentation continue des initiatives de conformité réglementaire dans les industries, ce qui aggrave la pression sur la vérification et les évaluations de gestion du risque et des workflows.

Pénurie de disques durs : Intel lance un avertissement sur résultats

Intel a averti que les résultats de son quatrième trimestre fiscal sera plus faible que prévu en raison d'une pénurie de disques durs. Le fabricant de puces anticipe désormais des revenus estimés à 13,7 milliards de dollars (+ ou -) contre une prévision précédente de 14,7 milliards de dollars.

L'industrie informatique va subir le contrecoup la réduction des approvisionnements de disques durs en raison des inondations en Thaïlande. Intel a indiqué dans un communiqué que les ventes de PC seront en augmentation sur le 4ème trimestre 2011, mais que les fabricants de PC commandent moins de processeurs à cause du manque de disques durs. La société prédit que cette pénurie va durer jusqu'au 1er trimestre fiscal de 2012. Les niveaux de production de disque dur reviendront à la normale dans la deuxième moitié de l'année, stimulant une demande accrue des processeurs.

Intel n'a pas révisé les autres perspectives financières pour ce trimestre ou pour l'exercice 2012. La société a prévu de publier ses chiffres du quatrième trimestre le 19 janvier 2012. (...)

Microsoft a livré Silverlight 5

Microsoft vient d'annoncer la version 5 de son plug-in Silverlight, en bêta depuis le printemps dernier. C'est l'une des technologies qu'il propose aux développeurs pour concevoir des applications fonctionnant à la fois sur Internet, sur un poste de travail et sur un terminal mobile.

Le plug-in gratuit pèse moins de 7 Mo et peut être installé en moins de dix secondes, assure Microsoft. Rappelons que Silverlight 5 inclut le support de l'accélération matérielle apportée par les processeurs graphiques (GPU) pour le décodage des flux vidéo au format H.264. Il bénéficie de l'impression Postscript vectorielle qui améliore la qualité et la taille des fichiers d'impression. Le rendu graphique en 3D s'appuie sur l'interface de programmation XNA sous Windows. Microsoft souligne par ailleurs que Silverlight 5 étend pour la première fois le modèle « Trusted Application » au navigateur web, ce qui évite à ce dernier de devoir gérer certaines tâches complexes, telles que le support de plusieurs fenêtres, dès lors que ces fonctions s'exécutent dans le cadre d'applications certifiées.

Quel avenir pour la technologie ?

Dans le même temps, certains s'interrogent toujours sur l'engagement à long terme de l'éditeur sur cette plateforme RIA (rich Internet application). Récemment, Microsoft a indiqué que les plug-in tels que Silverlight ne fonctionneraient pas avec l'interface de style Metro prévue pour son navigateur Internet Explorer (Metro est l'interface utilisateur, orientée applications mobiles, attendue avec le système d'exploitation Windows 8). A la place, l'éditeur de Redmond recourra à la technologie HTML5. Quant au vice-président Scott Guthrie, qui fut l'un des supporters de Silverlight, a rejoint l'équipe de la plateforme cloud Azure il y a quelques mois de cela. Malgré tout, l'éditeur poursuit sa route avec Silverlight. L'an dernier, en réponse aux rumeurs qui circulaient déjà, il avait expliqué qu'il proposait aux développeurs plusieurs technologies complémentaires.

Silverlight a encore du potentiel

Al Hilwa, analyste chez IDC, considère toujours que le plug-in a du potentiel pour l'instant. « Il y a une base importante d'applications ou de sites web écrits en Silverlight et leurs utilisateurs vont bénéficier des améliorations du runtime », en particulier du côté de l'accélération apportée par le décodage matériel des vidéos. « Viser des populations importantes d'utilisateurs avec HTML5 sur les navigateurs des postes de travail reste un défi parce que de nombreux utilisateurs vont continuer à recourir à des navigateurs non compatibles avec HTML5 dans les deux années qui viennent », ajoute Al Hilwa, même s'il s'attend à ce que, dans cinq ans, il y ait moins de sites qui supportent Silverlight, et s'il reconnaît que sur le poste de travail, le plug-in est sérieusement concurrencé.

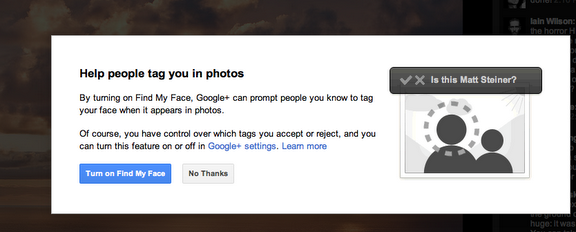

La reconnaissance faciale optionnelle pour Google+

Google a décidé d'ajouter une fonctionnalité optionnelle de reconnaissance faciale à son réseau social Google+, L'application Find My Face permet aux membres du site communautaire de se retrouver sur les photos mises en ligne par leurs amis. A l'instar de l'application Photo Tag Suggest de Facebook, cette fonction suggère de marquer tel ou tel nom en faisant correspondre les visages avec les photos du profil des utilisateurs ou d'autres photos sur le site.

«Pendant la période des fêtes, beaucoup d'entre nous se retrouvent avec leurs amis et familles, et si vous êtes comme moi, vous allez prendre un maximum de photos», a indiqué Matt Steiner, responsable du groupe Google Photos, dans un billet posté sur le blog de l'éditeur. « En ajustant Find My Face, nous incitons les personnes que vous connaissez à identifier votre visage dès qu'il apparaît sur des photos. Bien sûr, vous pouvez contrôler les tags en décidant de les accepter ou de les rejeter. Pour cela, Il suffit d'activer la fonction ou de la désactiver dans les paramètres de Google ».

Une action en justice contre Facebook

L'application de reconnaissance faciale devrait être opérationnelle d'ici quelques jours. Les membres de Google+ semblent largement satisfaits de cet ajout, selon les commentaires publiés sur le billet de Matt Steiner. Ils se réjouissent que cette fonctionnalité ne soit pas activée par défaut. Au cours de l'été dernier, Facebook avait suscité une certaine controverse en imposant son outil de reconnaissance faciale à l'ensemble de sa communauté.

Certains utilisateurs et analystes étaient méfiants du fait qu'un réseau social de la taille de Facebook puisse identifier des personnes simplement avec leur visage, Le mois dernier, l'Allemagne a annoncé qu'elle lançait une action en justice contre Facebook à cause de sa fonction de marquage de photos activée par défaut. Les lois du pays obligent les sociétés à alerter les utilisateurs sur la façon dont leurs données sont utilisées. et le gouvernement allemand avait déclaré, à cette époque, qu'il n'avait pas été en mesure de parvenir à un accord sur la question avec la société dirigée par Mark Zuckerberg.

En juillet dernier, Google s'était emparé de PittPatt et de sa technologie de biométrie pour suivre des visages dans une vidéo et reconnaître quelqu'un dans une série de clichés.

(...)

Facebook livre son compilateur PHP pour optimiser les pages utilisateurs

Pour afficher rapidement les activités de ses 800 millions d'utilisateurs, Facebook a revu la gestion de ses pages en PHP. Facebook a posté sur GitHub sa HipHop Virtual Machine (HHVM), que les ingénieurs de l'entreprise présentent comme un compilateur de PHP Just In Time (JIT). Selon Facebook, ce moteur d'exécution de PHP est 60% plus rapide que sa solution actuelle et utilise 90 % de mémoire en moins.

Facebook a travaillé sur HHVM dans ses environnements de test comme un remplaçant de son système PHP maison. Il devrait probablement s'en servir pour exécuter le code PHP du site Internet. Le site de réseau social avait déjà rendu public en 2010 le code source de son interpréteur PHP, baptisé HipHop .

PHP a été conçu à l'origine comme un langage de script web, utilisé pour ajouter du contenu dynamique aux pages web. Ce langage est un élément vital de Facebook, en ce sens qu'il est utilisé avec JavaScript pour générer chaque page d'accueil des abonnés. HipHop de Facebook transforme les extensions PHP en code C++ optimisé, rendant l'exécution des applications plus véloce. Les développeurs PHP de Facebook peuvent écrire leurs extensions en PHP et HipHop les transformera en code C++. Le site de Mark Zuckerberg a migré l'ensemble de ses propres serveurs sur HipHop en 2010 et a affirmé qu'il avait diminué l'utilisation CPU de moitié. Facebook a publié le code source de cet interpréteur pour que d'autres puissent l'utiliser. À l'époque, Facebook avait aussi développé un interpréteur PHP, appelé HPHPi, qui permet aux développeurs PHP d'exécuter leur code sans les compiler. L'exécution du code depuis HPHPi était plus lente que le code compilé et exécuté sur HipHop, mais il fournissait aux développeurs un moyen plus facile de le débuguer.

Un intérêt pour d'autres entreprises

Avec HHVM, les ingénieurs de Facebook ont combiné la vitesse d'un langage compilé avec la souplesse d'un langage en script. « Un traducteur dynamique peut observer les types de données que le programme exécute et générer du code machine spécialisé » précise Jason Evans, ingénieur chez Facebook dans un blog annonçant la sortie de HHVM. Le site de réseau social indique que HHVM sera réservé à son propre usage, mais « ces technologies d'accélération PHP pourrait être utiles pour d'autres entreprises intégrant PHP » a déclaré Al Hilwa, spécialiste des logiciels chez IDC. Il ajoute que « la complexité du code PHP peut bénéficier de ce type d'optimisation. PHP est le langage dominant côté serveur et une part importante des applications sont écrites dans ce langage ».

Jason Evans estime que du travail doit encore être fait sur HHVM. Le compilateur doit encore être réglé pour une utilisation en production. La traduction de cache code doit être affinée et l'utilisation de sa mémoire doit être réduite. « Nous espérons que la communauté PHP trouvera [HHVM] utile car il évolue et s'engagera avec nous à l'améliorer grâce à des discussions techniques, des rapports d'erreurs, et des contributions au code», conclut l'ingénieur de Google.

Un point sur les rumeurs relatives à Free Mobile

Avant même le lancement officiel de l'offre Free Mobile, Xavier Niel tacle sévèrement ses concurrents et annonce des prix imbattables, dans une interview accordée au site internet ITespresso en marge de la conférence LeWeb'11 : « Je suis étonné que nos concurrents n'aient toujours rien fait : il faut vraiment couper les prix ! [...] On a dit qu'on les divisera par deux : s'il y a des offres à sept euros sur le marché, il y aura alors des offres à 3,5 euros. »

Selon les derniers bruits de couloir, les premiers abonnements pourraient commencer à moins de six euros par mois pour deux heures de communication, mais sans accès internet. Pour moins de dix euros, il pourrait être possible de disposer d'un crédit de cinq heures de communication et d'un accès à internet dans la limite de 2Go de données. Enfin, pour 29,99€ (un prix historique chez Free), les abonnés pourraient bénéficier du tout illimité : communication, y compris vers certaines destinations étrangères et internet.

Cartes SIM envoyées aux abonnés pour tester le service ?

En aucun cas ces tarifs ne comprendront la location ou l'achat d'un terminal mobile. Free aurait cependant passé un accord avec plusieurs constructeurs et l'entreprise de crédit à la consommation Sofinco, afin de proposer des offres d'achat à crédit de téléphones.

Enfin, la rumeur la plus étonnante concerne l'envoi d'une carte SIM à l'ensemble des abonnés Free (quelques 4,36 millions de clients), afin qu'ils puissent très rapidement tester l'offre et s'abonner dans la foulée. Ce qui est sûr, c'est que le réseau Free Mobile couvre désormais plus de 25% de la population française, un seuil requis par l'Autorité de régulation des communications (Arcep) pour pouvoir devenir opérateur mobile. Il peut donc désormais être lancé à tout moment.

Motivés par l'arrivée de ce nouvel opérateur dans le secteur mobile, Orange (avec son offre Sosh), Bouygues (B&YOU) et SFR (Red) se sont tous lancés dans des offres low-cost ces dernières semaines. Des offres qui, si l'on en croit Xavier Niel, sont encore bien trop chères comparées à celles à venir de Free Mobile...

Google teste IPv6 sur son réseau interne

Lors de la conférence Usenix Large Installation System Administration (LISA), qui s'est tenue la semaine dernière à Boston, Irena Nikolova, ingénieur réseau chez Google, a évoqué le déploiement, en interne, d'un réseau IPv6 qui doit s'étendre à toute l'entreprise. Elle a notamment partagé les enseignements que Google a pu tirer de cette opération, et dont d'autres entreprises pourraient profiter au moment où certaines ont également entamé la migration de leurs propres réseaux vers le protocole Internet IP de prochaine génération.

Par exemple, Google a retenu qu'une migration vers l'IPv6 consiste à faire davantage de choses que la seule mise à jour logicielle et matérielle. Cela exige également une forte implication des managers et du personnel, notamment des administrateurs, déjà pris par des tâches trop nombreuses. Et, pour les entreprises qui essuient les plâtres, il faut aussi beaucoup travailler avec les fournisseurs pour les amener à corriger un code inachevé, qui comporte encore des bogues. « Ce n'est pas parce qu'on vous annonce que le protocole est pris en charge qu'il faut s'attendre à ce que cela fonctionne », a-t-elle mis en garde dans le document qui accompagnait la présentation. « Je pense que tous ceux qui ont essayé de migrer vers l'IPv6 ont rencontré les mêmes problèmes que ceux auxquels nous devons faire face », a-t-elle encore expliqué.

Un déploiement à mi-chemin, des gains déjà significatifs

Le projet, en route depuis environ quatre ans, a demandé beaucoup plus d'efforts de la part de l'équipe d'ingénieurs que ce qui était prévu au départ. Le déploiement est seulement à mi-chemin, mais Google peut d'ores et déjà faire état de gains significatifs pour l'entreprise. Environ 95% des ingénieurs de Google profitent désormais d'un accès IPv6 à leur bureau. Et au final, l'entreprise envisage de passer la totalité de son réseau en IPv6.

Le projet avait été lancé en 2008 par un petit groupe d'ingénieurs, salariés du géant de l'Internet. Certains d'entre eux y consacraient déjà 20% de leur temps de travail, celui accordé par Google à ses ingénieurs pour mener des projets personnels au sein de l'entreprise. Le but était d'introduire « l'IPv6 partout », a déclaré Irena Nikolova. L'aspect pratique était aussi un élément intéressant. Même si le réseau était lui-même privé, interne à Google, il utilisait des adresses IP publiques, et Google allait bientôt se trouver à court d'adresses IPv4 en interne.

Le problème de la poule et de l'oeuf

Les ingénieurs de Google travaillaient alors au développement de versions IPv6 des outils et applications de Google et ils avaient besoin de les tester en interne avant de les livrer au public. Ils ont réalisé que le déploiement de l'IPv6 ressemblait au problème de la poule et de l'oeuf. Comme de nombreuses entreprises, Google a mis du temps à adopter l'IPv6 en raison du manque d'applications tierces fonctionnant avec le nouveau protocole. Mais cette rareté vient aussi du fait que peu d'entreprises exploitent les réseaux IPv6.

Le réseau interne de Google est déployé entre plus de 200 bureaux dans le monde et il dessert 30 000 salariés environ. Il comporte une grande variété de périphériques provenant de fournisseurs comme Cisco Systems, Juniper Networks et Aruba Networks, des centaines d'applications commerciales et de produits faits maison, sans compter l'usage de plusieurs systèmes d'exploitation différents, dont Linux, Mac OS X et Windows. Les ingénieurs ont essayé de modéliser le réseau IPv6 aussi finement que possible en le calquant sur l'actuel réseau IPv4, afin de conserver le même routage et le même trafic. Au début, ils ont fait fonctionner l'IPv6 sur les réseaux IPv4, en utilisant l'effet tunnel. Puis, quand c'était possible, ils ont dédoublé les piles, plaçant côte à côte l'IPv4 et l'IPv6. Mais ils ont décidé finalement qu'ils ne maintiendraient que le réseau IPv6.

Recours à l'auto-configuration sans état

Pour affecter des adresses aux périphériques IPv6, Google a suivi les directives RFC 5375 de l'Internet Engineering Task Force. Chaque campus ou bureau a reçu un bloc d'adressage /48, ce qui correspond à l'allocation de 280 adresses. Par ailleurs, chaque immeuble a reçu un bloc d'adressage /56, soit environ 272 adresses, et chaque VLAN (Virtual Local Area Network) a reçu un bloc /64, soit environ 264 adresses. Pour affecter des numéros à des appareils spécifiques, les ingénieurs ont utilisé l'auto-configuration sans état (Stateless Address Autoconfiguration, SLAAC), qui permet aux périphériques de s'attribuer des numéros à eux-mêmes. Cette approche évite la nécessité d'attribuer manuellement une adresse à chaque appareil. Celle-ci était aussi incontournable dans la mesure où certains systèmes d'exploitation ne supportent pas encore le protocole de configuration dynamique DHCPv6 (Dynamic Host Configuration Protocol), la version d'attribution des adresses pour les réseaux IPv6.

[[page]]

« L'un des plus gros problèmes a été le support insuffisant de l'IPv6 par les appareils réseaux et les logiciels », a convenu Irina Nikolova. Beaucoup de périphériques réseaux actuels ne supportent l'IPv6 que grâce à une mise en oeuvre logicielle, ce qui signifie que l'essentiel du traitement du trafic est réalisé par logiciel, plutôt qu'avec un matériel spécialisé. Par conséquent, en IPv6, les opérations réseaux consomment beaucoup plus de cycles processeur qu'en IPv4. Au moins un fournisseur d'équipement sans fil ne prenait pas en charge les ACL (Access Control Lists). En outre, les périphériques d'optimisation du réseau WAN (Wide Area Network) ne savent pas chiffrer le trafic IPv6, car le protocole WCCP (Web Cache Control Protocol) qu'ils utilisent ne fonctionne pas encore avec le nouveau protocole. Les équipements réseaux ne sont pas les seuls à poser problème. Les imprimantes restent aussi problématiques, en ce que nombre d'entre elles ne prennent pas totalement en charge l'IPv6.

Contraint d'éliminer des applications ne supportant pas IPv6

Les applications et la compatibilité avec les OS se sont également avérées être un défi. Google a été amenée à éliminer au fur et mesure des applications qui ne supportaient pas l'IPv6. Mais un certain nombre d'outils essentiels, comme des bases de données et des applications de facturation, ont été conservées, car elles ne peuvent pas être modifiées ou mises à jour facilement. Et même si les versions actuelles de la plupart des systèmes d'exploitation prennent en charge l'IPv6, ceux-ci ne le font pas par défaut. Ce qui suppose une intervention supplémentaire de la part des administrateurs et des utilisateurs. « Nous pouvons aussi confirmer que les problèmes techniques sont souvent le fait d'un nouveau code, inachevé ou comprenant des bogues. Il a fallu intervenir auprès des fournisseurs pour les inciter à améliorer leurs produits en termes de support pour l'IPv6. C'était un autre défi » , indique le document de Google.

Google a également dû se confronter aux prestataires de service, ces entreprises chargées d'amener la connectivité jusqu'aux bureaux de Google. Les SLA (Service Level Agreements) ne sont pas aussi exigeants en matière d'IPv6 qu'en matière d'IPv4. Les prestataires ont mis plus de temps à relier les points d'accès IPv6 distincts que pour la mise en place et la configuration de peerings en IPv4. Google a dû également réécrire ses propres outils de surveillance réseaux pour travailler en IPv6. Malgré ces obstacles, Irena Nikolova s'est dite confiante et ne doute pas que l'équipe va réussir à mettre en oeuvre un réseau tout-IPv6 chez Google. « Nous avons également cessé de qualifier l'IPv6 de 'nouveau protocole', mais nous commençons à parler de l'IPv4 comme de 'l'ancien protocole' », a-t-elle enfin déclaré.

Les Innovact Campus Awards 2012 lancés

Le coup d'envoi est donné pour la 10ème édition des Innovact Campus Awards. Cette compétition est organisée dans le cadre du Forum européen de la start-up innovante Innovact par la CCI de Reims-Epernay. Elle bénéficie également du soutien de la Commission européenne. Gratuite, elle est ouverte à tous les étudiants et jeunes chercheurs européens, dans le cadre ou non de leur formation, et valorise des projets en phase de conception, en cours de réalisation ou déjà lancés. La récompense ? Une visibilité au niveau européen, des conseils d'experts et une dotation financière allant jusqu'à 5 000 euros.

Les candidatures doivent être déposées, à titre individuel ou en équipe, avant le 20 février 2012. Le jury, constitué de professionnels venus de toute l'Europe, distinguera les candidats qui ont fait preuve d'imagination et d'innovation dans leur démarche de création, quel que soit le produit ou activité.

Comme chaque année, les finalistes pourront participer gratuitement à la 16e édition du forum européen de la jeune entreprise Innovante-Innovact, les 27 et 28 mars 2012, à Reims. Leurs projets seront présentés à plus de 1 500 professionnels de 20 pays, et leur expérience partagée avec plus de 100 autres jeunes entreprises innovantes européennes.

Les Français en bonne place en 2011

Lors du forum, les membres du jury rencontreront directement les finalistes sur leur stand afin de choisir les 3 projets les plus prometteurs et novateurs. Les critères seront notamment l'audace, le professionnalisme, la créativité et la viabilité des projets.

L'an dernier, sur les 170 dossiers de projets innovants reçus, provenant de 27 pays européens, 30 ont été pré-sélectionnés pour la finale de 2011, représentant l'Allemagne, la Belgique, la Croatie, l'Espagne, la France, la Hongrie, l'Italie, la Roumanie, le Royaume-Uni et la Suède. Parmi ceux-ci, 4 projets européens ont été couronnés. La France s'était distinguée avec un 2ème prix décerné au projet Visibrain, un outil professionnel de veille en ligne basé sur l'intelligence collective et créé par Nicolas Huguenin, jeune diplômé de l'école d'ingénieurs Isep. Le jury avait également accordé un prix spécial supplémentaire à Justine Noiset, étudiante à l'Institut Sup' Biotech Paris, pour une solution de dépistage précoce des cancers.

(...)

Le fonds Thoma Bravo acquiert Blue Coat pour 1,3 milliard de dollars

La société d'investissements Thoma Bravo acquiert Blue Coat, société spécialisée dans la sécurité et l'optimisation WAN, pour un montant de 1,3 milliard de dollars. Le conseil d'administration de l'entreprise a accepté cette offre et la recommande aux actionnaires. Selon les termes de l'accord, les actionnaires de Blue Coat recevront 25,81 $ par action, ce qui représente une prime d'environ 48 % par rapport au cours de clôture de Blue Coat, le 8 décembre dernier.

David Hanna, PDG de Blue Coat, a déclaré: « Au cours des six derniers mois, notre conseil d'administration a entrepris un examen exhaustif de toutes les options stratégiques disponibles pour Blue Coat. Après une évaluation approfondie des alternatives stratégiques avec nos conseillers indépendants, le Conseil a conclu que l'accord avec Thoma Bravo constitue une offre attrayante pour nos actionnaires »

Orlando Bravo, directeur associé chez Thoma Bravo, a ajouté: « En tant que société privée, Blue Coat sera mieux positionnée pour innover à un rythme accéléré et atteindre un niveau de croissance supérieur. »

L'opération est soumise à l'accord des autorités de concurrence ainsi qu'à l'approbation des actionnaires de Blue Coat. Cette dernière prévoit la finalisation de la transaction au premier trimestre 2012.

Panasonic revient sur le marché des smartphones en Europe

Panasonic annonce travailler actuellement sur un prototype de smartphone destiné au marché européen, qui devrait être présenté en mars 2012. Il s'agit d'une première pour le constructeur japonais, qui pourrait lentement mais sûrement mettre son expertise de la photographie au service de la téléphonie mobile et diversifier ses activités.

Ce premier modèle de smartphone devrait être présenté au prochain Mobile World Congress (MWC), à Barcelone du 27 février au 1er mars 2012. Il se présente comme un appareil très fin, étanche et résistant à la poussière, disposant d'un écran OLED de 4,3 pouces et fonctionnant sous Android.

Panasonic, qui avait abandonné le marché international de la téléphonie mobile en 2006, ambitionne désormais de vendre neuf millions d'unités par an hors du Japon à l'horizon 2016.

(...)| < Les 10 documents précédents | Les 10 documents suivants > |