Flux RSS

Cloud computing

904 documents trouvés, affichage des résultats 1 à 10.

| Les 10 documents suivants > |

(10/05/2012 11:20:40)

Google simplifie l'utilisation de ses API analytiques

Google a développé un outil pour automatiser la création de tableaux de bord personnalisés sur son service d'analyse de la fréquentation des sites web. La bibliothèque Google Analytics Easy Dashboard donne aux développeurs la possibilité d'élaborer ces éléments de reporting sans passer par une phase d'apprentissage des API analytiques mises à disposition et sans avoir besoin d'écrire manuellement le code. Il suffit que les webmasters s'enregistrent pour accéder à la console API de Google, qu'ils copient et collent une portion de code JavaScript puis ajustent celui-ci pour le type de données qu'ils veulent récupérer et le type de graphiques qu'ils souhaitent afficher.

« Vous pouvez ainsi créer très rapidement des tableaux de bord Google Analytics, avec très peu de code », écrivent dans un billet de blog Jeetendra Soneja et Nick Mihailovski, membres de l'équipe concernée chez Google.

La société dirigée par Larry Page a bâti l'outil en collaboration avec une équipe d'étudiants de l'Université de Californie d'Irvine. Elle travaille aussi avec un autre groupe d'étudiants pour le simplifier encore.

Google Analytics est une application cloud que les webmasters utilisent pour surveiller le trafic sur leurs sites web et analyser l'utilisation qui en est faite pour déterminer l'efficacité des différentes catégories de contenus et publicités.

(...)(10/05/2012 10:39:42)Gartner dessine les contours du cloud personnel

Intitulée «Competitive Landscape: Consumer Personal Cloud», cette étude décrit un réel changement de paradigme en cours dans les attitudes des utilisateurs en matière de stockage et de synchronisation de données, suite aux développement récents des services et apps.

Alors que le cloud sert des fonctions aussi variées que les affaires, l'administration publique, ou les loisirs, l'étude relève qu'aucune entreprise ne peut à l'heure actuelle prétendre dominer l'ensemble de ces services. Ainsi si les grands fournisseurs comme Microsoft, Apple, Amazon and Google font des efforts considérables pour se positionner, beaucoup de plus petits fournisseurs misent sur des offres «verticales», en offrant des services de stockage et de streaming accessibles depuis certaines plateformes et appareils particuliers.

L'étude distingue trois aspects autour desquels les fournisseurs devraient se profiler à l'avenir: la mobilité, l'indépendance des plateformes et la synchronisation. Ainsi l'indépendance des plateformes implique que le choix du consommateur ne sera plus déterminé en fonction du système d'exploitation ou des apps d'un appareil, mais bien plutôt du type de services cloud accessibles. Quant à la synchronisation de données stockées localement vers les fonctions du cloud, celle-ci devra être fluide, et impliquera des fonctions de contrôle d'identité du consommateur, ainsi qu'une capture permanente de ses états d'utilisation, avec la possibilité d'activer ou de désactiver chacune de ces fonctions.

Selon Michael Gartenberg, directeur de recherche chez Gartner, «il règne encore une certaine confusion sur la nature du cloud personnel parmi les consommateurs. Le fait que beaucoup de vendeurs continuent à assimiler les services du cloud avec le stockage en ligne exclusivement et négligent ses autres aspects et potentiels n'arrange pas les choses. A l'avenir, les consommateurs vont définir eux-mêmes leur propre ensemble de services cloud».

(...)(07/05/2012 10:41:08)L'industrie adopte le cloud plus vite que la santé

IDC publie deux études sur l'attrait et les freins aux services du cloud, d'une part auprès des entreprises industrielles, d'autre part auprès des prestataires de soins en Europe de l'Ouest, en sondant leurs projets d'investissement dans le domaine. Citant des avantages en matière d'agilité commerciale, de qualité des services et de partage d'information avec leurs partenaires, 60% des entreprises manufacturières déclarent disposer d'un budget dédié au cloud et ne pas prévoir réduire ce dernier. En outre, la moitié des entreprises interrogées déclarent vouloir y dédier davantage de moyens dans le futur.

Ces investissements sont principalement dirigés vers les applications de collaboration et de service à la clientèle (CRM). Selon Pierfrancesco Manenti, chef de IDC Manufacturing Insights, EMEA, «des craintes subsistent encore, notamment en matière de sécurité et de disponibilité, cependant ces craintes habituelles sont rapidement compensées par les avantages massifs qui découlent de ces investissements, ce qui explique aujourd'hui une telle conversion».

Du côté des prestataires de soins, la prudence est toujours de mise, puisque seuls 6% des responsables IT disent consacrer plus de 10% de leur budget au cloud computing. Parmi les freins, une nécessité que les infrastructures restent privées pour cause de sécurité des données - dissuadant ces derniers de déployer leurs systèmes et informations au-delà de leur firewall - et la nécessité d'être en conformité avec les exigences légales en matière d'audit. Cependant, les prestataires de soins pourraient profiter dans le futur d'investissements publics de plus en plus importants dans le cloud, qui leur permettraient notamment de surmonter ces barrières légales.

Selon Silvia Piai, research manager EMEA chez IDC Health Insights, «nos résultats démontrent que les prestataires de soins ont conscience des avantages potentiels du cloud et ont l'intention de les explorer dans le futur; ces avantages concernent notamment le self-service, des économies d'échelle, la flexibilité, le principe pay-as-you-go, et une amélioration du rapport valeur/temps de la technologie».ICTjournal (...)(02/05/2012 09:26:11)

Impact2012 : IBM fournit des clés pour adopter ses PureSystems

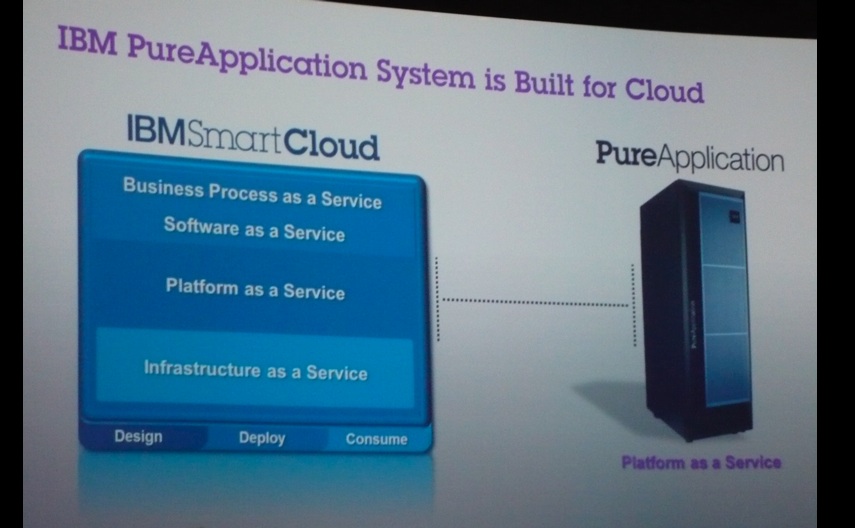

Trois semaines après les avoir annoncés, IBM a exposé ses appliances PureSystems à Las Vegas, lors de sa conférence Impact2012 consacrée à sa gamme de solutions middleware WebSphere (du 29 avril au 4 mai, 8 500 personnes sont attendues). Déclinées en solutions de cloud privé IaaS (PureFlex) et PaaS (PureApplication) sur serveurs PowerPC ou Intel, ces appliances associent les savoir-faire combinés d'IBM sur la gestion d'infrastructure à des modules d'expertise pré-intégrés, afin d'automatiser et d'optimiser la gestion de l'environnement informatique.

Sur Impact2012, la dernière-née d'IBM a joué les stars, poussée sur scène sous les feux des projecteurs, lors du keynote d'ouverture de Marie Wieck, directrice générale, responsable des solutions d'intégration de l'entité Logiciels d'IBM (voir photo principale). A sa suite, Jason McGee, Chief Architect sur l'offre WebSphere Cloud Computing, a vanté la rapidité d'installation des PureSystems, appuyé par une courte vidéo déroulant comment, en 4 heures chrono, le système, connecté et initialisé, était prêt à l'emploi.

Une appliance qui s'installe en 4 heures chrono, assure IBM (crédit : M.G.)

Développer ses propres modules d'expertise

Lors de l'annonce, IBM avait précisé que plus de 125 éditeurs et constructeurs avaient déjà ajouté leurs solutions et modules d'expertise aux siens pour exploiter la famille PureSystems de façon optimisée avec leurs solutions. Plus de 150 d'entre eux sont déjà répertoriés dans le catalogue PureSystems Center. Les modules d'expertise (qu'IBM désigne en anglais sous le nom de patterns) se répartissent en trois catégories selon qu'ils s'appliquent aux ressources d'infrastructure (serveurs, stockage, réseau, virtualisation), à celles de la plateforme (bases de données et logiciels de middleware) ou encore, aux applications.

Parmi ceux d'IBM figurent, par exemple, un module de migration qui facilite les déploiements dans un environnement PureApplication et un autre visant à simplifier la maintenance. On y trouve aussi un module destiné au déploiement de bases de données (pour des traitements OLTP ou la mise en place de datamarts) et un autre conçu pour la mise en oeuvre d'applications de Business Intelligence. Il en existe également un qui automatise la vingtaine d'étapes nécessaire au déploiement d'applications web.

Une Sandbox gratuite pendant trois mois dans SmartCloud

Ces modules d'expertise constituent des éléments essentiels aux bénéfices d'optimisation apportés par les PureSystems. IBM a donc poussé cette logique en permettant aux entreprises de développer elles-mêmes leurs propres « patterns ». Sur Impact2012, Marie Wieck a ainsi annoncé l'arrivée d'un Virtual Pattern Kit, gratuit, qui aidera à convertir une expertise technologique en composante réutilisable pour automatiser certaines tâches informatiques. Le toolkit aidera les entreprises à préparer leur développement qui sera finalisé en collaboration avec IBM. Les « patterns » ainsi créés pourront ensuite être directement intégrés dans les appliances PureSystems.

Pour bâtir et tester ces modules, IBM propose à ses clients et partenaires d'accéder à des environnements PureSystems en passant par son service IaaS SmartCloud. L'utilisation de cette Sandbox est disponible à l'essai gratuitement pendant trois mois. Les développeurs pourront y concevoir des applications qui s'exploiteront ensuite indifféremment sur l'appliance PureApplication ou dans SmartCloud. L'essai gratuit inclut des fonctions de gestion du cycle de développement logiciel qui permettront à des équipes de travailler de façon collaborative.

Les applications conçues dans SmartCloud tourneront indifféremment sur un système PureApplication (cliquer ici pour agrandir l'image).

Faire croître l'écosystème

Sur Impact2012, l'exemple de SugarCRM a été évoqué. Cet éditeur de solutions de CRM en Open Source fait partie des 125 sociétés qui ont développé un « plug-in » pour PureSystems, avec Infor, Esri, Coheris, Sopra (pour Evolan), Sab, EnterpriseDB, SAS, ou Saba, entre autres. Dans un document publié sur son site, IBM relate sa démarche. « SugarCRM est une application PHP nécessitant une pile LAMP (Linux, Apache, MySQL, PHP) qui n'est pas supportée de base par les PureSystems ». L'équipe a donc élaboré un module d'expertise et un jeu de plug-in qui supportent la modélisation, le déploiement et l'exploitation d'une application au-dessus de la base Linux ou de l'image AIX.

En fournissant la sandbox et les outils pour faciliter la mise au point de modules d'expertise et de plug-in, IBM espère susciter une émulation et faire grossir l'écosystème autour de sa famille PureSystems.

Sur Impact2012, trente-cinq clients et partenaires français d'IBM ont fait le déplacement, la plupart ayant manifesté leur intérêt pour la famille PureSystems. Sur la vingtaine de clients figurent de grandes banques, des opérateurs de télécommunications, des fournisseurs d'énergie, mutuelles... « Les grands clients s'intéressent à PureApplication System », confirme Rémy Mandon, responsable WebSphere France, IBM Software Group, en ajoutant que l'offre PaaS devrait être disponible en trois versions, proposant différentes tailles de configurations.

Amazon courtise les entreprises avec son cloud privé virtuel (VPC)

Pour attirer dans le cloud les entreprises, Amazon Web Services (AWS) fait valoir la qualité des fonctions de sécurité de son cloud privé virtuel (VPC) lancé en 2009. Même si le cloud computing est source d'économies potentielles, beaucoup d'entreprises restent encore rebutées par des préoccupations de sécurité. Dans un sondage réalisé en 2011 par le Cloud Industry Forum auprès de 300 entreprises, 62% d'entre elles mettent la sécurité des données au premier plan de leurs préoccupations, et en font le premier déterminant à l'adoption du cloud.

Alors que le cloud public est largement considéré comme inadapté aux applications professionnelles critiques, certaines entreprises commencent à davantage utiliser les clouds privés. Dans ce cas, ce sont souvent des datacenters sur site qui utilisent une technologie équivalente au cloud. Avec le VPC, l'infrastructure informatique est hébergée dans le propre cloud public EC2 d'Amazon. Un espace isolé du cloud public est dédié aux clients qui peuvent le relier à leur propre datacenter via une passerelle Internet, par exemple un réseau privé virtuel (VPN) ou un réseau dédié connecté à l'aide d'AWS Direct Connect. Contrairement à EC2, qui attribue une adresse IP publique aléatoire à toute instance opérationnelle, les instances VPC disposent d'adresses privées. « Toutes les ressources installées dans le cloud privé virtuel ne peuvent communiquer qu'avec le propre centre de calcul de l'entreprise concernée », a expliqué Werner Vogels, CTO d'Amazon lors d'une conférence qui s'est tenue à Londres cette semaine. « C'est aussi une manière pour l'entreprise de moduler à volonté la taille de son environnement sur site. »

Sécurisation des accès

Pour Steve Schmidt, directeur général et CISO d'Amazon, qui travaillait auparavant pour le FBI, l'offre Virtual Private Cloud a suscité beaucoup d'intérêt de la part des entreprises depuis son lancement en 2009. Selon lui, ce qui attire le plus les entreprises, c'est qu'elles peuvent passer par la même structure de contrôle pour leur VPC et pour leur infrastructure sur site. Cela comprend aussi les pare-feu de la couche réseau, les configurations d'adresses IP et l'infrastructure de gestion. «Beaucoup de clients demandent comment fonctionnent les pare-feu dans le VPC et en quoi cela diffère de ce qui se passe sur l'EC2 », a déclaré Steve Schmidt. « L'EC2 oblige à la mise en place de pare-feu entrants pour toutes les instances, et ces pare-feux sont sans états (stateless firewalls). Le VPC nécessite également des pare-feu entrants obligatoires, mais ils sont à états (stateful firewalls). Et il a aussi des pare-feu sortants. Ainsi, il est possible contrôler tout ce qui peut entrer et sortir de la machine ».

Le Virtual Private Cloud d'Amazon dispose de listes de contrôle d'accès (ACL) au niveau du réseau, qui gèrent les échanges entre les serveurs web, les serveurs d'applications et les bases de données. En option, AWS permet également aux clients qui veulent être locataires uniques d'un morceau physique de hardware d'avoir des instances dédiées. « Si le CSO demande à ce que toutes les données résident sur un ensemble particulier de machines, c'est possible. Celui-ci pourra augmenter ou abaisser la taille de son espace à volonté et les données iront exclusivement sur ces machines réservées », a déclaré Steve Schmidt.

Aux clients de déployer les outils de sécurité

Cependant, celui-ci a ajouté que la position d'Amazon en ce qui concerne le partage des responsabilités entre AWS et les clients était très claire. Si Amazon prend la responsabilité de « bétonner la sécurité au niveau de l'hyperviseur », il revient aux clients de définir leur niveau de tolérance en matière d'exposition de l'information. Et par conséquent, c'est aux clients de décider quels outils de sécurité ils choisissent de mettre en oeuvre. «Nous fournirons aux clients une suite d'outils qu'ils peuvent utiliser pour assurer de manière appropriée la sécurité de leur information et celle de leurs systèmes. Nous leur donnerons un ensemble de meilleures pratiques qui expliquent et suggèrent comment configurer et utiliser les outils mis à leur disposition. Mais ce sera à eux de décider comment les mettre en oeuvre dans leur propre environnement », a-t-il déclaré.

Lors du Cloud Computing for the Enterprise d'Amazon, Werner Vogels a également déclaré que les startups et les petites entreprises avaient pris un avantage sur les grandes entreprises. Selon le CTO d'Amazon, « elles ont intégré plus rapidement les analytiques au coeur de leur activité, et font, de fait, un meilleur usage du big data ».

(...)(26/04/2012 17:40:47)Selon Amazon, les start-ups sont en pointe pour l'analyse des big data

Selon Amazon Web Services (AWS), les start-ups et les petites entreprises sont en train de prendre l'avantage sur les plus grandes entreprises en mettant les analytiques au coeur de leur activité. Lors d'un événement qui s'est tenu à Londres mercredi, Werner Vogels, le CTO d'Amazon a déclaré que « historiquement la business intelligence était un « domaine secret des grandes entreprises ». Cependant, avec l'avènement du cloud computing, les petites entreprises ont pu avoir accès à des applications comme Hadoop, qui leur ont permis d'acquérir un avantage concurrentiel. « Ce secteur que nous pensions réservé à certains acteurs est en train de basculer au bénéfice d'entreprises plus jeunes », a déclaré Werner Vogels. Une des raisons, c'est qu'elles « ont mis le big data au coeur de leur activité beaucoup plus rapidement afin d'améliorer leurs services de façon permanente. Comparativement, les autres entreprises ont pris du retard ».

Selon le CTO d'Amazon, la fidélité envers les marques n'est plus de mise, ce qui oblige les entreprises à être plus audacieuses. Si bien que, de son point de vue, les entreprises ont beaucoup à apprendre des start-ups qui développent souvent leurs produits et leurs services dans des conditions d'extrême incertitude, et comprennent l'importance qu'il y a à mettre rapidement leurs produits sur le marché. « La solution, c'est de faire beaucoup de tentatives et d'échouer rapidement », a déclaré Werner Vogels. « Dans le passé, ce type d'expériences coûtaient très chères, et souvent le budget qu'il fallait y consacrer suffisait pour tuer toute nouvelle idée. Mais avec le cloud, ces risques ont été réduits de manière significative. Alors, dans la mesure où le prix de l'échec est quasi nul, il y a là une réelle motivation à multiplier les tentatives », a t-il expliqué.

50 000 coeurs pour 5 000 dollars de l'heure

Le CTO d'Amazon en a profité pour rappeler un des objectifs d'Amazon, à savoir : mettre un supercalculateur à la portée de tout développeur. Celui-ci a cité l'exemple de Cycle Computing, qui permet aux chercheurs et aux entreprises de faire tourner des applications de calcul intensif dans l'infrastructure Amazon EC2. Cycle Computing a construit un supercalculateur intégrant 50 000 coeurs dans le cloud AWS pour Schroedinger, une entreprise qui effectue des recherches sur les drogues. « Jusqu'à encore récemment, il aurait fallu des années pour analyser un ensemble de 21 millions de composés chimiques avec une petite instance HPC intégrant quelques centaines de coeurs ». Grâce au supercalculateur de Cycle Computing, Schrödinger a effectué ses tests en trois heures seulement. « Ce supercalculateur de 50 000 coeurs est immédiatement accessible pour 5000 dollars de l'heure. Cela signifie aussi qu'il est disponible pour tout le monde », a déclaré Werner Vogels.

Le point de vue du CTO donne bien la tonalité de la conférence d'Amazon qui a insisté sur le fait que les services cloud étaient désormais prêts pour l'entreprise, et que leur adoption avait beaucoup augmenté au cours des 18 derniers mois. Amazon a cité les noms d'entreprises clientes comme Shell, Samsung, SAP ou encore le journal The Guardian, « qui utilisent toutes l'AWS pour améliorer l'agilité et acquérir un avantage concurrentiel ».

Les éditeurs se sont adaptés au cloud

Selon le CTO d'Amazon, Oracle et SAP ont modifié leurs applications pour permettre leur déploiement dans des zones de disponibilité multiples, et d'autres entreprises comme Microsoft, IBM et Red Hat permettent également le déplacement de licence, ce qui laisse la possibilité aux entreprises de gérer leurs licences existantes sur AWS, un concept surnommé « bring your own licence » par Amazon.

Peu de temps avant la conférence, Amazon Web Services a lancé une série de nouveaux produits et services destinés à l'entreprise, dont AWS Direct Connect, AWS Storage Gateway, DynamoDB, CloudSearch et AWS Marketplace. « L'informatique est souvent considérée comme un frein à l'innovation », a encore déclaré M. Vogels. « L'une des raisons pour laquelle nos clients adoptent les services cloud d'AWS, c'est que ces services peuvent justement devenir un catalyseur de l'innovation ». (...)

Werner Vogels, CTO d'Amazon, dénonce le verrouillage des fournisseurs de cloud

« Les fournisseurs [de cloud] devraient être sous pression 24h/24», a expliqué Werner Vogels, CTO d'Amazon.com, lors de l'Amazon Web Services Summit à New York le 19 avril dernier, dans une allocution retransmise en direct. Les clients devaient avoir le choix de quitter Amazon quand ils le veulent. « Si nous ne sommes pas en mesure de vous offrir une bonne qualité de services, vous devriez avoir le choix d'aller voir ailleurs. Vous, consommateurs de services, devriez être tout à fait libre. C'est le coeur de notre philosophie ».

Le CTO d'Amazon évoquait spécifiquement le modèle de tarification « pay-as-you-go » de l'entreprise qui permet au consommateur de payer à hauteur des services qu'il utilise. Mais, selon plusieurs clients, AWS, et les fournisseurs de cloud en général, ne les laissent pas partir aussi facilement. Bien sûr, les systèmes peuvent être activés ou désactivés selon ses besoins, mais ce n'est pas si simple de migrer ses données du Simple Storage Service (S3) d'AWS. « La communauté du cloud pense que les données pèsent lourd, et que, une fois qu'elles sont déposées chez un fournisseur, il très difficile de les déplacer», explique Dan Koffler, fondateur de Hybrid Cloud Gateway, un service qui aide les clients à connecter leur environnement informatique sur site à des vendeurs de cloud publics comme AWS. Selon Dan Koffler, « ce n'est pas nécessairement difficile de sortir ses données du S3, mais cela peut coûter plus cher que de les mettre ».

Un frein au développement du cloud

Les préoccupations soulevées par le lock-in exercé par les vendeurs sont « un obstacle majeur à l'adoption du cloud », estime encore le fondateur d'Hybrid Cloud Gateway. C'est même la plus grande préoccupation des clients quand ils réfléchissent à la mise en oeuvre d'une stratégie cloud », a-t-il ajouté. « AWS n'est ni mieux, ni pire que les autres fournisseurs de clouds publics avec lesquels nous travaillons - que ce soit Terremark, Rackspace ou GoGrid Cloud Hosting. Ils ont tous les mêmes défauts », explique-t-il. « C'est à peu près la même chose chez chacun d'eux. C'est juste à l'image du business modèle du cloud d'entreprise. Les fournisseurs veulent que leur système soit adopté par les clients et ils veulent garder leurs clients, » explique-t-il encore.

Selon Rena Lunak, une porte-parole d'AWS, le fournisseur « s'engage à laisser aux clients choix et flexibilité ». Elle affirme que les clients « ne veulent pas se laisser enfermer dans un système d'exploitation ou dans un langage de programmation particulier et qu'ils veulent pouvoir transférer leurs compétences existantes dans le cloud ». Celle-ci explique encore que ça coûte plus cher de migrer ses données vers le système S3 que de les en retirer, à cause des multiples couches de redondance que le fournisseur met en place pour la sauvegarde des données. Enfin, selon elle, les clients sont libres d'ajouter ou de supprimer des données de S3 comme ils le souhaitent, et que ces modifications comptent pour une petite part dans la facture d'un client.

[[page]]

Certains clients ont trouvé le moyen de contourner le verrouillage des vendeurs. Jorge Escobar, vice-président de l'ingénierie de Order Groove, un site d'e-commerce basé sur le SaaS. Order Groove permet aux revendeurs d'offrir des services de souscription et de s'abonner à des programmes d'achats récurrents. Celui-ci explique que l'offre utilise le système middleware en place, ce qui protège la société du lock-in. Grâce au middleware, Order Groove sépare les services cloud de back-end de la couche applicative en front-end. « Le mapping objet-relationnel, ou « Object-relational Mappoing - ORM », est facilement disponibles, et le plus souvent, gratuitement », dit-il, et permet de créer des correspondances entre la base de données et les objets de nombreux langages de programmation. « Je ne sais pas comment les ORM sont utilisés en général, mais je sais que si on ne les a pas, c'est l'impasse. Il faut alors pouvoir consacrer beaucoup de longues nuits et de week-ends pour passer le code au peigne fin et retirer toutes les références à son ancien système », explique-t-il.

Certains services professionnels proposent de réaliser ce travail pour le compte des entreprises. Comme Informatica, par exemple, qui vend des services d'intégration de données. Elle prépare les données pour faciliter leur migration d'un environnement sur site vers un environnement cloud. L'entreprise a développé des « passerelles », essentiellement des applications qui permettent des connexions entre des applications très utilisées sur site et des services clouds populaires.

Juan Carlos Soto, vice-président senior et directeur général de la division cloud de l'entreprise, affirme que si les clients sont préoccupés par le verrouillage des fournisseurs de IaaS, ils sont encore plus préoccupés par le lock-in des fournisseurs de SaaS. « Dans un environnement IaaS, les données peuvent être simplement retirées du cloud », a-t-il déclaré. Mais avec le SaaS, un grand nombre de données, qui représentent une forte plus-value en temps de travail, sont intégrées dans l'application. « Il est important que l'entreprise s'assure qu'elle dispose des bons outils pour toujours conserver l'accès à ces données. Après tout, elles lui appartiennent, » a déclaré Juan Carlos Soto. Si un client utilise un système de gestion de la relation client (Customer Relationship Management - CRM) ou un système de gestion des ressources humaines (Human Resource Management - HCM) dans son offre cloud, il est probable qu'il transmette beaucoup de données vers le cloud. Le client doit s'assurer que le fournisseur SaaS ou IaaS permet la restitution de ces données et que cette clause figure explicitement dans le contrat de niveau de service (Service Level Agreement - SLA) conclu entre les parties.

(...)(17/04/2012 14:06:01)

Rackspace prépare la mise en production d'OpenStack

Ainsi, à compter du 1er mai, les clients de Rackspace auront accès par défaut aux serveurs de l'opérateur de cloud via l'API OpenStack, ou par le biais d'une console qui utilise l'API de Rackspace, comme ce dernier l'a annoncé hier. Jusque là, l'accès aux fichiers sur Rackspace se faisait uniquement par le biais d'OpenStack. L'entreprise a aussi développé un certain nombre d'autres services hébergés basés sur OpenStack, pour le stockage, le réseau et les bases de données. Ces services vont être commercialisés sous la dénomination générique de Rackspace Cloud. L'API OpenStack est « plus extensible et plus robuste » que l'interface précédemment proposée jusque-là par Rackspace, a déclaré Mark Interrante, vice-président produits chez l'hébergeur.

Ce déploiement arrive à un moment crucial pour le projet OpenStack. Les responsables du projet viennent de créer une fondation à but non but lucratif pour gérer le développement de la pile logicielle Open Source. On devrait d'ailleurs en savoir plus à ce sujet cette semaine au cours de la conférence OpenStack qui se tient à San Francisco (16 - 20 Avril 2012). La Fondation vient de livrer la cinquième version de la pile logicielle, baptisée Essex, qui sera utilisée comme base pour l'offre de Rackspace.

Un temps de mise en service et de maintenance divisé par deux

La mise en place de cette interface ne changera pas le prix du service Cloud Servers. Le tarif de base reste à 0,015 dollar de l'heure pour un serveur virtuel Linux avec 10 Go d'espace disque et 256 Mo de RAM. Le prix des serveurs Microsoft Windows démarre à 0,08 dollar de l'heure. Selon Mark Interrante, le fait d'utiliser OpenStack pourrait diviser par deux le temps que les administrateurs consacrent à la mise en service et à la maintenance des serveurs de Rackspace. Celui-ci a aussi reconnu que sa société n'avait pas réalisé d'étude pour mesurer la performance « sur toute la chaîne» parce que le service n'est pas encore en production. Mais le potentiel existe. « Il est beaucoup plus facile de changer un paramètre sur quelques centaines de serveurs avec l'API OpenStack », a t-il déclaré.

Avec la console Rackspace, les administrateurs peuvent marquer certains ensembles de serveurs - pour distinguer des serveurs de production et des serveurs de développement par exemple - et appliquer ensuite des actions spécifiques en fonction de ce classement. L'interface est mise à jour de manière dynamique, si bien que les administrateurs n'ont pas besoin de rafraîchir les pages de la console quand ils font des modifications. Pour les clients qui réalisent leurs propres panneaux de contrôle, l'API OpenStack propose une interface standard qu'ils peuvent utiliser pour tous les services OpenStack. « L'API OpenStack offre beaucoup plus d'options pour la programmabilité », explique encore Mark Interrante. « Le client peut naviguer entre les fournisseurs de services OpenStack, ou entre Rackspace et un cloud interne, en pointant simplement vers le service approprié. Les nouveaux services devraient offrir une flexibilité similaire », a-t-il ajouté.

Accès à des bases MySQL en juillet, stockées sur SAN ou SSD

A partir du mois de juillet, Rackspace permettra d'accéder à une base de données relationnelle MySQL via l'API OpenStack. Les utilisateurs pourront alors créer, alimenter et gérer une base MySQL complète par l'intermédiaire du service Cloud Database de Rackspace. Ces bases seront sauvegardées dans un SAN (Storage Area Networks) redondant pour plus de fiabilité. Un autre service, Cloud Block Storage, permettra le stockage brut de données, soit de l'entreposage en blocs via un SAN, soit du stockage sur disques SSD, une option plus rapide, mais plus chère. Avec OpenStack, le client pourra aussi réserver un bloc de stockage indépendant de tout serveur déjà géré par l'entreprise. Enfin, avec le service Cloud Networks, les clients vont pouvoir mettre en place des réseaux virtuels sur leurs serveurs Rackspace réservés. Les utilisateurs pourront configurer plusieurs réseaux autonomes, et affecter à chaque réseau virtuel sa propre politique de sécurité et d'usage.

Rackspace n'a pas dévoilé les prix de ces services de base de données, de stockage et de réseaux. Mais, selon Mark Interrante, ils seront très concurrentiels, comparés à d'autres offres de cloud computing, comme celles d'Amazon. Les services de stockage et de réseaux seront gratuits pendant la période de test.

Fondée en 1998, Rackspace propose des services d'hébergement de serveurs dédiés, de messagerie, et des installations en colocalisation. L'entreprise compte environ 172 000 clients. C'est elle qui a dirigé le développement initial d'OpenStack, à partir d'une fonctionnalité centrale développée par la NASA.

Fujitsu ouvre les portes de ses labs

Selon le patron du principal département de recherche de Fujitsu, ce serait une erreur de réduire les investissements dans les nouvelles technologies à cause de la crise économique. « Parce que la recherche travaille sur le long terme, il est important que les fonds qu'on lui consacre ne soient pas trop dépendant de conditions économiques à court terme », a déclaré Tatsuo Tomita. Celui-ci s'exprimait la semaine dernière au cours de la journée portes ouvertes que les laboratoires de l'entreprise ont organisé à Kawasaki, dans la proche banlieue de Tokyo.

Fujitsu, qui a développé le supercalculateur K le plus rapide du monde, est connue pour ses travaux de recherche et de développement. Quels que soient les bénéfices réalisés, l'entreprise japonaise a consacré en moyenne 5% de ses revenus annuels à la création d'une nouvelle technologie. Et d'ailleurs, ses revenus ont fortement chuté au cours du récent ralentissement économique. Selon Tatsuo Tomita, le financement de la recherche ne doit pas être basé sur les bénéfices, mais plutôt sur les recettes, qui « reflètent mieux l'état de l'entreprise. » Celui-ci a réaffirmé que Fujitsu continuerait ses efforts dans la recherche, et que celle-ci se concentrerait notamment sur les technologies cloud et serveur, alors que l'entreprise cherche à prendre de la distance avec son image historique de fabricant de matériel électronique.

Analyse prédictive des défauts à venir

Un certain nombre de projets de recherche montrés lors de la journée portes ouvertes dans les laboratoires de Fujitsu reflètent ce changement. Les chercheurs ont montré des technologies qui permettent d'analyser rapidement de grands ensembles de données collectées à partir de milliers de capteurs installés sur le terrain, ainsi que des logiciels pour prédire les défauts de certains produits à partir de l'analyse de documents publics et de rapports, et un système pour réduire le nombre de lectures nécessaires sur les disques durs hébergeant des bases de données volumineuses.

Fujitsu a également montré le prototype d'un nouveau type de centre de calcul conteneurisé. Ces datacenters sont toujours plus populaires, car ils peuvent être rapidement installés et configurés. Mais les versions occidentales, généralement de la taille d'un conteneur de transport standard, sont souvent trop grandes pour être utilisées dans les espaces plus réduits de Tokyo. La version proposée par Fujitsu occupe l'espace d'une voiture de taille moyenne. Le constructeur a également choisi l'option peu répandue d'intégrer des serveurs sans ventilateurs internes. Le système préfère compter sur l'ajout d'une grosse unité de refroidissement chargée de surveiller les températures des CPU de chaque serveur et de l'ajuster en conséquence. Fujitsu prévoit de tester son prototype de datacenter conteneurisé au Japon pendant la saison d'été, chaude et humide. Avec une température extérieure de 35 degrés Celsius, le constructeur estime qu'il peut théoriquement réduire la consommation électrique de 40% par rapport aux versions traditionnelles.

Des assistants robotiques pour rester en contact avec des parents âgés

L'entreprise japonaise a également montré ses « teddy robots» expérimentaux, qui peuvent accompagner des personnes grâce aux caméras logées dans leurs narines et répondre au toucher ou à la pression. Ces ours-robots sont destinés à devenir les compagnons de personnes âgées et handicapées. Fujitsu leur ajoute toujours plus de fonctionnalités, comme la capacité à identifier l'humeur de leurs propriétaires et celle de stocker des données en ligne. Selon Toshiko Morita, qui dirige le département concsacré à l'interaction humaine, Fujitsu espère pouvoir utiliser les informations sur l'humeur pour aider les familles à rester en contact avec leurs parents âgés, aussi bien ceux séjournant dans des centres de soins, que ceux vivant à domicile. « Les données peuvent être envoyées à la famille, de sorte que celle-ci peut rester en contact avec un parent à distance, » a t-il expliqué.

(...)(06/04/2012 12:33:28)Citrix place CloudStack chez Apache et abandonne OpenStack

Citrix a abandonné sa distribution Olympus OpenStack pour se concentrer sur son système d'exploitation Open Source CloudStack, qu'il vient de faire accepter comme projet par l'Apache Software Foundation. Dans son annonce, Citrix a précisé que CloudStack continuerait à supporter les API d'Amazon, estimant que ce soutien était crucial pour le succès des plates-formes cloud. Citrix a sans doute reçu l'accord préalable d'Amazon avant de faire cette déclaration.

L'abandon d'OpenStack est peut-être aussi un coup porté contre ce système collaboratif pour le cloud. Ce dernier a du affronter certaines critiques suite à des décisions stratégiques qui auraient contribué à rendre certains utilisateurs dépendant de la plate-forme. Mais les experts n'ont pas tardé à affirmer que la décision de Citrix n'aurait pas d'impact significatif sur OpenStack.

Fondation Apache contre Fondation OpenStack

C'est mardi que Citrix a lancé CloudStack 3.0 sous licence Apache 2.0. L'entreprise prévoit également d'offrir une distribution commerciale d'Apache CloudStack. Ce système d'exploitation Open Source pour le cloud a été acquis par Citrix l'an dernier en même temps que le rachat de Cloud.com. Selon le vendeur, cette décision aurait reçu un large soutien de la part des entreprises utilisatrices de CloudStack ou de celles qui ont rendu leurs produits compatibles avec le système d'exploitation pour le cloud. « Cinquante fournisseurs de logiciels et de services, dont Engine Yard, RightScale, CumuLogic, Puppets Labs, HortonWorks, Opscode, Equinix, Juniper Networks et ScaleXtreme soutiennent le projet. Et plus de 100 clouds commerciaux utilisent CloudStack, dont certains font tourner des dizaines de milliers de serveurs, » a déclaré Citrix.

Le vendeur pense que l'Open Source est la clé du succès pour la plate-forme cloud. « Contrairement aux générations précédentes, nous croyons que le développement de cette plate-forme cloud va tirer profit de technologies qui auront fait leur preuve dans des nuages de taille importante, avant d'être mises à la disposition des clients sous licence Open Source », a déclaré Sameer Dholakia, vice-président et directeur général des plates-formes cloud chez Citrix. « C'est ce qui s'est passé avec les technologies cloud comme Hadoop, Hive et Cassandra, tous des outils Open Source qui servent à construire ou à gérer des bases de données, » a-t-il fait remarquer. « Nous pensons qu'il va se passer la même chose avec les plates-formes cloud qui vont faire tourner ces nouveaux services. »

Faire aussi bien que Red Hat

Citrix croit au fort potentiel de sa plate-forme et espère faire aussi bien que Red Hat, qui rapporte des centaines de millions de dollars avec la vente de produits basés sur Linux. L'éditeur au chapeau rouge vient d'ailleurs de passer la barre du milliard en chiffre d'affaires. « Nous allons mettre sur le marché une distribution commerciale d'Apache CloudStack qui a des chances de devenir très populaire, » a-t-il ajouté. « Parce que les clients auront envie d'acheter ce type de logiciel à une entreprise bien établie comme Citrix, » a-t-il encore déclaré. « Nous prévoyons de réaliser des investissements à « sept chiffes » en ingénierie et en marketing sur le projet Apache CloudStack, » a-t-il encore confié.

[[page]]

La décision de Citrix d'abandonner OpenStack, implique qu'elle cesse tout travail sur la distribution. OpenStack a décidé de créer une fondation pour soutenir son projet. « L'idée était de donner plus de légitimité à ce logiciel, mais ce choix a rendu OpenStack moins attrayant pour Citrix, » a déclaré Sameer Dholakia. « En tant qu'entreprise, Citrix ne pense pas que la création d'une fondation soit une question secondaire. Nous pensons que c'est un engagement et un risque qu'il n'est pas nécessaire de prendre vis-à-vis d'un programme aussi critique ... surtout quand il existe déjà une Fondation comme Apache qui a fait ses preuves, » a-t-il déclaré. De plus, Citrix va pouvoir s'appuyer sur les API d'Amazon, ce qui signifie que les clients vont pouvoir déplacer facilement leurs charges de travail entre Amazon Web Services et d'autres cloud - en particulier, des clouds privés - qui supportent également les API d'Amazon.

La guerre des APi ne fait que commencer

Si OpenStack supporte certaines API d'Amazon, le projet semble plus enclin à supporter ses propres API. « Amazon a inventé et a créé ce marché. Nous pensons que pour avoir du succès dans ce secteur, il faut proposer une plate-forme avec un fort degré d'interopérabilité avec Amazon, » a estimé le vice-président et directeur général des plates-formes cloud chez Citrix.

Il y a quelques semaines à peine, Amazon avait annoncé qu'elle soutenait le choix d'Eucalyptus de supporter les API d'AWS. C'était la première fois qu'Amazon proposait un tel support en matière d'API. À l'époque, les experts disaient que certaines entreprises rechignaient à utiliser Eucalyptus parce qu'elles ne savaient pas si Amazon avait approuvé l'utilisation de son API. Sans cette approbation, les utilisateurs finaux s'inquiétaient des violations potentielles de la propriété intellectuelle. Par ailleurs, Amazon pouvait aussi modifier son API de manière à empêcher l'interopérabilité entre un cloud Eucalyptus et les clouds d'Amazon. Après l'annonce concernant Eucalyptus, les entreprises ont été rassurées, estimant que le partenariat garantissait qu'Eucalyptus resterait compatible avec les API d'Amazon, et qu'Eucalyptus pourrait plus rapidement supporter davantage d'API d'Amazon. Citrix ne communiquerait pas sur le sujet si, lui aussi, n'avait pas obtenu le soutien officiel d'Amazon. Le vendeur a d'ailleurs laissé entendre que c'était bien le cas. « L'élément le plus important dans l'annonce d'Eucalyptus, c'est qu'elle n'était pas exclusive. Je ne peux pas dire que nous ferons une déclaration publique aussi explicite », a déclaré Sameer Dholakia.

Encore des liens avec OpenStack

Mais Citrix ne tourne pas entièrement le dos à OpenStack. « Nous allons continuer à jouer un rôle actif dans la communauté OpenStack, » a ainsi déclaré le vice-président et directeur général des plates-formes cloud chez Citrix. Notamment, le vendeur va continuer à travailler avec OpenStack pour rendre la plate-forme compatible avec l'hyperviseur de Citrix. « De plus, au fur et à mesure que les composants OpenStack gagneront en maturité, Citrix en intégrera certains dans sa propre pile, » a-t-il ajouté.

Selon un analyste, la communauté OpenStack ne va pas regretter le départ de Citrix. « Pendant plusieurs mois, la communauté OpenStack a eu l'occasion de travailler avec Citrix pour fusionner les codes de CloudStack et d'OpenStack. Si cette annonce avait vraiment été un coup dur pour eux, ils auraient fait quelque chose pour l'éviter. « En d'autres termes, je ne pense pas que les développeurs OpenStack soient très concernés par le fait que Citrix reste ou s'en aille », a déclaré Rachel Chalmers, directeur de recherche en infrastructure pour The 451 Group. OpenStack est supporté par de grands bailleurs comme AT&T, Dell et HP. « Il est trop tôt pour apprécier vraiment l'impact de la décision prise par Citrix, » a déclaré Stephen O'Grady, analyste chez Redmonk. « Évidemment, ce n'est pas une bonne nouvelle pour OpenStack, mais c'est aussi très prématuré de prédire l'effet possible. Certes, les contributeurs d'OpenStack ont réussi à donner un certain élan à ce projet. Il sera intéressant de voir quel impact cette nouvelle aura sur leur motivation, » a-t-il déclaré.

(...)| Les 10 documents suivants > |