Flux RSS

Infrastructure serveur

2924 documents trouvés, affichage des résultats 1111 à 1120.

| < Les 10 documents précédents | Les 10 documents suivants > |

(03/05/2010 12:48:17)

Valse d'hésitations dans les switchs 40 Gbits Ethernet pour datacenters

L'équipementier Extreme Networks a présenté un module de 4 ports 40 Gbits Ethernet sur le Summity X650 et sur les commutateurs Black Diamond lors de la conférence Interop. L'innovation réside aussi dans l'agressivité tarifaire avec un prix au port de 1000 dollars soit seulement 85 dollars de plus que le prix moyen d'un port 10 Gbits Ethernet, indique le Dell'Oro Group.

Pour autant à l'exception de Force 10 Networks et Brocade, les concurrents d'Extreme restent prudents sur le calendrier de la disponibilité de leur produit 40 Gbits Ethernet. Et seul Brocade a estimé qu'il pourrait s'aligner sur les mêmes tarifs. Un mail envoyé par Kevin Wade, directeur marketing de Force 10 a indiqué que le prix serait compris entre 6 à 8 fois le prix du 10 Gbits Ethernet. Avec l'acquisition de 3Com HP, lui, a hérité d'un commutateur compatible pour le 40/100 Gbits Ethernet, le 12500. La start-up Arista Networks a dévoilé le AN 7500 comprenant une capacité de 10 To sur du 40/100 Gbits Ethernet. Ce produit, qui a été récompensé lors du salon Interop, propose d'embarquer 12 à 16 ports 40 Gbits Ethernet et 4 ports 100 Gbits Ethernet d'ici à la fin 2011 ou au début 2012, selon Doug Gourlay, vice-président marketing et ce dernier explique que « les clients s'interrogent sur l'intérêt d'investir dans des cartes 40/100 Gbits Ethernet si d'ici 2 ou 3 ans, si elles doivent ensuite les jeter et migrer vers des capacités plus importantes ». Brocade, par exemple, prévoit la sortie de son interface 100 Gbits Ethernet sur son sytème MLX-32 avant la fin de l'année et le 40 Gbits Ethernet au début 2011.

Avaya, n'a rien annoncé, mais à travers l'acquisition des solutions entreprises de Nortel, des solutions 40 Gbits Ethernet devraient apparaître sur des produits comme le VSP 9000, commutateur de coeur de datacenter.

Une problématique spécifique Cisco

De son côté, Cisco pourrait avoir d'autres soucis que les éléments tarifaires ou la disponibilité des produits. Avec une capacité maximale de 230 Gbits, le commutateur dédié au datacenter Nexus 7000 n'aurait peut-être pas assez de puissance pour accueillir des interfaces 40 Gbits Ethernet, estimées entre 8 et 16 ports par les spécialistes du secteur. Cela nécessiterait une mise à jour technique des modules fabric du switchs Nexus 7000 qui datent de 2 ans, selon des sources internes et externes à Cisco.

[[page]]

« Il pourrait intégrer le 40 Gbits Ethernet, mais pas à une densité optimisée pour une capacité maximale de 230 Gbits » déclare une source qui connaît la situation et d'ajouter « il n'y a pas d'évolution du module fabric, sans risques de pannes ». Il fait référence à la nécessaire interruption des commutateurs pour les mettre à jour. Une autre source au sein de l'équipementier explique qu'il devrait déployer le 40 Gbits Ethernet sur le Nexus 7000, après que le standard soit ratifié en juin prochain. Cette intégration pourrait intervenir avant la fin de l'année, si les différents acteurs intègrent la même densité de ports que Cisco. Un autre salrié de l'équipementier est plus évasif sur la date et l'intégration du 40 Gbits Ethernet dans le Nexus 7000, avec une capacité d'au moins 8 ports. « Le plus grand problème pour nous est de savoir si le client disposera d'un système avec une architecture suffisamment évolutive à un prix raisonnable » souligne Thomas Scheibe, directeur de la commutation des DataCenters et des services chez Cisco. « Le 7000 actuel supportera les interfaces 40/100 Gbits Ethernet » explique t'il et d'ajouter « Est-ce que l'architecture sera évolutive ? Elle sera adaptée à une capacité de la moitié de 1 Tbit par slot. Cela devrait être suffisant pour répondre aux besoins des clients ».

Côté clients justement, on ne s'alarme pas de ces problématiques. « Je n'ai rien entendu sur le sujet de la part de Cisco, mais je ne leur ai pas demandé non plus. Je n'ai pas besoin de capacité 40/100 Gbits Ethernet aujourd'hui et ce n'est pas un problème pour moi » déclare Michael Morris, blogger sur Network World et ingénieur en communication.

Pourquoi Google est-il devenu courtier en énergie ?

En février dernier, sa filiale, Google Energy, avait reçu l'approbation de la US Federal Energy Regulatory Commission (FERC) pour acheter et vendre de l'électricité sur le marché de gros, provoquant quelques spéculations et laissant même entendre que Google aurait l'intention d'entrer dans le secteur de l'énergie. « Nous ne voulons pas devenir opérateur d'électricité, que Dieu nous protège d'un autre Enron, »a déclaré Bill Weihl, tsar de l'énergie verte chez le géant du web, au cours d'une interview donnée pendant la conférence GreenNet de San Francisco. « Ce que nous voulons, c'est une souplesse suffisante pour gérer nos contrats d'énergie, en particulier nous souhaitons être en mesure de signer des contrats utiles pour les producteurs d'énergie et avoir plus de choix en matière de sources renouvelables. »

A titre d'exemple sur la façon dont Google pouvait utiliser son statut FERC pour soutenir le développement de projets d'énergie propre, Bill Weihl a expliqué que l'entreprise signait généralement avec les fournisseurs d'énergie du service public des contrats d'approvisionnement de plusieurs années, afin notamment de prévoir ses besoins en électricité. «Si un producteur veut construire un parc éolien au coin de la rue, nous serions ravi d'acheter de l'électricité provenant de sa ferme à vent. Mais pour le faire d'une manière utile pour lui, nous avons besoin de signer un accord d'achat d'électricité, pour, disons 10 ou 20 ans, ce qui lui permet d'obtenir des taux de financement intéressant et libère des capitaux pour un autre projet, » a t-il déclaré.

Illustration : crédits D.R.

[[page]]

Si Google est liée à une entreprise de services publics, elle ne peut plus signer de contrat de fourniture d'électricité avec le parc éolien, « sauf à vouloir perdre de l'argent. » « Ce que l'autorisation de la FERC nous permet de faire, c'est de revendre cette production d'énergie éolienne jusqu'au jour où nous pourrons l'utiliser pour nos propres besoins, » a déclaré Bill Weihl. « C'est fondamentalement le genre de chose que nous voulons faire. » En d'autres termes, la compagnie de Mountain View peut acheter et vendre de l'énergie, mais comme une manière d'augmenter son ratio d'approvisionnement en énergies renouvelables, plutôt que comme une entreprise en soi.

Google, l'un des plus grands opérateurs mondiaux de datacenters, est toujours à la recherche de moyens pour réduire ses coûts et l'empreinte environnementale de ses opérations. La société s'est en effet engagée à une activité à zéro carbone en combinant plusieurs facteurs : accroître son efficacité, augmenter son utilisation d'énergies renouvelables et jouer sur les crédits carbone. Greenpeace a fait l'éloge de Google pour sa défense de l'environnement et pour son outil PowerMeter, qui aide les consommateurs à réduire leur consommation d'énergie. Mais elle a aussi reproché à la société de ne pas avoir fixé d'objectifs en matière de réduction de CO2 et de ne pas divulguer de chiffres à ce propos. Au palmarès Cool IT de Greenpeace qui classe les entreprises informatiques en fonction de leur impact sur l'environnement, Google arrive en sixième position sur 15. (...)

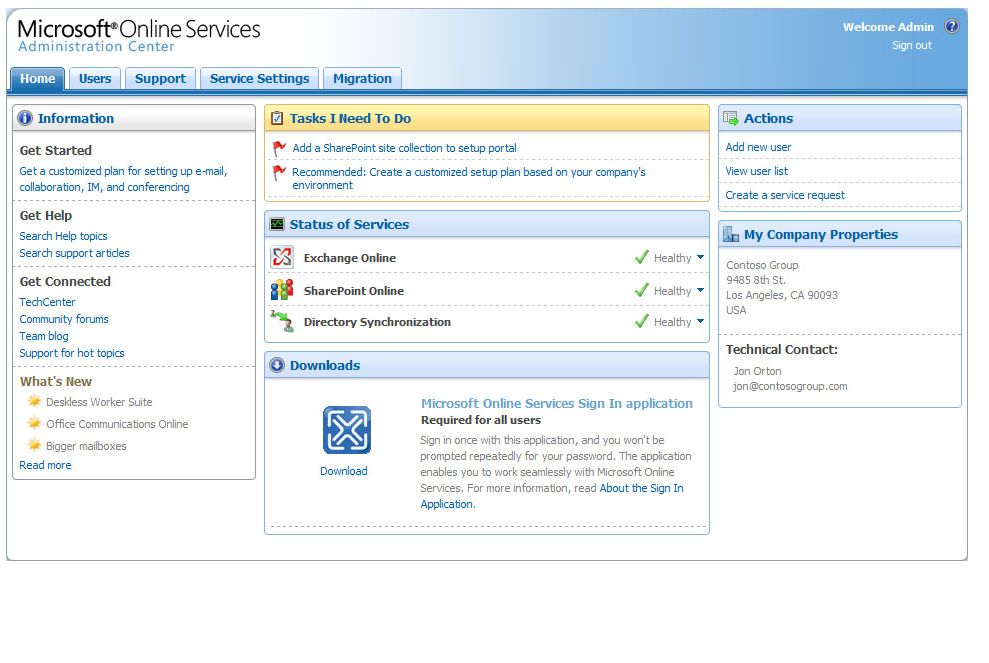

Microsoft pousse Exchange dans le cloud vers les grands comptes

Voilà déjà plusieurs années que les entreprises françaises peuvent utiliser Exchange en ligne en s'adressant à l'un des partenaires de Microsoft qui hébergent le serveur de messagerie. Ceux-ci tarifient le service en fonction des prestations qu'ils lui associent. Parmi ces prestataires figurent, notamment, des sociétés comme Jet Multimedia, Global SP ou encore Orange. A cela s'est ajouté, uniquement aux Etats-Unis dans un premier temps, l'offre mutualisée Online Services que Microsoft héberge sur ses propres datacenters. Cette offre s'est ouverte à 25 autres pays, dont la France, il y a exactement un an. Pour l'Europe, l'éditeur la gère dans son datacenter de Dublin. Les services ainsi réunis donnent accès à Exchange Online, mais aussi à Office Communications Online (messagerie instantanée, texte, voix et vidéo), au logiciel de réunion Live Meeting, ainsi qu'au portail Sharepoint Online. Il en coûte 8,52 €HT par mois et par utilisateur pour exploiter l'ensemble des fonctions, et 4,26 €HT seulement si l'on se limite à la messagerie.

Face à Microsoft, le grand concurrent, Google, propose aux entreprises d'accéder à sa messagerie Gmail et à la totalité de ses Google Apps (Calendar, Documents, etc.) au tarif annuel de 40 € par utilisateur.

Une offre 'Dedicated' au-delà de 20 000 postes

En France, cent clients ont déjà opté pour les Microsoft Online Services. Ils rassemblent quelque 35 000 utilisateurs, dont 80 à 90% exploitent Exchange. Avec cette offre, Microsoft cible toutes les tailles d'entreprise. « Parmi nos clients, nous avons aussi bien des PME de cinquante salariés [comme Peaks, une société de consultants lyonnaise de 50 personnes], que de grandes entreprises telles que le fournisseur de matériel électrique Rexel, qui compte 10 000 postes à ce jour et prévoit d'en déployer davantage », explique Isabelle Scemla, chef produit pour les communications unifiées chez Microsoft France.

Pour apporter une réponse adaptée aux très grands déploiements, Microsoft a dédoublé sa proposition sur Online Services. « Nous avons d'une part l'offre Standard, installée sur des datacenters mutualisés, et d'autre part l'offre Dedicated qui, au-delà de 20 000 postes, peut être installée par Microsoft sur des serveurs dédiés, ce qui permet d'aller plus loin sur la personnalisation des serveurs », explique la responsable produit. Pour l'instant, la filiale hexagonale n'a pas encore de référence sur cette offre Dedicated. « Mais nous sommes en négociation avec de grands comptes français. Sur les trois à quatre mois, un million de postes devraient se négocier sur les Online Services ».

Crédit photo illustration : Microsoft

[[page]]

Rappelons par ailleurs qu'un partenariat exclusif a été signé avec Orange qui, dans quelques mois, pourra lui-aussi revendre l'accès aux Online Services sous la forme d'offres packagées accompagnées de prestations supplémentaires (migration, personnalisation...). Microsoft reste, dans tous les cas, celui qui facture et héberge.

Cliquer sur l'image pour l'ouvrir

Combiner des serveurs Exchange internes et dans le cloud

Dans bien des situations, les entreprises trouveront avantageux de faire migrer leur messagerie Exchange de leurs serveurs vers ceux de Microsoft. Face à l'alternative Google, la société de Steve Ballmer avance, entre autres, l'avantage d'une forte intégration entre ses outils en ligne et son client Outlook. Pour tester sans hâte les services cloud, l'éditeur promeut vigoureusement un modèle hybride mêlant licences classiques installées dans l'entreprise et services en ligne. Les configurations Exchange utilisées sans personnalisation peuvent facilement migrer vers le cloud. Dans le même temps, les versions d'Exchange très intégrées avec d'autres applications du système d'information (avec les applications de gestion de SAP, par exemple) resteront gérées en interne.

Aujourd'hui, outre Atlantique notamment, certaines grandes entreprises qui ont pris la décision de migrer vers les Google Apps l'ont souvent fait avant que Microsoft ait livré Exchange dans le cloud. Désormais, les deux concurrents sont sur un pied d'égalité en termes de messageries dans le cloud.

Interop 2010 : la portabilité des services cloud au coeur des débats

« Probablement dès cette année, nous aurons les moyens de faciliter le déplacement de la charge de travail des centres de calcul internes vers des services cloud externes, à l'aide d'un logiciel » a expliqué Randy Rowland, vice-président en charge du développement produit chez Terremark. Les clients veulent avoir l'assurance de pouvoir rapatrier une charge de travail confiée à un cloud dans leur datacenter si les circonstances le permettent », a-t-il ajouté. « Les entreprises ont peur de rester bloquées. Certains obstacles réseaux existent effectivement, comme le changement des adresses IP, pour lequel il faut trouver une méthode plus facile ». Pour Simon Crosby, CTO de Citrix, « cette préoccupation autour de la transférabilité est prise en compte. Les vendeurs savent qu'elle existe et qu'ils doivent trouver des solutions. »

« Les images de la machine virtuelle Amazon, utilisées sur le service cloud Amazon EC2, très répandu, sont en propriété exclusive et difficiles à répartir sur les réseaux d'entreprise, » a souligné de son côté Alistair Croll, fondateur de Bitcurrent. Mais Simon Crosby a constaté des progrès dans certains domaines, comme la norme Open Virtualization Format (OVF). Selon lui, elle rend la charge de travail indépendante de l'hyperviseur, et permet l'interopérabilité entre des plates-formes de virtualisation multiples. « La virtualisation a permis d'améliorer la portabilité des charges de travail entre serveurs, mais les premières versions des offres « Infrastructure-as-a-Service » pour le Cloud manquaient de ressources en matière de réseaux, et il faudra trouver de nouvelles méthodes pour les renforcer et améliorer la portabilité », a précisé Simon Crosby.

Illustration Alistair Croll, fondateur de Bitcurrent, Crédits D.R.

[[page]]

Kristof Kloeckner, CTO d'IBM, autre conférencier présent à Interop, a déclaré dans une interview que le déplacement des charges de travail depuis les centres de données internes vers les cloud n'était pas difficile. Selon lui, « les problèmes surviennent lorsque les applications demandent qu'un grand nombre de données soient transférées vers le cloud. » Certaines démonstrations faites à Interop ont montré le déplacement d'applications entre différents clouds, mais « la plupart des exemples sont vraiment basiques dans le sens où ils ne déplacent pas de volumes de données très importants », a expliqué le CTO d'IBM. Selon lui, les applications à base de grid, les simulations, ou les charges de travail occasionnelles (saisonnières notamment) sont sans doute bien adaptées au déplacement temporaire vers un cloud. « Les services clouds s'intègreront les uns aux autres », a-t-il ajouté au cours de son allocution. « Surtout, ils devront rester ouverts. C'est un de nos objectifs majeurs. Ce qui se passe aujourd'hui est un changement fondamental. Cela montre la nécessité d'introduire plus de souplesse dans le déploiement des services informatiques. »

« Dans l'avenir, il y aura essentiellement trois catégories d'applications », a poursuivi de son côté Alistair Croll, de Bitcurrent. Celles qui resteront toujours à l'intérieur du datacenter de l'entreprise, celles qui pourront être exécutées indifféremment en interne ou au sein d'un service cloud si cet hébergement a un sens sur le plan économique, et une troisième catégorie qui demeurera toujours en cloud, notamment si l'application doit être partagée avec des partenaires. »

La question de savoir si les entreprises doivent déplacer des applications existantes vers des services cloud externes n'est pas toujours facile à résoudre. Certains intervenants présents à Interop ont laissé entendre que si les clients sont prêts à déplacer de nouvelles applications vers le cloud, ils ne savent pas encore si l'effort et les coûts de transfert de leurs applications existantes correspondent à un vrai gain en termes de budget.

(...)(30/04/2010 13:18:52)Le recours aux SSD va grimper dans les entreprises d'ici 2015

Une étude du cabinet Objective Analysis prévoit une sensible augmentation de l'utilisation des SSD (solid state drives) dans les serveurs et systèmes de stockage d'entreprise, dans les cinq prochaines années. Selon ses estimations, leur nombre devrait être multiplié par 50 sur ce marché, soit 4 millions de disques et un marché de 4 milliards de dollars en 2015 (17 fois celui de 2009) pour les SSD en entreprise.

L'année dernière, il s'est écoulé, tous usages confondus, 11 millions de ces disques, selon IDC. Le cabinet d'analyste rappelait alors que les PC constituaient le marché le plus important pour les SSD, d'une part comme alternative aux disques durs dans les notebooks traditionnels, d'autre part pour les mininotebooks.

Le stockage sur SSD réduit le TCO

Jim Handy, auteur de l'étude d'Objective Analysis, note de son côté que le recours aux SSD a déjà commencé à se développer dans les entreprises. « Les responsables IT se sont aperçus qu'ils pouvaient réduire leurs coûts et augmenter les performances en remplaçant les disques durs avec cette technologie de prime abord bien trop onéreuse. » Le rapport explique que le stockage sur SSD peut diminuer le coût total de possession, la consommation d'électricité et l'encombrement au sol.

Crédit illustration photo : Intel

[[page]]Les SSD sont utilisés dans les datacenters, soit pour remplacer les disques Fibre Channel à 15 000 rpm (révolutions par minute), soit pour ajouter un niveau de stockage plus performant au-dessus du Fibre Channel pour l'exploitation de bases de données relationnelles ou la diffusion de flux vidéo en continu (streaming video). L'atout performance apporté par les SSD en datacenter est très important, indique le cabinet d'études. Un seul SSD peut effectuer jusqu'à 16 000 entrées/sorties par seconde (IOPS). Par comparaison, un disque Fibre Channel haut de gamme à 15 000 rpm effectue au maximum 200 IOPS.

Les MLC aussi performantes que les premières SLC

Originellement, les SSD étaient destinés à des datacenters, avec puces NAND flash dotée de cellules sur un niveau (SLC, single-level cell) de très haute qualité, offrant les meilleures performances et fiabilité. Or, maintenant, les cellules flash NAND multiniveaux (MLC), qui stockent plus d'un bit par cellule de mémoire flash, offrent des capacités supérieures et approchent les mêmes performances et fiabilité que les SLC en recourant à des firmwares spécifiques dans le contrôleur du disque. Cité par nos confrères de Computerworld, Dean Klein, vice-président du développement des mémoires chez Micron, affirme qu'un administrateur du système de stockage pourrait remplacer jusqu'à 30 disques Fibre Channel par un seul SSD.

L'étude d'Objective Analysis liste 22 applications clés dans l'entreprise pour les SSD, dans des domaines variés.

Le PDG de Bull démissionne

C'est par un communiqué que l'information a été divulguée, le conseil d'administration de Bull a pris acte de la de la démission de Didier Lamouche, Président Directeur Général. Celui-ci a précisé : « Après plus de 5 ans passés à la tête de l'entreprise, j'estime ma mission de transformation accomplie. Avec l'acquisition, en début d'année, d'Amesys et la constitution d'un actionnariat de long terme, le groupe Bull a désormais les moyens de son développement. Je remercie les collaborateurs pour leur mobilisation et leur soutien pendant toutes ces années et leur souhaite de poursuivre avec succès cette nouvelle étape ». Selon le journal la Tribune, ce départ pourrait s'expliquer par un désaccord entre le dirigeant et le principal actionnaire de Bull, Crescendo Industries.

Dans l'attente de trouver un successeur, un groupe de travail va être mis en place autour de Philippe Vannier, membre du conseil d'administration. Ce groupe sera chargé de faire les propositions de nature à conforter la stratégie de l'entreprise.

Red Hat étend son support Premium à ses VM sur le cloud Amazon

Cette option permettra aux abonnés Premium de déplacer leurs VM entre le datacenter et le cloud, en précisant que les frais d'abonnement Premium s'élèvent à 1 300 dollars US par an pour un serveur équipé au maximum de deux sockets processeur, et à 2 500 dollars pour un machine avec trois emplacements ou plus. Cependant, tous les clients ne sont pas éligibles à la formule Access Cloud puisqu'il faut en effet disposer au minimum de 25 abonnements Premium actifs et disposer d'un contrat de support direct avec Red Hat. En d'autres termes, les clients ayant achetés leur support Red Hat via un tiers ou par l'intermédiaire d'équipementiers OEM ne sont pas admis au programme, selon le site web de Red Hat.

« L'objectif est de faciliter l'ajout de capacité serveurs à l'aide du cloud ou le déplacement de VM entre le centre de calcul et le cloud, et vice versa, sans avoir à se préoccuper de la manière dont est assurée l'administration, » explique Magnus Svensson, directeur de Red Hat pour les pays nordiques. Selon Red Hat, avec Cloud Access, les clients pourront continuer à utiliser leurs contacts et leurs méthodes habituelles pour obtenir le support en matière de gestion et d'administration serveurs. Red Hat s'engage également à livrer les dernières versions disponibles d'Enterprise Linux pour Amazon EC2 en même temps que celles destinées aux déploiements traditionnels sur site, de manière à augmenter la cohérence entre les deux mondes.

Illustration, crédits Red Hat

(...)(28/04/2010 16:17:33)Un cloud privé externalisé pour Veepee

Pour Eric Rousseau, PDG de Veepee, « il s'agit d'une évolution logique et naturelle d'un opérateur qui apporte des services managés », en annonçant le lancement de son offre de cloud privé externalisé. Cela signifie que la société met à disposition ses capacités de calcul au sein de ses deux datacenters pour mutualiser les coûts d'infrastructures. L'entreprise est assurée via un VLAN d'avoir un espace dédié pour le stockage et la virtualisation, donc la traçabilité de ses données.

L'offre de l'opérateur se décline en deux gammes. Le cloud HD (Haute Disponibilité) est monosite, et comprend plusieurs packs, pour élaborer des machines virtuelles, allant de 1 processeur Intel, 2 Go Ram et 40 Go de capacité à 8 CPU, 16 Go Ram et 320 Go de capacité. Un autre service THD (Très Haute Disponibilité) reprend les caractéristiques de l'offre HD avec une redondance sur le datacenter d'un opérateur tiers relié en fibre optique elle aussi doublée. Cette offre répond aux besoins spécifiques des PRA (plan de reprise d'activité). La tarification de la gamme HD dépend des ressources souhaitées, mais elle varie de 100€ HT à 800€ HT selon la machine et la capacité désirée. Il n'y a pas de durée d'engagement sur ces deux offres.

Eric Rousseau est optimiste sur les solutions proposées « avec les annonces gouvernementales en matière de cloud (NDLR, une enveloppe de 700 millions d'euros a été évoquée dans le volet numérique du grand emprunt), le déploiement de la fibre optique réduisant ainsi les problématiques de latence ». La cible de l'opérateur est multiple allant des radios aux sites de e-commerce. Ces derniers sont à la recherche de disponibilité et des ressources à des moments précis (soldes, ventes flash, etc.).

Bull adopte l'Itanium Tukwila sur ses gcos 8

Systèmes de classe mainframe, les novascale gcos 9010 (à partir de 150 K€) reposent toujours sur une architecture centralisée et supportent les systèmes d'exploitation gcos 8 - sur laquelle tournent encore aujourd'hui un grand nombre d'applications métiers comme le moteur Cristal de la CNAF - et Linux qui assure aujourd'hui l'ouverture et l'évolutivité demandées par les clients. Avec le concours de Bull, l'organisme travaillait depuis plusieurs mois sur la consolidation de ses centres de production. Fin juin, 5 datacenters reposant sur des solutions Bull - les 3 autres utilisent des systèmes IBM - vont ainsi être concentrés à Bordeaux pour assurer le fonctionnement de l'application Cristal qui assure le calcul des droits des 33 millions de bénéficiaires. Il s'agit du coeur de la CNAF qui assure les versements des prestations légales, des minima sociaux et des aides sociales.

Un mainframe unique pour consolider 5 centres de production

Douze machines novascale Helios 3 (2 systèmes avec 8 puces Itanium Montecito pour 5 centres de production et un autre d'étude et de développement) sont ainsi consolidées sur un gcos 9010 avec douze partitions de production avec 12 processeurs Itanium (et une treizième en réserve), une boîte noire Linux pour les entrées/sorties et des serveurs Xeon 7500 pour la partie base de données PostgreSQL qui a remplacé la solution RFM2 de Bull en 2009. Gérard Russeil, DSI de la CNAF précise à cette occasion avoir « choisi le serveur novascale gcos 9010 pour répondre aux exigences de performances, de continuité de service et d'ouverture de notre système d'information. Son architecture conçue par Bull (...) répondent à nos attentes. Les tests engagés depuis plusieurs mois ont montré un niveau de performance en transactionnel et Batch associés à la nouvelle base de données PostgreSQL qui nous permet d'aborder avec confiance un programme de concentration de plusieurs centres de production sur un seul datacenter ».

Nous reviendrons sur ce cas utilisateur la semaine prochaine avec une interview du DSI de la CNAF, monsieur Gérard Russeil.

(...)(28/04/2010 09:54:39)Après son ouverture sur EC2, Lawson déploie aussi en cloud privé

Quelques semaines après avoir proposé à ses clients d'installer les ERP de son catalogue dans le cloud d'Amazon (EC2), Lawson Software lance une deuxième option de déploiement en environnement virtualisé. Cette fois, il est question d'infrastructure privée. Avec son offre Lawson Internal Cloud Services, l'éditeur américain propose des technologies de virtualisation (celle de VMware) et de distribution de la charge de travail sur des serveurs en clusters (Lawson Grid Technology, développée par ses soins). Il vise les entreprises qui veulent déployer les applications en interne, sur leurs propres équipements.

Lawson prévoit de commercialiser plusieurs « appliances virtuelles ». Les deux premières, en mai, seront Lawson Smart Office et Lawson Enterprise Search, présentées comme des add-on à ses ERP. Le premier produit permet de personnaliser son espace de travail, le deuxième est un outil de recherche destiné aux ERP. Ils sont livrés, prêts à être déployés, dans des machines virtuelles sous VMware qui utilisent Linux et le serveur d'application WebSphere d'IBM.

En complément, l'éditeur propose une console d'administration qui permettra au département informatique de mettre l'application en route, de façon automatisée, par « drag and drop » dans un environnement de test, de développement, de formation ou de production. C'est le même outil que Lawson utilise lui-même pour gérer les applications que ses clients auront choisi de déployer dans le cloud d'Amazon, avec l'offre Lawson External Cloud Services. Cette dernière concerne ses solutions de gestion intégrées Lawson Enterprise Management Systems (c'est-à-dire S3 et M3, ex-Intentia Movex), ainsi que l'offre Talent Management de gestion des ressources humaines.

| < Les 10 documents précédents | Les 10 documents suivants > |