Flux RSS

Architecture logicielle

2077 documents trouvés, affichage des résultats 41 à 50.

| < Les 10 documents précédents | Les 10 documents suivants > |

(16/01/2012 14:33:58)

Oracle va livrer 78 correctifs, dont 27 pour MySQL

Oracle proposera le mardi 17 janvier 78 correctifs de sécurité pour corriger les vulnérabilités de sa base de données, de son middleware et de ses applications, selon un communiqué posté sur le site aperçu de l'entreprise.

27 de ces correctifs concernent la base de données MySQL. Une des vulnérabilités peut être exploitée sur un réseau sans droits d'administration. Le plus haut CVSS (Common Vulnerability Scoring System) parmi les bogues MySQL est noté 5,5, ce qui le classe dans la gamme de risques «moyens». Deux autres correctifs sont destinés à Oracle database et l'éditeur a également prévu de délivrer 11 patchs pour Fusion Middleware. Cinq de ces bogues concernent des failles qui peuvent être exploitées à distance sans que l'authentification de l'utilisateur soit requise.

Sur le front applicatif, la suite E-Business de l'éditeur va recevoir trois patchs, le logiciel de gestion de l'approvisionnement un seul, PeopleSoft six correctifs, et JD Edwards huit. Par ailleurs, 17 patchs seront destinés aux produits Sun, avec 6 failles qui peuvent être exploitées à distance sans authentification préalable. Les produits affectés comprennent GlassFish Enterprise Server et le système d'exploitation Solaris. Enfin, trois autres patchs sont affectés aux technologies de virtualisation d'Oracle, notamment la machine virtuelle VirtualBox. Le langage de programmation Java n'est toutefois pas concerné par cette annonce. Sa dernière mise à jour datait de Décembre 2011.

Progress Software rachète Corticon, spécialiste des règles métiers

Progress Software étoffe son offre de réactivité opérationnelle (RPM) en rachetant la société Corticon. L'éditeur basé à Redwood en Californie propose une solution de gestion des règles métiers. Elle doit permettre aux entreprises de prendre plus rapidement des décisions. Le logiciel de Corticon s'appuie sur un moteur de règles « sans codage » autorisant l'automatisation des processus des décisions. L'éditeur annonce une réduction de 90% du cycle de développement et de modification des règles. Son produit phare est Corticon 5 qui comprend plusieurs modules, Server, Studio, Collaborator, Entreprise data connector (pour le dialogue avec les bases de données). On notera aussi une version beta de RulesCloud pour adopter des règles métiers aux services proposés en mode hébergé.

Le montant de l'opération n'a pas été publié.

(...)

Objectif-C, 5ème langage de programmation le plus utilisé selon Tiobe

Selon l'indice calculé par Tiobe, le langage de programmation Objective-C, utilisé pour le développement d'applications pour iOS, a connu une très forte croissance en 2011. Il se hisserait à la cinquième place derrière Java, C, C# et C++, dépassant désormais PHP, Basic/Visual Basic et Python. Ce langage atteindrait ainsi 6,9% de parts de marché.

L'indice Tiobe est calculé mensuellement en tenant compte de l'utilisation des différents langages dans différents projets, de mots clés identifiés dans les moteurs de recherches, ou encore du nombre de développeurs, de logiciels et d'offres de formation répertoriés.

ICTjournal.ch (...)

Témoignage : Oracle Exadata, une machine de consolidation pour Redcats

Venu évaluer les applications de gestion Fusion d'Oracle, à l'automne 2010 sur la conférence OpenWorld, à San Francisco, Frédéric Ndiaye, Responsable Solutions Informatiques du Groupe Redcats (La Redoute Catalogues), découvre sur place l'intérêt suscité par Exadata. Cette appliance, annoncée pour la première fois en 2008, combine des serveurs de bases de données et des systèmes de stockage avec des logiciels optimisés pour exploiter les bases, à la fois pour les applications de datawarehouse et en mode transactionnel (OLTP). En 2010, la solution est présentée dans une 3e version plus puissante, la X2-8, basée sur deux serveurs Sun 8-socket totalisant 128 coeurs Intel et rassemblant jusqu'à 336 téraoctets de stockage brut. « Sur OpenWorld, tout le monde parlait de l'Exadata, en commençant par Larry Ellison le PDG d'Oracle, et il y avait une telle énergie derrière cette machine que j'ai voulu en apprendre davantage », se souvient Frédéric Ndiaye. Ce qui l'intéresse surtout, c'est l'aspect tuning de la solution qui vient booster les performances de l'infrastructure.

Redcats est la holding de la filiale VAD (vente à distance) du groupe PPR. C'est un groupe international de 14 000 collaborateurs qui gère 17 marques parmi lesquelles La Redoute, Vert Baudet, Cyrillus, Somewhere et Daxon. Plus de 54% de ses 3,5 milliards d'euros de chiffre d'affaires sont réalisés sur Internet et la moitié est générée hors de France. Si ses différents services informatiques fonctionnent de façon assez décentralisée, avec des DSI dans chacune des marques, certaines applications partagées sont portées au niveau du groupe pour l'ensemble des marques, explique Frédéric Ndiaye. « Il s'agit principalement du système financier, qui repose sur la E-Business Suite d'Oracle, de la plateforme de conception et de gestion des produits, qui s'appuie sur un outil de PLM, et de la partie connaissance des clients et CRM ». C'est pour cette troisième activité qu'Exadata intéresse le responsable Solutions Informatiques de Redcats. « Nous exploitons des bases de données Oracle avec des outils de datamining IBM Modeler, l'ancien SPSS Clementine, et des logiciels multicanaux Neolane », précise-t-il en indiquant qu'il délivre, dans ce domaine, une prestation à laquelle les marques du groupe peuvent s'abonner. Ce service est géré de A à Z par son équipe (achat des serveurs, des systèmes de stockage et des logiciels, pilotage des équipes projets et de la mise en oeuvre).

Un Proof of Concept non influencé par Oracle

Pour déterminer l'adéquation d'Exadata avec les besoins de Redcats, Oracle France propose un test de faisabilité, un Proof of Concept (PoC) réalisé avec des partenaires. « Nous avons travaillé avec l'intégrateur Overlap dans les locaux d'Altimate qui disposait d'une machine de test ». Sur cette étape, Frédéric Ndiaye entend garder une marge de manoeuvre importante. « Je ne voulais pas être téléguidé. Dans certains PoC, on vous demande d'envoyer toutes vos requêtes à l'avance et lorsque l'on arrive, tout fonctionne bien, mais on ignore finalement s'il n'y a pas eu certains ajustements. » Oracle joue le jeu et accepte un scénario comportant une dose d'improvisation, avec des requêtes non connues.

Les tests s'effectuent sur des données sensibles qu'il faut au préalable rendre anonymes. « C'est un énorme travail que nous avons fait avec Overlap, souligne le responsable informatique. Il nous fallait des données complètement anonymes, mais qui conservent néanmoins une signification pour que le PoC ait un sens. »

Frédéric Ndiaye, Responsable Solutions Informatiques du Groupe Redcats.

[[page]]

Oracle avait proposé deux options pour le test. Celui-ci pouvait s'effectuer en Ecosse, dans un centre Oracle, sur le modèle d'appliance Exadata que Redcats voulait acquérir, le X2-2. Ou bien en France, sur une version antérieure, la V2. Mais dans le premier cas, il aurait fallu envoyer toutes les requêtes à l'avance ce qui, pour Frédéric Ndiaye, était exclu. « Je voulais vraiment bénéficier de l'effet de surprise. Nous avons donc choisi de réaliser le PoC sur l'ancien Exadata, afin de garder notre liberté de manoeuvre, plutôt que de gagner 10 à 15% de performances sur les tests car cela ne se jouait plus à cela ».

Des temps de réponse divisés par 6

Overlap a assisté l'équipe informatique de Redcats sur le chargement des données dans l'Exadata en déroulant un scénario mis au point sur le serveur de production en cours d'utilisation dans le groupe de VAD. « Nous avons ainsi pu mesurer les différences », relate Frédéric Ndiaye. « Nous avons tout comparé. Je n'avais pas trop de doutes sur la partie datawarehouse et sur les grosses requêtes car, sur ce plan, nous disposions de nombreux retours de performances de la part des clients d'Oracle déjà équipés d'Exadata. J'étais à peu près sûr d'obtenir un gain important. Nous avons néanmoins fait des requêtes de ce type pour être fixés. »

Mais c'est sur les requêtes OLTP que Redcats concentre surtout ses tests, ainsi que sur les requêtes mixtes, car il n'y avait pas beaucoup de retours clients dans ces domaines. « Nous avons, en fait, un système consolidé avec un mix de requêtes OLTP qui s'effectuent en même temps que l'exploitation du datawarehouse. C'est ce qu'il nous fallait valider. »

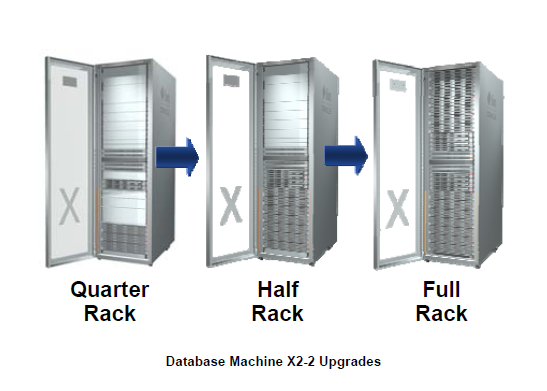

Sur l'ensemble du test, les temps de réponse ont été divisés par six en moyenne, révèle Frédéric Ndiaye. Ce qui sous-entend des mesures supérieures sur le datawarehouse, « forcément à l'avantage de l'Exadata », et des résultats un peu inférieurs sur le transactionnel. « J'ai été très attentif aux mesures de ce mix. Je voulais savoir si la base tenait le choc lorsque l'on faisait tout fonctionner en même temps. Or, plus on faisait tourner de scripts, plus la différence se creusait avec le système que nous utilisions. C'était positif. » Les montées en charge s'avéraient en outre beaucoup plus linéaires sur l'appliance d'Oracle que sur les machines de Redcats. « Pour moi, l'Exadata est une vraie machine de consolidation, estime aujourd'hui le responsable informatique. Cela signifie que vous pouvez y installer énormément d'applications et qu'elle délivre toujours à peu près la même performance ».  Les différentes configurations et possibilités d'évolution sur le modèle X2-2 de l'Exadata Database Machine (cliquer ici pour agrandir l'image). Crédit : Oracleace

Les différentes configurations et possibilités d'évolution sur le modèle X2-2 de l'Exadata Database Machine (cliquer ici pour agrandir l'image). Crédit : Oracleace

[[page]]

Datamining, ciblage et création de campagnes

Fin juin 2011, un quart de rack Exadata X2-2 est en place chez Redcats. Actuellement, une cinquantaine de personnes y accèdent pour exploiter intensivement les données. Il s'agit d'utilisateurs intervenant dans les directions marketing, répartis en deux catégories. D'une part, des dataminers qui procèdent à des requêtes intensives avec le logiciel IBM Modeler. « Ils effectuent des analyses de données sur de gros volumes et font beaucoup de ciblage avec cet outil complet qui constitue vraiment le coeur de la solution », explique Frédéric Ndiaye. D'autre part, il y a les utilisateurs des outils Neolane, comprenant différents profils, à l'origine des campagnes d'e-mailing. On trouve parmi eux des cibleurs qui font également de grosses requêtes sur les clients pour trouver les cibles. Et puis, ceux qui vont créer les campagnes, visuellement, et vont interagir avec les sites web. « Aujourd'hui, toute la communication avec les clients part de l'Exadata, résume le responsable informatique. Toutes les études, tous les ciblages, toutes les sélections, l'e-mail, le papier. »

Dataminers et cibleurs représentent la moitié des utilisateurs de l'Exadata, les équipes web constituant l'autre moitié. Tous exploitent continuellement l'appliance, sans restriction. « Nous fournissons un système et il doit tenir le choc », assène Frédéric Ndiaye.

Une capacité totale loin d'être atteinte

L'Exadata est venu remplacer des systèmes de stockage IBM, et des serveurs Power 6 et 7. Redcats a choisi le modèle quart de rack de l'appliance d'Oracle, une configuration haute performance qui lui permet de stocker au total de 6 à 7 téraoctets en mode compressé. Une capacité loin d'être atteinte. « Il y a de la place pour installer d'autres projets sur cette plateforme. Je la considère vraiment comme une machine de consolidation sur laquelle je mettrai les prochaines applications, même si elles n'ont pas besoin de cette puissance ».

La mise en place de l'appliance était avant tout destinée à apporter aux équipes marketing un environnement beaucoup plus favorable en termes de puissance de calcul. « Elles réalisent des campagnes de plus en plus ciblées et analysent donc de plus en plus de données. Il fallait changer les serveurs gérant la partie Neolane, car nous avions du mal à tenir nos engagements. Partant de là, nous nous sommes placés dans une démarche globale plutôt que ponctuelle qui aurait consisté à remplacer une machine ici ou une autre là ». Mais demain, si un projet applicatif Oracle arrive, « il ira sur l'Exadata. Ce n'est pas négociable. Dans le cas contraire, il faudrait racheter des serveurs, d'autres licences... »

Neuf millions de clients actifs pour La Redoute (ayant commandé il y a moins de deux ans). En considérant ce nombre, on imagine que même très ciblés, les e-mails envoyés représentent un volume énorme, sur lequel Redcats ne communique pas. « Nous travaillons beaucoup sur la personnalisation, nous essayons de ne pas augmenter le volume d'envoi. L'idée, c'est d'apporter de la valeur aux clients ».

[[page]]

Des économies sur l'infogérance

L'acquisition d'un système Exadata représente un investissement financier très important. Pour le modèle quart de rack de l'Exadata Database Machine X2-2, le prix communiqué par Oracle sur son site indique 330 000 dollars au 6 décembre 2011 et 39 600 dollars pour le support Premier du système. Il s'agit d'un prix catalogue, en dehors de toute négociation commerciale, mais il donne une indication sur le budget à envisager pour ce type d'acquisition (les taux de remise sur le matériel sont généralement moins élevés que sur le logiciel). Interrogé sur le coût de l'opération, le responsable informatique ne fournit pas de chiffres, tout en reconnaissant qu'il s'agit d'un projet très important. « Mais, paradoxalement, il faut tout mettre dans l'équation », tient-il à préciser. Il explique ainsi être passé par plusieurs étapes. Après avoir trouvé la solution particulièrement intéressante en la découvrant sur la conférence OpenWorld, il a rapidement jugé qu'elle était trop chère pour son budget, avant de travailler le sujet avec Oracle. « Il faut tenir compte des économies, explique-t-il. En la positionnant comme une machine de consolidation, avec les gains de fonctionnement que nous pouvions capter, nous arrivons à une équation économique qui était très bonne. Nous faisons par exemple des économies sur l'infogérance. »

Les données étant compressées, la volumétrie est moindre, ce qui réduit les sauvegardes. « Lorsque vous avez un prix au Go sauvegardé, votre facture baisse. Or, ma facture de sauvegarde était assez conséquente, la réduction porte donc sur de grosses sommes. Ensuite, ainsi que je l'ai dit, la plateforme dispose encore d'une place importante pour consolider d'autres systèmes. Economiquement, c'est une solution que je trouve rentable ».

Un projet moins ardu en partant d'un cluster

Sur le coût d'achat, les niveaux de remise accordés par Oracle sont moindres par rapport à ceux d'autres constructeurs. Quant au coût de l'intégration, il est lié à la durée du projet. Or, celui-ci, en dépit de sa complexité, fut très ramassé. « Nous avons reçu la machine et moins de deux mois plus tard, notre plus grosse base y avait été migrée par notre intégrateur, Overlap. Cela représentait pourtant un gros changement car nous n'utilisions pas de serveurs en cluster jusque-là, mais des serveurs stand alone », décrit Frédéric Ndiaye. « Or, en termes de technologies, il est beaucoup plus facile de passer à l'Exadata lorsque vous venez d'une installation en RAC [Real Application Cluster] que lorsque utilisiez des serveurs stand alone. »

La première base de données a été de loin la plus complexe à migrer car de nombreuses options y avaient été actionnées pour doper la performance. Pour les autres bases, ce fut beaucoup plus facile. En revanche, le responsable informatique insiste sur les efforts requis pour insérer l'Exadata dans l'infrastructure IT de Redcats, pour le faire communiquer avec les applications, avec les firewalls, avec le réseau, etc. Il faut passer par des liens qui n'existaient pas forcément, bien analyser l'architecture, savoir identifier ce qui manque, ce qui risque de bloquer... « Il est nécessaire de travailler avec des équipes qui comprennent l'appliance dans son ensemble. L'installation d'un Exadata ne s'improvise pas », conclut-il.

Des interfaces plus élaborées avec Netbeans 7.1, souligne Oracle

Oracle a livré hier la version 7.1 de l'environnement intégré NetBeans pour le développement d'applications web et mobiles en Java, en PHP et en C/C++. L'IDE supporte désormais entièrement JavaFX 2.0 et le JDK7, ainsi que la version 12c du serveur d'application WebLogic, compatible Java EE6, annoncée début décembre.

Oracle s'est concentré sur la mise à jour des outils et bibliothèques permettant de bâtir des interfaces utilisateurs plus élaborées, ainsi que l'a souligné le vice président Bill Pataky, responsable de la gestion de produits chez Oracle. « Il y a de nombreuses nouveautés réparties à travers l'IDE, mais l'essentiel de l'effort a porté sur l'amélioration des interfaces, à la fois sur le desktop et sur le client web ». Ainsi, pour le poste de travail, outre le support de JavaFX utilisé pour les applications RIA, NetBeans 7.1 a mis à jour le logiciel Matisse editor qui utilise maintenant la dernière version de la bibliothèque Java Swing pour concevoir des interfaces. L'IDE comprend aussi un debugger visuel pour Swing et JavaFX qui, selon Bill Pataky, améliore sensiblement l'identification de problèmes difficiles à repérer dans le code des applications pour desktop.

Du côté des clients web, l'environnement a étendu son support des bibliothèques JSF (Java Server Faces) et tire parti de la version 3 de CSS (cascading style sheets). Les développeurs web pourront accéder à des fonctions utilisées depuis longtemps pour les applications desktop (code completion, coloration de la syntaxe).

Intégration avec Git

NetBeans est l'une des nombreuses technologies acquises par Oracle lors de son rachat de Sun Microsystems début 2010. L'éditeur a continué à proposer le logiciel gratuitement et à publier le code source. C'est, avec Eclipse, IntelliJ de JetBrain et le propre JDeveloper d'Oracle, l'un des environnements principaux de développement écrits pour Java et pour d'autres langages basés sur JVM, la machine virtuelle Java. Il s'utilise sur Solaris, sur différentes distributions Linux, sur Windows et Mac OS.

Parmi les autres nouveautés figure l'intégration avec le système de contrôle de versions Git, qui permet à plusieurs développeurs de travailler sur le même programme à la fois. On peut voir les précédentes versions d'un programme à l'aide d'une interface à onglets. Le logiciel accepte aussi la gestion des branches avec Mercurial, pointe Bill Pataky, les versions expérimentales d'un programme pouvant être créées et supprimées si elles ne fonctionnent pas. Le débogage PHP a également été amélioré.

22 outils gratuits pour visualiser et analyser les données (2ème partie)

Pour faire parler des données, rien ne vaut une panoplie d'outils de visualisation graphique. Pour ceux dont le budget est limité, il existe de nombreux outils gratuitement accessibles pour visualiser les données et faire apparaître des modèles ou des tendances. Au printemps dernier, Sharon Machlis, de Computerworld, en a listé plus de vingt, qu'elle a répartis en neuf catégories : nettoyage de données, analyse statistique, outils et services de visualisation (1ère partie publiée le 3 janvier), outils de développement, SIG, analyse de données temporelles, nuages de mots, visualisation de données relationnelles (2e partie). Les bibliothèques JavaScript et les interfaces de programmation (API) s'adressent aux développeurs.

Pour relire la 1ère partie, «22 outils gratuits pour visualiser et analyser les données»

- Assistants, bibliothèques et API

Il faut quelquefois écrire du code pour produire certaines visualisations, en particulier quand le type d'affichage que l'on veut obtenir ne peut être réalisé qu'en recourant à une application desktop ou web existante. Cela ne signifie pas que l'on doive partir de rien, plusieurs bibliothèques et API fournissant déjà divers éléments.

10 - Choosel : pour enrichir les applications Google Web Toolkit

Ce framework Open Source disponible en mode web est destiné à la réalisation de graphiques sectoriels, de nuages, d'histogrammes, de diagrammes chronologiques et de cartographies. Il s'adresse davantage aux développeurs qu'aux utilisateurs. On peut néanmoins consulter une démo interactive qui explique comment importer des données en utilisant des fichiers CSV. Disponible sous licence Apache 2.0, il a trois champs d'applications principaux : l'exploration visuelle de données, les infographies interactives, la visualisation de données dans les applications GWT (le framework de développement Java Google Web Toolkit), peut-on lire sur code.google.com.

Comme avec Tableau Public, plusieurs visualisations peuvent s'afficher sur une page en étant reliées, de telle sorte que l'on peut, par exemple, mettre en valeur certaines données sur une carte en passant la souris sur un graphique associé.

Choosel (cliquer ici pour agrandir l'image)

Niveau de compétences requis : Expert.

Fonctionne à partir de Chrome, Safari et Firefox.

En savoir plus : http://code.google.com/p/choosel/

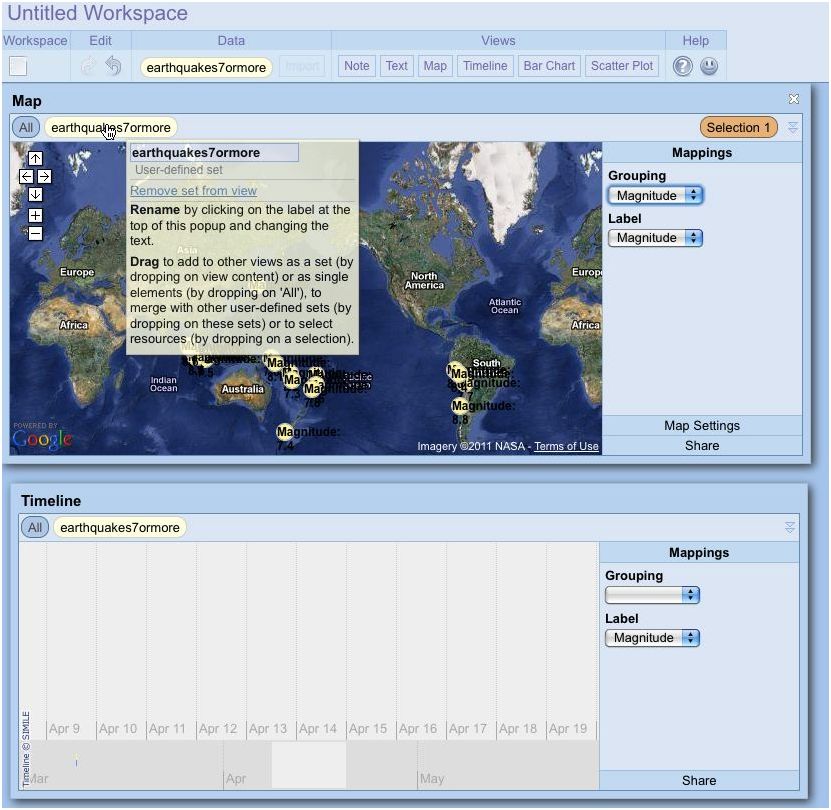

11 - Exhibit : une bibliothèque JavaScript

Issu du projet Simile conduit par le MIT, le logiciel Open Source Exhibit, sous licence BSD, permet de « créer facilement des pages web comportant des fonctionnalités de recherche et de filtrage, des cartographies interactives, des échelles chronologiques et autres visualisations », décrit le site Simile-widgets.org/exhibit. Présenté comme un framework de publication, cette bibliothèque JavaScript permet d'ajouter facilement des filtres et des recherches. Sharon Machlis, de Computerworld, fait néanmoins remarquer que ce qui est jugé « facile » par les professionnels du MIT ayant créé Exhibit peut ne pas l'être autant pour un utilisateur qui connaît surtout Excel. Comme la plupart des bibliothèques JavaScript, Exhibit requiert d'écrire davantage de lignes de code que des services tels que Many Eyes et Google Fusion Tables. Cela dit, il propose une documentation claire pour les débutants, même pour ceux qui n'ont pas d'expérience JavaScript.

Si l'écriture de code ne vous pose pas de problèmes, vous avez des chances de vous approcher au plus près des présentations que vous voulez réaliser. Et vos données restent stockées localement, sauf si vous souhaitez les publier. Pour les novices, il faudra un peu de temps pour se familiariser avec l'écriture de code et la syntaxe de la bibliothèque.

Exhibit (cliquer ici pour agrandir l'image)

Niveau de compétences requis : Expert.

En savoir plus : http://www.simile-widgets.org/exhibit/

12 - Google Chart Tools : des graphiques statiques et interactifs

Contrairement à Google Fusion Tables qui est comme une application à part entière pour stocker des données en ligner et générer graphiques et cartes, Chart Tools est conçu pour visualiser des données résidant ailleurs, par exemple sur un site web ou au sein de Google Docs. Il offre à la fois les API Chart utilisant une simple requête URL vers un serveur de graphiques Google pour créer une image statique, et l'API Visualization qui accède à une bibliothèque JavaScript pour bâtir des graphiques interactifs. Avec celle-ci, on n'échappe pas à l'écriture de code. Google donne des informations (taille des données, compétences requises...) pour déterminer quelle option retenir.

Pour les graphiques statiques les plus simples, un assistant fournit quelques exemples. Il va jusqu'à aider à saisir les données ligne par ligne, quoi qu'à partir d'une certaine taille, il est plus logique de formater celles-ci dans un fichier texte.

Google Chart Tools (cliquer ici pour agrandir l'image)

Niveau de compétences : débutant avancé et expert.

Fonctionne sur tout navigateur.

En savoir plus : http://code.google.com/apis/chart/image/docs/making_charts.html

[[page]]

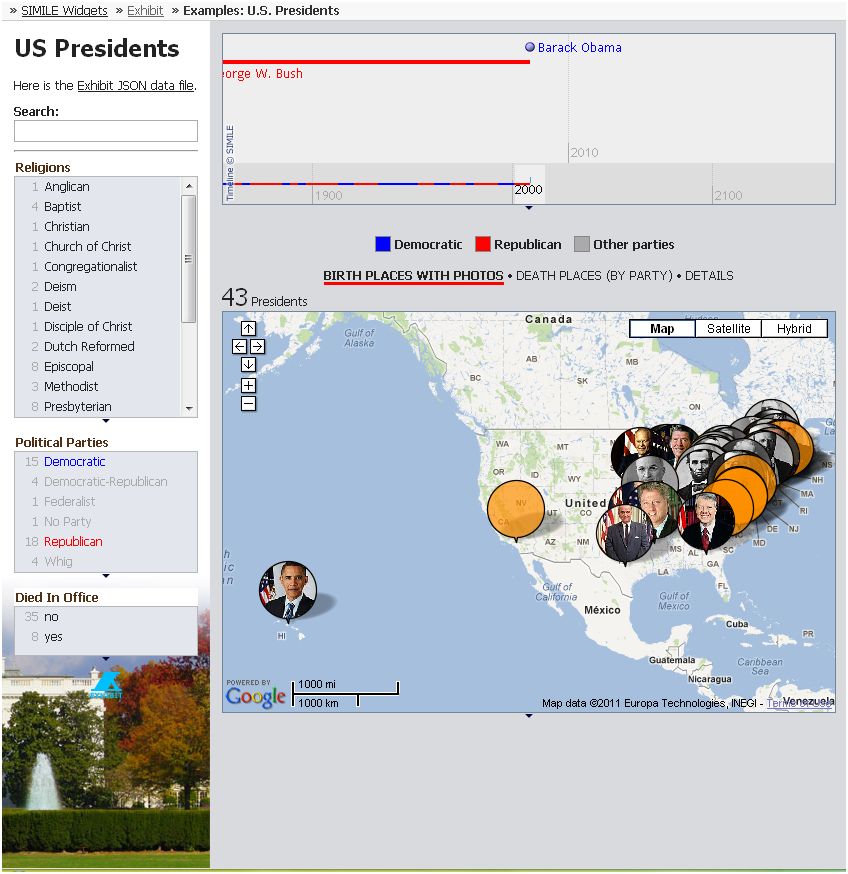

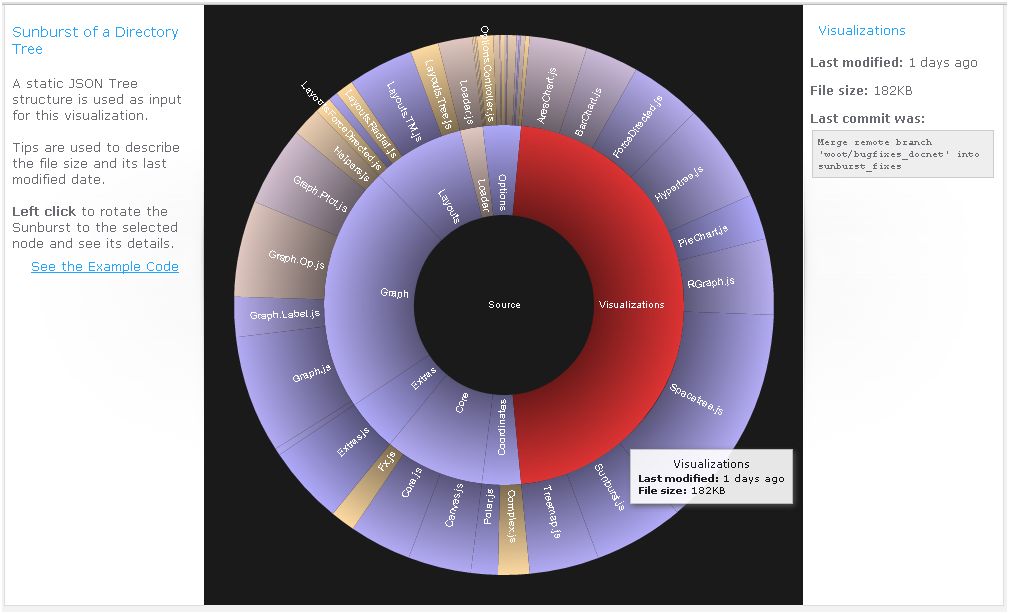

13 - JavaScript InfoVis Toolkit : de superbes graphiques

InfoVis ne compte sans doute pas parmi les bibliothèques de visualisation JavaScript les mieux connues, mais elle vaut vraiment la peine d'y jeter un oeil si vous voulez permettre la consultation de données interactive sur le web. Elle a été utilisée par la Maison Blanche pour créer le graphique présentant le budget de l'administration Obama.

Ce qui différencie cet outil des autres est l'apparence très léchée des graphiques qu'il réalise avec des exemples simples de code. Visiblement, le créateur d'InfoVis, Nicolas Garcia Belmonte, développeur senior chez Sencha Inc, s'intéresse autant à l'esthétique du dessin qu'à celle du code et ça se voit.

Les échantillons présentés sont superbes. On peut télécharger uniquement le code pour les types de visualisations que l'on veut utiliser pour réduire la taille des pages web. Attention, comme il ne s'agit pas d'une application mais d'une bibliothèque de code, il faut savoir développer pour l'utiliser. Par conséquent, cela peut ne pas convenir à des utilisateurs en entreprise qui analysent les données mais ne savent pas programmer. Par ailleurs, le choix du type de visualisation est limité. Enfin, les données doivent être au format JSON.

InfoVis Toolkit (cliquer ici pour agrandir l'image)

Niveau de compétences : expert.

Fonctionne sur les navigateurs compatibles JavaScript.

En savoir plus : démos avec code source (http://thejit.org/demos/)

14 - Protovis : une bibliothèque bien documentée

Présenté comme un toolkit graphique pour la visualisation, ce projet de l'Université de Stanford est l'une des bibliothèques JavaScript les plus populaires pour transformer les données en visuels. Une des choses les plus intéressantes à propos de cet outil est sa documentation. Celle-ci comporte de nombreux exemples des types de visualisation disponibles, incluant des cartes et quelques analyses statistiques. C'est un bon outil, permettant de construire des représentations telles qu'une carte associée à une échelle chronologique.

De la même façon qu'avec les autres bibliothèques JavaScript, il faut connaître ce langage (ou tout au moins être familier d'un autre langage). Même s'il est possible de copier, coller et modifier du code sans vraiment comprendre ce que l'on fait, il est difficile de recommander cette approche à des non-techniciens.

Protovis (cliquer ici pour l'image)

Niveau de compétences : expert.

Fonctionne sur les navigateurs compatibles JavaScript.

En savoir plus : comment démarrer avec Protovis

- Les systèmes d'information géographique sur poste de travail

Il existe de nombreuses applications pour les SIG (systèmes d'information géographique), allant de l'affichage des sites d'extraction pétrolier au choix de nouvelles implantations pour des magasins. Comme le Miami Herald l'a fait (le magazine a obtenu le prix Pulitzer pour sa couverture de l'ouragan Andrew), il est possible de comparer les vitesses maximum des bourrasques avec les dégâts constatés (pour s'apercevoir, par exemple, que les dommages les plus importants n'ont pas été subis dans les zones où le vent a été le plus fort, mais dans des endroits nouvellement construits où les constructions n'étaient pas de bonne qualité).

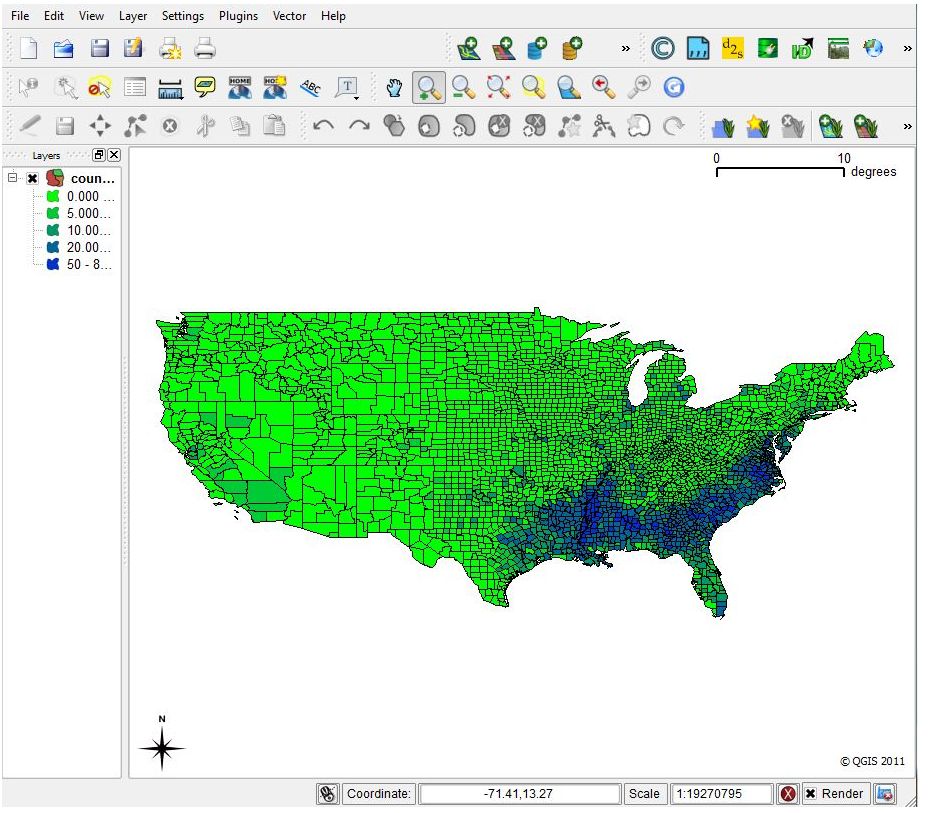

15 - Quantum GIS (QGIS) : une alternative à ArcView

C'est un SIG à part entière, conçu pour créer des cartes et qui permet des analyses de données détaillées et avancées par zones géographiques. L'application SIG desktop la plus connue est sans doute ArcView, d'Esri, qui coûte un certain prix, mais s'accompagne d'un solide support professionnel. L'alternative Open Source est QGIS, comme OpenOffice peut l'être pour Microsoft Office. A noter qu'Esri a récemment lancé une offre découverte de son SIG pour un usage privé. Les passionnés d'ArcView considèrent qu'Esri offre deux ans d'avance sur ses alternatives Open Source, que son interface est meilleure et qu'il est mieux adapté pour les impressions. De leur côté, les utilisateurs de QGIS soulignent l'excellence du produit Open Source et pointent ses performances lorsqu'il est question de générer des cartes pour le web, grâce à un plug-in spécialisé dans la génération d'images de cartes en HTML.

Quoi qu'il en soit, avec tout SIG avancé, apprendre le maniement du logiciel demande un sérieux engagement. Cela prend du temps. Certaines choses sont plus faciles à faire avec la version commerciale ArcView, a noté pour sa part Sharon Machlis, de Computerworld, qui a pris en main ArcView et QCIS. Elle explique qu'ArcView dispose d'une fonction normalisée pour calculer, par exemple, le pourcentage de personnes de 65 ans et plus au sein d'une population dans une table comportant les deux colonnes. Dans QGIS, il lui fallait appeler un champ calcul et créer une nouvelle colonne avec la formule pour l'obtenir.

Quantum GIS (cliquer ici pour agrandir l'image)

Niveau de compétences : Intermédiaire et expert.

Fonctionne sur Linux, Unix, Mac OS X et Windows. L'installation sur OS X nécessite la mise en place de plusieurs compléments.

En savoir plus : http://www.plantsciences.ucdavis.edu/plant/qgislabs.htm

On trouve d'autres solutions SIG en Open Source sur Spatialanalysisonline.com. A regarder aussi, un outil comme Post-GIS qui permet d'ajouter des objets géographiques à la base de données relationnelle PostgreSQL.

[[page]]

- Les solutions de cartographie en ligne

Certains outils de cartographie en ligne sont devenus très populaires. Celui de Google, bien sûr, qui dispose en outre de plusieurs compléments tels que Map A List, un add-on qui ajoute à une carte Google Map des données provenant d'un tableur. Il y a aussi Yahoo Maps Web Services, et Bing Maps, de Microsoft qui comportent également des API. Il en existe beaucoup d'autres venant de petites sociétés ou de contributeurs Open Source individuels : des outils, entièrement développés en partant de zéro, pour afficher des données sur des cartes géographiques.

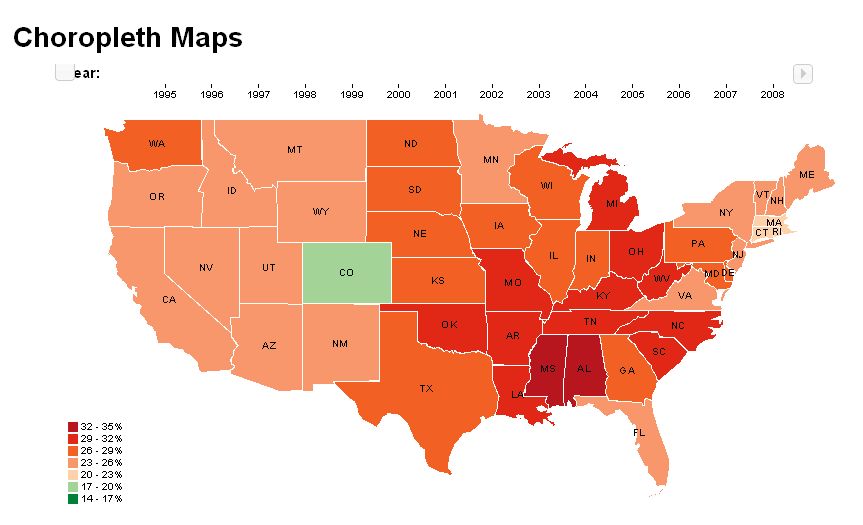

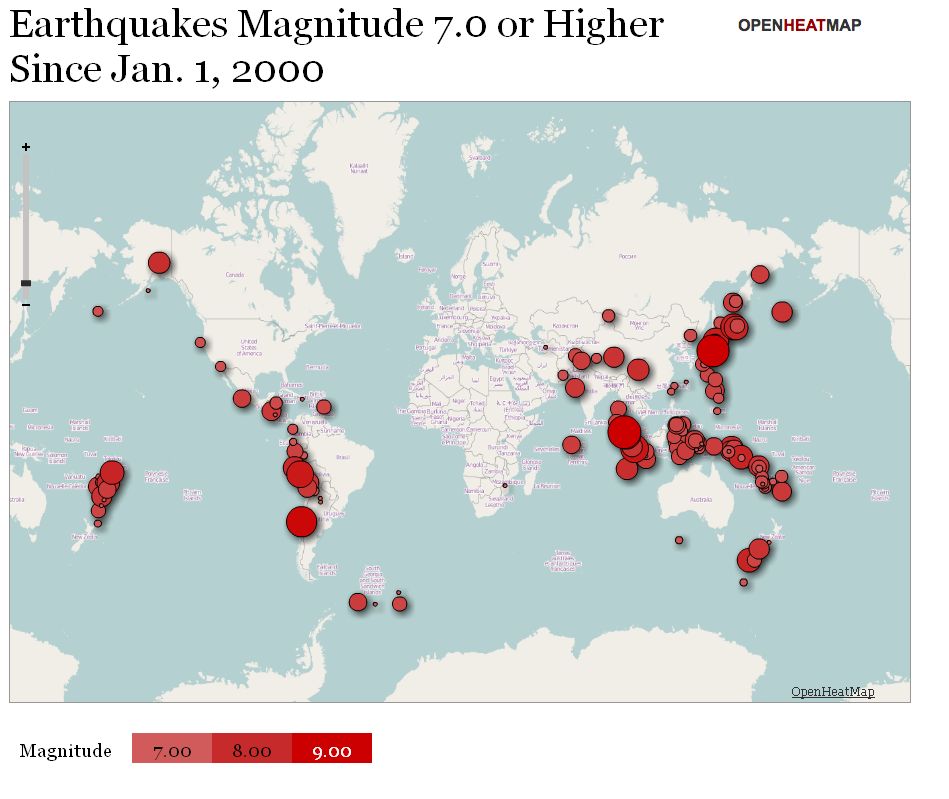

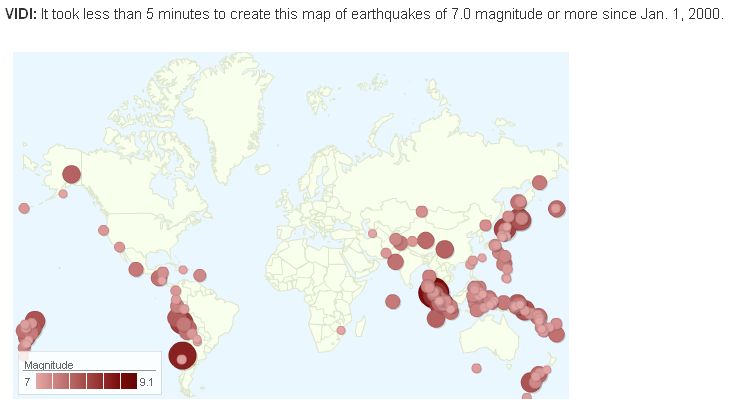

16 - OpenHeatMap : des cartes en couleurs très faciles à créer

Ce site web convivial génère des cartes dont les couleurs se modifient en fonction des informations sous-jacentes : l'évolution d'une population ou d'un revenu moyen, par exemple. On peut aussi placer sur une carte des marqueurs dont la taille varie en fonction des données qui figurent dans la table associée.

En plus de fournir ce service sur le web, son auteur Pete Warden (qui fut un temps développeur chez Apple, notamment sur Final Cut Studio) a également packagé OpenHeatMap sous la forme d'un plug-in JQuery pour ceux qui ne veulent pas dépendre de l'hébergement de OpenHeatMap.com. Toutefois, tous les formats de données ne fonctionnent pas correctement lorsqu'ils sont stockés localement. Pete Warden conseille d'intégrer les cartes depuis le site.

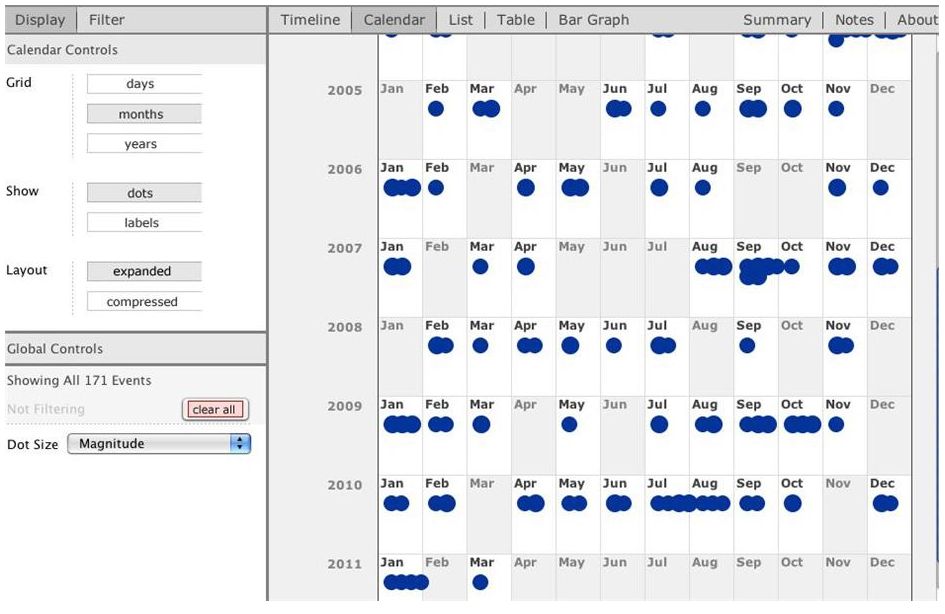

Selon Sharon Machlis, de ComputerWorld (qui a dressé cette liste il y a quelques mois), il est très facile de créer rapidement une carte en couleurs à partir de nombreuses sources de données de localisation, même des adresses IP. « Cela m'a pris environ 60 secondes pour créer une carte présentant les séismes de magnitude 7 et plus dans le monde depuis janvier 2000 », indique-t-elle dans son article (cf image ci-dessous). Les tailles, les couleurs et la transparence des marqueurs se personnalisent aisément.

Inconvénient signalés : les données ne peuvent pas être supprimées une fois mises en ligne.

OpenHeatMap (cliquer ici pour agrandir l'image)

Niveau de compétences : débutant.

Fonctionne sur les navigateurs web compatibles Flash ou HTML 5 Canvas.

En savoir plus : http://www.openheatmap.com/gallery.html

17 - OpenLayers : insérer des cartes dans des pages web

Cette bibliothèque JavaScript pour intégrer des cartes d'informations dynamiques dans des pages web. Elle fonctionne avec OpenStreetMap et d'autres services comme Google Street View. Il est destiné à apporter des fonctionnalités similaires à celles de ces bibliothèques, mais en Open Source. D'autres projets s'en servent pour ajouter des fonctionnalités ou une facilité d'utilisation. C'est le cas de GeoExt qui l'utilise pour apporter des fonctions SIG. OpenLayers peut intéresser les utilisateurs qui connaissent JavaScript et préfèrent se tourner vers une option non commerciale (plutôt que recourir à Google ou Bing).

Niveau de compétences : expert

Fonctionne sur tout navigateur web.

En savoir plus : http://openlayers.org/

Il y a d'autres bibliothèques JavaScript pour incruster des informations sur les cartes, telles que Polymaps. Il existe également d'autres plateformes de cartographies : Google Maps et ses nombreuses API, Yahoo Maps Web Services, Bing Maps et GeoCommons.

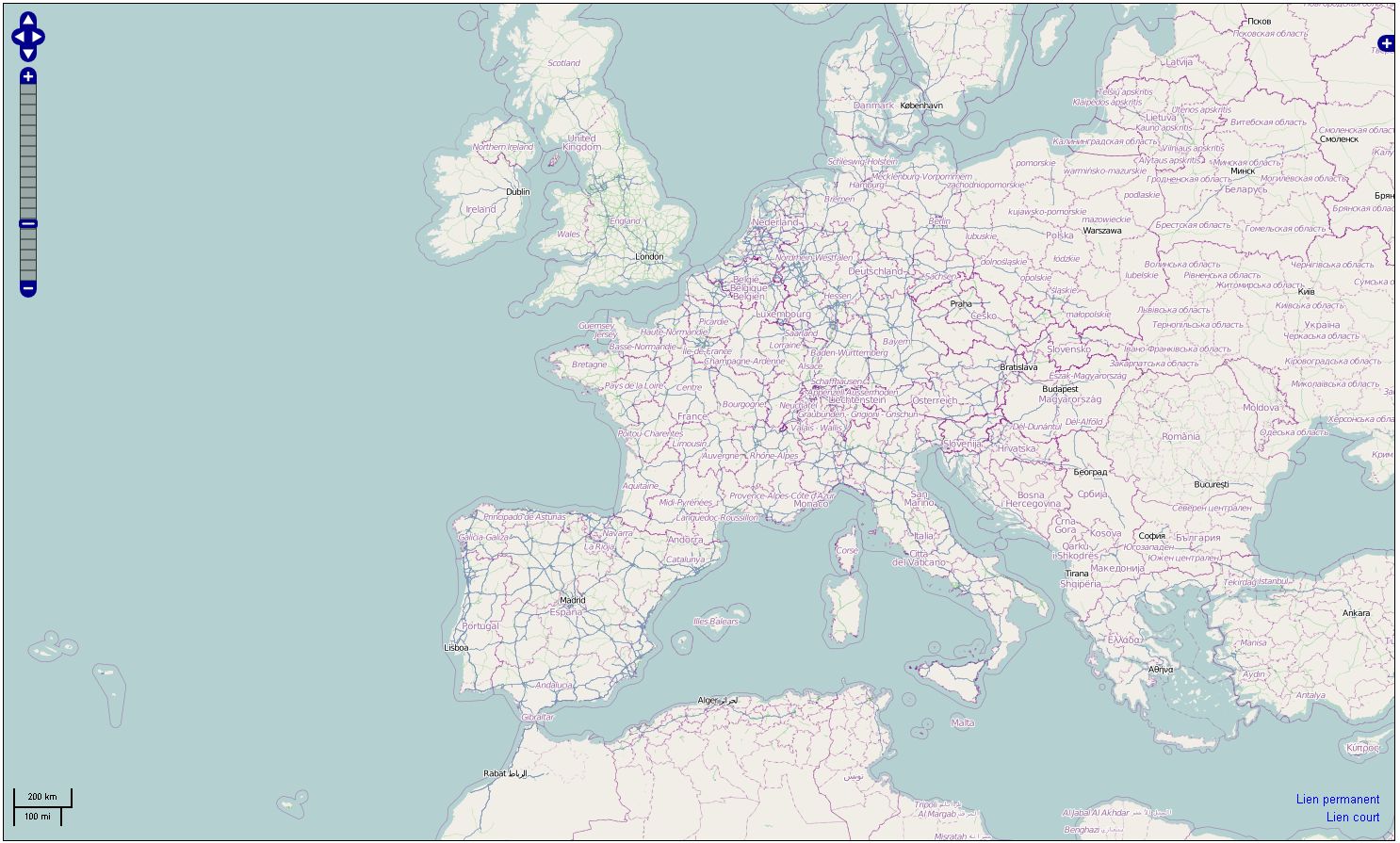

18 - OpenStreetMap : une cartographie communautaire

C'est un peu le Wikipedia de la cartographie, doté de fonctions de routes ou d'immeubles auxquelles ont contribué différents utilisateurs dans le monde. L'intérêt principal, c'est son caractère communautaire qui a débouché sur des utilisations intéressantes. Il est par exemple compatible avec la plateforme mobile Ushahidi http://www.ushahidi.com/

utilisée pour récupérer des informations après les tremblements de terre en Haïti et au Japon (alors que Ushahidi peut utiliser plusieurs fournisseurs pour les couches cartographiques, en incluant Google et Yahoo, certains créateurs de projets se sentent plus à l'aise avec des solutions en Open Source).

Inconvénients : Comme pour tout projet acceptant les contributions publiques, il peut y avoir des problèmes d'exactitude certaines fois sur les informations fournies (sur le positionnement de certains services sur les cartes, par exemple). Quoi que ce genre de choses peut arriver avec Google Maps. Par ailleurs, l'apparence des cartes est moins bonne que celles des produits commerciaux concurrents.

OpenStreetMap.org (cliquer ici pour agrandir l'image)

Niveau de compétences : débutant avancé et intermédiaire

Fonctionne sur tout navigateur web.

En savoir plus : http://www.openstreetmap.org/

http://openstreetmap.fr/

[[page]]

- Analyse de données temporelles

19 - TimeFlow : les concepteurs du projet ont rejoint Google

Ce logiciel pour poste de travail a été développé pour analyser des données ayant une composante temporelle. Ses créateurs, Fernanda Viégas et Martin Wattenberg (tous deux se trouvant derrière le projet Many Eyes d'IBM) ont créé la société Flowing Media, un studio de visualisation spécialisé sur les groupes médias et les projets grand public http://hint.fm/about/. Ils ont rejoint Google en 2010 pour diriger son groupe de visualisation de données Big Picture.

TimeFlow (cliquer ici pour agrandir l'image)

En savoir plus : https://github.com/FlowingMedia/TimeFlow/wiki

- Les nuages de mots et de textes

Certaines spécialistes de la visualisation de données n'aiment guère ces nuages qui affichent les mots d'un fichier texte en faisant varier leur taille en fonction du nombre de fois où ils figurent dans le fichier. Ils ne les trouvent pas sérieux ou jugent qu'ils ont été trop utilisés. Ceux qui veulent néanmoins y recourir peuvent se tourner vers trois outils.

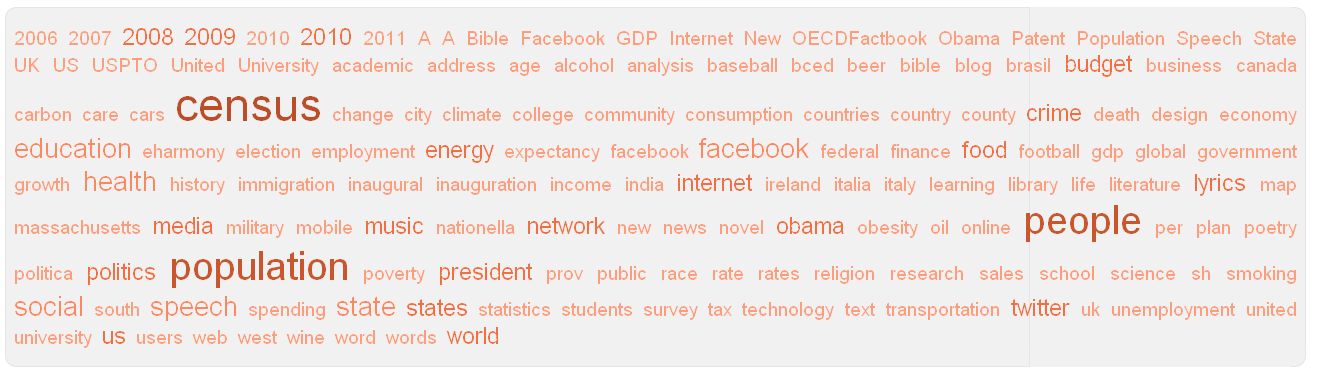

20 - IBM Word Cloud Generator : dans Many Eyes

Plusieurs des outils déjà cités dans la liste établie par Computerworld permettent de créer des nuages de mots. C'est le cas de l'API Visualization de Google et de Many Eyes où l'on trouve Word-Cloud Generator. On peut aussi le faire avec Wordle http://www.wordle.net/ (un outil pratique pour créer ces nuages à partir de sites web plutôt que de fichiers texte).

Word Cloud Generator dans Many Eyes (cliquer ici pour agrandir l'image)

- Outils d'analyse de réseaux sociaux

Ces outils se réfèrent à la définition SNA (social network analysis) pré-Facebook/Twitter. Ils servent à rechercher des liens entre des individus en s'appuyant sur différents jeux de données. Il est nécessaire d'avoir des notions de statistiques pour les utiliser.

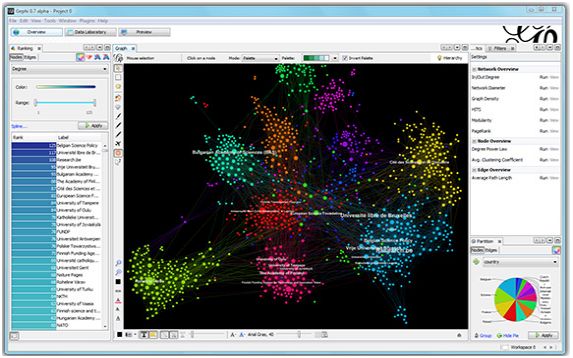

21 - Gephi : pour établir des relations dans un réseau complexe

Présenté comme un Photoshop pour les données. Ce projet Open Source est conçu pour visualiser des informations statistiques, incluant des relations au sein de réseaux de type graphe comptant jusqu'à 50 000 noeuds et un demi-million de connexions, de même que l'analyse de facteurs tels que l'intermédiarité, la proximité auxquels s'ajoute un coefficient d'agglomération.

Gephi (cliquer ici pour agrandir l'image)

Fonctionne sur Windows, Linux, Mac OS X avec Java 1.6

En savoir plus : http://gephi.org/

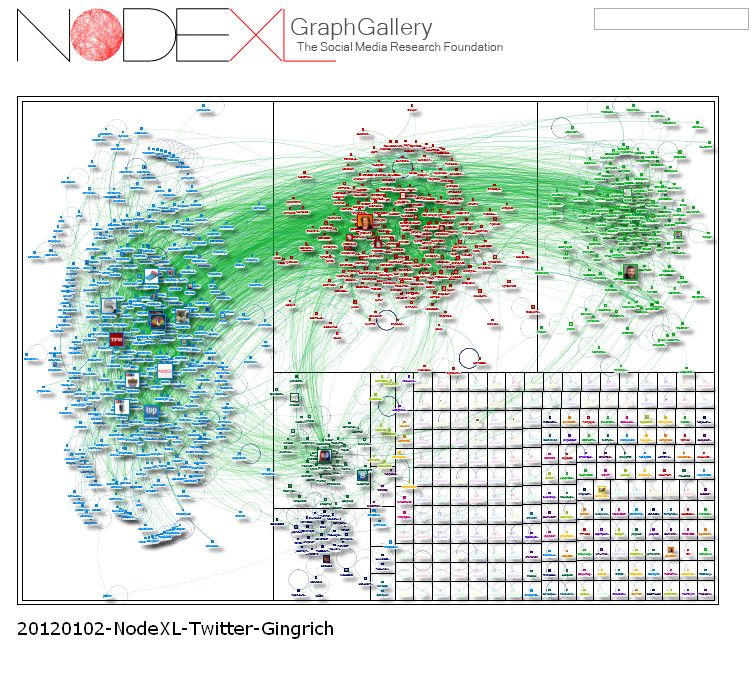

22 - NodeXL : plug-in pour Excel pour explorer Twitter et Flickr

Ce plug-in pour Excel affiche des graphes de réseaux à partir d'une liste de connexions, afin d'aider à dégager des modèles et des liens entre les données. NodeXL combine l'ancienne et l'actuelle définition de SNA. Il est optimisé pour analyser les médias sociaux en ligne. Il intègre notamment des connexions pour appeler les API de Twitter, Flickr et YouTube, ce qui permet de dessiner des réseaux d'utilisateurs et leurs activités, explique Peter Aldhous, responsable du bureau de San Francisco du magazine New Scientist.

NodeXL (cliquer ici pour agrandir l'image)

Fonctionne sur Excel 2007 et 2010 sur Windows.

En savoir plus : http://nodexl.codeplex.com/

IBM acquiert Green Hat, spécialiste de logiciel de tests

Pour renforcer son offre d'outils de test, IBM vient de racheter Green Hat. Cette dernière propose une plateforme virtuelle de tests. Elle donne aux développeurs les moyens de tester les applications sans avoir besoin de configurer physiquement des environnements de tests. Cela permet d'économiser du temps et de l'argent souligne IBM. Le constructeur ajoute que les cycles de développement sont devenus plus rapides avec l'essor des smartphones et des tablettes.

Les produits de Green Hat seront intégrés au sein de la division Rational d' IBM, qui offre déjà plusieurs logiciels et outils de tests. Alors quel est le sens de ce rachat, « je pense que Green Hat va étendre les capacités actuelles de Rational Quality Manager », déclare Jeffrey Hammond analyste chez Forrester Research et de mentionner à titre d'exemple « le support de Netweaver de SAP et Fusion Middleware d'Oracle ». Le site de Green Hat rajoute dans la liste les middleware de Tibco, Software AG et Progress Software, etc. Jeffrey Hammond précise « le support des tests sur les services REST (Representational State Transfer) apportera une valeur ajoutée pour Rational. Avec l'augmentation des services web basés sur XML et JSON, nous constatons que de plus en plus d'entreprises construisent des plateformes de tests pour s'assurer de la fonctionnalité des API ».

Facebook lance sa 3ème Hacker Cup

Pour mettre au défi les programmeurs dans le monde, Facebook a lancé son concours Hacker Cup. C'est la troisième édition de cette compétition un peu particulière. « Le hacking est au coeur de notre façon de développer sur Facebook », a écrit David Alves, ingénieur chez Facebook, sur le blog annonçant le concours. Les sociétés reposant sur des ingénieurs sont « toujours à la recherche de solutions de type hacking pour résoudre les problèmes », a-t-il dit.

Facebook se sert de la définition originale de «hacker», se référant non pas à quelqu'un qui s'introduit illégalement dans les systèmes informatiques, mais plutôt à une personne qui « aime explorer en détail les programmes et essaye d'étendre leurs capacités », pour emprunter la définition publiée par la bible du jargon informatique, le dictionnaire anglo-saxon The Jargon File.

Les quatre premières manches du concours se dérouleront en ligne, à partir du 28 janvier. Les 25 finalistes seront invités au siège de Facebook pour une dernière épreuve le 27 mars prochain. Le gagnant repartira avec 5 000 dollars, et les trois autres finalistes recevront aussi une récompense pécuniaire. Le concours se compose d'une série successive de problèmes algorithmiques de plus en plus difficiles. La notation sera basée sur la précision et la rapidité des développeurs à résoudre les casse-têtes.

Des casse-têtes très geek

L'année dernière, les principaux défis portaient sur la détermination du nombre optimal de générateurs de boucliers et de guerriers Protoss qu'un joueur devait construire au jeu Starcraft II et l'estimation de la meilleure stratégie de course dans un jeu de voitures avec un nombre variable de concurrents, tout en gérant la probabilité d'accidents. Pour chaque problème, les participants reçoivent un ensemble de données et une explication du problème. Ils ont ensuite six minutes pour proposer une réponse, avec le code source utilisé pour résoudre le problème. Les participants peuvent recourir à n'importe quel langage de programmation, ainsi que des bibliothèques de code et même des programmes complets, comme un tableur.

L'année dernière, la Hacker Cup a connu un démarrage difficile. Sur le site de réseautage social Quora, certains candidats s'étaient plaints que les procédures du concours étaient confuses et parfois contradictoires. Pour cette nouvelle édition, le géant des réseaux sociaux a revu les processus pour améliorer la première sélection.

(...)(03/01/2012 16:55:03)22 outils gratuits pour visualiser et analyser les données (1ère partie)

Pour faire parler des données, rien ne vaut une panoplie d'outils de visualisation graphique. Il en existe de nombreux, notamment destinés aux professionnels versés dans l'analyse statistique. Mais leur prix, généralement élevé, ne convient pas aux utilisateurs moins spécialisés qui n'ont besoin qu'occasionnellement d'afficher des données sous une forme graphique. Or, il existe, pour ceux dont le budget est limité, un nombre surprenant d'outils très intéressants pour la visualisation et l'analyse de données, accessibles gratuitement. Au printemps dernier, Sharon Machlis, de Computerworld, en a listé plus de vingt, qu'elle a répartis en neuf catégories : nettoyage de données, analyse statistique, outils et services de visualisation (1ère partie), outils de développement, SIG, analyse de données temporelles, nuages de mots, visualisation de données relationnelles (2ème partie publiée le 5 janvier). Ils permettent de manipuler les données et de les afficher à travers de multiples représentations graphiques. Particulièrement utiles pour faire apparaître des modèles ou des tendances. La plupart d'entre eux avaient été présentés lors de la conférence Computer-Assisted Reporting (la prochaine conférence CAR aura lieu du 23 au 26 février 2012, à Saint-Louis, Missouri).

- Nettoyage de données

Avant toute analyse ou visualisation, les données ont souvent besoin d'être nettoyées, afin de standardiser leur transcription ou de corriger des fautes. Dans une même base, les noms de ville ou de clients, par exemple, peuvent être avoir été saisis de différentes façons (Net York, New York City, NY..., Société Lambda, Lambda, Sté Lambda, Lambda Sarl...). On trouve deux outils destinés à cet usage : DataWrangler et Google Refine.

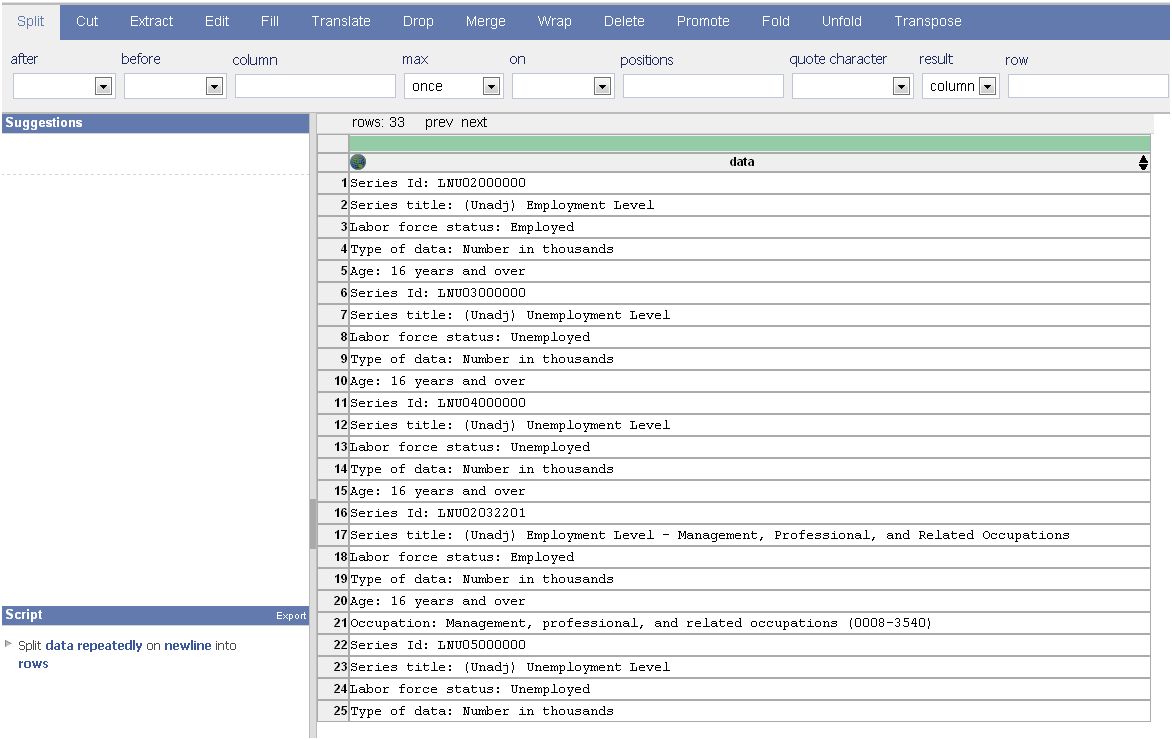

1 - DataWrangler : uniquement en ligne

Ce service web du groupe Visualization de l'Université de Stanford est conçu pour nettoyer et réarranger les données sous une forme pouvant être reconnues par d'autres logiciels : les tableurs, mais aussi un langage tel que « R », ou des logiciels commerciaux comme Tableau ou Open Source comme Protovis. En cliquant sur une ligne ou une colonne, cet outil va suggérer des modifications. Par exemple, il proposera de supprimer les lignes vides. Il conserve l'historique qui facilite un retour en arrière (undo), une fonctionnalité également disponible dans Google Refine).

Computerworld souligne que la correction des textes se fait simplement. En revanche, le service étant disponible en ligne (à partir de tout navigateur), cela implique que les données transitent vers un site externe, ce qui le rend inapproprié pour des informations internes sensibles. Une version « poste de travail » est prévue. Autre élément important, l'outil est toujours en cours de développement.

DataWrangler (cliquer ici pour agrandir l'image)

Niveau de compétences requis : débutant avancé.

Fonctionne sur tout navigateur web.

En savoir plus : http://vis.stanford.edu/wrangler/

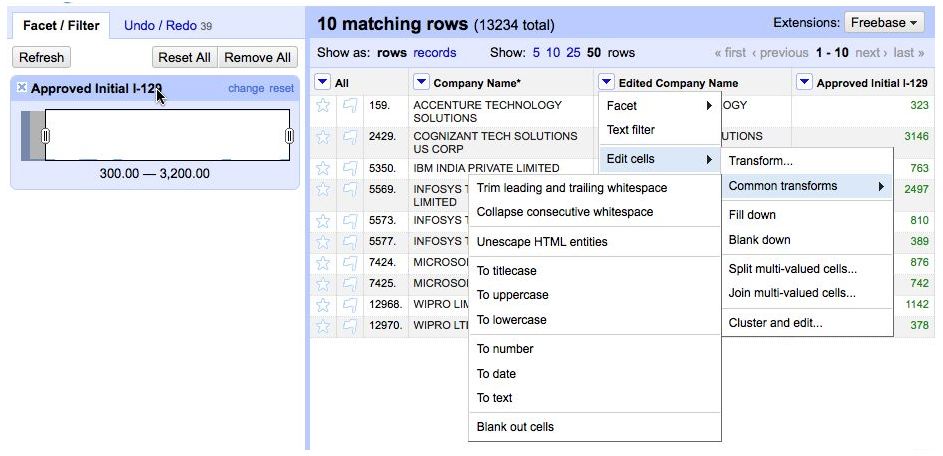

2 - Google Refine : comme un tableur

Il ressemble à un tableur pour examiner à la fois les données numériques et alphanumériques, mais à l'inverse du tableur, il ne permet pas d'effectuer des calculs. Comme Excel, il peut importer et exporter dans différents formats, incluant les fichiers tabulés, textes, Excel, XML et JSON.

Refine intègre plusieurs algorithmes retrouvant les mots orthographiés différemment mais qui devraient en fait être regroupés. Il y a aussi des options pour passer rapidement en revue les données numériques. Ces fonctionnalités peuvent pointer des anomalies pouvant résulter d'erreurs de saisie, telles que 800 000 dollars à la place de 80 000 dollars pour un salaire par exemple, ou mettre à jour d'autres incohérences. Inconvénient, si le jeu de données est volumineux, son examen peut prendre un certain temps. A noter que Refine propose aussi des outils de tri et de filtre.

Google Refine (cliquer ici pour agrandir l'image)

Niveau de compétences requis : débutant avancé. La connaissance des concepts d'analyse de données est plus importante que la prouesse technique. Les utilisateurs avancés d'Excel qui ont l'habitude du nettoyage de données devraient être à l'aise avec cet outil.

Google Refine fonctionne sur Windows, Mac OS X et Linux.

En savoir plus : http://code.google.com/p/google-refine/ [[page]]

- Analyse statistique

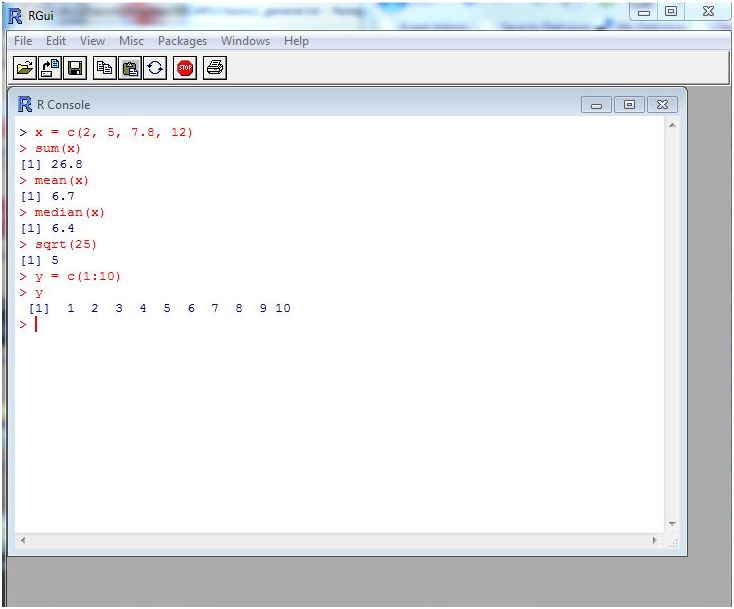

3 - Le projet R : un langage pour l'univers des statistiques

Projet GNU similaire au langage S, développé par les Laboratoires Bell (anciennement AT&T, désormais Lucent Technologies) par le statisticien John Chambers. Il peut être considéré comme une mise en oeuvre différente de S, même s'il y a d'importantes différences, une grande partie du code écrit pour S fonctionnant de la même façon sous R, explique-t-on sur le site du projet. Il compile et fonctionne sur de nombreuses plateformes Unix, ainsi que sous Windows et MacOS. S'il s'agit de déterminer des moyennes, des valeurs médianes, des écarts types ou des corrélations, R peut le faire et bien plus encore, en incluant les modèles linéaires, les modèles de régression non linéaires, l'analyse des séries chronologiques, les tests paramétriques et non paramétriques, les classifications, le lissage, indique encore le site web. « R » fournit aussi nombre de représentations graphiques, ainsi que des capacités d'analyse spatiale, et se complète de nombreux add-ons.

Inconvénient, l'environnement utilise des lignes de commandes, ce qui nécessite un minimum d'apprentissage pour connaître les commandes à mettre en oeuvre. Pour les utilisateurs qui souhaitent disposer d'une interface graphique, Peter Aldhous, du bureau de San Francisco du magazine New Scientist, suggère RExcel qui propose d'accéder au moteur de R à partir d'Excel. On peut rencontrer une autre limite avec les jeux de données trop importants. Pour la franchir, il existe une option commerciale de la plateforme, fournie par Revolution Analytics.

L'environnement R (cliquer ici pour agrandir l'image)

Niveau de compétences : intermédiaire ou avancé. La connaissance des statistiques facilite la prise en main.

R fonctionne sur Linux, Mac OS X, Unix, Windows XP et ultérieurs.

En savoir plus : le projet R

Premiers pas avec R, de Peter Aldhous

- Outils et services de visualisation

Ces outils offrent différentes options de visualisation. Certains se cantonnent aux graphiques conventionnels (représentations sectorielles, histogrammes...), mais la plupart proposent un éventail de choix supplémentaires tels que les Treemap pour afficher les données hiérarchisées ou les nuages de mots. Quelques-uns disposent aussi de représentations géographiques. Dans ce domaine, il existe toutefois des logiciels gratuits spécifiques.

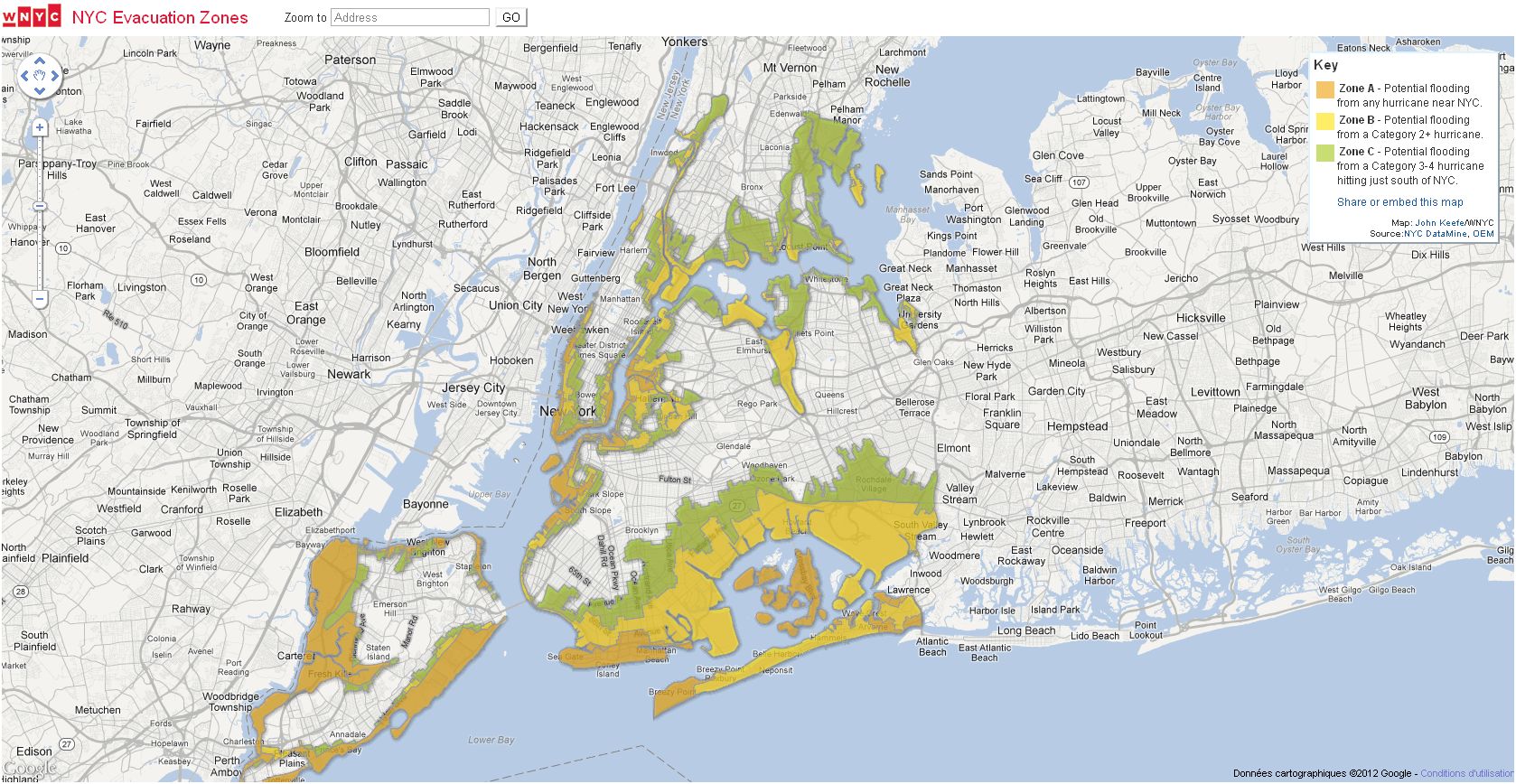

4 - Google Fusion Tables : simple à utiliser et personnalisable

C'est l'une des plus simples façons de transformer des données en graphiques. On met en ligne son fichier (dans différents formats) et on choisit comment l'afficher : sous forme de tableau, de carte, de bargraphe, de camembert, de « heat map », de diagramme de dispersion, d'historique, d'animation... C'est assez personnalisable. Il est notamment possible de changer les icônes des cartes et le style des fenêtres d'information. Fusion Tables comporte aussi des fonctions d'édition de données, quoi que cela devient vite fastidieux dès que l'on commence à devoir modifier au-delà que quelques cellules. On peut aussi faire des jointures de table (important quand les données à afficher se trouvent dans différentes tables), filtrer, trier, ajouter des colonnes et commenter les données.

Un exemple d'utilisation de Fusion Tables (source WNYC)

Niveau de compétences : débutant.

S'utilise avec tout navigateur web.

En savoir plus : Google Fusion Tables

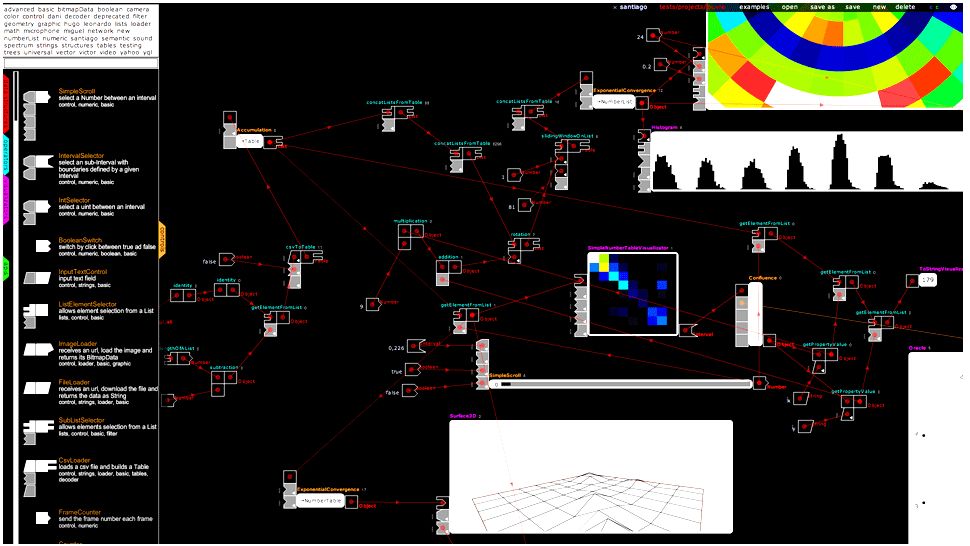

5 - Impure : un peu comme un Yahoo Pipes

Impure est une sorte de « Yahoo Pipes » adapté à la visualisation de données, conçu pour créer de nombreux types de représentations graphiques très peaufinées en utilisant un espace de travail de type « drag and drop ». Le service inclut une bibliothèque d'objets et de méthodes. Et, comme avec Yahoo Pipes, il permet de cliquer et déplacer pour connecter des modules de façon à ce que les « sorties » (output) de l'une deviennent les « entrées » (input) d'une autre. L'outil a été développé par la société d'analyse espagnole Bestiario.

Impure présente l'intérêt d'offrir une interface très visuelle pour préparer les représentations graphiques, ce qui n'est pas aussi fréquent qu'on pourrait s'y attendre. Il offre une interface élégante et de nombreux modules, dont quelques API (interfaces de programmation) destinées à extraire des données du Web.

On peut chercher par mots-clés (numeric, tables, nodes, geometry, map) ses nombreux types de visualisation. Et bien qu'il sauvegarde votre espace de travail sur le Web, il est possible de copier et conserver le code localement, afin de sauvegarder son travail et de mettre à jour ses propres bibliothèques de code.

Attention, les utilisateurs d'Impure devront faire un effort d'apprentissage malgré les fonctionnalités drag and drop. La documentation est quelquefois détaillée, mais pas toujours. Une fois que l'espace de travail est sauvegardé, il devient public sur le web, bien qu'il soit difficile de le retrouver sans l'URL.

Impure (cliquer ici pour agrandir l'image)

Niveau de compétences : intermédiaire.

Fonctionne sur tout navigateur.

En savoir plus : sur Impure

[[page]]

6 - Many Eyes : facile d'accès et bien documenté

Le projet Many Eyes d'IBM est l'un des pionniers de la visualisation de données sur le web. Il est très facile à utiliser et très bien documenté, incluant des suggestions sur le type de représentations qu'il convient d'utiliser suivant les cas. Many Eyes comprend plus d'une douzaine d'options de rendu, depuis les graphiques sectoriels, jusqu'aux nuages de mots, en passant par les treemaps, les diagrammes relationnels, plots, ainsi que quelques cartes géographiques.

Il faudra ouvrir un compte gratuit pour mettre ses données en ligne. Le formatage est basique : pour la plupart des visualisations, les données doivent être dans un fichier texte avec séparation par tabulateurs, comportant des têtes de colonnes sur la première ligne. Les résultats offerts apparaissent bien plus sophistiqués que ce que l'on aurait pu attendre au regard des efforts déployés pour les créer. La liste de visualisations possible s'accompagne d'explications pour déterminer celles qui sont les plus appropriées suivant le contexte.

Inconvénient : vos jeux de données apparaissent publiquement sur le site Many Eyes et peuvent être facilement téléchargées, partagées, republiées et commentées par d'autres, ainsi que le projet soutenu par IBM encourage à le faire. Autre limite : la personnalisation est limitée, de même que la taille du fichier, qui ne peut pas dépasser 5 Mo.

Many Eyes (cliquer ici pour agrandir l'image)

Niveau de compétences : débutants.

Fonctionne sur les navigateurs Java et ceux pouvant afficher en Flash.

En savoir plus : sur Many Eyes

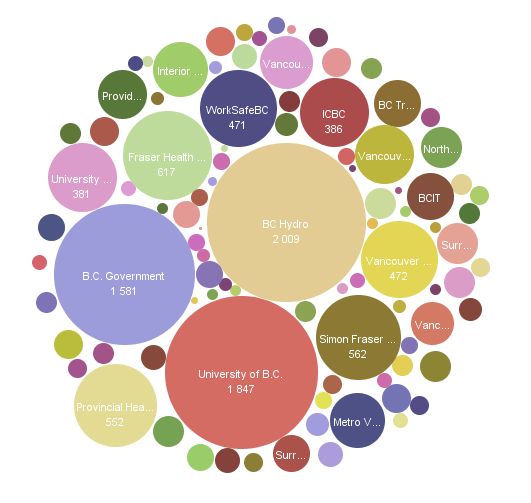

7 - Tableau Public : personnalisable et interactif

Transforme les données en diverses visualisations, simples ou plus complexes. Les champs peuvent être glissés/déplacés sur l'espace de travail et le logiciel peut alors suggérer un type de visualisation, puis personnaliser tous les éléments : étiquettes, infobulles, taille, filtres interactifs, légendes... L'un des intérêts de l'outil réside dans les différentes façons d'afficher des données interactives sur lesquelles un filtre de recherche peut agir sur de nombreux graphiques, diagrammes et cartes. Les tables sous-jacentes peuvent également être jointes. Et une fois que vous savez comment fonctionne le logiciel, le maniement de son interface « drag and drop » se fait bien plus rapidement que de coder en JavaScript ou en R. Ce qui incite à essayer davantage de scénarios avec les données. En outre, on peut facilement effectuer des calculs sur les données au sein du logiciel.

Dans cette version gratuite du logiciel de BI de Tableau Software, les données doivent résider sur le site de Tableau. La mise à jour vers la version desktop coûte environ 1 000 dollars. Par ailleurs, sans surprise, les fonctionnalités gratuites ont malgré tout un coût : le temps d'apprentissage comparé à, par exemple, Fusion Tables. Même avec l'interface drag and drop, cela prend plus d'une heure ou deux pour savoir se servir du logiciel, à moins de réaliser d'abord des graphiques simples.

Tableau Public (cliquer ici pour agrandir l'image)

Niveau de compétences : débutant avancé ou intermédiaire.

Fonctionne sur Windows 7, Vista, XP, 2003, Server 2008 et 2003.

En savoir plus : quelques vidéos de formation

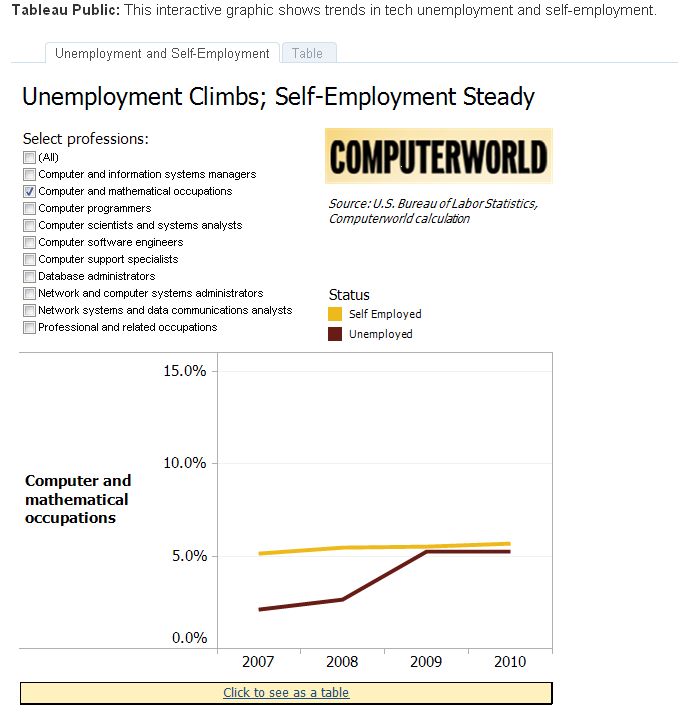

8 - VIDI : des graphiques exportables en HTML

Quoi que le site VIDI le présente comme un outil pour le système de gestion de contenus Drupal, les graphiques créés par l'assistant de visualisation du site peuvent être utilisés sur n'importe quelle page HTML sans recourir à Drupal. Une fois les données en ligne, on sélectionne le type de visualisation retenu, on personnalise un peu et le graphique est prêt à être utilisé via un code embarqué auto-généré (utilisant une balise iframe, pas de JavaScript, ni de Flash).

C'est à peu près aussi facile que Many Eyes, avec davantage d'options cartographiques et sans être obligé de rendre ses données publiques. Quelques écrans fournissent rapidement des explications sur chaque type de représentation graphique et on accède à différentes couleurs de personnalisation. La taille limite des fichiers monte à 30 Mo, soit six fois plus qu'avec Many Eyes.

VIDI, source Computerworld (cliquer ici pour agrandir l'image)

Niveau de compétences : débutants.

Fonctionne avec tout navigateur web.

En savoir plus : http://www.dataviz.org/

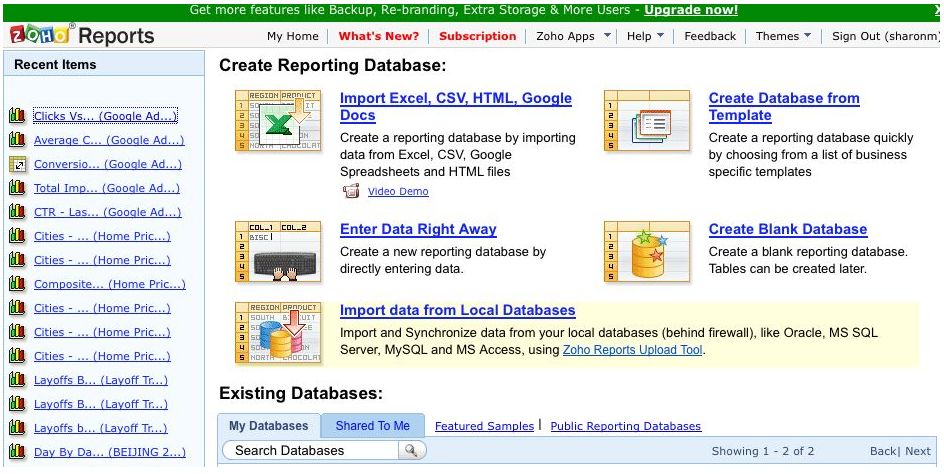

9 - Zoho Reports : pour les analyses métiers

L'un des plus orienté « analyse métier » de sa catégorie. Zoho Reports peut récupérer les données venant de différents formats de fichiers ou directement d'une base de données et les transformer en graphiques sectoriels, tableaux et tables pivots, autant de formats familiers aux utilisateurs de tableurs.

Il présente l'intérêt de pouvoir programmer des importations de données depuis des sources provenant du web. On peut faire des requêtes sur les données en utilisant SQL et les transformer en représentations graphiques. Le service permet de faire de la publication web et du partage. Il faudra toutefois disposer d'un compte payant si plus de deux utilisateurs doivent accéder aux données.

Inconvénient : les options de visualisation sont limitées. L'interaction de données avec le web peut être lente quelquefois. La taille des fichiers est limitée à 10 Mo.

Zoho Reports (cliquer ici pour agrandir l'image)

Niveau de compétences : débutants avancés.

Fonctionne sur tout navigateur.

En savoir plus : http://reports.zoho.com/ZDBSampleDatabases.cc

Pour lire la 2ème partie « 22 outils gratuits pour visualiser et analyser les données »

Cinq technologies Open Source pour 2012 (1ère partie)

L'année prochaine, si tout se passe comme prévu, Red Hat deviendra le premier éditeur Open Source à générer plus d'un milliard de dollars de chiffre d'affaires annuel. Cela constituera un tournant pour le monde de l'Open Source qui a longtemps considéré son approche du développement « communautaire » comme une alternative viable, voire supérieure, aux notions traditionnelles régissant l'écriture de logiciels. Jim Whitehurst, PDG de Red Hat, estime que l'on assiste à un changement fondamental sur l'origine de l'innovation. Pour lui, celle-ci est passée des laboratoires de quelques éditeurs vers l'Open Source où se déploient des efforts considérables.

De fait, l'Open Source a bousculé le monde du logiciel propriétaire ces dernières années, à mesure que Linux, le serveur web Apache, ou encore Perl, OpenOffice, Hadoop, GIMP et des dizaines d'autres programmes empiétaient sur le terrain de leurs équivalents commerciaux. Mais quels seront les poids lourds de demain ? Voici cinq projets à regarder de près en 2012. Ils pourraient constituer une base pour de nouvelles activités. Ou tout au moins séduire les développeurs et administrateurs en facilitant les façons de faire, ou en réduisant les coûts.

1 - Nginx, serveur web pour les sites à fort trafic :

Sur la décennie écoulée, le choix du serveur web a été relativement stable. On trouvait Apache sur la majorité d'entre eux tandis qu'Internet Information Services (IIS, ex Internet Information Server), de Microsoft, était à l'oeuvre sur les autres. Toutefois, au cours des dernières années, une troisième option est apparue avec Nginx (prononcez « engine-x »), en raison de la capacité de ce dernier à contrôler des trafics importants.

Nginx gère déjà 50 millions de noms de domaines, soit 10% de la totalité d'Internet, selon les estimations de ses développeurs. Il est particulièrement utilisé sur les sites web à fort trafic, tels que Facebook, Zappos, Groupon, Hulu, Dropbox et WordPress. Son créateur, Igor Sysoev, l'a conçu en 2004 pour gérer un grand nombre d'utilisateurs simultanés, jusqu'à 10 000 connexions par serveur. Son architecture est assez réduite, selon Andrew Alexeev, co-fondateur de la société, qui propose une version commerciale du produit.

L'année qui s'annonce devrait être bonne pour Nginx qui a récupéré 3 millions de dollars de différentes sociétés de capital risque, l'une d'elles étant soutenue par Michael Dell, le PDG de Dell. L'éditeur de Nginx a noué un partenariat pour fournir son serveur dans le package de Jet-Stream, un acteur de la diffusion de contenus (content delivery network). Il travaille aussi avec Amazon pour adapter son logiciel au service de cloud AWS.

En dehors du recours à Nginx dans les opérations web de grande ampleur, Andrew Alexeev voit l'utilisation de son serveur sur le marché du cloud computing et des services partagés. « C'est là où nous pourrons apporter le plus de bénéfice », estime-t-il en indiquant que la prochaine version importante, attendue en 2012, sera plus flexible pour les environnements d'hébergement partagés. Il précise qu'elle affrontera mieux les attaques distribuées en déni de services (DDoS) et comportera des fonctions de sécurité supplémentaires.

OpenStack, page 2

Stig, page 3

2e partie : Linux Mint et GlusterFS

[[page]]

2 - Le projet de cloud OpenStack :

Le projet OpenStack est arrivé relativement tard dans la sphère du cloud computing, mais il a apporté une fonctionnalité indispensable : l'extensibilité. « Nous ne parlons pas ici de gérer un cloud de 100 ou 1 000 serveurs, mais des dizaines de milliers de serveurs », explique Jonathan Bryce, qui préside le bureau du projet. Selon lui, les autres choix actuellement disponibles ne prennent pas véritablement en compte cette échelle.

Depuis son lancement en juillet 2010, OpenStack a rapidement gagné de nombreux soutiens de la part d'acteurs IT intéressés par le cloud, comme Hewlett-Packard, Intel et Dell. Les inconditionnels de cette brique IaaS (Infrastructure as a service) aiment à présenter leur travail comme le projet Open Source au développement le plus rapide, avec l'implication de plus de 140 entreprises et de 2 100 participants. Sous le nom de Dell OpenStack Cloud Solution, le Texan a lancé un package qui l'associe à ses serveurs et logiciels. HP a également lancé, en bêta, un service de cloud public utilisant cette technologie.

Le noyau de traitement d'OpenStack a été développé au centre de recherche Ames de la NASA, pour les besoins d'un cloud interne destiné à stocker de très importants volumes d'imagerie spatiale. A l'origine, les administrateurs de la NASA ont essayé d'utiliser la plateforme Eucalyptus, mais ils ont rencontré des limites à dimensionner le logiciel aux échelles requises, selon Chris Kemp, qui supervisa le développement du contrôleur de cloud OpenStack lorsqu'il était directeur informatique de NASA Ames.

Pour favoriser une plus large adoption, OpenStack a été complété d'autres fonctionnalités afin d'être mieux accepté par les entreprises, explique John Engates, directeur technique de l'hébergeur Rackspace. L'un des projets, appelé Keystone, permettra par exemple aux entreprises d'intégrer OpenStack avec leurs systèmes de gestion des identités, basés sur Active Directory, de Microsoft, ou sur d'autres annuaires LDAP. De la même façon, les développeurs travaillent aussi sur un portail pour les logiciels. Rackspace, qui a d'abord collaboré avec la NASA pour packager OpenStack pour un usage général, poursuit par ailleurs le projet de façon séparé et indépendante, en espérant constituer ainsi une option attractive pour davantage de fournisseurs de cloud.

« 2011 a été l'année de construction pour la base du produit, mais je pense que 2012 sera celle où nous commencerons vraiment à utiliser cette base pour de nombreux clouds publics et privés », estime le directeur technique de Rackspace.

Nginx, page 1

Stig, page 3

2e partie : Linux Mint et GlusterFS

[[page]]

3 - Stig, une base de données orientée graphe

Au cours de l'année écoulée, le recours à des bases de données non relationnelles s'est développé de façon importante, avec des solutions comme Cassandra, MongoDB, CouchDB et bien d'autres encore. Toutefois, lors de la conférence NoSQL Now, en août, il fut beaucoup question d'une base qui n'était pas encore disponible : Stig. Avec un peu de chance, on devrait la voir en 2012.

Stig est spécialement conçue pour prendre en charge les traitements liés aux sites de médias sociaux, expliquent ceux qui y travaillent. Elle a été créée au sein du réseau social Tagged par le développeur Jason Lucas. Celui-ci présente sa technologie comme une base de données distribuée orientée graphe. Elle a vocation à supporter les applications web de type social qui sont fortement interactives. L'architecture de stockage des données permet d'effectuer des recherches déductives, à travers lesquelles les utilisateurs et les applications peuvent prendre en compte les connexions entre des éléments d'information disparates. Parce qu'elle a été écrite, en partie, avec le langage de programmation fonctionnel Haskell, elle peut répartir facilement sa charge de travail entre plusieurs serveurs.

La base Stig reste encore un peu mystérieuse, puisqu'elle n'est pas sortie. Mais les observateurs prédisent qu'elle pourrait jouer un rôle dans les réseaux sociaux et les applications qui exploitent une large étendue de données. Par nature, les besoins des services liés aux réseaux sociaux sont différents d'autres catégories de traitements et ils tireraient profit d'une base qui leur soit ajustée, explique Jason Lucas. « Dans ce domaine, vous ne pouvez pas apporter de réponse pertinente si votre service n'est pas capable de s'étendre à l'échelle planétaire ».

Stig fonctionne actuellement sur un serveur au sein du réseau social Tagged, mais la société pense étendre son utilisation jusqu'à en faire sa seule base de données. Au départ, les développeurs prévoyaient une sortie en décembre, mais celle-ci a été repoussée à 2012. « Ce que j'ai pu en voir m'a semblé très intéressant », a indiqué Dan McCreary, un architecte en solutions sémantiques pour la société de conseil Kelly-McCreary & Associates. Il a apprécié l'architecture basée sur un langage fonctionnel qui devrait faciliter le déploiement de la base de données à travers plusieurs serveurs.

Nginx, page 1

OpenStack, page 2

2e partie : Linux Mint et GlusterFS

| < Les 10 documents précédents | Les 10 documents suivants > |