Flux RSS

HPC

138 documents trouvés, affichage des résultats 51 à 60.

| < Les 10 documents précédents | Les 10 documents suivants > |

(03/03/2011 10:42:50)

La haute densité va se renforcer dans les datacenters selon le Gartner

Le Gartner estime qu'une zone à haute densité nécessite une énergie supérieure à 10 kW par rack. Or, les datacenter construits depuis cinq ans ont été conçus pour distribuer 2 kilowatts (kW) à 4 kW par rack. Avec l'utilisation croissante des systèmes de lame haute densité, l'énergie des datacenter n'est plus suffisante pour équilibrer la puissance et les exigences de refroidissement des différents équipements informatiques (serveurs, stockage et mise en réseau des boîtes) réunis dans un même centre de données physiques.

Une zone de haute densité nécessite effectivement des refroidissements supplémentaires. Rakesh Kumar, vice-président recherche chez Gartner, souligne que si le bâtiment du datacenter n'évolue pas dans le temps, tous les systèmes informatiques à l'intérieur ne cessent de le faire. C'est l'équilibrage entre tous ces changements qui fait la complexité du sujet. Garner conseille doncaux entreprises de développer une zone à forte densité suffisamment grande pour accueillir des capacités supplémentaires, normalement de 20 à 25 pour cent de l'espace plancher.

Toutefois, les utilisateurs restent encore sceptiques note le Gartner. Ils restent incertains sur la possibilité d'obtenir une flexibilité dans la prévision des capacités nécessaires et sur les pièges potentiels de la haute densité. «Les zones à haute densité sont de loin la meilleure façon de gérer les différences dans les changements du cycle de vie des structures des bâtiments des centres de données, leurs équipements électromécaniques et autres », a pourtant souligné Rakesh Kumar.

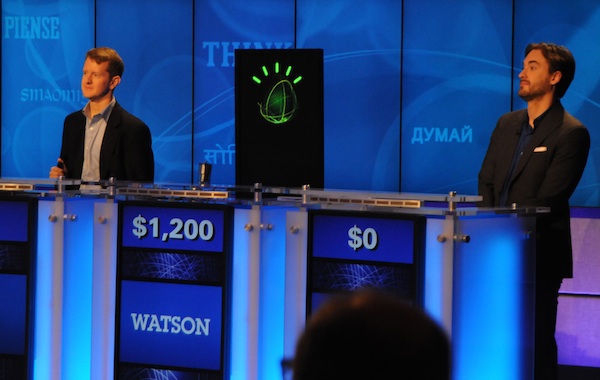

Le superordinateur Watson d'IBM a imposé sa loi à Jeopardy

Au total des deux parties, Watson a amassé un total de 77 147 dollars, comparativement à 24 000 dollars pour Ken Jennings et 21 600 dollars pour Brad Rutter. Ken Jennings détient le record du plus grand nombre de parties consécutives gagnées à Jeopardy, soit 74. Ses gains à vie se chiffrent à 2,5 millions de dollars. Brad Rutter détient quant à lui le record des gains à l'émission, soit 3,2 millions de dollars.

L'usine d'IBM Canada à Bromont a grandement contribué à cette victoire, puisque c'est à cet endroit que sont conçus de nombreux composants des 90 serveurs P750 utilisés dans la conception de Watson. Chacun de ces serveurs coûte environ 300 000 dollars. « Nous ressentons surtout une grande fierté. Ce fut très serré hier soir (mercredi), mais nous avons pu l'emporter, ce qui nous permettra de remettre la bourse du vainqueur (1 million de dollars américains) à des oeuvres de charité », raconte le directeur en chef d'IBM Bromont, Raymond Leduc, en entrevue.

Plus qu'une contribution matérielle, l'usine a également joué un rôle stratégique dans la mise au point de Watson: « Nous avons également participé au développement de la stratégie de vérification électrique et contribué à solutionner les défis thermiques liés à l'intégration de puces d'aussi grande puissance afin qu'elles offrent des performances sans faille dans les serveurs », explique Éric Paradis, spécialiste consultant en technologies de l'information chez IBM Canada à l'usine de Bromont.

Tout le monde a pu voir Watson en action

Pendant la deuxième portion de la première partie (mardi soir) et pendant la finale de mercredi, l'usine de Bromont a fonctionné à 50 % de sa capacité pour permettre à tous les employés de regarder les exploits de Watson en direct. « Nous avons divisé l'équipe en deux et tout le monde a pu voir Watson en action », précise Raymond Leduc.

Ce dernier affirme qu'IBM vise à présent d'autres applications pour son superordinateur, notamment au niveau médical. « L'ordinateur peut aider les médecins avec leurs diagnostics dans des cas très complexes. À ce niveau, nous discutons déjà avec le Columbia University Medical Center et avec l'University of Maryland School of Medicine », dit-il.

M. Leduc ajoute que les possibilités sont infinies avec Watson, qui pourrait également prendre en charge la planification des systèmes routiers des municipalités afin de mieux gérer les problèmes de circulation, ou même aider des clients avec leur service à la clientèle... « C'est très motivant car ça représente un futur très prometteur pour l'usine d'IBM Bromont », affirme-t-il.

IBM a choisi de remettre la bourse de 1 million de dollars aux organismes de charité Vision Mondiale et au World Community Grid. Ken Jennings et Brad Rutter ont reçu respectivement 300 000 dollars et 200 000 dollars pour leur participation à l'affrontement.

Denis Lalonde est rédacteur en chef du magazine canadien Direction informatique (publié à Montréal). (...)

Annuels Bull : la croissance s'est accélérée au 2e semestre

(Mise à jour) Deux mois après avoir présenté sa stratégie BullWay, avec laquelle il affiche l'ambition de devenir, en trois ans, l'un des leaders européens des systèmes numériques critiques, Bull présente des résultats intéressants sur son exercice 2010. Son chiffre d'affaires a progressé de 12% à 1,24 milliard d'euros, à taux de change et périmètre courants par rapport à 2009 (+2,7% en organique, c'est-à-dire à taux de change et périmètre constants d'une année sur l'autre). Après un premier semestre en retrait, la croissance a repris au troisième trimestre (+4,1%) pour s'accélérer sur le quatrième (+11,6%). Sur l'année, les prises de commande se sont élevées à 1,31 milliard d'euros, soit une augmentation de 11,4% par rapport à l'an dernier (+3,7% en organique). En considérant séparément chaque catégorie d'activités de Bull, John Selman souligne que les solutions matérielles, produits traditionnels du constructeur, ont montré une croissance de 11% et une bonne dynamique commerciale au 2e semestre (le book-to-bill est de 1,04 et la marge brute est stable). L'offre HPC, « cruciale pour l'avenir de Bull » est désormais la plus importante. Elle a représenté 150 millions d'euros en 2010, ce qui représente une progression de 50%. Parmi les références de l'année, le groupe cite, pour son offre bullx, le Tera 100 mis en place au CEA, mais aussi Genci et Awe. Sur bullion, Xerox et sur novascale gcos, la CNAF. gcos, encore bon pied bon oeil

« L'entreprise est mobilisée pour progresser », a commenté le PDG de Bull, Philippe Vannier, en faisant référence au programme BullWay dont l'organisation est en cours de déploiement. Il a également rappelé qu'un audit du groupe avait été réalisé avant l'été. Ces derniers mois ont donc constitué « une période assez particulière où l'on a pu tester la volonté des équipes à assurer cette transformation. » Et la période allant de juillet 2010 à l'été 2011 s'annonce comme une année de transition. Un plan d'embauche d'un millier de personnes(*) est prévu, la moitié des recrutements concernant la France, l'autre moitié devant s'effectuer à l'international.

L'offre HPC, cruciale pour l'avenir de Bull

La trésorerie opérationnelle de Bull à l'issue de 2010 est jugée satisfaisante par le PDG et son directeur financier, John Selman. Elle permet de couvrir les besoins non récurrents et les éventuelles acquisitions ciblées si des opportunités, notamment technologiques, se présentaient. Quant au bénéfice net « toujours insuffisant » selon le directeur financier, il a certes été multiplié par 4,6 en un an, à 6,5 M€, mais en partant d'un résultat net 2009 qui « n'était pas très élevé ».

A noter que l'activité liée à l'environnement gcos a cessé de décliner, a signalé Philippe Vannier en réponse à une question de l'assistance lors de la conférence de presse des résultats. Son chiffre d'affaires s'est établi à 60 M€ environ. « Ces serveurs ont comme atout leur extrême fiabilité. Nous avons pris des commandes de systèmes en 2010 et nous allons en chercher de nouvelles. Chaque année, cette activité baisse moins vite que prévu. Il va y avoir un plateau que j'espère à 40 M€ -et que nous souhaitons compenser par d'autres ventes ailleurs- mais pas en 2011. »

Excellentes performances pour l'activité Services...

MAJ (*) En tenant compte des départs, l'effectif devrait augmenter de 500 à 600 personnes. Aucun plan de départs n'est prévu, ceux-ci devraient se faire de manière plus individuelle.

[[page]]

Léger tassement pour l'activité Maintenance (-1,3%), mais avec une petite hausse des commandes (+0,5%) et une marge brute de 27,6%. L'activité Services & Solutions a, en revanche, enregistré « d'excellentes performances, à contre courant du marché », ne manque pas de souligner John Selman. La progression s'élève à 3,8% alors que Syntec numérique a fait état de 1% de croissance sur le marché des logiciels et services en 2010. La marge brute n'a pas augmenté autant que Bull l'aurait souhaité, notamment en raison de provisions que le groupe avait placées sur certains projets difficiles.

Bull mise sur les appliances DLP d'Amesys en 2011

Enfin, sur l'activité Securité et systèmes critiques, Bull annonce un chiffre d'affaires de 89 M€ et des prises de commandes de 90 M€ avec une marge brute à méthode constante de 29%. Dans ce domaine, des affaires ont été décalées, probablement sur 2011, espèrent les dirigeants. A cela s'ajoute par ailleurs l'offre de sécurité Data Leakage Prevention d'Amesys qui va être lancée. Ce produit de prévention des pertes des données permet une analyse en temps réel des données dans une appliance Bull. Trois gros clients français ont accepté d'être des partenaires de lancement de cette offre. Ce sont des machines assez conséquentes « sur lesquelles nous fondons certains espoirs », a confié le PDG.

Objectif : 700 M€ à l'international en 2013, soit 50% du CA

D'ici à 2013, Bull s'est fixé un objectif de chiffre d'affaires situé entre 1,35 et 1,45 milliard d'euros et un bénéfice avant impôt et taxes (EBIT) entre 50 et 60 M€. A cet horizon, le groupe souhaite réaliser 50% de son chiffre d'affaires à l'international, sans diminuer la partie réalisée en France. Aujourd'hui, le ratio est de 55% pour la France. « C'est un gros challenge », reconnaît Philippe Vannier qui rappelle que cela correspond, à terme, à environ 700 M€ d'un côté et de l'autre, soit 1,4 M€ au total. Mais le PDG semble confiant. « Notre position d'acteurs de niche [associant une offre d'infrastructures de puissance et des applications de sécurité] nous met dans une position favorable face à nos concurrents, ajoute-t-il Philippe Vannier. Comment, notamment, envisager le cloud sans solutions de sécurité ».

(...)

Dell introduit un serveur avec 96 coeurs Opteron

Le PowerEdge C6145 est l'un des serveurs les plus rapides jamais mis en place par la société, a déclaré Armando Acosta, chef produit PowerEdge-C chez Dell. Cette machine de type HPC (calculs hautes performances), comprend en effet deux noeuds serveurs de quatre sockets pouvant accueillir un maximum de huit processeurs AMD Opteron série 6100 avec 12 coeurs chacun. Soit 96 coeurs au total dans un châssis 2U !

Si ce serveur a été conçu pour exécuter des applications scientifiques ou mathématiques, il peut également être utilisé pour animer des plates-formes cloud et des environnements informatiques hautement virtualisés, précise Armando Acosta. Un châssis externe avec plusieurs processeurs graphiques peut également être connecté au serveur principal pour travailler sur des applications telles que le rendu vidéo.

Un marché en pleine croissance

Il y a une demande croissante des clients pour plus de performances dans des serveurs qui consomment moins, a déclaré Tim Carroll, responsable mondial de l'activité informatique de recherche chez Dell. Des plafonds en consommation électrique ont été édictés pour les bâtiments écoresponsables, afin d'inciter les utilisateurs à rechercher les économies partout et notamment dans leur salle informatique. Dell collabore avec les fournisseurs de composants pour répondre à ces besoins en puissance et en performances tout en diminuant la consommation électrique de ses systèmes. Avec ce serveur HPC, la compagnie texane propose par exemple des barrettes mémoire Samsung de faible puissance et des puces AMD Opteron intégrant plus de coeurs que les processeurs Intel Xeon, plafonnant aujourd'hui à 8 coeurs. Pour l'instant, Dell ne proposera pas ce serveur avec des puces Intel, a ajouté Armando Acosta.

Les clients sont également à la recherche de solutions permettant d'ajouter des puces graphiques aux côtés de processeurs pour créer des clusters de puissance dédiés à certaines applications, précise encore le responsable de Dell. Les serveurs équipés de GPU apportent plus de puissance brute et consomment davantage d'énergie, mais ils permettent également de réduire le nombre de machines dans un datacenter. C'est une piste déjà exploitée sur les supercalculateurs (voir lien) et de plus en plus utilisée dans les centres de calcul.

Mieux conjuguer CPU et GPU

Dell travaille ainsi avec ses clients pour mettre en place des bancs d'essai dans lesquels la puissance de calcul en parallèle des CPU et des GPU pourra être parfaitement regroupée, souligne Tim Carroll. Les clients peuvent utiliser des outils de programmation parallèle, comme Cuda de Nvidia ou la technologie OpenCL du consortium Khronos Group pour écrire leurs applications. La plate-forme Cuda est l'option la plus populaire en ce moment, indique Tim Carroll.

Basé sur le châssis du C6105 présenté en septembre dernier et qui peut accueillir jusqu'à 48 coeurs de processeurs AMD dans un boîtier 2U, le C6145 supporte jusqu'à 1 To de mémoire avec un maximum de 96 coeurs de processeurs. Les dimensions du serveur sont de 44,8 centimètres (17,6 pouces) en largeur et de 79 cm (31,1 pouces) en profondeur. Comme AMD l'a précédemment annoncé, ce serveur est "socket compatible" avec la prochaine génération de puces Interlagos reposant sur l'architecture Bulldozer. Les processeurs Interlagos, qui succéderont donc fin 2011 aux Magny-Cours actuels, incluront jusqu'à 16 coeurs par processeur. Un châssis C410X externe avec des slots PCI-Express peut également être connecté au C6145 pour ajouter jusqu'à 32 processeurs graphiques. Le serveur est livré avec Suse Novell, Red Hat Enterprise Linux 5.5, Windows Server 2008 R2 ou Windows HPC Server 2008. Les responsables de Dell ont également précisé qu'ils avaient préféré AMD à Intel pour baisser le prix du serveur. Le C6145 est proposé à partir de 18 000 $ et sera disponible à partir du 28 février en France.

Un rachat pour quoi faire ?

Cette annonce intervient également alors que circule une rumeur de rachat d'AMD par Dell portée par le blog de l'analyste financier Tiernan Ray, hébergé par le site du Barron's du groupe Wall Street Journal. Valorisé à 6,1 milliards environ, AMD n'est pas une cible évidente pour le Texan et on ne comprend pas bien quelle synergie pourrait en résulter. Dell travaillant principalement avec Intel pour la fourniture des composants nécessaires à ses PC, serveurs et contrôleurs. On se souvient également que Dell travaille depuis peu avec AMD (2006). Pendant près de 20 ans, le Texan avait refusé d'intégrer les circuits d'AMD sur ses machines...

(...)(16/02/2011 10:03:49)Le supercomputer Watson d'IBM défie les candidats du jeu Jeopardy (MAJ)

En 1997, IBM avait fait une percée avec Deep Blue, qui était parvenu à vaincre le champion mondial d'échecs Gary Gasparov. En 2011, la société revient à la charge avec un autre ordinateur, Watson, nommé en l'honneur du fondateur d'IBM, Thomas J. Watson.

Cette fois-ci, l'ordinateur se mesurera aux deux plus grands gagnants de l'histoire de Jeopardy, soit Ken Jennings et Brad Rutter. Ken Jennings détient le record du plus grand nombre de parties consécutives gagnées à Jeopardy, soit 74. Ses gains à vie se chiffrent à 2,5 millions de dollars. Brad Rutter détient quant à lui le record des gains à l'émission, soit 3,2 millions de dollars.

Ken Jennings et Brad Rutter, les deux lauréats du jeu Jeopardy

Autopsie d'un superordinateur

Le Watson est particulièrement impressionnant. Cet ordinateur est composé de 10 racks contenant chacun 9 serveurs Power 750 montés en réseau. Chaque serveur, dont la valeur se chiffre à environ 300 000 dollars, possède 32 coeurs qui peuvent gérer un total de 128 tâches en parallèle. L'ordinateur dans son ensemble compte 2 880 coeurs, peut effectuer 11 520 tâches en parallèle, possède une mémoire vive de 15 000 gigaoctets (Go) et une puissance totale de 80 téraflops. Selon les dirigeants d'IBM, ces performances placent Watson dans le Top 100 des ordinateurs les plus puissants au monde en ce moment.

À titre comparatif, Deep-Blue avait une puissance totale de 1 téraflop et celle de la salle des serveurs de l'usine d'IBM Canada à Bromont frôle les 4 téraflops. Pour chaque téraflop de puissance, un ordinateur peut effectuer mille milliards d'opérations à la seconde.

Une intelligence artificielle de plus en plus fine

Si le matériel qui compose Watson est imposant, le vrai défi pour l'équipe d'IBM fut tout autre qu'avec Deep Blue, selon Éric Paradis, spécialiste consultant en technologies de l'information chez IBM Canada à l'usine de Bromont. « En matière de logiciel, les échecs, c'est relativement simple. Avec Deep Blue, en 1997, il s'agissait surtout d'un exploit matériel. Il s'agit d'une planche de 64 cases avec des règles et des pièces qui ont toutes un rôle limité. L'algorithme était assez simple: à chaque coup, il fallait prévoir le prochain mouvement de l'adversaire et ensuite établir quel serait le meilleur mouvement à partir de toutes les combinaisons possibles », dit-il.

Dans le cas de Watson, le défi est de traiter le langage naturel. L'ordinateur est équipé d'une série d'algorithmes qui ont nécessité plusieurs années de recherche et même certains partenariats avec des universités. M. Paradis précise que contrairement à la croyance populaire, Watson n'entend pas et ne peut donc reconnaître la voix. Il reçoit les questions en texte, de même que les réponses de ses concurrents. À défaut d'entendre, il doit donc comprendre les questions : « Les questions de Jeopardy peuvent contenir des jeux de mots, des farces, des doubles sens... Par exemple, si vous cherchez Mercury dans un moteur de recherche Internet, vous pouvez obtenir des résultats sur un métal, sur une planète, sur une vieille marque de voitures et même sur le chanteur Freddy Mercury. Un seul mot peut donc avoir différents sens, ce qui rend le défi de la compréhension très complexe », dit-il.

Entretien réalisé par Denis Lalonde, rédacteur en chef du magazine Direction informatique.

[[page]]

A défaut d'Internet, une base de connaissance interne

De plus, Watson n'a pas accès à Internet. Il contient l'équivalent de 200 millions de pages de contenus, structurés (anatomie, atlas géographiques...) et non structurés (tels que journaux, documents historiques, scénarios de films...). Il est également doté de connaissances élémentaires logiques, par exemple que la pluie est mouillée, qu'un père est toujours plus vieux que son fils et que quelqu'un qui est décédé ne peut revenir à la vie. Les questions à Jeopardy peuvent toucher à une multitude de catégories, allant du sport à l'histoire et à la littérature, en passant par la géographie, ce qui nécessite des connaissances générales très poussées. « Un algorithme très important est aussi celui de l'acquisition et de l'indexation dynamique de connaissances. Cela signifie que Watson s'améliore avec l'usage », affirme M. Paradis, rencontré à Bromont quelques jours avant l'affrontement entre la machine et l'homme.

L'ordinateur possède également la capacité de s'adapter à une catégorie. Si, à un moment durant l'émission, on recherche uniquement des noms de joueurs de hockey et que Watson ne l'a pas réalisé au début, il peut faire l'ajustement pour répondre aux questions restantes dans cette catégorie précise. Comme les mauvaises réponses à Jeopardy font perdre des points, Watson doit également autoévaluer le degré de confiance en ses réponses.

Préparer l'après-Jeopardy

Évidemment, l'objectif ultime derrière la conception de Watson est de réaliser une percée au niveau de l'intelligence artificielle qui permettrait à IBM de vendre des clones de son superordinateur pour divers types d'applications commerciales, industrielles ou publiques.

Éric Paradis explique que Watson pourrait par exemple servir de référence au niveau médical. « L'ordinateur, avec ses algorithmes et son architecture, pourrait contenir l'ensemble de la littérature médicale et tirer des conclusions à partir de symptômes, de résultats et de tous les outils à la disposition des médecins. Ces derniers ont accès à des connaissances phénoménales, mais qui ne sont pas toujours organisées. Le système pourrait alors intervenir », dit-il. C'est pourquoi IBM tient à ce que Watson soit capable d'évaluer lui-même sa capacité à donner de bonnes réponses. Dans le cas d'un diagnostic médical, la marge d'erreur est nulle.

Un match en deux manches

Après la première manche, Watson et Brad Rutter ont terminé à égalité avec 5 000 dollars chacun, alors que Ken Jennings a remporté seulement 2 000 dollars. Et lors de la seconde et dernière manche, Watson a pris le pas sur ses deux adversaires : le supercomputer d'IBM a remporté des gains d'un montant de 35 734 dollars contre 10 400 pour Brad Rutter et 4 000 pour Ken Jennings. Big Blue a indiqué qu'il reverserait cette somme rondelette à des oeuvres.

(...)

Microsoft pousse Intel à produire des puces Atom 16 coeurs

Il y a une « énorme opportunité » pour améliorer l'efficacité énergétique en utilisant des serveurs basés sur des petites puces de faible puissance telles que les modèles Atom d'Intel et Bobcat d'AM, a déclaré Dileep Bhandarkar, un ingénieur travaillant pour la Global Foundation Services de Microsoft, qui gère les centres de calcul de la firme de Redmond. Ces petits processeurs consomment peu d'électricité, car ils ont été conçus à l'origine pour équiper des ordinateurs mobiles comme les netbooks. Mais, pour certaines charges de travail, ils sont aussi plus économes en énergie que les processeurs pour serveurs comme les puissantes puces Intel Xeon, a indiqué Dileep Bhandarkar lors d'un exposé au centre de conférence Liney Group dans la Silicon Valley. Les datacenters de Microsoft alimentent les différents services en ligne de l'éditeur comme Bing, Hotmail et Windows Live Messenger, ainsi que Windows Azure et les déclinaisons SaaS des applications d'entreprise Sharepoint et Exchange.

Des expérimentations déjà en cours

Ce n'est un secret pour personne que Microsoft et d'autres grands opérateurs de centres de calculs expérimentent les puces de faible puissance. Des fournisseurs comme Dell tentent déjà de vendre des serveurs basés sur le processeur Nano de Via. Les commentaires de Dileep Bhandarkar témoignent du vif intérêt de Microsoft dans ces modèles alternatifs et des demandes spécifiques qui ont été faites à Intel et AMD. Les fondeurs doivent également utiliser une approche plus intégrée de leurs puces a-t-il dit. « Quand vous regardez ces coeurs minuscules, une autre façon de les faire fonctionner d'une manière très efficace est [de ne pas] multiplier les liens et les contrôleurs... Fondamentalement les noyaux minuscules et les systèmes sur une puce devraient aller de concert ».

Microsoft possède un poids suffisant pour faire pression sur ses fournisseurs et obtenir les équipements qui répondent à ses spécifications; Intel est en outre tout à fait capable de concevoir une puce Atom pour serveurs, souligne de son coté Linley Gwennap, fondateur et analyste principal du Linley Group. « Je pense qu'Intel va devoir se résigner à le faire. Nous voyons également les dirigeants d'ARM s'intéresser au marché des serveurs et pour répondre à cette concurrence sur la performance par watt de puissance, Intel devra s'appuyer sur ses processeurs Atom », a-t-il ajouté.

ARM, nouveau challenger sur le marché des serveurs

Dileep Bhandarkar a encore expliqué que Microsoft peut accompagner ARM sur le marché des serveurs, mais cette architecture doit encore faire face à de nombreux obstacles. « Si ARM réussit à nous montrer qu'elle apporte plus de bénéfices qu'une solution x86 nous pourrons considérer la chose, dit-il. Mais le bénéfice en termes de performances doit être absolument significatif ». «La translation de jeu d'instructions est un exercice très difficile », précise Dileep Bhandarkar . « Pour certaines applications où il n'y a pas vraiment de dépendance [à la plate-forme x86, ndlr], ... ARM a quelque chose d'intéressant à proposer et si il réussit pousser Intel et AMD à sortir des solutions x86 plus efficaces, j'en serai très heureux ».

Microsoft a récemment déclaré qu'il allait porter Windows [la version 8 attendue en 2012, ndlr] sur les processeurs ARM pour une utilisation dans des dispositifs mobiles tels que les tablettes. Mais c'est très différent des PC et des serveurs, fait valoir Dileep Bhandarkar, qui doivent exécuter un large éventail de logiciels existants. ARM, qui a décidé de concevoir de puissantes puces pour serveurs et commutateurs, est plus optimiste. La firme note que certains serveurs n'ont besoin que d'une poignée de programmes pour travailler, comme la stack LAMP (Linux, Apache, la base de données MySQL et PHP).

Illustration principale : plaque de coeurs Atom, crédit photo Intel

[[page]]

Linley Gwennap estime que les processeurs ARM pourraient tout à fait jouer un rôle dans les datacenters. Ils sont susceptibles d'être d'abord utilisés par les fournisseurs de services Internet et pour certains usages dans les entreprises. «Il est clair que le logiciel est un gros obstacle, mais certains clients sont prêts à travailler avec ça», précise-t-il. « Cela va prendre du temps, mais si ARM réussit à s'installer dans les centres de calcul, puis à migrer dans les entreprises, il peut y avoir un certain élan ».

Un porte-parole d'Intel a noté que HP vend un serveur multimédia familial avec

un processeur Atom, mais Intel n'a « pas de nouvelles à annoncer » concernant l'arrivée de puces Atom pour les centres de calcul, a-t-il indiqué. Il a également souligné que Google et Microsoft ont, dans le passé, indiqué leurs préférences pour des processeurs plus puissants. « Nous sommes très satisfaits des dernières solutions multicoeurs, et nous pensons que, pour améliorer le design et la performance des processeurs, la course au toujours plus petit n'est pas forcément la meilleure solution », écrivait d'ailleurs Google, une note de synthèse l'an dernier.

Réduire la consommation globale des datacenter

Mais Dileep Bhandarkar affirme de son coté qu'il y a une baisse des rendements lorsque les puces multi coeurs montent en fréquences. Microsoft prête une attention particulière à la performance par watt pour un dollar au moment de sélectionner son matériel, et les gains en performance des dernières puces ne compensent pas assez l'augmentation de la consommation d'énergie. « Donc, pour beaucoup de nos configurations, nous avons généralisé l'usage de puces quatre coeurs » conclut-il.

Chez Microsoft, les processeurs ne sont toutefois qu'une partie de l'équation de l'efficacité énergétique. L'éditeur essaie de considérer ses datacenters dans une approche globale avec un cahier des charges très stricte à destination des constructeurs. La firme a par exemple installé des serveurs sans ventilateurs en optimisant l'agencement des racks dans les armoires. Microsoft demande également à ses fournisseurs des serveurs sans lecteur de CD ou DVD, avec moins de slots DIMM et de ports PCI, et des alimentations électriques répondant aux normes Gold et Platinium de l'Initiative Climate Savers.

L'Itanium Poulson attendu en 2012

Du 20 au 24 février 2011 à San Francisco, les principaux concepteurs de processeurs partageront leurs travaux à l'occasion de la conférence International Solid State Circuits. Intel et IBM en profiteront pour lever le voile sur leurs prochaines générations de puces pour grands systèmes. Ces dernières années, les fabricants de processeurs avaient multiplié les coeurs, augmenté les cadences et étoffé la mémoire cache pour améliorer les performances. Et pour permettre aux serveurs de renforcer leur disponibilité et leur fiabilité, les fondeurs avaient également bardé leurs plates-formes de fonctions d'auto-diagnostique.

Dans un mois environ, Intel dévoilera sa prochaine génération de puces Itanium encore connue sous le nom de code Poulson. Attendu en 2012, ce processeur fort de huit coeurs serait doté de 50 Mo de cache, selon les premières informations livrées par le fondeur. Ces puces équiperont les serveurs haute disponibilité sur base IA64 que l'on retrouve principalement chez HP (Integrity NonStop). Les processeurs Pulson seront l'occasion pour Intel de tester certaines technologies qui pourront ensuite arriver sur les puces x86 pour serveurs et PC, explique Dean McCarron, analyste chez Mercury Research. Ces processeurs mettront à la fois l'accent sur les performances et la maitrise de la consommation d'énergie.

Une mise en production prévue pour 2012

La puce Poulson huit coeurs succédera à l'Itanium Tukwila quatre coeurs, qu'Intel a commencé à livrer en février 2010, après de nombreux mois de retard. Comme Poulson, Tukwila a servi de banc d'essai pour la plupart des fonctionnalités avancées qu'Intel intègre désormais dans ses processeurs Xeon haut de gamme (Nehalem-EX) livrés en mars dernier. Le fondeur a par exemple intégré la correction d'erreur et des facilités de maintenance (RAS). Gravé en 32 nm (contre 65 nm pour Tukwila), le processeur Poulson embarquerait jusqu'à 3,1 milliards de transistors (contre 2 milliards pour Tukwila). L'amélioration significative du procédé de fabrication permettra à Intel d'améliorer la performance du circuit et de réduire la consommation d'énergie.

Si la majeure partie de l'activité d'Intel provient des puces x86, la conception et la fabrication des Itanium IA64 (30 à 40 000 unités par trimestre) répondent à des obligations contractuelles vis-à-vis de HP. Après le rachat de Compaq, Hewlett-Packard avait transféré une grande partie des ingénieurs travaillant sur le processeur Alpha chez Intel pour améliorer les performances décevantes de l'IA64 Merced qui devait remplacer la puce PA-Risc des HP 3000 et 9000 (Superdome). Aujourd'hui, le constructeur de Palo Alto utilise également les puces Itanium dans ses serveurs Integrity Non Stop, hérités de Compaq. « [Itanium] fait appel à un ensemble très restreint de consommateurs » souligne Dean McCarron. «Ces puces reposent sur un design qui commence à dater. Le cycle de rafraîchissement pour cette catégorie de composants est toutefois assez lent ».

Puces pour mainframe et supercalculateur

De son côté, IBM fera une présentation de son zEnterprise 196 avec des puces quatre coeurs qui fonctionnent à une cadence de 5,2 GHz. Présenté en juillet dernier, ce mainframe est commercialisé depuis septembre dernier. Ce CPU est aujourd'hui présenté dans le programme de l'ISSCC comme le microprocesseur avec la fréquence la plus élevée. Doté de 3 Mo de mémoire cache, il renferme 1,4 milliard de transistors.

Un troisième acteur surprenant est attendu sur cette conférence. L'ICT (Institute of Computing Technology), qui dépend de l'Académie des Sciences de Chine Populaire, présentera son processeur huit coeurs Godson-3B qui vient succéder au Godson-3. Basée sur une architecture Mips, cette nouvelle puce offrirait une puissance de calcul de 128 gigaflops/s tout en consommant moins de 40 watts. La puce a déjà été dévoilée lors de la conférence Hot Chips à l'Université de Stanford, en août dernier.

(...)(10/01/2011 14:34:52)Selon Forrester, l'écart se resserre entre serveurs x86 et RISC

Selon le rapport « x86 Servers Hit The Hight Notes » publié par le cabinet anglo-saxon Forrester, il y a eu un abandon progressif des serveurs Unix RISC au profit des systèmes x86 qui ont considérablement mûri ces dernières années. L'auteur de l'étude, Richard Fichera, explique notamment qu'auparavant les entreprises n'avaient pas d'autre choix que d'utiliser des serveurs Unix RISC haut de gamme pour certains traitements même si l'option était fort couteuse. Toutefois, le jeu a changé l'an dernier quand Intel a introduit ses puces Xeon 7500 et 6500. « Avec cette famille de processeurs, Intel a fondamentalement modifié la dynamique de ce segment du marché des serveurs. Ces processeurs permettent désormais aux fabricants de systèmes de construire des serveurs x86 qui sont des alternatives réalistes sur le marché des systèmes moyenne gamme RISC/Unix », écrit-il.

Mais il y a aussi d'autres facteurs à prendre en compte. Richard Fichera souligne que les fournisseurs de systèmes ont considérablement amélioré la qualité de leurs serveurs, notamment pour l'accès et la quantité de mémoire grâce à l'utilisateur de jeux de composants propriétaires. Il a également expliqué que les systèmes d'exploitation pour systèmes x86 se sont bonifiés au niveau des performances, de la stabilité et de la montée en charge.

Des systèmes RISC encore plus performants

Toutefois, le rapport continue de montrer que, malgré ces améliorations, il existe encore un écart considérable entre les solutions RISC et x86. L'analyste fait par exemple valoir que le benchmark applicatif Two-Tiers de SAP démontre que les systèmes x86 ont encore trois ou quatre ans de retard sur les meilleures offres RISC. «Les plates-formes x86 ont connu de nombreuses améliorations ces 10 dernières années et elles ont été proportionnellement plus élevées que celles des systèmes RISC. Il semble que, avec une petite marge d'erreur, le résultat x86 le plus haut est environ égal à la meilleure performance RISC des trois à quatre précédentes années ». L'analyste indique également que les solutions RISC ne sont pas équivalentes, certains constructeurs ne sont que 50% supérieurs aux serveurs X86. Plusieurs processeurs et OS sont aujourd'hui disponibles sur le marché : Sparc/Solaris, Power7/Aix, Itanium/HP-Ux...

Ce qu'il va être intéressant de suivre dans les prochains mois, c'est si l'arrivée des prochaines puces X86 d'Intel va changer la donne. Richard Fichera note sur un blog hébergé par notre confrère ComputerWorld que l'amélioration des performances des serveurs repose en grande partie sur le travail réalisé sur les processeurs et que l'arrivée des Xeon Sandy Bridge EP reposant sur le coeur du Core i7-2600K 32 nm devrait permettre d'accroitre les performances de 50 à 100%

Illustration : HP Proliant sur base Xeon 7500

Bilan supercomputers 2010 : En route vers l'exaflopique

L'année 2010 a été marquée par l'arrivée d'un supercalculateur chinois, le Tianhe-1A, à la tête du fameux classement mondial Top500. Avec une puissance de calcul de 2,57 petaflops/s, ce dernier a en effet ravi la première place du podium au Cray Jaguar XT5-HE du Département américain de l'Énergie. Un autre système chinois, le Nebulae installé au National Supercomputing Centre de Shenzhen, occupe même la troisième place avec 1,27 petaflops/s. Un supercomputer japonais, Tsubame 2.0, tient désormais la quatrième place avec 1,19 petaflops/s. Avec le concours de Bull, le CEA a mis en service son Tera100, d'une puissance de 1,05 petaflops/s, qui se classe sixième pour l'instant.

Chasse gardée des américains, ce classement est aujourd'hui bouleversé par l'arrivée des très ambitieux programmes chinois. Si IBM n'a pas totalement renoncé à reprendre la main sur ce classement - le projet SuperMUC en Bavière annonce 3 pétaflops - il a également décidé de porter ses efforts sur le Green500. Une catégorie où le rapport puissance/consommation est pris en compte. Pour mesurer le rapport performance/consommation qui sera affiché dans le classement, les administrateurs des sites doivent exécuter un ensemble de tests conformes aux spécifications Energy Star. Et à ce petit jeu, les supercalculateurs les plus puissants ne font pas nécessairement le meilleur usage de l'énergie consommée.

Dernière tendance pour l'année 2010, le développement de supercalculateurs exaflopiques. Aujourd'hui, les systèmes les plus puissants atteignent le pétaflops, ce qui signifie qu'ils sont capables d'effectuer un million de milliards d'opérations en virgule flottante par seconde. Un système exaflopique quant à lui se mesure en exaflops, soit 1 milliard de milliards d'opérations en virgule flottante par seconde. Les États-Unis, la Chine, l'Europe et le Japon travaillent tous sur des plates-formes informatiques exascales même si les premiers systèmes ne sont pas attendus avant 2018.

Les articles publiés en 2010 sur le sujet :

- Le 14 décembre 2010 : IBM va construire un supercalculateur de 3 pétaflops en Bavière

- Le 10 décembre 2010 : BullWay 2013 : Sur le HPC, Bull devra compter avec la Chine

- Le 2 décembre 2010 : La technologie des puces CMOS photoniques rapproche IBM de l'exaflopique

- Le 30 novembre 2010 : Dezineforce : le supercalculateur mis en boite

- Le 26 novembre 2010 : Supercalculateurs exaflopiques : Pas avant 2018

- Le 25 novembre 2010 : Dassault Aviation se dote de supercalcultateurs Bull

- Le 22 novembre 2010: IBM en tête du Green500

- Le 16 novembre 2010 : Un supercalculateur chinois a pris la tête du Top500

- Le 28 octobre 2010 : Un supercalculateur chinois revendique une puissance de 2,5 pétaflops

(...)(14/12/2010 17:55:15)Oracle confirme son intérêt pour le système de fichiers Lustre

Alors qu'un certain nombre d'acteurs, comme Xyratex par exemple, proposent des services de support pour le système de gestion de fichiers Lustre (ex-Sun Microsystems), Oracle n'a pas du tout l'intention d'abandonner la technologie. Cette dernière a été conçue pour les systèmes à haute performance qui peuvent rassembler des dizaines de milliers de noeuds et de pétaoctets de stockage générant des flux d'entrées/sorties élevés.

Si l'on en croit Jason Schaffer, directeur senior, responsable des produits de stockage chez Oracle, sa société manifeste « un engagement inébranlable vis-à-vis de Lustre, de sa communauté et, plus largement, de celle des supercalculateurs dans son ensemble. Depuis l'acquisition de Sun, nos concurrents ont eu de nombreuses occasions de faire des déclarations un peu présomptueuses sur ce qu'Oracle allait développer ou pas », a-t-il ajouté.

Cette garantie formulée par Jason Schaffer succède à une longue période pendant laquelle Oracle s'est montré bien silencieux au sujet de Lustre, ce qui a rendu nerveux quelques-uns des utilisateurs et conduit certains fournisseurs à diffuser leurs propres messages marketing autour de la technologie. Ainsi, Brent Gorda, PDG de Whamcloud (une start-up à capital risque de San Francisco qui a démarré cette année des mises en oeuvre de Lustre), a-t-il fait remarquer en octobre, qu'au sein de la communauté Lustre, il y a le sentiment qu'Oracle s'éloigne du monde HPC (high performance computing) et de Linux.

61% du Top100 des supercalculateurs utilisent Lustre

Lustre est réputé en tant que système de gestion de fichiers massivement parallèle, ce qui lui permet de stocker d'importants volumes de données à travers de multiples noeuds. Cette technologie est utilisée par de très nombreux supercalculateurs parmi les plus rapides du monde (61% des cent premiers systèmes du dernier Top500 y recourent, et parmi eux, le numéro 1 de la liste, le système chinois Tianhe-1A). Ses partisans soulignent qu'elle convient également au cloud computing.

En avril, Peter Bojanic, directeur de développement de Lustre chez Oracle, a présenté l'avenir de la technologie à un groupe d'utilisateurs. Il avait alors précisé que, si la société de Redwood Shores allait bien continuer à proposer des solutions de stockage exploitant Lustre, en revanche, elle ne prévoyait pas de vendre le produit sous la forme d'un logiciel indépendant. Depuis cette date, le constructeur est resté très silencieux sur l'évolution du produit, tout en livrant tranquillement, au mois d'août, la version 2.0 du système de gestion de fichiers.

Ce silence a irrité certains utilisateurs de Lustre, surtout en voyant comment Oracle avait utilisé ce mode de communication pour signifier son manque d'intérêt pour OpenSolaris, la version communautaire du système d'exploitation Solaris, développé par Sun. Le fait qu'Oracle ait perdu cette année plusieurs développeurs clés de Lustre n'a pas arrangé les choses. Parmi eux, Peter Bojanic, justement, a rejoint Xyratex, un éditeur de logiciels de stockage spécialisé sur Lustre (il est vrai que la société a été lancée par Peter Braam, celui-là même qui a inventé le système de gestion de fichiers, au début des années 2000).

[[page]]

En dépit de ces signaux d'alerte, Oracle reste engagé sur Lustre, affirme Jason Schaffer. Le constructeur prévoit de continuer à maintenir la branche originelle du logiciel et en assurer la disponibilité. « Nous n'avons pas l'intention de nous écarter de ce rôle, pas plus que nous ne prévoyons de créer une dérivation privée du code », a-t-il encore assuré.

Le responsable des produits de stockage sur disque d'Oracle a également ajouté que sa société travaillait à intégrer Lustre avec l'autre système de gestion de fichiers de Sun, le très connu ZFS (Zettabyte File System) 128 bits. Lustre pourrait ainsi être utilisé avec ZFS sur les périphériques de stockage du constructeur. Jason Schaffer ajoute qu'il est évidemment prévu de répercuter ces changements dans la version Open Source du logiciel.

HP et Dell exploitent Lustre dans leurs solutions

Parmi les signes positifs pour les amateurs de Lustre, on peut signaler qu'Oracle avait pris un stand sur le salon Supercomputer 2010 (SC 2010) qui s'est tenu à La Nouvelle Orléans le mois dernier. Les autres sociétés présentes sur cette manifestation ont montré de leur côté qu'elles s'intéressaient toujours à Lustre. Ainsi, HP a présenté son Unified Cluster Portfolio, un ensemble de matériels, logiciels et services préintégrés qui exploitent ce système de gestion de fichiers. Le support de Lustre est fourni à HP par DataDirect Networks, a expliqué Alanna Dwyer, responsable marketing clusters chez HP.

Dell propose lui aussi Lustre sur plusieurs de ses systèmes de stockage, a également indiqué Donnie Bell, responsable marketing produit senior chez le constructeur texan. Ce dernier travaille avec l'éditeur de logiciels Terascala pour cette offre. « Lustre est quelque chose d'assez compliqué. Terascala nous aide à fournir des systèmes de gestion de fichiers parallèles à ceux qui n'ont pas pu s'en approcher jusque-là », a ainsi expliqué Donnie Bell. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |